A modern digitális világban a felhasználók elvárják, hogy az általuk használt weboldalak, alkalmazások és online szolgáltatások mindig elérhetőek, gyorsak és megbízhatóak legyenek. Egyre növekvő forgalommal és komplexitással szembesülve a hagyományos szerverarchitektúrák gyorsan elérhetik a teljesítőképességük határát, ami lassú betöltődési időkhöz, hibákhoz és végső soron elégedetlen felhasználókhoz vezethet. Ebben a kihívásokkal teli környezetben válik elengedhetetlenné egy olyan technológia, amely képes hatékonyan kezelni a bejövő kérések áradatát, optimalizálni a rendszer erőforrásait és fenntartani a szolgáltatás folyamatos rendelkezésre állását. Ez a technológia nem más, mint a terheléselosztás, angolul load balancing, amely a modern infrastruktúrák gerincét képezi.

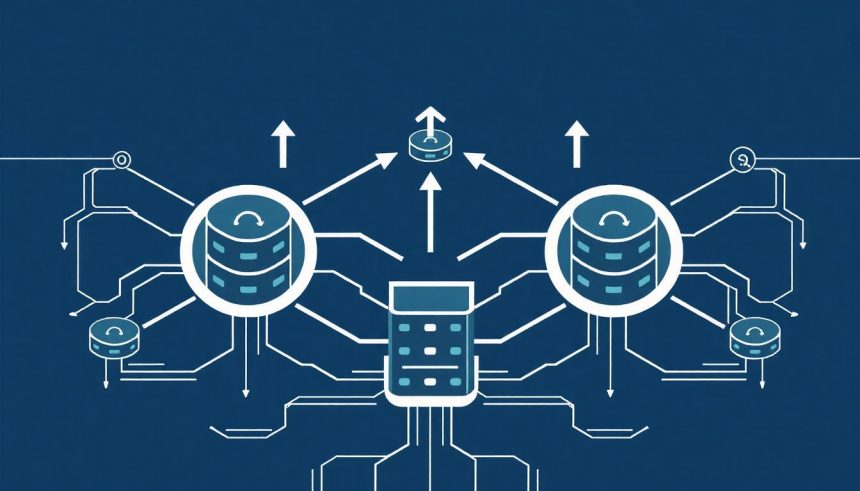

A terheléselosztás lényege, hogy a bejövő hálózati forgalmat több szerver vagy erőforrás között osztja el, megakadályozva ezzel, hogy egyetlen szerver túlterheltté váljon, miközben más szerverek kihasználatlanul állnak. Ezáltal nemcsak a teljesítmény optimalizálható, hanem a rendszer ellenállóbbá válik a hibákkal szemben is. Amikor egy szerver meghibásodik, a terheléselosztó automatikusan átirányítja a forgalmat a működő egységekre, biztosítva a szolgáltatás megszakítás nélküli működését. Ez a képesség kritikus a mai, 24/7-es rendelkezésre állást igénylő környezetekben.

Miért van szükség terheléselosztásra?

A digitális szolgáltatások exponenciális növekedése és a felhasználói elvárások emelkedése alapjaiban változtatta meg a szerverinfrastruktúrákkal szembeni követelményeket. Korábban elegendő lehetett egyetlen, erőteljes szerver, ám a mai forgalom és az adatok mennyisége már messze meghaladja egyetlen gép kapacitását. A terheléselosztás szükségessége több kulcsfontosságú tényezőből fakad, amelyek mind a modern webes és alkalmazás-infrastruktúrák alapvető kihívásait jelentik.

Növekvő forgalom és skálázhatóság

Az online szolgáltatások, mint a webáruházak, streaming platformok, közösségi média oldalak vagy akár a banki rendszerek, folyamatosan növekvő felhasználói bázissal és ebből adódóan növekvő forgalommal szembesülnek. Egyetlen szerver képtelen lenne kezelni a több tízezer, vagy akár több millió egyidejű kérést anélkül, hogy ne válna lassúvá, vagy ne omlana össze. A terheléselosztás lehetővé teszi, hogy több szerver dolgozzon együtt, mint egyetlen logikai egység, elosztva a munkaterhelést. Ez a megközelítés biztosítja a rendszer horizontális skálázhatóságát, ami azt jelenti, hogy szükség esetén egyszerűen hozzáadhatunk újabb szervereket a poolhoz anélkül, hogy a meglévő architektúrát jelentősen módosítanánk.

A skálázhatóság nem csupán a forgalom növekedésének kezeléséről szól, hanem arról is, hogy a rendszer képes legyen rugalmasan alkalmazkodni a terhelés ingadozásaihoz. Gondoljunk például egy Black Friday akcióra, vagy egy népszerű esemény online jegyértékesítésére, ahol a forgalom hirtelen többszörösére ugrik. A terheléselosztó ilyenkor kulcsszerepet játszik abban, hogy az extra terhelést szétossza, elkerülve a túlterhelést és a szolgáltatáskimaradást. Miután a csúcsidőszak elmúlt, a felesleges szerverek leállíthatóak vagy más feladatokra irányíthatóak, optimalizálva a költségeket.

Magas rendelkezésre állás és hibatűrés

Egyetlen szerver meghibásodása esetén az egész szolgáltatás elérhetetlenné válna. Ez elfogadhatatlan a kritikus üzleti alkalmazások és a felhasználók számára. A terheléselosztás kulcsfontosságú a magas rendelkezésre állás (High Availability) és a hibatűrés (Fault Tolerance) biztosításában. A terheléselosztó folyamatosan figyeli a mögötte lévő szerverek „egészségi állapotát” (health checks). Amennyiben egy szerver nem válaszol, vagy hibát jelez, a terheléselosztó automatikusan kiveszi azt a forgalomelosztásból, és a kéréseket a továbbra is működő szerverekhez irányítja. Ez a folyamat észrevétlen marad a felhasználó számára, biztosítva a szolgáltatás folytonosságát.

A terheléselosztás nem csupán a teljesítményt optimalizálja, hanem a modern digitális szolgáltatások alapkövét képező megbízhatóságot és folyamatos elérhetőséget is szavatolja.

Ez a hibatűrő képesség nem csak a hardveres meghibásodásokra vonatkozik, hanem szoftveres problémákra, hálózati kimaradásokra vagy akár karbantartási munkákra is. Egy szerver frissítése vagy karbantartása során egyszerűen kivehető a poolból, a terheléselosztó pedig gondoskodik arról, hogy a forgalom továbbra is zökkenőmentesen áramoljon a többi, online szerver felé. A karbantartott szerver visszatérése után pedig újra bekapcsolható az elosztásba.

Teljesítményoptimalizálás

A terheléselosztás nem csupán a túlterhelés elkerüléséről szól, hanem arról is, hogy a rendszer a lehető leghatékonyabban működjön. A bejövő kérések intelligens elosztásával a terheléselosztó biztosítja, hogy minden szerver optimálisan legyen kihasználva, elkerülve ezzel az erőforrások pazarlását. Ez csökkenti a válaszidőket, növeli az átviteli sebességet és javítja a felhasználói élményt.

A terheléselosztók képesek figyelembe venni a szerverek aktuális terhelését, kapacitását, sőt akár a válaszidőit is, amikor döntést hoznak arról, hogy melyik szerverhez irányítsák a következő kérést. Ez a dinamikus megközelítés garantálja, hogy a kérések mindig a legkevésbé leterhelt vagy a leggyorsabban válaszoló szerverhez kerüljenek, maximalizálva ezzel a rendszer teljesítményét és hatékonyságát. Ezen felül, bizonyos terheléselosztók képesek SSL/TLS offloadingra, ami azt jelenti, hogy ők kezelik a titkosítási/dekódolási feladatokat, tehermentesítve ezzel a háttérszervereket, és tovább javítva azok teljesítményét.

A terheléselosztás alapvető definíciója és céljai

A terheléselosztás egy olyan technológia, amely a bejövő hálózati forgalmat és munkaterhelést több háttérszerver (back-end server, vagy szerver pool) között osztja el. Célja, hogy optimalizálja az erőforrás-kihasználtságot, maximalizálja az átviteli sebességet, minimalizálja a válaszidőket és elkerülje az egyes szerverek túlterhelését. Mindemellett alapvető szerepet játszik a magas rendelkezésre állás és a hibatűrés biztosításában, hiszen képes automatikusan felismerni a hibás szervereket és kizárni azokat a forgalom elosztásából.

A terheléselosztás nem csupán a webes forgalomra korlátozódik; alkalmazható bármilyen TCP/UDP alapú szolgáltatásra, mint például adatbázis-kapcsolatok, VPN-ek, vagy egyéb egyedi protokollok. A modern rendszerekben szinte mindenhol találkozhatunk vele, ahol magas forgalmat és folyamatos rendelkezésre állást kell biztosítani.

Mi az a terheléselosztó (load balancer)?

A terheléselosztó az a hardveres vagy szoftveres eszköz, amely ezt a funkciót ellátja. Ez egy központi pont, amely az összes bejövő kérést fogadja, majd egy előre meghatározott algoritmus alapján továbbítja azt a mögötte lévő szerverek egyikére. A felhasználók számára ez az egyetlen pont látszik, a mögöttes szerverek infrastruktúrája rejtve marad. Ez a virtuális IP (VIP) cím, amihez a felhasználók csatlakoznak, és a terheléselosztó felelős a forgalom megfelelő szerverre való irányításáért.

A terheléselosztók sokfélék lehetnek, a dedikált hardveres berendezésektől kezdve, mint például az F5 Networks vagy a Citrix ADC, egészen a szoftveres megoldásokig, mint az NGINX vagy a HAProxy. A felhőalapú szolgáltatások, mint az AWS Elastic Load Balancing (ELB) vagy az Azure Load Balancer, szintén terheléselosztók, amelyek a felhőinfrastruktúra részét képezik és szolgáltatásként érhetők el.

A proxy szerepe

A terheléselosztók gyakran proxy szerverként működnek. Ez azt jelenti, hogy ők maguk nem a végső szolgáltatást nyújtják, hanem közvetítőként lépnek fel a kliens és a háttérszerverek között. Amikor egy kliens kérést küld a terheléselosztónak, az fogadja azt, majd egy új kérést generál a kiválasztott háttérszerver felé. A háttérszerver válaszát a terheléselosztó fogadja, majd továbbítja a kliensnek. Ez a folyamat teljesen átlátszó a kliens számára.

A proxy szerepe számos előnnyel jár. Először is, a terheléselosztó absztrakciós réteget biztosít a kliensek és a szerverek között. A klienseknek nem kell tudniuk a háttérszerverek IP-címeiről vagy topológiájáról. Másodszor, a proxyképesség lehetővé teszi a terheléselosztónak, hogy különféle funkciókat lásson el a kérések továbbítása előtt, például:

- SSL/TLS titkosítás kezelése (offloading): A terheléselosztó dekódolja a bejövő titkosított forgalmat, és titkosítatlanul küldi tovább a háttérszervereknek, tehermentesítve őket.

- Tartalom alapú útválasztás: A kérés URL-je vagy fejlécei alapján dönthet arról, hogy melyik szervercsoporthoz irányítja a forgalmat (pl. /api kérések az API szerverekhez, /images kérések a kép szerverekhez).

- HTTP fejléc manipuláció: Fejlécek hozzáadása, módosítása vagy eltávolítása a kérésekből vagy válaszokból.

- Támadások elleni védelem: Bizonyos szintű DDoS védelem vagy webalkalmazás tűzfal (WAF) funkciók.

Hogyan működik a terheléselosztás?

A terheléselosztás működési elve viszonylag egyszerűnek tűnik, de a mögötte rejlő mechanizmusok és konfigurációs lehetőségek rendkívül komplexek lehetnek. Alapvetően egy bejövő kérés fogadásáról, egy optimális szerver kiválasztásáról és a kérés továbbításáról van szó. Azonban a részletek, mint az egészségellenőrzés és a munkamenet-ragadósság, kulcsfontosságúak a megbízható és hatékony működéshez.

A kérés útvonala

Amikor egy felhasználó hozzáfér egy weboldalhoz vagy alkalmazáshoz, a kérés a következő utat járja be:

- A felhasználó böngészője vagy alkalmazása DNS feloldást végez a szolgáltatás domain nevére (pl. www.pelda.hu).

- A DNS szerver visszaadja a terheléselosztó virtuális IP-címét (VIP).

- A kliens erre a VIP-címre küldi a kérést.

- A terheléselosztó fogadja a kérést, és egy előre konfigurált terheléselosztási algoritmus alapján kiválasztja a rendelkezésre álló háttérszerverek közül azt, amelyik a legalkalmasabbnak tűnik a kérés feldolgozására.

- A terheléselosztó továbbítja a kérést a kiválasztott háttérszervernek. Ez történhet közvetlenül (például Layer 4 terheléselosztás esetén), vagy proxyként (Layer 7 terheléselosztás esetén).

- A háttérszerver feldolgozza a kérést és visszaküldi a választ a terheléselosztónak.

- A terheléselosztó fogadja a választ, és továbbítja azt a kliensnek.

Ez a folyamat milliszekundumok alatt zajlik le, és a felhasználó számára teljesen átláthatatlan. A háttérben azonban számos döntés és ellenőrzés történik, amelyek biztosítják a zökkenőmentes szolgáltatást.

Egészségellenőrzés (health checks)

Az egészségellenőrzés, vagy angolul health checks, a terheléselosztás egyik legfontosabb aspektusa, amely biztosítja a magas rendelkezésre állást. A terheléselosztó folyamatosan figyeli a mögötte lévő háttérszerverek állapotát, hogy megbizonyosodjon arról, hogy azok képesek-e kéréseket fogadni és feldolgozni. Ennek hiányában a terheléselosztó olyan szerverekre is küldhetne forgalmat, amelyek nem működnek, ami hibákhoz és rossz felhasználói élményhez vezetne.

Az egészségellenőrzések típusai és paraméterei konfigurálhatók, és jellemzően a következőket foglalják magukban:

- Ping (ICMP): Alapszintű ellenőrzés, amely megnézi, hogy a szerver elérhető-e a hálózaton.

- TCP port ellenőrzés: A terheléselosztó megpróbál TCP kapcsolatot létesíteni egy adott porton (pl. 80-as HTTP, 443-as HTTPS, 3306-os MySQL). Ha a kapcsolat sikeresen létrejön, a szerver „egészségesnek” minősül.

- HTTP/HTTPS ellenőrzés: A terheléselosztó egy HTTP/HTTPS kérést küld egy előre meghatározott URL-re (pl. /healthz vagy /status), és elemzi a válaszkódot (pl. 200 OK) és/vagy a válasz tartalmát. Ez a leggyakoribb és legátfogóbb ellenőrzés, mivel ellenőrzi az alkalmazásréteg működését is.

- Egyedi protokoll ellenőrzés: Komplexebb alkalmazások esetén egyedi szkriptek vagy protokollok is használhatók a szerverek állapotának ellenőrzésére.

Ha egy szerver az egészségellenőrzések során több alkalommal is hibásnak bizonyul (ezt a „hibahatárt” is konfigurálni lehet), a terheléselosztó automatikusan kiveszi azt a forgalom elosztásából. Amint a szerver újra „egészségesnek” minősül, automatikusan visszakerül a poolba. Ez a dinamikus alkalmazkodás biztosítja a szolgáltatás folyamatosságát még szerverhibák esetén is.

Munkamenet-ragadósság (session persistence/stickiness)

Bizonyos alkalmazások, különösen az állapotalapúak (stateful applications), megkövetelik, hogy egy felhasználó kérései mindig ugyanahhoz a háttérszerverhez kerüljenek. Például egy webáruház kosarának tartalma vagy egy bejelentkezett felhasználó munkamenete gyakran egy adott szerver memóriájában vagy fájlrendszerében tárolódik. Ha a felhasználó következő kérése egy másik szerverre kerülne, a munkamenet elveszhetne, ami rossz felhasználói élményt eredményezne.

Erre a problémára nyújt megoldást a munkamenet-ragadósság (session persistence vagy session stickiness). Ez a funkció biztosítja, hogy miután egy kliens első kérése egy adott szerverhez került, a terheléselosztó minden további kérését is ahhoz a szerverhez irányítja egy előre meghatározott időtartamig. Ennek megvalósítására több módszer is létezik:

- IP-cím alapú ragadósság (Source IP affinity): A terheléselosztó a kliens IP-címét használja az azonosításhoz. Ez a legegyszerűbb, de kevésbé megbízható megoldás, mivel a kliensek IP-címe változhat (pl. mobilhálózatok esetén), vagy több kliens is használhatja ugyanazt a proxy szervert, így ugyanaz az IP-cím több különböző felhasználóhoz is tartozhat.

- Cookie alapú ragadósság: A terheléselosztó egy speciális cookie-t helyez el a kliens böngészőjében, amely tartalmazza a hozzárendelt szerver azonosítóját. A következő kérések során a terheléselosztó leolvassa ezt a cookie-t, és ennek alapján irányítja a kérést a megfelelő szerverhez. Ez a legelterjedtebb és legmegbízhatóbb módszer Layer 7 terheléselosztás esetén.

- SSL munkamenet-azonosító (SSL Session ID): Titkosított kapcsolatok esetén az SSL munkamenet-azonosító is használható a ragadósság fenntartására.

Fontos megjegyezni, hogy bár a munkamenet-ragadósság megoldja az állapotalapú alkalmazások problémáját, csökkentheti a terheléselosztás hatékonyságát, mivel korlátozza a terheléselosztó szabadságát a kérések elosztásában. Ideális esetben az alkalmazásokat úgy kell megtervezni, hogy azok állapotmentesek (stateless) legyenek, vagy a munkamenetadatokat egy megosztott, külső tárolóban (pl. Redis, memcached, adatbázis) tárolják, ami lehetővé teszi, hogy bármely szerver feldolgozza a kérést, függetlenül attól, hogy melyik szerver kezelte az előzőt. Ez maximalizálja a skálázhatóságot és a hibatűrést.

A terheléselosztási algoritmusok típusai

A terheléselosztó szíve a terheléselosztási algoritmus, amely meghatározza, hogy a bejövő kéréseket hogyan ossza el a rendelkezésre álló háttérszerverek között. Ezek az algoritmusok két fő kategóriába sorolhatók: statikus és dinamikus. A választás az alkalmazás jellegétől, a szerverek kapacitásától és a kívánt teljesítménytől függ.

Statikus algoritmusok

A statikus algoritmusok egyszerűek és könnyen konfigurálhatók. Nem veszik figyelembe a szerverek aktuális terhelését vagy állapotát, hanem előre meghatározott szabályok alapján osztják el a forgalmat. Ez bizonyos esetekben hatékony lehet, de dinamikusan változó terhelés esetén kevésbé optimális.

Round Robin (Körbe-körbe)

A Round Robin a legegyszerűbb és leggyakrabban használt terheléselosztási algoritmus. A kéréseket sorban osztja ki a szerverek között. Az első kérés az 1-es szerverre, a második a 2-esre, a harmadik a 3-asra kerül, majd újra az 1-esre, és így tovább, körkörösen. Ez az algoritmus feltételezi, hogy az összes szerver azonos kapacitású és egyforma gyorsan tudja feldolgozni a kéréseket. Ideális homogén szerverfarmok esetén, ahol a kérések mérete és feldolgozási ideje viszonylag egységes.

A Round Robin hátránya, hogy nem veszi figyelembe a szerverek aktuális terhelését. Ha az egyik szerver lassabban dolgozza fel a kéréseket, vagy éppen egy hosszabb feladaton dolgozik, akkor is kapni fogja a soron következő kérést, ami lassuláshoz vezethet. Ennek ellenére rendkívül népszerű egyszerűsége és alacsony erőforrásigénye miatt.

Weighted Round Robin (Súlyozott körbe-körbe)

A Weighted Round Robin a Round Robin továbbfejlesztett változata, amely figyelembe veszi a szerverek eltérő kapacitását vagy teljesítményét. Minden szerverhez hozzárendelünk egy súlyt (weight), amely arányosan jelzi a szerver kapacitását. Egy nagyobb súlyú szerver több kérést fog kapni, mint egy kisebb súlyú. Például, ha az A szerver súlya 3, a B szerveré 2, a C szerveré pedig 1, akkor a terheléselosztó 3 kérést küld az A-ra, 2-t a B-re és 1-et a C-re, mielőtt újra kezdené a ciklust.

Ez az algoritmus különösen hasznos heterogén szerverfarmok esetén, ahol különböző teljesítményű gépek működnek együtt. Lehetővé teszi, hogy a drágább, erősebb szerverek jobban kihasználva legyenek, míg a gyengébbek kevésbé terhelődnek. Ezáltal optimalizálható az erőforrás-kihasználtság és a teljesítmény.

IP Hash (IP-cím alapján)

Az IP Hash algoritmus a kliens forrás IP-címét használja egy hash függvény bemeneteként. A hash függvény kimenete alapján dönt a terheléselosztó, hogy melyik szerverhez irányítja a kérést. A lényeg, hogy ugyanaz az IP-cím mindig ugyanahhoz a szerverhez kerül. Ez a módszer biztosítja a munkamenet-ragadósságot anélkül, hogy cookie-kat kellene használni, ami hasznos lehet olyan alkalmazásoknál, amelyek nem kezelnek cookie-kat, vagy Layer 4 terheléselosztás esetén.

Hátránya, hogy ha egy kliens IP-címe megváltozik (pl. mobilhálózaton keresztül), a munkamenet megszakadhat. Ezenkívül, ha sok felhasználó egyetlen proxy szerver mögül érkezik (így ugyanaz az IP-címük), akkor az adott szerver túlterheltté válhat, ami egyenetlen terheléselosztáshoz vezethet.

Dinamikus algoritmusok

A dinamikus algoritmusok intelligensebbek, mivel figyelembe veszik a szerverek aktuális állapotát, terhelését és teljesítményét, amikor döntést hoznak a kérések elosztásáról. Ezáltal jobb teljesítményt és hatékonyabb erőforrás-kihasználtságot érhetnek el dinamikusan változó környezetekben.

Least Connection (Legkevesebb kapcsolat)

A Least Connection algoritmus a legkevesebb aktív kapcsolatot fenntartó szerverhez irányítja a következő kérést. Ez a megközelítés ideális olyan környezetekben, ahol a kapcsolatok hossza változó. A terheléselosztó folyamatosan figyeli az egyes szerverekhez tartozó aktív kapcsolatok számát, és mindig azt a szervert választja, amelyik éppen a legkevésbé terhelt a kapcsolatok számát tekintve. Ez biztosítja az egyenletes terheléselosztást a szerverek között.

Bár ez az algoritmus hatékonyan osztja el a kapcsolatokat, nem veszi figyelembe a kapcsolatok „súlyát” vagy az egyes kérések feldolgozási idejét. Egy rövid HTTP kérés és egy hosszú adatbázis-lekérdezés is egy „kapcsolatnak” számít, ami torzíthatja a valós terhelésről alkotott képet.

Weighted Least Connection (Súlyozott legkevesebb kapcsolat)

A Weighted Least Connection algoritmus ötvözi a Least Connection és a Weighted Round Robin előnyeit. Minden szerverhez súlyt rendelünk, és a terheléselosztó a legkevesebb aktív kapcsolatot fenntartó szervert választja ki, figyelembe véve a szerver súlyát. Ez azt jelenti, hogy egy nagyobb súlyú szerver továbbra is több kapcsolatot kaphat, de csak akkor, ha arányosan még mindig kevésbé terhelt, mint a kisebb súlyú társai. Ez a módszer rugalmasabb és pontosabb terheléselosztást tesz lehetővé heterogén környezetekben.

Least Response Time (Legrövidebb válaszidő)

A Least Response Time algoritmus a leggyorsabban válaszoló szerverhez irányítja a kérést. A terheléselosztó folyamatosan méri az egyes szerverek válaszidejét, és mindig azt választja, amelyik a legrövidebb idő alatt tudta feldolgozni az előző kérést. Ez az algoritmus kiválóan alkalmas a felhasználói élmény optimalizálására, mivel a kérések mindig a leggyorsabb úton jutnak el a céljukhoz.

Hátránya, hogy a válaszidők mérése további terhelést jelenthet a terheléselosztónak, és a hirtelen ingadozások miatt előfordulhat, hogy egy átmenetileg gyors szerverre túl sok kérés kerül, mielőtt a terheléselosztó korrigálná a hibát.

Source IP affinity (Forrás IP-cím affinitás)

A Source IP affinity, más néven IP-cím alapú ragadósság, arra törekszik, hogy egy adott forrás IP-címről érkező összes kérést ugyanarra a háttérszerverre irányítsa. Ez a módszer biztosítja a munkamenet-ragadósságot (session stickiness), ami elengedhetetlen az állapotot tároló alkalmazásoknál. A terheléselosztó egy hash függvényt alkalmaz a kliens IP-címére, és az eredmény alapján választ szervert. Ha az IP-cím változatlan marad, a kliens mindig ugyanarra a szerverre kerül.

Mint korábban említettük, ez a módszer egyszerű, de vannak korlátai. Ha több felhasználó osztozik egyetlen IP-címen (pl. egy vállalati proxy mögött), vagy ha egy felhasználó IP-címe megváltozik, az problémákat okozhat. Ennek ellenére Layer 4 terheléselosztásnál, ahol nincs hozzáférés a HTTP cookie-khoz, ez egy életképes megoldás lehet.

Least Bandwidth (Legkisebb sávszélesség)

A Least Bandwidth algoritmus a szerverek közötti sávszélesség kihasználtságát figyeli. A következő kérést ahhoz a szerverhez irányítja, amelyik éppen a legkevesebb adatforgalmat bonyolítja. Ez az algoritmus különösen hasznos olyan alkalmazásoknál, ahol nagy méretű fájlok átvitele vagy streaming szolgáltatások dominálnak, és a hálózati sávszélesség a szűk keresztmetszet.

Segít elkerülni, hogy egyetlen szerver hálózati interfésze telítődjön, biztosítva ezzel a folyamatos, nagy sebességű adatátvitelt. Méréséhez azonban komolyabb monitorozási képességekre van szükség a terheléselosztó részéről.

Predictive (Prediktív)

A prediktív algoritmusok a legfejlettebbek, és gyakran gépi tanulási (Machine Learning) modelleket használnak a jövőbeli terhelés és szerverállapot előrejelzésére. Ezek az algoritmusok nem csak az aktuális állapotot veszik figyelembe, hanem a korábbi adatok és trendek alapján próbálják megjósolni, hogy melyik szerver lesz a legoptimálisabb a következő kérés feldolgozására. Figyelembe vehetnek számos metrikát, mint például a CPU kihasználtság, memória használat, I/O műveletek, hálózati forgalom, válaszidő és a hibák aránya.

A prediktív algoritmusok célja a proaktív terheléselosztás, még a problémák megjelenése előtt. Bár rendkívül hatékonyak lehetnek, konfigurálásuk és karbantartásuk komplexebb, és jelentős számítási erőforrást igényelhetnek a terheléselosztó részéről. Ezek a jövő terheléselosztási megoldásai, különösen a felhőalapú és mikroszolgáltatás-architektúrákban.

A terheléselosztók típusai és elhelyezkedése

A terheléselosztók különböző formákban és elhelyezkedésekben léteznek, attól függően, hogy milyen infrastruktúrában és milyen skálán kell működniük. Megkülönböztetünk hardveres és szoftveres megoldásokat, valamint a DNS alapú és a felhőalapú terheléselosztást is.

Hardveres terheléselosztók

A hardveres terheléselosztók dedikált fizikai eszközök, amelyeket kifejezetten a terheléselosztási feladatok elvégzésére terveztek. Ezek nagy teljesítményű, speciális célú berendezések, amelyek saját operációs rendszerrel és optimalizált hardverrel rendelkeznek a gyors és hatékony forgalomkezelés érdekében. Példák közé tartoznak az F5 Networks BIG-IP, a Citrix ADC (korábban NetScaler) vagy a Brocade ADX termékei.

Előnyeik közé tartozik a rendkívül magas teljesítmény, a nagy átviteli kapacitás, az alacsony késleltetés és a robusztus megbízhatóság. Képesek hatalmas mennyiségű egyidejű kapcsolatot kezelni és komplex terheléselosztási algoritmusokat futtatni. Gyakran tartalmaznak fejlett biztonsági funkciókat, mint például Web Application Firewall (WAF) vagy DDoS védelem. Hátrányuk viszont a magas beszerzési és karbantartási költség, valamint a kevésbé rugalmas skálázhatóság a szoftveres megoldásokhoz képest. Jellegzetesen nagyvállalati környezetben, kritikus infrastruktúrákban használják őket, ahol a maximális teljesítmény és megbízhatóság elsődleges szempont.

Szoftveres terheléselosztók

A szoftveres terheléselosztók általános célú szervereken futó alkalmazások, amelyek a terheléselosztás funkcióit látják el. Ezek rugalmasabb és költséghatékonyabb megoldást kínálnak, mint a hardveres társaik. Népszerű példák közé tartozik az NGINX, a HAProxy, az Apache HTTP Server (mod_proxy) és az Envoy Proxy.

Előnyük a rugalmasság, a könnyű skálázhatóság (virtuális gépeken vagy konténerekben is futtathatók), és az alacsonyabb költségek. A szoftveres terheléselosztók nyílt forráskódú verziói ingyenesen elérhetők, és széles körű közösségi támogatással rendelkeznek. Hátrányuk lehet, hogy a teljesítményük függ a mögöttes hardver erőforrásaitól, és nagy terhelés esetén a dedikált hardveres megoldások elmaradhatnak. Azonban a modern szerverek teljesítménye és a szoftverek optimalizáltsága miatt ez a különbség egyre kisebb. A szoftveres terheléselosztók ideálisak kis- és közepes vállalkozások, valamint felhőalapú és konténerizált környezetek számára.

DNS terheléselosztás

A DNS terheléselosztás (DNS Load Balancing) nem egy hagyományos értelemben vett terheléselosztó eszköz, hanem egy módszer, amely a Domain Name System (DNS) segítségével osztja el a forgalmat. Amikor egy kliens lekérdezi egy domain IP-címét, a DNS szerver több IP-címet is visszaadhat, és a kliens véletlenszerűen választ közülük egyet, vagy a listán szereplő elsőt használja. A leggyakoribb megvalósítás a Round Robin DNS.

Ennek a módszernek az előnye az egyszerűsége és a költséghatékonysága, mivel nem igényel külön hardvert vagy szoftvert a terheléselosztáshoz. Azonban számos hátránya is van:

- Nincs egészségellenőrzés: A DNS szerver nem tudja, hogy egy adott IP-címhez tartozó szerver működik-e. Ha egy szerver leáll, a DNS továbbra is visszaadhatja az IP-címét, ami hibás kérésekhez vezet.

- DNS cache: A kliensek és a köztes DNS szerverek hosszú ideig cache-elhetik az IP-címeket, ami azt jelenti, hogy a változások lassan terjednek el.

- Egyenetlen elosztás: A kliensek DNS resolverjei nem mindig követik a Round Robin logikát, ami egyenetlen terheléselosztáshoz vezethet.

Emiatt a DNS terheléselosztást általában csak kiegészítő vagy nagyon alapvető megoldásként használják, vagy olyan rendszerekben, ahol a hibatűrés nem kritikus.

Felhő alapú terheléselosztás

A felhő alapú terheléselosztás a modern felhőinfrastruktúrák integrált része, amelyet a felhőszolgáltatók (pl. AWS, Azure, Google Cloud) biztosítanak szolgáltatásként (Load Balancer as a Service). Ezek a megoldások rendkívül rugalmasak, skálázhatók és könnyen konfigurálhatók a felhőplatformokon belül. A felhasználóknak nem kell aggódniuk a terheléselosztó infrastruktúrájának kezelésével, a skálázásával vagy a karbantartásával, mivel ezt a felhőszolgáltató végzi.

Példák:

- AWS Elastic Load Balancing (ELB): Az Amazon Web Services (AWS) kínálja, és több típusban elérhető (Application Load Balancer – ALB, Network Load Balancer – NLB, Gateway Load Balancer – GLB, Classic Load Balancer – CLB). Az ALB Layer 7 terheléselosztást nyújt, a NLB Layer 4-et, míg a GLB harmadik féltől származó hálózati virtuális készülékekkel integrálódik.

- Azure Load Balancer: A Microsoft Azure platformja, amely Layer 4 terheléselosztást biztosít. Emellett az Azure Application Gateway Layer 7 funkcionalitást kínál, míg az Azure Front Door globális terheléselosztásra és WAF szolgáltatásokra fókuszál.

- Google Cloud Load Balancing: A Google Cloud Platform (GCP) átfogó terheléselosztási megoldásokat kínál, beleértve a globális, Layer 7 alapú HTTP(S) Load Balancingot, a Layer 4 TCP/UDP Load Balancingot és az SSL Proxy Load Balancingot.

A felhő alapú terheléselosztók előnye a beépített integráció más felhőszolgáltatásokkal (pl. autoscaling, monitoring), a globális elérhetőség, a magas rendelkezésre állás és a pay-as-you-go árképzés. Ideálisak dinamikusan skálázódó alkalmazásokhoz, mikroszolgáltatásokhoz és konténerizált környezetekhez.

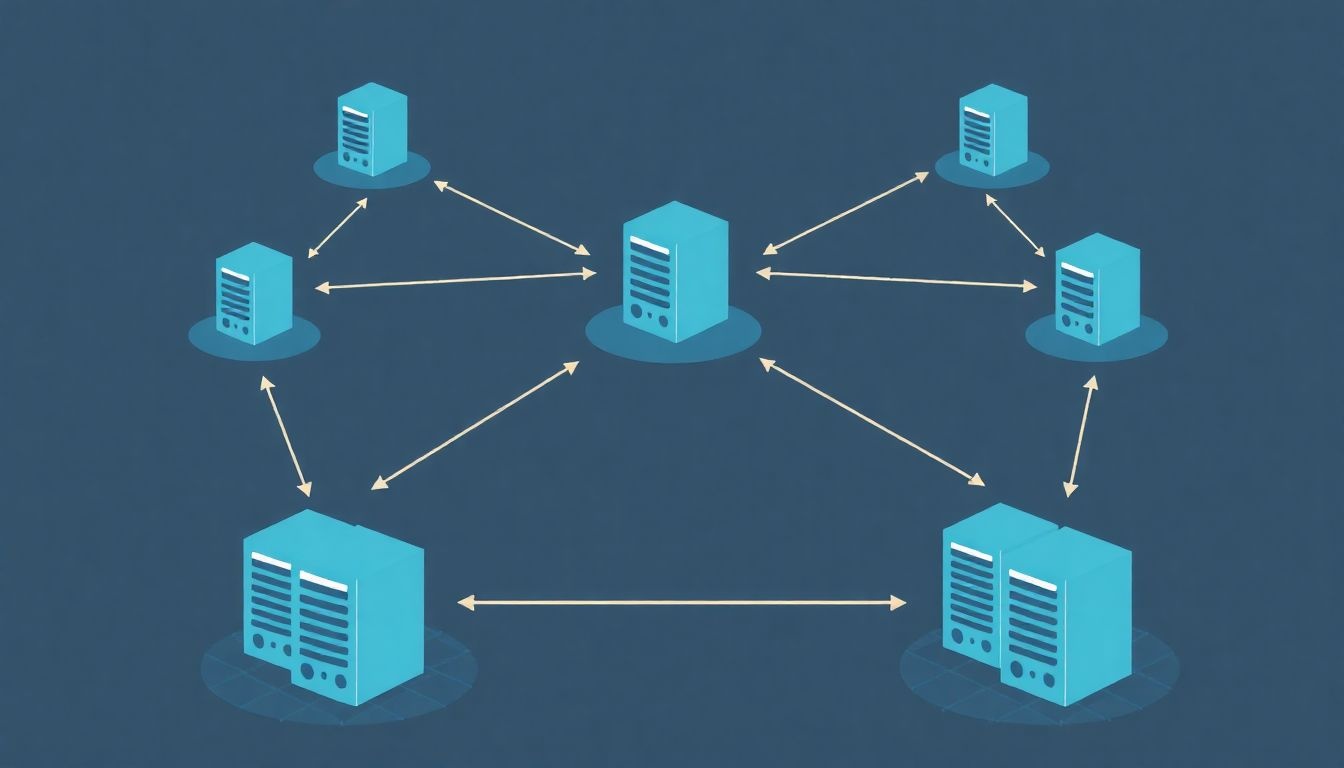

Globális szerver terheléselosztás (GSLB)

A Globális Szerver Terheléselosztás (GSLB – Global Server Load Balancing) egy olyan fejlett terheléselosztási technika, amely a forgalmat több földrajzilag elosztott adatközpont vagy felhőrégió között osztja el. Célja a globális rendelkezésre állás, a teljesítmény optimalizálása és a katasztrófa utáni helyreállítás (Disaster Recovery) biztosítása.

A GSLB a DNS rendszerrel együttműködve irányítja a felhasználókat a számukra legközelebbi vagy legkevésbé terhelt adatközpontba. Figyelembe veheti a hálózati késleltetést, a szerverek terhelését, az adatközpontok „egészségi állapotát” és egyéb metrikákat. Ha az egyik adatközpont meghibásodik, a GSLB automatikusan átirányítja a forgalmat egy másik, működő régióba. Ezáltal a felhasználók mindig a lehető legjobb szolgáltatási minőséget kapják, függetlenül attól, hogy hol tartózkodnak, és a szolgáltatás globálisan is hibatűrővé válik.

A GSLB kulcsfontosságú a nagy multinacionális vállalatok és a globális elérésű szolgáltatások számára, amelyeknek biztosítaniuk kell a folyamatos működést és a kiváló felhasználói élményt világszerte.

A terheléselosztás rétegei

A terheléselosztás működése a hálózati modell különböző rétegein valósulhat meg, és ez alapvetően befolyásolja a terheléselosztó képességeit és funkcióit. A leggyakoribb megkülönböztetés a Layer 4 (Transport Layer) és a Layer 7 (Application Layer) terheléselosztás között történik, amelyek az OSI modell megfelelő rétegeire utalnak.

Layer 4 (Transport Layer) terheléselosztás

A Layer 4 terheléselosztók az OSI modell negyedik rétegén, a szállítási rétegen (Transport Layer) működnek. Elsősorban a TCP (Transmission Control Protocol) és UDP (User Datagram Protocol) protokollokon alapuló forgalmat kezelik. Ezek a terheléselosztók a bejövő kérések cél IP-címét és portszámát vizsgálják, majd a forgalmat egy kiválasztott háttérszerver IP-címére és portjára irányítják.

A Layer 4 terheléselosztók nem tekintenek bele a kérés tartalmába (payload), azaz nem vizsgálják a HTTP fejléceket, URL-eket vagy cookie-kat. Egyszerűen csak továbbítják a TCP/UDP csomagokat a kiválasztott szervernek. Ez a megközelítés rendkívül gyors és hatékony, mivel a terheléselosztónak kevesebb feldolgozást kell végeznie. Ideálisak nagy forgalmú, egyszerű webes szolgáltatásokhoz, adatbázis-kapcsolatokhoz vagy más TCP/UDP alapú protokollokhoz.

Főbb jellemzői:

- Protokoll: TCP, UDP.

- Vizsgálat: Csak az IP-cím és a portszám alapján dönt.

- Sebesség: Nagyon gyors, alacsony késleltetés.

- Funkciók: Alapvető terheléselosztási algoritmusok (Round Robin, Least Connection, IP Hash), egészségellenőrzés (ping, TCP port ellenőrzés).

- Használat: Magas forgalmú, egyszerű szolgáltatások, ahol a Layer 7 funkcionalitás nem szükséges.

A Layer 4 terheléselosztók gyakran NAT (Network Address Translation) vagy Direct Server Return (DSR) módban működnek. NAT módban a terheléselosztó lecseréli a cél IP-címet a háttérszerver IP-címére, és a válaszforgalmat is ő továbbítja. DSR módban a terheléselosztó csak a bejövő kérést irányítja át, a válasz közvetlenül a háttérszerverről megy a klienshez, ami tovább növeli a teljesítményt, de bonyolultabb konfigurációt igényel.

Layer 7 (Application Layer) terheléselosztás

A Layer 7 terheléselosztók az OSI modell hetedik rétegén, az alkalmazási rétegen (Application Layer) működnek. Ezek a terheléselosztók képesek a bejövő kérések teljes tartalmának elemzésére, beleértve a HTTP/HTTPS fejléceket, URL-eket, cookie-kat és az alkalmazás-specifikus adatokat. Ez a mélyebb betekintés sokkal kifinomultabb és intelligensebb terheléselosztási döntéseket tesz lehetővé.

Főbb jellemzői:

- Protokoll: HTTP, HTTPS, FTP, SMTP, SIP stb.

- Vizsgálat: HTTP fejlécek, URL-ek, cookie-k, metódusok (GET, POST), felhasználói adatok alapján dönt.

- Sebesség: Lassabb, mint a Layer 4, mivel több feldolgozást igényel, de az optimalizált implementációk minimális késleltetést okoznak.

- Funkciók:

- Tartalom alapú útválasztás (Content-based routing): Kérések irányítása különböző szervercsoportokhoz az URL vagy a HTTP fejlécek alapján (pl. /images az egyik szerverre, /api a másikra).

- SSL/TLS offloading: A terheléselosztó kezeli az SSL/TLS titkosítást és dekódolást, tehermentesítve a háttérszervereket, amelyek így titkosítatlanul kapják meg a forgalmat.

- Munkamenet-ragadósság (Session persistence): Cookie-k vagy egyéb azonosítók alapján biztosítja, hogy egy felhasználó mindig ugyanahhoz a szerverhez kerüljön.

- URL átírás (URL rewriting): Képes az URL-ek módosítására a továbbítás előtt.

- Caching: Gyakran kért tartalmak gyorsítótárazása.

- Tömörítés: A válaszok tömörítése a sávszélesség-használat csökkentése érdekében.

- Web Application Firewall (WAF): Biztonsági funkciók a webes támadások ellen.

- Használat: Komplex webalkalmazások, mikroszolgáltatások, API gateway-ek, ahol a tartalom alapú útválasztás és a fejlett funkciók elengedhetetlenek.

A Layer 7 terheléselosztók nagyobb rugalmasságot és intelligenciát biztosítanak, ami kritikus a modern, elosztott alkalmazásokban. Bár nagyobb feldolgozási terhelést rónak a terheléselosztóra, a nyújtott előnyök (pl. jobb biztonság, optimalizált erőforrás-kihasználtság, fejlettebb útválasztás) gyakran felülmúlják ezt a hátrányt. A legtöbb modern webes terheléselosztó Layer 7 funkcionalitást kínál.

A terheléselosztás előnyei

A terheléselosztás bevezetése egy infrastruktúrába számos jelentős előnnyel jár, amelyek közvetlenül hozzájárulnak a szolgáltatások megbízhatóságához, teljesítményéhez és költséghatékonyságához. Ezek az előnyök teszik a terheléselosztást a modern IT architektúrák egyik alappillérévé.

Skálázhatóság (Scalability)

Az egyik legfontosabb előny a skálázhatóság. A terheléselosztás lehetővé teszi a rendszerek számára, hogy rugalmasan alkalmazkodjanak a változó forgalmi igényekhez. Ha a forgalom növekszik, egyszerűen hozzáadhatunk további szervereket a terheléselosztó mögé, és az automatikusan elkezdi rájuk irányítani a forgalmat. Ezt nevezzük horizontális skálázásnak. Ez sokkal költséghatékonyabb és rugalmasabb, mint egyetlen, egyre erősebb szerver (vertikális skálázás) beszerzése, amelynek kapacitása előbb-utóbb korlátokba ütközik.

A felhőalapú környezetekben ez az előny még inkább kiemelkedik az automatikus skálázási csoportokkal (autoscaling groups) való integráció révén. A terheléselosztó és az autoscaling együttműködve képes automatikusan elindítani új szervereket, ha a terhelés eléri a küszöbértéket, és leállítani azokat, ha a forgalom csökken, optimalizálva ezzel az erőforrás-felhasználást és a költségeket. Ez a rugalmasság különösen fontos a szezonális vagy előre nem látható forgalmi csúcsok kezelésében.

Rendelkezésre állás és megbízhatóság (Availability and reliability)

A terheléselosztás kritikus szerepet játszik a magas rendelkezésre állás és a rendszer megbízhatóságának biztosításában. Mivel a forgalom több szerver között oszlik el, egyetlen szerver meghibásodása nem okozza a teljes szolgáltatás leállását. A terheléselosztó az egészségellenőrzések (health checks) révén felismeri a hibás szervereket, és automatikusan kiveszi azokat a forgalom elosztásából, amíg újra működőképessé nem válnak. Ez a hibatűrő képesség alapvető fontosságú a kritikus üzleti alkalmazások és a 24/7-es működést igénylő szolgáltatások számára.

A karbantartási munkák, mint például szoftverfrissítések vagy hardvercserék, is zökkenőmentesen végezhetők el anélkül, hogy a felhasználók számára szolgáltatáskimaradást okoznánk. Egyszerűen kivehetjük az adott szervert a poolból, elvégezzük a szükséges munkát, majd visszahelyezzük. A terheléselosztó gondoskodik a folyamatos forgalomelosztásról a többi szerver között. Ez a megközelítés jelentősen csökkenti a tervezett és nem tervezett állásidőt, maximalizálva a szolgáltatás rendelkezésre állását.

Teljesítményjavulás (Performance improvement)

A terheléselosztás közvetlenül hozzájárul a rendszer teljesítményének javításához azáltal, hogy optimalizálja az erőforrás-kihasználtságot és minimalizálja a válaszidőket. A kérések intelligens elosztásával elkerülhető, hogy egyetlen szerver túlterheltté váljon, ami lassú válaszidőkhöz vagy időtúllépésekhez vezetne. Ehelyett a terheléselosztó biztosítja, hogy a kérések a legkevésbé leterhelt vagy leggyorsabban válaszoló szerverhez kerüljenek.

A Layer 7 terheléselosztók további teljesítményoptimalizálási funkciókat is kínálnak, mint például az SSL/TLS offloading, ami tehermentesíti a háttérszervereket a titkosítási feladatok alól. A gyorsítótárazás (caching) és a tömörítés (compression) szintén hozzájárulhat a válaszidők csökkentéséhez és a hálózati sávszélesség hatékonyabb kihasználásához. Az eredmény egy gyorsabb, reszponzívabb felhasználói élmény, ami kulcsfontosságú a felhasználói elégedettség és a konverziós arányok szempontjából.

Biztonság (Security)

A terheléselosztók jelentősen hozzájárulnak a rendszer biztonságához is. Mivel ők jelentik az egyetlen nyilvánosan elérhető pontot a háttérszerverek felé, absztrakciós réteget képeznek, amely elrejti a belső hálózati topológiát a külső támadók elől. A háttérszerverek IP-címei és belső struktúrája nem látható kívülről.

Sok terheléselosztó beépített biztonsági funkciókkal rendelkezik, mint például:

- DDoS védelem: Képesek felismerni és elnyelni a Distributed Denial of Service (DDoS) támadásokat, megakadályozva, hogy azok elérjék a háttérszervereket.

- Web Application Firewall (WAF): A Layer 7 terheléselosztók gyakran tartalmaznak WAF funkciókat, amelyek védelmet nyújtanak a gyakori webes támadások (pl. SQL injection, cross-site scripting) ellen.

- SSL/TLS titkosítás kezelése: A terheléselosztók kezelhetik a végpontok közötti titkosítást, biztosítva a biztonságos kommunikációt a kliensek és a szolgáltatás között.

- Hozzáférés-szabályozás: Lehetővé teszik a bejövő forgalom szűrését IP-cím, port vagy egyéb paraméterek alapján.

Ez a központosított biztonsági réteg leegyszerűsíti a biztonsági szabályok kezelését és biztosítja, hogy a háttérrendszer védett maradjon a különféle fenyegetésekkel szemben.

Költséghatékonyság (Cost-effectiveness)

Bár a terheléselosztók bevezetése kezdeti befektetést igényelhet, hosszú távon jelentős költségmegtakarítást eredményezhet. A horizontális skálázhatóság révén nem kell drága, nagyteljesítményű szervereket vásárolni, amelyek kapacitása gyakran kihasználatlan marad. Ehelyett több, olcsóbb, standard szerver használható, amelyek együttműködve biztosítják a szükséges teljesítményt.

A felhőalapú terheléselosztás és az autoscaling különösen költséghatékony, mivel csak a ténylegesen felhasznált erőforrásokért kell fizetni. A terheléselosztó optimalizálja a szerverek kihasználtságát, csökkentve az üresjárati kapacitást és az ezzel járó költségeket. A magas rendelkezésre állás minimalizálja a szolgáltatáskimaradásokból adódó bevételkiesést és a hírnév romlását, ami szintén jelentős megtakarítást jelent.

Összességében a terheléselosztás nem csupán technikai megoldás, hanem stratégiai beruházás is, amely alapjaiban javítja a digitális szolgáltatások minőségét, megbízhatóságát és gazdaságosságát.

Kihívások és megfontolások a terheléselosztás során

Bár a terheléselosztás számos előnnyel jár, bevezetése és optimalizálása nem mentes a kihívásoktól. A megfelelő konfiguráció és a rendszerszintű megfontolások elengedhetetlenek a maximális hatékonyság és megbízhatóság eléréséhez.

Egyszerűsített konfiguráció vs. komplexitás

Az alapvető terheléselosztási beállítások (pl. Round Robin algoritmus) viszonylag egyszerűen konfigurálhatók. Azonban ahogy az alkalmazások komplexebbé válnak, és a követelmények növekednek (pl. Layer 7 útválasztás, SSL offloading, munkamenet-ragadósság, WAF integráció), a terheléselosztó konfigurációja is exponenciálisan bonyolultabbá válhat. A hibás beállítások súlyos teljesítményproblémákhoz, biztonsági résekhez vagy akár szolgáltatáskimaradásokhoz vezethetnek.

A komplexitás kezeléséhez elengedhetetlen a szakértelem és a gondos tervezés. A felhőalapú terheléselosztók némileg egyszerűsíthetik ezt a folyamatot azáltal, hogy menedzselt szolgáltatást nyújtanak, de még ezek esetében is alaposan ismerni kell a különböző beállítások hatásait.

Munkamenet-kezelés (Session management)

A munkamenet-ragadósság (session stickiness) beállítása kritikus az állapotot tároló alkalmazásoknál, de mint korábban említettük, korlátozhatja a terheléselosztás hatékonyságát. Ha minden felhasználó ragaszkodik egy adott szerverhez, az egyenetlen terheléselosztáshoz vezethet, különösen ha egy-egy szerver meghibásodik vagy túlterheltté válik. Ilyenkor a terheléselosztó kénytelen megszakítani a ragadósságot, ami a felhasználói munkamenet elvesztéséhez vezethet.

A legjobb gyakorlat az alkalmazások állapotmentessé tétele, vagy a munkamenetadatok külső, megosztott tárolóban (pl. Redis, Cassandra, adatbázis) való tárolása. Ezáltal bármelyik szerver képes lesz feldolgozni a kéréseket, és a terheléselosztó szabadon irányíthatja a forgalmat anélkül, hogy a felhasználói élmény romlana. Ez a megközelítés maximalizálja a skálázhatóságot és a hibatűrést.

Egészségellenőrzés finomhangolása (Fine-tuning health checks)

Az egészségellenőrzések kulcsfontosságúak, de a helytelen konfigurációjuk problémákat okozhat. Túl agresszív ellenőrzések (túl gyakori, túl alacsony hibahatár) esetén a terheléselosztó feleslegesen kivehet működő szervereket a poolból, ami instabilitáshoz vagy kapacitáshiányhoz vezethet. Túl laza ellenőrzések (túl ritka, túl magas hibahatár) esetén viszont a terheléselosztó túl sokáig küldhet forgalmat egy már meghibásodott szerverre, rontva a felhasználói élményt.

Az egészségellenőrzéseket az alkalmazás specifikus igényeihez kell igazítani. Fontos, hogy ne csak a szerver elérhetőségét, hanem az alkalmazás működőképességét is ellenőrizzék (pl. adatbázis-kapcsolat, kritikus szolgáltatások elérése). Az ellenőrzések paramétereit (időintervallum, timeout, sikertelen próbálkozások száma) gondosan be kell állítani, és folyamatosan monitorozni kell a hatékonyságukat.

Biztonsági aspektusok (Security aspects)

A terheléselosztó egy kritikus pont az infrastruktúrában, és mint ilyen, kiemelt biztonsági figyelmet igényel. Mivel ez az első védelmi vonal a bejövő forgalommal szemben, fontos, hogy maga a terheléselosztó is megfelelően védett legyen. Ez magában foglalja a rendszeres frissítéseket, a felesleges portok és szolgáltatások letiltását, a hozzáférés-szabályozás (ACL-ek) megfelelő beállítását, valamint a biztonsági naplózást.

A WAF funkciók bekapcsolása és finomhangolása elengedhetetlen a webes támadások (pl. SQL injection, XSS) ellen. A DDoS védelem konfigurálása szintén kulcsfontosságú. Ezenkívül, ha SSL/TLS offloadingot használunk, gondoskodni kell arról, hogy a terheléselosztó és a háttérszerverek közötti kommunikáció is titkosított legyen (re-encryption), ha az érzékeny adatokat kezel.

Monitoring és naplózás (Monitoring and logging)

A terheléselosztási rendszer hatékony működésének biztosításához elengedhetetlen a folyamatos monitoring és naplózás. Figyelni kell a terheléselosztó saját erőforrás-kihasználtságát (CPU, memória, hálózati forgalom), a mögötte lévő szerverek terhelését, a kapcsolatok számát, a válaszidőket, valamint az egészségellenőrzések állapotát. A részletes naplók (access logs, error logs) segítenek azonosítani a problémákat, hibaelhárítani és optimalizálni a konfigurációt.

A monitoring rendszerek (pl. Prometheus, Grafana, ELK Stack) integrálása a terheléselosztóval lehetővé teszi a valós idejű betekintést a rendszer teljesítményébe és segít proaktívan reagálni a felmerülő problémákra. A naplók központosított gyűjtése és elemzése (log aggregation) pedig elengedhetetlen a hibakereséshez és a biztonsági auditokhoz.

Költségek (Costs)

A terheléselosztás bevezetése jelentős költségekkel járhat, különösen a hardveres megoldások esetében. Ezek a költségek magukban foglalják a berendezések beszerzését, a licenceket, a karbantartást és a szakértelmet. A szoftveres megoldások olcsóbbak lehetnek, de még ezek is hardvererőforrásokat és üzemeltetési szakértelmet igényelnek. A felhőalapú terheléselosztók „pay-as-you-go” modellje rugalmas, de nagy forgalom esetén a költségek gyorsan emelkedhetnek.

Fontos a teljes birtoklási költség (TCO – Total Cost of Ownership) alapos elemzése a döntéshozatal előtt. Mérlegelni kell a kezdeti beruházást, az üzemeltetési költségeket, a skálázhatóság költségeit és a lehetséges megtakarításokat a megnövekedett rendelkezésre állás és teljesítmény révén. A megfelelő terheléselosztási megoldás kiválasztása mindig egy egyedi mérlegelési folyamat, amely figyelembe veszi az üzleti igényeket és a rendelkezésre álló erőforrásokat.

Gyakori terheléselosztó szoftverek és megoldások

A terheléselosztás megvalósítására számos szoftveres és felhőalapú megoldás létezik, amelyek különböző funkciókat, teljesítményt és rugalmasságot kínálnak. A választás az infrastruktúra típusától, a forgalmi igényektől, a költségvetéstől és a technikai szakértelemtől függ.

NGINX

Az NGINX (ejtsd: engine-x) egy népszerű nyílt forráskódú web szerver, reverse proxy és terheléselosztó. Rendkívül hatékony és skálázható, képes statikus tartalmakat rendkívül gyorsan kiszolgálni, és kiválóan alkalmas Layer 7 terheléselosztásra HTTP/HTTPS forgalom esetén. Az NGINX Plus, a fizetős verzió, további funkciókat kínál, mint például fejlettebb egészségellenőrzések, munkamenet-ragadósság és dinamikus konfiguráció.

Az NGINX előnyei közé tartozik a nagy teljesítmény, az alacsony erőforrás-felhasználás, a rugalmas konfiguráció, a széles körű moduláris bővíthetőség és a nagy közösségi támogatás. Széles körben használják webes alkalmazások, API gateway-ek és mikroszolgáltatás-architektúrák terheléselosztására.

HAProxy

A HAProxy (High Availability Proxy) egy másik népszerű nyílt forráskódú megoldás, amelyet kifejezetten terheléselosztásra és proxyzásra terveztek. Különösen ismert a megbízhatóságáról, a nagy teljesítményéről és a fejlett terheléselosztási algoritmusok széles skálájáról. Képes Layer 4 (TCP) és Layer 7 (HTTP/HTTPS) terheléselosztást is végezni.

A HAProxy erősségei közé tartozik a robusztus egészségellenőrzési mechanizmus, a fejlett munkamenet-ragadóssági opciók, a részletes statisztikák és a megbízható működés rendkívül nagy terhelés mellett is. Gyakran használják adatbázis-kapcsolatok (pl. MySQL), üzenetsorok (pl. RabbitMQ) és egyéb TCP alapú szolgáltatások terheléselosztására is, a HTTP/HTTPS forgalom mellett.

Apache HTTP Server (proxy modules)

Az Apache HTTP Server, a világ egyik legelterjedtebb web szervere, szintén képes terheléselosztási funkciókat ellátni a mod_proxy és mod_proxy_balancer modulok segítségével. Bár nem elsősorban terheléselosztóként tervezték, ezek a modulok alapvető Layer 7 terheléselosztási képességeket biztosítanak.

Előnye, hogy sok fejlesztő és rendszergazda már ismeri az Apache-ot, így a konfiguráció is viszonylag egyszerű lehet számukra. Hátránya, hogy általában alacsonyabb teljesítményt nyújt, mint a dedikált terheléselosztók (NGINX, HAProxy), és a fejlett funkciók terén is korlátozottabb. Leginkább kisebb projektekhez vagy meglévő Apache alapú infrastruktúrák bővítésére alkalmas.

Envoy Proxy

Az Envoy Proxy egy modern, nyílt forráskódú, nagy teljesítményű edge/service proxy, amelyet a Lyft fejlesztett ki, és ma már a Cloud Native Computing Foundation (CNCF) projektje. Célja, hogy egységes hálózati réteget biztosítson a mikroszolgáltatás-architektúrákban. Rendkívül rugalmas és konfigurálható, támogatja a Layer 3/4 és Layer 7 terheléselosztást is.

Az Envoy kiemelkedő képességei közé tartozik a dinamikus konfiguráció, a fejlett megfigyelhetőség (observability), a beépített hibatűrési mechanizmusok (pl. circuit breaking, retries), valamint a széles körű protokoll-támogatás. Ideális választás konténerizált környezetekhez, Kubernetes klaszterekhez és service mesh architektúrákhoz (pl. Istio részeként), ahol a dinamikus és elosztott terheléselosztás kritikus.

Felhő szolgáltatók natív megoldásai

Ahogy korábban is említettük, a nagy felhőszolgáltatók (AWS, Azure, Google Cloud) saját, menedzselt terheléselosztási szolgáltatásokat kínálnak. Ezek a megoldások szorosan integrálódnak a felhőplatform többi szolgáltatásával (pl. autoscaling, DNS, WAF), és rendkívül skálázhatók, megbízhatóak és könnyen használhatók.

Például az AWS Elastic Load Balancing (ELB) különböző típusokkal (ALB, NLB, GLB) fedi le a Layer 4 és Layer 7 igényeket, az Azure Load Balancer és Application Gateway hasonló funkcionalitást nyújtanak, míg a Google Cloud Load Balancing globális, szoftveresen definiált hálózati képességeivel tűnik ki. Ezek a szolgáltatások ideálisak a felhőben futó alkalmazásokhoz, mivel tehermentesítik az üzemeltetőket a terheléselosztó infrastruktúrájának kezelésétől, és automatikusan skálázódnak a forgalmi igényeknek megfelelően.

A választás során figyelembe kell venni a felhőfüggőséget, az árképzést és a specifikus funkcionalitási igényeket. Bár kényelmesek, a felhőalapú megoldások korlátozhatják a testreszabhatóságot bizonyos speciális esetekben, és hosszú távon magasabb költségekkel járhatnak, mint a saját üzemeltetésű szoftveres megoldások.

A terheléselosztás jövője: Mesterséges intelligencia és gépi tanulás

A technológia folyamatos fejlődésével a terheléselosztás is egyre intelligensebbé válik. A mesterséges intelligencia (MI) és a gépi tanulás (ML) integrálása új dimenziókat nyit meg a terheléselosztási stratégiákban, lehetővé téve a rendszerek számára, hogy proaktívan optimalizálják a teljesítményt, növeljék a rendelkezésre állást és adaptálódjanak a változó körülményekhez.

Adaptív algoritmusok

A hagyományos terheléselosztási algoritmusok gyakran statikus szabályokon alapulnak, vagy csak az azonnali metrikákat veszik figyelembe. Az MI és ML alapú adaptív algoritmusok képesek tanulni a múltbeli adatokból és a valós idejű metrikákból (pl. CPU kihasználtság, memória használat, I/O, hálózati késleltetés, alkalmazás-specifikus teljesítményindikátorok). Ezáltal képesek előre jelezni a terhelési mintákat, a szerverek viselkedését és a lehetséges szűk keresztmetszeteket.

Egy ilyen rendszer képes dinamikusan módosítani a terheléselosztási súlyokat, kiválasztani a legmegfelelőbb algoritmust, vagy akár proaktívan elindítani új erőforrásokat, mielőtt a terhelés kritikus szintet érne el. Ez a megközelítés sokkal hatékonyabb és reszponzívabb, mint a manuális konfiguráció vagy a reaktív skálázás.

Proaktív hibaelhárítás

Az MI-alapú terheléselosztók nem csupán a hibás szervereket tudják felismerni, hanem képesek lehetnek előre jelezni a hibákat is, még mielőtt azok bekövetkeznének. A gépi tanulási modellek elemzik a szerverek teljesítményadatait, a naplókat és az egészségellenőrzési eredményeket, és képesek azonosítani azokat az anomáliákat, amelyek egy közelgő meghibásodásra utalnak. Például, ha egy szerver válaszideje fokozatosan romlik, vagy a hibaaránya lassan emelkedik, az MI rendszer figyelmeztetést adhat, vagy akár automatikusan kiveheti a szervert a forgalom elosztásából, mielőtt az teljesen leállna. Ez minimalizálja a szolgáltatáskimaradások kockázatát és javítja a rendszer általános megbízhatóságát.

Automatizált optimalizálás

A jövő terheléselosztási rendszerei képesek lesznek teljesen automatizált optimalizálásra. Ez azt jelenti, hogy a terheléselosztó nem csupán a forgalmat osztja el, hanem aktívan kezeli az egész infrastruktúrát. Például, képes lesz:

- Automatizáltan skálázni az erőforrásokat a felhőben, figyelembe véve a költségeket és a teljesítményt.

- Dinamikusan allokálni a hálózati sávszélességet a különböző szolgáltatások között.

- Optimalizálni a kérés útvonalát a hálózati torlódások elkerülése érdekében.

- A/B tesztelést vagy kanári bevezetést (canary deployment) támogatni a forgalom intelligens elosztásával az új verziók tesztelésére.

Ez a szintű automatizálás jelentősen csökkenti az emberi beavatkozás szükségességét, növeli a rendszer agilitását és lehetővé teszi a mérnökök számára, hogy komplexebb feladatokra koncentráljanak. Az MI és ML bevezetése a terheléselosztásba nem csupán a technikai képességeket bővíti, hanem alapjaiban változtatja meg az infrastruktúra menedzsmentjét, egy öntanuló, önoptimalizáló rendszerré alakítva azt.

Esettanulmányok és gyakorlati példák

A terheléselosztás nem egy elméleti koncepció, hanem a modern digitális világ mindennapi valósága. Szinte minden nagy online szolgáltatás, amellyel naponta találkozunk, terheléselosztást alkalmaz a zökkenőmentes működés érdekében. Néhány példa a teljesség igénye nélkül:

Webáruházak (E-commerce sites)

Egy nagy webáruház számára a terheléselosztás létfontosságú. Képzeljünk el egy Black Friday akciót, ahol a forgalom hirtelen tízszeresére ugrik. A terheléselosztó gondoskodik arról, hogy a több ezer egyidejű vásárló kérése eljusson a rendelkezésre álló szerverekhez anélkül, hogy a rendszer összeomlana. A kosárba helyezés, a termékoldalak megtekintése és a fizetési folyamatok mind-mind terheléselosztón keresztül jutnak el a háttérrendszerhez. Az egészségellenőrzések biztosítják, hogy ha egy szerver meghibásodik, a vásárlók továbbra is be tudják fejezni a tranzakcióikat, elkerülve a bevételkiesést.

Streaming szolgáltatások (Streaming services)

A Netflix, YouTube vagy Spotify típusú streaming szolgáltatások hatalmas mennyiségű adatot és felhasználót kezelnek globálisan. A terheléselosztás itt kulcsfontosságú a videó- és hangtartalmak gyors és megszakítás nélküli továbbításához. A GSLB (Globális Szerver Terheléselosztás) irányítja a felhasználókat a számukra legközelebbi adatközponthoz, minimalizálva a késleltetést és optimalizálva a sávszélesség-használatot. A Layer 7 terheléselosztók pedig képesek a tartalomtípusok alapján különböző szerverekhez irányítani a kéréseket (pl. filmek a videó szerverekhez, felhasználói profilok az adatbázis szerverekhez), tovább javítva a teljesítményt.

Banki rendszerek (Banking systems)

A banki rendszerek és online pénzügyi szolgáltatások számára a rendelkezésre állás, a megbízhatóság és a biztonság a legfontosabb. Egy banki alkalmazásban a tranzakciók feldolgozása, a számlaegyenlegek lekérdezése és a biztonságos bejelentkezés mind terheléselosztón keresztül történik. Itt a Layer 4 és Layer 7 terheléselosztás kombinációja biztosítja a magas rendelkezésre állást és a hibatűrést. A WAF funkciók védelmet nyújtanak a kiberbiztonsági támadások ellen, míg a robusztus egészségellenőrzések garantálják, hogy minden kritikus rendszer működőképes maradjon.

Ezek a példák jól mutatják, hogy a terheléselosztás nem csak egy technikai részlet, hanem egy alapvető stratégiai komponens, amely lehetővé teszi a modern digitális szolgáltatások megbízható, gyors és skálázható működését a mai, rendkívül igényes online környezetben.