A mesterséges intelligencia (MI) területén az elmúlt években a nagyméretű nyelvi modellek (LLM-ek) robbanásszerű fejlődésen mentek keresztül, forradalmasítva a gépi szövegértést és -generálást. Ezek a modellek, mint a GPT-3, GPT-4 vagy a LLaMA, képesek koherens, kontextuálisan releváns és gyakran meglepően kreatív szövegeket alkotni, kérdésekre válaszolni, nyelveket fordítani és akár programkódot is írni. Képességeik azonban nem korlátlanok. A tréningkorpuszuk mérete és frissessége, valamint a belső reprezentációikból fakadó inherens bizonytalanságok gyakran vezetnek úgynevezett hallucinációkhoz, amikor a modell ténybeli tévedéseket vagy nem létező információkat generál. Ezen korlátok áthidalására született meg a Retrieval-Augmented Language Model (RALM) koncepciója, amely egy új paradigmát képvisel a nyelvi modellek világában, ötvözve a generatív képességeket a valós idejű információ-visszakereséssel.

A nagyméretű nyelvi modellek (LLM) alapjai és korlátai

Mielőtt mélyebben belemerülnénk a RALM működésébe, érdemes röviden áttekinteni, honnan is érkezünk, és milyen kihívásokra keressük a választ. A modern LLM-ek alapja a transzformer architektúra, amely lehetővé tette a szövegekben lévő hosszú távú függőségek hatékony modellezését. Ezek a modellek hatalmas mennyiségű szöveges adaton – internetes oldalakon, könyveken, cikkeken – tréningeznek, és a tréning során megtanulják a nyelvi mintázatokat, a szavak közötti kapcsolatokat, a nyelvtani szabályokat és a világ bizonyos aspektusairól szóló tudást.

A tréning célja általában a következő szó megjóslása egy adott szövegkörnyezetben. Ezzel a módszerrel a modell egy rendkívül komplex statisztikai reprezentációt épít fel a nyelv struktúrájáról és szemantikájáról. A kimenetei azonban alapvetően valószínűségi eloszlásokon alapulnak, nem pedig tények közvetlen lekérdezésén. A modell a tréningadataiban látott mintázatok alapján generál, és ha egy tényről nincs egyértelmű vagy friss információ a tréningkorpuszban, vagy ha több, egymásnak ellentmondó információval találkozott, hajlamos a konfabulációra, azaz kitalált, de koherensnek tűnő válaszok gyártására.

A legfőbb kihívások, amelyekkel az önálló LLM-ek szembesülnek, a következők:

- Hallucináció és pontatlanság: Ahogy már említettük, a modellek képesek meggyőzően hangzó, de téves információkat generálni. Ez különösen problémás lehet olyan területeken, ahol a pontosság kulcsfontosságú, mint például az orvostudomány, a jog vagy a pénzügyek.

- Tudás frissessége: Az LLM-ek tudása a tréningkorpusz lezárásának időpontjában rögzül. Egy 2023-ban tréningezett modell nem tud a 2024-es eseményekről, hacsak nem történik újratanítás, ami rendkívül költséges és időigényes folyamat.

- Átláthatóság és magyarázhatóság hiánya: Az LLM-ek „fekete dobozként” működnek. Nehéz megérteni, miért adtak egy bizonyos választ, és honnan származik az adott információ. Ez megnehezíti a hibakeresést és a bizalom kiépítését.

- Kontextusfüggőség korlátai: Bár a transzformerek képesek hosszú kontextusokat kezelni, van egy felső határa annak, hogy mennyi bemeneti szöveget tudnak egyszerre feldolgozni. A nagyon hosszú, komplex dokumentumok vagy beszélgetések kezelése nehézségekbe ütközhet.

- Számítási költségek: Az LLM-ek tréningje és futtatása hatalmas számítási erőforrásokat igényel, ami korlátozza a kisebb szervezetek hozzáférését és a gyakori frissítések lehetőségét.

„A nagyméretű nyelvi modellek ereje lenyűgöző, de korlátaik rávilágítottak arra, hogy a puszta generáció nem elegendő. Szükség van egy mechanizmusra, amely a modell belső tudását külső, megbízható forrásokkal egészíti ki.”

Mi az a Retrieval-Augmented Language Model (RALM)? A definíció

A Retrieval-Augmented Language Model (RALM), vagy magyarul visszakeresés-kiegészített nyelvi modell, egy olyan hibrid architektúra, amely a hagyományos generatív nyelvi modellek képességeit ötvözi az információ-visszakereső rendszerek (Information Retrieval, IR) erejével. Lényegében a RALM egy „nyelvi modell könyvtárossal”, ahol a modell nem csak a saját belső, tréning során megszerzett tudására támaszkodik, hanem képes releváns információkat keresni és felhasználni egy külső, dinamikus tudásbázisból, mielőtt választ generálna.

Ez a megközelítés gyökeresen változtatja meg a nyelvi modellek működését. Ahelyett, hogy kizárólag a paramétereikbe „beleégetett” tudásból merítenének, a RALM-ek proaktívan keresnek megerősítő vagy kiegészítő tényeket. Ezáltal a generált válaszok nem csak koherensebbek és relevánsabbak lesznek, hanem sokkal pontosabbak és tényalapúbbak is, minimalizálva a hallucinációk kockázatát.

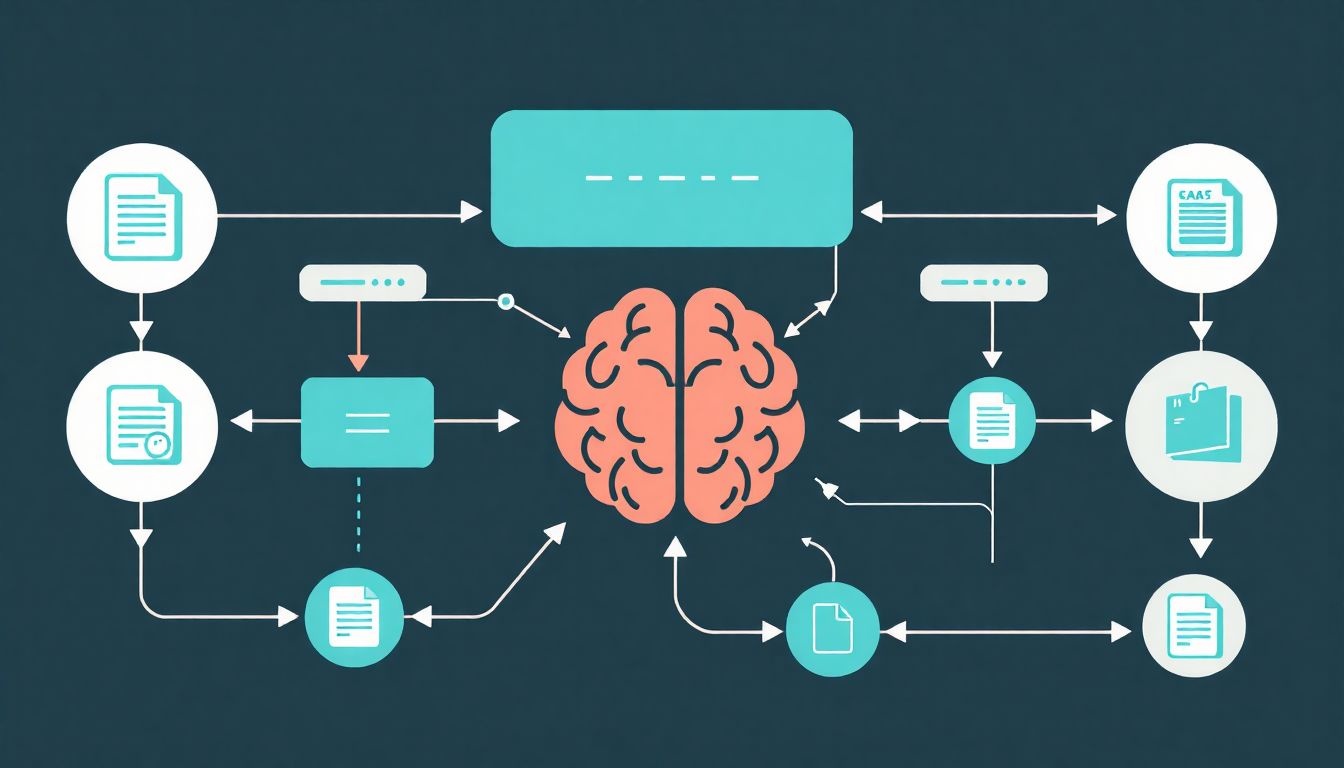

A RALM lényegében két fő komponensből áll, amelyek szinergikusan működnek együtt:

- Retriever (visszakereső): Ennek feladata, hogy egy adott felhasználói lekérdezés vagy kontextus alapján releváns dokumentumokat, szövegrészleteket vagy adatokat keressen egy nagyméretű, külső tudásbázisban.

- Generator (generátor): Ez a komponens egy hagyományos nagyméretű nyelvi modell, amely a felhasználói lekérdezést és a retriever által talált releváns információkat együttesen felhasználva generálja a végső választ.

Ez a kettős megközelítés lehetővé teszi, hogy a modell a legfrissebb és legrelevánsabb információkhoz férjen hozzá, így áthidalva az LLM-ek tudásfrissességi és pontossági korlátait.

A RALM architektúrájának részletes felépítése és komponensei

A RALM-ek működésének mélyebb megértéséhez elengedhetetlen az architektúrájuk részletesebb vizsgálata. Ahogy már említettük, a rendszer két fő, egymással szorosan együttműködő részből áll: a retrieverből és a generátorból.

A retriever komponens: a tudás felkutatója

A retriever a RALM „könyvtárosa”. Feladata, hogy a felhasználó lekérdezése (query) alapján releváns információkat találjon egy előre definiált, nagyméretű tudásbázisban. Ez a tudásbázis bármilyen strukturált vagy strukturálatlan adathalmaz lehet, például weboldalak gyűjteménye, vállalati dokumentumok, tudományos cikkek, adatbázisok vagy akár szakszövegek. A retriever hatékonysága alapvetően meghatározza a RALM teljesítményét, hiszen ha nem találja meg a megfelelő információt, a generátor sem tud pontos választ adni.

A tudásbázis felépítése és indexelése

A retriever nem keres „élőben” az interneten, hanem egy előre feldolgozott és indexelt tudásbázison dolgozik. Ez az indexelés kulcsfontosságú a gyors és hatékony visszakereséshez. A dokumentumokat általában kisebb egységekre, úgynevezett chunkokra (szövegrészletekre) bontják, amelyek egyenként is releváns információkat tartalmazhatnak. Ezeket a chunkokat aztán valamilyen módon reprezentálják, hogy a keresés hatékony legyen.

- Lexikális indexelés: Hagyományosabb módszerek, mint például a BM25 vagy a TF-IDF (Term Frequency-Inverse Document Frequency), amelyek a szavak előfordulási gyakoriságán és fontosságán alapulnak. Ezek gyorsak és jól működnek pontos kulcsszavas keresés esetén, de nem értik a szöveg szemantikai jelentését.

- Vektoros indexelés (embeddingek): A modern retrieverek gyakran használnak neurális hálózatokat a dokumentumok és a lekérdezések numerikus vektorokká (embeddingekké) alakítására. Ezek a vektorok a szövegek szemantikai jelentését kódolják, így a hasonló jelentésű szövegek vektorai közel helyezkednek el egymáshoz egy többdimenziós térben. A keresés ekkor a lekérdezés embeddingjéhez legközelebb eső dokumentum embeddingek megtalálását jelenti, például koszinusz hasonlóság alapján. Ez a módszer sokkal rugalmasabb és jobban kezeli a szinonimákat, parafrázisokat.

Retriever modellek és technikák

A retriever komponens is lehet egy komplex neurális modell. Két fő típust különböztetünk meg:

- Sparse Retrieval (ritka visszakeresés): Olyan technikák, amelyek a kulcsszavakra és azok előfordulására fókuszálnak. Ide tartozik a már említett BM25. Előnye a gyorsaság és az egyszerűség, hátránya, hogy nem érti a szemantikai hasonlóságot.

- Dense Retrieval (sűrű visszakeresés): Neurális hálózatokon alapuló módszerek, amelyek a szövegek szemantikai jelentését használják fel a hasonlóság megállapítására. Ide tartoznak a DPR (Dense Passage Retrieval) és az ANCE (Approximate Nearest Neighbor Negative Contrastive Learning for Effificient Dense Retrieval) modellek. Ezek a modellek egy lekérdezést és egy dokumentumot is embeddinggé alakítanak, majd a két embedding közötti távolság alapján ítélik meg a relevanciát. Ez a megközelítés sokkal hatékonyabb a komplex, szemantikai alapú kérdések megválaszolásában.

A retriever kimenete általában egy rangsorolt lista a legrelevánsabbnak ítélt szövegrészletekből vagy dokumentumokból. Ezeket a „bizonyítékokat” (evidence) továbbítja a generátor felé.

A generator komponens: a válasz szintetizálója

A generátor a RALM másik kulcseleme, amely a modern nagyméretű nyelvi modellek alapjain nyugszik. Feladata, hogy a felhasználói lekérdezést és a retriever által szolgáltatott releváns információkat felhasználva egy koherens, pontos és értelmes választ állítson elő. A generátor a retrieved információkat kontextusként építi be a bemenetébe, mintha a felhasználó maga adta volna meg azokat a kiegészítő tényeket.

A retrieved információk beépítése

A generátor számára az a kihívás, hogy a visszakeresett információkat hatékonyan integrálja a saját belső tudásába és a felhasználói lekérdezésbe. Ez általában a prompt engineering technikáival történik, ahol a lekérdezést és a retrieved chunkokat egyetlen, jól strukturált prompttá fűzik össze. Például:

"Kérdés: [Felhasználói kérdés]

Kontextus: [Retrieved chunk 1]

Kontextus: [Retrieved chunk 2]

...

Kontextus: [Retrieved chunk N]

Válasz: "Ezáltal a generátor képes lesz a retrieved információkat prioritásként kezelni a válasz generálásakor, csökkentve a hallucinációk esélyét és növelve a tényalapúságot. A modell ekkor nem csak „emlékszik” valamire a tréningadatokból, hanem „elolvassa” a frissen előkeresett tényeket, mielőtt válaszol.

A generátor technológiák

A generátor komponens lehet bármilyen erős, transzformer alapú LLM, mint például a T5, a GPT-sorozat, vagy akár a BERT finomhangolt verziói. A lényeg, hogy képes legyen a bemeneti kontextus (a lekérdezés és a retrieved információk) alapján releváns és koherens szöveget generálni. A RALM architektúra egyik szépsége, hogy a generátor modelljét nem feltétlenül kell újra tréningezni a visszakeresés képességének elsajátításához; elegendő, ha képes a kiterjesztett kontextust hatékonyan feldolgozni.

Az interakció és integráció: a két komponens szinergiája

A RALM ereje abban rejlik, hogy a retriever és a generátor nem különállóan működik, hanem szorosan együttműködik. A folyamat dinamikus és iteratív is lehet, bár a legegyszerűbb implementációk szekvenciálisak.

- A felhasználó kérdést tesz fel.

- A retriever feldolgozza a kérdést és releváns dokumentumokat keres a tudásbázisban.

- A retriever a legrelevánsabb dokumentumokat (vagy azok részleteit) továbbítja a generátor felé.

- A generátor a kérdéssel és a retrieved dokumentumokkal kiegészítve generálja a választ.

Ez az integráció biztosítja, hogy a generált válaszok ne csak nyelvtanilag helyesek és folyékonyak legyenek, hanem tényalapúak és naprakészek is, a külső forrásoknak köszönhetően.

A RALM működési folyamata lépésről lépésre

A Retrieval-Augmented Language Model (RALM) működésének megértéséhez érdemes egy tipikus interakciót lépésről lépésre végigkövetni. Ez a folyamat bemutatja, hogyan koordinálja a két fő komponens, a retriever és a generátor, a feladatát a felhasználói lekérdezés megválaszolása érdekében.

1. Felhasználói lekérdezés fogadása

A folyamat egy felhasználói lekérdezéssel indul, amely lehet egy egyszerű kérdés, egy összetett utasítás vagy akár egy beszélgetés folytatása. Például: „Ki volt Kölcsey Ferenc és mikor írta a Himnuszt?”

2. A lekérdezés elemzése és a retriever előkészítése

A rendszer először elemzi a beérkező lekérdezést. Ez magában foglalhatja a kulcsszavak kinyerését, a kérdés típusának azonosítását, vagy – modernebb rendszerek esetén – a lekérdezés embeddingjének (vektoros reprezentációjának) előállítását egy neurális hálózat segítségével. Ez az embedding teszi lehetővé, hogy a retriever ne csak a pontos kulcsszavakra, hanem a lekérdezés szemantikai jelentésére is keressen.

3. Információ-visszakeresés a tudásbázisból

A retriever a feldolgozott lekérdezést felhasználva keresést indít a külső tudásbázisban.

- Ha a rendszer lexikális alapú retrievert használ, akkor a kulcsszavak alapján keresi meg a releváns dokumentumokat vagy szövegrészleteket.

- Ha neurális (dense) retrievert alkalmaz, akkor a lekérdezés embeddingjéhez legközelebb eső dokumentum embeddingeket azonosítja a vektoros adatbázisban.

Ez a lépés a kulcsa annak, hogy a RALM hozzáférjen a naprakész és tényalapú információkhoz, amelyek nincsenek feltétlenül beégetve a generátor modelljének paramétereibe.

4. A visszakeresett dokumentumok rangsorolása és szűrése

A retriever általában több potenciálisan releváns dokumentumot vagy szövegrészletet (chunkot) talál. Ezeket a rendszer rangsorolja a relevancia mértéke szerint. A legrelevánsabbnak ítélt top-N számú chunk kerül kiválasztásra, amelyet aztán a generátor számára készítenek elő. Előfordulhat, hogy a rendszer egy további, úgynevezett reranker (újrarangsoroló) komponenst is használ, amely finomítja a retriever által visszaadott eredmények sorrendjét, még pontosabb relevancia-értékelést biztosítva.

5. A releváns információk beépítése a generátor promptjába

Ez a lépés a RALM működésének egyik legfontosabb része. A kiválasztott releváns szövegrészleteket a rendszer beépíti a generátor bemenetére szánt promptba. A prompt gondos kialakítása (prompt engineering) kritikus a sikeres válaszgeneráláshoz. A retrieved információkat gyakran egy speciális formátumban, például „Kontextus: [szövegrészlet]” elrendezésben adják át a kérdés mellé. Ez segíti a generátort abban, hogy a kapott információkat prioritásként kezelje.

6. A generátor válaszának előállítása

A generátor, amely egy nagyméretű nyelvi modell, megkapja az összeállított promptot (felhasználói kérdés + retrieved kontextus). Ezen információk alapján generálja a válaszát. A generátor ekkor nem csak a saját belső tudására támaszkodik, hanem a frissen kapott külső tényekre is. Ezáltal a válasz sokkal pontosabbá, tényalapúbbá és relevánsabbá válik, minimalizálva a hallucinációk kockázatát.

Példánkban a generátor a retrieved információk (Kölcsey Ferenc életrajza, a Himnusz keletkezésének körülményei és dátuma) alapján egy összefüggő és pontos választ alkotna: „Kölcsey Ferenc (1790–1838) magyar költő, irodalomtudós, politikus és nyelvújító volt. A Himnuszt, Magyarország nemzeti himnuszát 1823. január 22-én írta meg Szatmárcsekén.”

7. A válasz finomhangolása és ellenőrzése (opcionális)

Bizonyos fejlettebb RALM rendszerekben a generált válasz egy további ellenőrzési fázison is áteshet. Ez magában foglalhatja a tények ellenőrzését a tudásbázisban, a nyelvtani hibák javítását, vagy akár a válasz további finomítását egy másik, kisebb nyelvi modell segítségével. Célja a kimenet minőségének további javítása és a lehetséges hibák kiszűrése.

„A RALM nem csupán adatokhoz fér hozzá, hanem intelligensen integrálja azokat, lehetővé téve a modellek számára, hogy túllépjenek a puszta emlékezésen, és ténylegesen »megértsék« a külső információkat.”

A Retrieval-Augmented Language Model (RALM) kulcsfontosságú előnyei

A RALM architektúra számos jelentős előnnyel jár a hagyományos, önálló nagyméretű nyelvi modellekhez képest. Ezek az előnyök teszik a RALM-et különösen vonzóvá olyan alkalmazások számára, ahol a pontosság, a naprakészség és a megbízhatóság kritikus fontosságú.

Pontosság és tényalapúság: a hallucinációk csökkentése

Talán a RALM legfontosabb előnye, hogy drámaian csökkenti az LLM-ek hallucinációs hajlamát. Mivel a generátor nem kizárólag a tréningadataiban lévő belső reprezentációkra támaszkodik, hanem a retriever által szolgáltatott, külső, valós adatokra, a generált válaszok sokkal inkább tényalapúak lesznek. A modell képes lesz ellenőrizni és megerősíteni az információkat, mielőtt kijelenti azokat, így jelentősen növelve a kimenet megbízhatóságát.

Frissesség: naprakész információk kezelése

Az LLM-ek egyik legnagyobb korlátja a tudásfrissesség problémája. A tréningadatok lezárása után bekövetkező eseményekről nem tudnak. A RALM ezt a problémát elegánsan áthidalja. A külső tudásbázis dinamikusan frissíthető, anélkül, hogy a generátor modellt újra kellene tréningezni. Ez azt jelenti, hogy a RALM rendszerek képesek a legfrissebb hírekre, adatokra vagy eseményekre hivatkozni, ami kritikus a gyorsan változó területeken, mint például a pénzügy, az orvostudomány vagy a technológia.

Átláthatóság és magyarázhatóság (explainability)

A hagyományos LLM-ek „fekete dobozok”, amelyeknek a válaszait nehéz nyomon követni. A RALM ezzel szemben forrásmegjelölési lehetőséget kínál. Mivel a generátor konkrét dokumentumokból vagy szövegrészletekből meríti az információkat, képes lehet hivatkozni ezekre a forrásokra. Ez növeli az átláthatóságot, lehetővé teszi a felhasználók számára, hogy ellenőrizzék az információk eredetét, és segíti a bizalom kiépítését a rendszer iránt.

Csökkentett tréningköltségek és erőforrás-igény

A nagyméretű nyelvi modellek újratanítása (fine-tuningja) vagy teljes újratréningje rendkívül drága és erőforrás-igényes folyamat. A RALM esetében, ha a tudásbázis frissül, általában elegendő csak az indexet frissíteni, és nem kell a generátor modellt újra tréningezni. Ez jelentős költség- és időmegtakarítást jelent, és lehetővé teszi a modellek gyorsabb adaptálását új információkhoz vagy doménekhez.

Kontextuális mélység és domain-specifikus alkalmazhatóság

A RALM képessé teszi a nyelvi modelleket, hogy sokkal hosszabb és specifikusabb kontextust kezeljenek, mint amit a bemeneti ablakuk korlátai egyébként megengednének. A retriever által szolgáltatott információk gyakorlatilag kiterjesztik a modell „memóriáját”. Emellett a tudásbázis testre szabható egy adott doménre (pl. orvosi szakirodalom, jogi dokumentumok, vállalati belső szabályzatok), így a RALM rendszerek rendkívül hatékonyan alkalmazhatók specifikus iparágakban vagy vállalatokon belül, ahol a generátor modellje önmagában nem rendelkezne a szükséges mélységű tudással.

Rugalmasság és adaptálhatóság

A RALM rendszerek rendkívül rugalmasak. A tudásbázis könnyen módosítható, bővíthető vagy cserélhető, anélkül, hogy a generátor modelljét érintené. Ez lehetővé teszi, hogy a rendszer gyorsan alkalmazkodjon változó igényekhez, új adatforrásokhoz vagy akár különböző nyelvekhez, amennyiben a tudásbázis és a retriever támogatja az adott nyelvet.

Ez a kombinált megközelítés lényegében egy „plug-and-play” megoldást kínál, ahol a generatív képességek egy dinamikus és frissíthető tudásforrással egészülnek ki, radikálisan javítva a nyelvi modellek teljesítményét és megbízhatóságát valós környezetben.

A RALM kihívásai és korlátai

Bár a Retrieval-Augmented Language Model (RALM) számos előnnyel jár, fontos megjegyezni, hogy ez a technológia sem hibátlan, és számos kihívással, illetve korláttal szembesül. Ezeknek az akadályoknak a megértése kulcsfontosságú a RALM rendszerek sikeres tervezéséhez és implementálásához.

A retriever minősége: a „garbage in, garbage out” elv

A RALM rendszer teljesítménye nagymértékben függ a retriever komponens minőségétől. Ha a retriever nem találja meg a releváns információkat, vagy rossz minőségű, félrevezető adatokat szolgáltat, a generátor – még ha egyébként kiváló is – is pontatlan vagy téves válaszokat fog adni. Ez az úgynevezett „garbage in, garbage out” (szemét be, szemét ki) elv itt különösen érvényes. A retriever rossz teljesítménye fakadhat rossz indexelésből, nem megfelelő embeddingekből, vagy egy gyengén felépített tudásbázisból.

Skálázhatóság és a tudásbázis kezelése

A RALM rendszerek nagyméretű tudásbázisokkal dolgoznak, amelyek akár több milliárd dokumentumot vagy szövegrészletet is tartalmazhatnak. Egy ilyen méretű adatbázis hatékony indexelése, karbantartása és a rajta történő gyors keresés komoly mérnöki kihívásokat támaszt. A vektoros adatbázisok (vector databases) és a hatékony, közelítőleg legközelebbi szomszéd keresési algoritmusok (Approximate Nearest Neighbor, ANN) elengedhetetlenek, de ezek implementálása és optimalizálása sem triviális feladat.

Komplexitás és integráció

A RALM két különálló, de egymással szorosan összefüggő komponensből áll, amelyek integrációja komplex. A retriever és a generátor közötti kommunikáció, a retrieved információk megfelelő formázása a promptba, valamint a teljes rendszer optimalizálása jelentős fejlesztési és üzemeltetési erőfeszítéseket igényel. A hibakeresés is bonyolultabb lehet, mivel a hiba forrása lehet a retrieverben, a generátorban, vagy az interakciójukban.

Költségek és erőforrás-igény

Bár a RALM csökkenti a generátor modell újratréningjének költségeit, maga a rendszer fenntartása is jelentős erőforrásokat igényel. A tudásbázis indexelése és frissítése, a retriever futtatása (különösen a neurális modellek esetében), valamint a vektoros adatbázisok fenntartása mind komoly számítási és tárolási költségekkel járhatnak. Az alacsony latency (késleltetés) elérése nagy terhelés mellett különösen drága lehet.

Latency (késleltetés)

A RALM rendszerek esetében a válaszgenerálás folyamata magában foglalja az információ-visszakeresés lépését is, ami extra időt ad a teljes válaszidőhöz. Ez a latency kritikus lehet olyan valós idejű alkalmazásokban, mint például a chatbotok vagy az ügyfélszolgálati rendszerek, ahol a gyors válaszidő elengedhetetlen a jó felhasználói élményhez. A retriever optimalizálása a sebességre kompromisszumokat igényelhet a pontosság rovására.

Adatminőség és torzítások

A tudásbázis minősége alapvető. Ha a tudásbázis torzított, elavult, pontatlan vagy hiányos információkat tartalmaz, akkor a RALM rendszer is ezeket a hibákat fogja reprodukálni. A bias (torzítás) problémája itt is fennáll, hiszen a retriever által talált dokumentumok tükrözhetik a források torzításait, amelyeket a generátor aztán továbbadhat. A gondos adatgyűjtés, tisztítás és kurálás elengedhetetlen a megbízható RALM rendszerekhez.

A kimenet ellenőrzése és felülvizsgálata

Annak ellenére, hogy a RALM csökkenti a hallucinációkat, nem szünteti meg teljesen azokat. Előfordulhat, hogy a retriever nem találja meg a pontos választ, vagy a generátor tévesen értelmezi a retrieved információkat. Ezért a kritikusan fontos alkalmazásokban továbbra is szükség van az emberi felülvizsgálatra és ellenőrzésre, hogy biztosítsák a kimenet abszolút pontosságát és megbízhatóságát.

Ezek a kihívások rávilágítanak arra, hogy a RALM nem egy „plug-and-play” megoldás, hanem gondos tervezést, implementációt és folyamatos karbantartást igényel a maximális hatékonyság eléréséhez.

RALM alkalmazási területei és felhasználási példák

A Retrieval-Augmented Language Model (RALM) rendszerek sokoldalúságuk és megbízhatóságuk révén számos iparágban és alkalmazási területen forradalmasíthatják a munkavégzést és az információ-hozzáférést. Képesek áthidalni a hagyományos LLM-ek korlátait, különösen ott, ahol a pontosság, a frissesség és a tényalapúság kiemelten fontos.

Ügyfélszolgálat és chatbotok

Az egyik legkézenfekvőbb alkalmazási terület az ügyfélszolgálat. A RALM alapú chatbotok képesek azonnali, pontos és naprakész válaszokat adni az ügyfelek kérdéseire, egy vállalat termékeivel, szolgáltatásaival vagy szabályzataival kapcsolatban. A tudásbázis itt a gyakran ismételt kérdések (GYIK), termékleírások, hibaelhárítási útmutatók és belső dokumentációk lehet. Ez csökkenti az emberi ügynökök terhelését, javítja az ügyfélélményt és növeli a hatékonyságot.

Tudásmenedzsment és belső vállalati keresés

Nagyvállalatok esetében a belső tudásmenedzsment rendszerek hatékonysága kulcsfontosságú. A RALM segíthet a munkatársaknak gyorsan megtalálni a releváns információkat a hatalmas mennyiségű belső dokumentációban – legyen szó HR szabályzatokról, műszaki specifikációkról, jogi útmutatókról vagy projekttervekről. A rendszer képes összefoglalni a talált dokumentumokat és közvetlenül válaszolni a kérdésekre, anélkül, hogy a felhasználónak több száz oldalt kellene átolvasnia.

Kutatás és fejlesztés (K+F)

A tudományos kutatásban és fejlesztésben a RALM felgyorsíthatja az információgyűjtést. A kutatók pillanatok alatt áttekinthetik a legújabb publikációkat, szabadalmakat és kutatási eredményeket. A modell képes összefoglalni komplex tudományos cikkeket, rámutatni a kulcsfontosságú módszerekre vagy eredményekre, és még a forrásokat is megjelölni, ami elengedhetetlen a tudományos hitelességhez.

Tartalomgenerálás és újságírás

A tényalapú cikkek, jelentések, összefoglalók vagy akár hírek generálásában a RALM hatalmas segítséget nyújthat. Az újságírók és tartalomgyártók gyorsan ellenőrizhetik a tényeket, gyűjthetnek releváns adatokat és generálhatnak vázlatokat, amelyek garantáltan a valós információkra épülnek. Ez növeli a tartalom minőségét és hitelességét, miközben felgyorsítja a munkafolyamatokat.

Oktatás és e-learning

Az oktatási szektorban a RALM személyre szabott tanulási élményt biztosíthat. A diákok kérdéseket tehetnek fel egy adott tananyagról, és a rendszer pontos, forrásokkal alátámasztott válaszokat adhat. Képes lehet összefoglalni tankönyvfejezeteket, magyarázatot adni komplex fogalmakra, vagy akár tesztkérdéseket generálni, mindezt a legfrissebb tananyagok alapján.

Jogi és orvosi szektor

Ezeken a területeken a pontosság és a megbízhatóság életbevágó. A RALM segíthet a jogászoknak gyorsan áttekinteni a jogszabályokat, bírósági ítéleteket és jogi precedenseket. Az orvosok számára támogathatja a diagnózist, a kezelési protokollok keresését vagy a legújabb orvosi kutatások áttekintését, mindezt a legfrissebb orvosi adatbázisok és szakirodalom alapján. A rendszer a forrásokat is megjelölheti, ami kritikus a felelősségvállalás szempontjából.

Pénzügyi elemzés és befektetés

A pénzügyi elemzők számára a RALM segíthet a piaci trendek, vállalati jelentések és gazdasági adatok gyors feldolgozásában. A rendszer képes összefoglalni a legfrissebb pénzügyi híreket, elemzéseket készíteni a vállalati eredményekről, vagy adatokat szolgáltatni a befektetési döntések alátámasztásához, mindig a legfrissebb adatokra támaszkodva.

Ezek a példák csak ízelítőt adnak a RALM technológia hatalmas potenciáljából. Ahogy a technológia tovább fejlődik, valószínűleg egyre több és innovatívabb felhasználási módja jelenik meg, amelyek alapjaiban változtatják meg az információval való interakciónkat.

Jelentős RALM modellek és nyílt forráskódú implementációk

A Retrieval-Augmented Language Model (RALM) koncepciója számos kutatási projekt és nyílt forráskódú implementáció alapját képezi, amelyek mind a technológia fejlesztését, mind a szélesebb körű alkalmazását célozzák. Ezek a modellek és keretrendszerek lehetővé teszik a fejlesztők számára, hogy hatékonyan építsenek RALM alapú rendszereket.

RAG (Retrieval-Augmented Generation) – A Meta AI úttörője

Az egyik legkorábbi és legismertebb RALM implementáció a RAG (Retrieval-Augmented Generation), amelyet a Meta AI (korábban Facebook AI) mutatott be 2020-ban. A RAG modell egy DPR (Dense Passage Retrieval) retrievert használ, amely a lekérdezés és a dokumentumok embeddingjei alapján keres. A generátor komponensként egy finomhangolt BART modellt alkalmaz. A RAG modell képes volt jelentősen felülmúlni a tisztán generatív modelleket a nyílt tartományú kérdés-válasz (open-domain question answering) feladatokban, bizonyítva a visszakeresés alapú kiterjesztés hatékonyságát.

A RAG modell kulcsfontosságú jellemzője, hogy a retriever és a generátor komponenseket együtt tréningezik (end-to-end training). Ez azt jelenti, hogy a tréning során a rendszer megtanulja, hogy mely dokumentumokat érdemes visszakeresni ahhoz, hogy a generátor a legjobb választ adja, optimalizálva a teljes folyamatot a végcél, a pontos válaszgenerálás érdekében.

REALM (Retrieval-Augmented Language Model) – A Google megközelítése

A Google által fejlesztett REALM (Retrieval-Augmented Language Model) egy másik fontos korai RALM modell. A REALM is end-to-end módon tréningezhető, és célja, hogy a nyelvi modell a tréning során megtanulja, mikor és hogyan kell információt visszakeresni egy külső tudásbázisból. A REALM a BERT alapú architektúrára épül, és képes volt javítani a tényalapú kérdés-válasz feladatokon, demonstrálva a visszakeresés értékét a nyelvi modellek tudásának bővítésében.

A REALM egyik különlegessége, hogy egy implicit retrievert használ, ami azt jelenti, hogy a modell maga hozza meg a döntést arról, hogy mikor és mit keressen, a belső reprezentációi alapján. Ez egyfajta „önszabályozó” visszakeresési mechanizmust tesz lehetővé.

Grounded Generation és kereskedelmi megoldások

A „Grounded Generation” kifejezés általában azokat a nyelvi modelleket írja le, amelyek külső, megbízható információforrásokra támaszkodva generálnak szöveget. Számos kereskedelmi megoldás és szolgáltatás épül ma már RALM elvekre, gyakran finomhangolt open-source modelleket (mint például a T5 vagy a LLaMA) kombinálva belső, optimalizált retriever rendszerekkel és saját tudásbázisokkal. Ezek a megoldások gyakran kínálnak testre szabható tudásbázisokat és API-kat a könnyű integráció érdekében.

Nyílt forráskódú keretrendszerek a RALM fejlesztéséhez

A RALM rendszerek fejlesztését jelentősen megkönnyítik a különböző nyílt forráskódú keretrendszerek, amelyek absztrahálják a komplexitást és előre elkészített modulokat biztosítanak a retriever, a generátor és az integráció megvalósításához.

- LangChain: Ez egy rendkívül népszerű Python keretrendszer, amely moduláris felépítésével lehetővé teszi a RALM alkalmazások gyors fejlesztését. Különböző LLM-eket, vektoros adatbázisokat (pl. Chroma, Pinecone, FAISS), és retrievereket (pl. BM25, neurális keresők) integrál, és láncokat (chains) kínál a komplex munkafolyamatok, például a RAG létrehozásához.

- LlamaIndex: A LangChain-hez hasonlóan a LlamaIndex is arra fókuszál, hogy az LLM-eket külső adatokkal bővítse. Különösen hatékony a privát vagy domain-specifikus adatok strukturálásában és indexelésében, hogy azok könnyen hozzáférhetővé váljanak az LLM-ek számára. Támogatja a különböző adatforrásokat és indexelési stratégiákat.

- Haystack: A Deepset által fejlesztett Haystack egy másik robusztus keretrendszer, amely end-to-end megoldásokat kínál a kérdés-válasz rendszerek és a RALM alkalmazások építéséhez. Moduláris felépítésű, és támogatja a különböző retrievereket (lexikális és neurális), generátorokat és adatbázisokat.

Ezek a keretrendszerek jelentősen csökkentik a belépési küszöböt a RALM technológia iránt érdeklődő fejlesztők számára, lehetővé téve számukra, hogy gyorsan prototípusokat készítsenek és skálázható megoldásokat építsenek.

A RALM modellek és keretrendszerek folyamatos fejlődése azt mutatja, hogy ez a megközelítés kulcsfontosságú a mesterséges intelligencia következő generációjában, ahol a megbízhatóság és a tényalapúság ugyanolyan fontos, mint a generatív képességek.

A RALM jövője és fejlődési irányai

A Retrieval-Augmented Language Model (RALM) technológia még viszonylag fiatal, de a benne rejlő potenciál hatalmas. A jövőbeli fejlődési irányok valószínűleg a jelenlegi korlátok áthidalására, a hatékonyság növelésére és az alkalmazási területek bővítésére fókuszálnak majd.

Multimodális RALM: túl a szövegen

Jelenleg a RALM rendszerek elsősorban szöveges adatokra támaszkodnak a visszakereséshez és a generáláshoz. A jövő egyik izgalmas iránya a multimodális RALM, amely képes lesz nem csak szöveges, hanem képi, audio vagy videó adatokból is releváns információkat visszakeresni. Képzeljük el, hogy egy modell képes egy képpel kapcsolatos kérdésre úgy válaszolni, hogy releváns képeket és azok leírásait keresi meg egy vizuális tudásbázisban, majd ezek alapján generál szöveges választ. Ez forradalmasíthatja a tartalomkészítést, a médiaelemzést és a vizuális keresést.

Interaktív visszakeresés és felhasználói visszajelzések

A jelenlegi RALM rendszerek többsége egyetlen körben hajtja végre a visszakeresést és a generálást. A jövőben várhatóan megjelennek az interaktív RALM-ek, amelyek képesek lesznek több körben kommunikálni a felhasználóval vagy akár a retrieverrel. Például, ha a generált válasz nem kielégítő, a modell további kérdéseket tehet fel a felhasználónak, vagy újabb keresést indíthat a tudásbázisban, finomítva a keresési stratégiáját a felhasználói visszajelzések alapján. Ezáltal a rendszer „tanulhat” a felhasználói interakciókból, és idővel egyre pontosabbá válhat.

Önfejlesztő és adaptív rendszerek

Az egyik legambiciózusabb cél az önfejlesztő RALM rendszerek létrehozása. Ezek a modellek nem csak a tréning során, hanem a valós idejű működésük során is képesek lennének optimalizálni a retriever és a generátor komponenseiket. Például, ha a generátor gyakran ad téves válaszokat egy bizonyos típusú kérdésre, a rendszer automatikusan finomhangolhatja a retrievert, hogy jobb minőségű dokumentumokat találjon, vagy frissítheti a tudásbázisát új, releváns információkkal. Ez egy folyamatosan tanuló és alkalmazkodó MI rendszert eredményezne.

Etiális megfontolások és megbízhatóság

Ahogy a RALM rendszerek egyre szélesebb körben elterjednek, az etikai kérdések és a megbízhatóság még nagyobb hangsúlyt kapnak. Különösen fontos lesz a tudásbázisok forrásainak hitelessége és torzításmentessége. Hogyan biztosítható, hogy a visszakeresett információk ne tartalmazzanak káros torzításokat, diszkriminatív tartalmakat vagy álhíreket? A jövőbeli kutatásoknak foglalkozniuk kell azzal, hogyan lehet a RALM rendszereket robusztusabbá és etikusabbá tenni, például a források diverzitásának növelésével, a tényellenőrző mechanizmusok beépítésével vagy a felhasználói visszajelzések proaktív kezelésével.

Hatékonyság és skálázhatóság

A nagyméretű tudásbázisok kezelése és a gyors válaszidő biztosítása továbbra is kulcsfontosságú kihívás marad. A jövőben várhatóan új, még hatékonyabb indexelési algoritmusok, vektoros adatbázis-technológiák és neurális architektúrák jelennek meg, amelyek tovább csökkentik a RALM rendszerek számítási költségeit és késleltetését, miközben növelik a skálázhatóságukat. A kvantum-számítástechnika vagy az új hardveres gyorsítók is szerepet játszhatnak ebben a fejlődésben.

Összességében a Retrieval-Augmented Language Model (RALM) egy rendkívül ígéretes technológia, amely a mesterséges intelligencia fejlődésének élvonalában áll. Képes áthidalni a generatív modellek alapvető korlátait, és utat nyit a megbízhatóbb, pontosabb és tényalapúbb MI alkalmazások felé, amelyek valóban képesek lesznek átalakítani a mindennapi életünket és a munkavégzésünket.