A Q-learning egy modell-mentes, off-policy megerősítéses tanulási algoritmus. Ez azt jelenti, hogy nem igényli a környezet modelljét (azaz nem kell tudnia, hogy egy adott akció milyen állapotváltozást eredményez), és tanulhat olyan adatokból, amelyek nem a jelenlegi policy szerint kerültek generálásra.

A Q-learning célja, hogy megtanulja az optimális Q-értéket minden állapot-akció párhoz. A Q-érték azt mutatja meg, hogy mennyire jó egy adott akció végrehajtása egy adott állapotban, figyelembe véve a jövőbeli jutalmakat is. Ezt az értéket iteratívan frissítjük a Bellman-egyenlet segítségével.

A Q-learning lényege, hogy a célfüggvény a lehető legjobb akció kiválasztása minden egyes állapotban, még akkor is, ha nem az a policy, amit éppen követünk.

A működése során az algoritmus egy Q-táblát használ, melynek sorai az állapotokat, oszlopai pedig az akciókat reprezentálják. Minden cella a megfelelő állapot-akció pár Q-értékét tartalmazza. Az algoritmus a következő lépéseket hajtja végre:

- Kiválaszt egy akciót a jelenlegi állapotban (pl. epsilon-greedy stratégiával).

- Végrehajtja az akciót, és megfigyeli a következő állapotot és a kapott jutalmat.

- Frissíti a Q-táblát a következő képlet szerint: Q(s, a) = Q(s, a) + α * (r + γ * maxₐ’ Q(s’, a’) – Q(s, a)), ahol:

- s a jelenlegi állapot,

- a a végrehajtott akció,

- r a kapott jutalom,

- s’ a következő állapot,

- α a tanulási ráta (0 és 1 közötti érték),

- γ a diszkont faktor (0 és 1 közötti érték),

- maxₐ’ Q(s’, a’) a következő állapotban elérhető maximális Q-érték.

- A jelenlegi állapotot a következő állapotra állítja, és folytatja a tanulást.

A tanulási ráta (α) szabályozza, hogy mennyire vesszük figyelembe az új információkat a Q-érték frissítésekor. A diszkont faktor (γ) pedig azt mutatja meg, hogy mennyire fontosak számunkra a jövőbeli jutalmak a jelenlegihez képest. Minél nagyobb a γ értéke, annál nagyobb súlyt helyezünk a jövőbeli jutalmakra.

A Q-learning széles körben alkalmazható különböző területeken, mint például a robotika, a játékok (pl. Atari játékok), vagy a vezérléselmélet. Előnye, hogy nem igényli a környezet modelljét, és képes optimális policy-t tanulni még akkor is, ha a környezet nem determinisztikus. Ugyanakkor hátránya lehet a nagy állapottér esetén a Q-tábla mérete, ami a memóriaigényt és a számítási időt is megnöveli. Ezen problémák kezelésére különböző módszerek léteznek, például a függvényapproximáció.

A Q-learning definíciója és a megerősítéses tanulás kapcsolata

A Q-learning egy megerősítéses tanulási (RL) algoritmus, amelynek célja, hogy megtalálja az optimális cselekvést egy adott állapotban. Lényegében egy érték-iterációs módszer, amely nem igényel a környezet modelljének ismeretét. Ez azt jelenti, hogy a Q-learning képes „tanulni” a helyes cselekvéseket anélkül, hogy tudná, hogyan fog a környezet reagálni egy adott cselekvésre.

A Q-learning a „Q” értéket használja, ami az állapot-cselekvés pár minőségét jelöli. A Q-érték azt becsüli meg, hogy mennyire jó egy adott állapotban végrehajtani egy adott cselekvést. A cél a Q-tábla (vagy Q-függvény) feltöltése az optimális Q-értékekkel minden állapot-cselekvés párra.

A Q-learning egy off-policy algoritmus. Ez azt jelenti, hogy az algoritmus a „greedy” stratégiával választja ki a cselekvéseket (azaz mindig a legmagasabb Q-értékkel rendelkező cselekvést választja), de a Q-értékek frissítésekor figyelembe veszi a maximális lehetséges jutalmat, függetlenül attól, hogy az adott pillanatban melyik cselekvést választotta.

A Q-learning a következőképpen működik:

- Inicializáljuk a Q-táblát (általában véletlenszerű értékekkel).

- Végrehajtunk egy ciklust (epizódot) a környezetben.

- Minden epizódban:

- Kiválasztunk egy cselekvést az aktuális állapotban (pl. epsilon-greedy stratégiával, ami néha véletlenszerű cselekvést is lehetővé tesz a feltárás érdekében).

- Végrehajtjuk a cselekvést, és megfigyeljük a jutalmat és a következő állapotot.

- Frissítjük a Q-értéket a következő képlettel: Q(s, a) = Q(s, a) + α * [R + γ * max_a’ Q(s’, a’) – Q(s, a)], ahol:

- α a tanulási ráta (learning rate),

- R a jutalom,

- γ a diszkont faktor (discount factor),

- s az aktuális állapot,

- a a végrehajtott cselekvés,

- s’ a következő állapot,

- a’ a következő állapotban lehetséges cselekvések.

- Az aktuális állapotot a következő állapotra állítjuk.

- A ciklust addig folytatjuk, amíg a Q-értékek konvergálnak (azaz nem változnak jelentősen).

A Q-learning szorosan kapcsolódik a megerősítéses tanuláshoz, mivel az RL egyik alapvető algoritmusa. A Q-learning egy modell-mentes módszer, ami azt jelenti, hogy nem kell modelleznünk a környezetet. Ehelyett a Q-learning közvetlenül a tapasztalatokból tanul, ami rendkívül hatékonnyá teszi komplex, ismeretlen környezetekben.

A Q-learning alapelvei: állapotok, akciók, jutalmak, és a Q-érték

A Q-learning egy megerősítéses tanulási algoritmus, amelynek célja, hogy megtanulja a legjobb stratégiát egy adott környezetben. A stratégia lényegében azt határozza meg, hogy egy adott állapotban milyen akciót kell végrehajtani a maximális jutalom elérése érdekében. A Q-learning nem igényli a környezet modelljét, ami azt jelenti, hogy nem kell előre tudnunk, hogyan működik a környezet, vagyis hogy az egyes akciók milyen hatással lesznek az állapotra.

A Q-learning alapelvei négy fő elemre épülnek:

- Állapotok (States): A környezet lehetséges helyzeteinek halmaza. Egy állapot leírja a környezet pillanatnyi kondícióját. Például egy robot navigációja esetén az állapot lehet a robot koordinátái a térben.

- Akciók (Actions): Azok a lépések, amelyeket az ügynök végrehajthat az adott állapotban. A robot esetében az akciók lehetnek az előrehaladás, balra fordulás, jobbra fordulás.

- Jutalmak (Rewards): A környezet által az ügynöknek adott visszajelzés az akciók eredményességéről. A jutalmak lehetnek pozitívak (ha az akció jó volt), negatívak (ha az akció rossz volt) vagy nullák (ha az akciónak nincs közvetlen hatása).

- Q-érték (Q-value): Egy adott állapot-akció párhoz rendelt érték, amely azt becsli meg, hogy mennyire jó az adott akció végrehajtása az adott állapotban a jövőbeli jutalmak szempontjából. A Q-érték a lényeg, amit a Q-learning algoritmus megpróbál megtanulni.

A Q-learning működése iteratív. Az ügynök interakcióba lép a környezettel, végrehajt akciókat, megfigyeli a jutalmakat, és frissíti a Q-értékeket. A frissítés során a Bellman-egyenletet használjuk, ami lényegében azt mondja, hogy egy adott állapot-akció pár Q-értéke egyenlő a kapott jutalommal, plusz egy diszkontált érték a következő állapotban elérhető legjobb Q-értékből.

A Q-learning célja a optimális Q-értékek megtanulása minden állapot-akció párra, ami lehetővé teszi az ügynök számára, hogy mindig a legjobb akciót válassza a maximális jutalom elérése érdekében.

A Q-learning algoritmus alapvetően a következő lépésekből áll:

- Inicializáljuk a Q-értékeket (általában nullával vagy véletlenszerű értékekkel).

- Ismételjük a következőket, amíg el nem érjük a konvergenciát:

- Válasszunk egy állapotot (s).

- Válasszunk egy akciót (a) az állapotban (s) (például egy ε-mohó stratégia segítségével, ami azt jelenti, hogy néha a legjobb ismert akciót választjuk, néha pedig véletlenszerűen választunk egy akciót).

- Hajtsuk végre az akciót (a) és figyeljük meg a jutalmat (r) és a következő állapotot (s’).

- Frissítsük a Q-értéket a következő képlet szerint: Q(s, a) = Q(s, a) + α * (r + γ * max(Q(s’, a’)) – Q(s, a)), ahol α a tanulási ráta, γ pedig a diszkont faktor.

- Legyen az aktuális állapot a következő állapot (s = s’).

A tanulási ráta (α) szabályozza, hogy mennyire gyorsan frissítjük a Q-értékeket. A diszkont faktor (γ) pedig azt határozza meg, hogy mennyire értékeljük a jövőbeli jutalmakat a jelenlegi jutalomhoz képest. A Q-learning egy hatékony algoritmus, de fontos a paraméterek helyes beállítása a konvergencia érdekében.

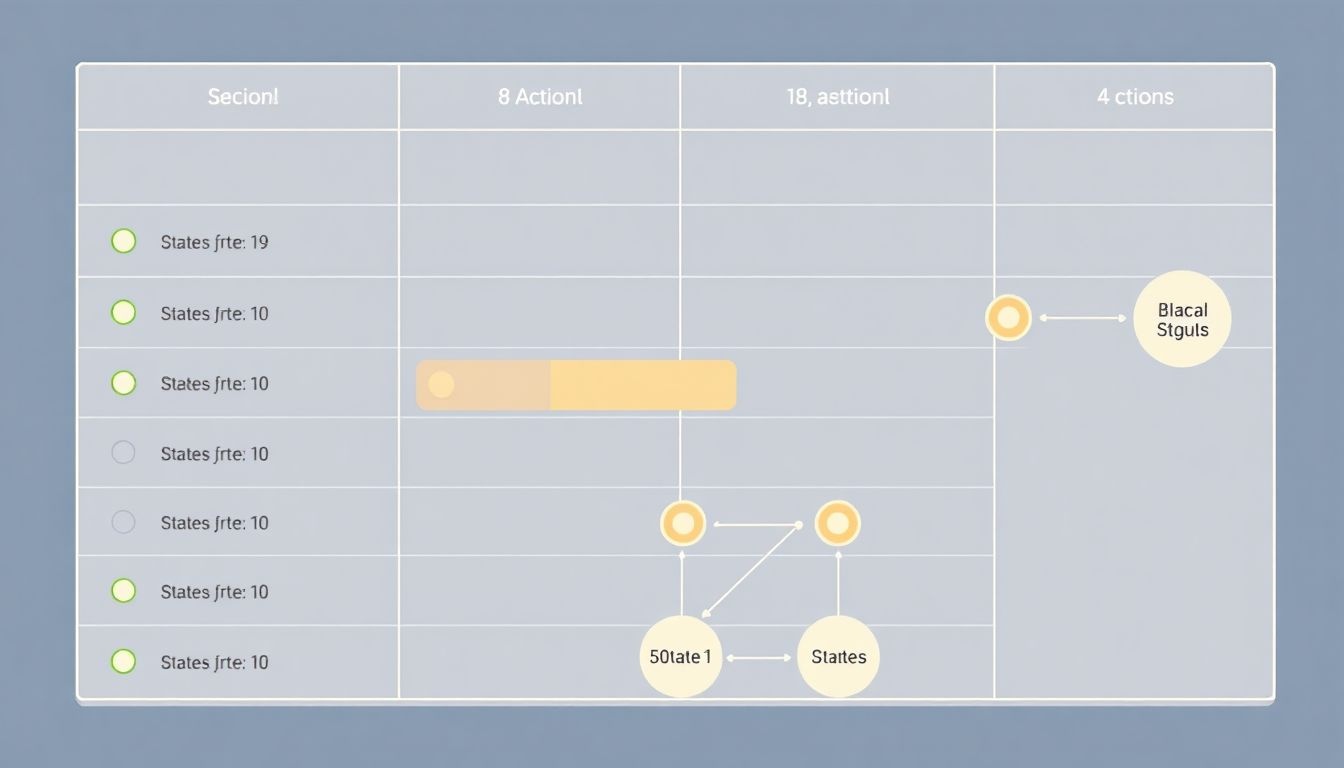

A Q-tábla felépítése és inicializálása

A Q-learning alapja a Q-tábla, mely egy mátrix formájában tárolja az egyes állapot-akció párokhoz tartozó Q-értékeket. Ezek az értékek reprezentálják, hogy mennyire előnyös egy adott állapotban egy adott akció végrehajtása. A Q-tábla sorai az állapotokat, oszlopai pedig a lehetséges akciókat jelölik.

A tábla inicializálása kritikus lépés. Gyakran nullával töltik fel a Q-táblát kezdetben, ami azt jelenti, hogy a kezdeti tudás nulla. Alternatív megoldásként használhatók véletlenszerű értékek is, melyek segíthetnek elkerülni a lokális optimumokba való beragadást a tanulási folyamat során. A lényeg, hogy az inicializálás után a Q-értékek a tanulás során frissülnek, ahogy az ügynök interakcióba lép a környezettel.

A Q-tábla mérete a környezet komplexitásától függ. Minél több állapot és akció létezik, annál nagyobb lesz a tábla. Nagyobb táblák esetén a tanulási folyamat több időt és erőforrást igényelhet.

A Q-tábla lényegében egy „emlékezet”, melyben az ügynök rögzíti a tapasztalatait az egyes állapot-akció párokkal kapcsolatban.

A Q-tábla frissítése a Bellman egyenlet alapján történik, mely figyelembe veszi a kapott jutalmat és a következő állapotban elérhető legjobb Q-értéket. Ez a iteratív folyamat lehetővé teszi, hogy az ügynök fokozatosan megtanulja a környezetben való optimális viselkedést.

Például, egy egyszerű labirintus esetén a labirintus minden egyes cellája egy állapotot reprezentál, a lehetséges akciók pedig a mozgás irányai (felfelé, lefelé, balra, jobbra). A Q-tábla minden cellájához egy Q-érték tartozik, mely azt mutatja, hogy mennyire előnyös az adott cellából egy adott irányba lépni.

A Bellman-egyenlet szerepe a Q-learningben

A Q-learning egy modellmentes, off-policy megerősítéses tanulási algoritmus, melynek célja az optimális cselekvési stratégia megtalálása egy Markov döntési folyamatban (MDP). A Bellman-egyenlet központi szerepet játszik a Q-learning működésében, mivel ez biztosítja az alapot a Q-értékek iteratív frissítéséhez.

A Bellman-egyenlet alapvetően egy rekurzív összefüggés, amely leírja egy adott állapotban lévő cselekvés értékét (Q-érték) a következő állapotbeli legjobb cselekvés értékével és a kapott jutalommal összefüggésben. A Q-learningben ezt az egyenletet használjuk a Q-tábla értékeinek frissítésére a következőképpen:

Q(s, a) ← Q(s, a) + α [r + γ maxₐ’ Q(s’, a’) – Q(s, a)]

- Q(s, a): Az s állapotban végrehajtott a cselekvés Q-értéke.

- α: A tanulási ráta (learning rate), amely meghatározza, hogy mennyire vesszük figyelembe az új információkat a korábbi értékekhez képest.

- r: A cselekvés végrehajtásáért kapott jutalom.

- γ: A diszkont faktor (discount factor), amely azt mutatja, hogy a jövőbeli jutalmak mennyire értékesek a jelenhez képest.

- s’: A következő állapot, amelybe az a cselekvés végrehajtása után kerülünk.

- maxₐ’ Q(s’, a’): A legjobb Q-érték az s’ állapotban lévő összes lehetséges a’ cselekvésre vonatkozóan.

A Bellman-egyenlet lényege, hogy a Q-érték frissítése a jelenlegi jutalom és a következő állapotban elérhető legjobb Q-érték kombinációján alapul, figyelembe véve a diszkont faktort.

Az iteratív frissítés során a Q-learning algoritmus fokozatosan konvergál az optimális Q-értékekhez, amelyek segítségével az ügynök képes megtalálni a legjobb cselekvési stratégiát. Az off-policy jelleg azt jelenti, hogy az algoritmus nem feltétlenül azt a cselekvést követi, amely a Q-tábla szerint a legjobb, hanem felfedező cselekvéseket is végrehajt, hogy új lehetőségeket találjon. Ez a felfedezés kulcsfontosságú a globális optimum megtalálásához és a lokális optimumok elkerüléséhez.

A Q-érték frissítésének algoritmusa lépésről lépésre

A Q-learning során a legfontosabb lépés a Q-érték frissítése. Ez az érték reprezentálja, hogy mennyire jó egy adott állapotban lévő ügynök számára egy adott akció végrehajtása. Az algoritmus iteratívan finomítja ezeket az értékeket a tapasztalatok alapján.

A Q-érték frissítése a következőképpen zajlik lépésről lépésre:

- Megfigyelés: Az ügynök megfigyeli a jelenlegi állapotát (s).

- Akcióválasztás: Az ügynök kiválaszt egy akciót (a) a jelenlegi állapotában. Ezt az akciót általában egy ε-mohó (epsilon-greedy) stratégia alapján választja ki. Ez azt jelenti, hogy az esetek többségében a jelenlegi Q-értékek alapján a legjobbnak ítélt akciót választja, de időnként (ε valószínűséggel) véletlenszerűen választ egy akciót a felfedezés érdekében.

- Akció végrehajtása: Az ügynök végrehajtja a kiválasztott akciót (a).

- Következő állapot és jutalom: Az ügynök megfigyeli az új állapotot (s’) és a jutalmat (r), amelyet az akció végrehajtásáért kapott.

- Q-érték frissítése: A Q-érték frissítése a következő képlettel történik:

Q(s, a) = Q(s, a) + α * [r + γ * maxₐ’ Q(s’, a’) – Q(s, a)]

- Iteráció: Az ügynök visszatér az 1. lépéshez, és folytatja a tanulást.

A fenti képletben:

- Q(s, a) a jelenlegi Q-érték az (s, a) párosra.

- α a tanulási ráta (learning rate), amely meghatározza, hogy mennyire gyorsan tanul az ügynök az új tapasztalatokból. Az értéke általában 0 és 1 között van.

- r a jutalom, amelyet az ügynök kapott az (s, a) akció végrehajtásáért.

- γ a diszkont faktor (discount factor), amely meghatározza, hogy mennyire fontosak a jövőbeli jutalmak a jelenlegi jutalomhoz képest. Az értéke általában 0 és 1 között van.

- maxₐ’ Q(s’, a’) a maximális Q-érték a következő állapotban (s’) az összes lehetséges akcióra (a’). Ez azt jelenti, hogy az ügynök feltételezi, hogy a következő állapotban a legjobb akciót fogja választani.

A Q-érték frissítése lényegében a Bellman egyenlet egy iteratív alkalmazása. Az algoritmus addig ismétli ezeket a lépéseket, amíg a Q-értékek konvergálnak, azaz nem változnak jelentősen az egyes iterációk során. Ekkor az ügynök megtanulta a optimális stratégiát.

A Q-learning egy off-policy módszer, ami azt jelenti, hogy az ügynök a Q-értékek frissítéséhez használt adatokat nem feltétlenül a jelenleg követett stratégiája alapján gyűjti. Ez lehetővé teszi, hogy az ügynök agresszíven felfedezze a környezetet, miközben a Q-értékeket a legjobb lehetséges stratégia alapján frissíti.

A tanulási ráta (alpha) és a diszkont faktor (gamma) hatása a Q-learningre

A Q-learning teljesítményét jelentősen befolyásolja a tanulási ráta (α) és a diszkont faktor (γ) értéke. Ezek a paraméterek határozzák meg, hogy az algoritmus milyen gyorsan és milyen mértékben veszi figyelembe az új információkat, illetve a jövőbeli jutalmakat.

A tanulási ráta (α), más néven lépésméret, azt szabályozza, hogy a Q-érték becslése mennyire változik egy-egy frissítés során. Értéke 0 és 1 között mozog. Ha α közel van 0-hoz, akkor az új információk csak kis mértékben befolyásolják a Q-értéket, ami lassú tanuláshoz vezethet. Viszont α = 0 esetén az algoritmus egyáltalán nem tanul. Ezzel szemben, ha α közel van 1-hez, akkor a Q-értékek gyorsan frissülnek, ami gyorsabb tanulást eredményezhet, de nagyobb a valószínűsége annak, hogy az algoritmus „túllő” a helyes értéken, és instabillá válik.

A megfelelő α érték megtalálása kulcsfontosságú a Q-learning hatékony működéséhez.

A diszkont faktor (γ) a jövőbeli jutalmak jelenlegi értékére gyakorolt hatását szabályozza. Értéke szintén 0 és 1 között mozog. Ha γ közel van 0-hoz, akkor az algoritmus rövidlátó, és csak a közvetlen jutalmakat veszi figyelembe. Ez akkor lehet előnyös, ha a feladatban a késleltetett jutalmak kevésbé fontosak. Ha γ közel van 1-hez, akkor az algoritmus távlati gondolkodású, és a jövőbeli jutalmakat is nagy súllyal veszi figyelembe. Ez akkor ideális, ha a feladatban a hosszú távú stratégia a fontos, például egy labirintusból való kijutás esetén.

Fontos megérteni, hogy a két paraméter együttesen befolyásolja a Q-learning konvergenciáját és teljesítményét. Például, ha α túl nagy és γ is közel van 1-hez, az algoritmus oszcillálhat, és soha nem fog konvergálni a helyes Q-értékekhez. Ezzel szemben, ha α és γ is túl kicsi, a tanulás nagyon lassú lesz, és az algoritmus nem fogja megtalálni a legjobb stratégiát.

A gyakorlatban a megfelelő α és γ értékek kiválasztása gyakran kísérletezés kérdése. Az adott feladathoz leginkább illeszkedő értékek megtalálásához érdemes különböző paraméterkombinációkat kipróbálni és az eredményeket összehasonlítani.

Az Exploration vs. Exploitation dilemma a Q-learningben

A Q-learning során az egyik legnagyobb kihívást az exploration vs. exploitation dilemma jelenti. Ez a probléma abból adódik, hogy az ügynöknek el kell döntenie, hogy a már ismert, jónak tűnő cselekvéseket (exploitation) választja-e, vagy új, ismeretlen cselekvéseket próbál ki (exploration) annak érdekében, hogy potenciálisan még jobb megoldásokat találjon.

Ha az ügynök kizárólag a már ismert, legjobb cselekvéseket választja (exploitation), fennáll a veszélye, hogy beragad egy lokális optimumba, és nem fedezi fel a globális optimumot jelentő, esetleg kezdetben kevésbé ígéretes cselekvéseket.

Másrészről, ha az ügynök túl sokat explorál, az időpocsékoláshoz vezethet, hiszen sok rossz cselekvést is kipróbál, ami lassítja a tanulási folyamatot és rontja a teljesítményt. A hatékony Q-learning algoritmusoknak valamilyen módon egyensúlyt kell teremteniük a kettő között.

Az ideális stratégia az, hogy az ügynök kezdetben sokat explorál, hogy minél több információt gyűjtsön a környezetéről, majd fokozatosan áttér az exploitation-re, ahogy egyre biztosabbá válik a legjobb cselekvésekben.

Számos módszer létezik az exploration vs. exploitation dilemma kezelésére. Az egyik leggyakoribb módszer az ε-greedy stratégia, ahol az ügynök egy ε valószínűséggel véletlenszerűen választ cselekvést (exploration), míg 1-ε valószínűséggel a legjobb ismert cselekvést (exploitation) választja. Az ε értékét gyakran csökkentik a tanulási folyamat során, hogy a kezdeti intenzív exploration után egyre inkább az exploitation kerüljön előtérbe.

Egy másik megközelítés a softmax akcióválasztás, ahol a cselekvések valószínűségét a Q-értékeik alapján határozzuk meg. A magasabb Q-értékű cselekvések nagyobb valószínűséggel kerülnek kiválasztásra, de a kisebb Q-értékű cselekvések is kapnak valamilyen esélyt, így biztosítva a folyamatos exploration-t.

A felső-konfidencia-határ (UCB) módszer egy harmadik lehetőség, amely explicit módon figyelembe veszi a cselekvések bizonytalanságát. Az UCB algoritmusok a cselekvések Q-értékéhez hozzáadnak egy bizonytalansági komponenst, amely arányos a cselekvés kiválasztásának ritkaságával. Így az algoritmus ösztönzi a kevésbé kipróbált cselekvések felfedezését.

Az epsilon-greedy stratégia a felfedezés és kihasználás egyensúlyozására

A Q-learning során a felfedezés (exploration) és kihasználás (exploitation) közötti egyensúly megtalálása kulcsfontosságú. Az epsilon-greedy stratégia egy népszerű módszer ennek az egyensúlynak a megteremtésére.

Lényege, hogy minden lépésben egy ε (epsilon) valószínűséggel véletlenszerűen választunk egy akciót, függetlenül annak Q-értékétől. Ezzel biztosítjuk, hogy az ügynök feltérképezze a környezetet, és új, potenciálisan jobb megoldásokat találjon. A maradék (1 – ε) valószínűséggel a legmagasabb Q-értékkel rendelkező akciót választjuk, azaz kihasználjuk a már megszerzett tudást.

Az epsilon-greedy stratégia egyszerű, de hatékony módja annak, hogy a Q-learning ügynök ne ragadjon bele egy lokális optimumba, hanem folyamatosan keresse a globális optimumot.

Az ε értékét gyakran idővel csökkentik. Kezdetben egy magasabb ε érték (pl. 0.9) biztosítja a széles körű felfedezést. Ahogy az ügynök egyre többet tanul, az ε érték csökken (pl. 0.1), így a kihasználás kerül előtérbe. Ez a csökkenő epsilon megközelítés lehetővé teszi, hogy az ügynök először feltérképezze a környezetet, majd finomítsa a stratégiáját a megszerzett tudás alapján.

Például, ha ε = 0.2, akkor minden 10 lépésből körülbelül 2-szer véletlenszerű akciót hajtunk végre, még akkor is, ha van egy látszólag jobb lehetőség. Ez a véletlenszerűség lehetővé teszi, hogy az ügynök olyan állapotokba kerüljön, amelyekről még nem szerzett tapasztalatot, és így javítsa a Q-értékeit.

Fontos, hogy az epsilon értékének helyes megválasztása kritikus a Q-learning hatékonysága szempontjából. Egy túl magas ε érték túlzott felfedezéshez vezethet, ami lassítja a tanulást. Egy túl alacsony ε érték pedig megakadályozhatja, hogy az ügynök megtalálja a legjobb stratégiát.

A Q-learning implementációja Pythonban egy egyszerű példán keresztül

A Q-learning implementációja Pythonban egy egyszerű példán keresztül jól szemlélteti a módszer működését. Tekintsünk egy egyszerű környezetet: egy robotnak el kell jutnia egy adott helyre egy rácson. A robot minden lépésben mozoghat fel, le, jobbra vagy balra. A célunk, hogy a robot megtanulja a legoptimálisabb útvonalat a célhoz.

A Q-learning alapja a Q-tábla. Ez egy mátrix, melynek sorai az állapotokat (a rács pozícióit), oszlopai pedig a lehetséges akciókat (fel, le, jobbra, balra) reprezentálják. A Q-tábla minden cellája (Q(s, a)) azt mutatja, hogy mennyire jó egy adott állapotban (s) egy adott akciót (a) végrehajtani. Kezdetben a Q-tábla értékei általában 0-ra vannak inicializálva.

A tanulási folyamat során a robot felfedezi a környezetet, és frissíti a Q-táblát a következő képlet segítségével:

Q(s, a) = Q(s, a) + α * (R(s, a) + γ * max(Q(s’, a’)) – Q(s, a))

Ahol:

- Q(s, a): Az aktuális állapot-akció pár Q-értéke.

- α (tanulási ráta): Meghatározza, hogy mennyire vesszük figyelembe az új információt.

- R(s, a) (jutalom): Az adott állapotban az adott akcióért kapott jutalom. A célba érésért kapunk pozitív jutalmat, egyébként pedig 0-t.

- γ (diszkont faktor): Meghatározza, hogy mennyire fontosak a jövőbeni jutalmak.

- s’: A következő állapot, miután végrehajtottuk az ‘a’ akciót az ‘s’ állapotban.

- a’: A következő állapotban (s’) elérhető legjobb akció.

Pythonban a Q-táblát egyszerűen egy NumPy tömbként reprezentálhatjuk. A tanulási ciklusban a robot véletlenszerűen választ egy akciót (exploration), vagy a Q-tábla alapján a legjobb akciót (exploitation). Az exploration-exploitation közötti egyensúlyt egy ε (epsilon) paraméter szabályozza. Az ε valószínűséggel véletlenszerű akciót választunk, míg 1-ε valószínűséggel a Q-tábla alapján a legjobbat.

Minden lépésben a robot frissíti a Q-táblát a fenti képlet segítségével. A tanulási ciklus végén a Q-tábla tartalmazza az optimális stratégiát. Ezt követően a robot a Q-tábla alapján egyszerűen kiválaszthatja a legjobb akciót minden állapotban, hogy elérje a célt.

Egy egyszerű Python implementáció tartalmazhatja a környezet definícióját (a rácsot, a cél pozícióját), a Q-tábla inicializálását, a tanulási ciklust és a Q-tábla frissítését. A kód érthetősége érdekében érdemes a környezetet, az akciókat és a jutalmakat objektumok segítségével reprezentálni.

A Q-learning alkalmazási területei: robotika, játékok, autonóm rendszerek

A Q-learning, mint egy megerősítéses tanulási módszer, rendkívül sokoldalú, és számos területen alkalmazható. Kiemelkedő szerepet játszik a robotikában, ahol a robotok környezetükkel való interakció során tanulnak meg optimális stratégiákat. Például, egy robotkar Q-learning segítségével sajátíthatja el a tárgyak hatékony megfogásának és mozgatásának módját, anélkül, hogy előre programoznák minden egyes mozdulatát.

A játékok világa egy másik fontos terület, ahol a Q-learning kiemelkedik. Gondoljunk csak a klasszikus játékokra, mint a Pac-Man vagy a Space Invaders. A Q-learning algoritmusok képesek megtanulni ezeket a játékokat játszani, sőt, akár emberi játékosokat is felülmúlni. A módszer lényege, hogy a játékos (az algoritmus) minden lépés után jutalmat vagy büntetést kap, ami alapján finomítja a stratégiáját.

A Q-learning lehetővé teszi a gépek számára, hogy autonóm döntéseket hozzanak a környezetükben, optimalizálva a hosszú távú jutalmakat.

Az autonóm rendszerek területén is széleskörűen alkalmazzák a Q-learninget. Ilyenek például az önvezető autók, ahol a rendszernek valós időben kell döntenie a forgalmi helyzetekben. A Q-learning segíthet az autóknak a sávváltás, a követési távolság tartása és a kereszteződésekben való biztonságos áthaladás optimális módjának elsajátításában. A rendszer a sikeres manőverekért jutalmat, a balesetekért pedig büntetést kap, így folyamatosan javítva a teljesítményét.

Ezen felül, a Q-learning alkalmazható még erőforrás-gazdálkodási problémák megoldására, például adatközpontokban a szerverek energiafogyasztásának optimalizálására. A módszer adaptív jellege lehetővé teszi, hogy a rendszer a változó körülményekhez igazodjon, és a legoptimálisabb megoldást találja meg.

A Q-learning korlátai és kihívásai

A Q-learning, bár hatékony módszer, számos korláttal és kihívással szembesül. Az egyik legjelentősebb a dimenzió átka, ami azt jelenti, hogy a Q-tábla mérete exponenciálisan nő az állapotok és cselekvések számának növekedésével. Ez hatalmas memóriaigényhez és lassú tanulási sebességhez vezethet.

Egy másik probléma a konvergencia garanciája. A Q-learning elméletileg konvergál az optimális Q-értékekhez, ha minden állapot-cselekvés párt végtelen sokszor meglátogatunk. A gyakorlatban ez szinte sosem valósul meg, és a konvergencia függ a tanulási rátától, a diszkont faktorától és a felfedezési stratégiától.

A felfedezés-kihasználás dilemma is komoly kihívást jelent. A Q-learning ügynöknek egyensúlyt kell tartania a már ismert jó cselekvések kihasználása (exploitation) és az új, potenciálisan még jobb cselekvések felfedezése (exploration) között. Ha az ügynök túl sokat kihasznál, elakadhat egy szuboptimális megoldásban. Ha túl sokat fedez fel, sosem tanulja meg a legjobb stratégiát.

A nem determinisztikus környezetekben a Q-learning teljesítménye jelentősen romolhat, mivel a Q-értékek becslése bizonytalanná válik.

A helyettesítő jutalomfüggvény (proxy reward function) használata is problémát okozhat. Gyakran nehéz olyan jutalomfüggvényt definiálni, amely pontosan tükrözi a kívánt viselkedést. Ha a jutalomfüggvény nem megfelelő, az ügynök nem a kívánt célt fogja optimalizálni.

Végül, a Q-learning érzékeny a hiperparaméterekre (pl. tanulási ráta, diszkont faktor). A hiperparaméterek helyes beállítása időigényes és sok kísérletezést igényel.

A Deep Q-Network (DQN) mint a Q-learning továbbfejlesztése

A Deep Q-Network (DQN) a Q-learning egy jelentős továbbfejlesztése, amely a mélytanulás erejét használja fel a Q-értékek becslésére. A hagyományos Q-learning táblázatos módszere korlátozottan alkalmazható nagyméretű, komplex állapotterekben, mivel a memóriaigénye és a számítási költsége exponenciálisan nő. A DQN ezt a problémát egy mély neurális hálózat alkalmazásával oldja meg, amely a Q-értékeket közelíti.

A DQN működésének kulcseleme az élmény-visszajátszás (experience replay). Ahelyett, hogy a tanulás közvetlenül a környezetből származó legfrissebb tapasztalatokon alapulna, a DQN egy memóriatárolóban (replay buffer) tárolja a tapasztalatokat (állapot, akció, jutalom, következő állapot). A hálózat ezután véletlenszerűen mintavételez ebből a tárolóból, ami segít megszüntetni a korrelációt a tapasztalatok között és javítja a tanulás stabilitását. Ez a technika kulcsfontosságú a konvergencia szempontjából, különösen a nem-stationárius környezetekben.

A DQN másik fontos újítása a célhálózat (target network) használata.

A Q-learning frissítési szabálya magában foglalja a Q-érték becslését a következő állapotra. A DQN-ben ez a becslés ugyanazzal a neurális hálózattal történik, amelyet a Q-értékek becslésére használunk. Ez instabilitáshoz vezethet, mivel a hálózat folyamatosan változik, és a célértékek is változnak. A célhálózat egy külön példánya a Q-hálózatnak, amely időnként frissül a Q-hálózat súlyaival. Ez stabilabb célértékeket biztosít a tanulási folyamat során.

A DQN jelentős áttörést jelentett a megerősítéses tanulás területén, lehetővé téve az ügynökök számára, hogy emberi szintű teljesítményt érjenek el olyan komplex játékokban, mint az Atari. A DQN alkalmazása a Q-learningben lehetővé tette, hogy kezelni lehessen a nagy dimenziós állapottereket és komplex problémákat, amelyekkel a hagyományos Q-learning nem tudott megbirkózni.