Az LZW (Lempel-Ziv-Welch) tömörítés egy veszteségmentes adattömörítési algoritmus, melyet széles körben alkalmaznak különféle fájlformátumokban, mint például a GIF és a TIFF. A célja, hogy csökkentse a fájlok méretét anélkül, hogy az eredeti adatokból bármit is elveszítene. Ez azért fontos, mert lehetővé teszi a hatékonyabb tárolást és gyorsabb adatátvitelt.

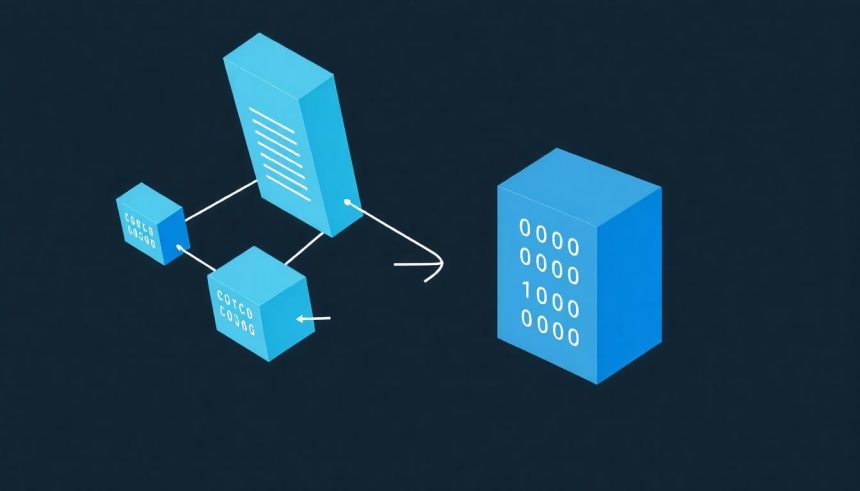

Az LZW működése azon alapul, hogy a bemeneti adatokban található ismétlődő karaktersorozatokat azonosítja, és ezeket rövidebb kódokkal helyettesíti. Ezt egy dinamikusan bővülő szótár segítségével éri el. A szótár kezdetben az összes egyedi karaktert tartalmazza (például az ASCII karakterkészletet). Amikor az algoritmus egy ismétlődő karaktersorozatot talál, hozzáadja ezt a sorozatot a szótárhoz, és hozzárendel egy új kódot. A tömörített adatfolyam ezután a szótárban található kódokat tartalmazza, nem pedig az eredeti karaktersorozatokat.

Az LZW tömörítés lényege, hogy a gyakran előforduló mintákat rövidebb kódszavakkal helyettesíti, ezáltal csökkentve a fájl méretét.

A dekódolás során a dekóder ugyanazt a szótárat építi fel, mint a kódoló, és a tömörített adatfolyamban található kódok alapján visszaállítja az eredeti adatokat. Mivel a dekóder a kódolás során használt logikát követi, képes pontosan rekonstruálni az eredeti fájlt. Az LZW különösen hatékony olyan adatok esetében, amelyek sok ismétlődő mintát tartalmaznak.

Például, ha egy szövegben gyakran szerepel a „alma” szó, az LZW algoritmus létrehozhat egy új kódot az „alma” szóhoz, és ahelyett, hogy minden alkalommal az „a”, „l”, „m”, „a” karaktereket tárolná, csak ezt az egyetlen kódot tárolja, ami jelentős helymegtakarítást eredményez.

Az LZW tömörítés története és fejlesztése

Az LZW tömörítés (Lempel-Ziv-Welch) egy veszteségmentes adattömörítési algoritmus, melyet 1978-ban fejlesztettek ki Abraham Lempel és Jacob Ziv korábbi munkáira alapozva, majd Terry Welch finomított tovább 1984-ben. Célja, hogy a redundanciát kihasználva kisebb méretűvé alakítsa az adatot, anélkül hogy információvesztés történne. A működési elve egyszerű: a bemeneti adatban gyakran előforduló karaktersorozatokat (szavakat, kifejezéseket) egyedi kódokkal helyettesíti, melyek rövidebbek, mint az eredeti sorozatok.

A technológia története szorosan összefonódik a korai számítástechnikai fejlesztésekkel, amikor a tárhely és a sávszélesség komoly korlátot jelentett. Az LZW algoritmus jelentős áttörést hozott, lehetővé téve hatékonyabb adattárolást és gyorsabb adatátvitelt. A GIF képformátum széles körű elterjedéséhez nagymértékben hozzájárult az LZW tömörítés alkalmazása, ami lehetővé tette a képek viszonylag kis méretben való tárolását és megosztását.

Az LZW működése egy szótár létrehozásán alapul. A kezdeti szótár az összes előforduló egyedi karaktert tartalmazza. Az algoritmus a bemeneti adatot szekvenciálisan olvassa, és keresi a leghosszabb olyan karaktersorozatot, amely már szerepel a szótárban. Ha talál ilyet, akkor a következő karakterrel kiegészítve ezt a sorozatot hozzáadja a szótárhoz egy új kód alatt. A kimenetre pedig a már meglévő karaktersorozat kódját írja ki. Ez a folyamat ismétlődik, amíg a teljes bemeneti adatot fel nem dolgozza.

Az LZW algoritmus egyik legfontosabb tulajdonsága, hogy a dekompressziós algoritmusnak nem kell előre ismernie a szótárat, mert azt a tömörített adatból rekonstruálja.

Az LZW algoritmus szabadalmi oltalom alatt állt, ami kezdetben korlátozta a szabad szoftverekben való felhasználását. A szabadalom lejárta után azonban az LZW széles körben elterjedt, és számos alkalmazásban használják, beleértve a TIFF képformátumot és bizonyos modem protokollokat is. Az algoritmus hatékonysága nagyban függ a bemeneti adatok jellegétől. Minél több ismétlődő karaktersorozatot tartalmaz az adat, annál jobb a tömörítési arány.

Az LZW algoritmus sikere ellenére az idők során más, hatékonyabb tömörítési eljárások is megjelentek, mint például a Deflate (amelyet a ZIP fájlokban és a PNG képformátumban használnak), melyek bizonyos esetekben jobb tömörítési arányt érnek el. Az LZW azonban továbbra is fontos szerepet játszik a digitális adattárolás és -átvitel történetében, és működési elve számos későbbi tömörítési algoritmust inspirált.

Az LZW algoritmus elméleti alapjai: adattömörítés szótárral

Az LZW (Lempel-Ziv-Welch) tömörítés egy veszteségmentes adattömörítési eljárás, amelyet széles körben alkalmaznak különböző fájlformátumokban, mint például a GIF vagy a TIFF. A célja, hogy a redundáns adatokat hatékonyabban tárolja, ezáltal csökkentve a fájlméretet.

Az LZW algoritmus alapja egy dinamikusan bővülő szótár használata. Ahelyett, hogy a bemeneti adatokat közvetlenül tárolná, az algoritmus a gyakran előforduló karaktersorozatokat (stringeket) kódokkal helyettesíti. A szótár kezdetben az alap karakterkészletet tartalmazza (például az ASCII karaktereket), majd a tömörítés során új bejegyzésekkel bővül.

A tömörítés folyamata a következőképpen zajlik:

- Az algoritmus beolvassa a bemeneti adatokat karakterenként.

- Keresi a szótárban a leghosszabb olyan stringet, amely megegyezik a beolvasott karakterekkel kezdődő sorozattal.

- Ha talál ilyen stringet, akkor hozzáolvassa a következő karaktert a bemeneti adatokból.

- Ha a kibővített string már nem szerepel a szótárban, akkor a szótárban lévő string kódját kiírja a tömörített adatba, majd a kibővített stringet hozzáadja a szótárhoz egy új kóddal.

- Az algoritmus a következő karakterrel kezdi újra a keresést.

Az LZW algorimus lényege, hogy a korábban látott karaktersorozatokra hivatkozik, így nem kell azokat ismételten tárolni.

Például, tekintsük a „ABABABAB” stringet. Az algoritmus először az „A”-t találja meg a szótárban. Ezután hozzáolvassa a „B”-t, és mivel az „AB” nincs a szótárban, az „A” kódját kiírja, az „AB”-t pedig hozzáadja a szótárhoz. A következő lépésben a „B”-t találja meg a szótárban, hozzáolvassa az „A”-t, és mivel a „BA” sincs a szótárban, a „B” kódját kiírja, a „BA”-t pedig hozzáadja a szótárhoz. Ezt a folyamatot folytatva az algoritmus hatékonyan tömöríti a redundáns „ABABABAB” stringet.

A kibontás a tömörítési folyamat fordítottja. A kibontó algoritmus ugyanazt a szótárat építi fel, mint a tömörítő, a tömörített adatban található kódok alapján. Minden kódhoz tartozik egy string, amelyet a kibontó algoritmus a kibontott adatba ír. Ha az algoritmus egy olyan kódot talál, amely még nincs a szótárban, akkor az azt jelenti, hogy a kód éppen a kibontás során kerül hozzáadásra a szótárhoz.

Az LZW tömörítés hatékonysága nagyban függ a bemeneti adatok redundanciájától. Minél több ismétlődő karaktersorozatot tartalmaz az adat, annál jobb a tömörítési arány. Az LZW különösen jól működik olyan adatok esetén, mint a képek vagy a szövegek, amelyek gyakran tartalmaznak ismétlődő mintákat.

Az LZW algoritmus adaptív, ami azt jelenti, hogy a szótár a tömörítés során dinamikusan változik. Ez lehetővé teszi, hogy az algoritmus alkalmazkodjon a bemeneti adatok változó tulajdonságaihoz, és a lehető legjobb tömörítési arányt érje el.

Bár az LZW egy hatékony és széles körben használt tömörítési eljárás, fontos megjegyezni, hogy szabadalmi védelem alatt állt, ami korlátozta a szabad felhasználását. A szabadalmak lejártával azonban az LZW ismét szabadon használhatóvá vált.

Az LZW algoritmus működése lépésről lépésre: kódolási folyamat

Az LZW (Lempel-Ziv-Welch) tömörítési algoritmus egy veszteségmentes adattömörítési eljárás, melynek célja, hogy a redundáns adatok azonosításával és helyettesítésével csökkentse a fájlok méretét. A kódolási folyamat során az algoritmus egy dinamikus szótárat épít fel, melyben a bemeneti adatokban gyakran előforduló karaktersorozatokhoz rendel kódokat. Ez a szótár folyamatosan bővül a kódolás során, alkalmazkodva a bemeneti adatok sajátosságaihoz.

A kódolási folyamat alapvetően a következő lépésekből áll:

- Inicializálás: Az algoritmus indulásakor a szótár tartalmazza az összes egyedi karaktert a bemeneti adatokban. Például, ha a bemeneti adatok csak az ‘A’, ‘B’ és ‘C’ karaktereket tartalmazzák, akkor a szótár a következő bejegyzéseket tartalmazza: ‘A’ -> 65, ‘B’ -> 66, ‘C’ -> 67 (az ASCII kódokat használva).

- Olvasás és keresés: Az algoritmus beolvassa a bemeneti adatok első karakterét. Ezt követően megpróbálja a leghosszabb olyan karaktersorozatot megtalálni a szótárban, amely a beolvasott karakterrel kezdődik.

- Kódolás: Ha az algoritmus talál egyezést a szótárban, akkor a karaktersorozathoz tartozó kódot kiírja a tömörített kimenetre.

- Szótár bővítése: Az algoritmus a talált karaktersorozatot a következő karakterrel kiegészítve (ami a bemeneti adatokban következett) egy új bejegyzésként hozzáadja a szótárhoz. Ez a lépés biztosítja, hogy az algoritmus a későbbiekben is képes legyen hatékonyan tömöríteni a gyakran előforduló karaktersorozatokat.

- Ismétlés: Az algoritmus a 2-4. lépéseket ismétli a bemeneti adatok végéig.

Nézzünk egy példát a kódolási folyamatra. Tegyük fel, hogy a bemeneti adat a következő: „ABABABAA”.

1. Inicializálás: A szótár a következő bejegyzéseket tartalmazza: ‘A’ -> 65, ‘B’ -> 66.

2. Olvasás és keresés: Az algoritmus beolvassa az ‘A’ karaktert. Az ‘A’ megtalálható a szótárban.

3. Kódolás: Az algoritmus kiírja az ‘A’ kódját (65) a tömörített kimenetre.

4. Szótár bővítése: Az algoritmus az ‘A’ karaktert a következő karakterrel (‘B’) kiegészítve, az ‘AB’ karaktersorozatot hozzáadja a szótárhoz: ‘AB’ -> 67.

5. Olvasás és keresés: Az algoritmus beolvassa a ‘B’ karaktert. A ‘B’ megtalálható a szótárban.

6. Kódolás: Az algoritmus kiírja a ‘B’ kódját (66) a tömörített kimenetre.

7. Szótár bővítése: Az algoritmus a ‘B’ karaktert a következő karakterrel (‘A’) kiegészítve, a ‘BA’ karaktersorozatot hozzáadja a szótárhoz: ‘BA’ -> 68.

8. Olvasás és keresés: Az algoritmus beolvassa az ‘A’ karaktert. Majd a ‘B’ karaktert is. Az ‘AB’ karaktersorozat megtalálható a szótárban.

9. Kódolás: Az algoritmus kiírja az ‘AB’ kódját (67) a tömörített kimenetre.

10. Szótár bővítése: Az algoritmus az ‘AB’ karaktersorozatot a következő karakterrel (‘A’) kiegészítve, az ‘ABA’ karaktersorozatot hozzáadja a szótárhoz: ‘ABA’ -> 69.

11. Olvasás és keresés: Az algoritmus beolvassa az ‘A’ karaktert. Majd a ‘B’ karaktert is. Majd az ‘A’ karaktert is. Az ‘ABA’ karaktersorozat megtalálható a szótárban.

12. Kódolás: Az algoritmus kiírja az ‘ABA’ kódját (69) a tömörített kimenetre.

13. Szótár bővítése: Az algoritmus az ‘ABA’ karaktersorozatot a következő karakterrel (‘A’) kiegészítve, az ‘ABAA’ karaktersorozatot hozzáadja a szótárhoz: ‘ABAA’ -> 70.

14. Olvasás és keresés: Az algoritmus beolvassa az ‘A’ karaktert. Az ‘A’ megtalálható a szótárban.

15. Kódolás: Az algoritmus kiírja az ‘A’ kódját (65) a tömörített kimenetre.

A tömörített kimenet tehát a következő: 65 66 67 69 65.

Az LZW algoritmus hatékonysága nagymértékben függ a bemeneti adatokban található redundancia mértékétől. Minél több ismétlődő karaktersorozat található a bemeneti adatokban, annál hatékonyabban tudja az algoritmus tömöríteni az adatokat. Az algoritmus különösen jól teljesít olyan adatok esetén, mint például a szövegek, képek és hangfájlok, amelyek gyakran tartalmaznak ismétlődő mintákat.

Az LZW algoritmus egyik legnagyobb előnye, hogy nem igényel előzetes információt a bemeneti adatokról. Ez azt jelenti, hogy az algoritmus képes önállóan alkalmazkodni a bemeneti adatok sajátosságaihoz, és hatékonyan tömöríteni azokat.

A szótár mérete korlátozott, ezért amikor a szótár megtelik, az algoritmus vagy törli a szótárat és újrakezdi az építését, vagy a kevésbé használt bejegyzéseket törli, hogy helyet csináljon az új bejegyzéseknek. A szótár kezelésének módja befolyásolja a tömörítési arányt és a tömörítési sebességet.

Az LZW algoritmust széles körben használják különböző alkalmazásokban, például a GIF képformátumban és a TIFF képformátumban. Az algoritmus egyszerűsége és hatékonysága miatt továbbra is népszerű választás adattömörítési feladatokra.

Az LZW algoritmus működése lépésről lépésre: dekódolási folyamat

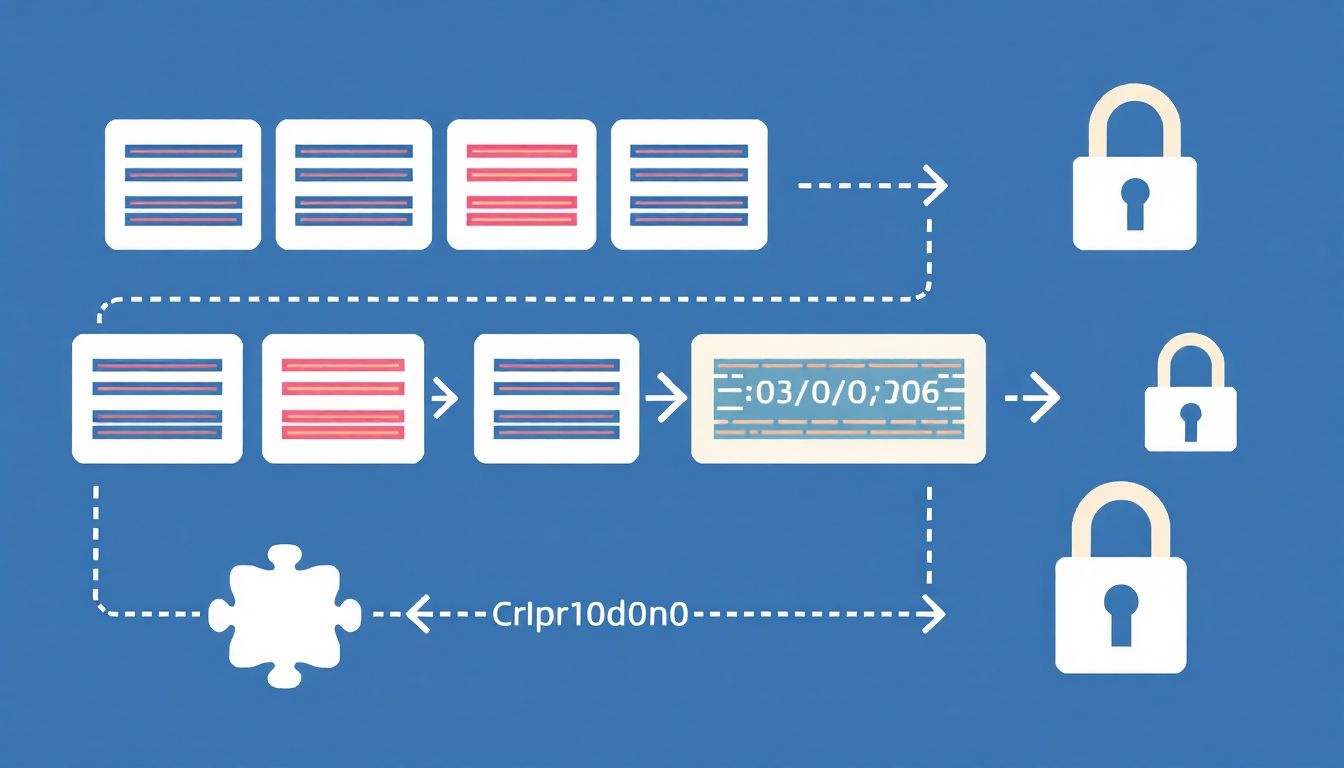

Az LZW tömörítés (Lempel-Ziv-Welch) egy veszteségmentes adatkompressziós algoritmus, ami azt jelenti, hogy a tömörített adatból pontosan visszaállítható az eredeti adat. A dekódolási folyamat az LZW algoritmusnak a kulcsfontosságú része, hiszen ez teszi lehetővé, hogy a tömörített adatot visszaalakítsuk az eredeti, olvasható formátumra.

A dekódolási eljárás alapja egy szótár, amely a tömörítés során épült fel. A dekódoló is létrehoz egy azonos szótárat, és a tömörített adatokban található kódokat a szótárban található megfelelő karakterláncokra cseréli. A folyamat során a dekódoló dinamikusan bővíti a szótárat, hasonlóan a tömörítőhöz, így biztosítva, hogy a dekódolás helyesen történjen.

A dekódolási folyamat lépései:

- Inicializálás: A dekódoló létrehoz egy szótárat, amely az összes egyedi karaktert tartalmazza az eredeti adatokból (például az ASCII karaktereket). Ez a szótár megegyezik a tömörítéskor használt kezdeti szótárral.

- Első kód beolvasása: A dekódoló beolvassa a tömörített adatfolyam első kódját.

- Kód dekódolása: A dekódoló megkeresi a kódot a szótárban. A kódhoz tartozó karakterlánc lesz a dekódolt kimenet első része.

- Következő kód beolvasása: A dekódoló beolvassa a tömörített adatfolyam következő kódját.

- Szótár frissítése: Itt jön a dekódolás trükkösebb része. A dekódoló létrehoz egy új bejegyzést a szótárban. Az új bejegyzés a legutóbb dekódolt karakterlánc és a most dekódolt karakterlánc első karakterének összefűzéséből áll.

Az LZW algoritmus hatékonysága abban rejlik, hogy képes ismétlődő mintákat azonosítani és azokat rövid kódokkal helyettesíteni, ezáltal csökkentve az adat méretét.

- Kód dekódolása és kimenet generálása: A dekódoló megkeresi az aktuális kódot a szótárban, és a hozzá tartozó karakterláncot hozzáadja a dekódolt kimenethez.

- Ismétlés: A 4-7. lépések ismétlődnek, amíg a tömörített adatfolyam végére nem ér a dekódoló.

Például, ha a tömörített adatfolyam a következő kódokat tartalmazza: 65, 66, 65, 256, 257, és a kezdeti szótár az ASCII karaktereket tartalmazza (65 = ‘A’, 66 = ‘B’), akkor a dekódolási folyamat a következőképpen néz ki:

- 65 dekódolása: ‘A’ (a kimenet ‘A’)

- 66 dekódolása: ‘B’ (a kimenet ‘AB’)

- 65 dekódolása: ‘A’ (a kimenet ‘ABA’)

- Szótár frissítése: 256 = ‘AB’

- 256 dekódolása: ‘AB’ (a kimenet ‘ABAAB’)

- 257 dekódolása: ‘BA’ (a kimenet ‘ABAABBA’)

- Szótár frissítése: 257 = ‘BA’

- Szótár frissítése: 258 = ‘ABA’

Fontos megjegyezni, hogy a dekódolási folyamatnak pontosan követnie kell a tömörítési folyamatot ahhoz, hogy a dekódolt adat megegyezzen az eredeti adattal. Ha a dekódoló nem tudja követni a tömörítő által használt logikát, a dekódolás hibás lesz, és az eredmény értelmetlen adathalmaz lesz.

Az LZW algoritmus dekódolási folyamata viszonylag egyszerű és hatékony, ami az egyik oka annak, hogy ez az algoritmus széles körben elterjedt a különböző alkalmazásokban, például a GIF képek tömörítésében és a UNIX compress parancsában.

A dekódolás során előfordulhat egy speciális eset, amikor a dekódoló olyan kódra talál, amely még nem szerepel a szótárban. Ez akkor fordulhat elő, amikor a tömörítő a szótárat egy olyan karakterlánccal bővíti, amelynek az első karaktere megegyezik az utolsó karakterével. Ebben az esetben a dekódoló a legutóbbi dekódolt karakterláncot veszi, hozzáadja az első karakterét, és ezt a karakterláncot használja a kód dekódolására. Ezzel a módszerrel a dekódoló képes kezelni ezt a ritka, de lehetséges esetet.

A dekódolási algoritmus hatékonyságát nagyban befolyásolja a szótár mérete. Minél nagyobb a szótár, annál több különböző karakterláncot képes tárolni, ami potenciálisan jobb tömörítési arányt eredményezhet. Ugyanakkor a nagyobb szótár több memóriát igényel, és a keresési idő is megnövekedhet. A gyakorlatban a szótár méretét általában a rendelkezésre álló memóriához és a tömörítési sebességhez igazítják.

Az LZW dekódolás tehát egy elegáns és hatékony módja annak, hogy a tömörített adatokat visszaalakítsuk az eredeti formátumra. A szótár dinamikus építése és a kódok egyszerű cseréje teszi lehetővé, hogy az algoritmus gyorsan és pontosan működjön, így biztosítva a veszteségmentes adatvisszaállítást.

Az LZW algoritmus pszeudokódja

Az LZW tömörítés alapja egy dinamikusan bővülő szótár. A pszeudokód bemutatja, hogy ez a szótár hogyan épül fel a tömörítés során.

A tömörítés algoritmusa a következő lépésekből áll:

- Inicializálás: A szótár feltöltése az összes lehetséges egybájtos karakterrel (0-255 közötti ASCII kódok).

- Input olvasása: Beolvasás a tömörítendő adatfolyamból egy karakterenként.

- Keresés: A beolvasott karakterlánc (string) keresése a szótárban.

- Egyeztetés:

- Ha a karakterlánc megtalálható a szótárban, akkor a karakterlánc kibővül a következő beolvasott karakterrel.

- Ha a karakterlánc nem található a szótárban, akkor a szótárba bekerül az új karakterlánc, mely az előző karakterlánc és a következő beolvasott karakter konkatenációja.

- Az előző karakterlánc kódja kerül kiírásra a tömörített adatfolyamba.

- Ismétlés: A 2-4. lépések ismétlése a teljes adatfolyam feldolgozásáig.

Az LZW algoritmus lényege, hogy a gyakran előforduló karaktersorozatokat egyetlen kóddal helyettesíti, ezáltal csökkentve a fájl méretét.

A pszeudokód a következőképpen nézhet ki:

Szótár inicializálása:

- Minden egybájtos karakterhez (0-255) rendelünk egy kódot (az ASCII értéket).

Tömörítési ciklus:

- string = Első karakter az inputból

- Amíg van bemenet:

- character = Következő karakter az inputból

- Ha string + character benne van a szótárban:

- string = string + character

- Egyébként:

- Kiírjuk a string kódját a tömörített outputba

- Szótárba beszúrjuk a string + character-t, új kóddal

- string = character

- Kiírjuk a string kódját a tömörített outputba

A dekompressziós algoritmus a tömörítési algoritmus inverze. A tömörített adatfolyam alapján rekonstruálja a szótárat és az eredeti adatokat.

A szótár dinamikus bővülése lehetővé teszi, hogy az algoritmus alkalmazkodjon a bemeneti adatok jellegéhez, és hatékonyan tömörítse azokat. A hatékonyság nagymértékben függ a bemeneti adatok ismétlődő mintáitól.

Például, ha a bemeneti adatfolyam sokszor tartalmazza az „ABABA” karaktersorozatot, akkor az LZW algoritmus ezt a sorozatot egyetlen kóddal fogja helyettesíteni, ezzel jelentősen csökkentve a fájl méretét. A kulcs a gyakran előforduló mintázatok azonosításában és kódolásában rejlik.

Az LZW szótár inicializálása és dinamikus bővítése

Az LZW tömörítés hatékonyságának kulcsa a szótár inicializálásában és dinamikus bővítésében rejlik. A tömörítési folyamat elején egy kezdeti szótárat hozunk létre, amely az összes előforduló egykarakteres szimbólumot tartalmazza. Például, ha a bemeneti adat ASCII karaktereket használ, a szótár az ASCII tábla 256 karakterét tartalmazza. Ez a kezdeti szótár biztosítja, hogy minden bemeneti karakter kódolható legyen a tömörítés kezdetén.

A tömörítés során a szótár dinamikusan bővül. A tömörítő algoritmus folyamatosan keresi a bemeneti adatokban előforduló karakterláncokat. Ha talál egy olyan karakterláncot, amely még nem szerepel a szótárban, akkor ezt a karakterláncot hozzáadja a szótárhoz, és hozzárendel egy új kódot. Ez a dinamikus bővítés lehetővé teszi, hogy az LZW algoritmus hatékonyan tömörítse azokat az adatokat, amelyekben ismétlődő minták találhatók.

A szótár dinamikus bővítése teszi az LZW-t adaptívvá: képes a bemeneti adatokban található mintákhoz igazodni, és ezáltal optimalizálni a tömörítési arányt.

A szótár bővítése során a tömörítő algoritmus az aktuális bemeneti karakterláncot (string) és a következő bemeneti karaktert kombinálja. Ha ez a kombináció még nem szerepel a szótárban, akkor hozzáadja. Például, ha a szótár tartalmazza az „ab” karakterláncot, és a következő bemeneti karakter „c”, akkor a szótárba felveszi az „abc” karakterláncot. Ezt a folyamatot addig folytatja, amíg a teljes bemeneti adatot fel nem dolgozta.

A kicsomagolás során a kicsomagoló algoritmus pontosan ugyanúgy építi fel a szótárat, mint a tömörítő. Mivel a kicsomagoló ismeri a kezdeti szótárat és a tömörítő algoritmus szabályait, képes rekonstruálni az eredeti adatokat a tömörített kódok alapján. Ez a szimmetrikus megközelítés biztosítja a veszteségmentes tömörítést.

Fontos, hogy a szótár mérete korlátozott. Amikor a szótár eléri a maximális méretét, az algoritmus vagy leállítja a szótár bővítését, vagy visszaállítja a kezdeti szótárat. A szótár méretének megfelelő megválasztása kritikus a tömörítési hatékonyság szempontjából. A túl kicsi szótár nem képes kihasználni az adatban rejlő ismétlődéseket, míg a túl nagy szótár feleslegesen növeli a memóriaigényt.

Az LZW tömörítési arányának befolyásoló tényezői

Az LZW tömörítés hatékonyságát, vagyis a tömörítési arányt számos tényező befolyásolja. Az egyik legfontosabb a bemeneti adatok jellege. Minél több ismétlődő minta van az adatokban, annál jobb tömörítést érhetünk el. Ez azt jelenti, hogy a szöveges fájlok, különösen azok, amelyek sok ismétlődő szót vagy kifejezést tartalmaznak, általában jól tömöríthetők LZW-vel.

A szótár mérete is kulcsfontosságú. Egy nagyobb szótár lehetővé teszi, hogy az algoritmus több mintát tároljon, ami elvileg jobb tömörítést eredményezhet. Ugyanakkor, ha a szótár túl nagy, az egyes kódok tárolásához több bitre van szükség, ami csökkentheti a tömörítési arányt. A megfelelő szótárméret megtalálása tehát kritikus.

Az LZW tömörítési aránya nagymértékben függ az adatok redundanciájától; minél redundánsabbak az adatok, annál magasabb a tömörítési arány.

A bemeneti adatok entrópiája szintén meghatározó tényező. Az entrópia az információ tartalmának mértéke. Minél magasabb az entrópia, annál kevésbé tömöríthetőek az adatok. Például, egy véletlenszerűen generált adatfolyam, amelyben nincs ismétlődés, nagyon nehezen tömöríthető LZW-vel.

Végül, az LZW implementáció részletei is befolyásolhatják a tömörítési arányt. Például a szótár kezelésének módja (pl. a szótár nullázása, ha megtelik) és a kódok hozzárendelésének stratégiája mind hatással lehet a végeredményre. Az LZW algoritmus különböző variánsai léteznek, amelyek különböző tömörítési arányokat eredményezhetnek ugyanazon a bemeneti adathalmazon.

Példák az LZW tömörítés alkalmazására különböző adattípusokon

Az LZW tömörítés sokoldalúsága abban rejlik, hogy különböző adattípusokon is hatékonyan alkalmazható. Nézzünk néhány példát:

- Szöveges adatok: Az LZW kiválóan teljesít szöveges fájlok esetén, különösen azokban, ahol gyakran ismétlődő szavak vagy kifejezések fordulnak elő. Például, egy hosszú jogi dokumentumban a „szerződő felek” kifejezés sokszor szerepelhet. Az LZW ezeket a ismétlődéseket felismeri és tömöríti, jelentősen csökkentve a fájl méretét.

- Képfájlok (GIF): A GIF (Graphics Interchange Format) az egyik leggyakoribb példa az LZW tömörítés alkalmazására. A GIF képek jellemzően kevés színt tartalmaznak, ami azt jelenti, hogy sok azonos színű képpont (pixel) van egymás mellett. Az LZW hatékonyan tömöríti ezeket a szekvenciákat, anélkül, hogy a kép minősége romlana (veszteségmentes tömörítés).

- Képfájlok (TIFF): Egyes TIFF (Tagged Image File Format) formátumú képek is alkalmazhatják az LZW tömörítést. Ez különösen hasznos nagy felbontású képek esetén, ahol a fájlméret jelentős lehet.

- Adatbázisok: Az LZW alkalmazható adatbázisokban tárolt adatok tömörítésére is. Például, egy nagy táblázatban, ahol sok azonos érték szerepel egy adott oszlopban, az LZW tömörítés jelentősen csökkentheti a tárolási igényt.

- Programkód: Bár a programkód nem feltétlenül ismétlődő, az LZW mégis alkalmazható rá, különösen ha a kód sok hasonló struktúrát vagy függvényhívást tartalmaz. A tömörítés mértéke függ a kód komplexitásától és redundanciájától.

Fontos megjegyezni, hogy az LZW tömörítés hatékonysága nagymértékben függ az adatok jellegétől. Minél több ismétlődés van az adatokban, annál jobb a tömörítési arány.

Az LZW tömörítés a veszteségmentes tömörítési eljárások közé tartozik, ami azt jelenti, hogy a tömörített adatokból az eredeti adatok pontosan visszaállíthatók. Ez kritikus fontosságú olyan alkalmazásokban, ahol az adatvesztés elfogadhatatlan.

Például, egy orvosi képalkotó rendszerben, ahol a diagnosztikai pontosság elengedhetetlen, az LZW tömörítés alkalmazása biztosítja, hogy a képek részletei ne vesszenek el a tömörítés során.

Egy másik példa lehet a szoftverdisztribúció, ahol a szoftverfájlok integritásának megőrzése kiemelten fontos. Az LZW tömörítés lehetővé teszi, hogy a szoftverfájlok kisebb méretben kerüljenek terjesztésre, miközben garantálja, hogy a felhasználó az eredeti, sértetlen szoftvert kapja meg.

Az LZW tömörítés előnyei és hátrányai más tömörítési eljárásokhoz képest

Az LZW tömörítés veszteségmentes tömörítési eljárás, ami azt jelenti, hogy a tömörített adatokból az eredeti adatokat pontosan vissza lehet állítani. Más veszteséges tömörítési eljárásokkal, mint például a JPEG (képekhez) vagy az MP3 (hanghoz) szemben, az LZW nem dob el információt. Ez előnyös olyan helyzetekben, ahol az adatok integritása kritikus, például szöveges dokumentumok, szoftverek vagy orvosi képek esetén.

Az LZW előnye a viszonylagos egyszerűsége és gyorsasága. A tömörítési és kitömörítési algoritmusok könnyen implementálhatók, és a legtöbb esetben gyorsan működnek. Ezzel szemben például a Huffman-kódolás, bár szintén veszteségmentes, bonyolultabb és időigényesebb lehet, főleg nagyméretű fájlok esetén. Az LZW adaptív is, ami azt jelenti, hogy a tömörítési szótár a tömörítés során dinamikusan épül fel, a bemeneti adatok alapján. Ez lehetővé teszi, hogy az eljárás hatékonyan tömörítse a különböző típusú adatokat, anélkül, hogy előre definiált szótárat kellene használnia.

Az LZW hatékonysága nagymértékben függ az adatok ismétlődő mintázatainak gyakoriságától. Minél több ismétlődő minta van egy fájlban, annál jobb tömörítési arányt lehet elérni.

Ugyanakkor az LZW hátrányai is vannak. A tömörítési arány nem mindig a legjobb. Például véletlenszerű adatok vagy kevés ismétlődő mintát tartalmazó fájlok esetén az LZW nem feltétlenül nyújt jelentős tömörítést, sőt, akár növelheti is a fájl méretét. Más tömörítési eljárások, mint például a DEFLATE (amit a ZIP fájlokban használnak), általában jobban teljesítenek ilyen esetekben. Továbbá, az LZW szabadalmi korlátozások alá esett a múltban, ami korlátozta a szabad felhasználását bizonyos alkalmazásokban. Bár ezek a szabadalmak már lejártak, a múltbeli korlátozások befolyásolhatták az eljárás elterjedését.

Összehasonlítva a veszteséges tömörítési eljárásokkal, az LZW előnye a veszteségmentesség, ami kritikus a fontos adatok megőrzése szempontjából. Viszont hátránya, hogy a tömörítési arány általában alacsonyabb, mint a veszteséges eljárásoké, amelyek jelentősen csökkenthetik a fájlméretet az adatok pontosságának feláldozásával.

Az LZW variánsai és optimalizációs technikái

Az LZW tömörítés alapelveinek megértése után érdemes megvizsgálni a különböző variánsokat és optimalizációs technikákat, amelyek célja a hatékonyság növelése és a korlátok leküzdése.

Az egyik gyakori variáns a korlátozott szótár használata. Az alapszabály szerint a szótár folyamatosan bővül. Ez azonban memóriakorlátokba ütközhet. A korlátozott szótár esetén, amikor a szótár megtelik, a legkevésbé használt bejegyzéseket eltávolítják (LRU – Least Recently Used), vagy a teljes szótárat visszaállítják az alapállapotba. Ez utóbbi megoldás egyszerűbb, de kevésbé hatékony.

A szótár méretének optimalizálása kulcsfontosságú a tömörítési arány és a sebesség szempontjából.

Egy másik fontos szempont a kódhossz kezelése. Az LZW kezdetben fix hosszúságú kódokat használ. A tömörítés során azonban célszerű lehet változó hosszúságú kódokat alkalmazni. Például, amíg a szótár mérete kicsi, rövidebb kódokat használunk, majd a szótár bővülésével növeljük a kódok hosszát. Ezáltal a gyakrabban előforduló szekvenciák rövidebb kódokkal reprezentálhatók, ami javítja a tömörítési arányt.

A bit order (LSB – Least Significant Bit vagy MSB – Most Significant Bit) is befolyásolhatja a teljesítményt. Egyes implementációk a biteket fordított sorrendben tárolják, ami hatással lehet a dekódolási sebességre.

Az LZW implementációk gyakran alkalmaznak különböző heurisztikákat a szótár építése során. Például, bizonyos szekvenciákat előnyben részesíthetnek a szótárba való felvételkor, ha azok statisztikailag valószínűbbek az adott adatban.

Végül, a hardveres implementáció is jelentős optimalizálási lehetőségeket kínál. Egy dedikált hardveres LZW tömörítő/bontó jelentősen gyorsabb lehet, mint a szoftveres megoldások.

Gyakori hibák és problémák az LZW implementációban

Az LZW implementáció során számos gyakori hibával és problémával találkozhatunk, melyek jelentősen befolyásolhatják a tömörítés hatékonyságát, vagy akár hibás működéshez is vezethetnek.

Az egyik leggyakoribb probléma a szótár méretének kezelése. A szótárnak véges mérete van, és ha megtelik, a programnak döntenie kell, hogy mi történjen. A legrosszabb eset, ha a program egyszerűen leáll, de ennél kifinomultabb megoldások is léteznek. Például a legkevésbé használt bejegyzések eltávolítása, vagy a szótár teljes újraindítása.

Egy másik gyakori hiba a szótár inicializálásának hiánya. Az LZW algoritmusnak egy alapszótárral kell indulnia, amely tartalmazza az összes lehetséges egykarakteres szimbólumot. Ha ez a lépés kimarad, a tömörítési arány jelentősen romlik, és a dekódolás során is problémák merülhetnek fel.

A kódolási és dekódolási folyamatok szinkronizációjának biztosítása kritikus fontosságú. Ha a kódoló és a dekódoló eltérő szótárt használ, a dekódolás hibás eredményeket fog produkálni. Ez különösen akkor fordulhat elő, ha a szótárkezelési algoritmus eltér a két oldalon.

A memóriakezelés is sarkalatos pont. A szótár nagyméretű is lehet, ezért a helytelen memóriakezelés memóriaszivárgáshoz vagy más memóriahibákhoz vezethet.

Gyakori hiba továbbá a speciális karakterek helytelen kezelése. Bizonyos karakterek (például a fájlvége jelző) problémákat okozhatnak, ha nem megfelelően kezelik őket.

Végül, a teljesítmény optimalizálása is kihívást jelenthet. Az LZW algoritmus sebessége nagyban függ a szótárban való keresés hatékonyságától. A lassú keresési algoritmusok jelentősen lelassíthatják a tömörítési és dekódolási folyamatot. A hatékony adatszerkezetek (például hash táblák) használata elengedhetetlen a jó teljesítmény eléréséhez.

Az LZW algoritmus licencelési kérdései és szabadalmi helyzete

Az LZW algoritmus elterjedését jelentősen befolyásolták a licencelési kérdések és a szabadalmi helyzet. Az 1980-as években és 1990-es évek elején az Unisys cég rendelkezett az LZW algoritmus szabadalmával az Egyesült Államokban és más országokban. Ez azt jelentette, hogy a szoftverfejlesztőknek, akik az LZW-t használták termékeikben (például GIF képeknél), licencdíjat kellett fizetniük az Unisysnek.

Ez komoly vitákat váltott ki, mivel az LZW algoritmus egyre népszerűbbé vált a digitális képek tömörítésére. Sok fejlesztő úgy érezte, hogy egy alapvető tömörítési eljárás szabadalmaztatása akadályozza az innovációt és a szoftverfejlesztést.

A szabadalmak lejárta után az LZW használata ismét szabadabbá vált, de a korábbi jogi bizonytalanságok nyomot hagytak.

A helyzetet bonyolította, hogy nem csak az Unisysnek voltak szabadalmai az LZW-hez kapcsolódóan. A Sperry Corporation (később Unisys) és a Compuserve is rendelkezett releváns szabadalmakkal. A Compuserve eredetileg a GIF formátumot fejlesztette ki, és az LZW-t használta a képek tömörítésére.

A szabadalmak fokozatosan lejártak az évek során. Az amerikai szabadalom 2003-ban járt le, ami jelentősen csökkentette a jogi kockázatokat az LZW használata szempontjából. Azonban fontos megjegyezni, hogy más országokban a szabadalmak eltérő időpontban jártak le.

A szabadalmak lejárta után az LZW ismét széles körben használhatóvá vált, és a mai napig alkalmazzák bizonyos területeken, bár az újabb tömörítési algoritmusok, mint például a DEFLATE (a PNG formátumban használt) gyakran jobb teljesítményt nyújtanak.

Az LZW algoritmus implementációja különböző programozási nyelveken (C, Python, Java)

Az LZW tömörítés hatékonysága nagymértékben függ a megvalósítás minőségétől. A különböző programozási nyelvek eltérő lehetőségeket kínálnak az algoritmus optimalizálására. Lássuk, hogyan valósítható meg az LZW C, Python és Java nyelveken.

C nyelv: A C nyelv alacsony szintű hozzáférést biztosít a memóriához, ami lehetővé teszi a tömörítési tábla hatékony kezelését. A C implementációk gyakran használják a malloc és realloc függvényeket a tábla dinamikus méretezéséhez. A bitműveletek optimalizálásával jelentős sebességnövekedés érhető el a kódolás és dekódolás során. Egy tipikus C implementációban a szótár egy dinamikusan allokált tömbként vagy egy hasítótáblaként valósul meg. A teljesítmény szempontjából kritikus fontosságú, hogy a szótárban való keresés és beillesztés gyors legyen. A hibakezelés is elengedhetetlen, mivel a memóriakezelés során könnyen előfordulhatnak problémák.

Python nyelv: A Python egy magasabb szintű nyelv, amely egyszerűbbé teszi a kódolást, de általában lassabb, mint a C. Az LZW Python implementációk gyakran használják a beépített dict típust a szótár tárolására. A Python kód olvashatóbb és könnyebben karbantartható, de a teljesítmény optimalizálása kihívást jelenthet. A zlib modul már tartalmaz LZW implementációt, de a saját implementációk lehetőséget adnak az algoritmus mélyebb megértésére és testreszabására. A Pythonban a karakterláncok kezelése automatikus, ami egyszerűsíti a bemeneti adatok feldolgozását. Fontos, hogy a Python implementációk kezeljék a nagy fájlokat is, ami memóriakorlátokat vethet fel.

Java nyelv: A Java platformfüggetlen és objektumorientált, ami lehetővé teszi az LZW algoritmus moduláris felépítését. A Java implementációk gyakran használják a HashMap osztályt a szótár tárolására. A Java virtuális gép (JVM) automatikus szemétgyűjtést biztosít, ami csökkenti a memóriaszivárgás kockázatát. A Java teljesítménye általában jobb, mint a Pythoné, de elmarad a C-től. A Java implementációk kihasználhatják a több szálú feldolgozást a tömörítés és a kitömörítés felgyorsítására. A java.util.zip csomag tartalmaz LZW alapú tömörítési algoritmusokat, de egyedi implementációk a specifikus igényekhez igazíthatók.

Az LZW implementációk hatékonysága a szótár méretétől és a bemeneti adatok jellegétől függ.

Összehasonlítás: A C nyelv a legjobb teljesítményt nyújtja, de a kódolás bonyolultabb és több hibalehetőséget rejt magában. A Python egyszerűbb kódolást tesz lehetővé, de a teljesítmény gyengébb. A Java kompromisszumot kínál a teljesítmény és a kódolás egyszerűsége között. A nyelvválasztás a projekt követelményeitől és a fejlesztői tapasztalattól függ.

Az alábbi táblázat összefoglalja a főbb különbségeket:

| Nyelv | Teljesítmény | Kódolás egyszerűsége | Memóriakezelés |

|---|---|---|---|

| C | Kiváló | Nehéz | Manuális |

| Python | Gyenge | Egyszerű | Automatikus |

| Java | Jó | Közepes | Automatikus |

Az LZW tömörítés teljesítményének mérése és elemzése

Az LZW tömörítés teljesítményének mérése és elemzése során kulcsfontosságú a tömörítési arány vizsgálata. Ez az arány mutatja meg, hogy az eredeti fájl mérete mennyire csökkent a tömörítés után. Minél nagyobb ez az arány, annál hatékonyabb a tömörítési eljárás.

A tömörítési arányt befolyásolja több tényező, például a bemeneti adatok jellege. Az LZW különösen jól teljesít olyan adatok esetén, amelyekben gyakran ismétlődő mintázatok találhatók. Ezzel szemben, véletlenszerű adatok esetén a tömörítési arány alacsony lehet, sőt, akár növekedhet is a fájlméret.

A szótár mérete szintén meghatározó tényező. Egy nagyobb szótár több mintázatot tud tárolni, ami elméletileg jobb tömörítést eredményezhet. Ugyanakkor a nagyobb szótár tárolása is erőforrásokat igényel, és a keresési idő is megnőhet.

Az LZW tömörítés hatékonyságát jelentősen befolyásolja a bemeneti adatok entropiája: minél alacsonyabb az entropia (azaz minél kevesebb információt tartalmaz egy adott adatmennyiség), annál jobb a tömörítési arány.

A tömörítési és kicsomagolási sebesség szintén fontos szempont. Bár egy magas tömörítési arány kívánatos, ha a tömörítés vagy kicsomagolás túl sok időt vesz igénybe, az kompromisszumot jelent a használhatóság szempontjából. A sebesség mérésére különböző benchmarkokat lehet használni, amelyek különböző típusú fájlokon tesztelik az algoritmust.

A teljesítmény elemzéséhez figyelembe kell venni a szükséges memória mennyiségét is. Az LZW algoritmus futása során a szótár tárolásához memória szükséges. A memóriaigény függ a szótár méretétől és a bemeneti adatoktól.

Összefoglalva, az LZW tömörítés teljesítményének mérése és elemzése egy komplex feladat, amely magában foglalja a tömörítési arány, a sebesség, és a memóriaigény vizsgálatát, figyelembe véve a bemeneti adatok jellegét és az alkalmazott paramétereket.