A HDFS Alapjai: Mi is az a Hadoop Elosztott Fájlrendszer?

A HDFS, azaz a Hadoop Distributed File System, a Hadoop ökoszisztéma gerince, amely forradalmasította a big data tárolását és feldolgozását. Lényegében egy elosztott fájlrendszer, amelyet úgy terveztek, hogy hatalmas mennyiségű adatot (terabájtoktól petabájtokig) tároljon megbízhatóan, nagyszámú, olcsó, árucikk szintű hardveres szerveren.

A hagyományos fájlrendszerekkel ellentétben, amelyek egyetlen gépen tárolják az adatokat, a HDFS az adatokat több gépre terjeszti szét, így rendkívül skálázható és hibatűrő. Ez a megközelítés lehetővé teszi a párhuzamos feldolgozást, ami kulcsfontosságú a modern adatfeldolgozási kihívások kezelésében. A HDFS architektúrája kifejezetten a nagy adatblokkok írására és egyszeri olvasására optimalizált, nem pedig a gyakori, kis fájlok módosítására.

A HDFS alapvető célja az volt, hogy megoldja azokat a problémákat, amelyek a hatalmas, strukturálatlan vagy félig strukturált adathalmazok kezelésénél merültek fel. A Google File System (GFS) ihlette, és a nulláról építették fel, hogy megfeleljen a big data analitika egyedi igényeinek. Ez a rendszer nem csupán egy tárolóeszköz, hanem egy alapvető komponens, amely lehetővé teszi a komplex adatkezelési és adatfeldolgozási feladatok hatékony végrehajtását a Hadoop keretrendszeren belül.

A HDFS egy alapvetően append-only (csak hozzáfűzés) fájlrendszer, ami azt jelenti, hogy a fájlok létrehozása után az adatok hozzáadhatók a végükhöz, de a már meglévő adatok nem módosíthatók vagy törölhetők tetszőlegesen a fájl közepén. Ez a tervezési elv egyszerűsíti a konzisztencia kezelését és optimalizálja az olvasási teljesítményt a nagy, szekvenciális adathalmazok esetében. Ez a tulajdonság teszi ideálissá olyan alkalmazásokhoz, mint a naplófájlok tárolása, archívumok kezelése vagy nagy adathalmazok egyszeri betöltése analitikai célokra.

A HDFS az alapja a big data feldolgozásnak a Hadoop ökoszisztémában, lehetővé téve a hatalmas adathalmazok megbízható és skálázható tárolását, amely elengedhetetlen a modern adatvezérelt alkalmazásokhoz.

Miért Pont a HDFS? A Big Data Tárolás Kihívásai

A hagyományos tárolórendszerek, mint például a Network Attached Storage (NAS) vagy a Storage Area Network (SAN), nem voltak felkészülve a big data korszak kihívásaira. Ezeket a rendszereket jellemzően korlátozott skálázhatóság, magas költségek és a hibatűrés hiánya jellemezte nagyméretű, elosztott környezetekben. Amikor az adatok mennyisége terabájtokról petabájtokra, sőt exabájtokra nőtt, egy új megközelítésre volt szükség.

A HDFS pontosan ezekre a kihívásokra kínál megoldást:

- Hatalmas adatmennyiségek kezelése: A HDFS képes petabájtos, sőt exabájtos adatok tárolására, horizontális skálázással, azaz további gépek hozzáadásával a klaszterhez.

- Költséghatékonyság: Olcsó, árucikk szintű hardvereken fut, ami jelentősen csökkenti az infrastruktúra költségeit a speciális, drága tárolómegoldásokhoz képest.

- Hibatűrés: Az adatok többszörös másolatban tárolódnak (replikáció), így ha egy gép meghibásodik, az adatok továbbra is elérhetők maradnak a klaszter többi részén. Ez biztosítja az adatvesztés elleni védelmet és a folyamatos rendelkezésre állást.

- Alkalmasság a Batch Feldolgozásra: A HDFS tervezése optimalizálja a nagy fájlok szekvenciális olvasását és írását, ami ideális a MapReduce és más batch feldolgozási keretrendszerek számára. A „write once, read many times” (egyszer írd meg, sokszor olvasd el) modell tökéletesen illeszkedik az analitikai munkaterhelésekhez.

- Adatlokalitás: A HDFS lehetővé teszi, hogy a feldolgozó logika (pl. MapReduce feladatok) közelebb kerüljön az adatokhoz, minimalizálva a hálózati forgalmat és javítva a teljesítményt. Ez a „compute where the data is” (számítás ott, ahol az adat van) paradigma alapvető a big data feldolgozás hatékonyságában.

A HDFS tervezési filozófiája az, hogy a hardverhiba nem kivétel, hanem szabály. Ez a megközelítés tette lehetővé egy olyan robusztus rendszer létrehozását, amely képes megbízhatóan működni nagyszámú, potenciálisan megbízhatatlan komponensből álló klaszterekben. A HDFS tehát nem csupán egy fájlrendszer, hanem egy stratégiai eszköz a big data kihívásainak leküzdésére, alapot biztosítva a modern adatvezérelt alkalmazásoknak.

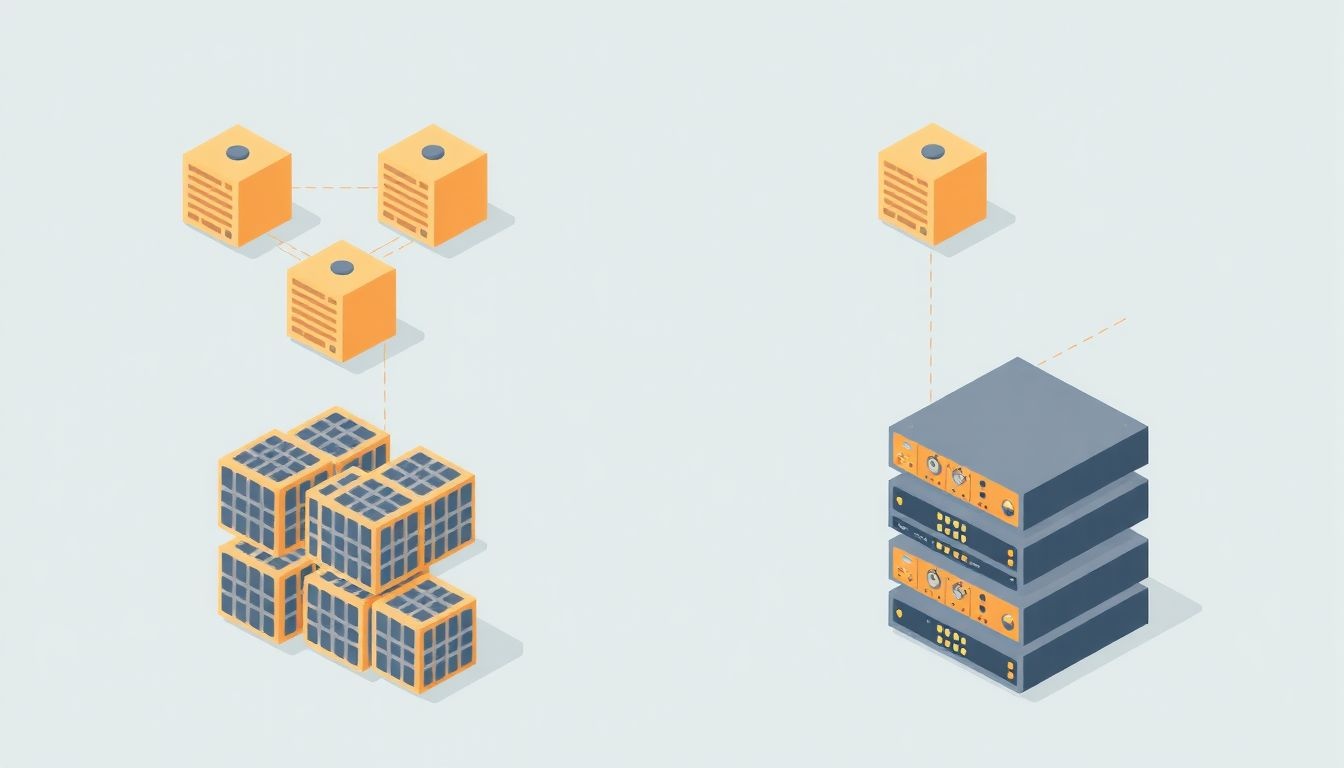

A HDFS Architektúra Részletesen: NameNode, DataNode és a Központi Irányítás

A HDFS architektúra egy mesteri példája az elosztott rendszerek tervezésének, amely két fő komponens köré épül: a NameNode és a DataNode. Ezek a komponensek együttműködve biztosítják a fájlrendszer működését, az adatok tárolását és a metaadatok kezelését.

NameNode: Az Agy

A NameNode a HDFS klaszter központi koordinátora és agya. Egyetlen NameNode felelős a fájlrendszer névterének (filesystem namespace) kezeléséért, amely magában foglalja a könyvtárakat, fájlokat és azok attribútumait (engedélyek, létrehozási idő, stb.). A NameNode tárolja a fájlrendszer metaadatait, például a fájlok és könyvtárak hierarchiáját, valamint azt, hogy melyik fájl mely adatblokkokból áll, és ezek a blokkok mely DataNode-okon találhatók.

A NameNode két kulcsfontosságú fájlt tárol a perzisztens tárolóján:

- FsImage: Ez a fájl a teljes fájlrendszer névterének pillanatfelvétele, beleértve a fájlok és könyvtárak állapotát, a blokkok leképezését a fájlokra, és a blokkok helyét a DataNode-okon.

- EditLog: Ez a naplófájl rögzíti a fájlrendszeren végrehajtott összes módosítást (pl. fájl létrehozása, törlése, átnevezése, blokk hozzáadása).

Minden kliens kérés, legyen az írás vagy olvasás, először a NameNode-hoz fordul a metaadatokért. A NameNode felelős a blokkok replikációjának kezeléséért is, figyeli a DataNode-ok állapotát a rendszeres szívverés (heartbeat) üzenetek alapján, és ha egy DataNode meghibásodik, elindítja a szükséges replikációt az elveszett blokkok pótlására. A NameNode memóriában tárolja a teljes fájlrendszer metaadatát a gyors hozzáférés érdekében, ami limitálja a klaszter méretét (bár ez a korlát ma már hatalmas).

DataNode: Az Adatőrzők

A DataNode-ok a HDFS klaszter munkásgépei, amelyek a tényleges adatokat tárolják. Minden DataNode egy vagy több fizikai merevlemezen tárolja az adatblokkokat. A DataNode-ok rendszeresen küldenek szívverés üzeneteket a NameNode-nak, hogy jelezzék, működőképesek és elérhetőek. Emellett blokkjelentéseket (block reports) is küldenek, amelyek felsorolják az általuk tárolt összes adatblokkot. Ez a jelentés segít a NameNode-nak naprakészen tartani a blokkok helyzetére vonatkozó információkat.

Amikor egy kliens ír vagy olvas egy fájlt, a NameNode-tól kapott információk alapján közvetlenül a DataNode-okkal kommunikál az adatok átviteléhez. A DataNode-ok felelősek a blokkok tárolásáért, lekéréséért és replikációjáért a NameNode utasításai szerint. Nincs központi koordináció a DataNode-ok között; minden kommunikáció a NameNode-on keresztül történik, vagy közvetlenül a kliens és a DataNode között, a NameNode által biztosított irányítás alapján.

Secondary NameNode: A Segítő

A Secondary NameNode szerepe gyakran félreértett. Nem egy „backup” NameNode, és nem veszi át a NameNode szerepét annak meghibásodása esetén. Fő feladata az FsImage és EditLog fájlok „összevonása” vagy „ellenőrzőpontozása” (checkpointing). A NameNode EditLog-ja folyamatosan növekszik a fájlrendszeren végrehajtott műveletekkel. Ha az EditLog túl nagyra nő, a NameNode újraindításakor sokáig tarthat az összes tranzakció visszajátszása az FsImage frissítéséhez.

A Secondary NameNode rendszeres időközönként vagy egy bizonyos EditLog méret elérésekor lekéri az FsImage-et és az EditLog-ot a NameNode-tól, egyesíti őket egy új FsImage-gé, majd visszaküldi azt a NameNode-nak. Ez a folyamat csökkenti az EditLog méretét, és felgyorsítja a NameNode újraindulását, mivel kevesebb tranzakciót kell visszajátszani. Bár nem biztosít valós idejű NameNode HA-t, kritikus szerepet játszik a NameNode karbantartásában és a helyreállítási idő csökkentésében.

Kulcsfontosságú Koncepciók a HDFS-ben: Blokkok, Replikáció és Rack Awareness

A HDFS hatékonyságát és megbízhatóságát számos alapvető koncepció biztosítja, amelyek együttesen teszik lehetővé a big data tárolását és kezelését. Ezek közé tartozik az adatblokkokra bontás, a replikáció és a rack awareness.

Adatblokkok: Az Építőelemek

A HDFS-ben minden fájl rögzített méretű blokkokra oszlik. A hagyományos fájlrendszerekben a blokkméret általában 4 KB vagy 8 KB. A HDFS esetében azonban sokkal nagyobb blokkméretet használnak, jellemzően 128 MB vagy 256 MB. Ennek oka, hogy a big data alkalmazások általában nagy fájlokat dolgoznak fel szekvenciálisan. A nagy blokkméret minimalizálja a metaadat-kezelés terhét a NameNode-on, és csökkenti a lemezkeresési időt, ami javítja az átviteli sebességet.

Ha egy fájl kisebb, mint egy blokkméret, akkor is elfoglal egy teljes blokkot. Ha nagyobb, akkor több blokkra oszlik. Például egy 500 MB-os fájl, 128 MB-os blokkméret esetén, négy 128 MB-os blokkra és egy 100 MB-os blokkra (ami szintén 128 MB-ot foglal) oszlik. Ez a blokkalapú megközelítés teszi lehetővé az adatok elosztását a klaszter DataNode-jai között, és a párhuzamos feldolgozást.

Adatreplikáció: A Megbízhatóság Záloga

A HDFS egyik legfontosabb jellemzője az adatreplikáció. Annak érdekében, hogy a rendszer hibatűrő legyen, minden adatblokkról több másolat készül, és ezeket a másolatokat különböző DataNode-okon tárolják. Az alapértelmezett replikációs faktor 3, ami azt jelenti, hogy minden blokknak három másolata van a klaszterben. Ez a szám konfigurálható az alkalmazás igényeinek megfelelően.

A replikáció biztosítja, hogy ha egy DataNode meghibásodik vagy elérhetetlenné válik, az adatok továbbra is hozzáférhetők maradnak a blokk többi másolatán keresztül. A NameNode folyamatosan figyeli a DataNode-okat, és ha egy DataNode kiesik, azonnal elindítja az érintett blokkok replikációját, hogy a kívánt replikációs faktort fenntartsa. Ez a mechanizmus garantálja az adatvesztés elleni védelmet és a magas rendelkezésre állást.

Rack Awareness: Az Optimalizált Elhelyezés

A Rack Awareness (rack-tudatosság) egy optimalizációs stratégia a HDFS-ben, amely a replikált blokkok elhelyezését befolyásolja a klaszter fizikai elrendezése alapján. Egy tipikus Hadoop klaszter több szerverrack-ből áll, és minden rack több DataNode-ot tartalmaz. A hálózati sávszélesség korlátozott a rack-ek között, de sokkal nagyobb egy rack-en belül.

A Rack Awareness policy alapértelmezés szerint a következőképpen helyezi el a replikált blokkokat (feltételezve a 3-as replikációs faktort):

- Az első másolatot a kliens DataNode-jára helyezi el (ha a kliens egy DataNode).

- A második másolatot egy másik DataNode-ra helyezi el ugyanabban a rack-ben.

- A harmadik másolatot egy másik rack-ben lévő DataNode-ra helyezi el.

Ez az elrendezés optimalizálja a hálózati forgalmat és növeli a hibatűrést. Ha egy teljes rack meghibásodik (pl. áramszünet miatt), az adatok továbbra is elérhetők maradnak a másik rack-ben lévő másolatról. Emellett az olvasási műveletek során a HDFS megpróbálja a klienshez legközelebbi blokkmásolatot kiválasztani, preferálva ugyanazon a rack-en belüli DataNode-okat, ami csökkenti a hálózati késleltetést és növeli az olvasási sebességet.

Adatfolyam a HDFS-ben: Olvasási és Írási Műveletek

Az HDFS-ben az adatok olvasása és írása egy jól meghatározott folyamatot követ, amely a kliens, a NameNode és a DataNode-ok közötti koordinált interakcióra épül. Ez a folyamat biztosítja az adatok konzisztenciáját, megbízhatóságát és a skálázhatóságot.

Fájl Írása a HDFS-be

Egy fájl HDFS-be írásának folyamata a következő lépésekből áll:

- Kliens kérés: A kliens (pl. egy MapReduce feladat) kéri a NameNode-tól egy új fájl létrehozását a HDFS-ben.

- NameNode válasz: A NameNode ellenőrzi, hogy a kliensnek van-e engedélye a fájl létrehozására, és hogy a fájlnév még nem létezik. Ha minden rendben van, a NameNode létrehoz egy új bejegyzést a fájlrendszer névterében, és válaszol a kliensnek, hogy megkezdheti az írást.

- Blokk hozzárendelés: A kliens a fájlt blokkokra bontja. Az első blokk írásához a kliens ismét felveszi a kapcsolatot a NameNode-dal, és kéri, hogy rendeljen hozzá DataNode-okat a blokk tárolásához. A NameNode a rack awareness szabályok figyelembevételével kiválasztja a megfelelő DataNode-okat (általában a replikációs faktor alapján, pl. 3 DataNode-ot egy 3-as replikációs faktornál).

- Adatátvitel (pipeline): A NameNode válasza után a kliens közvetlenül az első kijelölt DataNode-hoz csatlakozik. A kliens elkezdi küldeni az adatblokkot az első DataNode-nak, amely továbbítja azt a második DataNode-nak, az pedig a harmadiknak. Ez egy „pipeline” mechanizmus, amely hatékonyan továbbítja az adatokat az összes replikációs célhelyre.

- Visszaigazolás: Amint az adatblokk írása befejeződött az összes kijelölt DataNode-on, minden DataNode visszaigazolást küld az előző DataNode-nak a pipeline-ban, egészen vissza a kliensig. A kliens ekkor tudja, hogy a blokk sikeresen elmentésre került.

- További blokkok: Ez a folyamat ismétlődik minden további blokk esetében, amíg az egész fájl fel nem töltődik a HDFS-be.

- Fájl lezárása: Miután minden blokk írása befejeződött, a kliens értesíti a NameNode-ot, hogy a fájl írása befejeződött. A NameNode véglegesíti a fájlbejegyzést a névterében és az EditLog-ban.

Fájl Olvasása a HDFS-ből

Egy fájl HDFS-ből történő olvasásának folyamata a következő:

- Kliens kérés: A kliens kéri a NameNode-tól egy fájl tartalmát.

- NameNode válasz: A NameNode ellenőrzi a kliens engedélyeit, majd visszaadja a fájlhoz tartozó összes blokk listáját, valamint az egyes blokkokat tároló DataNode-ok listáját (a replikáció miatt több DataNode is lehet egy blokkhoz).

- Blokk kiválasztás és olvasás: A kliens megpróbálja a hozzá legközelebb eső DataNode-ról olvasni a blokkokat, figyelembe véve a rack awareness-t és a hálózati topológiát. Ha egy DataNode elérhetetlenné válik, a kliens automatikusan megpróbálja a blokk egy másik másolatát egy másik DataNode-ról olvasni.

- Adatátvitel: A kliens közvetlenül a kiválasztott DataNode-hoz csatlakozik, és elkezdi olvasni az adatblokkot.

- Több blokk párhuzamosan: A kliens párhuzamosan olvashat több blokkot is különböző DataNode-okról, ami jelentősen növeli az olvasási teljesítményt, különösen nagy fájlok esetén.

Ez a közvetlen DataNode-kliens kommunikáció minimalizálja a NameNode terhelését, és lehetővé teszi a HDFS számára, hogy rendkívül magas átviteli sebességet biztosítson a nagy adathalmazok olvasásakor.

Hibatűrés és Magas Rendelkezésre Állás (HA) a HDFS-ben

A HDFS egyik legfontosabb tervezési elve a hibatűrés. Mivel a rendszer olcsó, árucikk szintű hardvereken fut, a komponensek meghibásodása nem kivétel, hanem várható esemény. A HDFS úgy lett kialakítva, hogy automatikusan kezelje ezeket a hibákat, biztosítva az adatok integritását és a folyamatos rendelkezésre állást.

Adatvesztés Elleni Védelem

Az alapvető hibatűrési mechanizmus az adatreplikáció. Ahogy korábban említettük, minden adatblokkról több másolat készül (alapértelmezésben 3), és ezeket különböző DataNode-okon tárolják. Ha egy DataNode meghibásodik vagy elérhetetlenné válik:

- A NameNode észleli a DataNode kiesését a szívverés üzenetek hiánya alapján.

- A NameNode azonosítja azokat a blokkokat, amelyeknek a meghibásodott DataNode volt az egyetlen vagy utolsó elérhető másolata, és amelyek replikációs faktora így a kívánt szint alá csökkent.

- A NameNode elindítja az érintett blokkok másolását más, egészséges DataNode-okra, hogy visszaállítsa a kívánt replikációs szintet. Ez a folyamat automatikus és transzparens a felhasználó számára.

Ez a mechanizmus biztosítja, hogy még egy vagy több DataNode meghibásodása esetén is az adatok továbbra is elérhetők maradjanak, és ne történjen adatvesztés.

NameNode Magas Rendelkezésre Állása (HA)

Korábban a NameNode volt a HDFS egypontos meghibásodási pontja (Single Point of Failure – SPoF). Ha a NameNode meghibásodott, a teljes HDFS klaszter elérhetetlenné vált, amíg a NameNode újra nem indult, vagy egy mentésből vissza nem állították. A modern Hadoop verziók bevezették a NameNode High Availability (HA) funkciót, hogy kiküszöböljék ezt a problémát.

A NameNode HA konfigurációban két NameNode fut:

- Aktív NameNode: Ez a NameNode kezeli az összes kliens kérést és a DataNode szívveréseket/blokkjelentéseket.

- Standby NameNode: Ez a NameNode folyamatosan szinkronban van az Aktív NameNode-dal, passzívan fogadja az EditLog frissítéseket, és rendelkezik a fájlrendszer névterének legfrissebb másolatával. Nem fogad kliens kéréseket.

A két NameNode közötti szinkronizációt egy megosztott tároló (pl. Quorum Journal Manager – QJM) biztosítja, ahová mind az Aktív, mind a Standby NameNode írja az EditLog bejegyzéseket. Egy Zookeeper alapú failover controller figyeli mindkét NameNode állapotát. Ha az Aktív NameNode meghibásodik, a failover controller automatikusan átkapcsolja a Standby NameNode-ot Aktív állapotba, minimalizálva az állásidőt. Ez a megoldás drámaian növeli a HDFS klaszter megbízhatóságát és rendelkezésre állását, biztosítva a folyamatos működést még a NameNode meghibásodása esetén is.

A HDFS hibatűrési mechanizmusai, mint az adatreplikáció és a NameNode HA, kulcsfontosságúak a big data környezetekben, ahol a rendszer folyamatos működése és az adatok integritása létfontosságú.

A HDFS Skálázhatósága: Horizontális Növekedés a Big Data Érdekében

A HDFS egyik legkiemelkedőbb tulajdonsága a skálázhatóság, különösen a horizontális skálázás képessége. Ez azt jelenti, hogy a rendszer kapacitása egyszerűen növelhető további szerverek (DataNode-ok) hozzáadásával a klaszterhez, anélkül, hogy a meglévő infrastruktúrát jelentősen módosítani kellene. Ez a rugalmasság alapvető a big data környezetekben, ahol az adatok mennyisége és a feldolgozási igények folyamatosan növekednek.

A tradicionális skálázási módszerek, mint a vertikális skálázás (azaz egyetlen szerver erőforrásainak növelése – több CPU, RAM, nagyobb lemez), korlátozottak és drágák. Egy bizonyos ponton túl egyszerűen nem lehet nagyobb vagy erősebb gépet vásárolni. Ezenkívül egyetlen nagyméretű szerver továbbra is egyetlen meghibásodási pontot jelent. A HDFS ezzel szemben a horizontális skálázásra épül, amelynek előnyei a következők:

- Költséghatékonyság: Olcsó, árucikk szintű hardverek használatával a klaszter bővítése sokkal gazdaságosabb, mint a drága, speciális szerverek beszerzése.

- Nincs felső korlát: Elméletileg nincs felső korlátja annak, hogy hány DataNode adható hozzá egy HDFS klaszterhez, bár a NameNode memóriája és a hálózati sávszélesség gyakorlati korlátokat szabhat. A valóságban a legnagyobb klaszterek több ezer DataNode-ot is tartalmazhatnak, petabájtos adatok tárolásával.

- Növelt átviteli sebesség: Minél több DataNode van a klaszterben, annál több párhuzamos adatfolyamot lehet kezelni, mind írási, mind olvasási műveletek során. Ez jelentősen növeli a rendszer teljes átviteli sebességét, ami kritikus a big data analitikai feladatokhoz.

- Fokozott hibatűrés: A több DataNode azt is jelenti, hogy a replikált adatok szélesebb körben oszlanak el, tovább növelve a rendszer ellenálló képességét a hardverhibákkal szemben. Ha egy DataNode meghibásodik, a klaszter többi része továbbra is működőképes marad, és a NameNode automatikusan pótolja az elveszett replikákat.

A skálázás folyamata viszonylag egyszerű. Amikor új DataNode-okat adnak hozzá a klaszterhez, azok regisztrálnak a NameNode-nál, és elkezdik fogadni az adatblokkokat. A NameNode automatikusan elkezdi elosztani az új blokkokat az új DataNode-okra, és szükség esetén kiegyensúlyozza a meglévő blokkok eloszlását is a klaszterben. Ez a dinamikus bővíthetőség teszi a HDFS-t ideális tárolómegoldássá a folyamatosan növekvő adatmennyiségű környezetek számára.

A HDFS skálázhatósága nem csak a tárolási kapacitásra vonatkozik, hanem a feldolgozási teljesítményre is, mivel a MapReduce, Spark és más feldolgozó motorok kihasználhatják az adatok elosztott jellegét, és párhuzamosan dolgozhatnak rajtuk. Ez a „data locality” (adatlokalitás) elv, ahol a feldolgozás az adatok közelében történik, minimalizálja a hálózati forgalmat és maximalizálja a teljesítményt a big data analitika során.

Adatintegritás és Biztonság a HDFS-ben

A HDFS nemcsak a skálázhatóságra és a hibatűrésre összpontosít, hanem az adatintegritás és a biztonság is kiemelt fontosságú szempont. Bár a HDFS elsődlegesen belső hálózatokon, megbízható környezetben való használatra készült, számos mechanizmust tartalmaz az adatok védelmére és a jogosulatlan hozzáférés megakadályozására.

Adatintegritás

Az adatintegritás biztosítása érdekében a HDFS a következő mechanizmusokat alkalmazza:

- Checksum (ellenőrzőösszeg): Minden adatblokkhoz egy ellenőrzőösszeg (általában CRC32) tartozik, amelyet az írási művelet során generál és tárol a DataNode. Amikor a kliens olvassa az adatblokkot, újra kiszámítja az ellenőrzőösszeget, és összehasonlítja azt a tárolt értékkel. Ha a két érték nem egyezik, az adatblokk sérültnek minősül, és a kliens megpróbálja a blokk egy másik replikáját olvasni egy másik DataNode-ról. Ez a folyamat biztosítja, hogy a korrupt adatok ne kerüljenek feldolgozásra.

- Blokk replikáció: Bár elsősorban a hibatűrést szolgálja, a replikáció közvetetten hozzájárul az adatintegritáshoz is. Ha egy blokk sérül egy DataNode-on, a HDFS képes azt a blokk egy egészséges másolatáról pótolni, visszaállítva az eredeti állapotot és a kívánt replikációs faktort.

- FsImage és EditLog: A NameNode által kezelt metaadatok (FsImage és EditLog) kritikusak a fájlrendszer integritásához. Ezeket a fájlokat is replikálják, és a Secondary NameNode rendszeresen ellenőrzőpontozza őket, hogy biztosítsa a konzisztenciát és a gyors helyreállítást.

Biztonság

A HDFS biztonsági modellje a Hadoop ökoszisztémán belül valósul meg, és több rétegből áll:

- Hitelesítés (Authentication): A Hadoop klaszterek leggyakrabban Kerberos-t használnak a felhasználók és szolgáltatások hitelesítésére. Ez biztosítja, hogy csak az arra jogosult entitások férhessenek hozzá a HDFS-hez és más Hadoop szolgáltatásokhoz. A Kerberos egy erős, hálózati hitelesítési protokoll, amely megakadályozza a jogosulatlan hozzáférést.

- Engedélyezés (Authorization): A HDFS támogatja a POSIX-szerű fájlrendszer engedélyeket (rwx – olvasás, írás, végrehajtás) a felhasználókra, csoportokra és másokra vonatkozóan. Ez lehetővé teszi a rendszergazdák számára, hogy részletes hozzáférés-vezérlést állítsanak be a fájlokhoz és könyvtárakhoz. Ezen felül az ACL-ek (Access Control Lists) is támogatottak a finomabb szemcsézettségű engedélyekhez.

- Adat titkosítás: Bár a HDFS alapértelmezésben nem titkosítja az adatokat nyugalmi állapotban, a Hadoop közösség fejlesztett ki megoldásokat az „encryption at rest” (nyugalmi állapotban lévő adatok titkosítása) megvalósítására. Ez történhet a HDFS szintjén (Encryption Zones), vagy az operációs rendszer/fájlrendszer szintjén (pl. LUKS). Az átvitel közbeni titkosítást (encryption in transit) a TLS/SSL használatával lehet biztosítani a kliensek és a DataNode-ok, valamint a DataNode-ok és a NameNode közötti kommunikációban.

- Auditálás: A HDFS képes naplózni a fájlrendszeren végrehajtott műveleteket, például a fájlok olvasását, írását vagy törlését. Ezek az audit naplók kritikusak a biztonsági incidensek nyomon követéséhez és a megfelelőségi követelmények teljesítéséhez.

A HDFS biztonságának beállítása és kezelése összetett feladat lehet, és gondos tervezést igényel. Egy jól konfigurált biztonsági réteg azonban elengedhetetlen a bizalmas big data adatok védelméhez egy elosztott környezetben.

HDFS Parancsok és Segédprogramok: A Rendszer Kezelése

A HDFS-sel való interakcióhoz és a fájlrendszer kezeléséhez a Hadoop számos parancssori segédprogramot biztosít. Ezek a parancsok lehetővé teszik a felhasználók számára, hogy fájlokat és könyvtárakat hozzanak létre, töröljenek, mozgassanak, másoljanak, listázzanak, valamint ellenőrizzék a fájlrendszer állapotát. Az alábbiakban bemutatjuk a leggyakrabban használt HDFS parancsokat.

Minden HDFS parancs a `hadoop fs` vagy `hdfs dfs` előtaggal kezdődik. A `hdfs dfs` az újabb és preferált módja a parancsok futtatásának.

Alapvető Fájlrendszer Műveletek

- `hdfs dfs -ls [útvonal]`: Listázza egy könyvtár tartalmát. Hasonló a Linux `ls` parancsához.

Példa: `hdfs dfs -ls /user/hadoop/data`

- `hdfs dfs -mkdir [-p] <útvonal>`: Létrehoz egy könyvtárat a HDFS-ben. A `-p` opcióval a szülőkönyvtárakat is létrehozza, ha nem léteznek.

Példa: `hdfs dfs -mkdir /user/myuser/new_dir`

- `hdfs dfs -put

[hdfs_útvonal]`: Másol egy fájlt a helyi fájlrendszerből a HDFS-be. Használható `copyFromLocal` néven is. Példa: `hdfs dfs -put local_file.txt /user/myuser/hdfs_file.txt`

- `hdfs dfs -get

[helyi_fájl]`: Másol egy fájlt a HDFS-ből a helyi fájlrendszerbe. Használható `copyToLocal` néven is. Példa: `hdfs dfs -get /user/myuser/hdfs_file.txt downloaded_file.txt`

- `hdfs dfs -cat

`: Kiírja egy fájl tartalmát a konzolra. Példa: `hdfs dfs -cat /user/myuser/data.csv`

- `hdfs dfs -rm [-r] [-skipTrash]

`: Töröl egy fájlt vagy könyvtárat. A `-r` opcióval rekurzívan töröl könyvtárakat. A `-skipTrash` opcióval a szemetesbe kerülés nélkül töröl. Példa: `hdfs dfs -rm /user/myuser/old_file.txt`

- `hdfs dfs -mv

`: Áthelyez (átnevez) egy fájlt vagy könyvtárat. Példa: `hdfs dfs -mv /user/myuser/temp_file.txt /user/myuser/final_file.txt`

- `hdfs dfs -cp

`: Másol egy fájlt vagy könyvtárat a HDFS-en belül. Példa: `hdfs dfs -cp /user/myuser/source_data /user/myuser/backup_data`

- `hdfs dfs -chown [-R]

: <útvonal>`: Megváltoztatja a fájlok/könyvtárak tulajdonosát és csoportját. A `-R` rekurzív mód. Példa: `hdfs dfs -chown -R newuser:newgroup /user/myuser/data`

- `hdfs dfs -chmod [-R]

<útvonal>`: Megváltoztatja a fájlok/könyvtárak jogosultságait (pl. `755`). A `-R` rekurzív mód. Példa: `hdfs dfs -chmod 777 /user/myuser/public_data`

HDFS-specifikus Parancsok

- `hdfs dfsadmin -report`: Jelentést készít a HDFS klaszter állapotáról, beleértve a DataNode-ok számát, a felhasznált és szabad területet, valamint a blokkok replikációs állapotát. Ez egy fontos parancs a klaszter monitorozásához.

- `hdfs dfs -setrep [-R]

<útvonal>`: Beállítja egy fájl vagy könyvtár (és annak tartalmának) replikációs faktorát. Példa: `hdfs dfs -setrep 2 /user/myuser/less_important_data`

- `hdfs fsck [-files [-blocks [-locations [-racks]]]]

`: Fájlrendszer konzisztencia ellenőrző eszköz. Segít azonosítani a sérült fájlokat és blokkokat. - `hdfs balancer`: Elosztja az adatblokkokat a DataNode-ok között, hogy azok egyenletesebben legyenek kihasználva a klaszterben. Ez akkor hasznos, ha új DataNode-okat adtak hozzá, vagy ha az adateloszlás kiegyensúlyozatlan lett.

Ezek a parancsok alapvető eszközöket biztosítanak a HDFS hatékony kezeléséhez és monitorozásához, lehetővé téve a rendszergazdák és a fejlesztők számára, hogy teljes mértékben kihasználják a Hadoop elosztott fájlrendszerének képességeit.

A HDFS Ökoszisztéma és Integráció: Együttműködés Más Hadoop Komponensekkel

A HDFS önmagában csak egy tárolórendszer. Valódi ereje abban rejlik, hogy szorosan integrálódik a Hadoop ökoszisztéma más komponenseivel, lehetővé téve a hatalmas adathalmazok hatékony feldolgozását és elemzését. Ezek a komponensek együttesen alkotnak egy robusztus platformot a big data kezelésére.

HDFS és YARN (Yet Another Resource Negotiator)

A YARN a Hadoop 2.x verziójától kezdve a klaszter erőforrás-kezelője és ütemezője. Felelős a klaszter erőforrásainak (CPU, memória) kiosztásáért a különböző alkalmazások számára. A YARN és a HDFS szorosan együttműködik:

- A YARN kezeli az alkalmazások (pl. MapReduce, Spark) futtatását a klaszterben, beleértve az erőforrások igénylését és felszabadítását.

- A HDFS biztosítja az adatokat ezeknek az alkalmazásoknak. A YARN kihasználja a HDFS adatlokalitási képességét, megpróbálva az alkalmazás konténereit (ahol a számítás fut) azon a DataNode-on futtatni, ahol az adatok is találhatók. Ez minimalizálja a hálózati forgalmat és jelentősen növeli a feldolgozás hatékonyságát.

Ez a szétválasztás (tárolás a HDFS-ben, erőforrás-kezelés a YARN-ban) tette a Hadoop-ot sokkal rugalmasabbá, lehetővé téve több feldolgozási keretrendszer futtatását ugyanazon a klaszteren a MapReduce mellett.

HDFS és MapReduce

A MapReduce volt az eredeti feldolgozási motor a Hadoopban, és szorosan kötődik a HDFS-hez. A MapReduce feladatok a HDFS-ben tárolt adatokon futnak, és az eredményeket is a HDFS-be írják vissza. A MapReduce kihasználja a HDFS blokk-alapú tárolását:

- A Map feladatok az adatblokkokon párhuzamosan futnak, gyakran azon a DataNode-on, ahol a blokk található.

- A HDFS nagy átviteli sebessége biztosítja a MapReduce számára a szükséges adat hozzáférést.

Bár a MapReduce továbbra is fontos, más, újabb feldolgozási motorok is megjelentek, amelyek szintén a HDFS-re építenek.

HDFS és Spark

Az Apache Spark egy gyors és általános célú klaszter-számítási motor, amely jelentős teljesítménybeli előnyöket kínál a MapReduce-hoz képest, különösen iteratív algoritmusok és interaktív elemzések esetén. A Spark is a HDFS-t használja alapvető tárolóként:

- A Spark képes közvetlenül olvasni és írni adatokat a HDFS-ből.

- A Spark RDD-k (Resilient Distributed Datasets) és DataFrame-ek HDFS-ben tárolt adatokon alapulhatnak.

- A Spark memóriában történő számítási képességei kiegészítik a HDFS lemez alapú tárolását, lehetővé téve a gyorsabb adatelérést és feldolgozást.

A Spark és HDFS kombinációja rendkívül népszerű a modern big data analitikai platformokon.

HDFS és Hive/Impala/HBase

- Apache Hive: Egy adatraktár infrastruktúra, amely SQL-szerű lekérdezéseket (HiveQL) tesz lehetővé a HDFS-ben tárolt adatokon. A Hive lefordítja a lekérdezéseket MapReduce, Spark vagy Tez feladatokká, amelyek aztán a HDFS-ből olvassák és írják az adatokat.

- Apache Impala: Egy valós idejű (real-time) lekérdező motor a HDFS-ben tárolt adatokhoz. Az Impala kihagyja a MapReduce-t, és közvetlenül olvassa az adatokat a HDFS-ből, sokkal gyorsabb válaszidőt biztosítva interaktív elemzésekhez.

- Apache HBase: Egy NoSQL, elosztott adatbázis, amely a HDFS tetején fut. A HBase a HDFS-t használja a tényleges adatok tárolására, de saját, alacsony késleltetésű hozzáférési mechanizmusokat biztosít. Ideális olyan alkalmazásokhoz, amelyek gyors olvasási/írási műveleteket igényelnek nagy mennyiségű strukturált adaton.

Ez az integráció teszi a HDFS-t a big data ökoszisztéma alapvető építőkövévé, lehetővé téve a különböző típusú adatkezelési és analitikai feladatok végrehajtását egyetlen, egységes platformon.

Haladó HDFS Funkciók: Tovább a Standard Tároláson

A HDFS az alapvető tárolási és hibatűrési képességeken túl számos haladó funkciót is kínál, amelyek tovább növelik a rugalmasságát, hatékonyságát és kezelhetőségét a komplex big data környezetekben. Ezek a funkciók a rendszergazdák és fejlesztők számára is hasznosak a specifikus igények kielégítésében.

Pillanatképek (Snapshots)

A HDFS pillanatképek lehetővé teszik egy fájlrendszer vagy egy alkönyvtár állapotának „fényképezését” egy adott időpontban. Ez egy rendkívül hatékony mechanizmus az adatok biztonsági mentésére és helyreállítására. A pillanatképek nem másolják fizikailag az adatokat; ehelyett csak a metaadatokat (fájlnévtér és blokkleképezések) rögzítik az adott időpontban. Az adatblokkokat csak akkor másolják, ha az eredeti fájl megváltozik a pillanatkép készítése után (copy-on-write elv). Ez rendkívül helytakarékos megoldás.

A pillanatképek használatának előnyei:

- Gyors visszaállítás: Lehetővé teszi az adatok gyors visszaállítását egy korábbi állapotba adatvesztés vagy véletlen törlés esetén.

- Adatvédelem: Védelmet nyújt a felhasználói hibák, a rosszindulatú támadások vagy a szoftverhibák ellen.

- Adatkonzisztencia: Készíthetők konzisztens pillanatképek a nagy adathalmazokról az analitikai feladatokhoz.

Kvoták (Quotas)

A HDFS kvóták lehetővé teszik a rendszergazdák számára, hogy korlátozzák a felhasználók vagy csoportok által elfoglalt tárhely mennyiségét és a létrehozható fájlok/könyvtárak számát egy adott könyvtárban. Kétféle kvóta létezik:

- Névtér kvóta (Namespace Quota): Korlátozza a fájlok és könyvtárak maximális számát, amelyek létrehozhatók egy adott könyvtárban.

- Tárhely kvóta (Diskspace Quota): Korlátozza a maximális tárhely mennyiségét (bájtokban), amelyet egy könyvtár elfoglalhat.

A kvóták segítenek a tárhely hatékonyabb kezelésében, megakadályozzák, hogy egyetlen felhasználó vagy alkalmazás túl sok erőforrást foglaljon le, és biztosítják a fair-share elosztást egy megosztott klaszterkörnyezetben.

Törlési Kódolás (Erasure Coding): A Helyhatékony Alternatíva

Bár a replikáció hatékony a hibatűrés biztosításában, jelentős tárhely-felhasználással jár (pl. 3-as replikáció esetén az adatok háromszorosát tárolja). A törlési kódolás (Erasure Coding – EC) egy fejlettebb hibatűrési technika, amelyet a HDFS bevezetett a tárhely-hatékonyság növelésére.

Az EC algoritmusok (pl. Reed-Solomon) redundáns paritásblokkokat generálnak az eredeti adatblokkokból. Például egy (6,3) EC séma azt jelenti, hogy 6 adatblokkból 3 paritásblokkot generál. Ez a 9 blokk tárolódik a HDFS-ben. Ha bármelyik 3 blokk elveszik (akár adat, akár paritásblokk), az eredeti 6 adatblokk rekonstruálható a megmaradt 6 blokkból. Ez jelentős tárhely-megtakarítást eredményez a 3-as replikációhoz képest, miközben hasonló szintű hibatűrést biztosít.

Az EC ideális olyan adatokhoz, amelyeket ritkábban érnek el (cold data), vagy amelyek nem igényelnek azonnali helyreállítást, mivel a rekonstrukció számításigényesebb, mint a replikált blokk olvasása. Ez a funkció kulcsfontosságú a költségek csökkentésében a nagyon nagy méretű Hadoop klaszterekben.

HDFS Caching

A HDFS Caching lehetővé teszi a rendszergazdák számára, hogy explicit módon gyorsítótárba helyezzenek gyakran hozzáférhető fájlokat és könyvtárakat a DataNode-ok memóriájában. Ez jelentősen felgyorsítja az olvasási műveleteket azokhoz az adatokhoz, amelyek a gyorsítótárban vannak, mivel elkerüli a lemez I/O-t.

A HDFS Caching hasznos olyan forgatókönyvekben, ahol bizonyos adathalmazokat gyakran olvasnak, például:

- Kis méretű, gyakran használt lookup táblák.

- Metaadatok, amelyekre gyakran szükség van.

- Referencia adatok, amelyeket több alkalmazás is használ.

Ezek a haladó funkciók tovább bővítik a HDFS képességeit, lehetővé téve a felhasználók számára, hogy még hatékonyabban kezeljék és optimalizálják a big data tárolását és feldolgozását.

HDFS Összehasonlítása Más Tárolórendszerekkel

A HDFS egy specifikus feladatkörre, a big data tárolására és feldolgozására optimalizált elosztott fájlrendszer. Ahhoz, hogy teljes mértékben megértsük a szerepét, érdemes összehasonlítani más, hagyományos vagy modern tárolórendszerekkel. Ez segít rávilágítani a HDFS erősségeire és gyengeségeire.

HDFS vs. Hagyományos Fájlrendszerek (NFS, SAN, NAS)

| Jellemző | HDFS | NFS (Network File System) | SAN (Storage Area Network) / NAS (Network Attached Storage) |

|---|---|---|---|

| Architektúra | Elosztott, master-slave (NameNode-DataNode) | Kliens-szerver, központosított tároló | Központosított, dedikált tároló hálózat (SAN) vagy fájlszerver (NAS) |

| Skálázhatóság | Horizontális, olcsó árucikk szerverekkel, petabájtig skálázható | Vertikális, korlátozott horizontális skálázás | Vertikális, drága bővítés, korlátozott |

| Hibatűrés | Beépített replikáció (alapértelmezett 3x), automatikus helyreállítás | Alapértelmezetten nincs, RAID-re támaszkodik a szerveren | RAID-re és redundáns komponensekre támaszkodik, drága |

| Adathozzáférés | Nagy, szekvenciális olvasás/írás, adatlokalitás a feldolgozáshoz | Kis fájlokhoz, véletlen hozzáféréshez optimalizált | Véletlen hozzáféréshez, tranzakciós rendszerekhez optimalizált |

| Költség | Alacsony (árucikk hardverek) | Közepes (dedikált szerver, tároló) | Magas (speciális hardver, szoftver) |

| Adatkonzisztencia | „Write once, read many times”, append-only, eventual consistency | Erős konzisztencia, írási/olvasási zárak | Erős konzisztencia, tranzakciók támogatása |

| Használati esetek | Big data analitika, naplógyűjtés, adatraktárak, offline feldolgozás | Általános fájlmegosztás, otthoni mappák, kis adatbázisok | Adatbázisok, virtualizáció, nagyvállalati fájlmegosztás |

A HDFS alapvetően különbözik a hagyományos fájlrendszerektől abban, hogy a big data specifikus igényeire lett optimalizálva. Nem alkalmas alacsony késleltetésű, véletlenszerű olvasási/írási műveletekre, vagy sok kis fájl kezelésére. Ehelyett a nagy átviteli sebességre és a megbízható, skálázható tárolásra fókuszál hatalmas adathalmazok esetén.

HDFS vs. Objektum Tárolás (pl. AWS S3, Azure Blob Storage)

Az objektum tárolók, mint az Amazon S3 vagy az Azure Blob Storage, szintén elosztott tárolási megoldások, amelyek hatalmas skálázhatóságot és hibatűrést kínálnak. Vannak azonban kulcsfontosságú különbségek:

- API: A HDFS egy fájlrendszer API-t biztosít, amely hasonlít a POSIX-hoz, míg az objektum tárolók RESTful API-n keresztül érhetők el.

- Konzisztencia modell: A HDFS alapvetően „write once, read many times” és erős (vagy közel erős) konzisztenciát biztosít az írások után. Az objektum tárolók gyakran „eventual consistency” (végső konzisztencia) modellt alkalmaznak, ami azt jelenti, hogy egy írás után eltarthat egy ideig, amíg az összes másolat konzisztenssé válik.

- Adatlokalitás: A HDFS tervezése alapvetően az adatlokalitásra épül, ahol a feldolgozás az adatok közelében történik. Az objektum tárolók esetében az adatok a felhőben vannak, és a feldolgozáshoz általában át kell mozgatni őket a számítási erőforrásokhoz, ami hálózati késleltetést és költségeket jelenthet.

- Költségmodell: A HDFS helyi klaszteren fut, a hardver költsége a felhasználót terheli. A felhő alapú objektum tárolók szolgáltatásként érhetők el, pay-as-you-go modellel, ami rugalmasságot kínál, de a hosszú távú, nagy mennyiségű adatok tárolása költséges lehet.

- Komplex tranzakciók/módosítások: A HDFS nem támogatja a tranzakciókat vagy a fájlok közepén történő módosításokat. Az objektum tárolók szintén „immutable objects” (nem módosítható objektumok) elven működnek, a módosítások új objektum létrehozását jelentik.

Összefoglalva, míg az objektum tárolók kiválóak az adatok archiválására és a felhőalapú alkalmazásokhoz, a HDFS továbbra is a preferált választás az on-premise Hadoop klaszterekben a big data analitikai feladatokhoz, különösen, ha az adatlokalitás és a nagy átviteli sebesség kritikus.

HDFS Alkalmazási Területek és Esetek

A HDFS, mint a Hadoop elosztott fájlrendszere, számos iparágban és alkalmazási területen vált alapvető fontosságúvá, ahol hatalmas adatmennyiségek tárolására és feldolgozására van szükség. Az alábbiakban bemutatunk néhány kulcsfontosságú alkalmazási területet és konkrét esetet.

1. Big Data Analitika és Adatraktárak

Ez a HDFS legfőbb alkalmazási területe. Vállalatok gyűjtenek hatalmas mennyiségű adatot különböző forrásokból (webes kattintások, IoT szenzorok, tranzakciók, közösségi média), és a HDFS-ben tárolják őket további elemzés céljából.

- Eset: Egy e-kereskedelmi vállalat összegyűjti az összes felhasználói interakciót a weboldalon (kattintások, keresések, vásárlások). Ezeket az adatokat a HDFS-ben tárolják, majd Spark vagy Hive segítségével elemzik, hogy betekintést nyerjenek a vásárlói viselkedésbe, optimalizálják a termékajánlatokat és személyre szabják a felhasználói élményt.

- Eset: Pénzügyi intézmények tárolják a tranzakciós adatokat, kockázati modelleket és csalásészlelési algoritmusokat futtatnak a HDFS-ben lévő adatokon, hogy valós időben azonosítsák a gyanús tevékenységeket.

2. Naplógyűjtés és Elemzés

A HDFS ideális a nagy mennyiségű, strukturálatlan vagy félig strukturált naplófájlok tárolására, amelyek különböző rendszerekből, szerverekről, hálózati eszközökről és alkalmazásokból származnak.

- Eset: Egy telekommunikációs szolgáltató gyűjti a hálózati forgalmi naplókat, hívásrészletező rekordokat (CDR) és hibajelentéseket. Ezeket a HDFS-ben tárolják, és elemzik őket a hálózati teljesítmény monitorozására, a hibaelhárításra, a biztonsági fenyegetések azonosítására és az ügyfélélmény javítására.

- Eset: DevOps csapatok konszolidálják az összes alkalmazás és szerver naplóját a HDFS-ben, hogy központilag elemezhessék azokat, felderítsék a teljesítményproblémákat és optimalizálják a rendszerműködést.

3. Archívumok és Hosszú Távú Adattárolás

Mivel a HDFS költséghatékonyan skálázható és hibatűrő, kiválóan alkalmas nagy adathalmazok hosszú távú archiválására, amelyekre esetleg csak ritkán van szükség, de meg kell őrizni azokat szabályozási vagy történeti okokból.

- Eset: Kutatóintézetek és tudományos projektek hatalmas adatgyűjteményeket (genomikai adatok, csillagászati megfigyelések, klímamodellezési adatok) tárolnak a HDFS-ben, biztosítva azok hosszú távú hozzáférhetőségét és integritását a jövőbeli kutatásokhoz.

- Eset: Médiavállalatok digitális média archívumokat (videók, képek, hangfelvételek) tárolnak HDFS-ben, kihasználva a törlési kódolást a tárhelyköltségek optimalizálására.

4. Gépi Tanulás és Mesterséges Intelligencia

A gépi tanulási modellek képzéséhez gyakran hatalmas mennyiségű adatra van szükség. A HDFS ideális platform ezeknek az adatoknak a tárolására.

- Eset: Egy önvezető autókat fejlesztő cég szenzoradatokat (videók, radar, lidar) gyűjt a tesztjárművekből. Ezeket az adatokat a HDFS-ben tárolják, és Spark MLlib vagy más gépi tanulási keretrendszerekkel dolgozzák fel, hogy modelleket képezzenek az objektumfelismerésre és a navigációra.

- Eset: Reklámtechnológiai cégek felhasználói profilokat és hirdetési interakciókat tárolnak HDFS-ben, hogy prediktív modelleket építsenek a célzott hirdetésekhez.

5. IoT (Internet of Things) Adatok Kezelése

Az IoT eszközök hatalmas mennyiségű idősoros adatot generálnak, amelyeket hatékonyan kell gyűjteni, tárolni és elemezni.

- Eset: Egy okosváros projekt szenzoradatokat (levegőminőség, forgalom, zajszint) gyűjt a városi infrastruktúrából. Ezek az adatok a HDFS-be kerülnek, ahol elemzik őket a városi szolgáltatások optimalizálására és a polgárok életminőségének javítására.

- Eset: Ipari IoT megoldások gépekből és berendezésekből származó telemetriai adatokat tárolnak HDFS-ben, hogy prediktív karbantartást végezzenek és optimalizálják a gyártási folyamatokat.

Ezek az esetek jól mutatják, hogy a HDFS rugalmassága és robusztussága miatt kulcsfontosságú elem a modern, adatvezérelt vállalatok és kutatási projektek számára, ahol a big data jelenti az alapot a döntéshozatalhoz és az innovációhoz.

A HDFS Jövője és Fejlődési Irányai

A HDFS a big data ökoszisztéma alapköveként folyamatosan fejlődik, hogy megfeleljen az új kihívásoknak és igényeknek. Bár a felhőalapú tárolási megoldások népszerűsége növekszik, a HDFS továbbra is kulcsszerepet játszik az on-premise és hibrid felhő környezetekben. A jövőbeli fejlesztések a hatékonyság, a rugalmasság, a biztonság és az integráció további javítására összpontosítanak.

1. Felhő-integráció és Hibrid Megoldások

Egyre nagyobb az igény a HDFS és a felhőalapú tárolók (pl. AWS S3, Azure Blob Storage) közötti zökkenőmentes integrációra. Ez lehetővé teszi a hibrid architektúrák kiépítését, ahol a HDFS továbbra is az aktív, gyakran használt adatok tárolója marad, míg a hidegebb adatok vagy archívumok a költséghatékonyabb felhőbe kerülnek.

- Hadoop Ozone: Ez egy újabb kezdeményezés, amely egy S3-kompatibilis objektumtárolót biztosít a HDFS tetején, lehetővé téve a klasszikus HDFS fájlrendszer szemantikája és az objektumtároló rugalmassága közötti hidat. Célja, hogy a HDFS képességeit objektumtárolóként is elérhetővé tegye, különösen a konténeres és felhőalapú alkalmazások számára.

- S3A Connector fejlesztése: A Hadoop S3A connector folyamatosan fejlődik, hogy jobb teljesítményt, megbízhatóságot és funkciókat biztosítson a HDFS és az S3 közötti adatáramlásban, lehetővé téve a Hadoop számítási feladatok közvetlen futtatását az S3-ban tárolt adatokon.

2. Teljesítmény és Hatékonyság Növelése

A HDFS továbbra is optimalizálva lesz a nagyobb átviteli sebesség és alacsonyabb késleltetés elérése érdekében.

- Törlési Kódolás (Erasure Coding) szélesebb körű elterjedése: Ahogy a klaszterek mérete növekszik, az EC egyre fontosabbá válik a tárhelyköltségek csökkentésében, miközben fenntartja a hibatűrést. További optimalizációk várhatók az EC performanciájában és használhatóságában.

- Flash tárolók (SSD/NVMe) jobb kihasználása: Bár a HDFS hagyományosan HDD-kre épül, a flash alapú tárolók növekvő népszerűsége és csökkenő ára lehetővé teszi azok hatékonyabb integrálását a klaszterekbe, különösen a „hot data” (gyakran hozzáférhető adatok) gyorsítótárazására és a metaadatok tárolására.

- NameNode teljesítmény optimalizálás: A NameNode a klaszter skálázhatóságának szűk keresztmetszete lehet. Folyamatos fejlesztések zajlanak a NameNode memóriahasználatának, feldolgozási sebességének és stabilitásának javítására.

3. Biztonság és Adatvédelem

Az adatvédelmi szabályozások (pl. GDPR) és a növekvő kiberfenyegetések miatt a HDFS biztonsági funkciói is folyamatosan fejlődnek.

- Titkosítás: Az „encryption at rest” és „encryption in transit” képességek továbbfejlesztése, beleértve a kulcskezelést és az integrációt a vállalati biztonsági rendszerekkel.

- Finomabb szemcsézettségű hozzáférés-vezérlés: Az ACL-ek és a jogosultságkezelés további finomítása a komplex vállalati környezetek igényeinek megfelelően.

- Auditálás és monitorozás: A naplózási és monitorozási képességek javítása a biztonsági incidensek gyorsabb észlelésére és elemzésére.

4. Konténerizáció és Felhőnatív Megközelítések

A Kubernetes és a konténerizáció térnyerése befolyásolja a HDFS fejlesztését is. Cél, hogy a HDFS komponensei (különösen a DataNode-ok) jobban illeszkedjenek a konténeres környezetekhez, és rugalmasabban telepíthetők és kezelhetők legyenek a felhőben vagy on-premise Kubernetes klasztereken.

A HDFS jövője tehát a big data ökoszisztéma folyamatosan változó igényeire való adaptációban rejlik. A hangsúly az interoperabilitáson, a költséghatékonyságon, a teljesítményen és a robusztus biztonsági funkciókon van, biztosítva, hogy a HDFS továbbra is a választott tárolási megoldás maradjon a hatalmas adathalmazokhoz a következő évtizedekben is.