Miért van szükség a Hadoopra? A Big Data kihívásai

A digitális korban az adatok exponenciális növekedése az egyik legnagyobb kihívás, amellyel a vállalkozásoknak, kutatóintézeteknek és szervezeteknek szembe kell nézniük. Ez a jelenség, amelyet Big Data néven ismerünk, olyan hatalmas, gyorsan változó és sokféle adatmennyiséget takar, amelyet a hagyományos adatfeldolgozási eszközök és módszerek már nem képesek hatékonyan kezelni. A Big Data három fő dimenziója – a Volume (mennyiség), a Velocity (sebesség) és a Variety (sokféleség) – szemlélteti a probléma nagyságát.

- Volume (Mennyiség): Az adatok mérete terabájtos, petabájtos, sőt exabájtos nagyságrendűvé vált. Gondoljunk csak a közösségi média posztjaira, a szenzorok által generált adatokra, a videó- és hangfájlokra, vagy a tranzakciós rekordokra. Ezek a mennyiségek meghaladják egyetlen szerver tárolási és feldolgozási kapacitását.

- Velocity (Sebesség): Az adatok nemcsak hatalmas mennyiségben keletkeznek, hanem rendkívül gyorsan is. Valós idejű streaming adatok, online vásárlások, pénzügyi tranzakciók – mindezek azonnali feldolgozást igényelnek, hogy értéküket megőrizzék. A késleltetés elfogadhatatlan lehet bizonyos alkalmazásoknál.

- Variety (Sokféleség): Az adatok formátuma rendkívül változatos. Lehetnek strukturáltak (pl. relációs adatbázisok táblái), félig strukturáltak (pl. JSON, XML fájlok) vagy teljesen strukturálatlanok (pl. szöveges dokumentumok, képek, videók). A hagyományos adatbázisok elsősorban a strukturált adatok kezelésére optimalizáltak, így nehezen birkóznak meg a sokféleséggel.

A hagyományos adatbázis-kezelő rendszerek és az egyedi szervereken alapuló architektúrák korlátai hamar nyilvánvalóvá váltak a Big Data térnyerésével. A vertikális skálázás, vagyis egyetlen szerver erőforrásainak (CPU, RAM, tárhely) növelése egy ponton túl már nem gazdaságos, sőt fizikailag is korlátokba ütközik. Emellett egyetlen szerver meghibásodása az egész rendszer leállásához vezethet, ami kritikus üzleti folyamatoknál óriási veszteségeket okozhat.

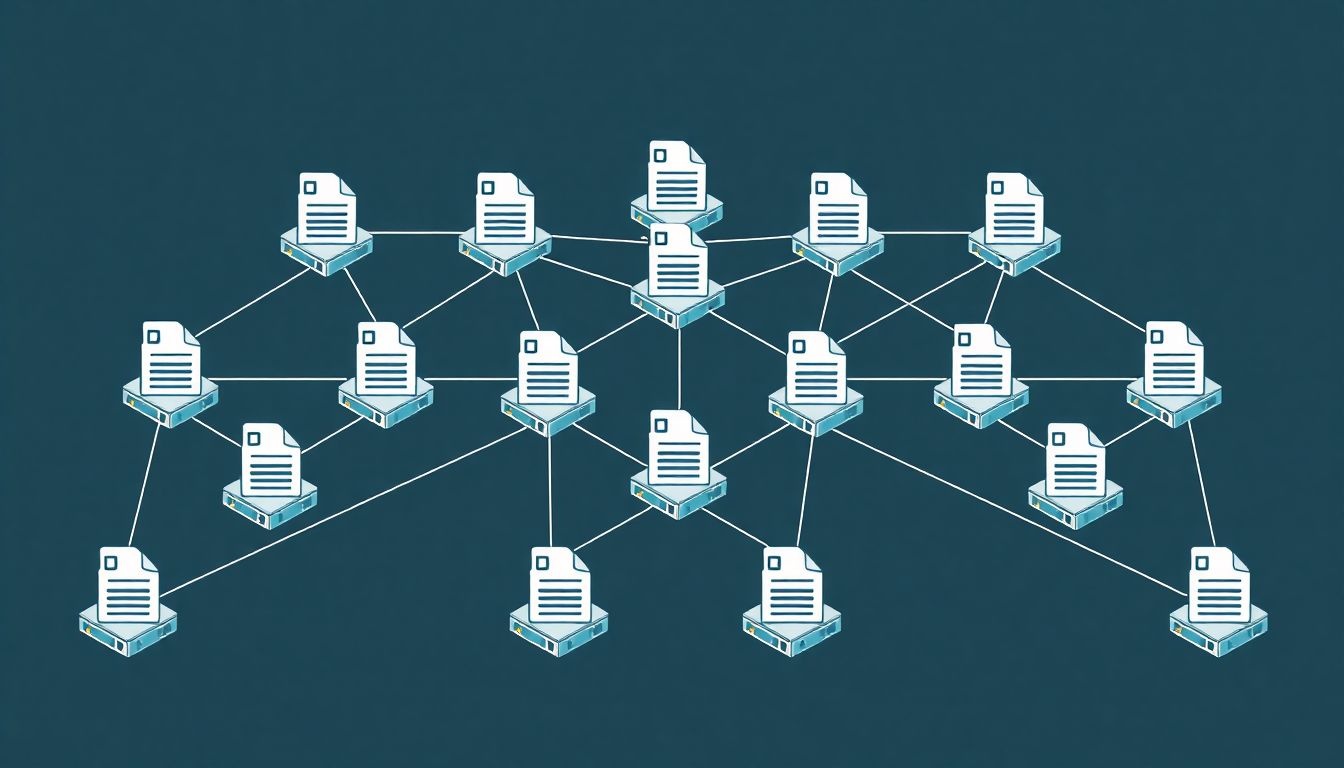

Ezekre a kihívásokra kerestek megoldást azok a technológiák, amelyek a horizontális skálázást teszik lehetővé. A horizontális skálázás lényege, hogy több, akár olcsó, commodity hardverből álló gépet kapcsolunk össze egy klaszterbe, és az adatok feldolgozását, tárolását elosztjuk ezek között a gépek között. Ez a megközelítés lehetővé teszi a szinte korlátlan skálázhatóságot, miközben jelentősen növeli a rendszer hibatűrését is. Ebben a kontextusban vált kulcsfontosságúvá a Hadoop, mint egy forradalmi keretrendszer, amely képes kezelni a Big Data által támasztott komplex igényeket.

A Hadoop eredete és filozófiája

A Hadoop története szorosan összefonódik a Google belső kutatásaival és publikációival a 2000-es évek elején. A Google mérnökei, akik hatalmas mennyiségű webes adat indexelésével és feldolgozásával foglalkoztak, olyan problémákba ütköztek, amelyekre a hagyományos rendszerek nem nyújtottak megfelelő megoldást. Válaszul két úttörő publikációt tettek közzé:

- Google File System (GFS): Egy elosztott fájlrendszer, amely nagy fájlok tárolására és nagy átviteli sebességű hozzáférésre optimalizált, hibatűréssel kiegészítve.

- MapReduce: Egy programozási modell és egy ahhoz kapcsolódó keretrendszer a nagyméretű adathalmazok elosztott és párhuzamos feldolgozására.

Ezek a publikációk inspirálták Doug Cuttingot és Mike Cafarellát, akik ekkoriban a Nutch nevű nyílt forráskódú webes keresőmotoron dolgoztak. A Nutch-nak hasonló problémái voltak a webes adatok skálázható tárolásával és feldolgozásával. A Google GFS és MapReduce koncepciói alapján Cutting és Cafarella elkezdték fejleszteni a Nutch infrastruktúrájának alapjait, amelyet később külön projektként, Hadoop néven indítottak el, Doug Cutting elefántjának neve után.

A Hadoop projekt gyorsan az Apache Software Foundation égisze alá került, mint egy nyílt forráskódú kezdeményezés. Ez a nyílt forráskódú filozófia kulcsfontosságú volt a Hadoop sikeréhez, mivel lehetővé tette egy hatalmas, globális fejlesztői közösség bevonását, akik folyamatosan hozzájárultak a keretrendszer fejlődéséhez, hibajavításához és új funkciók implementálásához. A közösségi támogatás és az ingyenes hozzáférés jelentősen csökkentette a Big Data megoldások bevezetésének költségeit.

A Hadoop alapvető filozófiája a következő elvekre épül:

- Elosztott tárolás és feldolgozás: Az adatok nem egyetlen gépen, hanem egy klaszter számos gépén vannak elosztva, és a feldolgozás is párhuzamosan történik ezeken a gépeken.

- Hibatűrés: Mivel a klaszter sok gépből áll, egyes gépek meghibásodása elkerülhetetlen. A Hadoop rendszere úgy van tervezve, hogy automatikusan kezelje ezeket a hibákat, azaz az adatok replikálásával és a feladatok újraütemezésével biztosítja a folyamatos működést.

- Skálázhatóság: A klaszterhez egyszerűen hozzáadhatók új gépek, növelve ezzel a tárolási és feldolgozási kapacitást anélkül, hogy a meglévő rendszert jelentősen át kellene alakítani. Ez a horizontális skálázás.

- Költséghatékonyság: A Hadoop úgy lett tervezve, hogy olcsó, kereskedelmi forgalomban kapható (commodity) hardveren is hatékonyan fusson, szemben a drága, speciális szerverekkel. Ez drámaian csökkenti a Big Data infrastruktúra költségeit.

- Adatlokalitás: A feldolgozást az adatokhoz közel végzi, minimalizálva az adatok hálózaton keresztüli mozgatását. Ez jelentősen növeli a feldolgozás hatékonyságát.

A Hadoop forradalmasította a Big Data kezelését azáltal, hogy egy nyílt forráskódú, elosztott és hibatűrő keretrendszert biztosít, amely képes hatalmas adatmennyiségek tárolására és párhuzamos feldolgozására olcsó, kereskedelmi hardvereken.

A Hadoop alapvető komponensei

Bár a Hadoop egy kiterjedt ökoszisztémát foglal magába, alapvetően három fő komponensre épül, amelyek a keretrendszer magját képezik. Ezek együtt biztosítják az adatok tárolását, feldolgozását és az erőforrások hatékony kezelését egy elosztott klaszterben.

- Hadoop Distributed File System (HDFS): Ez a Hadoop elosztott fájlrendszere, amely az adatok tárolásáért felelős a klaszter gépein. Úgy tervezték, hogy hatalmas fájlokat tároljon megbízhatóan, nagy átviteli sebességgel, hibatűréssel.

- MapReduce: Ez a Hadoop eredeti programozási modellje és feldolgozó motorja. Lehetővé teszi a nagyméretű adathalmazok elosztott és párhuzamos feldolgozását. A feladatokat két fő fázisra osztja: a Map fázisra és a Reduce fázisra.

- Yet Another Resource Negotiator (YARN): Ez a Hadoop 2.x verziójával bevezetett erőforrás-kezelő és feladatütemező komponens. Leválasztotta a MapReduce feldolgozó motort az erőforrás-kezelésről, lehetővé téve más feldolgozó keretrendszerek (pl. Apache Spark) futtatását is a Hadoop klaszter erőforrásain.

Ez a három komponens együtt alkotja a Hadoop alapvető architektúráját, biztosítva a Big Data tárolásának és feldolgozásának alapvető képességeit. A továbbiakban részletesen megvizsgáljuk mindegyik komponens működését és szerepét.

HDFS: Az elosztott fájlrendszer

A Hadoop Distributed File System (HDFS) a Hadoop gerince, amely a rendszer alapvető tárolási képességét biztosítja. Nem egy hagyományos fájlrendszer, mint amilyet a helyi merevlemezeken ismerünk, hanem egy speciálisan tervezett elosztott fájlrendszer, amely hatalmas adatmennyiségek (terabájtos, petabájtos skálán) megbízható, nagy átviteli sebességű tárolására optimalizált, több ezer szerverből álló klasztereken keresztül.

A HDFS architektúrája

A HDFS egy mester/szolga (master/slave) architektúrát követ, amely két fő komponensből áll:

- NameNode (Mester): Ez a HDFS agya. Felelős a fájlrendszer metaadatainak (pl. fájlnevek, könyvtárak, fájlok blokkjainak elhelyezkedése a DataNode-okon, hozzáférési jogok) tárolásáért és kezeléséért. Minden fájlrendszer művelet, mint például a fájlok megnyitása, bezárása, átnevezése vagy törlése, a NameNode-on keresztül történik. A NameNode ismeri a klaszter teljes topológiáját és az egyes adatok fizikai elhelyezkedését. Mivel az összes metaadatot memóriában tárolja, a NameNode memóriája korlátozhatja a klaszterben tárolható fájlok számát. A NameNode egy kritikus pont, egyetlen hibapont (Single Point Of Failure – SPOF) lehet, ezért a modern Hadoop disztribúciók magas rendelkezésre állású (High Availability – HA) megoldásokat kínálnak, ahol egy aktív és egy passzív NameNode biztosítja a rendszer folyamatos működését.

- DataNode (Szolga): Ezek a klaszterben található gépek, amelyek ténylegesen tárolják az adatokat. Minden DataNode a helyi fájlrendszerén tárolja az adatblokkokat, és rendszeres időközönként „szívverés” (heartbeat) üzeneteket küld a NameNode-nak, tájékoztatva azt a rendelkezésre állásáról és az általa tárolt blokkokról. Ha egy DataNode meghibásodik, a NameNode észleli ezt a szívverések hiányából, és elindítja a hiányzó adatblokkok replikálását más DataNode-okra, biztosítva ezzel az adatok integritását és elérhetőségét.

Adatblokkok és replikáció

A HDFS az adatokat nagy méretű blokkokra osztja fel. Az alapértelmezett blokkméret régebben 64 MB volt, ma már jellemzően 128 MB vagy 256 MB. Ez a nagy blokkméret csökkenti a metaadatok mennyiségét a NameNode-on, és minimalizálja a lemezkeresési időt a szekvenciális olvasás során, ami a Big Data feldolgozásban gyakori.

A HDFS egyik legfontosabb jellemzője az adatreplikáció. Annak érdekében, hogy a rendszer hibatűrő legyen és az adatok ne vesszenek el egy DataNode meghibásodása esetén, minden adatblokk több másolattban tárolódik a klaszter különböző DataNode-jain. Az alapértelmezett replikációs faktor 3, ami azt jelenti, hogy minden blokk három példányban létezik. Ezek a másolatok jellemzően különböző fizikai rackekben vagy adatközpontokban lévő DataNode-okon helyezkednek el, hogy a rack vagy adatközpont szintű hibák ellen is védelmet nyújtsanak.

Adatírás a HDFS-be

Amikor egy kliens egy fájlt ír a HDFS-be, a következő folyamat zajlik:

- A kliens kapcsolatba lép a NameNode-dal, és kéri a fájl létrehozását.

- A NameNode ellenőrzi a jogosultságokat, és ha az írás engedélyezett, megadja a fájl első blokkjának írására alkalmas DataNode-ok listáját (a replikációs faktornak megfelelően).

- A kliens közvetlenül az első kijelölt DataNode-nak kezdi el küldeni az adatokat.

- Ez a DataNode továbbítja az adatokat a következő kijelölt DataNode-nak, az pedig a harmadiknak, és így tovább, amíg az összes másolat elkészül. Ez a pipeline írási mechanizmus növeli a hatékonyságot.

- Amikor az összes DataNode megerősíti a blokk sikeres írását, a NameNode frissíti a metaadatait.

- Ez a folyamat ismétlődik minden egyes blokk esetében, amíg a teljes fájl beírásra nem kerül.

Ez a láncolt replikációs mechanizmus biztosítja a gyors írási sebességet és a magas rendelkezésre állást.

Adatolvasás a HDFS-ből

Amikor egy kliens egy fájlt olvas a HDFS-ből:

- A kliens kapcsolatba lép a NameNode-dal, és kéri a fájl olvasását.

- A NameNode lekérdezi a metaadatokat, és visszaadja a fájl összes blokkjának és az őket tároló DataNode-ok helyének listáját. A NameNode megpróbálja a klienshez legközelebb eső DataNode-okat prioritásként kezelni (adatlokalitás elve).

- A kliens közvetlenül a kijelölt DataNode-októl kezdi el olvasni a blokkokat párhuzamosan.

- Ha egy DataNode nem válaszol, a kliens automatikusan átvált egy másik DataNode-ra, amely ugyanazt a blokkot tárolja.

A HDFS előnyei

- Hibatűrés: Az adatreplikációnak köszönhetően a DataNode-ok meghibásodása nem okoz adatvesztést.

- Skálázhatóság: Egyszerűen hozzáadhatók új DataNode-ok a klaszterhez, növelve ezzel a tárolási kapacitást.

- Nagy átviteli sebesség: A nagy blokkméret és a párhuzamos olvasás/írás révén a HDFS kiválóan alkalmas nagy fájlok gyors átvitelére.

- Alacsony költség: Olcsó, commodity hardveren futtatható.

A HDFS tehát nem csak egy tárolórendszer, hanem egy intelligens, elosztott infrastruktúra, amely a Big Data alapját képezi, biztosítva az adatok megbízható és hatékony kezelését a klaszterben.

MapReduce: A programozási modell a párhuzamos feldolgozáshoz

A MapReduce volt a Hadoop eredeti, forradalmi feldolgozó motorja és programozási modellje. Bár azóta számos más, gyorsabb és rugalmasabb feldolgozó keretrendszer (mint például az Apache Spark) is megjelent a Hadoop ökoszisztémában, a MapReduce alapvető koncepciói továbbra is kulcsfontosságúak a Big Data feldolgozás megértéséhez, és számos feladatnál még ma is alkalmazzák.

Mi az a MapReduce?

A MapReduce egy olyan programozási paradigma, amely lehetővé teszi a fejlesztők számára, hogy nagyméretű adathalmazokat dolgozzanak fel elosztott és párhuzamos módon egy klaszterben. Nevét a két fő fázisáról kapta, amelyekből áll: a Map fázisból és a Reduce fázisból. A modell lényege, hogy a komplex feldolgozási feladatokat kisebb, független részekre bontja, amelyeket párhuzamosan lehet futtatni a klaszter különböző gépein. A MapReduce keretrendszer gondoskodik az adatok elosztásáról, a feladatok ütemezéséről, a hibakezelésről és az eredmények összegyűjtéséről, így a fejlesztők a logikára koncentrálhatnak.

A MapReduce fő fázisai

Egy tipikus MapReduce feladat a következő lépésekből áll:

- Input Split (Bemeneti felosztás):

A HDFS-ben tárolt bemeneti adatok logikai darabokra (splits) vannak osztva. Minden splitet egy különálló Map feladat (Map Task) dolgoz fel. Ezek a splitek jellemzően igazodnak a HDFS blokkméretéhez, hogy kihasználják az adatok lokalitását.

- Map Fázis:

A Map fázis a feldolgozás első lépése. A Map Task-ok bemenetként kulcs-érték párokat kapnak, és egy felhasználó által definiált mapper függvényt futtatnak rajtuk. A mapper függvény feladata, hogy feldolgozza a bemeneti adatokat, és köztes kulcs-érték párokat generáljon. A mapper függvények egymástól függetlenül futnak a klaszter különböző DataNode-jain, jellemzően azokon a gépeken, ahol a bemeneti adatok is találhatók (adatlokalitás).

Példa: Szószámolás (WordCount)

Bemenet: „Hello world, hello Hadoop.”

Mapper kimenet (köztes kulcs-érték párok):

(Hello, 1)

(world, 1)

(hello, 1)

(Hadoop, 1) - Shuffle & Sort Fázis:

Ez egy implicit, a keretrendszer által automatikusan végrehajtott fázis a Map és Reduce fázisok között. Feladata, hogy az összes Map Task által generált köztes kulcs-érték párokat gyűjtse, csoportosítsa és rendezze. Az azonos kulccsal rendelkező párok egyetlen Reduce Task-hoz kerülnek továbbításra. A „shuffle” (keverés) azt jelenti, hogy az adatok áramlanak a Map Task-okból a Reduce Task-okhoz, míg a „sort” (rendezés) biztosítja, hogy minden kulcshoz tartozó értékek rendezetten érkezzenek meg a reducerhez.

Példa: Szószámolás (WordCount)

Shuffle & Sort kimenet (a Reduce fázis bemenete):

(Hadoop, [1])

(Hello, [1, 1])

(world, [1]) - Reduce Fázis:

A Reduce fázis a feldolgozás utolsó lépése. A Reduce Task-ok bemenetként egy kulcsot és a hozzá tartozó értékek listáját kapják (a Shuffle & Sort fázis eredményeként). Egy felhasználó által definiált reducer függvényt futtatnak rajtuk. A reducer feladata, hogy aggregálja, összefoglalja vagy valamilyen módon feldolgozza az értékek listáját, és végső kimeneti kulcs-érték párokat generáljon.

Példa: Szószámolás (WordCount)

Reducer kimenet (végső eredmény):

(Hadoop, 1)

(Hello, 2)

(world, 1) - Output (Kimenet):

A Reduce Task-ok által generált végső eredmények a HDFS-be kerülnek tárolásra, általában egy meghatározott kimeneti könyvtárba.

A MapReduce előnyei és korlátai

Előnyök:

- Párhuzamos feldolgozás: Képes hatalmas adathalmazokat párhuzamosan feldolgozni a klaszter több gépén.

- Hibatűrés: Ha egy Map vagy Reduce Task meghibásodik, a keretrendszer automatikusan újraütemezi azt egy másik gépen.

- Skálázhatóság: A klaszterhez hozzáadott további gépekkel a feldolgozási kapacitás is növelhető.

- Egyszerű programozási modell: Bár a komplex feladatok implementálása kihívást jelenthet, az alapvető Map és Reduce függvények koncepciója viszonylag egyszerű.

Korlátok:

- Batch feldolgozás: A MapReduce elsősorban nagy adathalmazok batch, azaz kötegelt feldolgozására optimalizált. Nem alkalmas valós idejű, interaktív lekérdezésekre vagy alacsony késleltetésű feladatokra.

- Iteratív algoritmusok nehézsége: Az iteratív algoritmusok, amelyek több lépésben finomítják az eredményt (pl. gépi tanulási algoritmusok), nehezen implementálhatók MapReduce-ban, mivel minden iterációhoz ki kell írni az eredményeket a HDFS-be, majd újra beolvasni, ami jelentős I/O overhead-et okoz.

- Magas késleltetés: A feladatok indítása, a shuffle fázis és az adatok lemezre írása miatt a MapReduce feladatok viszonylag nagy késleltetéssel futnak.

- Komplexitás: Bár a modell egyszerű, komplexebb logika implementálása, különösen az optimalizálás és a hibakeresés, kihívást jelenthet.

A MapReduce volt a Hadoop alapja, és továbbra is fontos szerepet játszik a nagy, kötegelt adatfeldolgozási feladatoknál. Azonban a fent említett korlátok vezettek ahhoz, hogy az ökoszisztémában más, speciálisabb feldolgozó motorok is megjelenjenek, amelyek kiegészítik vagy helyettesítik a MapReduce-ot bizonyos use case-ekben.

YARN: A Hadoop erőforrás-kezelője

A Hadoop 2.0-val bevezetett YARN (Yet Another Resource Negotiator) volt az egyik legjelentősebb fejlesztés a Hadoop architektúrájában. A YARN forradalmasította a Hadoop működését azáltal, hogy leválasztotta az erőforrás-kezelést és a feladatütemezést a MapReduce feldolgozó motortól. Ez a szétválasztás lehetővé tette, hogy a Hadoop klaszter ne csak MapReduce feladatokat futtasson, hanem más, különböző feldolgozó keretrendszereket (pl. Apache Spark, Apache Flink, Apache Storm) is képes legyen kezelni ugyanazon az elosztott infrastruktúrán, optimalizálva az erőforrás-kihasználtságot és a klaszter rugalmasságát.

A YARN célja

A YARN fő célja a Hadoop klaszter erőforrásainak (CPU, memória) központosított és hatékony kezelése, valamint az alkalmazások (applications) futtatásának felügyelete. Ezelőtt a MapReduce felelt mind az adatok feldolgozásáért, mind az erőforrások kezeléséért, ami korlátozta a klaszter sokoldalúságát. A YARN bevezetésével a Hadoop egy általános célú Big Data operációs rendszerré vált.

A YARN architektúrája

A YARN is egy mester/szolga architektúrát követ, de a NameNode és DataNode szerepekhez képest más feladatokkal:

- ResourceManager (Mester): Ez a YARN agya. Felelős a klaszter összes erőforrásának (CPU, memória) globális felügyeletéért és ütemezéséért. Egyetlen ResourceManager fut a klaszterben (magas rendelkezésre állással biztosított). Két fő komponense van:

- Scheduler: Felelős az erőforrás-igények kielégítéséért a rendelkezésre álló erőforrások alapján. Különböző ütemezési algoritmusokat (pl. Capacity Scheduler, Fair Scheduler) támogat, amelyek lehetővé teszik a klaszter erőforrásainak megosztását több alkalmazás és felhasználó között.

- ApplicationsManager: Felelős az alkalmazások (ApplicationMaster-ek) kezeléséért, a feladatok benyújtásáért és monitorozásáért.

- NodeManager (Szolga): Minden DataNode-on (vagy a klaszter minden számítási csomópontján) fut egy NodeManager. A NodeManager felelős az adott gépen lévő erőforrások (CPU, memória) felügyeletéért, a konténerek (containers) indításáért és leállításáért, valamint a ResourceManagerrel való kommunikációért (szívverések küldése, erőforrás-státusz jelentése).

- ApplicationMaster (Alkalmazás-specifikus mester): Minden futó alkalmazás (pl. egy MapReduce feladat, egy Spark feladat) rendelkezik egy saját ApplicationMasterrel. Az ApplicationMaster feladata, hogy erőforrásokat kérjen a ResourceManagertől az alkalmazás feladataihoz, és felügyelje azok végrehajtását a NodeManagereken. Az ApplicationMaster felelős az adott alkalmazás hibakezeléséért és az előrehaladás jelentéséért.

- Container (Konténer): A konténer a YARN alapvető erőforrás-egysége. Minden konténer egy adott mennyiségű CPU-t és memóriát foglal magában egy NodeManageren. Az alkalmazás feladatai (pl. egy Map Task, egy Reduce Task, egy Spark Executor) konténerekben futnak.

A YARN működése egy alkalmazás indításakor

Amikor egy felhasználó elindít egy alkalmazást (pl. egy MapReduce feladatot) a YARN klaszteren, a következő folyamat zajlik:

- A kliens benyújtja az alkalmazást a ResourceManagernek.

- A ResourceManager a Scheduler segítségével kiválaszt egy NodeManagert, és utasítja, hogy indítson el egy konténert az ApplicationMaster számára.

- Az ApplicationMaster elindul a kijelölt konténerben. Feladata, hogy felügyelje a teljes alkalmazást.

- Az ApplicationMaster elemzi az alkalmazás logikáját (pl. egy MapReduce feladat esetén, hány Map és Reduce Taskra van szükség), és erőforrás-kérelmeket küld a ResourceManager Schedulerjének.

- A Scheduler a klaszter aktuális terheltsége és a rendelkezésre álló erőforrások alapján konténereket allokál a NodeManagereken az alkalmazás feladatai számára.

- Az ApplicationMaster utasítja a kijelölt NodeManagereket, hogy indítsák el az alkalmazás feladatait (pl. Map Taskokat, Reduce Taskokat) a kapott konténerekben.

- A NodeManagerek felügyelik a konténerekben futó feladatokat, és jelentik állapotukat az ApplicationMasternek.

- Amikor az alkalmazás befejeződik, az ApplicationMaster értesíti a ResourceManagert, amely felszabadítja az allokált erőforrásokat.

A YARN előnyei

- Több keretrendszer támogatása: A YARN legfontosabb előnye, hogy lehetővé teszi több különböző Big Data feldolgozó keretrendszer (MapReduce, Spark, Flink, Tez stb.) futtatását ugyanazon a Hadoop klaszteren. Ez megszünteti a „silók” kialakulását, ahol minden technológiához külön klaszter szükséges.

- Jobb erőforrás-kihasználtság: A YARN központosított erőforrás-kezelése optimalizálja a klaszter erőforrásainak kihasználtságát, mivel dinamikusan allokálja azokat a futó alkalmazások között.

- Skálázhatóság és rugalmasság: A klaszter könnyen skálázható, és a YARN rugalmasságot biztosít az erőforrások elosztásában a különböző típusú munkaterhelések között.

- Stabilitás és hibatűrés: A YARN architektúra robusztusabbá teszi a klasztert, mivel az ApplicationMaster hibái nem befolyásolják a ResourceManager működését.

A YARN bevezetésével a Hadoop nem csupán egy MapReduce motor és egy fájlrendszer lett, hanem egy teljes értékű, általános célú platform a Big Data alkalmazások futtatására, amely alapvetően hozzájárult a Hadoop ökoszisztéma robbanásszerű növekedéséhez és sokoldalúságához.

A Hadoop ökoszisztéma: Több mint HDFS és MapReduce

Bár a HDFS, MapReduce és YARN alkotják a Hadoop magját, a keretrendszer ereje és rugalmassága abban rejlik, hogy egy hatalmas és folyamatosan bővülő ökoszisztémát épített maga köré. Ezek a kiegészítő eszközök és projektek bővítik a Hadoop képességeit, leegyszerűsítik a Big Data feldolgozást, és lehetővé teszik a Hadoop használatát a legkülönfélébb alkalmazási területeken. A MapReduce korlátai (pl. batch jelleg, iteratív algoritmusok nehézsége) vezettek számos új eszköz kifejlesztéséhez, amelyek más feldolgozási paradigmákat vagy magasabb szintű absztrakciókat kínálnak.

Nézzünk meg néhány kulcsfontosságú komponenst a Hadoop ökoszisztémából:

Adatkezelés és lekérdezés

-

Apache Hive:

A Hive egy adatraktár (data warehouse) szoftver, amely SQL-szerű lekérdezéseket (HiveQL) tesz lehetővé a HDFS-ben tárolt adatokon. A HiveQL lekérdezéseket a háttérben MapReduce, Tez vagy Spark feladatokká fordítja le. Ideális nagy, strukturált vagy félig strukturált adathalmazok elemzésére és riportok készítésére. A Hive-t gyakran használják az adatelemzők és üzleti intelligencia (BI) szakemberek, akik hozzászoktak az SQL-hez.

-

Apache Pig:

A Pig egy magas szintű platform a nagy adathalmazok elemzésére. Saját nyelvvel rendelkezik, a Pig Latin-nel, amely egy procedurális adatfolyam nyelv. A Pig Latin szkripteket MapReduce feladatokká fordítja le. A Pig ideális az ETL (Extract, Transform, Load) típusú feladatokhoz, és rugalmasabb, mint a Hive, ha az adatok szerkezete nem teljesen szabályos.

-

Apache HBase:

Az HBase egy elosztott, oszloporientált, NoSQL adatbázis, amely a HDFS tetején fut. Úgy tervezték, hogy valós idejű, véletlenszerű olvasási/írási hozzáférést biztosítson hatalmas adathalmazokhoz. Ellentétben a MapReduce-szal, amely batch feldolgozásra optimalizált, az HBase alacsony késleltetésű hozzáférést kínál milliárdnyi sorhoz és milliónyi oszlophoz. Gyakran használják webes alkalmazások, szenzoradatok vagy más gyorsan változó adatok tárolására.

Adatbetöltés és -integráció

-

Apache Sqoop:

A Sqoop (SQL to Hadoop) egy eszköz, amely lehetővé teszi az adatok hatékony átvitelét a relációs adatbázisok (RDBMS) és a Hadoop (HDFS, Hive, HBase) között. Képes importálni adatokat RDBMS-ből HDFS-be, és exportálni adatokat HDFS-ből RDBMS-be. Teljes mértékben kihasználja a MapReduce párhuzamosságát a gyors adatátvitel érdekében.

-

Apache Flume:

A Flume egy elosztott, megbízható és rendelkezésre álló szolgáltatás a nagy mennyiségű naplóadat (log data) és más eseményalapú adatok gyűjtésére, aggregálására és áthelyezésére különböző forrásokból (pl. web szerverek, alkalmazások) a HDFS-be vagy más központi adattárakba. Ideális a streaming adatok gyűjtésére.

Munkafolyamat-kezelés és ütemezés

-

Apache Oozie:

Az Oozie egy munkafolyamat-ütemező rendszer a Hadoop feladatok kezelésére. Lehetővé teszi komplex adatfeldolgozási munkafolyamatok definiálását és ütemezését, amelyek MapReduce, Pig, Hive vagy más Hadoop alkalmazásokat tartalmazhatnak. Képes időalapú vagy adatfüggő triggereket használni a munkafolyamatok indításához.

Klaszterkezelés és koordináció

-

Apache ZooKeeper:

A ZooKeeper egy elosztott koordinációs szolgáltatás a nagy elosztott rendszerek számára. Központosított szolgáltatást nyújt a konfigurációs információk fenntartásához, a névszolgáltatáshoz, a szinkronizált elosztott állapot fenntartásához és a csoportszolgáltatások biztosításához. A Hadoop és számos más elosztott rendszer (pl. HBase, Kafka) támaszkodik a ZooKeeperre a klaszter tagjainak koordinálásához és az állapot kezeléséhez.

Új generációs feldolgozó motorok

A YARN megjelenésével a Hadoop klaszterek már nem kizárólag MapReduce-ra korlátozódnak. Ez megnyitotta az utat új, erősebb és rugalmasabb feldolgozó motorok előtt:

-

Apache Spark:

A Spark egy rendkívül gyors és általános célú klaszter-számítási keretrendszer. Képes memóriában (in-memory) történő feldolgozásra, ami jelentősen gyorsabbá teszi a MapReduce-nál, különösen iteratív algoritmusok vagy interaktív lekérdezések esetén. Támogatja a batch feldolgozást, a streaminget (Spark Streaming), az SQL-t (Spark SQL), a gépi tanulást (MLlib) és a gráffeldolgozást (GraphX). Gyakran használják a HDFS-sel együtt, mint a tárolási réteggel, de a feldolgozást a Spark végzi MapReduce helyett. A Spark mára a legnépszerűbb feldolgozó motorrá vált a Hadoop ökoszisztémában.

-

Apache Kafka:

A Kafka egy elosztott streaming platform, amely nagy mennyiségű adatfolyam megbízható kezelésére optimalizált. Lehetővé teszi az adatok valós idejű beolvasását, tárolását és feldolgozását. Gyakran használják adatok gyűjtésére és továbbítására a forrásrendszerekből a Hadoop klaszterbe, vagy más streaming feldolgozó motorokhoz (pl. Spark Streaming, Flink).

-

Apache Flink:

A Flink egy erőteljes, elosztott streaming adatfeldolgozó motor, amely valós idejű, eseményalapú alkalmazásokhoz és batch feldolgozáshoz egyaránt alkalmas. A Sparkhoz hasonlóan in-memory feldolgozást kínál, de hangsúlyosabban a streamingre fókuszál, garantálva az adatok pontos, egyszeri feldolgozását (exactly-once semantics).

Ez a széleskörű ökoszisztéma teszi a Hadoopot egy rendkívül sokoldalú és átfogó megoldássá a Big Data kihívásainak kezelésére. A különböző komponensek együttműködve egy teljes adatfeldolgozási láncot képesek biztosítani, az adatok gyűjtésétől kezdve, a tároláson és feldolgozáson át az elemzésig és vizualizációig.

A Hadoop előnyei

A Hadoop, mint a Big Data keretrendszerek úttörője és a mai napig meghatározó szereplője, számos jelentős előnnyel rendelkezik, amelyek hozzájárultak széleskörű elterjedéséhez és népszerűségéhez. Ezek az előnyök teszik képessé a szervezeteket arra, hogy kezeljék a modern adatmennyiségeket és kinyerjék belőlük az értéket.

-

Skálázhatóság (Scalability):

Ez a Hadoop egyik legfontosabb előnye. A keretrendszer képes petabájtos, sőt exabájtos méretű adathalmazok tárolására és feldolgozására. A horizontális skálázás elvét alkalmazva a klaszterhez egyszerűen hozzáadhatók további, olcsó szerverek (DataNode-ok), így a tárolási és feldolgozási kapacitás szinte korlátlanul növelhető anélkül, hogy a meglévő rendszert jelentősen át kellene alakítani. Ez a rugalmasság alapvető a folyamatosan növekvő adatmennyiségek kezeléséhez.

-

Hibatűrés (Fault Tolerance):

A Hadoopot alapvetően úgy tervezték, hogy ellenálljon a hardverhibáknak. A HDFS az adatok replikálásával (alapértelmezés szerint 3 másolatban) biztosítja, hogy ha egy DataNode meghibásodik, az adatok továbbra is elérhetők maradjanak más csomópontokon. A MapReduce és YARN keretrendszerek pedig automatikusan újraütemezik a meghibásodott feladatokat más elérhető gépeken. Ez a beépített hibatűrés garantálja az adatok integritását és a feldolgozási folyamatok folyamatosságát, még egy nagyméretű, sok komponensből álló klaszter esetén is, ahol a hardverhibák elkerülhetetlenek.

-

Költséghatékonyság (Cost-effectiveness):

A Hadoop úgy lett tervezve, hogy olcsó, kereskedelmi forgalomban kapható (commodity) hardveren is hatékonyan fusson. Nincs szükség drága, speciális szerverekre vagy tárolórendszerekre. Ez drámaian csökkenti a Big Data infrastruktúra kiépítésének és üzemeltetésének költségeit. Ezen felül, mivel nyílt forráskódú, nincsenek licencdíjak, ami tovább csökkenti a teljes birtoklási költséget (TCO).

-

Rugalmasság (Flexibility):

A Hadoop képes kezelni a strukturált, félig strukturált és strukturálatlan adatok széles skáláját. A HDFS mindenféle adatot tárolhat, anélkül, hogy előzetes sémára (schema-on-write) lenne szükség, ami a hagyományos relációs adatbázisokra jellemző. Ehelyett a séma az olvasáskor (schema-on-read) kerül alkalmazásra, ami nagy rugalmasságot biztosít az adatok tárolásában és későbbi elemzésében. Ez a képesség kulcsfontosságú a mai sokféle adatforrás kezelésében.

-

Párhuzamos feldolgozás (Parallel Processing):

A MapReduce és a YARN által támogatott más feldolgozó motorok (pl. Spark) lehetővé teszik a hatalmas adathalmazok párhuzamos feldolgozását a klaszter több gépén. Ez jelentősen felgyorsítja az adatfeldolgozást és az elemzést, lehetővé téve, hogy a szervezetek gyorsabban jutjanak értékes betekintésekhez.

-

Adatlokalitás (Data Locality):

A Hadoop megpróbálja a feldolgozást az adatokhoz közel végezni, azaz a Map Taskokat (vagy Spark Executort) azokon a DataNode-okon futtatja, ahol az adatok fizikailag is tárolódnak. Ez minimalizálja az adatok hálózaton keresztüli mozgatását, csökkenti a hálózati terhelést és növeli a feldolgozás hatékonyságát.

-

Nyílt Forráskódú és Közösségi Támogatás:

Mivel a Hadoop nyílt forráskódú projekt, egy nagy és aktív globális közösség támogatja. Ez folyamatos fejlesztést, hibajavítást és új funkciók hozzáadását jelenti. A nyílt forráskódú modell lehetővé teszi a transzparenciát és a testreszabhatóságot, valamint hozzáférést biztosít a rengeteg dokumentációhoz és fórumhoz.

Ezek az előnyök együttesen teszik a Hadoop-ot egy rendkívül vonzó és hatékony megoldássá a Big Data tárolására és elemzésére, lehetővé téve a vállalatok számára, hogy kihasználják az adatokban rejlő potenciált.

A Hadoop kihívásai és korlátai

Bár a Hadoop számos előnnyel jár a Big Data kezelésében, fontos megérteni, hogy nem mindenható megoldás, és számos kihívással és korláttal is járhat, különösen, ha nem megfelelően implementálják vagy használják. Ezek a tényezők befolyásolhatják a Hadoop bevezetésének és üzemeltetésének sikerességét.

-

Komplexitás (Complexity):

A Hadoop klaszterek telepítése, konfigurálása és menedzselése jelentős technikai szakértelmet igényel. Sok komponensből áll (HDFS, YARN, Hive, HBase, Spark stb.), és mindegyiknek megvannak a saját konfigurációs beállításai. A hibakeresés és a teljesítmény-optimalizálás is bonyolult lehet egy elosztott környezetben. Ez a komplexitás magasabb tanulási görbét és képzett szakemberek iránti igényt jelent.

-

Késleltetés és Valós Idejű Feldolgozás (Latency and Real-time Processing):

A Hadoop eredeti MapReduce modellje elsősorban kötegelt (batch) feldolgozásra optimalizált, ami azt jelenti, hogy nagy adathalmazokat dolgoz fel hosszú időintervallumok alatt. Ez a megközelítés magas késleltetéssel jár, és nem alkalmas valós idejű, interaktív lekérdezésekre vagy alacsony késleltetésű tranzakciós rendszerekre. Bár az ökoszisztémában megjelentek az olyan eszközök, mint az HBase, Spark Streaming vagy Flink, amelyek valós idejű képességeket kínálnak, a Hadoop alapvető batch-orientáltsága korlátozhatja bizonyos alkalmazásoknál való használhatóságát.

-

Biztonság (Security):

A Hadoop klaszterek biztonsága komplex feladat. A korai verziókban a biztonsági funkciók korlátozottak voltak, de az Apache Kerberos integrációjával és más kiegészítésekkel (pl. Apache Sentry, Apache Ranger) jelentősen javultak. Ennek ellenére a hitelesítés, engedélyezés, adatvédelem (titkosítás nyugalmi és mozgásban lévő adatokra) és a hálózati biztonság konfigurálása továbbra is kihívást jelenthet, és gondos tervezést igényel.

-

Kisebb Adathalmazok Ineffektivitása (Inefficiency for Small Data):

A Hadoopot hatalmas adathalmazok kezelésére tervezték. Kisebb fájlok vagy adathalmazok esetén az elosztott fájlrendszer és a feldolgozó motorok overheadje (pl. metaadat-kezelés, feladatok indítása) jelentősen csökkentheti a hatékonyságot. A MapReduce különösen rosszul teljesít sok kis fájl esetén, mivel minden fájl egy külön Map Task-ot igényel, ami sok overhead-et generál.

-

Programozási Nehézségek (Programming Challenges):

Bár a MapReduce elméleti koncepciója egyszerű, a komplex algoritmusok közvetlen MapReduce-ban való implementálása bonyolult és időigényes lehet. A fejlesztőknek folyamatosan gondolniuk kell a párhuzamosságra, az adatok elosztására és a hibakezelésre. Bár a Pig és Hive magasabb szintű absztrakciókat kínálnak, a mélyebb optimalizáláshoz és hibakereséshez továbbra is szükség van a MapReduce alapjainak ismeretére.

-

Adatminőség és Adatirányítás (Data Quality and Governance):

A Hadoop klaszterekben tárolt adatok sokfélesége és mennyisége miatt az adatminőség biztosítása és az adatirányítás (data governance) fenntartása jelentős kihívást jelent. Nincs beépített séma kényszerítés a HDFS-ben, ami rugalmasságot ad, de megnehezíti az adatok konzisztenciájának és tisztaságának fenntartását. Megfelelő folyamatokra és külső eszközökre van szükség az adatok profilozásához, tisztításához és metaadatainak kezeléséhez.

-

Teljesítmény-optimalizálás (Performance Optimization):

A Hadoop klaszterek teljesítményének optimalizálása folyamatos kihívás. Számos tényező befolyásolja a teljesítményt, például a hardverkonfiguráció, a hálózati sávszélesség, a szoftverkonfigurációk, az adatok elosztása és a feladatok ütemezése. A legjobb teljesítmény eléréséhez gyakran finomhangolásra és mélyreható ismeretekre van szükség.

Ezek a kihívások nem azt jelentik, hogy a Hadoop nem életképes megoldás, hanem azt, hogy a sikeres bevezetéshez és üzemeltetéshez alapos tervezésre, megfelelő szakértelemre és folyamatos karbantartásra van szükség. Sok vállalat számára a felhőalapú Hadoop szolgáltatások (pl. AWS EMR, Azure HDInsight) enyhítik a menedzselési komplexitás terhét.

Hadoop alkalmazási területei

A Hadoop rugalmassága, skálázhatósága és hibatűrése miatt számos iparágban és területen vált alapvető eszközzé a Big Data kezelésére. Az alábbiakban bemutatunk néhány kulcsfontosságú alkalmazási területet, ahol a Hadoop jelentős értéket teremt:

-

Webanalitika és Logelemzés:

A vállalatok, különösen az online szolgáltatók, hatalmas mennyiségű webes naplóadatot (web logs) generálnak. Ezek az adatok tartalmazzák a felhasználók viselkedését, a weboldal látogatottságát, a hibaüzeneteket és sok mást. A Hadoop segítségével ezeket a naplókat hatékonyan lehet tárolni és elemezni, hogy betekintést nyerjünk a felhasználói élménybe, optimalizáljuk a weboldal teljesítményét, vagy azonosítsuk a trendeket és anomáliákat. A Flume adatgyűjtésre, a HDFS tárolásra, a Hive vagy Spark SQL pedig elemzésre használható.

-

Pénzügyi Szektor: Csalásfelderítés és Kockázatkezelés:

A bankoknak és pénzintézeteknek hatalmas mennyiségű tranzakciós adatot kell elemezniük, hogy azonosítsák a potenciális csalásokat vagy felmérjék a kockázatokat. A Hadoop lehetővé teszi ezen adatok tárolását és komplex algoritmusokkal (pl. gépi tanulás) történő feldolgozását, hogy valós időben vagy közel valós időben felismerjék a gyanús mintákat. A kockázatkezelésben a Hadoop segíthet a nagy adathalmazokon alapuló pontosabb pénzügyi modellek építésében.

-

Egészségügy és Élettudományok:

Az egészségügyben a genomikai adatok, elektronikus egészségügyi kartonok (EHR), orvosi képek és szenzoradatok hatalmas mennyiségei keletkeznek. A Hadoop képes tárolni és feldolgozni ezeket a Big Data forrásokat, lehetővé téve a kutatók számára, hogy új gyógymódokat fedezzenek fel, személyre szabott orvoslást fejlesszenek ki, vagy javítsák a betegellátás minőségét. A genomikai adatok elemzése, ahol a fájlok mérete terabájtos nagyságrendű, különösen jól illeszkedik a HDFS képességeihez.

-

Kiskereskedelem és E-kereskedelem: Ajánlórendszerek:

A kiskereskedők és e-kereskedelmi platformok rengeteg adatot gyűjtenek az ügyfelek vásárlási szokásairól, böngészési előzményeiről és preferenciáiról. A Hadoop segítségével ezeket az adatokat elemezni lehet, hogy pontosabb ajánlórendszereket hozzunk létre, amelyek személyre szabott termékajánlatokat kínálnak, növelve ezzel az eladásokat és az ügyfél-elégedettséget. Az ügyfélviselkedés elemzése, a készletoptimalizálás és az árképzési stratégiák is profitálhatnak a Hadoop alapú analitikából.

-

Internetes Szolgáltatások: Keresőmotorok és Közösségi Média Elemzés:

A Google eredeti inspirációja is a webes adatok feldolgozásából származott. A keresőmotorok, mint a Nutch, amelyekből a Hadoop is kinőtt, a mai napig támaszkodnak elosztott rendszerekre a weboldalak indexeléséhez és a keresési eredmények generálásához. A közösségi média platformok hatalmas mennyiségű szöveges, képi és videó adatot generálnak. A Hadoop segítségével elemezhetők a felhasználói posztok, trendek, hangulatelemzések végezhetők, és célzott hirdetések jeleníthetők meg.

-

IoT (Internet of Things): Szenzoradatok Feldolgozása:

Az IoT eszközök (okosotthonok, ipari szenzorok, okosautók) folyamatosan hatalmas mennyiségű idősoros adatot generálnak. A Hadoop klaszterek ideálisak ezeknek az adatoknak a tárolására és valós idejű vagy batch feldolgozására. Az elemzések segíthetnek a prediktív karbantartásban, az energiafelhasználás optimalizálásában vagy az okos városok fejlesztésében.

-

Tudományos Kutatás és Fejlesztés:

A tudományos területeken (pl. asztrofizika, klímakutatás, fizika) gyakran keletkeznek gigantikus adathalmazok szimulációkból, kísérletekből vagy megfigyelésekből. A Hadoop lehetővé teszi ezeknek az adatoknak a tárolását és komplex elemzését, felgyorsítva a kutatási folyamatokat és új felfedezésekhez vezetve.

Ez a lista csak ízelítő a Hadoop széleskörű alkalmazási lehetőségeiből. Szinte minden iparágban, ahol hatalmas adatmennyiségek keletkeznek, és ahol az adatokból értékes betekintéseket szeretnének nyerni, a Hadoop vagy az ökoszisztémájának elemei kulcsszerepet játszhatnak.

A Hadoop jövője és a Big Data trendek

A Hadoop, mint a Big Data forradalom úttörője, jelentős utat járt be az elmúlt években. Bár a technológiai tájkép folyamatosan változik, és újabb eszközök jelennek meg, a Hadoop alapvető koncepciói és komponensei továbbra is relevánsak maradnak, sőt, beépülnek az új trendekbe. A Hadoop jövője szorosan összefonódik a szélesebb Big Data és felhőalapú technológiák fejlődésével.

A Hadoop szerepe a modern Big Data ökoszisztémában

A Hadoop már nem kizárólag a MapReduce motorra fókuszál. A YARN bevezetésével a Hadoop egy általános célú erőforrás-kezelő és elosztott tároló platformmá vált, amelyen számos más feldolgozó motor és alkalmazás futhat. Ez azt jelenti, hogy a HDFS továbbra is az egyik legfontosabb, megbízható, skálázható és költséghatékony tárolási réteg a Big Data számára, még akkor is, ha a feldolgozást már nem feltétlenül MapReduce, hanem például Apache Spark, Apache Flink vagy más rendszerek végzik.

A Hadoop ökoszisztéma folyamatosan fejlődik, új projektekkel gazdagodik, amelyek specializáltabb feladatokra kínálnak megoldást. Ez a diverzifikáció biztosítja, hogy a Hadoop továbbra is releváns maradjon a legkülönfélébb Big Data kihívásokra.

Felhőalapú Big Data szolgáltatások

Az egyik legnagyobb trend, amely befolyásolja a Hadoop jövőjét, a felhőalapú Big Data szolgáltatások térnyerése. Az olyan felhőszolgáltatók, mint az Amazon Web Services (AWS EMR), a Microsoft Azure (Azure HDInsight) és a Google Cloud (Google Cloud Dataproc), menedzselt Hadoop klasztereket kínálnak. Ezek a szolgáltatások jelentősen leegyszerűsítik a Hadoop klaszterek telepítését, konfigurálását, skálázását és karbantartását, csökkentve az üzemeltetési terheket és a komplexitást. Ez lehetővé teszi a vállalatok számára, hogy a Big Data infrastruktúra menedzselése helyett az adatok elemzésére és az üzleti érték kinyerésére koncentráljanak. A felhőalapú megoldások rugalmassága és a „pay-as-you-go” modell különösen vonzóvá teszi őket a dinamikusan változó igényekkel rendelkező szervezetek számára.

Konténerizáció és Kubernetes

A konténerizációs technológiák, mint a Docker és az orchestrációs platformok, mint a Kubernetes, egyre inkább áthatják az elosztott rendszerek világát. A Hadoop komponensek konténerizálása és Kubernetesen való futtatása további rugalmasságot, hordozhatóságot és erőforrás-kihasználtságot kínálhat. Bár a Hadoopot hagyományosan „bare metal” vagy virtuális gépeken futtatják, a konténerizáció felé való elmozdulás lehetővé teheti a klaszterek még dinamikusabb skálázását és a különböző munkaterhelések hatékonyabb elkülönítését.

Mesterséges Intelligencia (AI) és Gépi Tanulás (ML) integrációja

A Big Data és az AI/ML szorosan összefonódik. A gépi tanulási modellek betanításához hatalmas mennyiségű adatra van szükség, amelyet a Hadoop klaszterek képesek tárolni és előfeldolgozni. Az olyan eszközök, mint az Apache Spark MLlib, közvetlenül a Hadoop klasztereken futnak, lehetővé téve a Big Data adathalmazokon alapuló gépi tanulási modellek fejlesztését és futtatását. A jövőben a Hadoop még szorosabban integrálódik az AI/ML platformokkal, támogatva a komplexebb modelleket és az automatizált adatfeldolgozási pipeline-okat.

Streaming adatok növekvő fontossága

Míg a Hadoop eredetileg batch feldolgozásra készült, a valós idejű adatok (streaming data) feldolgozásának igénye folyamatosan növekszik. Az olyan komponensek, mint az Apache Kafka (streaming adatok gyűjtésére), az Apache Spark Streaming és az Apache Flink (streaming adatok feldolgozására), a Hadoop ökoszisztéma szerves részévé váltak. A jövőben még nagyobb hangsúlyt kap a valós idejű analitika és a streaming adatokon alapuló döntéshozatal, ahol a Hadoop továbbra is a háttérben biztosíthatja a megbízható tárolást és a batch feldolgozási képességeket.

Adat tó (Data Lake) koncepció

A Data Lake koncepciója egyre népszerűbbé válik, amely szerint a nyers, strukturálatlan, félig strukturált és strukturált adatokat egy központi, skálázható tárolóban gyűjtik össze, anélkül, hogy előzetes sémát kényszerítenének. A HDFS gyakran képezi egy Data Lake alapját, mivel rendkívül alkalmas a nyers adatok tárolására. Ez a megközelítés nagy rugalmasságot biztosít az adatok későbbi elemzéséhez és különböző célokra történő felhasználásához.

Összességében a Hadoop továbbra is kulcsszerepet játszik a Big Data világában, de szerepe változik. A hangsúly egyre inkább a Hadoop mint egy rugalmas és megbízható alapinfrastruktúra használatára helyeződik át, amelyre más, specializáltabb feldolgozó motorok és szolgáltatások épülhetnek. A felhőalapú szolgáltatások, a konténerizáció és az AI/ML integrációja tovább formálja a Hadoop jövőjét, biztosítva annak relevanciáját a digitális korszakban.

Hogyan kezdjünk hozzá a Hadoophoz?

A Hadoop világába való belépés izgalmas és hasznos lehet, tekintettel a Big Data iránti folyamatosan növekvő igényre a munkaerőpiacon. Íme néhány lépés, hogyan kezdhetünk hozzá a Hadoop tanulásához és használatához:

-

Alapok elsajátítása:

Kezdjük a Big Data alapfogalmainak megértésével, a Hadoop architektúrájával (HDFS, YARN, MapReduce). Számos ingyenes online kurzus, tutorial és könyv áll rendelkezésre, amelyek részletesen bemutatják ezeket a koncepciókat.

-

Környezet beállítása:

- Single-Node Cluster: Kezdésnek a legegyszerűbb egy „single-node” Hadoop klaszter beállítása egy virtuális gépen (pl. VirtualBox vagy VMware) vagy akár a helyi gépen. Ez lehetővé teszi az alapvető parancsok és a HDFS interakciók gyakorlását anélkül, hogy egy teljes elosztott klasztert kellene menedzselni.

- Felhőalapú szolgáltatások: A felhőalapú Big Data szolgáltatások (pl. AWS EMR, Azure HDInsight, Google Cloud Dataproc) kiváló lehetőséget kínálnak a Hadoop és az ökoszisztéma eszközeinek kipróbálására minimális konfigurációs terheléssel. Ezek a platformok gyorsan indítható klasztereket biztosítanak, és fizetős, de költséghatékony módon skálázhatók. Sok szolgáltató ingyenes próbaverziót vagy kreditet kínál az új felhasználóknak.

- Docker: A Docker konténerek használata is egyre népszerűbb módja a Hadoop komponensek helyi futtatásának, mivel izolált és könnyen reprodukálható környezetet biztosítanak.

-

Gyakorlati tapasztalat:

A legjobb módja a tanulásnak a gyakorlás. Kezdjünk egyszerű MapReduce feladatokkal (pl. WordCount), majd térjünk át a HiveQL lekérdezésekre, Pig szkriptekre, és végül az Apache Spark alkalmazásokra. Használjunk nyilvánosan elérhető adathalmazokat (pl. Kaggle) a gyakorláshoz.

-

Főbb ökoszisztéma komponensek megismerése:

A HDFS és YARN mellett fontos megismerkedni az olyan kulcsfontosságú eszközökkel, mint az Apache Spark (a legnépszerűbb feldolgozó motor), az Apache Hive (SQL-szerű lekérdezésekhez), az Apache HBase (NoSQL adatbázis) és az Apache Kafka (streaming adatokhoz). Ezek az eszközök adják a Hadoop ökoszisztéma erejét.

-

Közösség és dokumentáció:

Használjuk ki az Apache Hadoop projekt kiváló dokumentációját és a hatalmas online közösség erejét. Fórumok, Stack Overflow, blogok és online közösségek rengeteg segítséget nyújthatnak a felmerülő kérdésekre.

-

Tanúsítványok és továbbképzés:

Számos cég (pl. Cloudera, Hortonworks – ma már Cloudera része) kínál hivatalos tanúsítványokat, amelyek igazolják a Hadoop ismereteket. Ezek a tanúsítványok segíthetnek a karrierépítésben.

A Hadoop egy robusztus és folyamatosan fejlődő technológia, amely a Big Data világának alapját képezi. A vele való ismerkedés befektetés a jövőbe, hiszen az adatok elemzésének képessége ma már elengedhetetlen a legtöbb iparágban.