A modern számítástechnika egyik legforradalmibb ága a GPGPU, azaz a General-Purpose computing on Graphics Processing Units, magyarul a videokártyák általános célú felhasználása. Ez a technológia alapjaiban változtatta meg a nagy teljesítményű számítástechnikáról alkotott képünket, áthidalva a hagyományos CPU-alapú architektúrák korlátait a párhuzamosan feldolgozható feladatok terén. Ami egykor kizárólag a képernyőn megjelenő pixelek renderelésére specializálódott hardver volt, az mára a mesterséges intelligencia, a tudományos szimulációk és az adatelemzés gerincét képezi, hihetetlen sebességnövekedést és hatékonyságot biztosítva a legösszetettebb számítási kihívások megoldásához.

A GPGPU paradigmaváltása nem csupán technológiai bravúr, hanem egy új korszak nyitánya is, ahol a videokártyák hatalmas számítási ereje nem korlátozódik a vizuális élmény fokozására, hanem a legkülönfélébb tudományágakban és iparágakban válik nélkülözhetetlenné. Ez a cikk részletesen bemutatja a GPGPU fogalmát, működési elvét, a mögötte álló technológiákat, valamint a számos alkalmazási területét, amelyek formálják a jövőnket.

A GPGPU fogalma és történelmi háttere

A GPGPU lényegében azt jelenti, hogy a grafikus feldolgozó egységet (GPU) nem csak grafikák renderelésére, hanem szélesebb körű, általános célú számítási feladatokra is használjuk. A GPU-k eredeti célja a 3D grafika gyorsítása volt, ami magában foglalta a geometriai transzformációkat, a megvilágítási számításokat és a pixelek színezését. Ezek a feladatok rendkívül párhuzamosíthatók: sok kis, független számítást kell elvégezni egyszerre, például minden pixel színének meghatározásakor vagy minden csúcs pozíciójának kiszámításakor.

A GPU-k fejlődésének korai szakaszában a hardver fix funkciójú egységekből állt, amelyek csak előre meghatározott grafikai műveleteket tudtak végrehajtani. A 2000-es évek elején azonban megjelentek a programozható shaderek. Ezek lehetővé tették a fejlesztők számára, hogy egyedi programokat (shadereket) írjanak, amelyek futnak a GPU-n, és befolyásolják a pixelek vagy a csúcsok tulajdonságait. Ez volt az első lépés az általános célú programozhatóság felé, mivel a shaderek már nem csak grafikai, hanem tetszőleges matematikai műveleteket is végezhettek.

A programozható shaderek forradalmasították a grafikus feldolgozást, és megnyitották az utat a GPU-k általános célú felhasználása előtt, bebizonyítva, hogy a párhuzamos architektúra sokkal többre képes, mint pusztán pixelek mozgatása.

Az igazi áttörést a 2000-es évek közepén hozta el az NVIDIA CUDA (Compute Unified Device Architecture) platformjának megjelenése 2006-ban. A CUDA egy olyan programozási modell és szoftvereszköz-készlet, amely lehetővé tette a fejlesztők számára, hogy C, C++ vagy Fortran nyelven írt programjaikat futtassák az NVIDIA GPU-kon, kihasználva azok masszív párhuzamos architektúráját. Ezzel a lépéssel a GPU-k nemcsak grafikai gyorsítókká, hanem erőteljes párhuzamos számítási processzorokká váltak, amelyek képesek voltak a CPU-nál nagyságrendekkel gyorsabban elvégezni bizonyos típusú feladatokat.

Ezt követően más gyártók és szervezetek is felismerék a GPGPU potenciálját. Az OpenCL (Open Computing Language) egy nyílt szabványú alternatívaként jelent meg, amely platformfüggetlen módon tette lehetővé a heterogén rendszereken – beleértve a CPU-kat, GPU-kat és más processzorokat – történő párhuzamos programozást. Az AMD a saját ROCm (Radeon Open Compute) platformjával lépett be a piacra, amely szintén nyílt forráskódú megközelítést alkalmazva igyekszik kihasználni a Radeon GPU-k számítási erejét általános célú feladatokra.

A CPU és a GPU közötti alapvető különbségek

Ahhoz, hogy megértsük a GPGPU erejét, elengedhetetlen különbséget tenni a CPU (Central Processing Unit) és a GPU (Graphics Processing Unit) közötti alapvető architekturális és működési eltérésekben. Bár mindkettő processzor, felépítésük és optimalizálásuk gyökeresen eltérő feladatokra készült.

Architektúra: soros vs. párhuzamos feldolgozás

A CPU-t a soros feldolgozásra optimalizálták. Ez azt jelenti, hogy viszonylag kevés, de rendkívül erős és sokoldalú magot tartalmaz, amelyek képesek komplex feladatok gyors és rugalmas végrehajtására. Egy CPU mag kiválóan alkalmas az egymástól függő utasítások sorozatának kezelésére, mint amilyen például egy operációs rendszer futtatása, egy adatbázis lekérdezése vagy egy szövegszerkesztő program működtetése. Ezek a magok nagy gyorsítótárral (cache) és komplex vezérlési logikával rendelkeznek, hogy minimalizálják az utasítások közötti késleltetést.

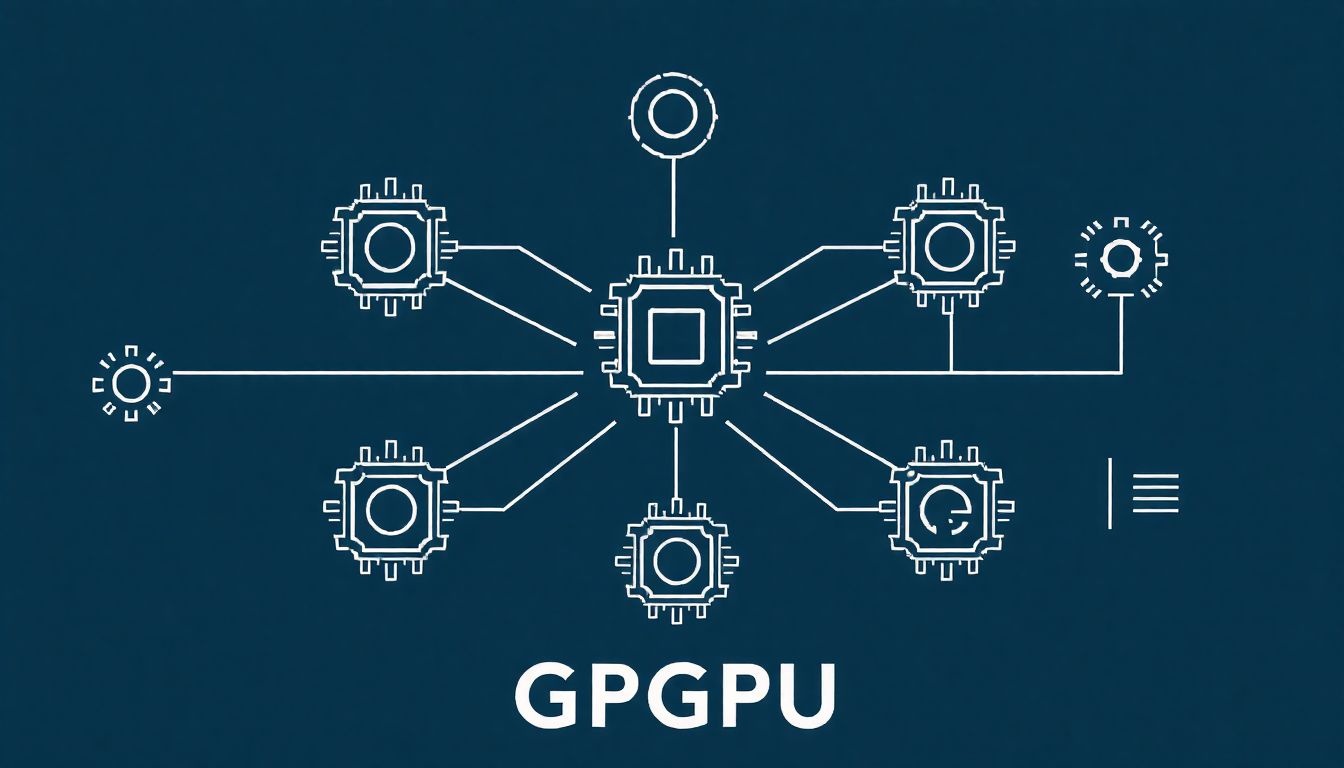

Ezzel szemben a GPU-t a masszív párhuzamos feldolgozásra tervezték. Sok ezer, viszonylag egyszerűbb magot tartalmaz, amelyek egyszerre, függetlenül képesek ugyanazt az utasítást végrehajtani különböző adatokon (SIMD – Single Instruction, Multiple Data elv). Gondoljunk csak a grafikus renderelésre: minden egyes pixel színét nagyrészt függetlenül számíthatjuk ki a többitől. Ez a „sok kicsi, de egyforma” feladat elvégzésére optimalizált architektúra teszi a GPU-t rendkívül hatékonnyá az olyan számításoknál, ahol nagy mennyiségű adatot kell azonos műveletekkel feldolgozni.

Magok száma és típusa

Egy tipikus modern CPU általában 4-től 64-ig terjedő számú maggal rendelkezik, amelyek mindegyike önállóan képes komplex utasításkészleteket végrehajtani. Ezek a magok rendkívül gyorsak és rugalmasak, képesek elágazásokat, feltételes utasításokat és különböző típusú adatok kezelésére. A CPU-magok „okosabbak” és önállóbbak, mint a GPU magjai.

A GPU-k ezzel szemben több száz, sőt több ezer úgynevezett stream processzort vagy CUDA magot (NVIDIA terminológiában) tartalmaznak. Ezek a magok egyszerűbbek, kevesebb vezérlési logikával és kisebb gyorsítótárral rendelkeznek, de hatalmas mennyiségben vannak jelen. A GPU ereje nem az egyes magok komplexitásából, hanem azok óriási számából és a párhuzamos munkavégzés képességéből fakad. Az újabb generációs GPU-k már speciális magokat is tartalmaznak, mint például az NVIDIA Tensor magok a mesterséges intelligencia műveletek gyorsítására, vagy az RT magok a sugárkövetéshez.

Memória hozzáférés és sávszélesség

A CPU-k memóriahozzáférése optimalizálva van az alacsony késleltetésre (low latency), mivel a soros feldolgozás során gyakran van szükség egyedi adatelemek gyors elérésére. A CPU-k tipikusan kisebb, de rendkívül gyors L1, L2 és L3 gyorsítótárakkal rendelkeznek, és a rendszermemóriához (RAM) való hozzáférés is a lehető leggyorsabb. A memória sávszélessége fontos, de nem olyan kritikus, mint a GPU esetében.

A GPU-k számára a memória sávszélesség az egyik legfontosabb teljesítményfaktor. Mivel egyszerre hatalmas mennyiségű adatot dolgoznak fel, folyamatosan szükségük van az adatok gyors be- és kiáramlására. Ezért a GPU-k saját, dedikált, rendkívül gyors memóriával (VRAM, pl. GDDR6, HBM) rendelkeznek, amely sokkal nagyobb sávszélességet biztosít, mint a CPU rendszermemóriája. A késleltetés kevésbé kritikus, mivel a GPU képes elrejteni azt azáltal, hogy rengeteg párhuzamos feladatot futtat, és ha az egyik várakozik, a másik azonnal elkezdheti a munkát.

Alkalmasság különböző feladatokra

A CPU kiválóan alkalmas olyan feladatokra, amelyek:

- Soros végrehajtást igényelnek.

- Komplex vezérlési logikát, elágazásokat tartalmaznak.

- Alacsony késleltetésű memória hozzáférést igényelnek.

- Kevés, de komplex adatelemet dolgoznak fel.

- Példák: operációs rendszerek, adatbázisok, webböngészők, szövegszerkesztők.

A GPU pedig az alábbi feladatokban jeleskedik:

- Masszív párhuzamosíthatóságot mutatnak.

- Ugyanazt az utasítást kell végrehajtani sok különböző adaton.

- Nagy memória sávszélességet igényelnek.

- Példák: grafikus renderelés, mesterséges intelligencia, tudományos szimulációk, kriptovaluta bányászat, videófeldolgozás.

Az alábbi táblázat összefoglalja a főbb különbségeket:

| Jellemző | CPU (Central Processing Unit) | GPU (Graphics Processing Unit) |

|---|---|---|

| Magok száma | Néhány (4-64), komplex magok | Sok (több száz/ezer), egyszerűbb magok (stream processzorok) |

| Feldolgozási elv | Soros, komplex feladatok, alacsony késleltetés | Párhuzamos, egyszerűbb feladatok, nagy átviteli sebesség |

| Memória | Rendszermemória (RAM), gyorsítótárak (L1, L2, L3) | Dedikált VRAM (GDDR, HBM), rendkívül nagy sávszélesség |

| Optimalizáció | Egyedi feladatok gyors végrehajtása | Masszív adathalmazok párhuzamos feldolgozása |

| Alkalmazási terület | Operációs rendszerek, általános alkalmazások, adatbázisok | Grafika, AI/ML, tudományos szimulációk, kriptovaluta bányászat |

Ez a komplementer jelleg magyarázza, miért működnek együtt olyan hatékonyan egy modern számítógépben. A CPU kezeli az általános feladatokat és a vezérlést, míg a GPU-ra bízza a masszívan párhuzamosítható, számításigényes részeket. Ez a heterogén számítástechnika alapja, amelyben a GPGPU kulcsszerepet játszik.

Hogyan működik a GPGPU? A párhuzamos feldolgozás elmélete

A GPGPU alapvető működési elve a párhuzamos feldolgozás maximális kihasználása. Ez azt jelenti, hogy ahelyett, hogy egyetlen, komplex feladatot lépésről lépésre oldanánk meg, sok kisebb, független feladatot hajtunk végre egyszerre. Ez a megközelítés bizonyos típusú problémák esetén drámai sebességnövekedést eredményez.

SIMD (Single Instruction, Multiple Data) elv

A GPGPU működésének kulcsa a SIMD (Single Instruction, Multiple Data) elv, azaz egyetlen utasítás, több adat. Ahelyett, hogy a processzor minden egyes adaton külön-külön hajtaná végre ugyanazt az utasítást, a SIMD architektúra lehetővé teszi, hogy egyetlen utasítás több adatelemen is végrehajtódjon egyidejűleg. Képzeljünk el egy gyári futószalagot, ahol minden munkás ugyanazt a műveletet végzi el egy-egy különálló termékdarabon, de mindannyian egyszerre dolgoznak. A GPU-k több ezer ilyen „munkást” (stream processzort) tartalmaznak.

Amikor egy GPGPU program fut, a CPU előkészíti az adatokat, majd elküldi azokat a GPU-nak. A GPU ezután a programozott „kernel” (a GPU-n futó függvény) segítségével párhuzamosan dolgozza fel ezeket az adatokat. Minden stream processzor ugyanazt a kernelt futtatja, de más-más bemeneti adatokkal. Ez a megközelítés rendkívül hatékony az olyan feladatoknál, mint a mátrixszorzás, képfeldolgozás (ahol minden pixelre azonos transzformációt alkalmazunk), vagy a neurális hálózatok számításai.

A stream processzorok szerepe

A stream processzorok a GPU alapvető számítási egységei. Az NVIDIA esetében ezeket CUDA magoknak nevezik, az AMD-nél pedig stream processzoroknak. Ezek a magok viszonylag egyszerűek, és elsősorban lebegőpontos aritmetikai műveletek (összeadás, szorzás) végrehajtására optimalizáltak. Egy modern GPU több ezer ilyen magot tartalmaz, csoportokba rendezve (ún. Streaming Multiprocessors – SM az NVIDIA-nál, Compute Units – CU az AMD-nél).

Amikor egy GPGPU program fut, a feladatot sok kis, független szálra bontják. Ezeket a szálakat a stream processzorok hajtják végre. A GPU ütemezője gondoskodik arról, hogy a magok mindig elfoglaltak legyenek, átkapcsolva a futó szálak között, ha az egyiknek adatra kell várnia. Ez a szálak közötti kontextusváltás rendkívül gyorsan történik, ami lehetővé teszi, hogy a GPU elrejtse a memória késleltetését, és folyamatosan kihasználja a hatalmas számítási kapacitását.

A GPGPU nem csupán gyorsabb számítást jelent, hanem egy alapvető paradigmaváltást is: a szekvenciális gondolkodásmódról a masszív párhuzamositás felé, ahol az adatok áramlása és az egyidejű műveletek kulcsfontosságúak.

A memóriahierarchia

A GPU memóriahierarchiája eltér a CPU-étól, és optimalizálva van a nagy sávszélességű, párhuzamos adathozzáférésre.

- Globális memória (Global Memory): Ez a GPU dedikált VRAM-ja (pl. GDDR6, HBM), amely a legnagyobb kapacitással rendelkezik és a leglassabb hozzáférést biztosítja a GPU-n belül. Ezt használják a nagy adathalmazok tárolására, amelyekkel a kernel dolgozik. Rendkívül nagy sávszélességgel rendelkezik.

- Megosztott memória (Shared Memory): Ez egy kisebb, de rendkívül gyors, alacsony késleltetésű memória, amely egy adott stream multiprocesszoron belül oszlik meg a futó szálak között. Kiválóan alkalmas az adatok újrafelhasználására és a szálak közötti kommunikációra egy blokkon belül.

- Regiszterek (Registers): A leggyorsabb memória, amelyet az egyes szálak kizárólagosan használnak a lokális változók tárolására.

- Konstans memória (Constant Memory) és Textúra memória (Texture Memory): Speciális, csak olvasható gyorsítótárak, amelyek a gyakran használt, statikus adatok (konstansok) vagy a textúraadatok hatékony elérésére szolgálnak.

Ez a rétegzett memóriahierarchia lehetővé teszi a fejlesztők számára, hogy optimalizálják a programjaikat az adathozzáférés minimalizálása és a magok maximális kihasználása érdekében.

Adatátvitel a CPU és GPU között

A GPGPU programok tipikusan úgy működnek, hogy a CPU (host) inicializálja a folyamatot, előkészíti az adatokat a rendszermemóriában, majd átmásolja azokat a GPU (device) memóriájába. Ez az adatátvitel általában a PCI Express (PCIe) buszon keresztül történik, ami egy viszonylag lassú művelet a GPU belső memóriájához képest. Ezért kritikus fontosságú, hogy minimalizáljuk az adatátvitelek számát és méretét a CPU és GPU között. Amint az adatok a GPU memóriájába kerültek, a GPU elvégzi a számításokat, majd az eredményeket vissza másolja a CPU memóriájába. A hatékony GPGPU programozás egyik fő kihívása ennek az adatátviteli szűk keresztmetszetnek a kezelése.

Főbb GPGPU programozási modellek és API-k

A GPGPU-k programozása speciális API-kat és programozási modelleket igényel, amelyek lehetővé teszik a fejlesztők számára, hogy kihasználják a párhuzamos architektúrát. A legfontosabbak a CUDA, az OpenCL és a ROCm.

CUDA: Az NVIDIA dominanciája

Az NVIDIA CUDA (Compute Unified Device Architecture) platformja volt az első széles körben elterjedt és sikeres GPGPU programozási modell. 2006-os bevezetése óta a CUDA az NVIDIA GPU-k általános célú programozásának de facto szabványává vált, különösen a tudományos kutatás, a mesterséges intelligencia és a nagy teljesítményű számítástechnika területén.

Története és jellemzői

A CUDA lehetővé teszi a fejlesztők számára, hogy C, C++, Fortran, és Python nyelveken írt kódokat futtassanak az NVIDIA GPU-kon. A platform egy speciális fordítót (NVCC) és egy futtatókörnyezetet biztosít, amelyek elrejtik a GPU hardverének komplexitását, miközben hozzáférést biztosítanak a párhuzamos feldolgozási képességeihez. A CUDA programozási modellje a „kernel” koncepcióra épül, amely egy olyan függvény, amelyet párhuzamosan hajt végre a GPU sok ezer szála.

A CUDA programozás alapvető egységei:

- Szál (Thread): A legkisebb végrehajtási egység, amely egyetlen adatponton dolgozik.

- Szálblokk (Thread Block): A szálak egy csoportja, amelyek együttműködhetnek egymással a megosztott memórián keresztül. Egy blokkon belüli szálak szinkronizálhatók.

- Rács (Grid): A szálblokkok gyűjteménye, amelyek önállóan működnek.

Ez a hierarchikus struktúra rendkívül rugalmasan kezeli a párhuzamos feladatokat, lehetővé téve a fejlesztők számára, hogy a problémákat a GPU architektúrájához igazítsák.

Ecosystem: Könyvtárak és fejlesztői eszközök

A CUDA sikeréhez nagyban hozzájárul az NVIDIA által kiépített gazdag ökoszisztéma. Ez magában foglalja a számos optimalizált könyvtárat, amelyek komplex számítási feladatokat gyorsítanak fel:

- cuBLAS: Lineáris algebrai műveletek (Basic Linear Algebra Subprograms) gyorsítására.

- cuFFT: Gyors Fourier transzformációkhoz.

- cuDNN: Mély neurális hálózatok (Deep Neural Networks) gyorsítására, elengedhetetlen a modern AI-ban.

- Thrust: Párhuzamos algoritmusok C++ STL-szerű implementációja.

- TensorRT: AI modell inferencia gyorsítására.

Ezenkívül az NVIDIA számos fejlesztői eszközt (profilozók, hibakeresők) és SDK-t (Software Development Kit) biztosít, amelyek megkönnyítik a CUDA programok fejlesztését és optimalizálását.

OpenCL: A nyílt szabvány

Az OpenCL (Open Computing Language) egy nyílt, royalty-free szabvány a heterogén rendszerek párhuzamos programozására, amelyet a Khronos Group fejlesztett ki. Célja, hogy platformfüggetlen alternatívát nyújtson a gyártóspecifikus megoldásokkal szemben, lehetővé téve a fejlesztők számára, hogy egyetlen kódbázissal célozzanak meg különböző hardvereket (CPU, GPU, FPGA, DSP).

Platformfüggetlenség

Az OpenCL legnagyobb előnye a platformfüggetlenség. Míg a CUDA kizárólag NVIDIA GPU-kon fut, az OpenCL-t támogató hardverek széles skáláján használható, beleértve az AMD GPU-kat, Intel integrált GPU-kat és CPU-kat, valamint más gyártók gyorsítóit. Ez rugalmasságot biztosít a fejlesztőknek, és elkerüli a gyártóhoz való kötöttséget.

Előnyök és hátrányok a CUDA-val szemben

Előnyök:

- Hordozhatóság: Ugyanaz a kód futtatható különböző gyártók hardverein.

- Nyílt szabvány: Nem kötődik egyetlen gyártóhoz sem, ami hosszú távon stabilitást és közösségi támogatást jelenthet.

- Szélesebb hardvertámogatás: CPU-kon és más gyorsítókon is futtatható.

Hátrányok:

- Komplexitás: Az OpenCL programozás általában bonyolultabbnak bizonyul, mint a CUDA, mivel a platformfüggetlenség érdekében alacsonyabb szintű absztrakciót kínál.

- Teljesítmény: Előfordulhat, hogy az OpenCL programok nem érik el ugyanazt a teljesítményt, mint az optimalizált CUDA programok az NVIDIA hardverén, mivel hiányzik a hardver-specifikus optimalizálás.

- Ökoszisztéma: Bár az OpenCL ökoszisztéma növekszik, még mindig nem olyan gazdag és kiforrott, mint a CUDA, különösen a mélytanulási könyvtárak terén.

ROCm: Az AMD válasza

Az AMD ROCm (Radeon Open Compute) platformja az AMD válasza az NVIDIA CUDA-ra. A ROCm egy nyílt forráskódú szoftverplatform, amely lehetővé teszi a fejlesztők számára, hogy az AMD Radeon GPU-k számítási erejét kihasználják HPC (High Performance Computing) és AI (Artificial Intelligence) alkalmazásokhoz.

Nyílt forráskódú megközelítés

A ROCm alapvető filozófiája a nyílt forráskód és a nyílt szabványok támogatása. Támogatja az OpenCL-t, de saját, magasabb szintű programozási nyelvet, a HIP-et (Heterogeneous-compute Interface for Portability) is kínálja. A HIP lényegében egy olyan C++ dialektus, amely lehetővé teszi a CUDA kódok egyszerű átalakítását ROCm-kompatibilis kódokká, ezzel megkönnyítve az átállást az NVIDIA platformról az AMD-re.

A ROCm ökoszisztéma is folyamatosan fejlődik, optimalizált könyvtárakat (pl. ROCm MIOpen a mélytanuláshoz, ROCm hipBLAS a lineáris algebrához) és fejlesztői eszközöket kínál. Az AMD erősen fókuszál a HPC és az adatközponti piacra a ROCm-mel, pozicionálva magát mint nyílt alternatívát a zárt CUDA ökoszisztémával szemben.

Egyéb GPGPU API-k

A CUDA, OpenCL és ROCm mellett léteznek más API-k is, amelyek bizonyos mértékig lehetővé teszik a GPGPU számításokat:

- DirectCompute: A Microsoft DirectX API része, amely Windows platformon biztosít GPGPU képességeket. Elsősorban játékfejlesztők és grafikus alkalmazások számára releváns.

- Vulkan Compute: A Vulkan grafikus API részeként szintén kínál számítási shadereket, amelyek hatékony GPGPU műveleteket tesznek lehetővé, különösen alacsony szintű hardverkontroll mellett.

Ezek az API-k általában specifikusabb felhasználási esetekre optimalizáltak, és nem rendelkeznek olyan széleskörű ökoszisztémával, mint a CUDA vagy az OpenCL.

A GPGPU alkalmazási területei

A GPGPU technológia széleskörűen elterjedt, és számos iparágban és tudományágban forradalmasította a számítási feladatok megközelítését. A GPU-k párhuzamos feldolgozási képességei olyan területeken hoztak áttörést, ahol hatalmas mennyiségű adatot kell gyorsan és hatékonyan feldolgozni.

Mesterséges intelligencia és gépi tanulás

A mesterséges intelligencia (AI) és különösen a gépi tanulás (Machine Learning – ML), azon belül is a mélytanulás (Deep Learning – DL) a GPGPU technológia egyik legfontosabb és legdinamikusabban fejlődő alkalmazási területe. A neurális hálózatok tréningje során hatalmas mátrixszorzásokat és egyéb lineáris algebrai műveleteket kell elvégezni, méghozzá iteratívan, sok millió, vagy akár milliárd paraméterrel.

A CPU-k soros architektúrája rendkívül lassúvá tenné ezeket a számításokat, míg a GPU-k masszív párhuzamossága ideális erre a feladatra. A Tensor magok, amelyeket az NVIDIA az újabb generációs GPU-kba épít be, kifejezetten a mátrixműveletek és a vegyes precíziós számítások (pl. FP16, INT8) gyorsítására szolgálnak, ami tovább gyorsítja a mélytanulási modellek tréningjét és inferenciáját.

Alkalmazási területek az AI-ban:

- Kép- és beszédfelismerés: A mély neurális hálózatok (CNN-ek és RNN-ek) tréningje, amelyek alapját képezik az arcazonosításnak, az orvosi képalkotás elemzésének és a hangasszisztenseknek.

- Természetes nyelvi feldolgozás (NLP): Nyelvi modellek (pl. Transformer alapú modellek, mint a GPT-3) tréningje, amelyek szövegfordításra, szöveggenerálásra és hangulatelemzésre képesek.

- Autonóm járművek: A szenzoradatok (kamera, lidar, radar) valós idejű feldolgozása a környezet megértéséhez és a döntéshozatalhoz.

- Ajánlórendszerek: Óriási adathalmazok elemzése a felhasználói preferenciák előrejelzéséhez.

Nagy teljesítményű számítástechnika (HPC)

A HPC (High Performance Computing), azaz a nagy teljesítményű számítástechnika területe szintén jelentős mértékben profitál a GPGPU-ból. A szuperszámítógépek ma már gyakran GPU-gyorsítókat is tartalmaznak, amelyek drámai módon megnövelik a számítási kapacitást a tudományos kutatás és mérnöki alkalmazások számára.

Példák a HPC-ben:

- Tudományos szimulációk:

- Fizika: Részecskefizika, kvantummechanika, asztrofizika (galaxisok szimulációja).

- Kémia: Molekuláris dinamika, anyagtudományi szimulációk.

- Biológia: Fehérjehajtogatás, gyógyszerkutatás, genomikai szekvenálás.

- Időjárás-előrejelzés és klímamodellezés: Komplex légköri és óceáni modellek futtatása a pontosabb előrejelzésekhez.

- Olaj- és gázipari kutatás: Szeizmikus adatok feldolgozása a föld alatti rétegek feltérképezéséhez.

- Pénzügyi modellezés: Kockázatelemzés, opciók árazása, Monte Carlo szimulációk.

Adatfeldolgozás és analitika

A Big Data korszakában az adatok feldolgozása és elemzése kulcsfontosságúvá vált. A GPU-k párhuzamos képességei kiválóan alkalmasak nagy adathalmazok gyors szűrésére, rendezésére, aggregálására és transzformálására.

Alkalmazási területek:

- Adatbázis gyorsítás: Bizonyos adatbázis-műveletek (pl. oszlop alapú lekérdezések) jelentősen gyorsíthatók GPU-val.

- Pénzügyi adatelemzés: Valós idejű piaci adatok elemzése, algoritmusos kereskedés.

- Kép- és videófeldolgozás: Nagy felbontású videók transzkódolása, effektek alkalmazása, orvosi képalkotás elemzése (pl. CT, MRI).

- Adatvizualizáció: Komplex adathalmazok interaktív vizualizációja, ahol a GPU gyors renderelési képességei kihasználhatók.

Kriptovaluták bányászata

A kriptovaluták bányászata, különösen a Bitcoin és az Ethereum korai időszakában, a GPGPU technológia egyik legismertebb (és néha vitatott) alkalmazása volt. A bányászat lényege, hogy a bányászok komplex kriptográfiai feladatokat oldanak meg (ún. „proof-of-work”), hogy új blokkokat adjanak a blokklánchoz, és jutalmat kapjanak érte.

Ezek a feladatok rendkívül számításigényesek és párhuzamosíthatók: sok hash-számítást kell elvégezni egymás után, amíg meg nem találják a megfelelő megoldást. A GPU-k masszív párhuzamossága sokkal hatékonyabbá tette a bányászatot, mint a CPU-k. Ez az alkalmazás nagyban hozzájárult a GPU-k iránti kereslet növekedéséhez és az árak emelkedéséhez a fogyasztói piacon.

Az Ethereum átállása a „proof-of-stake” mechanizmusra és más kriptovaluták bányászatának változásai azonban csökkentették a GPU-k szerepét ezen a területen, de a GPGPU képességei továbbra is alapvetőek maradnak a bányászatban, ahol még releváns.

Professzionális grafikai tervezés és renderelés

Bár a GPGPU eredetileg grafikai célokra készült, az általános célú felhasználás új szintre emelte a professzionális grafikai tervezést és renderelést. A modern renderelő motorok (pl. OctaneRender, V-Ray GPU, Blender Cycles) kihasználják a GPU-k számítási erejét a fotorealisztikus képek és animációk gyorsabb elkészítéséhez.

A sugárkövetés (Ray Tracing), amely korábban rendkívül számításigényes volt és csak órákig tartó renderelés után volt lehetséges, mára valós időben is megvalósítható az NVIDIA RTX kártyák RT magjainak köszönhetően, amelyek kifejezetten a sugár-háromszög metszéspontok gyorsítására szolgálnak. Ez forradalmasítja a filmgyártást, az építészeti vizualizációt és a játékfejlesztést.

Ezen túlmenően a videóvágás, a speciális effektek (VFX) és a virtuális valóság (VR) alkalmazások is profitálnak a GPU-gyorsításból, lehetővé téve a művészek és tervezők számára, hogy gyorsabban iteráljanak és komplexebb projekteket valósítsanak meg.

Egyéb területek

A felsoroltakon kívül számos más területen is alkalmazzák a GPGPU-t:

- Orvosi képalkotás: 3D rekonstrukció, képzaj szűrés, diagnosztikai algoritmusok gyorsítása.

- Genomika: DNS szekvenálás, génanalízis, bioinformatikai számítások.

- Robotika: Látásrendszerek, mozgástervezés, valós idejű szenzoradat-feldolgozás.

- Autonóm rendszerek: Drónok, robotok vezérlése, valós idejű döntéshozatal.

- Kiberbiztonság: Jelszófeltörés, kriptográfiai támadások szimulációja.

A GPGPU alkalmazási területei folyamatosan bővülnek, ahogy a fejlesztők felfedezik a párhuzamos architektúra újabb és újabb kihasználási módjait.

A GPGPU jövője és kihívásai

A GPGPU technológia fejlődése töretlen, és a jövőben is kulcsszerepet fog játszani a számítástechnika számos területén. Azonban a növekvő teljesítménnyel együtt járnak bizonyos kihívások is, amelyekre a gyártóknak és fejlesztőknek egyaránt reagálniuk kell.

Hardver fejlődés: Integrált GPU-k, dedikált AI chipek

A hardverfejlődés több irányba mutat. Egyrészt az integrált GPU-k (iGPU) teljesítménye folyamatosan növekszik, és egyre inkább képesek lesznek bizonyos GPGPU feladatok elvégzésére, különösen az alacsony fogyasztású eszközökben és a mobil platformokon. Ez elmoshatja a határokat a dedikált és az integrált GPU-k között, és szélesebb körben elérhetővé teheti a GPGPU képességeket.

Másrészt, a dedikált AI chipek (pl. Google TPU, NVIDIA H100 GPU Tensor Cores-szal) megjelenése azt mutatja, hogy a GPGPU technológia specializálódik. Ezek a chipek kifejezetten a mesterséges intelligencia számításokra vannak optimalizálva, és a mátrixműveletekhez szükséges alacsony precíziós aritmetikát rendkívül hatékonyan hajtják végre. Ez a trend azt jelzi, hogy a jövőben a heterogén rendszerek még komplexebbé válhatnak, ahol a CPU, a GPU és a dedikált AI gyorsítók együtt dolgoznak a legoptimálisabb teljesítmény elérése érdekében.

A chiplet architektúrák és a magas sávszélességű memória (HBM) terjedése is jelentősen hozzájárul a GPGPU-k teljesítményének növekedéséhez, lehetővé téve a nagyobb magszámot és a gyorsabb adathozzáférést.

Szoftver fejlődés: Könnyebb programozhatóság, magasabb szintű absztrakciók

A GPGPU programozás továbbra is viszonylag komplex feladat, amely speciális ismereteket igényel. A jövő egyik fő kihívása a könnyebb programozhatóság elérése. Ez magában foglalja a magasabb szintű absztrakciók fejlesztését (pl. Python alapú keretrendszerek, mint a TensorFlow, PyTorch), amelyek elrejtik a GPU alacsony szintű részleteit a fejlesztők elől. A fordítóprogramoknak és a futtatókörnyezeteknek is egyre okosabbá kell válniuk, hogy automatikusan optimalizálják a kódot a különböző GPU architektúrákhoz.

A nyílt szabványok, mint az OpenCL és a ROCm folyamatos fejlesztése is kulcsfontosságú, hogy elkerüljük a gyártóspecifikus zárt rendszerek dominanciáját, és elősegítsük az innovációt a GPGPU területén.

Energiahatékonyság

A GPU-k hatalmas számítási teljesítményük mellett jelentős energiafogyasztással is járnak. A szerverparkokban és adatközpontokban ez komoly költséget és hűtési kihívást jelent. A jövőben az energiahatékonyság még kritikusabbá válik. A gyártók folyamatosan dolgoznak az új, energiatakarékosabb architektúrákon, a fejlettebb gyártástechnológiákon és a hatékonyabb hűtési megoldásokon. Az alacsonyabb precíziós számítások (pl. FP16, INT8) alkalmazása az AI területén szintén hozzájárul az energiafogyasztás csökkentéséhez.

Memóriakorlátok

Bár a GPU-k rendkívül gyors VRAM-mal rendelkeznek, a memória mérete gyakran korlátozó tényező lehet, különösen a gigantikus AI modellek tréningje vagy a nagy adathalmazokkal való munka során. A jövőben a memóriakapacitás növelése és az egységes memóriaarchitektúrák (ahol a CPU és GPU ugyanazt a memóriaterületet tudja közvetlenül elérni) kulcsfontosságúak lesznek. A HBM technológia és az integrált memóriamegoldások tovább javíthatják ezt a helyzetet.

A felhőalapú GPGPU

A felhőalapú GPGPU szolgáltatások (pl. AWS EC2 P/G instances, Google Cloud TPU, Azure NC/ND series) egyre népszerűbbek. Ezek lehetővé teszik a felhasználók számára, hogy igény szerint béreljenek GPU-erőforrásokat anélkül, hogy drága hardverbe kellene beruházniuk. Ez demokratizálja a nagy teljesítményű számítástechnikát, és rugalmasságot biztosít a változó számítási igényekhez. A felhőalapú GPGPU infrastruktúra fejlődése várhatóan folytatódik, és még szélesebb körben elérhetővé teszi ezt a technológiát.

Kvantumszámítástechnika és a GPGPU kapcsolata

Bár a kvantumszámítástechnika egy teljesen más paradigmát képvisel, a GPGPU-nak közvetett szerepe lehet a fejlődésében. A kvantumalgoritmusok szimulációja és a kvantumchipek vezérlése továbbra is klasszikus számítógépeket igényel, ahol a GPU-k felgyorsíthatják a szimulációs feladatokat vagy az adatfeldolgozást. A kvantumszámítástechnika és a GPGPU valószínűleg komplementer módon fejlődnek majd, ahol mindkét technológia a saját erősségeit kamatoztatja a komplex problémák megoldásában.

Hogyan válasszunk GPGPU-ra alkalmas hardvert?

A megfelelő GPGPU hardver kiválasztása kulcsfontosságú a feladat hatékony elvégzéséhez. Számos tényezőt kell figyelembe venni, amelyek a felhasználási esettől, a költségvetéstől és a szoftveres ökoszisztémától függően változhatnak.

NVIDIA vs. AMD

A GPGPU hardverpiacon alapvetően két fő szereplő dominál: az NVIDIA és az AMD.

- NVIDIA: Az NVIDIA GPU-k, különösen a Tesla és Quadro sorozatok (professzionális), valamint a GeForce RTX sorozat (fogyasztói) a GPGPU piac vezetői. A CUDA platformjuk rendkívül kiforrott, gazdag ökoszisztémával rendelkezik (cuDNN, cuBLAS, TensorRT), és széles körben támogatott a tudományos közösségben és az AI fejlesztők körében. Ha a szoftveres támogatás és a maximális kompatibilitás a legfontosabb (különösen a mélytanulásban), az NVIDIA általában a biztos választás. Az NVIDIA Tensor magok az AI feladatokhoz különösen hatékonyak.

- AMD: Az AMD Radeon Instinct (professzionális) és Radeon RX (fogyasztói) GPU-k erős alternatívát kínálnak, különösen az OpenCL és a ROCm platformjuk révén. Az AMD nyílt forráskódú megközelítése vonzó lehet azoknak, akik el akarják kerülni a gyártóspecifikus zárt rendszereket. Az AMD folyamatosan fejleszti ROCm ökoszisztémáját, és egyre versenyképesebbé válik a HPC és AI területeken, különösen az ár/teljesítmény arány tekintetében.

A választás nagyban függ attól, hogy milyen szoftvereket és keretrendszereket tervezünk használni, és mennyire fontos számunkra a nyílt forráskódú megközelítés.

Memória mérete és típusa

A VRAM (Video Random Access Memory) mérete az egyik legkritikusabb tényező GPGPU feladatoknál. Minél nagyobb adathalmazokkal dolgozunk (pl. nagy felbontású képek az AI tréningben, komplex szimulációk), annál több VRAM-ra lesz szükség. A kevés VRAM jelentősen lassíthatja a számításokat, mivel az adatoknak gyakran kell mozogniuk a CPU és GPU memória között.

A memória típusa is fontos. A modern GPU-k általában GDDR6 vagy HBM (High Bandwidth Memory) memóriát használnak. A HBM sokkal nagyobb sávszélességet kínál, ami különösen előnyös a rendkívül adatintenzív feladatoknál, mint például a HPC és a fejlett AI modellek. Azonban a HBM-mel felszerelt kártyák általában drágábbak és elsősorban professzionális szegmensben érhetők el.

Teljesítmény, hűtés, tápellátás

A számítási teljesítmény (pl. TFLOPS-ban mérve) természetesen alapvető, de fontos figyelembe venni, hogy a különböző precíziós szintek (FP64, FP32, FP16, INT8) teljesítménye eltérő lehet, és az adott feladat milyen precíziót igényel. Az AI feladatok gyakran megelégszenek alacsonyabb precízióval, ami nagyobb teljesítményt tesz lehetővé.

A hűtés létfontosságú. A GPGPU feladatok hosszú ideig terhelik a GPU-t maximális kapacitással, ami jelentős hőtermeléssel jár. Megfelelő hűtés nélkül a kártya túlmelegedhet, ami teljesítménycsökkenéshez (throttling) vagy károsodáshoz vezethet. Professzionális környezetben a blower-típusú hűtés előnyösebb lehet, mivel a meleg levegőt közvetlenül a házon kívülre vezeti, míg a többventillátoros megoldások a házon belüli légáramlásra támaszkodnak.

A tápellátás is kulcsfontosságú. Győződjünk meg róla, hogy a tápegység elegendő teljesítményt biztosít a GPU és a rendszer többi komponense számára. Egy erős GPGPU kártya akár 300-600W-ot vagy még többet is fogyaszthat önmagában.

Szoftveres támogatás és ökoszisztéma

Végül, de nem utolsósorban, a szoftveres támogatás és az ökoszisztéma döntő fontosságú. A leggyorsabb hardver is haszontalan, ha nincsenek hozzá megfelelő illesztőprogramok, optimalizált könyvtárak és fejlesztői eszközök. Győződjünk meg róla, hogy az általunk használni kívánt keretrendszerek (pl. TensorFlow, PyTorch, Caffe) és alkalmazások kompatibilisek a kiválasztott GPU-val és annak programozási platformjával (CUDA, OpenCL, ROCm).

A közösségi támogatás és a dokumentáció elérhetősége is fontos szempont, különösen, ha egy új technológiával ismerkedünk. Az NVIDIA CUDA ökoszisztémája ezen a téren jelenleg a legerősebb, de az AMD ROCm platformja is folyamatosan fejlődik és egyre nagyobb támogatottságot élvez.