A modern üzleti környezetben az adatok jelentik az egyik legértékesebb erőforrást. A vállalatok nap mint nap hatalmas mennyiségű információt gyűjtenek különböző forrásokból, legyen szó tranzakciós rendszerekről, CRM platformokról, IoT eszközökről, webanalitikákról vagy közösségi média csatornákról. Ezeknek a nyers adatoknak a puszta birtoklása azonban önmagában nem elegendő; ahhoz, hogy valódi értéket képviseljenek, feldolgozni, rendszerezni és elemezhetővé kell tenni őket.

Ebben a komplex folyamatban kap kiemelkedő szerepet az Extract, Load, Transform (ELT) adatintegrációs modell, amely a Big Data és a felhőalapú technológiák térnyerésével vált egyre népszerűbbé. Az ELT nem csupán egy technikai megoldás, hanem egy stratégiai megközelítés, amely lehetővé teszi a szervezetek számára, hogy rugalmasan és hatékonyan kezeljék az egyre növekvő adatmennyiséget, és gyorsabban jussanak el az adatokból származó üzleti felismerésekhez.

Ez a cikk részletesen bemutatja az ELT folyamatot, annak egyes fázisait, előnyeit és kihívásait, összehasonlítja az ETL-lel, és feltárja, hogyan illeszkedik a modern adatarchitektúrába. Célunk, hogy átfogó képet adjunk erről a kulcsfontosságú adatintegrációs paradigmáról, amely alapvető fontosságú az adatközpontú vállalatok sikeréhez.

Az ELT adatintegrációs modell alapjai

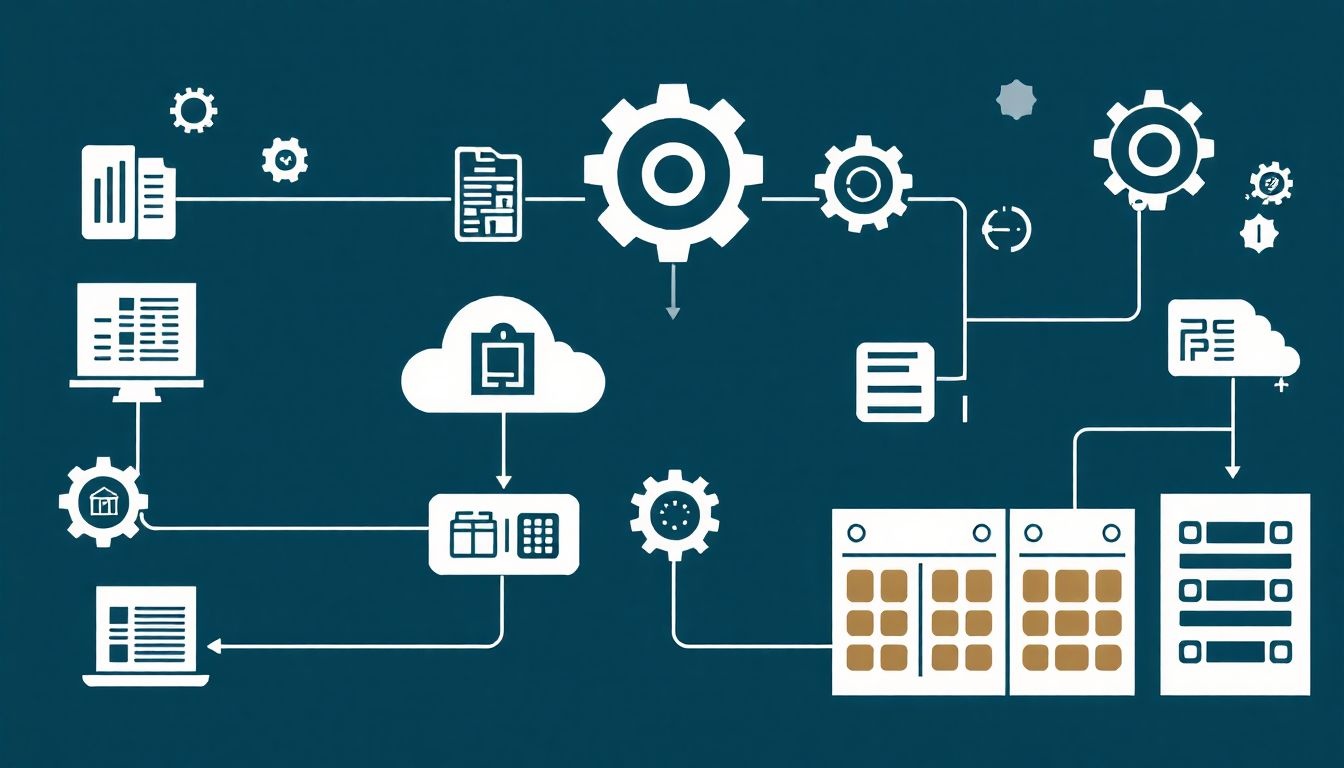

Az ELT, vagyis az Extract, Load, Transform egy adatintegrációs módszertan, amelynek célja a nyers adatok különböző forrásokból való kinyerése, egy célrendszerbe (általában adattóba vagy adattárházba) való betöltése, majd ott történő átalakítása elemzésre alkalmas formába. Ez a sorrend – először a nyers adatok betöltése, majd az átalakítás – alapvetően különbözteti meg az ELT-t a hagyományos ETL (Extract, Transform, Load) megközelítéstől.

A modell népszerűsége a felhőalapú adattárházak és az adattavak (data lakes) robbanásszerű fejlődésével párhuzamosan nőtt. Ezek a modern tárolási megoldások képesek hatalmas mennyiségű nyers adatot tárolni rendkívül költséghatékonyan és skálázhatóan, anélkül, hogy előzetesen strukturálnunk kellene azokat. Ez a képesség teszi lehetővé, hogy az átalakítás fázisa a betöltést követően valósuljon meg, kihasználva a célrendszer számítási erejét.

Az ELT lényege, hogy az adatok integritását és eredeti formáját megőrzi a betöltés pillanatáig, lehetővé téve a későbbi, rugalmasabb adatelemzést. A nyers adatok hozzáférhetősége kritikus lehet a jövőbeni elemzésekhez, a gépi tanulási modellek képzéséhez vagy akár a szabályozási megfelelőség biztosításához.

„Az ELT paradigmája forradalmasította az adatintegrációt azáltal, hogy a nyers adatok azonnali hozzáférhetőségét és a célrendszer számítási erejének kiaknázását helyezte előtérbe, optimalizálva a modern adatarchitektúrákban rejlő potenciált.”

Ez a megközelítés különösen előnyös a Big Data környezetekben, ahol az adatmennyiség és az adatok változatossága (struktúrált, félig-struktúrált, strukturálatlan) óriási kihívást jelent. Az ELT rugalmasabbá teszi az adatfeldolgozást, mivel az adatszakértők és adatelemzők a nyers adatokkal közvetlenül dolgozhatnak, és a szükséges átalakításokat a saját igényeik szerint végezhetik el, anélkül, hogy előre definiált sémákhoz kellene ragaszkodniuk.

A modern adatkezelés kihívásai

A digitális korban az adatkezelés komplexitása exponenciálisan növekszik. A szervezetek egyre több adatforrással dolgoznak, amelyek különböző formátumokban, sebességgel és minőségben termelnek adatokat. A hagyományos adatintegrációs módszerek gyakran nem képesek hatékonyan kezelni ezt a sokféleséget és mennyiséget.

Az egyik legnagyobb kihívás az adatok volumene. A petabájtos, sőt exabájtos adatmennyiségek kezelése megköveteli a skálázható tárolási és feldolgozási megoldásokat. A felhőalapú adattárházak és adattavak pontosan erre a problémára kínálnak megoldást, de szükség van egy olyan adatintegrációs folyamatra, amely képes kihasználni ezeket a képességeket.

Az adatok változatossága (variety) szintén jelentős problémát jelent. Strukturált relációs adatbázisok, félig-strukturált JSON vagy XML fájlok, strukturálatlan szöveges dokumentumok, képek és videók – mindezeket egységesen kell kezelni ahhoz, hogy teljes képet kapjunk az üzleti folyamatokról. Az ELT ebben a tekintetben is előnyös, mivel képes a nyers, változatos formátumú adatok betöltésére.

Végül, az adatok sebessége (velocity) is kulcsfontosságú. A valós idejű adatok, például az IoT szenzorokból vagy online tranzakciókból származó információk azonnali feldolgozást igényelnek, hogy az üzleti döntések naprakész információkon alapulhassanak. Bár az ELT hagyományosan batch feldolgozásra épült, a modern streaming ELT megoldások már képesek a közel valós idejű adatintegrációra is.

Miért az ELT a válasz?

Az ELT modell számos előnnyel jár, amelyek révén hatékony választ ad a modern adatkezelés kihívásaira. Az egyik legfontosabb előny a rugalmasság. Mivel az adatok nyers formában kerülnek betöltésre, az adatszakértők és adatelemzők szabadon kísérletezhetnek különböző átalakításokkal és elemzési megközelítésekkel, anélkül, hogy az eredeti adatforrásokat vagy az adatintegrációs folyamatot újra kellene tervezniük.

A skálázhatóság egy másik kulcsfontosságú tényező. A felhőalapú adattárházak és adattavak, mint például a Snowflake, BigQuery vagy Redshift, automatikusan skálázódnak az adatmennyiség és a számítási igények függvényében. Az ELT kihasználja ezt a skálázhatóságot, mivel a nehézkes átalakítási feladatokat a célrendszerre terheli, így elkerülhető a forrásrendszerek túlterhelése.

Az alacsonyabb kezdeti költségek és a gyorsabb implementáció is az ELT mellett szólnak. Mivel nincs szükség komplex átalakítási logikák előzetes definiálására és fejlesztésére, az adatok gyorsabban betölthetők a célrendszerbe. Ez felgyorsítja az adatelemzési projektek elindítását és lehetővé teszi a gyorsabb értékelést.

Az ELT emellett a teljes adatelőzmények megőrzését is támogatja. A nyers adatok tárolása révén lehetőség nyílik a múltbéli állapotok elemzésére, a hibakeresésre és a szabályozási előírásoknak való megfelelésre. Ez a megközelítés növeli az adatirányítás (data governance) és az adatminőség (data quality) hatékonyságát is, mivel minden adatváltozás nyomon követhető.

Az ‘Extract’ fázis mélyreható elemzése

Az ELT folyamat első, és talán legkritikusabb lépése az Extract, vagyis az adatkinyerés. Ebben a fázisban a különböző forrásrendszerekből származó adatok kerülnek összegyűjtésre. Az adatkinyerés célja, hogy a lehető legteljesebb és legpontosabb adatkészletet gyűjtse össze, amelyet aztán a további fázisokban feldolgozni lehet.

Az adatkinyerés komplexitása az adatforrások sokféleségéből és az adatok természetéből adódik. Különböző adatforrások eltérő protokollokat, API-kat és hozzáférési mechanizmusokat igényelnek, ami megköveteli a rugalmas és robusztus kinyerési stratégiákat. A sikeres Extract fázis alapja a forrásrendszerek alapos ismerete és a megfelelő eszközök kiválasztása.

A kinyerési folyamat során figyelembe kell venni az adatforrások terhelhetőségét is. A túl agresszív adatkinyerés lassíthatja vagy akár le is állíthatja a forrásrendszereket, ami súlyos üzleti fennakadásokat okozhat. Ezért elengedhetetlen a kinyerési ütemezés optimalizálása és a terheléselosztás megfelelő kezelése.

Adatforrások sokfélesége

A modern vállalatok által használt adatforrások rendkívül sokrétűek, és mindegyikük speciális megközelítést igényel az adatkinyerés során. A leggyakoribb adatforrások közé tartoznak a következők:

- Relációs adatbázisok (RDBMS): Ilyenek például az Oracle, SQL Server, MySQL, PostgreSQL. Ezekből az adatok jellemzően SQL lekérdezésekkel, adatbázis-kapcsolatokon keresztül, vagy Change Data Capture (CDC) technológiával nyerhetők ki.

- NoSQL adatbázisok: MongoDB, Cassandra, DynamoDB. Ezek az adatbázisok strukturálatlan vagy félig-strukturált adatokat tárolnak, és speciális API-kat vagy illesztőprogramokat igényelnek a kinyeréshez.

- Felhőalapú alkalmazások (SaaS): Salesforce, HubSpot, SAP, Google Analytics. Ezekből az adatok általában RESTful API-kon vagy dedikált konnektorokon keresztül érhetők el.

- Fájlrendszerek: CSV, JSON, XML, Parquet, ORC fájlok, amelyek lehetnek helyi szervereken, FTP-n vagy felhőalapú tárolókban (pl. S3, Azure Blob Storage).

- Streaming adatok: IoT szenzorok, clickstream adatok, log fájlok, közösségi média feedek. Ezek valós idejű adatokat szolgáltatnak, és olyan technológiákat igényelnek, mint a Kafka, Kinesis vagy Pub/Sub.

- Adatpiacterek és külső API-k: Harmadik féltől származó adatok, amelyek további üzleti kontextust biztosítanak.

Az egyes adatforrások egyedi jellemzőinek megértése elengedhetetlen a hatékony és megbízható adatkinyeréshez. Az adatforrások heterogenitása miatt gyakran több különböző kinyerési módszert és eszközt kell alkalmazni egy integrált ELT folyamaton belül.

Adatkinyerési technikák és protokollok

Az adatkinyerés során számos technika és protokoll alkalmazható, attól függően, hogy milyen típusú adatforrásról van szó, és milyen gyakorisággal kell az adatokat kinyerni:

- Teljes kinyerés (Full Extraction): Az összes adat kinyerése a forrásrendszerből minden alkalommal. Ez egyszerű, de erőforrásigényes, különösen nagy adatmennyiség esetén. Gyakran használják kisebb, statikusabb adatkészletekhez.

- Inkrementális kinyerés (Incremental Extraction): Csak a legutóbbi kinyerés óta megváltozott vagy hozzáadott adatok kinyerése. Ez sokkal hatékonyabb, de megköveteli a forrásrendszer képességét a változások nyomon követésére (pl. timestamp, verziószám, Change Data Capture).

- Change Data Capture (CDC): Egy kifinomult inkrementális kinyerési technika, amely az adatbázis tranzakciós logjait figyeli, és valós időben rögzíti az adatváltozásokat (insert, update, delete). Ez biztosítja a legfrissebb adatokat minimális késleltetéssel és terheléssel a forrásrendszeren.

- API alapú kinyerés: A forrásrendszer által biztosított programozási interfészek (API-k) használata az adatok lekérdezésére. Ez gyakori a SaaS alkalmazások és webes szolgáltatások esetében.

- Adatbázis-lekérdezések: SQL lekérdezések futtatása relációs adatbázisokon a szükséges adatok szelektálására és kinyerésére.

- Fájl alapú kinyerés: Fájlok (pl. CSV, JSON, XML) közvetlen olvasása a fájlrendszerből vagy felhőalapú tárolókból.

A megfelelő technika kiválasztása kulcsfontosságú a kinyerési folyamat hatékonysága, megbízhatósága és a forrásrendszerekre gyakorolt terhelés szempontjából. A modern ELT eszközök gyakran beépített konnektorokkal és automatizált CDC képességekkel rendelkeznek, amelyek egyszerűsítik ezt a fázist.

Az adatkinyerés kihívásai és megoldásai

Az Extract fázis számos kihívást rejthet magában, amelyek megfelelő tervezéssel és technológiai megoldásokkal orvosolhatók:

- Heterogén adatforrások: Különböző adatforrások eltérő sémákkal, adattípusokkal és hozzáférési protokollokkal rendelkeznek. Megoldás: Univerzális adatkinyerő eszközök és platformok használata, amelyek széles körű konnektivitást biztosítanak.

- Adatminőség: A forrásrendszerekben lévő hibás, hiányos vagy inkonzisztens adatok. Megoldás: Az Extract fázisban történő alapvető validáció, vagy a nyers adatok betöltése, majd a Transform fázisban történő részletesebb tisztítás.

- Teljesítmény és skálázhatóság: Nagy adatmennyiségek kinyerése anélkül, hogy a forrásrendszereket túlterhelnénk. Megoldás: Inkrementális kinyerés, CDC, párhuzamos adatkinyerés, terheléselosztás és a kinyerési időszakok optimalizálása.

- Adatbiztonság és hozzáférés: Az érzékeny adatok védelme a kinyerés során, és a megfelelő jogosultságok kezelése. Megoldás: Titkosított kapcsolatok, hozzáférés-vezérlés, tokenizáció és a forrásrendszerek biztonsági szabályzatainak betartása.

- Adatváltozások nyomon követése: Annak biztosítása, hogy minden releváns változás kinyerésre kerüljön. Megoldás: CDC, időbélyegzők használata, vagy verziókezelési mechanizmusok alkalmazása a forrásrendszerben.

A sikeres adatkinyerés alapja a forrásrendszerek mélyreható ismerete, a megfelelő technológia kiválasztása és egy robusztus hiba- és kivételkezelési stratégia kialakítása. Az Extract fázisban elkövetett hibák az egész ELT folyamat minőségét és megbízhatóságát veszélyeztethetik.

Az ‘Load’ fázis: Nyers adatok betöltése az adattárházba vagy adattóba

Az ELT folyamat második fázisa, a Load, azaz a betöltés, során a kinyert nyers adatok átkerülnek a célrendszerbe. Ez a célrendszer a modern adatarchitektúrákban jellemzően egy adattó (data lake) vagy egy felhőalapú adattárház (cloud data warehouse). A Load fázis az ELT kulcsfontosságú eleme, mivel itt valósul meg az adatok tárolása a későbbi átalakítás és elemzés céljából, anélkül, hogy előzetesen átalakítanánk őket.

A betöltés sebessége és hatékonysága kritikus. A célrendszereknek képesnek kell lenniük hatalmas adatmennyiségek gyors befogadására és tárolására. A felhőalapú megoldások ebben kiemelkedőek, mivel rendkívül skálázhatóak és költséghatékonyak a nagy mennyiségű tárolásra.

A Load fázisban az adatok gyakran strukturálatlan vagy félig-strukturált formában kerülnek tárolásra, megőrizve eredeti formájukat. Ez a „schema-on-read” megközelítés lehetővé teszi, hogy az adatok sémáját csak akkor határozzuk meg, amikor azokat elemzésre használjuk, ami jelentős rugalmasságot biztosít az adatszakértők számára.

A célrendszerek (adattó és adattárház) összehasonlítása

Az adattó (data lake) és az adattárház (data warehouse) a két leggyakoribb célrendszer az ELT folyamatokban, de alapvetően eltérő célokat szolgálnak:

Adattó (Data Lake):

- Cél: Minden típusú nyers adat tárolása, legyen az strukturált, félig-strukturált vagy strukturálatlan, anélkül, hogy előzetesen meghatároznánk a sémáját.

- Adattípusok: Relációs adatbázisok, NoSQL adatbázisok, IoT adatok, log fájlok, videók, képek, szöveges dokumentumok.

- Séma: „Schema-on-read” – a séma csak az adatok olvasásakor kerül meghatározásra.

- Felhasználók: Adattudósok, adatmérnökök, akik mélyreható elemzéseket végeznek, gépi tanulási modelleket építenek.

- Eszközök: Hadoop, Spark, felhőalapú tárolók (AWS S3, Azure Data Lake Storage, Google Cloud Storage).

- Előnyök: Maximális rugalmasság, nyers adatok megőrzése, költséghatékony tárolás, támogatja a fejlett analitikát és gépi tanulást.

- Hátrányok: „Data swamp” kockázata (rendszertelen adattömeg), nehezebb navigáció, magasabb adatszakértői ismereteket igényel.

Adattárház (Data Warehouse):

- Cél: Strukturált, tisztított és átalakított adatok tárolása üzleti intelligencia (BI) és jelentéskészítés céljából.

- Adattípusok: Elsősorban strukturált adatok, amelyek előre definiált sémákba illeszkednek.

- Séma: „Schema-on-write” – a séma az adatok betöltése előtt rögzített.

- Felhasználók: Üzleti elemzők, menedzserek, akik előre definiált jelentésekre és dashboardokra támaszkodnak.

- Eszközök: Snowflake, Google BigQuery, Amazon Redshift, Azure Synapse Analytics.

- Előnyök: Optimalizált lekérdezési teljesítmény, magas adatminőség, könnyű hozzáférés a BI eszközökből, megbízható jelentéskészítés.

- Hátrányok: Kevésbé rugalmas, csak strukturált adatokhoz ideális, drágább lehet a nyers adatok tárolásánál.

Sok modern architektúra hibrid megközelítést alkalmaz, ahol az adattó szolgál a nyers adatok elsődleges tárolására, majd onnan kerülnek az adatok kiválasztásra és átalakításra egy adattárházba a specifikus BI igények kielégítésére. Ez a Data Lakehouse koncepció.

Betöltési stratégiák és technikák

A betöltési fázisban is számos stratégia alkalmazható, a forrásrendszer, az adatmennyiség és a célrendszer típusától függően:

- Teljes betöltés (Full Load): A kinyert adatkészlet teljes egészének betöltése a célrendszerbe. Ez egyszerű, de időigényes és erőforrás-intenzív lehet. Gyakran használják kezdeti betöltésre vagy kisebb, statikus adatkészletek frissítésére.

- Inkrementális betöltés (Incremental Load): Csak a legutóbbi betöltés óta megváltozott vagy újonnan érkezett adatok betöltése. Ez sokkal hatékonyabb, és gyakran párosul az inkrementális kinyeréssel. Két fő típusa van:

- Insert only (csak beszúrás): Új rekordok hozzáadása a meglévő táblához.

- Upsert (update/insert): Meglévő rekordok frissítése és új rekordok beszúrása. Ehhez szükség van egy egyedi azonosítóra (kulcsra) az adatokban.

- Mikro-batch betöltés: Nagy adatmennyiség kis, kezelhető adagokra (mikro-batch-ekre) bontása, és ezek egymás utáni betöltése. Ez javítja a hibatűrést és a teljesítményt, különösen nagy méretű fájlok vagy adatfolyamok esetén.

- Streaming betöltés: Valós idejű adatok folyamatos betöltése a célrendszerbe. Ez elengedhetetlen a valós idejű analitikához és monitorozáshoz, és olyan technológiákat igényel, mint a Kafka, Kinesis vagy a felhőalapú streaming szolgáltatások.

A betöltés során a felhőalapú adattárházak és adattavak olyan funkciókat kínálnak, mint a párhuzamos betöltés, a tömeges beszúrási (bulk insert) műveletek és az automatikus skálázás, amelyek drámaian felgyorsítják a folyamatot. Az adatok gyakran ideiglenes (staging) területekre kerülnek először, mielőtt a végleges táblákba kerülnének.

Skálázhatóság és teljesítmény a betöltés során

A Load fázis skálázhatósága és teljesítménye alapvető fontosságú, különösen a Big Data környezetekben. A felhőalapú ELT megoldások ebben a tekintetben kiemelkedőek, mivel számos mechanizmust kínálnak a betöltés optimalizálására:

- Elosztott feldolgozás: A felhőalapú rendszerek, mint a Google BigQuery vagy az Amazon Redshift, elosztott architektúrára épülnek, ami lehetővé teszi az adatok párhuzamos betöltését több csomóponton keresztül.

- Automatikus skálázás: A számítási erőforrások automatikusan növelhetők vagy csökkenthetők az adatmennyiség és a betöltési igények függvényében. Ez biztosítja, hogy a rendszer mindig elegendő kapacitással rendelkezzen a feladatok gyors végrehajtásához.

- Optimalizált fájlformátumok: Az adatok gyakran oszloporientált formátumokban (pl. Parquet, ORC) kerülnek betöltésre, amelyek optimalizáltak a gyors lekérdezésekhez és a hatékony tároláshoz.

- Batch betöltés optimalizálása: A nagy adatmennyiségek kisebb batch-ekre bontása és azok párhuzamos betöltése minimalizálja a hálózati késleltetést és maximalizálja az átviteli sebességet.

- Hálózati infrastruktúra: A felhőszolgáltatók nagy sávszélességű hálózati infrastruktúrája kulcsfontosságú a gyors adatátvitelhez a forrásrendszerek és a célrendszer között.

A betöltési folyamat során a hibakezelés is kiemelten fontos. A sikertelen betöltéseket naplózni kell, és szükség esetén automatikusan újra kell próbálni. Az adatok integritásának biztosítása érdekében a tranzakciókezelés és a konzisztencia fenntartása alapvető. A modern ELT platformok beépített monitoring és riasztási funkciókat kínálnak, amelyek segítenek a betöltési folyamat felügyeletében és az esetleges problémák gyors azonosításában.

Az ‘Transform’ fázis: Adatok előkészítése elemzésre

Az ELT folyamat harmadik és utolsó fázisa a Transform, azaz az átalakítás. Ez a lépés az adatok tisztítására, normalizálására, aggregálására és dúsítására szolgál, hogy azok elemzésre alkalmas formába kerüljenek. Az ELT modellben az átalakítás a nyers adatok célrendszerbe (adattárházba vagy adattóba) történő betöltése után, közvetlenül a célrendszeren belül zajlik.

Ez a megközelítés kihasználja a modern felhőalapú adattárházak és adattavak számítási erejét és skálázhatóságát. Ahelyett, hogy egy külön átmeneti szerveren végeznénk az átalakítást (mint az ETL-ben), az ELT lehetővé teszi, hogy a nagy teljesítményű, elosztott rendszerek végezzék el a komplex átalakítási műveleteket, gyakran SQL-alapú lekérdezésekkel.

Az átalakítás célja, hogy az üzleti felhasználók, adatelemzők és adatszakértők számára könnyen értelmezhető, konzisztens és megbízható adatkészleteket hozzon létre. Ez az adatok minőségének javításáról és az üzleti logika alkalmazásáról szól, amelyek elengedhetetlenek a pontos elemzésekhez és a megalapozott döntéshozatalhoz.

Az átalakítás célja és típusai

Az átalakítási fázis fő célja, hogy a nyers adatokból értelmes, konzisztens és elemzésre alkalmas információkat hozzon létre. Ez magában foglalja a következő főbb tevékenységeket:

- Tisztítás (Cleaning): Az adatokban található hibák, inkonzisztenciák és hiányosságok azonosítása és korrigálása. Például duplikált rekordok eltávolítása, hiányzó értékek kitöltése, formátumhibák javítása.

- Normalizálás/Denormalizálás: Az adatok strukturálása a relációs adatbázis elveknek megfelelően (normalizálás) vagy a lekérdezési teljesítmény optimalizálása érdekében (denormalizálás, gyakori az adattárházakban).

- Aggregálás (Aggregation): Az adatok összegzése vagy csoportosítása magasabb szintű nézetek létrehozásához. Például napi értékesítési adatok összegzése heti vagy havi szinten.

- Dúsítás (Enrichment): Külső adatforrásokból származó további információk hozzáadása a meglévő adatokhoz. Például földrajzi koordináták hozzáadása címekhez, vagy ügyfélprofilok kiegészítése demográfiai adatokkal.

- Adattípus konverzió: Az adatok megfelelő adattípusra alakítása (pl. szövegből szám, dátumformátumok egységesítése).

- Kalkulált mezők létrehozása: Új mezők generálása meglévő adatokból származó számítások alapján (pl. profit margin, életkori kategória).

- Adatmaszkolás/Anonimizálás: Érzékeny adatok (pl. személyes azonosítók) elfedése vagy anonimizálása a biztonság és a megfelelőség érdekében.

Az átalakítási logikákat gyakran SQL parancsokkal, Python szkriptekkel vagy speciális adatintegrációs eszközökkel valósítják meg a célrendszeren belül. A modern adattárházak és adattavak optimalizált motorokkal rendelkeznek, amelyek rendkívül gyorsan képesek végrehajtani ezeket a műveleteket.

Adatminőség és validáció az átalakítás során

Az adatminőség az átalakítási fázis egyik legkritikusabb szempontja. A rossz minőségű adatok félrevezető elemzésekhez és hibás üzleti döntésekhez vezethetnek. Az átalakítási folyamat során szigorú validációs és minőségellenőrzési lépéseket kell beépíteni:

- Adatprofilozás: Az adatok alapos elemzése az Extract fázis után, hogy azonosítsuk a lehetséges minőségi problémákat (hiányzó értékek, inkonszisztens formátumok, kiugró értékek).

- Validációs szabályok: Előre definiált szabályok alkalmazása az adatok ellenőrzésére. Például:

- Adattípus ellenőrzés (számmező csak számot tartalmazzon).

- Tartományellenőrzés (érték egy előre meghatározott tartományon belül legyen).

- Referenciális integritás ellenőrzés (idegen kulcsok létező rekordokra mutassanak).

- Egyediség ellenőrzés (kulcsmezők egyediek legyenek).

- Hibakezelés: A validációs szabályokat megsértő adatok kezelése. Ez magában foglalhatja a hibás rekordok elutasítását, naplózását, vagy speciális hibakezelési logikák alkalmazását.

- Adatminőségi metrikák: Az adatok minőségének rendszeres mérése és nyomon követése (pl. teljesség, pontosság, konzisztencia, időszerűség).

- Adatirányítás (Data Governance): Az adatminőségi szabályok, felelősségek és folyamatok definiálása és betartatása az egész szervezetben.

A modern ELT eszközök és a felhőalapú adattárházak beépített adatminőségi funkciókat és keretrendszereket kínálnak, amelyek automatizálják ezeket a feladatokat. Az adatminőség folyamatos biztosítása elengedhetetlen a megbízható adatelemzéshez.

Az átalakítási logikák megtervezése

Az átalakítási logikák megtervezése egy iteratív folyamat, amely szoros együttműködést igényel az adatszakértők, üzleti elemzők és adatmérnökök között. A tervezés során figyelembe kell venni az üzleti igényeket, a célrendszer képességeit és az adatok jellegét.

Néhány szempont az átalakítási logikák tervezéséhez:

- Üzleti igények megértése: Milyen kérdésekre kell az adatoknak választ adniuk? Milyen jelentésekre és dashboardokra van szükség? Ez határozza meg, hogy milyen átalakításokra van szükség.

- Sématervezés: Az adattárházban vagy adattóban lévő céladatmodellek (csillagséma, hópehely séma) megtervezése, amelyek optimalizáltak a lekérdezésekhez és az elemzéshez.

- Lépésről lépésre történő átalakítás: A komplex átalakítási folyamatok kisebb, kezelhető lépésekre bontása. Ez javítja az olvashatóságot, a tesztelhetőséget és a karbantarthatóságot.

- Verziókövetés: Az átalakítási szkriptek és logikák verziókezelése (pl. Git használatával), hogy nyomon követhetőek legyenek a változások és szükség esetén visszaállíthatóak legyenek a korábbi verziók.

- Tesztelés: Az átalakítási logikák alapos tesztelése tesztadatokon, hogy biztosítsuk a helyes működést és a kívánt eredményeket. Az egységtesztek, integrációs tesztek és végpontok közötti tesztek elengedhetetlenek.

- Dokumentáció: Az átalakítási logikák, sémák és üzleti szabályok részletes dokumentálása, hogy mások is megérthessék és karbantarthassák azokat.

Az átalakítási fázis az, ahol a nyers adatok valóban értékessé válnak az üzlet számára. Egy jól megtervezett és implementált Transform fázis biztosítja, hogy az adatok megbízhatóak, relevánsak és könnyen hozzáférhetőek legyenek a döntéshozatalhoz.

ELT vs. ETL: Részletes összehasonlítás

Az ELT (Extract, Load, Transform) és az ETL (Extract, Transform, Load) egyaránt adatintegrációs módszertanok, amelyek célja az adatok forrásrendszerekből történő kinyerése és egy célrendszerbe való betöltése elemzés céljából. A legfőbb különbség a Transform fázis sorrendjében rejlik, ami alapvetően befolyásolja az architektúrát, a teljesítményt, a rugalmasságot és a költségeket.

Az ETL a hagyományos megközelítés, amely évtizedek óta dominálja az adatintegrációt, különösen a helyszíni (on-premise) adattárházak világában. Az ELT a felhőalapú adattárházak és adattavak elterjedésével vált népszerűvé, kihasználva ezek skálázható számítási és tárolási képességeit.

A két megközelítés közötti választás alapvetően függ a szervezet adatmennyiségétől, az adatok jellegétől (struktúrált, strukturálatlan), a költségvetéstől, a szükséges elemzések típusától és a meglévő infrastruktúrától. Egyik sem „jobb” a másiknál abszolút értelemben, inkább arról van szó, hogy melyik illeszkedik jobban az adott üzleti és technológiai környezethez.

Az alapvető különbségek megértése

Nézzük meg részletesebben az ELT és ETL közötti alapvető különbségeket egy táblázatban:

| Jellemző | ETL (Extract, Transform, Load) | ELT (Extract, Load, Transform) |

|---|---|---|

| Folyamat sorrendje | 1. Extract, 2. Transform, 3. Load | 1. Extract, 2. Load, 3. Transform |

| Hol történik az átalakítás? | Külön ETL szerver (staging area) | Célrendszeren belül (adattárház/adattó) |

| Adatok tárolása a célrendszerben | Már átalakított, strukturált adatok | Nyers, eredeti formájú adatok |

| Sémakezelés | Schema-on-write (előre definiált séma) | Schema-on-read (sématulajdonságok olvasáskor) |

| Teljesítmény | Az átalakítás korlátozhatja a sebességet, különösen nagy adatmennyiség esetén. | A betöltés gyorsabb, az átalakítás a célrendszer skálázható erejét használja. |

| Skálázhatóság | Korlátozottabb, az ETL szerver kapacitásától függ. | Magas, a felhőalapú célrendszerek (adattárházak/adattavak) automatikusan skálázódnak. |

| Rugalmasság | Kevésbé rugalmas, az átalakítási logika változása az ETL folyamat újraépítését igényelheti. | Rugalmasabb, a nyers adatok megőrzése lehetővé teszi a későbbi, változó elemzési igényeket. |

| Adatminőség | Az átalakítás során garantáltan jó minőségű adatok kerülnek a célrendszerbe. | A nyers adatok betöltése után az átalakítás garantálja a minőséget. |

| Költségek | Külön ETL szerverek, szoftverlicencek. | A felhőalapú tárolás és számítás költségei, gyakran használat alapú. |

| Használati esetek | Hagyományos BI, strukturált adatok, előre definiált jelentések. | Big Data, adatelemzés, gépi tanulás, adatexploráció, strukturálatlan adatok. |

Mikor válasszuk az ELT-t?

Az ELT megközelítés különösen előnyös bizonyos helyzetekben és üzleti igények mellett:

- Nagy adatmennyiség (Big Data): Ha a szervezet hatalmas mennyiségű adatot kezel, az ELT skálázhatósága és a felhőalapú rendszerek képességei elengedhetetlenek. Az adatok gyors betöltése és a célrendszeren belüli párhuzamos átalakítás jelentős időt takaríthat meg.

- Strukturálatlan vagy félig-strukturált adatok: Az ELT lehetővé teszi a nyers adatok, például log fájlok, közösségi média feedek, IoT adatok közvetlen betöltését, anélkül, hogy előre definiált sémát kellene alkalmazni. Ez ideális az adattavak számára.

- Rugalmas adatelemzési igények: Ha az adatelemzési igények folyamatosan változnak, vagy az adatszakértőknek szabadon kell kísérletezniük az adatokkal, a nyers adatok megőrzése kritikus. Az ELT támogatja a „schema-on-read” megközelítést, ami nagyobb rugalmasságot biztosít.

- Felhőalapú infrastruktúra: Ha a szervezet már felhőalapú adattárházat (pl. Snowflake, BigQuery, Redshift) vagy adattavat (pl. S3, ADLS) használ, az ELT természetes módon illeszkedik ehhez az architektúrához, kihasználva a felhő nyújtotta előnyöket.

- Valós idejű vagy közel valós idejű igények: Bár az ETL is képes valós idejű feldolgozásra, az ELT a gyors betöltés és a célrendszeren belüli gyors átalakítás révén hatékonyabban támogathatja a streaming adatfeldolgozást.

- Költséghatékonyság a számításban: A felhőalapú rendszerek gyakran optimalizáltabbak a nagy volumenű számítási feladatokhoz, mint a dedikált ETL szerverek, különösen, ha a számítási erőforrásokat csak szükség esetén skálázzák fel.

Mikor válasszuk az ETL-t?

Az ETL továbbra is releváns és gyakran előnyös bizonyos forgatókönyvekben:

- Hagyományos adattárházak (on-premise): Ha a szervezet már rendelkezik bevált, helyszíni adattárházzal és ETL infrastruktúrával, az áttérés az ELT-re jelentős beruházást igényelhet.

- Szabályozott környezetek: Bizonyos iparágakban (pl. pénzügy, egészségügy) szigorú szabályozások írhatják elő az adatok tisztítását és strukturálását még a betöltés előtt. Az ETL előre definiált sémája és a beépített minőségellenőrzés segíthet a megfelelőség biztosításában.

- Kisebb adatmennyiség: Kisebb adatmennyiségek és jól strukturált adatok esetén az ETL egyszerűbb lehet, és nem feltétlenül indokolt a felhőalapú ELT rendszerek bevezetése.

- Adatminőségi garanciák: Ha az adatminőség kritikus, és a hibás adatok kizárását már a célrendszerbe való betöltés előtt meg kell oldani, az ETL pre-transform fázisa előnyös lehet.

- Konzisztens üzleti logika: Ha az üzleti logika stabil és ritkán változik, az ETL előre definiált átalakításai hatékonyan működhetnek.

- Adatérzékenység és biztonság: Bizonyos esetekben a nyers adatok tárolása a célrendszerben (még ha az biztonságos is) kevésbé kívánatos, mint azok azonnali átalakítása és maszkolása.

Hibrid megközelítések

Gyakran előfordul, hogy a szervezetek hibrid megközelítést alkalmaznak, ötvözve az ETL és ELT előnyeit. Ez a Data Lakehouse koncepció egyik alapja, ahol az adattóban tárolják a nyers adatokat (ELT), majd onnan kiválasztott, tisztított és strukturált adatok kerülnek egy adattárházba (ETL) a specifikus üzleti intelligencia és jelentéskészítési igények kielégítésére.

Egy másik hibrid megközelítés, amikor az adatok egy részét ETL-lel dolgozzák fel (pl. érzékeny adatok azonnali maszkolása), míg más, kevésbé kritikus vagy nagyméretű adatokat ELT-vel kezelnek. A választás mindig az adott projekt és szervezet egyedi igényeitől függ.

„Az ETL és ELT közötti választás nem egy vagy-vagy döntés, hanem egy stratégiai megfontolás, amely a szervezet adatmennyiségéhez, elemzési igényeihez és technológiai infrastruktúrájához igazodik. A hibrid modellek gyakran a legoptimálisabb megoldást nyújtják.”

A modern adatintegrációs platformok gyakran támogatják mindkét megközelítést, lehetővé téve a rugalmas konfigurációt és a különböző adatfolyamokhoz való alkalmazkodást. Az adatmérnökök feladata, hogy a legmegfelelőbb stratégiát válasszák ki az adott kihívásokhoz.

Az ELT architektúra kulcsfontosságú elemei

Egy robusztus és hatékony ELT architektúra felépítése számos kulcsfontosságú komponens integrációját igényli. Ezek az elemek együttműködve biztosítják az adatok zökkenőmentes áramlását a forrástól a célrendszerig, miközben fenntartják az adatminőséget, a biztonságot és a skálázhatóságot. Az ELT architektúra jellemzően a felhőalapú infrastruktúrára épül, kihasználva annak rugalmasságát és költséghatékonyságát.

Az architektúra tervezésekor figyelembe kell venni az adatforrások sokféleségét, az adatmennyiséget, az elemzési igényeket és a szervezet hosszú távú adatstratégiáját. Egy jól megtervezett ELT architektúra képes alkalmazkodni a változó üzleti igényekhez és az adattechnológiai fejlődéshez.

A fő komponensek általában magukban foglalják az adatkinyerési mechanizmusokat, az adattárolási rétegeket, az átalakítási motorokat, az orchestrálási és monitoring eszközöket, valamint az adatkezelési és biztonsági rendszereket. Ezek együttesen alkotják azt a keretrendszert, amely lehetővé teszi a nyers adatokból valódi üzleti érték kinyerését.

Adattárolási rétegek: adattó, adattárház, adatpiac

Az ELT architektúra alapját az adatok tárolására szolgáló rétegek képezik. Ezek a rétegek különböző célokat szolgálnak, és az adatok feldolgozottsági szintjétől függően helyezkednek el a folyamatban:

- Adattó (Data Lake):

- Cél: A nyers adatok elsődleges tárolója, minden formátumban (strukturált, félig-strukturált, strukturálatlan).

- Jellemzők: Költséghatékony, rendkívül skálázható, „schema-on-read” megközelítés.

- Példák: Amazon S3, Azure Data Lake Storage, Google Cloud Storage.

- Szerep az ELT-ben: Az Extract fázis után az adatok ide kerülnek betöltésre, mielőtt bármilyen átalakítás történne. Ez a „Load” fázis célpontja a nyers adatok számára.

- Adattárház (Data Warehouse):

- Cél: Strukturált, tisztított és átalakított adatok tárolása üzleti intelligencia és jelentéskészítés céljából.

- Jellemzők: Optimalizált lekérdezési teljesítmény, „schema-on-write” megközelítés, magas adatminőség.

- Példák: Snowflake, Google BigQuery, Amazon Redshift, Azure Synapse Analytics.

- Szerep az ELT-ben: Az adattóból származó nyers adatok átalakítása után ide kerülnek a strukturált adatok. Ez a „Transform” fázis eredménye, és az üzleti elemzők fő adatforrása.

- Adatpiac (Data Mart):

- Cél: Az adattárház egy kisebb, tematikusan fókuszált része, amely egy adott üzleti terület (pl. értékesítés, marketing, pénzügy) specifikus igényeit szolgálja ki.

- Jellemzők: Egyszerűsített adatmodell, gyorsabb hozzáférés a specifikus jelentésekhez.

- Példák: Kisebb, dedikált táblák vagy nézetek az adattárházon belül.

- Szerep az ELT-ben: Az adattárházban lévő adatokból származó további aggregációk és specifikus nézetek. Segít az adatok demokratizálásában és a felhasználók önkiszolgáló elemzési képességeinek növelésében.

A modern architektúrákban gyakran találkozunk a Data Lakehouse koncepcióval, amely az adattó rugalmasságát és az adattárház teljesítményét ötvözi. Ez lehetővé teszi a nyers adatok közvetlen elérését az adattóból, miközben az adatok sémáját és minőségét is biztosítja a strukturált elemzéshez.

Orchestration és monitoring eszközök

Az ELT folyamatok automatizálásához, ütemezéséhez és felügyeletéhez elengedhetetlenek az orchestration és monitoring eszközök:

- Orchestration (vezénylés): Az ELT folyamat egyes lépéseinek (kinyerés, betöltés, átalakítás) sorrendjét, függőségeit és ütemezését kezeli. Biztosítja, hogy a lépések a megfelelő sorrendben és időben fussanak le.

- Példák: Apache Airflow, Prefect, Dagster, felhőalapú szolgáltatások, mint az AWS Step Functions, Azure Data Factory, Google Cloud Composer (Airflow alapú).

- Funkciók: DAG (Directed Acyclic Graph) alapú munkafolyamat-kezelés, ütemezés, függőségi kezelés, paraméterezés.

- Monitoring (felügyelet): Az ELT folyamat állapotának, teljesítményének és esetleges hibáinak valós idejű nyomon követése. Elengedhetetlen a proaktív hibaelhárításhoz és a folyamatos üzemeltetés biztosításához.

- Példák: Prometheus, Grafana, ELK Stack (Elasticsearch, Logstash, Kibana), felhőalapú monitoring szolgáltatások (AWS CloudWatch, Azure Monitor, Google Cloud Monitoring).

- Funkciók: Loggyűjtés, metrika-gyűjtés, riasztások, dashboardok, teljesítményelemzés.

Ezek az eszközök segítenek az adatmérnököknek abban, hogy átlássák az ELT pipeline-ok működését, gyorsan azonosítsák és orvosolják a problémákat, valamint optimalizálják a folyamatok teljesítményét és erőforrás-felhasználását.

Adatkezelési és biztonsági komponensek

Az ELT architektúra elengedhetetlen része az adatkezelés (data governance) és a biztonság biztosítása. Ezek a komponensek védik az adatokat, biztosítják a megfelelőséget és növelik az adatok megbízhatóságát:

- Adatminőség-kezelés (Data Quality Management): Eszközök és folyamatok az adatok tisztítására, validálására és minőségének folyamatos ellenőrzésére. Ez magában foglalja a profilozást, a validációs szabályok alkalmazását és a hibakezelést.

- Adatkatalógus és metaadat-kezelés (Data Catalog & Metadata Management): Egy központi tárhely, amely tárolja az adatokról szóló metaadatokat (pl. séma, forrás, tulajdonos, használat). Segít az adatok felfedezésében, megértésében és a lineage (adatvonal) nyomon követésében.

- Példák: Apache Atlas, Collibra, Alation, felhőalapú katalógusok (AWS Glue Data Catalog, Azure Purview, Google Cloud Data Catalog).

- Adatbiztonság (Data Security): Az adatok védelme illetéktelen hozzáférés, módosítás vagy megsemmisítés ellen. Ez magában foglalja:

- Hozzáférési kontroll: Szerepalapú hozzáférés-vezérlés (RBAC), amely meghatározza, ki férhet hozzá mely adatokhoz.

- Titkosítás: Adatok titkosítása átvitel közben (in-transit) és tárolás közben (at-rest).

- Adatmaszkolás/Anonimizálás: Érzékeny adatok elfedése vagy átalakítása, hogy azok ne legyenek visszavezethetők az egyénekre.

- Auditálás és naplózás: Minden adat-hozzáférési és módosítási tevékenység naplózása a biztonsági incidensek azonosítása és a megfelelőség biztosítása érdekében.

- Megfelelőség (Compliance): Az adatkezelési folyamatok összehangolása a vonatkozó jogszabályokkal és szabványokkal (pl. GDPR, HIPAA, CCPA).

Ezek a komponensek biztosítják, hogy az ELT folyamatok ne csak hatékonyak, hanem biztonságosak és megbízhatóak is legyenek, megfelelve a modern adatkezelés szigorú követelményeinek.

Felhő alapú ELT megoldások és platformok

A felhőalapú technológiák forradalmasították az adatintegrációt, és az ELT modell természetes otthonra talált a felhőben. A felhőszolgáltatók által kínált skálázható tárolási, számítási és adatintegrációs szolgáltatások ideális környezetet biztosítanak a nagy mennyiségű nyers adat hatékony kezeléséhez és átalakításához. A felhőalapú ELT megoldások jelentősen csökkentik az infrastruktúra-kezelés terhét, miközben növelik a rugalmasságot és a költséghatékonyságot.

A felhő ereje abban rejlik, hogy a szervezetek anélkül építhetnek robusztus ELT pipeline-okat, hogy dedikált hardverekbe vagy komplex szoftverlicencekbe kellene beruházniuk. Ehelyett a „pay-as-you-go” modell alapján fizetnek a felhasznált erőforrásokért, ami optimalizálja a költségeket és lehetővé teszi a gyors kísérletezést.

Ez a szekció bemutatja a felhő előnyeit az ELT-ben, valamint a legnépszerűbb felhőalapú ELT szolgáltatásokat, amelyek ma elérhetők.

A felhő előnyei az ELT-ben

A felhő számos előnnyel jár az ELT megvalósítása szempontjából:

- Skálázhatóság: A felhőalapú adattárházak és adattavak automatikusan skálázódnak az adatmennyiség és a számítási igények függvényében. Ez azt jelenti, hogy a rendszer képes kezelni a hirtelen adatbeáramlásokat vagy a komplex lekérdezéseket anélkül, hogy manuális beavatkozásra lenne szükség. Ez a dinamikus skálázhatóság kritikus a Big Data környezetekben.

- Költséghatékonyság: A „pay-as-you-go” modell azt jelenti, hogy csak a felhasznált erőforrásokért kell fizetni. Nincs szükség drága hardverek beszerzésére és karbantartására. Az erőforrásokat le lehet állítani, ha nincsenek használatban, ami jelentős megtakarítást eredményezhet.

- Rugalmasság és Agilitás: A felhő lehetővé teszi a gyors prototípus-készítést és a gyors fejlesztést. Az adatmérnökök és adatszakértők gyorsan beállíthatnak új környezeteket, tesztelhetnek különböző átalakítási logikákat és alkalmazkodhatnak a változó üzleti igényekhez.

- Teljesítmény: A felhőszolgáltatók optimalizált infrastruktúrát és nagy teljesítményű számítási erőforrásokat biztosítanak, amelyek felgyorsítják az adatbetöltést és az átalakítási folyamatokat. Az elosztott feldolgozási képességek lehetővé teszik a párhuzamos végrehajtást.

- Beépített szolgáltatások: A felhőplatformok széles skáláját kínálják beépített szolgáltatásoknak, mint például adatkinyerési konnektorok, adatminőségi eszközök, adatkezelési platformok és monitoring rendszerek, amelyek egyszerűsítik az ELT pipeline-ok építését és karbantartását.

- Megbízhatóság és Adatbiztonság: A felhőszolgáltatók magas szintű megbízhatóságot, adatvesztés elleni védelmet (redundancia, biztonsági mentések) és robusztus biztonsági intézkedéseket (titkosítás, hozzáférés-vezérlés, megfelelőségi tanúsítványok) biztosítanak.

Népszerű felhőalapú ELT szolgáltatások

Számos felhőszolgáltató kínál átfogó platformokat és szolgáltatásokat az ELT folyamatok megvalósításához. A legnépszerűbbek közé tartoznak:

- Snowflake:

- Leírás: Egy teljesen felhőalapú adattárház (data warehouse as a service), amely rendkívül skálázható és rugalmas. Elkülöníti a számítást és a tárolást, ami optimalizálja a költségeket és a teljesítményt.

- ELT képességek: Kiválóan alkalmas az adatok nyers formában történő betöltésére (Load), majd SQL-alapú átalakításokra (Transform) a virtuális adattárházakban. Támogatja a strukturált és félig-strukturált adatok kezelését.

- Google BigQuery:

- Leírás: Egy szerver nélküli, rendkívül skálázható és költséghatékony felhőalapú adattárház, amely petabájtos adatmennyiségek elemzésére képes.

- ELT képességek: Nagyon gyorsan képes nyers adatokat betölteni (Load), majd a BigQuery SQL motorjával végezni az átalakításokat (Transform). Integrálódik a Google Cloud Storage-szel (adattó) és a Cloud Dataflow-val (adatkinyerés és streaming).

- Amazon Redshift:

- Leírás: Az Amazon Web Services (AWS) felhőalapú adattárház szolgáltatása, amely masszívan párhuzamos feldolgozásra (MPP) épül.

- ELT képességek: Az S3-ból (adattó) vagy más AWS forrásokból gyorsan betölthetők az adatok (Load), majd SQL-alapú átalakítások végezhetők el. Integrálódik az AWS Glue-val (ETL és adatkinyerés) és az AWS Kinesis-szel (streaming).

- Azure Synapse Analytics:

- Leírás: A Microsoft Azure integrált analitikai szolgáltatása, amely egyesíti az adattárház, a Big Data elemzés és az adatintegráció képességeit.

- ELT képességek: Támogatja a nyers adatok betöltését az Azure Data Lake Storage-ba (Load), majd a Spark vagy SQL motorok segítségével történő átalakításokat (Transform). Az Azure Data Factory (ADF) kezeli az Extract és Orchestration fázisokat.

- Databricks (Delta Lake):

- Leírás: Egy „Data Lakehouse” platform, amely az Apache Sparkra épül, és egyesíti az adattó (Delta Lake) és az adattárház (SQL Analytics) funkcióit.

- ELT képességek: A Delta Lake lehetővé teszi a nyers adatok strukturált, megbízható tárolását az adattóban (Load), majd a Spark és SQL segítségével végezhető el a hatékony átalakítás (Transform).

Ezen platformok mindegyike kínál egyedi előnyöket, és a választás az adott szervezet meglévő felhőstratégiájától, költségvetésétől és specifikus igényeitől függ.

Költséghatékonyság és rugalmasság

A felhőalapú ELT megoldások jelentős költséghatékonyságot és rugalmasságot kínálnak a hagyományos helyszíni rendszerekhez képest:

- Optimalizált erőforrás-felhasználás: A felhőben csak a ténylegesen felhasznált számítási és tárolási erőforrásokért kell fizetni. Ez kiküszöböli a túlzott kapacitás kiépítésének szükségességét és a kihasználatlan erőforrások költségét.

- Kevesebb üzemeltetési teher: A felhőszolgáltatók kezelik az infrastruktúra karbantartását, frissítését és biztonságát, így az adatmérnökök a magasabb hozzáadott értékű feladatokra, például az adatmodellezésre és az elemzésre koncentrálhatnak.

- Gyorsabb piaci bevezetés: A felhőalapú szolgáltatások gyorsan beállíthatók és konfigurálhatók, ami felgyorsítja az adatintegrációs projektek elindítását és az adatok elemzésre való előkészítését. Ez lehetővé teszi a szervezetek számára, hogy gyorsabban reagáljanak a piaci változásokra.

- Innováció: A felhőszolgáltatók folyamatosan fejlesztik és bővítik szolgáltatásaikat, új funkciókat és technológiákat (pl. gépi tanulás, valós idejű analitika) kínálva, amelyek könnyen integrálhatók az ELT pipeline-okba.

Összességében a felhőalapú ELT megoldások lehetővé teszik a szervezetek számára, hogy agilisabban, költséghatékonyabban és skálázhatóbb módon kezeljék az adataikat, maximalizálva az adatokból kinyerhető üzleti értéket.

Az ELT megvalósításának legjobb gyakorlatai

Az ELT folyamatok sikeres megvalósítása nem csupán a megfelelő technológia kiválasztásáról szól, hanem a jól átgondolt tervezésről, a robusztus fejlesztési gyakorlatokról és a folyamatos karbantartásról is. A legjobb gyakorlatok alkalmazása biztosítja az adatminőséget, a skálázhatóságot, a megbízhatóságot és a hosszú távú fenntarthatóságot.

Az ELT pipeline-ok komplexitása megköveteli a gondos tervezést és a moduláris megközelítést. A cél az, hogy olyan rendszert hozzunk létre, amely képes kezelni a növekvő adatmennyiséget, alkalmazkodni a változó üzleti igényekhez, és minimalizálni az üzemeltetési terheket. Ez a szekció bemutatja azokat a kulcsfontosságú gyakorlatokat, amelyeket érdemes figyelembe venni az ELT rendszerek tervezése és implementálása során.

Az adatirányítás, a moduláris tervezés, a tesztelés és a dokumentáció mind-mind alapvető elemei egy sikeres ELT stratégiának, amelyek hozzájárulnak az adatközpontú döntéshozatalhoz.

Adatirányítás és adatminőség biztosítása

Az adatirányítás (Data Governance) és az adatminőség (Data Quality) az ELT folyamatok alapkövei. Nélkülük a legfejlettebb technológia is értéktelen adatokat eredményezhet:

- Adatirányítási keretrendszer kialakítása: Definiálni kell az adatok tulajdonosait, felelősségi köröket, hozzáférési szabályokat, adatvédelmi irányelveket és megfelelőségi követelményeket. Ez biztosítja az adatok konzisztens és biztonságos kezelését.

- Adatminőségi standardok és szabályok definiálása: Tisztázni kell, hogy mit jelent a „jó minőségű adat” az adott szervezet számára. Ez magában foglalja a teljesség, pontosság, konzisztencia, időszerűség és érvényesség kritériumait.

- Adatprofilozás: Rendszeresen elemezni kell a nyers adatokat az Extract fázis után, hogy azonosítsuk a lehetséges minőségi problémákat, anomáliákat és a hiányzó értékeket. Ez segít az átalakítási logikák finomításában.

- Validációs és tisztítási logikák implementálása: A Transform fázisban be kell építeni a validációs szabályokat és a tisztítási műveleteket az adatok konzisztenciájának és pontosságának biztosítása érdekében. A hibás adatok naplózása és kezelése kulcsfontosságú.

- Adatminőségi metrikák nyomon követése: Folyamatosan mérni és monitorozni kell az adatok minőségét, és riasztásokat kell beállítani a kritikus eltérések esetén. Ez lehetővé teszi a proaktív beavatkozást.

- Adatkatalógus és metaadat-kezelés: Egy központosított adatkatalógus segít az adatok megértésében, a lineage (adatvonal) nyomon követésében, és a felelősségi körök tisztázásában. Ez növeli az adatok átláthatóságát és bizalmát.

Moduláris és skálázható tervezés

Az ELT pipeline-ok tervezésénél a moduláris és skálázható megközelítés elengedhetetlen a hosszú távú fenntarthatóság és a rugalmasság érdekében:

- Moduláris felépítés: Az ELT folyamatot kisebb, önállóan tesztelhető és karbantartható modulokra kell bontani (pl. egy modul egy forrásrendszer kinyerésére, egy másik egy specifikus átalakításra). Ez megkönnyíti a hibakeresést és a fejlesztést.

- Paraméterezhetőség: A pipeline-okat úgy kell megtervezni, hogy paraméterezhetők legyenek, elkerülve a hardkódolt értékeket. Ez lehetővé teszi a könnyű konfigurálást és az új adatforrások vagy célok hozzáadását.

- Idempotencia: Az átalakítási logikáknak idempotensnek kell lenniük, ami azt jelenti, hogy többszöri futtatásuk is ugyanazt az eredményt adja, és nem okoz mellékhatásokat. Ez kritikus a hibatűrés és az újrapróbálkozások szempontjából.

- Verziókövetés: Minden kódot, szkriptet és konfigurációt verziókövető rendszerben (pl. Git) kell tárolni. Ez lehetővé teszi a változások nyomon követését, a visszaállítást és a csapatmunka hatékonyságát.

- Skálázható infrastruktúra: Kihasználni a felhőalapú szolgáltatások (pl. adattárházak, adatfolyam-feldolgozó motorok) automatikus skálázhatóságát, hogy a rendszer képes legyen kezelni a növekvő adatmennyiséget és a számítási igényeket.

- Adatmodell tervezés: Az adattárház vagy adattó adatmodelljét gondosan meg kell tervezni, figyelembe véve az üzleti igényeket és az elemzési mintákat. A csillagséma (star schema) és a hópehely séma (snowflake schema) gyakori választás az adattárházakban.

Tesztelés és validáció

Az ELT pipeline-ok tesztelése és validációja elengedhetetlen a megbízhatóság és a pontosság biztosításához:

- Egységtesztek (Unit Tests): Az egyes átalakítási modulok vagy függvények önálló tesztelése, hogy biztosítsuk azok helyes működését.

- Integrációs tesztek (Integration Tests): A különböző modulok közötti interakciók tesztelése, valamint a teljes ELT folyamat tesztelése egy kisebb adatkészlettel a kinyeréstől a betöltésig és átalakításig.

- Adatminőségi tesztek: Tesztek futtatása az adatok minőségének (pl. null értékek, duplikátumok, tartományon kívüli értékek) ellenőrzésére a Transform fázis után.

- Regressziós tesztek: Új változtatások bevezetésekor a korábbi funkcionalitás tesztelése, hogy biztosítsuk, nem okoztak-e váratlan hibákat.

- Teljesítménytesztek: Az ELT folyamat teljesítményének mérése nagy adatmennyiségekkel, hogy azonosítsuk a szűk keresztmetszeteket és optimalizáljuk a folyamatokat.

- Adatvalidáció (Data Validation): Az átalakított adatok összehasonlítása a forrásadatokkal vagy az előző futtatások eredményeivel, hogy ellenőrizzük az adatok integritását és konzisztenciáját.

- Automatizált tesztelés: A tesztek automatizálása a Continuous Integration/Continuous Delivery (CI/CD) pipeline részeként, hogy a változások gyorsan és megbízhatóan legyenek telepíthetők.

Dokumentáció és verziókövetés

A dokumentáció és a verziókövetés gyakran alábecsült, de kritikus elemei a sikeres ELT megvalósításnak:

- Részletes dokumentáció: Minden ELT pipeline-ról, adatforrásról, átalakítási logikáról és céladatmodellről részletes dokumentációt kell készíteni. Ez magában foglalja az adatvonalat (data lineage), az üzleti definíciókat és a technikai specifikációkat.

- Adatkatalógus integráció: A dokumentációt integrálni kell egy adatkatalógusba, hogy az adatok és metaadatok könnyen felfedezhetők és hozzáférhetők legyenek az adatok felhasználói számára.

- Verziókövetés minden komponensen: Nem csak a kódot, hanem a konfigurációs fájlokat, sémadefiníciókat és az orchestration scripteket is verziókövető rendszerben (pl. Git) kell tárolni. Ez lehetővé teszi a változások nyomon követését, a hibakeresést és a csapatmunka hatékonyabbá tételét.

- Folyamatos frissítés: A dokumentációt folyamatosan frissíteni kell a rendszer változásaival. Az elavult dokumentáció rosszabb, mint a hiányzó, mivel félrevezető lehet.

- Kódkommentek: A kódban (SQL, Python szkriptek stb.) hasznos és informatív kommenteket kell elhelyezni, amelyek magyarázzák a komplex logikákat és üzleti szabályokat.

Ezek a legjobb gyakorlatok együttesen biztosítják, hogy az ELT rendszerek megbízhatóan működjenek, könnyen karbantarthatók legyenek, és valóban támogassák az adatközpontú döntéshozatal folyamatát a szervezetben.

Biztonság és megfelelőség az ELT folyamatokban

Az adatintegrációs folyamatok, beleértve az ELT-t is, nagymértékben hozzáférnek és kezelnek érzékeny adatokat, ezért a biztonság és a megfelelőség (compliance) kiemelten fontos szempontok. A nem megfelelő adatvédelem súlyos adatvédelmi incidensekhez, bírságokhoz, reputációs károkhoz és az ügyfelek bizalmának elvesztéséhez vezethet. Egy robusztus ELT architektúrának alapvetően kell magában foglalnia a biztonsági és megfelelőségi mechanizmusokat a tervezéstől az üzemeltetésig.

A modern adatkezelési szabályozások, mint például a GDPR, HIPAA vagy CCPA, szigorú követelményeket támasztanak az adatok gyűjtésére, tárolására, feldolgozására és megosztására vonatkozóan. Az ELT folyamatoknak képesnek kell lenniük ezeknek a szabályozásoknak való megfelelésre, biztosítva az adatok védelmét és az egyének jogait.

Ez a szekció részletezi azokat a kulcsfontosságú biztonsági protokollokat, szabályozásokat és technikákat, mint az adatmaszkolás és anonimizálás, amelyek elengedhetetlenek az ELT környezetben.

Adatbiztonsági protokollok

Az adatbiztonság több rétegből álló megközelítést igényel az ELT folyamatokban. Az alábbi protokollok és intézkedések alapvetőek:

- Hozzáférési kontroll (Access Control):

- Szerepalapú hozzáférés-vezérlés (RBAC): Csak azok a felhasználók és rendszerek férhetnek hozzá az adatokhoz, amelyeknek ehhez jogosultságuk van, a feladataikhoz szükséges minimális jogosultság elve alapján.

- Megerősített hitelesítés: Erős jelszavak, többfaktoros hitelesítés (MFA) használata minden hozzáférési ponton.

- Hálózati szegmentáció: Az ELT komponensek és adatforrások elkülönítése a hálózaton belül, tűzfalak és virtuális magánhálózatok (VPN) használatával.

- Titkosítás (Encryption):

- Adatok titkosítása átvitel közben (Encryption in Transit): Az adatok titkosítása a hálózati átvitel során (pl. SSL/TLS protokollok használatával) a kinyerési és betöltési fázisokban.

- Adatok titkosítása tárolás közben (Encryption at Rest): Az adatok titkosítása a tárolórendszerekben (adattó, adattárház) (pl. AES-256 algoritmusokkal). A felhőszolgáltatók gyakran automatikusan biztosítják ezt.

- Kulcskezelés: A titkosítási kulcsok biztonságos tárolása és kezelése kulcskezelő szolgáltatások (pl. AWS KMS, Azure Key Vault, Google Cloud Key Management Service) segítségével.

- Auditálás és naplózás (Auditing & Logging):

- Minden adat-hozzáférési, módosítási és rendszeradminisztrációs tevékenység részletes naplózása.

- A naplók központosított tárolása és elemzése a biztonsági incidensek azonosítása és a megfelelőségi auditok támogatása érdekében.

- Rendszeres biztonsági auditok és sebezhetőségi vizsgálatok végrehajtása.

- Adatvesztés megelőzése (Data Loss Prevention – DLP):

- Technológiák és folyamatok az érzékeny adatok azonosítására és megakadályozására, hogy azok illetéktelenül elhagyják a kontrollált környezetet.

GDPR és egyéb szabályozások

Az ELT folyamatoknak szigorúan meg kell felelniük a különböző adatvédelmi és adatkezelési szabályozásoknak. Néhány kiemelten fontos:

- GDPR (General Data Protection Regulation): Az Európai Unió adatvédelmi rendelete, amely szigorú szabályokat ír elő a személyes adatok gyűjtésére, tárolására és feldolgozására. Az ELT folyamatoknak biztosítaniuk kell:

- Adatminimalizálás: Csak a szükséges adatok gyűjtése.

- Célhoz kötöttség: Az adatok csak a meghatározott célra használhatók fel.

- Átláthatóság: Az érintettek tájékoztatása az adataik kezeléséről.

- Adatvédelem alapértelmezés és tervezés szerint (Privacy by Design and Default): Az adatvédelmi szempontok beépítése az ELT rendszer tervezésébe.

- Adatmaszkolás és anonimizálás: Érzékeny adatok védelme a Transform fázisban.

- HIPAA (Health Insurance Portability and Accountability Act): Az Egyesült Államok egészségügyi adatvédelmi törvénye, amely a védett egészségügyi információk (PHI) biztonságos kezelését szabályozza.

- CCPA (California Consumer Privacy Act): Kaliforniai fogyasztóvédelmi törvény, amely hasonló jogokat biztosít a kaliforniai lakosoknak, mint a GDPR.

- Egyéb iparági és nemzeti szabályozások: Pénzügyi szektorban (PCI DSS), kormányzati szektorban (FedRAMP) stb.

A megfelelőség biztosítása érdekében az adatirányítási (Data Governance) programoknak szorosan együtt kell működniük az ELT csapatokkal, hogy az adatvédelmi és biztonsági követelmények beépüljenek a folyamat minden szakaszába.

Adatmaszkolás és anonimizálás

Az adatmaszkolás és az anonimizálás kulcsfontosságú technikák az érzékeny adatok védelmére az ELT folyamatokban, különösen a Transform fázisban, mielőtt az adatok elemzők kezébe kerülnének. Ezek a módszerek segítenek a megfelelőség biztosításában és az adatvédelmi kockázatok csökkentésében:

- Adatmaszkolás (Data Masking): Az eredeti érzékeny adatok helyettesítése valósághű, de fiktív adatokkal. A maszkolt adatok megőrzik az eredeti adatok formátumát és szerkezetét, így továbbra is használhatók tesztelésre vagy fejlesztésre, de nem vezethetők vissza az eredeti egyénekre.

- Típusai: Statikus maszkolás (egyedi adatkészlet maszkolása), dinamikus maszkolás (valós idejű maszkolás a lekérdezések során, a felhasználói jogosultságok alapján).

- Példák: Személyi igazolvány számok cseréje véletlenszerű, de érvényes formátumú számokra; nevek helyettesítése fiktív nevekkel; email címek átalakítása generikus formátumra.

- Anonimizálás (Anonymization): Az adatok olyan módon történő átalakítása, hogy azokból ne lehessen közvetlenül vagy közvetve azonosítani az egyéneket. Ez egy egyirányú folyamat, az eredeti adatok visszaállítása nem lehetséges.

- Típusai:

- Általánosítás (Generalization): Az adatok pontosságának csökkentése (pl. pontos életkor helyett életkori tartomány).

- K-anonimitás: Az adatok átalakítása úgy, hogy minden rekord legalább K másik rekorddal azonos legyen az azonosító attribútumok tekintetében.

- Differenciális adatvédelem (Differential Privacy): Statisztikai zaj hozzáadása az adatokhoz, hogy az egyének ne legyenek azonosíthatók, miközben az aggregált minták továbbra is megőrzik hasznos statisztikai tulajdonságaikat.

- Pszeudonimizálás (Pseudonymization): Az azonosító adatok (pl. név) lecserélése egy álnevével (pseudonym), ami lehetővé teszi az adatok összekapcsolását anélkül, hogy az eredeti azonosítók láthatók lennének. Ez visszafordítható, ha az álnevet az eredeti adatokkal összekapcsoló kulcs biztonságosan tárolva van.

- Típusai:

Az adatmaszkolási és anonimizálási stratégiákat gondosan meg kell választani az adatok érzékenysége, a szabályozási követelmények és az elemzési igények alapján. A cél az, hogy maximalizáljuk az adatok hasznosságát, miközben minimalizáljuk az adatvédelmi kockázatokat.

Az ELT jövője és a feltörekvő trendek

Az ELT, mint adatintegrációs modell, folyamatosan fejlődik, ahogy az adattechnológia és az üzleti igények is változnak. A Big Data, a felhőalapú számítástechnika és a mesterséges intelligencia térnyerése új lehetőségeket és kihívásokat teremt az ELT számára. A jövőben az ELT rendszerek még intelligensebbé, automatizáltabbá és valós idejűvé válnak, hogy támogassák a legmodernebb adatelemzési és gépi tanulási alkalmazásokat.

A trendek azt mutatják, hogy az adatokhoz való hozzáférés sebessége és a feldolgozás rugalmassága még kritikusabbá válik. A szervezetek egyre inkább valós idejű döntéseket szeretnének hozni, és ehhez folyamatosan frissülő adatokra van szükségük. Emellett az adatok szétszórt elhelyezkedése (multi-cloud, edge computing) új architektúra-megoldásokat is megkíván.

Ez a szekció bemutatja azokat a feltörekvő trendeket, amelyek alakítják az ELT jövőjét, és amelyekre az adatmérnököknek és adatszakértőknek fel kell készülniük.

Mesterséges intelligencia és gépi tanulás az ELT-ben

A mesterséges intelligencia (MI) és a gépi tanulás (GM) egyre nagyobb szerepet kap az ELT folyamatok optimalizálásában és automatizálásában:

- Adatprofilozás és minőségellenőrzés: Az MI/GM algoritmusok képesek automatikusan azonosítani az adatminőségi problémákat, anomáliákat, hiányzó értékeket és inkonzisztenciákat a nyers adatokban, sokkal gyorsabban és hatékonyabban, mint a manuális módszerek.

- Sémafelismerés és -ajánlás: A gépi tanulás segíthet a strukturálatlan és félig-strukturált adatok sémájának automatikus felismerésében és ajánlásában, ami felgyorsítja az adatok előkészítését az adattóban.

- Adatátalakítási javaslatok: Az MI alapú eszközök képesek tanulni a korábbi átalakítási mintákból, és javaslatokat tenni az adatok tisztítására, normalizálására és dúsítására.

- Teljesítményoptimalizálás: A gépi tanulás alkalmazható az ELT pipeline-ok teljesítményének prediktív elemzésére és optimalizálására, például a legjobb betöltési stratégiák kiválasztására vagy az erőforrás-felhasználás optimalizálására.

- Automatizált hibaelhárítás: Az MI képes észlelni a rendellenességeket az ELT folyamatokban, és automatikusan riasztásokat generálni, vagy akár önállóan megpróbálni orvosolni a kisebb problémákat.

Az MI/GM integrációja az ELT-be növeli az automatizáltság szintjét, csökkenti a manuális beavatkozás szükségességét, és felgyorsítja az adatok elemzésre való előkészítését.

Streaming ELT és valós idejű adatintegráció

A hagyományos ELT folyamatok gyakran batch-alapúak, ami azt jelenti, hogy az adatok meghatározott időközönként kerülnek feldolgozásra. Azonban az üzleti igények egyre inkább a valós idejű adatok felé mutatnak, ami a Streaming ELT térnyerését eredményezi:

- Valós idejű adatforrások: IoT szenzorok, online tranzakciók, weboldal clickstream adatok, közösségi média feedek – ezek mind folyamatosan termelnek adatokat, amelyek azonnali feldolgozást igényelnek.

- Streaming adatfeldolgozó platformok: Olyan technológiák, mint az Apache Kafka, Apache Flink, Apache Spark Streaming, AWS Kinesis, Azure Stream Analytics vagy Google Cloud Dataflow, lehetővé teszik az adatok folyamatos kinyerését, betöltését és átalakítását minimális késleltetéssel.

- Micro-batch és folyamatos feldolgozás: A Streaming ELT megközelítések gyakran micro-batch feldolgozást alkalmaznak, ahol az adatok nagyon kis adagokban, közel valós időben kerülnek feldolgozásra, vagy teljesen folyamatosan áramlanak a pipeline-on keresztül.

- Azonnali üzleti döntések: A valós idejű ELT képességek lehetővé teszik a vállalatok számára, hogy azonnali döntéseket hozzanak, például csalás észlelése, személyre szabott ajánlások, vagy az ellátási lánc optimalizálása.

A Streaming ELT a „low-latency” (alacsony késleltetésű) adatintegráció jövője, amely elengedhetetlen a modern, dinamikus üzleti környezetben.

Data Mesh és Data Fabric koncepciók

Az ELT jövőjét olyan új adatarchitektúra-koncepciók is formálják, mint a Data Mesh és a Data Fabric:

- Data Mesh:

- Leírás: Egy decentralizált adatarchitektúra, amely az adatokat terméknek tekinti, és a domain-specifikus csapatoknak adja az adatok tulajdonjogát és felelősségét.

- ELT szerepe: A Data Mesh-ben az ELT pipeline-ok domain-specifikussá válnak, és minden adattermékhez saját ELT folyamat tartozhat. A hangsúly a „self-serve” adatinfrastruktúrán és az adatok könnyű elérhetőségén van.

- Előnyök: Növeli az agilitást, csökkenti a központi adatelemző csapatok szűk keresztmetszeteit, és elősegíti az adatkultúra elterjedését.

- Data Fabric:

- Leírás: Egy integrált adatinfrastruktúra, amely a metaadatok, a mesterséges intelligencia és a gépi tanulás segítségével automatizálja az adatok felfedezését, integrációját, irányítását és fogyasztását a heterogén környezetekben.

- ELT szerepe: A Data Fabric célja az ELT folyamatok automatizálása és egyszerűsítése az intelligens metaadat-kezelés és az MI-vezérelt adatintegrációs eszközök révén. A hangsúly az adatok virtuális rétegén van, amely egységes hozzáférést biztosít a szétszórt adatokhoz.

- Előnyök: Csökkenti az adatintegráció komplexitását, javítja az adatok hozzáférhetőségét és felhasználhatóságát a különböző rendszerek között.

Ezek a koncepciók arra irányulnak, hogy az ELT folyamatokat még rugalmasabbá, automatizáltabbá és felhasználóbarátabbá tegyék, alkalmazkodva a modern, elosztott adatkörnyezetekhez. Az ELT továbbra is az adatintegráció alapköve marad, de a jövőben még inkább az intelligens, önvezérlő és valós idejű rendszerek felé mozdul el.

Az ELT hatása az üzleti intelligenciára és az adatelemzésre

Az Extract, Load, Transform (ELT) modell nem csupán egy technikai adatintegrációs folyamat, hanem alapvetően átalakítja azt, ahogyan a vállalatok hozzáférnek, elemzik és felhasználják az adataikat. Közvetlen és jelentős hatása van az üzleti intelligenciára (BI) és az adatelemzésre, lehetővé téve a gyorsabb, rugalmasabb és mélyrehatóbb betekintést az üzleti működésbe. Az ELT által biztosított nyers adatokhoz való hozzáférés és a célrendszeren belüli rugalmas átalakítás képessége új dimenziókat nyit meg az adatközpontú döntéshozatal előtt.

A modern üzleti környezetben a versenyelőny gyakran azon múlik, hogy egy vállalat milyen gyorsan képes adatokat gyűjteni, elemezni és azok alapján cselekedni. Az ELT ebben a tekintetben kulcsszerepet játszik, mivel felgyorsítja az adatfeldolgozási ciklust és támogatja a fejlett analitikai technikákat.

Ez a szekció feltárja, hogyan befolyásolja az ELT az üzleti intelligenciát és az adatelemzést, kiemelve a gyorsabb adathozzáférést, a rugalmasabb adatexplorációt és a jobb üzleti döntéshozatal lehetőségét.

Gyorsabb adathozzáférés és elemzés

Az ELT egyik legjelentősebb előnye az üzleti intelligencia szempontjából a gyorsabb adathozzáférés és elemzés:

- Azonnali hozzáférés a nyers adatokhoz: Az ELT modellben az adatok nyers formában kerülnek betöltésre az adattóba vagy adattárházba. Ez azt jelenti, hogy az adatok szinte azonnal elérhetők az adatszakértők és adatelemzők számára, amint kinyerésre és betöltésre kerültek. Nincs szükség hosszú átalakítási folyamatokra a betöltés előtt.

- Rövidebb adatfeldolgozási ciklusok: Az adatok gyors betöltése és a felhőalapú rendszerek skálázható számítási ereje lehetővé teszi a gyorsabb átalakításokat. Ez lerövidíti az időt az adatgyűjtéstől az elemzésig, felgyorsítva az üzleti intelligencia ciklusát.

- Frissebb adatok a döntéshozatalhoz: A gyorsabb pipeline-oknak köszönhetően a BI dashboardok és jelentések frissebb adatokkal dolgozhatnak. Ez kritikus a valós idejű vagy közel valós idejű üzleti döntések meghozatalához, például készletkezelés, kampányoptimalizálás vagy csalásészlelés esetén.

- Kevesebb szűk keresztmetszet: Az átalakítási feladatok áthelyezése a célrendszerre csökkenti az ETL szerverek terhelését, és kiküszöböli a potenciális szűk keresztmetszeteket, amelyek lassíthatják az adatfeldolgozást.

Ez a gyorsaság és aktualitás lehetővé teszi a vállalatok számára, hogy proaktívabban reagáljanak a piaci változásokra és az ügyfél igényeire.

Rugalmasabb adatexploráció

Az ELT által biztosított rugalmasabb adatexploráció kulcsfontosságú a mélyreható adatelemzéshez és az innovatív felhasználási esetek felfedezéséhez:

- Nyers adatok megőrzése: Mivel az ELT a nyers adatokat tárolja, az adatszakértők bármikor visszatérhetnek az eredeti adatkészletekhez. Ez lehetővé teszi számukra, hogy különböző átalakítási logikákkal és modellekkel kísérletezzenek, anélkül, hogy az eredeti adatokat módosítanák.

- „Schema-on-read” megközelítés: Az adatok sémáját csak akkor kell meghatározni, amikor azokat elemzésre használják. Ez óriási rugalmasságot biztosít, különösen a strukturálatlan és félig-strukturált adatok esetében, ahol az előre definiált séma korlátozó lehet.

- Adattudomány és gépi tanulás támogatása: Az adatelemzők és adatszakértők közvetlenül dolgozhatnak a nyers adatokkal, ami elengedhetetlen a fejlett analitikai modellek, például a gépi tanulási algoritmusok képzéséhez és finomításához. A nyers adatok hozzáférése lehetővé teszi számukra, hogy mélyebben megértsék az adatok mögötti mintákat.

- Ad-hoc lekérdezések és exploráció: Az ELT környezetek, különösen a felhőalapú adattárházak, rendkívül gyors ad-hoc lekérdezéseket tesznek lehetővé. Ez felhatalmazza az üzleti felhasználókat, hogy önállóan fedezzenek fel adatokat és válaszoljanak a saját kérdéseikre, csökkentve az adatelemző csapatokra nehezedő terheket.

- Új üzleti kérdések megválaszolása: A nyers adatok megőrzése és a rugalmas átalakítási képességek lehetővé teszik a vállalatok számára, hogy olyan üzleti kérdésekre is választ találjanak, amelyekre korábban nem gondoltak, vagy amelyekre a hagyományos, előre definiált ETL rendszerek nem voltak képesek.

Ez a rugalmasság ösztönzi az innovációt és az adatok kreatív felhasználását a szervezetben.

Jobb üzleti döntéshozatal

Végső soron az ELT célja, hogy támogassa a jobb üzleti döntéshozatalt. Azáltal, hogy gyorsabban, frissebben és rugalmasabban férhetnek hozzá az adatokhoz, a vezetők és elemzők megalapozottabb döntéseket hozhatnak:

- Teljesebb kép az üzletről: A különböző forrásokból származó nyers adatok integrálása egyetlen helyre (adattó/adattárház) lehetővé teszi a holisztikusabb képet az üzleti működésről, az ügyfelekről és a piaci trendekről.

- Pontosabb előrejelzések és modellek: A nyers adatokhoz való hozzáférés és a fejlett analitikai eszközök használata pontosabb előrejelzéseket és prediktív modelleket eredményez, amelyek segítenek a jövőbeli események előrejelzésében és a kockázatok kezelésében.

- Versenyelőny: A gyorsabb adathozzáférés és elemzés lehetővé teszi a vállalatok számára, hogy gyorsabban reagáljanak a piaci változásokra, azonosítsák az új lehetőségeket és optimalizálják működésüket, ezáltal versenyelőnyre tegyenek szert.

- Növelt hatékonyság: Az adatokhoz való könnyebb hozzáférés és a gyorsabb elemzés növeli az üzleti felhasználók hatékonyságát, mivel kevesebb időt töltenek az adatok előkészítésével és többet azok elemzésével.

- Adatközpontú kultúra: Az ELT támogatja egy adatközpontú kultúra kialakítását, ahol az adatokhoz való hozzáférés demokratizált, és mindenki képes az adatokra támaszkodva döntéseket hozni.

Az ELT tehát nem csupán egy technikai eszköz, hanem egy stratégiai beruházás, amely lehetővé teszi a vállalatok számára, hogy maximalizálják az adatokból származó értéket, és a digitális korban is versenyképesek maradjanak.

Esettanulmányok és iparági példák az ELT alkalmazására

Az Extract, Load, Transform (ELT) adatintegrációs modell széles körben alkalmazható különböző iparágakban és szektorokban, ahol a nagy adatmennyiségek, a változatos adatforrások és a rugalmas elemzési igények kihívást jelentenek. A felhőalapú ELT megoldások lehetővé teszik a vállalatok számára, hogy mérettől függetlenül kihasználják az adatokban rejlő potenciált, optimalizálják működésüket és új üzleti lehetőségeket teremtsenek.

Az alábbiakban bemutatunk néhány esettanulmányt és iparági példát, amelyek illusztrálják az ELT gyakorlati alkalmazását és előnyeit a különböző szektorokban. Ezek a példák rávilágítanak arra, hogyan segíti az ELT a vállalatokat abban, hogy valós időben reagáljanak a piaci változásokra, személyre szabott szolgáltatásokat nyújtsanak, és mélyebb betekintést nyerjenek az üzleti folyamataikba.

Kiskereskedelem

A kiskereskedelmi szektor az egyik leginkább adatközpontú iparág, ahol az ELT kulcsfontosságú szerepet játszik:

- Ügyfélviselkedés elemzése: Egy nagy online kiskereskedő az ELT-t használja a weboldal clickstream adatok, tranzakciós adatok, közösségi média interakciók és mobilalkalmazás-használati adatok gyűjtésére. Ezeket a nyers adatokat egy adattóba töltik be, majd ott alakítják át, hogy 360 fokos képet kapjanak az ügyfelekről.

- Személyre szabott ajánlatok: Az elemzések alapján az ELT lehetővé teszi a személyre szabott termékajánlatok, célzott marketingkampányok és dinamikus árazási stratégiák kialakítását. A nyers adatok megőrzése révén a marketingcsapat folyamatosan finomíthatja algoritmusaikat.

- Készletoptimalizálás: Az ELT segít az értékesítési adatok, a készletszintek, a szezonális trendek és az ellátási lánc adatok valós idejű integrálásában. Ez lehetővé teszi a vállalatok számára, hogy pontosabban előre jelezzék a keresletet, optimalizálják a készletszinteket és minimalizálják a raktározási költségeket.

- Bolt optimalizálás: Fizikai üzletek esetén az ELT integrálhatja a POS (Point of Sale) adatokat, a kamerás felvételekből származó anonimizált mozgásadatokat és a demográfiai információkat, hogy optimalizálja az üzlet elrendezését, a termékmegjelenítést és a személyzet beosztását.

Pénzügyi szektor

A pénzügyi szolgáltatások területén az ELT elengedhetetlen a kockázatkezeléshez, a csalásészleléshez és az ügyfélkapcsolatok kezeléséhez:

- Csalásészlelés: Egy bank az ELT-t alkalmazza a tranzakciós adatok, a hitelkártya-használati minták, a belépési logok és a külső kockázati adatok valós idejű integrálására. Az adatok betöltése egy felhőalapú adattárházba történik, ahol gépi tanulási modellek elemzik azokat a csalárd tevékenységek azonosítása érdekében.

- Kockázatkezelés: A befektetési bankok az ELT segítségével gyűjtik össze a piaci adatokat, a kereskedési logokat, a portfólióadatokat és a szabályozási jelentéseket. Az adatok átalakítása és elemzése lehetővé teszi a kockázati modellek futtatását és a piaci kockázatok valós idejű monitorozását.

- Ügyfél 360 fokos nézet: Pénzügyi intézmények az ELT-t használják ügyféladatok (számlatörténet, interakciók, termékhasználat) integrálására, hogy átfogó képet kapjanak az ügyfeleikről. Ez segíti a személyre szabott pénzügyi termékek és szolgáltatások ajánlását.

- Szabályozási megfelelőség: A szigorú szabályozási követelmények (pl. MiFID II, Basel III) miatt a bankoknak képesnek kell lenniük az adatok teljes életciklusának nyomon követésére. Az ELT a nyers adatok megőrzésével és a részletes adatvonal biztosításával támogatja ezt.

Egészségügy

Az egészségügyi szektorban az ELT hozzájárul a betegellátás javításához, a kutatáshoz és az operatív hatékonysághoz:

- Klinikai adatok elemzése: Kórházak és kutatóintézetek az ELT-t használják az elektronikus egészségügyi rekordok (EHR), laboreredmények, képalkotó adatok és genetikai adatok integrálására. Az adatok egy adattóba kerülnek, ahol anonimizálják és átalakítják őket a kutatási célokra.

- Betegpopuláció-elemzés: Az ELT lehetővé teszi a betegpopulációk elemzését a betegségek terjedésének nyomon követésére, a kockázati tényezők azonosítására és a megelőző intézkedések hatékonyságának értékelésére.

- Működési hatékonyság: Az ELT segíti a kórházakat az adminisztratív adatok (pl. betegfelvétel, ágykihasználtság, személyzeti beosztás) elemzésében, hogy optimalizálják a munkafolyamatokat és csökkentsék a várakozási időt.

- Gyógyszerfejlesztés: Gyógyszeripari cégek az ELT-t alkalmazzák a klinikai vizsgálatok adatainak, a valós életbeli adatoknak (Real World Data) és a genomikai adatoknak az integrálására, felgyorsítva a gyógyszerfejlesztési folyamatot és az új terápiák felfedezését.

Gyártás

A gyártóiparban az ELT kulcsfontosságú az operatív hatékonyság, a minőségellenőrzés és az ellátási lánc optimalizálása szempontjából:

- IoT adatok elemzése: Egy autógyártó az ELT-t használja a gyártósori gépekből származó IoT szenzor adatok (hőmérséklet, nyomás, vibráció), a minőségellenőrzési adatok és a termelési logok gyűjtésére. Az adatok valós időben kerülnek betöltésre egy adattóba, ahol azonnal elemzik őket.

- Prediktív karbantartás: Az ELT lehetővé teszi a gépek állapotának valós idejű monitorozását és a hibák előrejelzését. Az adatok elemzésével a vállalatok előre jelezhetik, mikor van szükség karbantartásra, csökkentve az állásidőt és a karbantartási költségeket.

- Ellátási lánc optimalizálása: Az ELT segít az ellátási lánc adatok (beszállítói teljesítmény, logisztikai adatok, keresleti előrejelzések) integrálásában. Ez lehetővé teszi a vállalatok számára, hogy optimalizálják a készletszinteket, javítsák a szállítási határidőket és csökkentsék a költségeket.

- Minőségellenőrzés: Az ELT révén a gyártók valós időben figyelhetik a termékminőséget, azonosíthatják a hibás tételeket és gyorsan beavatkozhatnak a gyártási folyamatba a minőségi problémák orvoslására.

Ezek az esettanulmányok jól mutatják, hogy az ELT rendkívül sokoldalú és hatékony eszköz az adatokból származó érték kinyerésére, függetlenül az iparágtól. A felhőalapú ELT megoldások democratizálják az adatintegrációt, és lehetővé teszik a vállalatok számára, hogy agilisabban és intelligensebben működjenek.