A modern informatikai rendszerek alapvető követelménye az adatok magas szintű rendelkezésre állása és integritása. Ebben a kontextusban a DRBD (Distributed Replicated Block Device) egy kulcsfontosságú szoftverkomponens, amely a Linux ökoszisztémában biztosítja a blokkeszközök valós idejű replikációját. Lényegében a DRBD egy hálózaton keresztül működő RAID 1 (mirroring) implementációjaként fogható fel, amely két vagy több szerver között szinkronizálja a lemez adatokat, ezáltal magas rendelkezésre állású (HA) klaszterek építésére ad lehetőséget.

A DRBD nem egy fájlrendszer, és nem is egy adatbázis. Ehelyett egy alacsony szintű, kernel-modul alapú réteg, amely a lemez I/O műveletek alá ékelődik. Ez a pozíció teszi lehetővé számára, hogy minden egyes írási műveletet valós időben tükrözzön a klaszter másik, másodlagos csomópontjára. Abban az esetben, ha az elsődleges szerver meghibásodik, a másodlagos csomópont azonnal átveheti a szerepét, minimális vagy nulla adatvesztéssel, biztosítva a szolgáltatások folytonosságát.

Az adatreplikáció szükségessége a mai üzleti környezetben elengedhetetlen. Legyen szó kritikus adatbázisokról, fájlszerverekről, virtualizált környezetekről vagy konténeres alkalmazásokról, az adatok elvesztése vagy a szolgáltatások leállása súlyos következményekkel járhat. A DRBD pontosan erre a problémára kínál robusztus, költséghatékony és rugalmas megoldást, kihasználva a standard Linux kernel képességeit és a hálózati infrastruktúrát.

A DRBD Alapvető Működési Elve és Architektúrája

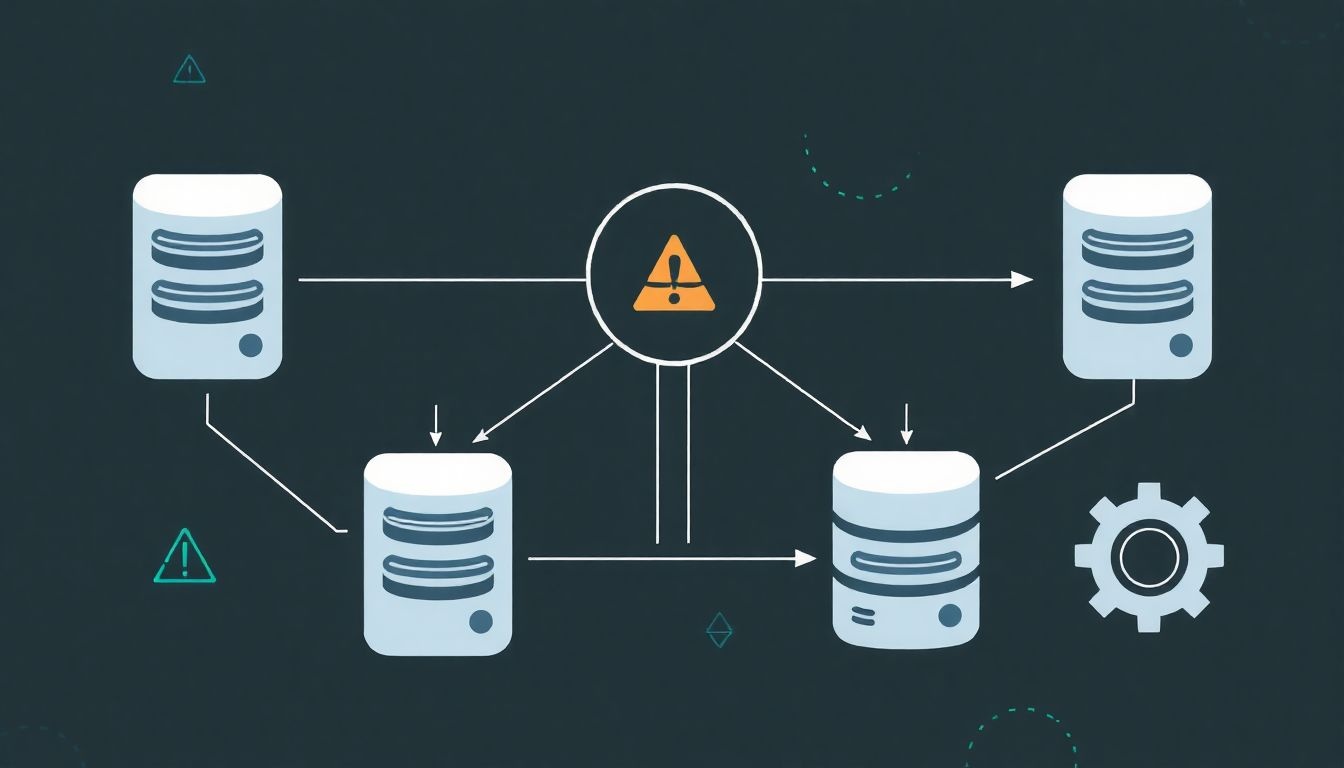

A DRBD működési elve viszonylag egyszerű, mégis rendkívül hatékony. Két (vagy több, bár a tipikus konfiguráció kettő csomópontot használ) szerverre épül, amelyek mindegyike rendelkezik egy dedikált blokkeszközzel (ez lehet fizikai lemez, RAID tömb logikai kötete, LVM logikai kötet vagy akár egy fájl). Ezeket a blokkeszközöket a DRBD „resource” néven kezeli.

Csomópontok és Szerepek

A DRBD klaszterben a csomópontoknak különböző szerepeket lehet adni:

- Primary (Elsődleges): Ez a csomópont az, amelyik aktívan hozzáfér a DRBD erőforráshoz, és írási/olvasási műveleteket végez rajta. Minden írási műveletet replikál a másodlagos csomópontra. Egy adott időpontban általában csak egy elsődleges csomópont létezik, különösen fájlrendszerek esetében.

- Secondary (Másodlagos): Ez a csomópont a replikált adatok passzív tárolója. Nem végez írási műveleteket az erőforráson, hanem csak fogadja és tárolja az elsődleges csomóponttól érkező adatokat. Ha az elsődleges meghibásodik, a másodlagos csomópontot lehet elsődlegessé előléptetni.

Létezik egy harmadik szerep is, a Diskless, ahol a csomópontnak nincs helyi lemeze az adott erőforráshoz, csak hálózaton keresztül kommunikál a többivel. Ez ritkább, speciális esetekben használatos.

Erőforrások (Resources)

A DRBD-ben az „erőforrás” az a konfigurációs egység, amely a replikálni kívánt blokkeszközt, a hálózati beállításokat és egyéb paramétereket definiálja. Minden erőforrásnak van egy neve (pl. `r0`, `data`). Egy szerveren több DRBD erőforrás is futhat párhuzamosan, mindegyik a saját dedikált blokkeszközével.

Állapotok (States)

A DRBD erőforrások különböző állapotokban lehetnek, amelyek jelzik a replikáció aktuális helyzetét:

- UpToDate: Az adatok teljesen szinkronban vannak a két csomópont között. Ez a kívánatos állapot.

- Outdated: Az adatok nincsenek szinkronban, például egy hálózati hiba vagy a másodlagos csomópont leállása miatt.

- EstablishingSync: A kezdeti szinkronizálás vagy egy újraszinkronizálás van folyamatban.

- Inconsistent: Az adatok konzisztenciája nem garantált, például egy sikertelen szinkronizáció vagy egy erőforrás szerepváltása után, mielőtt az adatok teljesen helyreálltak volna.

A DRBD kernel modul a VFS (Virtual File System) réteg alá illeszkedik, ami azt jelenti, hogy a fájlrendszerek és az alkalmazások számára egy szabványos blokkeszközként jelenik meg. Amikor egy alkalmazás írási kérést küld a DRBD eszközre, a DRBD kernel modul elfogja azt, elvégzi a helyi lemezen az írást, majd hálózaton keresztül elküldi a másodlagos csomópontnak. A másodlagos csomópont is elvégzi a helyi lemezére az írást, és visszajelzést küld az elsődlegesnek. Csak ezt követően nyugtázza az elsődleges csomópont az írási műveletet az alkalmazás felé. Ez biztosítja az adatok konzisztenciáját a replikáció során.

Replikációs Módok a DRBD-ben: A, B és C

A DRBD a hálózati replikációhoz három különböző módot kínál, amelyek az adatbiztonság és a teljesítmény közötti kompromisszumot tükrözik. A választás az adott alkalmazás igényeitől és a hálózati infrastruktúra képességeitől függ.

Protokoll A: Aszinkron replikáció

Ebben a módban az elsődleges csomópont azonnal nyugtázza az írási műveletet az alkalmazás felé, amint az adatokat elküldte a hálózaton keresztül a másodlagos csomópontnak, anélkül, hogy megvárná a másodlagos csomópont visszaigazolását. Ez a leggyorsabb replikációs mód, mivel az írási késleltetés minimális.

- Előnyök: Nagyon alacsony írási késleltetés az elsődleges csomóponton. Ideális WAN (széles hálózat) környezetekbe, ahol a hálózati késleltetés magas.

- Hátrányok: Adatvesztés kockázata az elsődleges csomópont váratlan meghibásodása esetén. Ha az elsődleges csomópont összeomlik, mielőtt a másodlagos megkapta és lemezre írta volna az adatokat, azok elveszhetnek. Ezért nem garantálja a nulla adatvesztést.

- Használat: Kevésbé kritikus adatokhoz, vagy ahol a sebesség a legfontosabb, és némi adatvesztés megengedett.

Protokoll B: Fél-szinkron replikáció

Ez a mód kompromisszumot jelent a sebesség és az adatbiztonság között. Az elsődleges csomópont megvárja a másodlagos csomópont visszaigazolását arról, hogy az adatokat megkapta és a hálózati pufferbe írta, de még nem feltétlenül írta ki a lemezre. Csak ezután nyugtázza az írási műveletet az alkalmazás felé.

- Előnyök: Jobb adatbiztonság, mint az aszinkron mód, kevesebb adatvesztés kockázata. Még mindig viszonylag jó teljesítmény.

- Hátrányok: Magasabb írási késleltetés, mint az aszinkron mód. Egy nagyon gyors leállás esetén, amikor az adat még a másodlagos csomópont memóriájában van, de nem került lemezre, adatvesztés még előfordulhat.

- Használat: Általánosan nem javasolt, mivel a Protocol C jobb biztonságot nyújt minimális plusz késleltetésért cserébe, vagy Protocol A jobb teljesítményt nyújt, ha az adatvesztés megengedett.

Protokoll C: Szinkron replikáció

Ez a legbiztonságosabb replikációs mód. Az elsődleges csomópont csak akkor nyugtázza az írási műveletet az alkalmazás felé, ha a másodlagos csomópont visszaigazolta, hogy az adatokat sikeresen lemezre írta. Ez garantálja a nulla adatvesztést (RPO=0) az elsődleges csomópont meghibásodása esetén.

- Előnyök: Garantálja a nulla adatvesztést. A legmagasabb adatbiztonságot nyújtja.

- Hátrányok: A legmagasabb írási késleltetés, mivel a hálózati késleltetés és a másodlagos csomópont lemez I/O sebessége befolyásolja az elsődleges csomópont írási teljesítményét. Nem ideális nagy hálózati késleltetésű környezetben.

- Használat: Kritikus alkalmazásokhoz, adatbázisokhoz, virtuális gépekhez, ahol az adatvesztés elfogadhatatlan. A leggyakrabban használt protokoll HA környezetekben.

A protokoll kiválasztása kulcsfontosságú a DRBD implementáció tervezésekor. A legtöbb magas rendelkezésre állású alkalmazás a Protokoll C-t részesíti előnyben az adatbiztonság miatt, még akkor is, ha ez némi teljesítménybeli kompromisszummal jár.

DRBD Konfiguráció és Kezelés

A DRBD konfigurációja egy szöveges fájlban történik, jellemzően a `/etc/drbd.d/` könyvtárban, több fájlra bontva, vagy egyetlen fájlban, a `/etc/drbd.conf` fájlban. A konfiguráció definiálja az erőforrásokat, a hálózati beállításokat, a replikációs protokollt és egyéb viselkedési paramétereket.

Példa DRBD Konfigurációra

Egy egyszerű kétcsomópontos konfiguráció:

resource r0 {

device /dev/drbd0;

disk /dev/sdb1;

meta-disk internal;

on node1 {

address 192.168.1.10:7788;

}

on node2 {

address 192.168.1.11:7788;

}

protocol C;

}

- `resource r0`: Egy erőforrást definiál ‘r0’ néven.

- `device /dev/drbd0`: A DRBD által létrehozott logikai blokkeszköz, amit az alkalmazások használni fognak.

- `disk /dev/sdb1`: Az alapul szolgáló fizikai blokkeszköz az adott szerveren.

- `meta-disk internal;`: A DRBD metaadatok tárolási helye. Az ‘internal’ azt jelenti, hogy az adatokkal azonos fizikai lemezen, de egy különálló, a lemez végén található területen tárolódnak. Lehet ‘external’ is, ami egy külön dedikált partíciót vagy lemezt jelent.

- `on node1 { … }` és `on node2 { … }`: Meghatározza a csomópont-specifikus beállításokat, mint például a hálózati IP cím és port.

- `protocol C;`: Meghatározza a szinkron replikációs protokollt.

DRBD Parancsok

A DRBD kezelésére a `drbdadm` parancssori eszköz szolgál, amely a konfigurációs fájlok alapján végzi el a műveleteket. Néhány alapvető parancs:

- `drbdadm create-md

`: Létrehozza az erőforrás metaadatait. Ezt minden csomóponton futtatni kell az első használat előtt. - `drbdadm up

`: Aktiválja az erőforrást. - `drbdadm primary

–force`: Az erőforrást elsődlegessé teszi. A `–force` opcióval kényszeríthető, ha a másik csomópont nem elérhető. - `drbdadm secondary

`: Az erőforrást másodlagossá teszi. - `drbdadm connect

`: Csatlakoztatja az erőforrást a távoli csomóponthoz. - `drbdadm disconnect

`: Lekapcsolja az erőforrást a távoli csomópontról. - `drbdadm down

`: Deaktiválja az erőforrást. - `drbdadm status`: Megjeleníti az összes DRBD erőforrás aktuális állapotát. Ez a leggyakrabban használt parancs a DRBD klaszter állapotának ellenőrzésére.

- `drbdadm initial-sync

`: Elindítja a kezdeti teljes szinkronizációt. Ezt az elsődleges csomóponton kell futtatni, miután mindkét oldalon létrejöttek a metaadatok és az erőforrás fel van kapcsolva.

A DRBD Szerepe a Magas Rendelkezésre Állásban (HA)

A DRBD önmagában egy blokkeszköz replikációs mechanizmus, de a valós magas rendelkezésre állású rendszerekhez klaszterkezelő szoftverre is szükség van. A leggyakoribb és leginkább elterjedt megoldás a Pacemaker és Corosync kombinációja.

Pacemaker és Corosync Integráció

- Corosync: Egy klaszter kommunikációs motor, amely biztosítja a csomópontok közötti üzenetküldést, klasztertagság kezelését és a kvórum (döntési képesség) fenntartását.

- Pacemaker: Egy erőforrás-kezelő, amely figyeli a klaszter csomópontjainak és erőforrásainak állapotát. Meghibásodás esetén képes automatikusan átadni (failover) az erőforrásokat egy másik, működő csomópontra, és elindítani a kapcsolódó szolgáltatásokat.

A Pacemaker a DRBD-t egy szabványos erőforrásként kezeli. A Pacemaker konfigurációban definiálni kell egy DRBD erőforrást, amely figyeli a DRBD eszköz szerepét (primary/secondary) és állapotát. Meghatározhatók függőségek is, például hogy egy fájlrendszer csak akkor csatolható fel, ha az alatta lévő DRBD eszköz elsődleges szerepben van.

Amikor az elsődleges csomópont meghibásodik, a Pacemaker észleli a problémát, és a következő lépéseket teszi:

- Észleli az elsődleges csomópont elérhetetlenségét.

- Meghatározza, hogy a másodlagos csomópontnak kell átvennie a szerepet.

- Előlépteti a másodlagos DRBD erőforrást elsődlegessé (`drbdadm primary

`). - Felcsatolja a fájlrendszert a most már elsődleges DRBD eszközre.

- Elindítja a kapcsolódó szolgáltatásokat (pl. adatbázis szerver, web szerver).

Ez a folyamat teljesen automatikus, minimalizálva a leállás idejét (downtime).

Katasztrófa-helyreállítás (Disaster Recovery)

Bár a DRBD elsősorban a helyi, magas rendelkezésre állásra fókuszál (általában LAN-on belül), bizonyos konfigurációkkal, mint például a DRBD Proxyval, kiterjeszthető WAN-on keresztüli katasztrófa-helyreállítási (DR) megoldásokhoz is. A DRBD Proxy puffereli az adatokat, csökkentve a késleltetés hatását a WAN kapcsolaton keresztül, és lehetővé teszi a Protocol C használatát távoli helyszínek között is, ahol a közvetlen szinkron replikáció túl lassú lenne.

A DRBD a Linux alapú, magas rendelkezésre állású architektúrák sarokköve, amely a blokkszintű adatreplikációval biztosítja a kritikus szolgáltatások folyamatos működését, minimalizálva az adatvesztést és a leállási időt még súlyos hardverhibák esetén is.

Fejlettebb DRBD Funkciók és Használati Esetek

A DRBD nem csupán egy egyszerű tükrözési megoldás. Számos fejlett funkcióval rendelkezik, amelyek rugalmasabbá és robusztusabbá teszik a komplex rendszerekben való alkalmazását.

Multi-Minor

A Multi-Minor funkció lehetővé teszi, hogy több DRBD erőforrás is osztozzon ugyanazon a fizikai diszken vagy partíción. Ez akkor hasznos, ha egyetlen fizikai tárolón belül több logikai egységet szeretnénk replikálni, de a konfigurációjuk vagy a használatuk eltérő. Például, ha egy LVM logikai kötetcsoport (VG) van az alapul szolgáló diszken, és ebből a VG-ből több LV-t (Logical Volume) szeretnénk DRBD-vel replikálni, akkor minden LV-hez létrehozhatunk egy külön DRBD erőforrást, amelyek mindegyike Multi-Minor módban fut. Ez segít az erőforrások izolálásában és a rugalmasabb kezelésben.

DRBD Proxy

Ahogy korábban említettük, a DRBD Proxy egy kiegészítő komponens, amely a DRBD adatáramlásának pufferelésére szolgál, különösen nagy késleltetésű WAN környezetekben. A Proxy-t a DRBD csomópontok és a WAN hálózat közé telepítik. Az elsődleges DRBD csomópont a Proxy-nak küldi az adatokat, a Proxy pedig puffereli és továbbítja a távoli, másodlagos DRBD csomópontnak. Ez lehetővé teszi a Protokoll C (szinkron) replikáció használatát is WAN-on keresztül, mivel a helyi DRBD csomópont a Proxy-tól kap gyors visszaigazolást, minimalizálva a késleltetés hatását az alkalmazásokra. Ezáltal a DRBD alkalmassá válik katasztrófa-helyreállítási célokra is, földrajzilag távoli adatközpontok között.

DRBD Reactor

A DRBD Reactor egy eseményvezérelt keretrendszer, amely lehetővé teszi, hogy a DRBD állapotváltozásaira (pl. kapcsolatvesztés, szinkronizáció befejezése) automatizált szkripteket futtassunk. Ez a funkció növeli a DRBD rendszer automatizálhatóságát és kezelhetőségét, lehetővé téve egyedi reakciók beállítását kritikus eseményekre.

DRBD és Fájlrendszerek

A DRBD blokkeszközökön működik, így bármilyen fájlrendszer felépíthető rájuk. A leggyakoribb választások a következők:

- Ext4, XFS: Ezek a naplózó fájlrendszerek jól működnek DRBD felett. Fontos, hogy egy adott időpontban csak az elsődleges csomópont csatolja fel a fájlrendszert (aktív-passzív konfiguráció).

- GFS2, OCFS2: Ezek a klaszter fájlrendszerek lehetővé teszik, hogy több csomópont egyszerre csatolja fel és írja ugyanazt a fájlrendszert (aktív-aktív konfiguráció). Ehhez a DRBD-nek is aktív-aktív módban kell futnia (lásd alább a dual-primary módot), ami komplexebb konfigurációt és fokozott figyelmet igényel a konzisztencia fenntartására.

Dual-Primary Mód

Alapértelmezés szerint a DRBD egy aktív-passzív konfigurációt támogat, ahol csak egy csomópont lehet elsődleges. A Dual-Primary mód (két elsődleges) lehetővé teszi, hogy mindkét csomópont egyszerre legyen elsődleges, azaz mindkettő írási/olvasási műveleteket végezhet ugyanazon a DRBD erőforráson. Ez a mód csak akkor használható biztonságosan, ha egy klaszter fájlrendszer, mint például a GFS2 vagy az OCFS2 van a DRBD eszközön. Ezek a fájlrendszerek képesek kezelni a párhuzamos írási hozzáféréseket és a gyorsítótárak konzisztenciáját. Dual-primary mód nélkül a fájlrendszer korrupciója garantált lenne, ha mindkét csomópont írna ugyanarra a blokkra anélkül, hogy tudnának egymásról.

DRBD és Virtualizáció

A DRBD kiválóan alkalmas virtualizált környezetekben való használatra, például KVM vagy Xen alapú hypervisorokkal. A virtuális gépek lemezképei (QCOW2, RAW) tárolhatók DRBD eszközökön, biztosítva a magas rendelkezésre állást a virtuális gépek számára. Ha a hypervisor meghibásodik, a virtuális gép lemezképe gyorsan elérhetővé válik egy másik hypervisoron, és a VM újraindítható.

Split-Brain Jelenség és Fencing Mechanizmusok

A „split-brain” (szétesett agy) jelenség az egyik legkritikusabb probléma, amellyel egy elosztott rendszerben szembe kell nézni, és a DRBD klaszterekben is előfordulhat. Akkor jön létre, ha a két DRBD csomópont elveszíti a hálózati kapcsolatot egymással, de mindkettő úgy hiszi, hogy a másik csomópont meghibásodott, és ezért mindkettő megpróbálja átvenni az elsődleges szerepet és írni az adatokra. Ez adatinkonzisztenciához és adatvesztéshez vezethet, mivel mindkét csomópont egymástól függetlenül módosítja ugyanazokat az adatblokkokat.

A Split-Brain Okai

- Hálózati Hiba: A leggyakoribb ok. A két csomópont közötti hálózati kapcsolat megszakad.

- Túlzott Terhelés: Extrém terhelés alatt a csomópontok annyira leterheltté válhatnak, hogy nem tudnak időben kommunikálni, és tévesen úgy érzékelik, hogy a másik csomópont elérhetetlen.

- Konfigurációs Hiba: Helytelen DRBD vagy klasztermenedzser konfiguráció.

Split-Brain Megelőzése és Kezelése

A DRBD számos mechanizmust kínál a split-brain megelőzésére és kezelésére:

- Auto-fencing: A DRBD képes automatikusan „fencingelni” (elkeríteni) a problémás csomópontot. Ha a DRBD észleli a split-braint, azonnal leállítja az egyik csomóponton az I/O műveleteket, hogy megakadályozza az adatkorrupciót. Ez a `split-brain` paraméterrel konfigurálható.

- Külső Fencing Eszközök: A legrobbanabb megoldás a külső fencing, amelyet a Pacemaker/Corosync klasztermenedzserek biztosítanak. A fencing (más néven STONITH – Shoot The Other Node In The Head) lényege, hogy ha egy csomópont úgy gondolja, hogy a másik meghibásodott, akkor egy külső eszközzel (pl. távoli áramellátás kikapcsolása, IPMI, SAN kapcsoló port leállítása) fizikailag leállítja vagy elszigeteli a problémás csomópontot. Ez garantálja, hogy csak egyetlen csomópont legyen aktív és írjon az adatokra.

A split-brain helyreállítása manuális beavatkozást igényelhet, ha nem megfelelően van beállítva az automatikus fencing. A folyamat magában foglalja a „rossz” ág azonosítását (amelyik a kevesebb friss adatot tartalmazza, vagy amelyik nem volt elsődleges), és annak felülírását a „jó” ág adataival. A `drbdadm disconnect`, `drbdadm primary`, `drbdadm secondary`, `drbdadm connect` és `drbdadm –discard-my-data connect` parancsok használatával történik.

Teljesítmény és Optimalizálás

A DRBD teljesítménye számos tényezőtől függ, beleértve a hálózati sávszélességet, a lemez I/O sebességét és a DRBD konfigurációját. A Protokoll C (szinkron) használatakor az írási teljesítményt nagymértékben befolyásolja a lassabb komponens, legyen az a hálózati késleltetés vagy a másodlagos csomópont lemezének írási sebessége.

Hálózati Optimalizálás

- Dedikált Hálózat: Erősen ajánlott egy dedikált Gigabit Ethernet vagy 10 Gigabit Ethernet hálózat a DRBD replikációhoz. Ez elkerüli a hálózati forgalom torlódását, ami befolyásolhatja a replikáció sebességét.

- MTU Beállítások: A Jumbo Frame-ek (nagyobb MTU méret, pl. 9000 byte) használata csökkentheti a CPU terhelést és növelheti az átviteli sebességet, de csak akkor, ha az összes hálózati eszköz (NIC, switch) támogatja.

- TCP Tuning: A Linux TCP/IP stack finomhangolása (pl. nagyobb TCP ablakméretek) javíthatja a WAN-on keresztüli teljesítményt.

Lemez I/O Optimalizálás

- Gyors Lemezek: Használjon gyors SSD-ket vagy nagy teljesítményű SAS/NVMe lemezeket az alapul szolgáló blokkeszközökhöz.

- RAID Konfiguráció: Ha RAID-et használ, győződjön meg róla, hogy az optimálisan van konfigurálva az I/O igényekhez (pl. RAID 10 nagy teljesítményt és redundanciát nyújt).

- I/O Scheduler: Kísérletezzen a különböző I/O ütemezőkkel (pl. `noop`, `deadline`, `cfq`, `mq-deadline`). A `noop` vagy `deadline` gyakran jó választás SSD-k és RAID vezérlők esetén.

- Write Cache: Győződjön meg róla, hogy a lemezvezérlőn az írási gyorsítótár be van kapcsolva és akkumulátorral védett (BBWC), különösen Protokoll C esetén.

DRBD Specifikus Optimalizálás

- `c-plan-ahead` és `c-fill-target` paraméterek: Ezek a paraméterek a DRBD belső puffereinek méretét és viselkedését szabályozzák, befolyásolva a szinkronizáció sebességét és a háttérben futó írások pufferelését. Finomhangolásuk segíthet a teljesítmény növelésében.

- `max-buffers` és `max-epoch-size`: Ezek a paraméterek a memóriahasználatot és a hálózati forgalmat befolyásolják.

- `resync-rate`: A szinkronizáció sebességét korlátozza. Érdemes beállítani, hogy a resync ne vegye el az összes hálózati sávszélességet a normál replikációtól, de elég gyors legyen a helyreállításhoz.

Gyakori Hibák és Hibaelhárítás

A DRBD robusztus, de mint minden komplex rendszer, hibákba ütközhet. Az alábbiakban néhány gyakori probléma és azok elhárítása található:

Split-Brain Helyreállítása

Ha a `drbdadm status` kimenetben `Split-Brain` állapotot lát, azonnal cselekedni kell.

A helyreállítás lépései:

- Állapítsa meg, melyik csomóponton van a „jó” adat, azaz melyik volt az elsődleges, és melyik a „rossz” ág. Ezt általában a `drbdadm status` kimenetben látható `al-extents` (allocated extents) száma, vagy a fájlrendszeren lévő adatok utolsó módosítási ideje alapján lehet eldönteni.

- A „rossz” ágon lévő csomóponton futtassa: `drbdadm secondary

` (ha még nem az), majd `drbdadm disconnect `. - A „jó” ágon lévő csomóponton győződjön meg róla, hogy az elsődleges: `drbdadm primary

`. - A „rossz” ágon lévő csomóponton futtassa: `drbdadm –discard-my-data connect

`. Ez arra utasítja a DRBD-t, hogy a helyi adatait dobja el, és szinkronizáljon a „jó” ágról. - Ellenőrizze az állapotot: `drbdadm status`. Látnia kell a szinkronizációs folyamatot.

Szinkronizációs Problémák

Ha a DRBD erőforrás `EstablishingSync` vagy `Outdated` állapotban marad, az szinkronizációs problémára utal.

- Hálózati Kapcsolat: Ellenőrizze a hálózati kapcsolatot a két csomópont között (ping, netcat a DRBD portra). Győződjön meg róla, hogy a tűzfal szabályok engedélyezik a DRBD kommunikációt (alapértelmezett port: 7788).

- Lemezhiba: Ellenőrizze az alapul szolgáló lemezek állapotát mindkét csomóponton (`dmesg`, `smartctl`). Egy lemezhiba megakadályozhatja a szinkronizációt.

- `resync-rate` korlát: Ha a `resync-rate` túl alacsonyra van állítva, a szinkronizáció nagyon lassan haladhat.

- Metaadatok Korrupciója: Ritkán előfordulhat, hogy a metaadatok megsérülnek. Ekkor újra kell létrehozni a metaadatokat (`drbdadm create-md

`), ami teljes újraszinkronizációt von maga után.

Konzisztencia Problémák Fájlrendszereken

Ha a fájlrendszer korrupttá válik a DRBD eszközön, az gyakran a nem megfelelő failover vagy a split-brain kezelés hiányának következménye.

- `fsck` futtatása: A fájlrendszer felcsatolása előtt futtasson `fsck`-t a DRBD eszközön (`fsck /dev/drbdX`). Ez segíthet az adatok helyreállításában, de nem garantálja a teljes sértetlenséget, ha az adatvesztés jelentős.

- Fencing Biztosítása: A legfontosabb a megfelelő fencing mechanizmusok beállítása a klaszterkezelőben, hogy elkerülje a split-braint, ami a fájlrendszer korrupciójának elsődleges oka.

Alternatívák és Összehasonlítás

Bár a DRBD kiváló megoldás a blokkszintű adatreplikációra Linux környezetben, fontos megérteni a helyét a szélesebb tárolási ökoszisztémában, és összehasonlítani más technológiákkal.

Hardveres Replikáció

Sok SAN (Storage Area Network) rendszer beépített hardveres replikációs funkciókat kínál. Ezek általában a tárolóvezérlő szintjén működnek, és rendkívül gyorsak és megbízhatóak lehetnek.

- Előnyök: Gyakran magasabb teljesítmény, gyártói támogatás, egyszerűbb kezelhetőség a végfelhasználó számára, mivel a tároló kezeli a replikációt.

- Hátrányok: Jelentősen drágább, gyártóhoz kötött, kevésbé rugalmas a hardverválasztásban, és a klaszterkezelés továbbra is szoftveres réteget igényelhet.

A DRBD költséghatékony alternatívát kínál a hardveres replikációhoz, különösen kisebb és közepes méretű vállalatok számára, vagy ahol a nyílt forráskódú megoldások preferáltak.

Szoftveres RAID (mdadm)

A Linux `mdadm` eszköze lehetővé teszi a szoftveres RAID tömbök (pl. RAID 1, RAID 5, RAID 6) létrehozását. Ez is biztosít redundanciát, de helyben, egyetlen szerveren belül.

- Előnyök: Olcsó, beépített a Linux kernelbe, helyi redundanciát biztosít.

- Hátrányok: Nem nyújt klaszterszintű magas rendelkezésre állást. Ha a szerver meghibásodik, az adatok nem érhetők el. A DRBD a hálózaton keresztül kiterjeszti ezt a redundanciát több szerverre.

Elosztott Fájlrendszerek és Objektumtárolók (Ceph, GlusterFS)

Az olyan technológiák, mint a Ceph vagy a GlusterFS, elosztott tárolási megoldásokat kínálnak, amelyek több szerveren terjesztik szét az adatokat, és magas rendelkezésre állást és skálázhatóságot biztosítanak.

- Előnyök: Skálázhatóság (petabájtos méretekig), magas rendelkezésre állás több csomópont felett, automatikus öngyógyítás, fájl- és/vagy objektumtárolás.

- Hátrányok: Komplexebb telepítés és kezelés, nagyobb rendszererőforrás-igény, gyakran magasabb késleltetés a blokkszintű hozzáféréshez képest. A Ceph képes blokkeszközt is emulálni (RBD), de alapvetően egy elosztott tárolórendszer, nem egy egyszerű, kétcsomópontos replikációs mechanizmus.

A DRBD a blokkszintű replikációra specializálódott, kétcsomópontos, aktív-passzív HA klaszterekhez ideális. Egyszerűbb, gyorsabb és kevesebb erőforrást igényelhet, mint egy teljes elosztott tárolórendszer, ha a cél csak két szerver közötti adat tükrözése.

Adatbázis Replikáció (pl. PostgreSQL Streaming Replication, MySQL Replication)

Sok adatbázisrendszer saját beépített replikációs mechanizmusokkal rendelkezik.

- Előnyök: Adatbázis-specifikus optimalizációk, logikai replikáció (ami rugalmasabb lehet bizonyos esetekben), gyakran egyszerűbb a beállítás az adott adatbázishoz.

- Hátrányok: Csak az adatbázis adatait replikálja, nem az egész blokkeszközt (pl. bináris fájlok, konfigurációs fájlok). Nehezebb lehet a failover automatizálása és az adatbázison kívüli alkalmazásokkal való integráció.

A DRBD alacsonyabb szinten működik, így bármilyen alkalmazás vagy fájlrendszer számára biztosítja a redundanciát, nem csak az adatbázisoknak. Gyakran használják együtt adatbázis replikációval, ahol a DRBD az alapul szolgáló lemezt tükrözi, míg az adatbázis replikáció a logikai konzisztenciát biztosítja az alkalmazásszinten.

Összességében a DRBD egy rendkívül specifikus, de rendkívül hatékony szerepet tölt be a Linux alapú infrastruktúrákban: a blokkszintű adatok valós idejű, hálózati replikációját. Költséghatékonysága, stabilitása és a Pacemaker/Corosync klaszterkezelőkkel való szoros integrációja miatt továbbra is az egyik legnépszerűbb választás a magas rendelkezésre állású Linux klaszterek építéséhez.