A DataOps egy olyan megközelítés az adatinfrastruktúra-kezelésben, amely az agilis szoftverfejlesztés, a DevOps és a lean gyártás elveit ötvözi. Célja, hogy gyorsabbá, megbízhatóbbá és hatékonyabbá tegye az adatok áramlását a szervezeten belül, a nyers adatforrástól a felhasználókig és a döntéshozókig.

Az adatközpontú szervezetekben, ahol az adatok kulcsfontosságúak a versenyképesség szempontjából, a DataOps elengedhetetlen. A hagyományos adatinfrastruktúra-kezelési módszerek gyakran lassúak, merevek és nehezen alkalmazkodnak a változó üzleti igényekhez. A DataOps ezzel szemben automatizálja az adatfolyamatokat, lehetővé téve a csapatok számára, hogy gyorsabban reagáljanak a piaci változásokra és új lehetőségekre.

A DataOps nem csupán technológia, hanem egy kultúra és szemléletmód is. Magában foglalja az adatszakértők, a fejlesztők, az üzemeltetők és az üzleti felhasználók közötti szoros együttműködést. A DataOps elősegíti a folyamatos integrációt és a folyamatos szállítást (CI/CD) az adatinfrastruktúrában, ami azt jelenti, hogy az új adatfolyamatok és adatmódosítások gyorsan és automatikusan telepíthetők.

A DataOps céljai a következők:

- Rövidebb ciklusidő: Gyorsabbá teszi az adatok kinyerését, átalakítását és betöltését (ETL).

- Jobb adatminőség: Növeli az adatok pontosságát, teljességét és konzisztenciáját.

- Alacsonyabb költségek: Csökkenti az adatinfrastruktúra üzemeltetési költségeit.

- Nagyobb üzleti agilitás: Lehetővé teszi a szervezetek számára, hogy gyorsabban reagáljanak a piaci változásokra.

A DataOps lényege, hogy az adatok értékének maximalizálása érdekében a lehető leggyorsabban és legbiztonságosabban juttassuk el őket a felhasználókhoz.

A DataOps implementálása automatizálást, monitorozást és folyamatos fejlesztést igényel. Fontos, hogy a szervezetek megfelelő eszközöket és technológiákat válasszanak, és hogy a csapatok rendelkezzenek a szükséges készségekkel és tudással.

A DataOps nem egy egyszeri projekt, hanem egy folyamatos törekvés a jobb adatinfrastruktúra-kezelésre. Azok a szervezetek, amelyek sikeresen implementálják a DataOps-ot, jelentős versenyelőnyre tehetnek szert.

A DataOps definíciója és alapelvei

A DataOps egy agilis módszertan, mely az adatkezelési folyamatok optimalizálására összpontosít. Célja, hogy az adatok gyorsabban, megbízhatóbban és hatékonyabban jussanak el a felhasználókhoz, ezáltal segítve a döntéshozatalt és az üzleti innovációt. Lényegében a DevOps elveit alkalmazza az adatok világában.

A DataOps nem csupán egy technológia, hanem egy kultúra és szemléletmód, amely ösztönzi az együttműködést az adatmérnökök, az adattudósok és az üzleti felhasználók között. Ennek a kultúrának a része az automatizálás, a folyamatos integráció és a folyamatos szállítás (CI/CD) alkalmazása az adatokkal kapcsolatos feladatok során.

A DataOps alapelvei közé tartozik:

- Automatizálás: Az ismétlődő feladatok automatizálása csökkenti a hibákat és felgyorsítja a folyamatokat.

- Együttműködés: A különböző csapatok közötti szoros együttműködés biztosítja az adatminőséget és a relevanciát.

- Folyamatos tesztelés: Az adatok minőségének folyamatos ellenőrzése elengedhetetlen a megbízható eredményekhez.

- Verziókövetés: Az adatokkal kapcsolatos változások nyomon követése lehetővé teszi a hibák gyors azonosítását és javítását.

- Monitoring: Az adatinfrastruktúra folyamatos monitorozása biztosítja a stabilitást és a teljesítményt.

A DataOps célja, hogy az adat a lehető leggyorsabban és legbiztonságosabban jusson el a felhasználókhoz, lehetővé téve a valós idejű döntéshozatalt és az üzleti értékteremtést.

A DataOps alkalmazása jelentős előnyökkel járhat a szervezetek számára. Gyorsabbá teszi az adatvezérelt innovációt, javítja az adatminőséget, csökkenti a költségeket és növeli az üzleti agilitást. Emellett lehetővé teszi a szervezetek számára, hogy jobban kihasználják az adataikban rejlő potenciált és versenyelőnyt szerezzenek a piacon.

A DataOps gyökerei: Agile, DevOps és Lean Manufacturing

A DataOps nem a semmiből jött létre. Gyökerei mélyen ágaznak az Agile szoftverfejlesztésben, a DevOps gyakorlatokban és a Lean Manufacturing elveiben.

Az Agile módszertanok hangsúlyozzák az iteratív fejlesztést, a gyors visszajelzéseket és az ügyfélközpontúságot. Ezek az elvek a DataOps-ban is megjelennek, ahol a hangsúly az adatok gyors és hatékony átalakításán, valamint az üzleti igényekre való reagáláson van.

A DevOps automatizálja és egyszerűsíti a szoftverfejlesztési és üzemeltetési folyamatokat. A DataOps hasonló megközelítést alkalmaz az adatok kezelésére, automatizálva az adatok betöltését, transzformációját, tesztelését és telepítését. Ezáltal csökkenti a hibákat, felgyorsítja a folyamatokat és növeli az adatok megbízhatóságát.

A Lean Manufacturing a pazarlás minimalizálására és a hatékonyság maximalizálására törekszik.

A DataOps a Lean elveket alkalmazva az adatfolyamatok optimalizálására, a felesleges lépések kiküszöbölésére és az adatok értékteremtő felhasználására összpontosít. Ez a megközelítés segít az adatcsapatoknak abban, hogy gyorsabban és hatékonyabban szállítsák az üzleti értéket.

A DataOps ötvözi ezen három megközelítés legjobb gyakorlatait, hogy egy átfogó és agilis adatkezelési keretrendszert hozzon létre. Ez lehetővé teszi a szervezetek számára, hogy jobban kihasználják az adataikban rejlő lehetőségeket és versenyelőnyre tegyenek szert.

A hagyományos adatkezelés kihívásai és a DataOps válaszai

A hagyományos adatkezelési módszerek gyakran merevek és lassúak, ami komoly kihívásokat jelent a modern, adatvezérelt vállalkozások számára. A hosszadalmas fejlesztési ciklusok, a szilókban tárolt adatok és a kézi folyamatok mind hozzájárulnak a hatékonyság csökkenéséhez és a hibák számának növekedéséhez. A hagyományos megközelítések gyakran nem képesek lépést tartani az adatok mennyiségének, sebességének és változatosságának exponenciális növekedésével.

A DataOps egy agilis megközelítés, amely az adatinfrastruktúra-kezelés hatékonyságának és megbízhatóságának növelésére összpontosít. Célja, hogy automatizálja az adatfolyamatokat, csökkentse a fejlesztési időt és javítsa az adatok minőségét. A DataOps lényegében az adatokkal foglalkozó csapatok számára kínálja ugyanazt az agilitást és együttműködést, amit a DevOps a szoftverfejlesztésben.

A DataOps célja az, hogy az adatokat gyorsabban, megbízhatóbban és hatékonyabban juttassa el a felhasználókhoz.

A DataOps válasza a hagyományos adatkezelés kihívásaira a folyamatok automatizálása, a folyamatos integráció (CI) és a folyamatos szállítás (CD) bevezetése. Ez lehetővé teszi az adatcsapatok számára, hogy gyorsabban kísérletezzenek, iteráljanak és telepítsenek új adatszolgáltatásokat. Az adatinfrastruktúra kódként kezelése (Infrastructure as Code) szintén kulcsfontosságú eleme a DataOps-nak, ami lehetővé teszi az infrastruktúra automatizált létrehozását és kezelését.

A DataOps emellett nagy hangsúlyt fektet a monitoringra és az adatok minőségének ellenőrzésére. Az automatizált tesztek és a folyamatos monitoring segítségével a hibák korán felismerhetők és javíthatók, ami csökkenti a kockázatot és javítja az adatok megbízhatóságát. A DataOps nem csupán technológiai megoldás, hanem egy kulturális változás is, amely az együttműködést, a kommunikációt és a folyamatos javítást helyezi a középpontba az adatcsapatok munkájában.

A DataOps főbb komponensei: Automatizálás, Együttműködés, Monitoring

A DataOps lényege az agilitás és a gyorsaság az adatinfrastruktúra kezelésében. Ennek kulcsfontosságú elemei az automatizálás, az együttműködés és a folyamatos monitoring. Ezek együttesen teszik lehetővé, hogy az adatcsapatok gyorsabban és hatékonyabban szállítsanak értéket a vállalkozás számára.

Az automatizálás a DataOps szívében rejlik. Ide tartozik az adatok betöltésének, átalakításának és a modellek telepítésének automatizálása. Az automatizált folyamatok csökkentik a manuális hibák kockázatát, felszabadítják az adatszakértőket a rutinfeladatok alól, és lehetővé teszik a gyorsabb iterációt. Az automatizálás kiterjedhet az infrastruktúra kiépítésére is, lehetővé téve a „infrastructure as code” (IaC) megközelítést, ahol a teljes adatinfrastruktúra kódként definiálható és verziókezelhető.

Az együttműködés a DataOps másik kritikus eleme. Az adatcsapatoknak szorosan együtt kell működniük a fejlesztőkkel, az üzleti felhasználókkal és az informatikai szakemberekkel. A közös célok elérése érdekében elengedhetetlen a hatékony kommunikáció és a közös platformok használata. A DevOps-ból átvett gyakorlatok, mint például a közös kódtárak és a verziókezelés, nagyban segítik az együttműködést.

A DataOps célja, hogy az adatcsapatok ugyanolyan gyorsan és megbízhatóan tudjanak adatokkal dolgozni, mint a fejlesztők a szoftverekkel.

A monitoring nélkülözhetetlen a DataOps sikeréhez. A folyamatos monitoring lehetővé teszi az adatcsapatok számára, hogy proaktívan azonosítsák és megoldják a problémákat. A monitoring kiterjed az adatok minőségére, a folyamatok teljesítményére és az infrastruktúra állapotára. A valós idejű riasztások segítenek a gyors reagálásban, a részletes naplózás pedig lehetővé teszi a problémák mélyreható elemzését és a jövőbeli incidensek megelőzését.

A monitoring rendszeres és automatizált teszteléssel is kiegészül. Ezek a tesztek ellenőrzik az adatok pontosságát, teljességét és konzisztenciáját, biztosítva, hogy a felhasználók megbízható adatokkal dolgozhassanak. A tesztelési folyamatok automatizálása lehetővé teszi a gyorsabb ciklusidőt és a korábbi hibafelismerést.

Ezek a fő komponensek – automatizálás, együttműködés és monitoring – szorosan összefonódnak és egymást erősítik. Együttes alkalmazásuk teszi lehetővé, hogy a DataOps valódi értéket teremtsen a vállalkozás számára, gyorsabbá, hatékonyabbá és megbízhatóbbá téve az adatinfrastruktúra-kezelést.

Automatizált adatintegrációs folyamatok a DataOps-ban

A DataOps egyik központi eleme az automatizált adatintegrációs folyamatok kiépítése. Ez azt jelenti, hogy a nyers adatok kinyerése, transzformálása, betöltése (ETL) és validálása nagyrészt emberi beavatkozás nélkül, automatizáltan történik. A cél a gyorsabb és megbízhatóbb adatellátás biztosítása a felhasználók számára.

Az automatizálás lehetővé teszi a csapatok számára, hogy gyorsabban reagáljanak a változó üzleti igényekre. Ha egy új adatforrásra van szükség, vagy egy meglévő adatfolyamot módosítani kell, az automatizált folyamatok segítségével ez sokkal gyorsabban elvégezhető, mint manuális munkával.

A DataOps automatizált adatintegrációja nem csak a sebességről szól, hanem a megbízhatóságról és a reprodukálhatóságról is.

Az automatizált folyamatok használata csökkenti a hibák kockázatát. Az emberi tévedések elkerülése érdekében a folyamatok definiált szabályok szerint működnek. A verziókövetés és az automatikus tesztelés biztosítja, hogy a változtatások ne okozzanak problémákat az adatminőségben.

A DataOps módszertan a következő elemekre támaszkodik az automatizált adatintegráció során:

- CI/CD (Continuous Integration/Continuous Delivery): Az adatintegrációs kód folyamatos integrálása és telepítése.

- Infrastructure as Code (IaC): Az adatinfrastruktúra automatizált kiépítése és konfigurálása kóddal.

- Monitoring és Alerting: Az adatfolyamok folyamatos monitorozása és riasztások küldése hibák esetén.

- Adatminőség-ellenőrzés: Automatikus tesztek futtatása az adatminőség biztosítására.

Az automatizált adatintegrációs folyamatok skálázhatóak és reprodukálhatóak kell, hogy legyenek. Ez azt jelenti, hogy képesnek kell lenniük arra, hogy kezeljék a növekvő adatmennyiséget és az egyre komplexebb üzleti igényeket.

Verziókövetés és tesztelés az adatinfrastruktúrában

A DataOps keretrendszerben a verziókövetés és tesztelés kulcsfontosságú szerepet játszik az adatinfrastruktúra megbízhatóságának és minőségének biztosításában. Az adatinfrastruktúra kódként kezelése (Infrastructure as Code – IaC) lehetővé teszi, hogy az adatfolyamatokat, adatbázis-struktúrákat és egyéb adatközpontú komponenseket verziókövető rendszerekben tároljuk.

A verziókövetés, például a Git használata, lehetővé teszi az adatinfrastruktúra változásainak nyomon követését, a korábbi állapotok visszaállítását és a párhuzamos fejlesztést. Ez kritikus fontosságú a hibák gyors javításához és az adatinfrastruktúra evolúciójának kontrollált kezeléséhez.

A tesztelés az adatinfrastruktúrában nem korlátozódik a kód tesztelésére. Magában foglalja az:

- Adatminőség tesztelést: Az adatok pontosságának, teljességének és konzisztenciájának ellenőrzése.

- Teljesítmény tesztelést: Az adatinfrastruktúra skálázhatóságának és válaszadási idejének mérése.

- Biztonsági tesztelést: A sérülékenységek felderítése és a jogosulatlan hozzáférés megakadályozása.

A DataOps filozófiája szerint a tesztelésnek automatizáltnak és folyamatosnak kell lennie, beépítve a CI/CD (Continuous Integration/Continuous Delivery) folyamatokba.

Az automatizált tesztek biztosítják, hogy minden változás előtt és után a rendszer megfeleljen az elvárt követelményeknek. Például, egy új adatfolyamat implementálása előtt tesztek futtathatók annak ellenőrzésére, hogy az adatok megfelelően transzformálódnak-e, és nem okoznak-e problémákat a downstream rendszerekben.

A tesztvezérelt fejlesztés (TDD) egy másik fontos gyakorlat a DataOps-ban. Ebben az esetben a teszteket először megírjuk, majd a kódot úgy fejlesztjük, hogy az megfeleljen a teszteknek. Ez a megközelítés segít a hibák korai felismerésében és a robusztusabb adatinfrastruktúra kialakításában.

A verziókövetés és a tesztelés együttes alkalmazása lehetővé teszi az adatinfrastruktúra gyorsabb és biztonságosabb fejlesztését, valamint a hibák minimalizálását. Ezáltal az adatok megbízhatóbbak és a döntéshozatal hatékonyabb.

A DataOps pipeline: a fejlesztéstől a termelésig

A DataOps pipeline a fejlesztéstől a termelésig tartó folyamat, amely automatizálja és optimalizálja az adatok útját. Ennek célja, hogy az adatok gyorsan, megbízhatóan és hatékonyan jussanak el a felhasználókhoz, lehetővé téve a jobb döntéshozatalt és az üzleti érték növelését.

A pipeline több szakaszból áll, amelyek mindegyike kritikus szerepet játszik az adatok minőségének és elérhetőségének biztosításában.

- Fejlesztés: Itt történik az adatforrások feltérképezése, az adatok tisztítása és transzformálása, valamint az elemzési modellek létrehozása.

- Tesztelés: Az adatokat alaposan tesztelik a minőség, a pontosság és a konzisztencia szempontjából. Az automatizált tesztek elengedhetetlenek a hibák korai felismeréséhez.

- Telepítés: Az adatokat és a modelleket éles környezetbe helyezik át, ügyelve a biztonságra és a megfelelőségre.

- Monitorozás: Az adatok és a pipeline teljesítményét folyamatosan monitorozzák, hogy azonnal reagálhassanak az esetleges problémákra.

A DataOps pipeline lényege, hogy az adatkezelés egy folyamatos, iteratív folyamat legyen, nem pedig egy egyszeri feladat.

Az automatizálás kulcsfontosságú a DataOps pipeline sikeréhez. Az automatizált eszközök és folyamatok lehetővé teszik a gyorsabb fejlesztést, a kevesebb hibát és a hatékonyabb erőforrás-kihasználást.

A DataOps pipeline a változásokhoz való alkalmazkodást is támogatja. Az agilis módszertanok alkalmazásával a csapatok gyorsan reagálhatnak az üzleti igények változásaira és az új adatforrásokra.

Adatminőség biztosítása a DataOps segítségével

A DataOps kulcsfontosságú eleme az adatminőség biztosítása. A DataOps megközelítés célja, hogy az adatfolyamatokat automatizálja és felgyorsítsa, miközben folyamatosan figyeli és javítja az adatok minőségét. Ez nem csupán egy egyszeri feladat, hanem egy folyamatos, iteratív folyamat, amely beépül az adatkezelési ciklusba.

A DataOps keretrendszerén belül az adatminőség biztosításának több aspektusa is van:

- Adatprofilozás: Az adatok szerkezetének, tartalmának és minőségének feltárása. Ez segít az anomáliák, hiányzó értékek és inkonzisztenciák azonosításában.

- Adattisztítás: Az adatok javítása és korrigálása, beleértve a hiányzó értékek pótlását, a hibás adatok javítását és a duplikációk eltávolítását.

- Adatvalidáció: Az adatok megfelelőségének ellenőrzése előre meghatározott szabályoknak és követelményeknek.

- Adatmonitoring: Az adatminőség folyamatos nyomon követése és figyelése, hogy időben észlelhetők legyenek a problémák.

A DataOps módszertan alkalmazása lehetővé teszi, hogy az adatminőségi problémák gyorsabban és hatékonyabban kerüljenek megoldásra. Az automatizált tesztek és a folyamatos monitoring révén a problémák már a kezdeti szakaszban felismerhetők, mielőtt azok a downstream rendszereket és elemzéseket befolyásolnák.

A DataOps nem csupán az adatok mozgatásáról szól, hanem arról is, hogy ezek az adatok megbízhatóak és használhatóak legyenek a döntéshozatalhoz.

Az adatminőség biztosítása érdekében a DataOps csapatok gyakran használnak különböző eszközöket és technikákat, mint például az adatminőségi szabályok meghatározása, az automatizált tesztek, az adatlineage követése és a verziókezelés. Ezek az eszközök és technikák lehetővé teszik, hogy az adatminőségi problémákat proaktívan kezeljék, és biztosítsák az adatok megbízhatóságát és pontosságát.

Végső soron a DataOps segítségével biztosított adatminőség lehetővé teszi a jobb üzleti döntéseket, a hatékonyabb működést és a nagyobb ügyfél elégedettséget. Az adatminőség nem csupán egy technikai kérdés, hanem egy üzleti imperatívusz, amely a DataOps segítségével hatékonyan kezelhető.

Data Governance és DataOps: Kölcsönhatások és különbségek

A Data Governance (Adatirányítás) és a DataOps két különböző, de egymással szorosan összefüggő terület az adatkezelésben. A Data Governance az adatok minőségének, biztonságának és elérhetőségének biztosítására összpontosít, meghatározva a szabályokat és eljárásokat az adatok kezelésére a szervezetben. Célja az adatokkal kapcsolatos kockázatok minimalizálása és a szabályozásoknak való megfelelés.

Ezzel szemben a DataOps az agilis adatinfrastruktúra-kezelés megvalósítására törekszik. A hangsúly itt az adatok gyors és megbízható eljuttatásán van a felhasználókhoz, automatizálva az adatokkal kapcsolatos folyamatokat, például az adatintegrációt, az adattisztítást és az adattranszformációt. A DataOps célja, hogy a fejlesztők és az adatelemzők gyorsabban és hatékonyabban dolgozhassanak az adatokkal.

A Data Governance meghatározza a „mit” és a „miért” kérdéseket (pl. milyen adatok gyűjthetők, hogyan kell azokat tárolni és felhasználni), míg a DataOps a „hogyan” kérdésre fókuszál (pl. hogyan lehet automatizálni az adatfolyamatokat, hogyan lehet gyorsan és megbízhatóan eljuttatni az adatokat a felhasználókhoz).

A Data Governance és a DataOps közötti kölcsönhatás kritikus. A Data Governance által meghatározott szabályok és eljárások befolyásolják a DataOps folyamatait. Például, ha a Data Governance előírja az adatok titkosítását, a DataOps-nak gondoskodnia kell arról, hogy az adatfolyamatok során a titkosítás automatikusan megtörténjen. Ezzel szemben a DataOps által kínált automatizálási és monitoring eszközök segíthetnek a Data Governance szabályok betartásának ellenőrzésében és az adatok minőségének javításában.

A két terület közötti fő különbség a fókuszban rejlik. A Data Governance stratégiai, míg a DataOps operatív. A Data Governance a szervezet egészére kiterjedő adatkezelési keretrendszert hoz létre, míg a DataOps a napi szintű adatfolyamatok hatékonyságát növeli. Bár különállóak, a sikeres adatközpontú szervezetek mindkét területet integrálják, hogy biztosítsák az adatok minőségét, biztonságát és elérhetőségét, miközben gyorsítják az adatokkal kapcsolatos fejlesztéseket és elemzéseket.

A DataOps technológiai eszköztára: Főbb platformok és megoldások

A DataOps sikeres megvalósításához elengedhetetlen a megfelelő technológiai eszköztár. Ezek az eszközök automatizálják, felgyorsítják és optimalizálják az adatok teljes életciklusát, a forrástól a felhasználásig. A platformok és megoldások sokfélesége lehetővé teszi a szervezetek számára, hogy a saját igényeikhez igazítsák a DataOps folyamataikat.

Az adatintegrációs platformok központi szerepet játszanak az adatok összegyűjtésében, transzformálásában és betöltésében (ETL/ELT). Ilyen platformok például az Apache Kafka, Apache Spark, vagy a felhőalapú megoldások, mint az AWS Glue vagy az Azure Data Factory. Ezek az eszközök lehetővé teszik a különböző forrásokból származó adatok egységesítését és a szükséges formátumra alakítását a további elemzésekhez.

Az adatminőség-ellenőrző eszközök biztosítják az adatok pontosságát, teljességét és konzisztenciáját. Ezek az eszközök automatizáltan futtatnak ellenőrzéseket az adatokon, és jelzik az esetleges hibákat vagy anomáliákat. Ilyen megoldások például a Great Expectations vagy a Deequ.

A DataOps eszköztárának kulcseleme a CI/CD (Continuous Integration/Continuous Delivery) pipeline-ok alkalmazása az adatinfrastruktúrában.

A verziókezelő rendszerek, mint a Git, elengedhetetlenek az adatpipeline-ok kódjának nyomon követéséhez és kezeléséhez. Lehetővé teszik a változások visszaállítását, a párhuzamos fejlesztést és a könnyű együttműködést a fejlesztők között.

A monitorozó és riasztó rendszerek folyamatosan figyelik az adatinfrastruktúra teljesítményét és a pipeline-ok működését. Értesítést küldenek, ha problémák merülnek fel, lehetővé téve a gyors beavatkozást és a leállások minimalizálását. Ilyen eszközök például a Prometheus vagy a Grafana.

Az adatkatalógusok központosítottan tárolják az adatok metaadatait, megkönnyítve az adatok felfedezését, megértését és használatát. Az adatkatagógusok segítenek a felhasználóknak megtalálni a szükséges adatokat, megérteni azok jelentését és eredetét, valamint betartani az adatkezelési szabályokat.

Végül, a felhőalapú platformok, mint az AWS, Azure vagy Google Cloud Platform, átfogó DataOps megoldásokat kínálnak, beleértve a tárolást, a számítást, az adatintegrációt és az elemzést. Ezek a platformok skálázható, rugalmas és költséghatékony infrastruktúrát biztosítanak a DataOps számára.

Felhő alapú DataOps: Előnyök és hátrányok

A felhő alapú DataOps a DataOps elveknek a felhő infrastruktúrában történő alkalmazását jelenti. Célja, hogy az adatvezérelt vállalkozások számára agilis, automatizált és együttműködő módon biztosítsa az adatinfrastruktúrát.

A felhő alapú DataOps számos előnnyel jár:

- Skálázhatóság: A felhő lehetővé teszi az adatinfrastruktúra könnyű és gyors skálázását a változó igényekhez igazodva.

- Rugalmasság: A felhő szolgáltatások széles választékát kínálja, amelyek lehetővé teszik a vállalatok számára, hogy az igényeiknek leginkább megfelelő megoldásokat válasszák.

- Költséghatékonyság: A felhőben általában csak a ténylegesen felhasznált erőforrásokért kell fizetni, ami csökkentheti az infrastruktúra költségeit.

- Automatizálás: A felhő natív automatizációs eszközei lehetővé teszik az adatfolyamatok egyszerűbb és gyorsabb kiépítését és karbantartását.

Azonban a felhő alapú DataOps-nak vannak hátrányai is:

- Biztonsági kockázatok: A felhőben tárolt adatok biztonsága kiemelt figyelmet igényel, és a vállalatoknak gondoskodniuk kell a megfelelő biztonsági intézkedések bevezetéséről.

- Komplexitás: A felhő környezet komplex lehet, és speciális szakértelmet igényel az adatinfrastruktúra megfelelő kezelése és optimalizálása.

- Vendor lock-in: A felhőszolgáltatók közötti átjárás bonyolult lehet, és a vállalatok függővé válhatnak egy adott szolgáltatótól.

A felhő alapú DataOps sikeres bevezetése gondos tervezést, megfelelő szakértelmet és a biztonsági szempontok kiemelt figyelembevételét igényli.

A felhő alapú DataOps lehetővé teszi az adatok gyorsabb és hatékonyabb feldolgozását, ami jelentősen javíthatja a vállalatok versenyképességét.

On-premise DataOps: A helyi infrastruktúra optimalizálása

A DataOps on-premise környezetben azt jelenti, hogy a helyi adatinfrastruktúrát optimalizáljuk az agilis elvek mentén. Célunk a gyorsabb, megbízhatóbb és automatizáltabb adatfolyam biztosítása a meglévő hardver és szoftver erőforrásaink felhasználásával.

Ez magában foglalja a folyamatos integráció (CI) és a folyamatos szállítás (CD) módszertanok alkalmazását az adatkörnyezetben. Gyakran kihívást jelent a legacy rendszerek integrálása, de a megfelelő tervezéssel és eszközökkel jelentős javulást érhetünk el.

A helyi DataOps implementáció során kiemelt figyelmet kell fordítani a következőkre:

- Automatizált tesztelés: Az adatkód és infrastruktúra változásainak automatikus tesztelése a hibák korai felismerése érdekében.

- Verziókezelés: Az adatfolyamok, a kód és a konfigurációk verzióinak nyomon követése.

- Monitoring és riasztás: Az adatinfrastruktúra teljesítményének folyamatos figyelése és azonnali riasztás a problémák esetén.

A helyi DataOps lehetővé teszi, hogy a vállalatok teljes mértékben kontrollálják adataikat és infrastruktúrájukat, miközben kihasználják az agilis módszertan előnyeit.

Az infrastruktúra-kódként (IaC) megközelítés alkalmazása kulcsfontosságú a helyi DataOps-ban. Ezzel a módszerrel az infrastruktúrát kódként kezeljük, ami lehetővé teszi annak automatizált létrehozását, konfigurálását és kezelését.

A megfelelő eszközök kiválasztása is kritikus fontosságú. Olyan megoldásokat kell választanunk, amelyek támogatják az automatizálást, a monitoringot és a verziókezelést a helyi környezetben.

Hibrid DataOps: A felhő és a helyi megoldások kombinálása

A DataOps megközelítésben a hibrid megoldások kulcsszerepet játszanak, lehetővé téve a szervezetek számára, hogy kihasználják a felhő és a helyi (on-premise) adatközpontok előnyeit. A hibrid DataOps nem más, mint az adatinfrastruktúra elemeinek (adatforrások, feldolgozó motorok, adatraktárak, analitikai eszközök) elosztása a felhő és a helyi környezetek között.

Ennek célja a rugalmasság növelése, a költségek optimalizálása és a biztonsági követelmények teljesítése. Például, a szenzitív adatokat helyben tárolhatjuk és dolgozhatjuk fel, míg a kevésbé érzékeny adatok elemzését a felhőben végezhetjük, kihasználva annak skálázhatóságát.

A hibrid DataOps lehetővé teszi a szervezetek számára, hogy a legjobb megoldásokat válasszák az adott feladathoz, függetlenül attól, hogy az a felhőben vagy helyben érhető el.

A hibrid DataOps megvalósítása során figyelembe kell venni a következőket:

- Adatmozgás: Hatékony és biztonságos adatátviteli mechanizmusok kialakítása a helyi és felhő rendszerek között.

- Adatintegráció: Az adatok egységes kezelése, függetlenül attól, hogy hol tárolódnak.

- Biztonság: Egységes biztonsági politika alkalmazása mindkét környezetben.

- Monitoring: Átfogó monitoring a teljes adatinfrastruktúra felett.

A konténerizáció (pl. Docker) és az orchestrációs eszközök (pl. Kubernetes) fontos szerepet játszanak a hibrid DataOps környezetekben, mivel lehetővé teszik az alkalmazások és szolgáltatások egyszerű telepítését és kezelését mind a felhőben, mind a helyi környezetekben. Ezek az eszközök segítenek az automatizálásban és a verziókezelésben, ami elengedhetetlen a DataOps agilis megközelítéséhez.

A hibrid DataOps bevezetése komplex feladat, de a jól megtervezett és implementált megoldás jelentős előnyöket hozhat a szervezetek számára, beleértve a gyorsabb adatelérést, a jobb analitikai képességeket és az alacsonyabb költségeket.

A DataOps bevezetése: Lépésről lépésre

A DataOps bevezetése nem egy egyszeri projekt, hanem egy folyamatos fejlődési út. Az első lépés a jelenlegi adatkörnyezet felmérése. Ez magában foglalja az adatok forrásainak, tárolási módjainak, feldolgozási folyamatainak és minőségének feltérképezését. Azonosítani kell a szűk keresztmetszeteket és a javításra szoruló területeket.

Ezt követően ki kell jelölni egy kísérleti projektet. Érdemes egy kisebb, jól definiált területen elkezdeni a DataOps elvek alkalmazását, ahol a siker gyorsan mérhető és demonstrálható. Ez a projekt szolgál majd a tapasztalatok gyűjtésére és a bevált gyakorlatok kialakítására.

A DataOps alapelvei közé tartozik az automatizálás. A manuális feladatok automatizálása csökkenti a hibák számát, felgyorsítja a folyamatokat és felszabadítja az erőforrásokat a stratégiai feladatokra. Automatizálni lehet például az adattisztítást, az adattranszformációt és az adatok betöltését.

A folyamatos integráció és folyamatos szállítás (CI/CD) bevezetése kulcsfontosságú. Ez azt jelenti, hogy az adatfolyamatok változtatásai automatikusan tesztelésre és telepítésre kerülnek, ami gyorsabb iterációt és kevesebb hibát eredményez.

A DataOps lényege, hogy az adatcsapatok agilisan és hatékonyan tudjanak együttműködni a különböző üzleti területekkel, hogy az adatokból gyorsan és megbízhatóan értéket lehessen teremteni.

A monitoring és a visszajelzés elengedhetetlen része a DataOps-nak. Folyamatosan figyelni kell az adatfolyamatok teljesítményét, és azonnal reagálni kell a felmerülő problémákra. A visszajelzés pedig lehetővé teszi a folyamatok folyamatos javítását és optimalizálását.

A kultúra átalakítása talán a legnagyobb kihívás. A DataOps egy együttműködő, transzparens és felelősségteljes kultúrát igényel. Ez azt jelenti, hogy az adatcsapatoknak szorosan együtt kell működniük a fejlesztőkkel, az üzemeltetőkkel és az üzleti felhasználókkal.

Végül pedig dokumentálni kell minden változást és folyamatot. A dokumentáció segíti az új munkatársak betanulását, és biztosítja, hogy a tudás ne csak egyéni szinten, hanem szervezeti szinten is elérhető legyen.

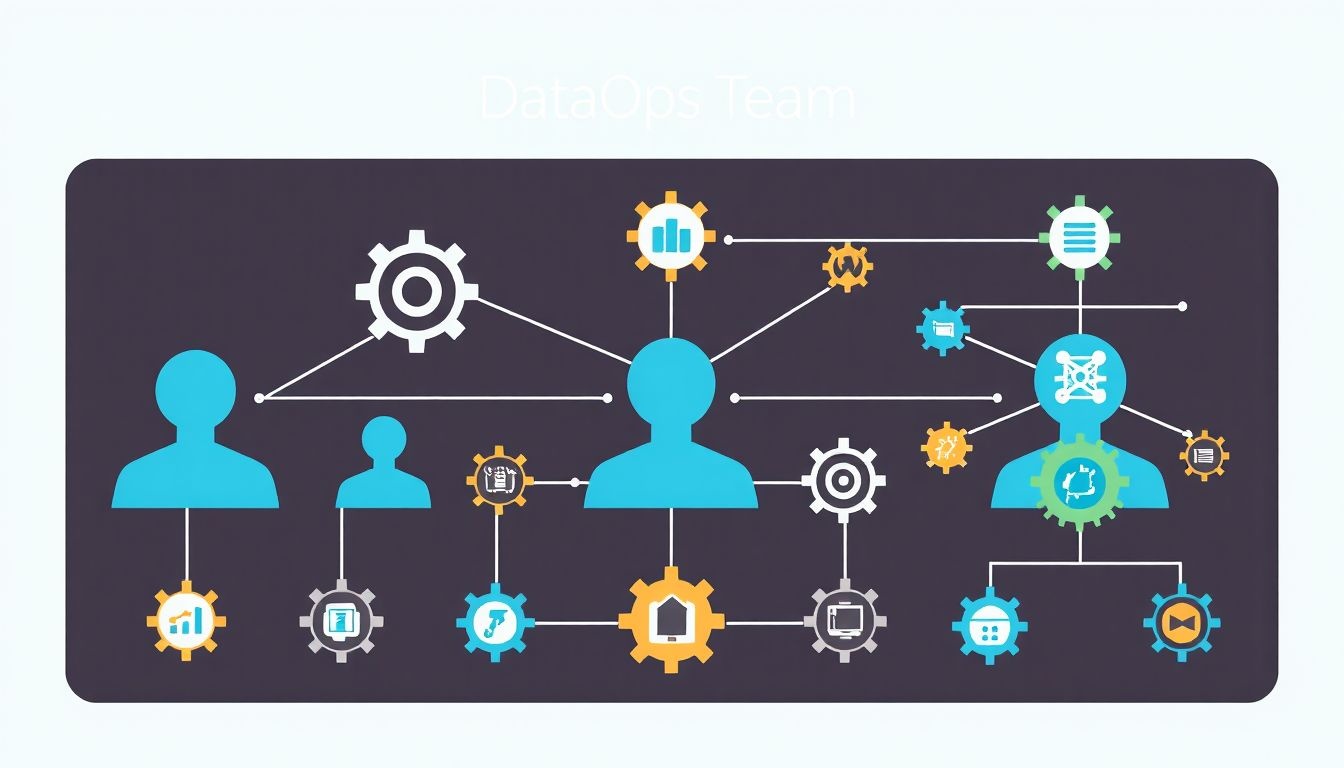

A DataOps csapat felépítése és szerepkörök

A DataOps csapat felépítése kulcsfontosságú a hatékony és agilis adatinfrastruktúra-kezeléshez. Nem létezik egyetlen, minden helyzetre alkalmazható modell, de néhány alapvető szerepkör általában megtalálható.

Ilyen például az Adatmérnök, aki felelős az adatcsatornák kiépítéséért és karbantartásáért, biztosítva az adatok megbízható és hatékony áramlását a különböző rendszerek között. Ők építik meg azokat a pipeline-okat, amelyek lehetővé teszik az adatok összegyűjtését, feldolgozását és tárolását.

Az Adattudós az adatok elemzésére és értelmezésére összpontosít, üzleti értékkel bíró következtetések levonására törekedve. Ők azok, akik a modelleket építik és validálják, hogy a döntéshozók számára hasznos információkat nyújtsanak.

A DataOps mérnök pedig a két világ közötti híd szerepét tölti be. Ő felelős az adatinfrastruktúra automatizálásáért, a folyamatok monitorozásáért és a problémák gyors elhárításáért. Ők biztosítják, hogy az adatcsatornák megbízhatóan működjenek, és az adattudósok számára a megfelelő környezet rendelkezésre álljon.

A DataOps sikeressége nagymértékben függ a csapatok közötti szoros együttműködéstől és a közös célok elérésére való törekvéstől.

Ezen felül gyakran találkozhatunk Adatbiztonsági szakértővel, aki az adatok védelméért és a megfelelőségi követelmények betartásáért felel. Valamint egy Termékmenedzserrel, aki az üzleti igények és a technikai lehetőségek közötti egyensúlyt teremti meg, biztosítva, hogy a DataOps tevékenységek a legfontosabb üzleti célokat szolgálják.

A DataOps metrikái: A siker mérése és optimalizálása

A DataOps sikerének mérése és optimalizálása kulcsfontosságú a hatékony adatinfrastruktúra-kezeléshez. A megfelelő metrikák nyomon követése lehetővé teszi a csapatok számára, hogy azonosítsák a szűk keresztmetszeteket, javítsák a folyamatokat és maximalizálják az adatértéket.

Számos metrika létezik, amelyek segítenek a DataOps teljesítményének értékelésében. Ezek a metrikák általában a következők köré csoportosulnak:

- Sebesség: Mennyi időbe telik az adatfolyamat egyes szakaszainak elvégzése? Ide tartozik az adatgyűjtés, -feldolgozás, -tesztelés és -telepítés.

- Minőség: Milyen pontosak és megbízhatóak az adatok? A minőségi metrikák közé tartozik az adatteljesítmény, az adatérvényesség és az adatkonzisztencia.

- Stabilitás: Mennyire stabil és megbízható az adatinfrastruktúra? A stabilitást mérő metrikák közé tartozik a rendelkezésre állás, a hibák száma és a helyreállítási idő.

- Költség: Mennyibe kerül az adatinfrastruktúra üzemeltetése? A költségmetrikák közé tartozik az infrastruktúra költsége, a munkaerő költsége és az energiaköltség.

A DataOps metrikák segítségével azonosíthatjuk a fejlesztési területeket, optimalizálhatjuk az erőforrásokat és biztosíthatjuk, hogy az adatok a lehető legnagyobb értéket képviseljék a szervezet számára.

Például, ha a telepítési idő túl hosszú, az a tesztelési folyamat vagy a telepítési automatizálás hiányosságaira utalhat. Ha az adatminőség alacsony, az az adatok tisztításával és validálásával kapcsolatos problémákra hívhatja fel a figyelmet.

A metrikák rendszeres nyomon követése és elemzése elengedhetetlen a DataOps sikeréhez. Az adatok alapján meghozott döntések lehetővé teszik a csapatok számára, hogy folyamatosan javítsák a folyamataikat és növeljék az adatok értékét.

Az alábbiakban néhány konkrét példa a DataOps metrikákra:

- Adatfolyamat átfutási ideje: Az adatok betöltésétől a felhasználók számára történő elérhetővé tétel időtartama.

- Tesztfedettség: A kód azon részeinek százalékos aránya, amelyeket tesztek fednek le.

- Hibák száma telepítésenként: A telepítés során felmerülő hibák száma.

- Adatok rendelkezésre állása: Az az időtartam, amikor az adatok elérhetőek a felhasználók számára.

Gyakori buktatók a DataOps bevezetése során és a megoldások

A DataOps bevezetésekor számos buktatóval találkozhatunk, melyek akadályozhatják az agilis adatinfrastruktúra kiépítését. Az egyik leggyakoribb probléma a szervezeti kultúra ellenállása. Sok vállalat ragaszkodik a hagyományos, silókban működő adatkezelési megközelítésekhez, ami nehezíti a csapatok közötti együttműködést és az automatizálást.

Egy másik jelentős kihívás a megfelelő eszközök és technológiák hiánya. A DataOps sikeres alkalmazásához szükség van a CI/CD (folyamatos integráció/folyamatos telepítés) elveit támogató szoftverekre, verziókövető rendszerekre és automatizált tesztelési keretrendszerekre. Ezek hiányában a folyamatok lassúak és hibákra hajlamosak maradnak.

A DataOps bevezetésének kulcsa a fokozatosság és a folyamatos kommunikáció.

A hiányos képzés és tudás is komoly akadályt jelenthet. A DataOps megköveteli a csapatoktól, hogy ismerjék az agilis módszertanokat, az automatizálást, a felhő alapú technológiákat és az adatbiztonsági elveket. Ha a munkatársak nem rendelkeznek a megfelelő tudással, a DataOps nem fogja a várt eredményeket hozni.

Végül, a rosszul definiált mérőszámok is problémát okozhatnak. A DataOps sikerét mérni kell, de ha a mérőszámok nem relevánsak vagy nem tükrözik a valós előrehaladást, akkor a DataOps kezdeményezés elveszítheti a lendületét.

A megoldások a következők lehetnek:

- A szervezeti kultúra megváltoztatása tréningekkel és workshopokkal, melyek a DataOps előnyeit hangsúlyozzák.

- A megfelelő eszközök és technológiák kiválasztása alapos elemzés és tesztelés után.

- A csapatok képzése külső és belső erőforrások felhasználásával.

- A mérőszámok pontos definiálása, figyelembe véve a vállalat specifikus céljait.

A DataOps jövője: Trendek és új irányok

A DataOps jövője szorosan összefonódik az adatok mennyiségének és komplexitásának növekedésével. A mesterséges intelligencia (AI) és a gépi tanulás (ML) egyre nagyobb szerepet kap a DataOps folyamatok automatizálásában, lehetővé téve az adatok hatékonyabb kezelését és elemzését. Az AI-alapú eszközök képesek az adatminőség javítására, az anomáliák felderítésére és a prediktív karbantartásra, ezáltal csökkentve a hibák kockázatát és növelve az adatok megbízhatóságát.

A felhőalapú megoldások elterjedése tovább erősíti a DataOps jelentőségét. A felhő rugalmassága és skálázhatósága lehetővé teszi az adatinfrastruktúra gyors és egyszerű kiépítését és karbantartását, minimalizálva a költségeket és növelve a hatékonyságot. A DataOps módszertan segít az adatok biztonságos és hatékony kezelésében a felhőben, biztosítva a megfelelőséget és a szabályozási követelmények betartását.

A DataOps a jövőben egyre inkább a valós idejű adatok kezelésére és elemzésére fog összpontosítani, lehetővé téve a vállalatok számára, hogy gyorsan reagáljanak a piaci változásokra és az ügyféligényekre.

Az adatbiztonság kiemelt fontosságúvá válik a DataOps keretein belül. A növekvő adatmennyiség és a komplexebb adatkezelési folyamatok miatt a vállalatoknak fokozottan kell ügyelniük az adatok védelmére a jogosulatlan hozzáférés és a kibertámadások ellen. A DataOps módszertan segíti az adatbiztonsági szabályok betartását és az adatvesztés megelőzését.

A low-code/no-code platformok megjelenése democratizálja az adathozzáférést és -elemzést, lehetővé téve a nem szakértők számára is, hogy adatokkal dolgozzanak. A DataOps keretein belül ezek a platformok segítenek az adatok integrálásában és a vizualizációk létrehozásában, ezáltal növelve az adatok értékét és az üzleti döntések hatékonyságát.

A DataOps kultúra terjedése elengedhetetlen a sikeres adatalapú működéshez. A DataOps nem csupán egy technológiai megközelítés, hanem egy szemléletmód, amely ösztönzi az együttműködést, a kommunikációt és a folyamatos fejlesztést az adatokkal dolgozó csapatok között.