Az AWS Glue egy teljes körűen menedzselt ETL (Extract, Transform, Load – Kinyerés, Átalakítás, Betöltés) szolgáltatás, amely leegyszerűsíti és automatizálja az adatok felfedezését, előkészítését és betöltését adatelemzési, gépi tanulási és adattárházas használatra. Lényegében a Glue segít abban, hogy az adatok különböző forrásokból (pl. adatbázisok, adattavak, felhőalapú tárolók) könnyedén átkerüljenek a célhelyre, ahol a felhasználók elemezhetik azokat.

A hagyományos ETL folyamatok manuális kódírást és infrastruktúra-kezelést igényelnek, ami időigényes és költséges lehet. Az AWS Glue ezt a komplexitást csökkenti azáltal, hogy automatizálja az adatfelfedezést, a séma következtetést és a kódgenerálást. A Glue Crawler nevű funkciója képes automatikusan feltérképezni az adattárakat, felismerni az adatok sémáját és metaadatokat generálni az AWS Glue Data Catalog-ban.

A Data Catalog egy központi metaadattár, amely az adatok szerkezetét, sémáját és helyét tárolja. Ez lehetővé teszi, hogy a különböző AWS szolgáltatások (pl. Amazon Athena, Amazon Redshift, Amazon EMR) könnyen hozzáférjenek az adatokhoz és értelmezzék azokat.

Az AWS Glue kulcsszerepet játszik a modern adatközpontú architektúrákban, mivel lehetővé teszi a szervezetek számára, hogy gyorsabban és hatékonyabban dolgozzanak fel és elemezzenek nagy mennyiségű adatot.

A Glue nem csupán az adatok mozgatására szolgál. Átalakítási képességei lehetővé teszik, hogy az adatokat tisztítsuk, normalizáljuk és a megfelelő formátumba hozzuk a célhelyre való betöltés előtt. Ehhez a Glue egy Apache Spark alapú ETL motort használ, amely lehetővé teszi a felhasználók számára, hogy Python vagy Scala nyelven írjanak adatátalakítási szkripteket.

A Glue kiszolgáló nélküli (serverless) szolgáltatás, ami azt jelenti, hogy a felhasználóknak nem kell aggódniuk a mögöttes infrastruktúra kiépítése és kezelése miatt. A Glue automatikusan skálázza az erőforrásokat az igényeknek megfelelően, és a felhasználók csak a ténylegesen felhasznált erőforrásokért fizetnek. Ez jelentősen csökkenti a költségeket és a működési terheket.

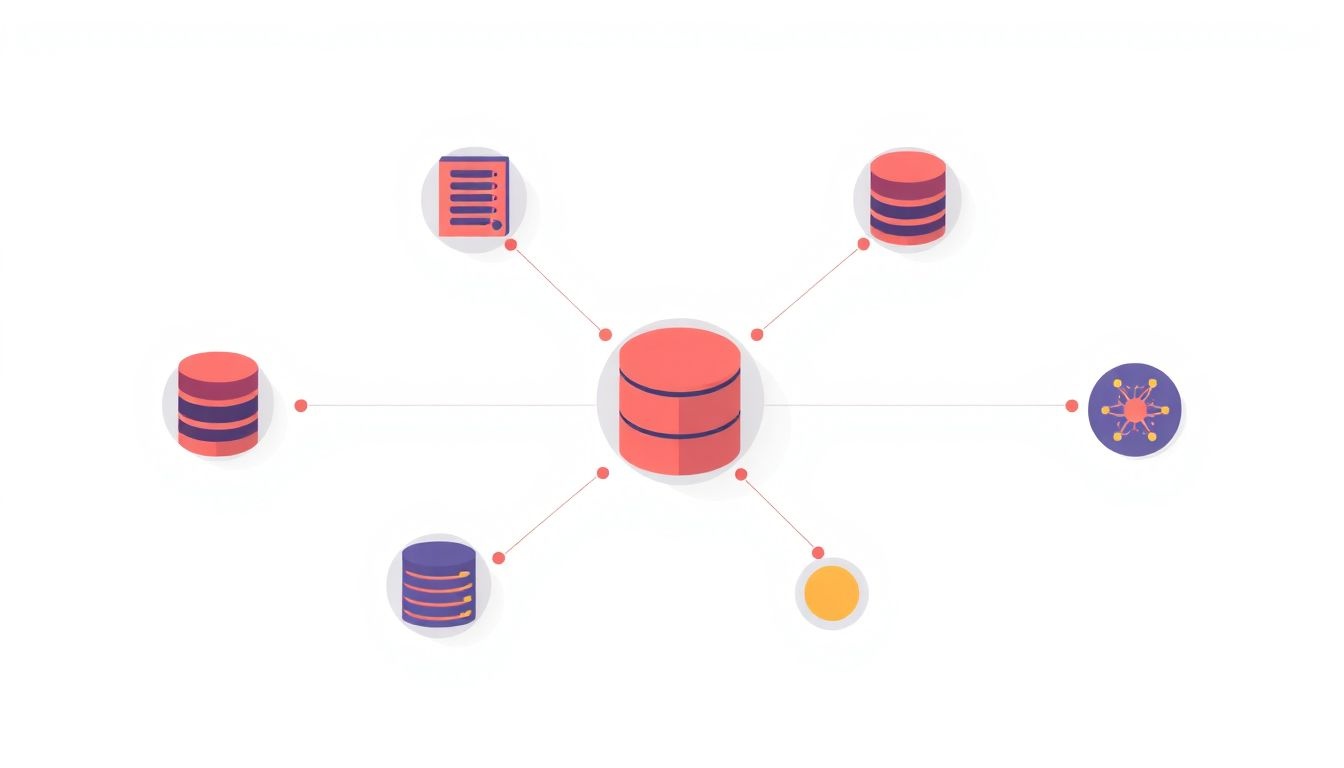

Az AWS Glue integrálódik más AWS szolgáltatásokkal, mint például az Amazon S3, Amazon Redshift, Amazon RDS, Amazon DynamoDB, és Amazon Kinesis, ezáltal egy átfogó adatintegrációs platformot biztosít.

Az AWS Glue alapvető fogalmai és architektúrája

Az AWS Glue egy teljes mértékben menedzselt ETL (Extract, Transform, Load – Kinyerés, Átalakítás, Betöltés) szolgáltatás, amely megkönnyíti az adatok felfedezését, tisztítását, gazdagítását és megbízható tárolását az adattavakban és adatbázisokban. Lehetővé teszi az adatok mozgását különböző adattárolók között, automatizálva az adatátalakítási folyamatokat.

A Glue alapvető elemei a következők:

- Data Catalog: Központi metaadat tároló, amely táblákat definiál az adatokhoz. Ez tartalmazza a tábla sémáját, fizikai helyét (pl. S3 bucket), és egyéb releváns információkat. A Data Catalog lehetővé teszi, hogy az adatokhoz egységesen, egy helyről férjünk hozzá, függetlenül attól, hogy hol vannak tárolva.

- Crawlers (feltérképezők): Ezek automatikusan felfedezik az adatokat a különböző adattárolókban (pl. S3, RDS, Redshift), és létrehozzák a megfelelő táblákat a Data Catalogban. A feltérképezők képesek automatikusan következtetni az adatok sémájára, így jelentősen csökkentve a manuális konfigurációs igényt.

- ETL Jobs: Ezek a munkák végzik el az adatok kinyerését, átalakítását és betöltését. A Glue támogatja a PySpark és a Scala nyelveket az ETL job-ok írásához. Lehetőség van vizuális interfészen keresztül is ETL folyamatokat tervezni, ami a kódolást kevésbé igénylő megoldásokat preferáló felhasználók számára előnyös.

- Triggers (indítók): Ezek határozzák meg, hogy mikor fusson egy ETL job. Indíthatók időzítetten, vagy eseményvezérelten, például egy új fájl érkezésekor egy S3 bucket-be.

Az AWS Glue egy szerver nélküli szolgáltatás, ami azt jelenti, hogy nem kell infrastruktúrát kezelnünk a futtatásához. A Glue automatikusan skálázódik a feladatok igényeihez igazodva, így csak a felhasznált erőforrásokért kell fizetnünk.

A Glue működése a következőképpen foglalható össze:

- Adatforrások meghatározása: Meg kell adnunk, hogy honnan szeretnénk kinyerni az adatokat (pl. S3, RDS, Redshift).

- Feltérképezők futtatása: A feltérképezők bejárják az adatforrásokat, és létrehozzák a táblákat a Data Catalogban.

- ETL job tervezése és implementálása: Létrehozunk egy ETL job-ot, amely meghatározza, hogyan szeretnénk átalakítani az adatokat. Ezt a job-ot PySpark vagy Scala nyelven írhatjuk meg, vagy használhatjuk a vizuális interfészt.

- ETL job futtatása: Az ETL job-ot futtatjuk, amely kinyeri az adatokat az adatforrásokból, átalakítja azokat, és betölti a cél adattárolóba.

- Monitorozás: A Glue konzolon nyomon követhetjük az ETL job-ok futását, és figyelhetjük a hibákat.

Az AWS Glue DataBrew kiegészíti a Glue-t azzal, hogy kódmentes módon teszi lehetővé az adatok előkészítését és tisztítását, vizuális interfésszel. Ez különösen hasznos adatelemzők és üzleti felhasználók számára, akik nem feltétlenül rendelkeznek mély programozási ismeretekkel.

A Glue integrálható más AWS szolgáltatásokkal, mint például az S3, Redshift, Athena és EMR, így egy átfogó adatelemzési platformot hozhatunk létre.

Az AWS Glue komponensei: Glue Data Catalog, ETL engine, és scheduler

Az AWS Glue egy teljes mértékben menedzselt ETL (Extract, Transform, Load) szolgáltatás, amely leegyszerűsíti az adatok kategóriákba rendezését, tisztítását, gazdagítását és megbízható tárolókba való áthelyezését. A Glue három fő komponensből áll, amelyek szorosan együttműködve teszik lehetővé az adatintegrációs folyamatok hatékony kezelését: a Glue Data Catalog, az ETL engine, és a scheduler.

A Glue Data Catalog egy központi metaadat-tároló, amely az adatok szerkezetét, sémáját és elhelyezkedését tartalmazza. Ez a katalógus nem csak az AWS Glue számára fontos, hanem más AWS szolgáltatások, például az Amazon Athena, az Amazon Redshift Spectrum és az Amazon EMR is használják. A Data Catalog alapvetően egy metaadat-szolgáltatás, amely lehetővé teszi, hogy az adatokkal dolgozó alkalmazások és szolgáltatások könnyen felfedezzék és megértsék az adatok tartalmát. A katalógus automatikusan felderíti az adatokat (data discovery), ami azt jelenti, hogy képes a különböző adatforrásokból származó adatok sémájának automatikus feltárására és regisztrálására. A Data Catalog fő funkciói:

- Adatforrások regisztrálása: Lehetővé teszi különböző adatforrások (pl. Amazon S3, Amazon RDS, Amazon DynamoDB) regisztrálását.

- Séma következtetés: Automatikusan felismeri az adatok sémáját, ami jelentősen csökkenti a manuális konfiguráció szükségességét.

- Adatok verziózása: Támogatja az adatok verziózását, ami lehetővé teszi a korábbi adatokhoz való hozzáférést és a változások nyomon követését.

- Keresés és felfedezés: Lehetővé teszi az adatok keresését és felfedezését, ami megkönnyíti az adatokkal való munkát.

Az ETL engine az AWS Glue szíve, amely felelős az adatok kinyeréséért, átalakításáért és betöltéséért. A Glue ETL engine a Apache Spark alapú, ami azt jelenti, hogy képes nagyméretű adathalmazok párhuzamos feldolgozására. A Glue ETL engine lehetővé teszi az egyéni ETL scriptek írását Python vagy Scala nyelven, de emellett biztosít előre definiált transzformációkat is, amelyekkel a gyakori adatintegrációs feladatok egyszerűen elvégezhetők. Az ETL engine fő jellemzői:

- Kódgenerálás: Automatikusan generál ETL scripteket a Data Catalog-ban lévő metaadatok alapján.

- Egyéni scriptek: Lehetővé teszi egyéni ETL scriptek írását Python vagy Scala nyelven, ami nagy rugalmasságot biztosít.

- Előre definiált transzformációk: Biztosít előre definiált transzformációkat a gyakori adatintegrációs feladatokhoz.

- Skálázhatóság: Képes nagyméretű adathalmazok párhuzamos feldolgozására, ami biztosítja a skálázhatóságot.

Az ETL engine kulcsfontosságú szerepet játszik az adatok minőségének javításában, a redundancia csökkentésében és az adatok megfelelő formátumba való átalakításában a célrendszer számára.

A scheduler felelős az ETL feladatok ütemezéséért és futtatásáért. A scheduler lehetővé teszi az ETL feladatok automatikus futtatását meghatározott időpontokban vagy események bekövetkeztekor. A scheduler integrálva van az AWS CloudWatch Events szolgáltatással, ami lehetővé teszi az ETL feladatok eseményvezérelt futtatását. A scheduler fő funkciói:

- Ütemezett futtatás: Lehetővé teszi az ETL feladatok ütemezett futtatását meghatározott időpontokban.

- Eseményvezérelt futtatás: Integrálva van az AWS CloudWatch Events szolgáltatással, ami lehetővé teszi az ETL feladatok eseményvezérelt futtatását.

- Monitoring és riasztás: Biztosítja a feladatok futásának monitoringját és riasztásokat küld hiba esetén.

- Függőségek kezelése: Lehetővé teszi az ETL feladatok közötti függőségek kezelését, ami biztosítja a feladatok helyes sorrendben történő futtatását.

Összességében, a Glue Data Catalog, az ETL engine és a scheduler szoros együttműködése teszi lehetővé az AWS Glue számára, hogy egy hatékony és rugalmas adatintegrációs platformot biztosítson a felhasználók számára.

Glue Data Catalog: Metaadat tárolás és adatforrás integráció

Az AWS Glue Data Catalog a Glue szolgáltatás központi eleme, mely egy metaadat tárolóként funkcionál. Ez azt jelenti, hogy itt tároljuk az adataink szerkezetére, sémájára és helyére vonatkozó információkat. Gondoljunk rá úgy, mint egy könyvtári katalógusra, ami megmondja, hol található egy könyv és miről szól, anélkül, hogy magát a könyvet kellene olvasnunk.

A Data Catalog nélkül a Glue munkamenetek nem tudnák, hogyan érjék el az adatainkat, milyen formátumban vannak tárolva, vagy milyen sémát követnek. Ezért kulcsfontosságú a Glue munkafolyamatok szempontjából.

Az adatforrás integráció terén a Glue Data Catalog rendkívül sokoldalú. Támogat számos adatforrást, beleértve:

- Amazon S3: Valószínűleg a leggyakrabban használt, hiszen az S3 egy rendkívül skálázható és költséghatékony adattároló.

- JDBC adatbázisok: Ilyenek például az Amazon RDS (MySQL, PostgreSQL, Oracle, SQL Server), és más, külső JDBC-kompatibilis adatbázisok.

- NoSQL adatbázisok: Például Amazon DynamoDB.

- Adattárházak: Mint az Amazon Redshift.

A Data Catalog-ba az adatok metaadatai többféle módon kerülhetnek be:

- Automatikus felderítés (Crawlers): A Glue Crawlers automatikusan bejárják az adatforrásokat, meghatározzák a sémát, és létrehozzák a megfelelő táblázatokat a Data Catalog-ban. A Crawlerek képesek kezelni a sémaváltozásokat is, és automatikusan frissítik a Data Catalogot.

- Manuális definíció: Lehetőség van kézzel is definiálni a táblázatokat és azok sémáját a Data Catalog-ban. Ez hasznos lehet speciális esetekben, vagy ha az automatikus felderítés nem lehetséges.

- API használata: A Glue API-n keresztül programozottan is létrehozhatók és kezelhetők a Data Catalog bejegyzései.

A Data Catalog táblázatok tartalmazzák a következő információkat:

- Tábla neve és leírása.

- Séma definíció (oszlopnevek, adattípusok).

- Adatforrás helye (pl. S3 bucket és elérési út).

- Adatformátum (pl. CSV, JSON, Parquet).

- Particionálás információi (ha az adatok particionáltak).

A Glue Data Catalog lehetővé teszi az adatok egységes kezelését és hozzáférését, függetlenül attól, hogy hol és milyen formátumban tároljuk azokat. Ez nagymértékben leegyszerűsíti az adatok integrációját és elemzését.

A Data Catalog versioning képességgel is rendelkezik, ami azt jelenti, hogy nyomon követhetjük a táblázatok sémájának változásait. Ez különösen fontos az adatok minőségének biztosításához és a hibakereséshez.

A Data Catalog integrálva van más AWS szolgáltatásokkal, például az Athena-val és a Redshift Spectrum-mal, lehetővé téve számukra, hogy közvetlenül a Data Catalogból szerezzék be az adatok metaadatait, és így könnyedén lekérdezéseket futtassanak az adatokon.

A partitioning a Data Catalogban egy hatékony módja az adatok szervezésének és lekérdezésének optimalizálásának. A partíciók lehetővé teszik az adatok logikai csoportosítását bizonyos oszlopok értékei alapján (pl. dátum, régió). A Glue Crawlers automatikusan felismeri a partíciókat, és létrehozza a megfelelő metaadatokat a Data Catalogban.

A Data Catalog használata jelentősen csökkenti az adatkezelési feladatokat, és lehetővé teszi, hogy az adatelemzők és fejlesztők az adatok elemzésére és a belőlük származó érték kinyerésére összpontosítsanak.

ETL folyamatok tervezése és implementálása AWS Glue-val

Az AWS Glue egy teljesen menedzselt ETL (Extract, Transform, Load) szolgáltatás, amely leegyszerűsíti és automatizálja az adatok előkészítését és betöltését analitikai célokra. Segítségével a fejlesztők időt és erőforrást takaríthatnak meg az adatvezérelt alkalmazások létrehozásakor. A Glue központi szerepet játszik az ETL folyamatok tervezésében és implementálásában az AWS ökoszisztémában.

Az ETL folyamatok tervezése Glue-val általában a következő lépésekből áll:

- Adatforrások azonosítása: Az első lépés az adatforrások azonosítása, amelyekből az adatokat kinyerjük. Ez lehet egy S3 bucket, egy RDS adatbázis, egy DynamoDB tábla vagy bármilyen más támogatott adatforrás.

- Glue katalógus konfigurálása: A Glue katalógus egy központi metaadat-tár, amely tárolja az adatforrások sémáit és egyéb metaadatait. A katalógus konfigurálása magában foglalja a táblák létrehozását és a sémák definiálását.

- Glue Crawlerek futtatása: A Crawlerek automatikusan feltérképezik az adatforrásokat, következtetnek a sémára, és létrehoznak táblákat a Glue katalógusban. Ez nagymértékben leegyszerűsíti a séma definiálásának folyamatát.

- Glue Jobok tervezése és implementálása: A Glue Jobok a tényleges ETL transzformációkat végzik. Ezek a jobok Python vagy Scala nyelven íródhatnak, és használhatják a Glue beépített függvényeit és könyvtárait az adatok tisztítására, transzformálására és betöltésére.

- Workflowk létrehozása: A Workflowk segítségével több Glue Jobot lehet összekapcsolni egyetlen, automatizált folyamattá. Ez lehetővé teszi az ETL folyamatok ütemezését, monitorozását és hibakezelését.

- Monitorozás és hibaelhárítás: A Glue rendelkezik beépített monitorozási és hibaelhárítási eszközökkel, amelyek segítségével nyomon követhetjük a jobok futását és azonosíthatjuk a problémákat.

Az AWS Glue egyik legnagyobb előnye a szerver nélküli (serverless) architektúrája, ami azt jelenti, hogy nincs szükség infrastruktúra kiépítésére és karbantartására. A Glue automatikusan skálázza az erőforrásokat a feladatok igényeihez igazodva, így a felhasználók csak a felhasznált erőforrásokért fizetnek.

A Glue Jobok implementálásakor figyelembe kell venni a következő szempontokat:

- Adatminőség: Az adatok tisztítása és validálása kulcsfontosságú a pontos és megbízható analitikai eredmények eléréséhez. A Glue beépített függvényeket és könyvtárakat biztosít az adatminőség javítására.

- Teljesítmény: Az ETL folyamatok optimalizálása a teljesítmény érdekében elengedhetetlen a nagy adathalmazok hatékony feldolgozásához. A Glue támogatja a párhuzamos feldolgozást és a skálázhatóságot a teljesítmény javítása érdekében.

- Biztonság: Az adatok védelme és a biztonsági követelmények betartása kritikus fontosságú. A Glue integrálva van az AWS Identity and Access Management (IAM) szolgáltatással, amely lehetővé teszi a hozzáférési jogosultságok szabályozását.

- Költségoptimalizálás: A Glue költségeinek optimalizálása fontos szempont lehet, különösen nagy adathalmazok feldolgozásakor. Fontos a megfelelő job típus kiválasztása (Spark vagy Ray), a worker típusok és számok helyes beállítása, valamint a felesleges adatfeldolgozás elkerülése.

A Glue integrálható más AWS szolgáltatásokkal, például az S3, az Athena, a Redshift és a QuickSight szolgáltatásokkal, ami lehetővé teszi a teljeskörű adatvezérelt megoldások létrehozását. Például, a Glue-val előkészített adatokat az Athena segítségével lehet lekérdezni, a Redshiftben tárolni, és a QuickSight segítségével vizualizálni.

Az AWS Glue egy hatékony eszköz az ETL folyamatok tervezéséhez és implementálásához az AWS ökoszisztémában. A szolgáltatás automatizálja az adat előkészítését és betöltését, így a fejlesztők az adatok elemzésére és a üzleti érték megteremtésére összpontosíthatnak. A Glue szerver nélküli architektúrája, beépített funkciói és integrációs képességei ideális választássá teszik a modern adatvezérelt alkalmazásokhoz.

Adatátalakítási technikák és best practice-ek Glue-ban

Az AWS Glue egy teljesen menedzselt ETL (Extract, Transform, Load) szolgáltatás, amely leegyszerűsíti az adatokat különböző forrásokból származó adatok kinyerésének, átalakításának és adattárházakba, adattavakba való betöltésének folyamatát. A Glue keretén belül az adatátalakítás kulcsfontosságú szerepet játszik, hiszen ez teszi lehetővé, hogy a nyers adatokat használható, elemzhető formátumra hozzuk.

Számos technika áll rendelkezésünkre az adatátalakításra a Glue-ban, ezek közül a leggyakoribbak:

- Glue DataBrew: Egy vizuális, kódmentes eszköz, amely lehetővé teszi az adatok profilozását és az átalakítások végrehajtását anélkül, hogy kódot kellene írnunk. Ideális az adatok tisztításához, normalizálásához és formázásához.

- PySpark: A Glue alapértelmezett motorja Spark-on alapul, így kihasználhatjuk a PySpark erejét az összetett adatátalakításokhoz. PySpark használatával írhatunk egyedi adatátalakítási logikát, és kezelhetünk nagy adathalmazokat.

- Glue Custom Transforms: Lehetővé teszi, hogy egyedi, saját fejlesztésű átalakítási logikát integráljunk a Glue folyamatokba. Ez különösen hasznos lehet, ha speciális, üzletági követelményeknek kell megfelelnünk.

A hatékony adatátalakítás érdekében érdemes a következő best practice-eket követni:

- Adatprofilozás: Az átalakítások megkezdése előtt alaposan ismerjük meg az adatainkat. Használjuk a Glue DataBrew-t vagy más adatprofilozó eszközöket, hogy feltárjuk az adatok minőségét, eloszlását és esetleges anomáliáit.

- Idempotencia: Tervezzük meg az átalakítási feladatokat úgy, hogy azok idempotensek legyenek. Ez azt jelenti, hogy ha egy feladat többször fut le ugyanazokkal a bemeneti adatokkal, akkor mindig ugyanazt az eredményt adja. Ez kritikus fontosságú a hibatűrés és az adatok konzisztenciájának biztosítása szempontjából.

- Particionálás és Bucketálás: Nagy adathalmazok esetén a particionálás és a bucketálás jelentősen javíthatja a lekérdezések teljesítményét. A Glue-ban használhatjuk ezeket a technikákat az adatok logikai csoportosítására és a lekérdezések optimalizálására.

- Optimalizált Spark kód: Ha PySpark-ot használunk, fordítsunk figyelmet a kód optimalizálására. Kerüljük a felesleges shuffle-okat, használjunk broadcast változókat a kisebb adathalmazokhoz, és figyeljünk a memória kezelésére.

- Monitoring és naplózás: Implementáljunk alapos monitoringot és naplózást a Glue feladatokhoz. Ez segít a hibák gyors azonosításában és a teljesítményoptimalizálásban.

A hatékony adatátalakítás a Glue-ban nem csak a megfelelő technológiák kiválasztásáról szól, hanem a bevált gyakorlatok alkalmazásáról és az adatok alapos megértéséről is.

Az adatminőség javítása érdekében használhatunk különböző átalakítási technikákat, mint például:

- Duplikációk eltávolítása: Az adatok tisztítása során elengedhetetlen a duplikációk kiszűrése.

- Adatok validálása: Ellenőrizzük, hogy az adatok megfelelnek-e a meghatározott szabályoknak és korlátoknak.

- Hiányzó értékek kezelése: Töltsük ki a hiányzó értékeket megfelelő módszerekkel (pl. középérték, medián, vagy egyedi érték).

- Adatok normalizálása és standardizálása: Hozzunk létre egységes formátumot az adatok számára.

A Glue segítségével az adatátalakítási folyamatunkat automatizálhatjuk és felgyorsíthatjuk, így időt és erőforrást takaríthatunk meg, miközben biztosítjuk az adatok minőségét és konzisztenciáját.

AWS Glue Python Shell: Egyedi adatátalakítási szkriptek írása

Az AWS Glue Python Shell lehetővé teszi a felhasználók számára egyedi adatátalakítási szkriptek írását, amelyek a Glue beépített funkcionalitásán túlmutató igényeket elégítenek ki. Ez különösen akkor hasznos, ha speciális könyvtárakra, bonyolult algoritmusokra vagy egyedi formátumokra van szükség az adatok feldolgozásához.

A Python Shell nem Spark alapú, ami azt jelenti, hogy nem használja ki a Spark elosztott feldolgozási képességeit. Ehelyett egyetlen végrehajtón fut, ami korlátozhatja a feldolgozható adatmennyiséget. Ugyanakkor, ez egyszerűbbé és gyorsabbá teszi a kisebb adatmennyiségek átalakítását és a prototípusok fejlesztését.

A Python Shell ideális megoldás olyan feladatokhoz, ahol komplex logikát kell alkalmazni kisebb adathalmazokon, anélkül, hogy a Spark overhead-jével kellene számolni.

A Python Shell szkriptek standard Python könyvtárakat és az AWS SDK for Python (Boto3) használhatják. Ez lehetővé teszi az AWS szolgáltatásokkal való interakciót, például adatok olvasását S3-ból vagy írását Redshiftbe. A szkriptek futtatásához a Glue biztosít egy futtatókörnyezetet, amely tartalmazza a szükséges függőségeket.

A Python Shell használatának előnyei:

- Rugalmasság: Szabadságot ad a felhasználóknak, hogy egyedi logikát implementáljanak.

- Egyszerűség: Könnyebb beállítani és futtatni, mint a Spark alapú Glue jobokat.

- Költséghatékonyság: Kisebb adatmennyiségek esetén költséghatékonyabb lehet, mint a Spark.

Azonban fontos figyelembe venni a korlátokat is:

- Skálázhatóság: Nem alkalmas nagy adathalmazok feldolgozására.

- Erőforrás-korlátok: A rendelkezésre álló memória és CPU korlátozott.

A Python Shell konfigurálásakor meg kell adni a szkript helyét, a szükséges Python könyvtárakat (a `–extra-py-files` opcióval) és a futtatáshoz szükséges IAM szerepkört.

AWS Glue Spark ETL: Skálázható adatfeldolgozás a felhőben

Az AWS Glue Spark ETL (Extract, Transform, Load) egy teljesen menedzselt Apache Spark alapú ETL szolgáltatás, amely lehetővé teszi a nagyméretű adatkészletek feldolgozását és átalakítását a felhőben. A Glue Spark ETL leegyszerűsíti az adattárházak építését, az adatlakek feltöltését és az adatok elemzését.

A Glue Spark ETL működése több lépésből áll:

- Adatforrások feltárása: A Glue crawlerei automatikusan feltárják az adatforrásokat (pl. S3, RDS, Redshift), és létrehoznak egy metaadat-katalógust a Glue Data Catalogban. Ez a katalógus tartalmazza az adatok sémáját, formátumát és helyét.

- ETL szkriptek generálása: A Glue automatikusan generálhat Spark ETL szkripteket Python vagy Scala nyelven a Data Catalog metaadatai alapján. Ezek a szkriptek az adatok kinyerésére, átalakítására és betöltésére szolgálnak.

- Szkriptek testreszabása: A generált szkriptek igény szerint testreszabhatók a bonyolultabb átalakítási követelményeknek megfelelően. A Glue IDE-je (Glue Studio) segíti a szkriptek szerkesztését és hibakeresését.

- Szkriptek futtatása: A Glue menedzselt Spark környezetben futtatja az ETL szkripteket. A szolgáltatás automatikusan skálázza a számítási erőforrásokat az adatmennyiség és a feldolgozási igények alapján.

- Adatok betöltése: Az átalakított adatok betöltésre kerülnek a célrendszerbe (pl. S3, Redshift, Elasticsearch).

A Glue Spark ETL egyik legfontosabb előnye a szerver nélküli architektúra. Ez azt jelenti, hogy a felhasználóknak nem kell szervereket kiépíteniük és karbantartaniuk a Spark feladatok futtatásához. A Glue automatikusan kezeli a skálázást és a rendelkezésre állást.

A Glue Spark ETL használatának számos előnye van:

- Skálázhatóság: Képes kezelni a nagyméretű adatkészleteket és a komplex átalakításokat.

- Költséghatékonyság: A szerver nélküli architektúra és az igény szerinti skálázás csökkenti a költségeket.

- Egyszerű használat: A Glue crawlerei és szkriptgenerálási képességei leegyszerűsítik az ETL folyamatok létrehozását.

- Integráció más AWS szolgáltatásokkal: A Glue integrálódik más AWS szolgáltatásokkal, mint például az S3, az RDS, a Redshift és az Athena.

A Glue Spark ETL különösen hasznos lehet olyan esetekben, amikor nagy mennyiségű adatot kell rendszeresen átalakítani és betölteni egy adattárházba vagy adatlakebe. A szolgáltatás ideális választás lehet adatelemzők, adattudósok és szoftverfejlesztők számára, akiknek szükségük van egy skálázható és menedzselt ETL megoldásra.

A Glue Spark ETL a Delta Lake formátumot is támogatja, ami lehetővé teszi a tranzakciós adatkezelést az adatlakekben. Ez különösen fontos az adatok minőségének és konzisztenciájának megőrzése szempontjából.

Glue trigger-ek és workflow-k: Automatizált ETL folyamatok

Az AWS Glue trigger-ek és workflow-k kulcsszerepet játszanak az automatizált ETL (Extract, Transform, Load) folyamatok megvalósításában. A trigger-ek eseményindítók, melyek elindítják a Glue feladatokat (Jobs) vagy workflow-kat, míg a workflow-k komplex ETL folyamatok definiálására szolgálnak, melyek több Glue feladatot kapcsolnak össze, meghatározott sorrendben és feltételekkel.

A trigger-ek három fő típusba sorolhatók:

- On-demand (igény szerinti) trigger-ek: Manuálisan indíthatók a Glue konzolról vagy az AWS CLI-ből.

- Scheduled (ütemezett) trigger-ek: Cron kifejezésekkel definiálhatók, így a feladatok rendszeres időközönként futtathatók.

- Event-based (eseményalapú) trigger-ek: AWS eseményekre reagálnak, például egy fájl feltöltésére az S3-ba.

A workflow-k lehetővé teszik, hogy a Glue feladatokat grafikus felületen vagy kóddal (Python script) szervezzük meg. A workflow-ban a feladatok közötti függőségeket (dependencies) is definiálhatjuk, így biztosítva, hogy egy feladat csak akkor induljon el, ha a megelőző feladat sikeresen lefutott. A workflow-k tartalmazhatnak:

- Feladatokat (Jobs): Az ETL folyamat egyes lépéseit végrehajtó Glue feladatok.

- Trigger-eket: A workflow elindítására szolgáló trigger-ek.

- Crawlereket: Az adatforrások séma felfedezésére szolgáló crawlereket.

- Feltételeket (Conditions): Logikai feltételeket, melyek alapján a workflow különböző ágakon haladhat tovább.

A workflow-k központi elemei az automatizált ETL folyamatoknak, lehetővé téve a komplex adattranszformációs láncok kezelését és monitorozását.

A workflow-k monitorozása az AWS Glue konzolján keresztül történhet, ahol nyomon követhetjük a feladatok állapotát, a futási időt és a felmerülő hibákat. Ezáltal a hibaelhárítás és a teljesítmény optimalizálása is egyszerűbbé válik. A Glue workflow-k hatékonyan integrálhatók más AWS szolgáltatásokkal, mint például az S3, Redshift és Athena, így egy teljes körű adatintegrációs megoldást kínálnak.

AWS Glue integráció más AWS szolgáltatásokkal (S3, Redshift, Athena, stb.)

Az AWS Glue ereje abban rejlik, hogy zökkenőmentesen integrálódik a különböző AWS szolgáltatásokkal, lehetővé téve a felhasználók számára, hogy adatvezérelt munkafolyamatokat építsenek ki anélkül, hogy bonyolult adatmozgatási és átalakítási feladatokkal kellene bajlódniuk. Ezek közül a legfontosabb integrációk közé tartozik az Amazon S3, az Amazon Redshift, az Amazon Athena és az Amazon RDS.

Az Amazon S3 az AWS Glue számára a leggyakoribb adatforrás. Az S3-ban tárolt strukturált (CSV, JSON, Parquet, ORC) és strukturálatlan adatokat az AWS Glue crawlerei automatikusan felfedezhetik és katalogizálhatják az AWS Glue Data Catalog-ban. Ez a katalógus központi adattárként szolgál, amely leírja az adatokat, beleértve azok sémáját, helyét és egyéb metaadatait. Az S3 integráció lehetővé teszi, hogy az AWS Glue ETL (Extract, Transform, Load) feladatai közvetlenül az S3-ban tárolt adatokon dolgozzanak, átalakítsák azokat, és betöltsék egy másik S3 helyre vagy egy másik adattárházba.

Az Amazon Redshift, az AWS felhő alapú adattárháza, szintén kulcsfontosságú integrációs pont. Az AWS Glue segítségével az S3-ban tárolt adatokat könnyedén betölthetjük a Redshiftbe. Az ETL feladatok átalakíthatják az adatokat a betöltés előtt, biztosítva, hogy azok megfeleljenek a Redshift séma követelményeinek. Ezen túlmenően, az AWS Glue használható a Redshiftből származó adatok kinyerésére, átalakítására és betöltésére más rendszerekbe, például az S3-ba adatok archiválása vagy más analitikai alkalmazásokhoz történő felhasználása céljából.

Az Amazon Athena, az AWS interaktív lekérdező szolgáltatása, szorosan együttműködik az AWS Glue Data Catalog-gal. Mivel az Athena közvetlenül használja a Data Catalog-ban tárolt metaadatokat, az AWS Glue segítségével katalogizált adatok azonnal lekérdezhetők az Athenában SQL lekérdezésekkel. Ez lehetővé teszi a felhasználók számára, hogy gyorsan és egyszerűen elemezhessék az S3-ban tárolt adatokat anélkül, hogy manuálisan kellene definiálniuk a sémákat vagy az adatformátumokat.

Az Amazon RDS (Relational Database Service) integráció lehetővé teszi az AWS Glue számára, hogy különböző relációs adatbázisokból, például MySQL, PostgreSQL, Oracle és SQL Server adatbázisokból nyerjen ki adatokat. Az AWS Glue JDBC (Java Database Connectivity) kapcsolatokat használ az RDS adatbázisokhoz való csatlakozáshoz, és a Data Catalogban tárolja a sémájukat. Ezután az ETL feladatok felhasználhatják ezeket az adatokat, hogy átalakítsák és betöltsék azokat más rendszerekbe, például az S3-ba vagy a Redshiftbe. Ez különösen hasznos lehet a relációs adatbázisokból származó adatok adattárházba való betöltéséhez vagy az adatok más analitikai alkalmazásokhoz történő előkészítéséhez.

Az AWS Glue emellett integrálódik más AWS szolgáltatásokkal is, például az Amazon Kinesis-szel a valós idejű adatfeldolgozáshoz, az Amazon CloudWatch-tal a feladatok monitorozásához és az AWS Lambda-val az eseményvezérelt adatfeldolgozáshoz. Ezek az integrációk lehetővé teszik a felhasználók számára, hogy komplex adatvezérelt munkafolyamatokat építsenek ki, amelyek a különböző AWS szolgáltatások előnyeit kihasználva biztosítják az adatok hatékony és megbízható feldolgozását.

Az AWS Glue központi szerepet játszik az adatintegrációban az AWS ökoszisztémájában, lehetővé téve a különböző szolgáltatások közötti zökkenőmentes adatmozgást és átalakítást.

Röviden, az AWS Glue integrációja más AWS szolgáltatásokkal egy hatékony és rugalmas platformot biztosít az adatok felfedezéséhez, katalogizálásához, átalakításához és betöltéséhez, lehetővé téve a felhasználók számára, hogy az adatokból értékes információkat nyerjenek ki, és adatvezérelt döntéseket hozzanak.

- Adatforrásként való használat: Az AWS Glue képes adatot fogadni S3-ból, Redshiftből, RDS-ből, és más adatbázisokból.

- Adat célként való használat: Az átalakított adatokat az AWS Glue képes S3-ba, Redshiftbe, és más adatbázisokba betölteni.

- Metaadat kezelés: Az AWS Glue Data Catalog központi helyen tárolja a metaadatokat, lehetővé téve az Athena és más szolgáltatások számára az adatok könnyű felfedezését.

Az AWS Glue használatával a felhasználók csökkenthetik az adatintegrációs feladatokhoz szükséges kézi munkát, javíthatják az adatok minőségét, és felgyorsíthatják az adatvezérelt projektek bevezetését.