Az Apache Spark egy gyors és általános célú elosztott számítási keretrendszer, amelyet nagyméretű adatok feldolgozására terveztek. Lényegében egy olyan motor, amely lehetővé teszi a párhuzamos adatfeldolgozást, ami drasztikusan felgyorsítja a komplex adatelemzési feladatokat.

A Spark különösen hatékony a batch feldolgozásban és a valós idejű adatfolyamok elemzésében. Képes adatokat olvasni különböző forrásokból, mint például Hadoop Distributed File System (HDFS), Amazon S3, és különböző adatbázisok, majd ezeken a adatokon komplex transzformációkat végrehajtani.

A Spark egyik legfontosabb előnye, hogy a memóriában tartja az adatokat, ami jelentősen gyorsabb, mint a lemezen alapuló feldolgozás, amelyet például a Hadoop MapReduce használ.

A Spark nem csupán egy adatfeldolgozó eszköz, hanem egy komplett ökoszisztéma, amely magában foglalja a Spark SQL-t (strukturált adatok feldolgozására), a Spark Streaming-et (valós idejű adatfolyamok feldolgozására), a MLlib-et (gépi tanulási könyvtár) és a GraphX-et (gráfadatbázisok feldolgozására).

Miért fontos a Spark? Mert a modern adatközpontú világban a vállalatok hatalmas mennyiségű adatot gyűjtenek, és ezeket az adatokat hatékonyan fel kell dolgozni ahhoz, hogy értékes üzleti betekintést nyerjenek. A Spark ehhez kínál egy skálázható és felhasználóbarát megoldást, lehetővé téve az adatkutatók és mérnökök számára, hogy gyorsan és hatékonyan végezzenek komplex adatelemzéseket.

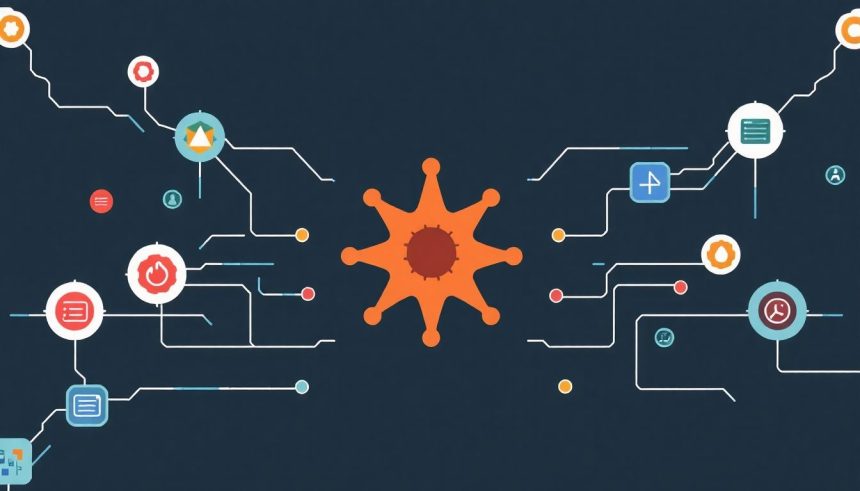

A Spark alaparchitektúrája: Driver, Executor, Cluster Manager

A Spark architektúrája három fő komponensre épül: a Driver-re, az Executor-okra és a Cluster Manager-re. Ezek az elemek együttműködve teszik lehetővé a nagyméretű adathalmazok elosztott feldolgozását.

A Driver program a Spark alkalmazás szíve. Ez az a folyamat, amelyben a felhasználói kód (a Spark alkalmazás) fut. A Driver felelős az alkalmazás logikájának definiálásáért, a feladatok (tasks) létrehozásáért és azok elosztásáért az Executor-ok között. Emellett a Driver koordinálja az Executor-ok munkáját, és gyűjti az eredményeket. A Driver tartalmazza a SparkContext-et, ami a Spark API belépési pontja, és ezen keresztül konfigurálhatjuk a Spark futási környezetét.

A Spark Driver program felelős az alkalmazás végrehajtásának tervezéséért és koordinálásáért.

Az Executor-ok elosztottan futó folyamatok a fürtön, amelyek a Driver által kiosztott feladatokat végzik el. Minden Executor egy adott csomóponton (node) fut, és hozzáfér az adott csomópont erőforrásaihoz (CPU, memória). Az Executor-ok fogadják a feladatokat a Driver-től, feldolgozzák az adatokat, és visszaküldik az eredményeket a Driver-nek. Az Executor-ok a futás során adatokat is tárolhatnak a memóriában vagy a lemezen, ami jelentősen felgyorsíthatja a későbbi műveleteket. Az Executor-ok életciklusát a Cluster Manager kezeli.

A Cluster Manager felelős a fürt erőforrásainak kezeléséért és az Executor-ok elindításáért. A Spark többféle Cluster Manager-t támogat, beleértve a Spark saját Standalone Cluster Manager-ét, a YARN-t (Yet Another Resource Negotiator) és a Mesos-t. A Cluster Manager kapja meg a Driver-től az erőforrásigényeket (pl. mennyi memória és CPU mag szükséges az Executor-okhoz), és kiosztja azokat a rendelkezésre álló csomópontok között. Ha egy Executor meghibásodik, a Cluster Manager automatikusan újraindítja azt, biztosítva ezzel a feladatok folyamatos végrehajtását.

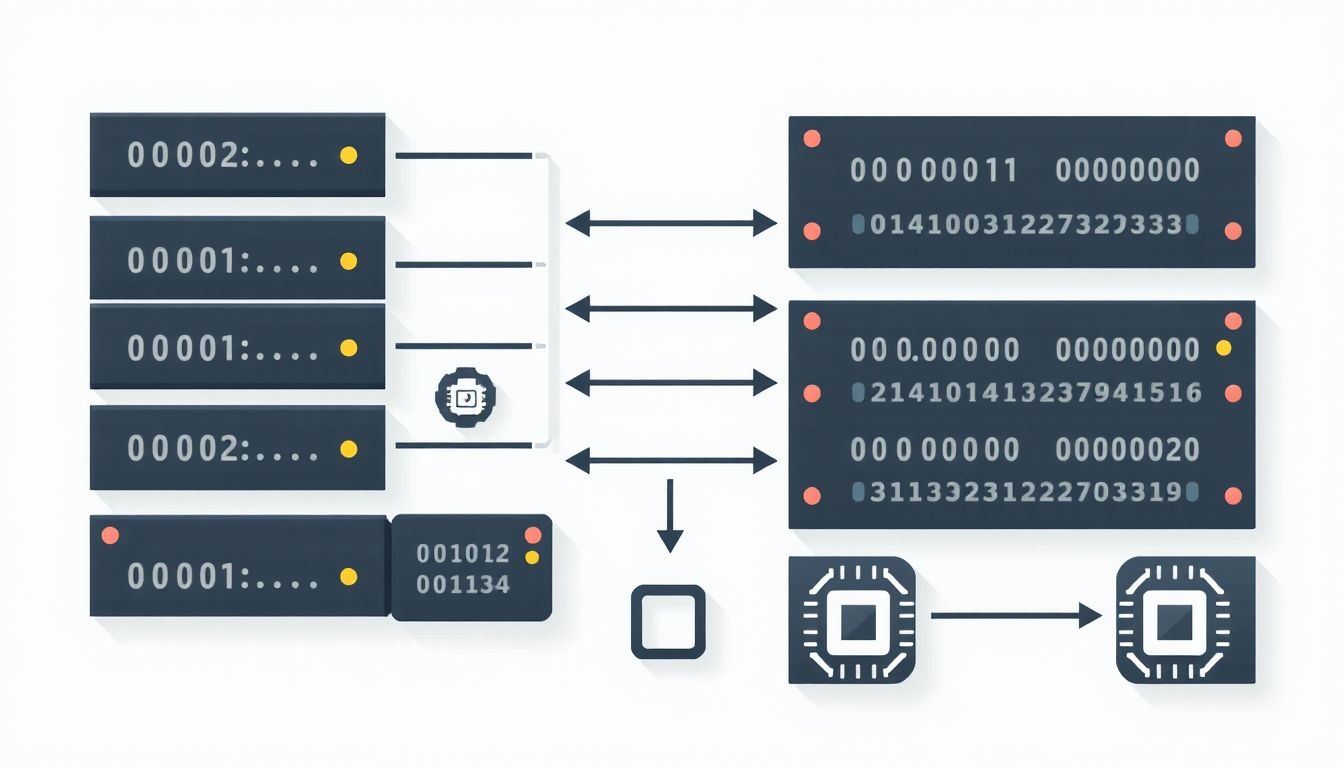

Az adatfeldolgozás folyamata a következőképpen zajlik: a Driver program létrehozza a RDD-ket (Resilient Distributed Datasets) vagy DataFrame-eket, amelyek az elosztott adathalmazokat reprezentálják. A Driver ezután a transzformációk és akciók alapján feladatokat generál, és elküldi azokat az Executor-oknak a Cluster Manager-en keresztül. Az Executor-ok párhuzamosan végrehajtják a feladatokat, és az eredményeket visszaküldik a Driver-nek. A Driver összesíti az eredményeket, és visszaadja azokat a felhasználónak.

RDD-k (Resilient Distributed Datasets): A Spark alapvető adatszerkezete

Az Apache Spark lelke a Resilient Distributed Dataset (RDD), ami egy elosztott, immutable adathalmaz. Ez azt jelenti, hogy az RDD-k egyszer létrejönnek, utána már nem változtathatók meg. Ez a tulajdonság kulcsfontosságú a Spark hibatűréséhez és párhuzamos feldolgozási képességeihez.

Az RDD-k elosztottak, vagyis a Spark cluster különböző csomópontjain tárolódnak. Ez lehetővé teszi, hogy a hatalmas adathalmazokat párhuzamosan dolgozzuk fel, jelentősen felgyorsítva az analitikai feladatokat.

Az RDD-k kétféleképpen hozhatók létre:

- Adatok betöltésével külső forrásból, mint például Hadoop Distributed File System (HDFS), Amazon S3, vagy helyi fájlrendszer.

- Más RDD-k transzformálásával. Ez a módszer lehetővé teszi, hogy komplex adatfeldolgozási pipeline-okat építsünk fel.

Az RDD-k működésének megértéséhez fontos tisztában lenni a transzformációkkal és az akciókkal.

Transzformációk olyan műveletek, amelyek egy RDD-t alakítanak át egy másik RDD-vé. Példák:

- map(): Minden elemre alkalmaz egy függvényt.

- filter(): Kiválasztja azokat az elemeket, amelyek megfelelnek egy adott feltételnek.

- flatMap(): Hasonló a map()-hez, de minden elemre több elemet is visszaadhat.

- reduceByKey(): Összevona az azonos kulccsal rendelkező elemeket.

- groupByKey(): Csoportosítja az elemeket kulcs szerint.

Az RDD-k transzformációi lazy módon értékelődnek ki. Ez azt jelenti, hogy a transzformációk csak akkor hajtódnak végre, amikor egy akciót hívunk meg.

Akciók olyan műveletek, amelyek eredményt adnak vissza a driver programnak, vagy adatokat írnak ki egy külső forrásba. Példák:

- count(): Visszaadja az RDD-ben lévő elemek számát.

- collect(): Visszaadja az RDD összes elemét a driver programnak. (Vigyázat, nagy RDD-k esetén ez problémás lehet!)

- first(): Visszaadja az RDD első elemét.

- take(n): Visszaadja az RDD első n elemét.

- saveAsTextFile(): Kiírja az RDD tartalmát egy szöveges fájlba.

Az RDD-k fault tolerance-e a lineage-en alapul. A lineage egy gráf, amely leírja, hogy egy RDD hogyan jött létre a korábbi RDD-kből. Ha egy partíció elveszik (pl. egy worker node meghibásodik), a Spark a lineage alapján újra tudja számolni azt.

Az RDD-k cache-elhetők is, ami azt jelenti, hogy a Spark a memóriában tárolja őket, így a későbbi műveletek gyorsabban futhatnak. A cache() vagy persist() metódusokkal lehet az RDD-ket cache-elni.

Az RDD-k absztrakciója lehetővé teszi, hogy a Spark felhasználók a nagyméretű adathalmazok elosztott feldolgozásának bonyolultságával ne foglalkozzanak. Ehelyett a feladatukra koncentrálhatnak, és a Spark hatékonyan elvégzi a párhuzamosítást és a hibakezelést.

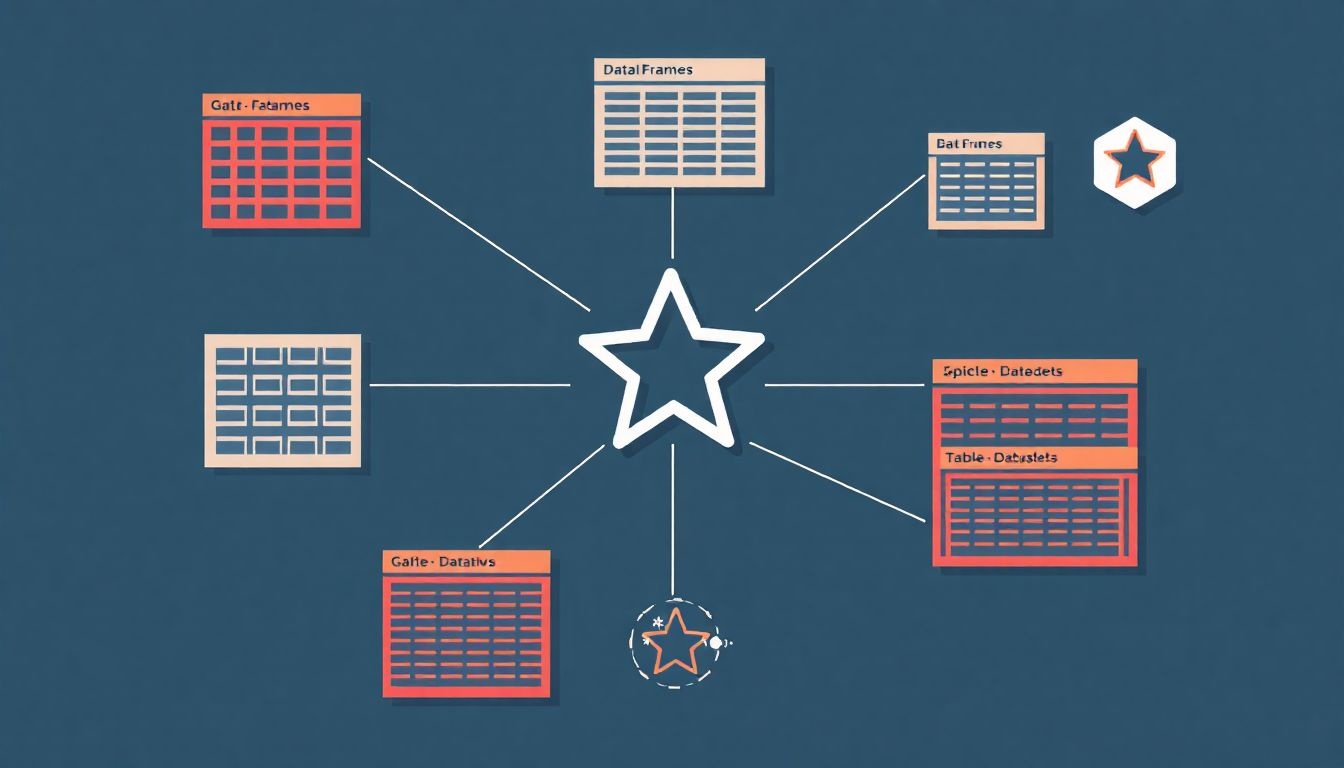

DataFrame-ek és Dataset-ek: Strukturált adatok kezelése a Sparkban

A Spark ereje nagyrészt abban rejlik, ahogyan a strukturált adatokat kezeli. Itt jönnek képbe a DataFrame-ek és a Dataset-ek, melyek a Spark SQL könyvtár alapját képezik. Ezek az absztrakciók lehetővé teszik a fejlesztők számára, hogy strukturált adatokkal dolgozzanak elosztott módon, a SQL-hez hasonló lekérdezéseket használva.

A DataFrame egy elosztott adathalmaz, amely oszlopokba rendezett adatokból áll, hasonlóan egy relációs adatbázis táblájához vagy egy Excel táblázathoz. Minden oszlopnak neve és adattípusa van. A DataFrame-ek sémát használnak, ami azt jelenti, hogy az adatok szerkezete előre definiált. Ez optimalizálást tesz lehetővé, például a lekérdezések gyorsabb végrehajtását.

A DataFrame-eket különböző forrásokból hozhatjuk létre, például:

- CSV fájlokból

- JSON fájlokból

- Parquet fájlokból

- JDBC adatbázisokból

- Meglévő RDD-kből

A Dataset egy újabb absztrakció, amely a DataFrame-ek előnyeit kombinálja a típusbiztonsággal. A Dataset-ek a DataFrame-ekhez hasonlóan strukturált adatokat tárolnak, de emellett Java vagy Scala objektumokat is tartalmazhatnak. Ez lehetővé teszi a fejlesztők számára, hogy a Spark-ot a saját egyéni adattípusaikkal használják, a típusbiztonság és a fordítási idejű ellenőrzés előnyeit élvezve.

A Dataset-ek használata a következő előnyökkel jár:

- Típusbiztonság: A fordító ellenőrzi az adattípusokat, ami csökkenti a futásidejű hibák számát.

- Objektum-orientált programozás: Lehetővé teszi az adatokkal való természetesebb interakciót Java vagy Scala objektumokon keresztül.

- Optimalizálás: A Spark optimalizálhatja a lekérdezéseket a típusinformációk felhasználásával.

A DataFrame és Dataset API-k gazdag eszköztárat kínálnak az adatok manipulálására. Többek között:

- Szűrés

- Rendezés

- Csoportosítás

- Aggregálás

- Join-ok

A Spark SQL Catalyst optimalizálója kulcsszerepet játszik a DataFrame-ek és Dataset-ek lekérdezéseinek optimalizálásában. A Catalyst a lekérdezéseket átalakítja egy hatékonyabb végrehajtási tervvé, így a Spark jelentősen gyorsabban képes feldolgozni az adatokat.

A DataFrame-ek és Dataset-ek a Spark központi elemei, amelyek lehetővé teszik a strukturált adatok hatékony és típusbiztos kezelését elosztott környezetben.

Például, ha egy nagy méretű naplófájlt szeretnénk feldolgozni, amiben a felhasználói aktivitásokat tároljuk, akkor a Spark segítségével a naplófájlt DataFrame-ként vagy Dataset-ként betölthetjük, majd SQL-szerű lekérdezésekkel kinyerhetjük a szükséges információkat, például a leggyakrabban látogatott oldalakat vagy a felhasználók demográfiai adatait.

Az alábbi táblázat összefoglalja a DataFrame-ek és Dataset-ek közötti főbb különbségeket:

| Jellemző | DataFrame | Dataset |

|---|---|---|

| Típusbiztonság | Nincs fordítási idejű típusellenőrzés | Van fordítási idejű típusellenőrzés |

| Adattípus | Oszlopokba rendezett adatok, sémával | Java/Scala objektumok, sémával |

| Teljesítmény | Általában gyorsabb bizonyos műveleteknél | Némely esetben lassabb a típusellenőrzés miatt, de optimalizálható |

Spark SQL: SQL lekérdezések futtatása a Sparkon

A Spark SQL a Spark keretrendszer egyik legfontosabb komponense, amely lehetővé teszi SQL lekérdezések futtatását strukturált adatokon. Ez a modul áthidalja a szakadékot a hagyományos relációs adatbázisok és a Spark által kezelt nagy adathalmazok között.

A Spark SQL legfőbb célja, hogy egységes interfészt biztosítson különböző adatforrásokhoz, beleértve a Hive-t, a Parquet fájlokat, a JSON fájlokat, az Avro fájlokat, és a JDBC-n keresztül elérhető relációs adatbázisokat. Ez azt jelenti, hogy a fejlesztők ugyanazt az SQL szintaxist használhatják a különböző adatok lekérdezésére, anélkül, hogy a mögöttes adattárolási formátummal kellene foglalkozniuk.

A Spark SQL kulcsfontosságú eleme a DataFrame. A DataFrame egy elosztott adattábla, amely oszlopokkal és sorokkal rendelkezik, hasonlóan egy relációs adatbázis táblájához. A DataFrame-ek létrehozhatók meglévő RDD-kből (Resilient Distributed Datasets), strukturált adatokból (mint például CSV vagy JSON fájlokból), Hive táblákból, vagy akár programozottan is.

A Spark SQL lehetővé teszi a fejlesztők számára, hogy SQL lekérdezéseket használjanak a DataFrame-eken, kihasználva a Spark elosztott feldolgozási képességeit a nagy adathalmazok hatékony lekérdezéséhez.

A Spark SQL optimalizálja a lekérdezéseket a Catalyst optimizer segítségével. A Catalyst egy kibővíthető lekérdezés optimalizáló, amely számos optimalizálást végez, mint például a lekérdezés átírása, a fizikai terv kiválasztása és a kódgenerálás. Ennek eredményeként a Spark SQL lekérdezések gyakran jelentősen gyorsabban futnak, mint a hagyományos MapReduce alapú megoldások.

A Spark SQL használatának előnyei:

- Egységes interfész: Ugyanaz az SQL szintaxis használható különböző adatforrások lekérdezésére.

- Teljesítmény: A Catalyst optimizer optimalizálja a lekérdezéseket a gyorsabb végrehajtás érdekében.

- Skálázhatóság: A Spark elosztott feldolgozási képességei lehetővé teszik a nagy adathalmazok hatékony lekérdezését.

- Integráció: A Spark SQL könnyen integrálható más Spark komponensekkel, mint például a Spark Streaming és a MLlib.

Példa egy egyszerű Spark SQL lekérdezésre:

Tegyük fel, hogy van egy „employees” nevű DataFrame-ünk, amely az alkalmazottak adatait tartalmazza. A következő SQL lekérdezéssel lekérdezhetjük az összes alkalmazott nevét és fizetését, akiknek a fizetése meghaladja az 50000-et:

SELECT name, salary FROM employees WHERE salary > 50000

Ez a lekérdezés a Spark SQL segítségével futtatható, és az eredmény egy új DataFrame lesz, amely a szűrt adatokat tartalmazza. A Spark SQL tehát egy erőteljes eszköz a strukturált adatok elemzéséhez a Spark keretrendszerben, lehetővé téve a fejlesztők számára, hogy a meglévő SQL ismereteiket felhasználva hatékonyan dolgozzanak nagy adathalmazokkal.

Spark Streaming: Valós idejű adatfeldolgozás

A Spark Streaming a valós idejű adatfeldolgozás Sparkon belüli megvalósítása. Lehetővé teszi, hogy a Spark feldolgozza az élő adatfolyamokat, szemben a hagyományos batch feldolgozással, ahol az adatokat először tárolják, majd egyben dolgozzák fel.

A Spark Streaming alapelve a diszkretizált adatfolyam (DStream) koncepcióján alapul. A DStream egy folyamatosan érkező adatfolyamot kis, diszkrét kötegekre bontja. Ezek a kötegek általában néhány másodperces időközönként keletkeznek. A Spark ezután az egyes kötegeket úgy kezeli, mintha egy-egy RDD (Resilient Distributed Dataset) lennének, ami a Spark alapvető adatszerkezete. Így a Spark teljes erejével, beleértve a párhuzamos feldolgozást és a hibatűrést, képes feldolgozni az élő adatfolyamokat.

A Spark Streaming számos adatforrást támogat, többek között:

- Kafka

- Flume

- Kinesis

- TCP socketek

Ez a sokoldalúság lehetővé teszi, hogy a Spark Streaming integrálódjon a meglévő adatfolyam-infrastruktúrába.

A DStream-ekkel végezhető transzformációk nagyon hasonlítanak az RDD-ken elvégezhető műveletekre. Ilyen transzformációk például:

- map(): Egy függvényt alkalmaz minden elemre a DStream-ben.

- filter(): Kiszűri azokat az elemeket, amelyek nem felelnek meg egy adott feltételnek.

- reduceByKey(): Összevonja az azonos kulcsú elemeket egy függvénnyel.

- window(): Egy adott időablakon belül lévő adatokat dolgozza fel. Ez különösen hasznos a valós idejű analitikában, ahol az adatokat időbeli kontextusban kell vizsgálni.

A Spark Streaming egyik legfontosabb előnye a hibatűrés. Mivel a DStream-ek RDD-ken alapulnak, a Spark képes automatikusan helyreállítani az adatvesztést, ha egy csomópont meghibásodik.

A Spark Streaming széles körben alkalmazható valós idejű analitikában, monitorozásban és eseményfeldolgozásban. Például, használható webes naplók valós idejű elemzésére, szenzoradatok feldolgozására, vagy csalások észlelésére.

A Spark Streaming használata során figyelembe kell venni a kötegméretet. A kisebb kötegméret kisebb késleltetést eredményez, de nagyobb terhelést jelent a rendszer számára. A nagyobb kötegméret nagyobb késleltetést eredményez, de csökkenti a terhelést. A megfelelő kötegméret kiválasztása a konkrét alkalmazási esettől és a rendszer erőforrásaitól függ.

A Spark Streaming egy hatékony eszköz a valós idejű adatfeldolgozáshoz, amely a Spark ökoszisztéma részeként kínálja a párhuzamosságot, a hibatűrést és a könnyű használhatóságot.

MLlib: A Spark gépi tanulási könyvtára

Az MLlib a Spark skálázható gépi tanulási könyvtára. Célja, hogy a gépi tanulási algoritmusokat nagy adathalmazokon is hatékonyan futtathatóvá tegye. Mivel a Spark elosztott számítási keretrendszerre épül, az MLlib kihasználja a Spark klaszter előnyeit, lehetővé téve a párhuzamos feldolgozást és a nagy adathalmazok kezelését.

Az MLlib számos gépi tanulási algoritmust tartalmaz, beleértve:

- Osztályozás: Logisztikus regresszió, döntési fák, véletlen erdők, gradiens növelésű fák, naiv Bayes.

- Regresszió: Lineáris regresszió, általánosított lineáris modellek.

- Klaszterezés: K-means, Gauss-keverék modell, LDA (Latent Dirichlet Allocation).

- Dimenziócsökkentés: PCA (Principal Component Analysis), SVD (Singular Value Decomposition).

- Ajánlórendszerek: Alternating Least Squares (ALS).

- Funkciókiválasztás és -transzformáció: TF-IDF, Word2Vec, StandardScaler, MinMaxScaler.

A könyvtár nem csak az algoritmusokat tartalmazza, hanem eszközöket is biztosít a gépi tanulási folyamat különböző fázisaihoz, mint például az adatelőkészítés, a modellértékelés és a modellválasztás. Az MLlib API-ja támogatja a Python, Scala és Java nyelveket, így a fejlesztők a számukra legkényelmesebb nyelven használhatják.

Az MLlib egyik kulcsfontosságú előnye a skálázhatóság. A Spark elosztott architektúrájának köszönhetően az MLlib képes nagyméretű adathalmazokon is hatékonyan futtatni a gépi tanulási algoritmusokat, ami elengedhetetlen a modern adatközpontú alkalmazásokhoz.

Az MLlib architektúrája két fő részből áll:

- spark.mllib: Az eredeti API, amely az RDD-kre (Resilient Distributed Datasets) épül. Bár továbbra is használható, az újabb fejlesztések elsősorban a spark.ml API-ra koncentrálnak.

- spark.ml: Az újabb API, amely a DataFrame-ekre épül. A spark.ml API a Pipeline API-t használja, ami lehetővé teszi a gépi tanulási munkafolyamatok egyszerűbb és strukturáltabb kezelését. A Pipeline API transzformátorokból és becslőkből áll, amelyek egy láncba fűzve alkotják a gépi tanulási folyamatot.

A spark.ml API a jövőben a preferált megoldás, mivel jobban integrálódik a Spark egyéb részeivel és hatékonyabb a nagyméretű adathalmazok kezelésében.

GraphX: Grafadatbázisok és grafalgoritmusok a Sparkban

A GraphX az Apache Spark grafikus számítási motorja, amely lehetővé teszi a grafadatbázisok kezelését és a grafalgoritmusok futtatását elosztott módon. A Spark ökoszisztémájába integrálva kihasználja a Spark skálázhatóságát és hibatűrését, így nagyméretű gráfok elemzésére is alkalmas.

A GraphX a property graph modellt használja, ahol a gráf csúcsai és élei is rendelkezhetnek attribútumokkal. Ezek az attribútumok lehetnek bármilyen adattípusok, ami nagy rugalmasságot biztosít a gráfok modellezésében. A gráfok reprezentációja a GraphX-ben elosztott módon történik, ami lehetővé teszi a párhuzamos feldolgozást.

A GraphX alapvető műveletei közé tartozik a gráfok transzformálása (pl. csúcsok és élek szűrése, élek irányának megfordítása) és a gráfalgoritmusok futtatása. Néhány gyakran használt grafalgoritmus, amely a GraphX-ben elérhető:

- PageRank: A csúcsok fontosságának meghatározására.

- Connected Components: A gráf összefüggő komponenseinek azonosítására.

- Triangle Counting: A gráfban található háromszögek számának meghatározására.

A GraphX lehetővé teszi a fejlesztők számára, hogy nagy teljesítményű grafikus elemzéseket végezzenek a Spark infrastruktúráján, anélkül, hogy külön grafadatbázisokat kellene használniuk.

A GraphX használata során fontos figyelembe venni a gráf particionálását. A hatékony particionálás kulcsfontosságú a teljesítmény szempontjából, mivel minimalizálja a hálózati kommunikációt a csúcsok és élek közötti függőségek miatt. Különböző particionálási stratégiák léteznek, és a megfelelő stratégia kiválasztása a gráf struktúrájától és a futtatandó algoritmustól függ.

A GraphX nem csak a beépített algoritmusokat kínálja, hanem lehetővé teszi a felhasználó által definiált függvények (UDF-ek) alkalmazását is a gráf csúcsaira és éleire. Ezáltal a felhasználók egyedi elemzéseket és transzformációkat hajthatnak végre, amelyek speciális problémák megoldására alkalmasak.

Spark Core API: Alapvető műveletek és transzformációk

A Spark Core API a Spark alacsony szintű motorja, amely az elosztott adatfeldolgozás alapját képezi. Lehetővé teszi az adatok kezelését RDD-k (Resilient Distributed Datasets) segítségével, melyek a Spark alapvető adatszerkezetei.

Az RDD-k immutable, elosztott adategyüttesek, amelyeket párhuzamosan lehet feldolgozni. Kétféle műveletet végezhetünk rajtuk:

- Transzformációk: Új RDD-ket hoznak létre a meglévőkből (pl. map, filter, flatMap, groupBy, reduceByKey). Ezek a műveletek lazy módon kerülnek kiértékelésre.

- Akciók: Számítást indítanak el az RDD-ken, és eredményt adnak vissza a driver programnak (pl. count, collect, first, reduce, saveAsTextFile).

A Spark Core API lehetővé teszi a felhasználók számára, hogy finomhangolják az adatfeldolgozási folyamatot, és optimalizálják a teljesítményt a speciális igényeiknek megfelelően.

Néhány példa a gyakori transzformációkra:

- map(): Minden elemre alkalmaz egy függvényt, és egy új RDD-t hoz létre a visszatérési értékekkel.

- filter(): Kiválasztja azokat az elemeket, amelyek megfelelnek egy adott feltételnek.

- reduceByKey(): Összevonja az azonos kulccsal rendelkező értékeket egy megadott függvénnyel.

Az akciók közül a collect() az RDD összes elemét összegyűjti a driver program memóriájába, ami nagy adathalmazok esetén nem ajánlott. Ehelyett célszerűbb a saveAsTextFile() akciót használni, amely az RDD tartalmát fájlokba menti.

A Spark Core API használata mélyebb megértést igényel az elosztott rendszerek működéséről, de cserébe nagyobb kontrollt biztosít a feldolgozási folyamat felett.

Spark Cluster Manager-ek: YARN, Mesos, Kubernetes és a Spark saját standalone módja

Az Apache Spark egy elosztott számítási keretrendszer, amely a cluster manager segítségével osztja el a feladatokat a fürtön. A cluster manager felelős az erőforrások kezeléséért és a Spark alkalmazások futtatásáért. Négy fő cluster manager opció létezik a Spark számára:

- YARN (Yet Another Resource Negotiator): A Hadoop ökoszisztéma erőforrás-kezelője. A Spark integrálható a YARN-nal, lehetővé téve, hogy a Spark alkalmazások ugyanazokon a csomópontokon fussanak, mint a Hadoop MapReduce feladatok. A YARN dinamikusan osztja ki az erőforrásokat a különböző alkalmazások között, optimalizálva a fürt kihasználtságát.

- Mesos: Egy másik általános célú cluster manager, amely támogatja a különböző számítási keretrendszereket, beleértve a Sparkot is. A Mesos lehetővé teszi a finom szemcsés erőforrás-megosztást, ami azt jelenti, hogy a Spark dinamikusan kérhet és adhat vissza erőforrásokat a feladatok futása közben.

- Kubernetes: Egy konténer-orchestrációs platform, amely egyre népszerűbb a Spark alkalmazások futtatására. A Kubernetes automatizálja a Spark alkalmazások telepítését, skálázását és kezelését. A konténerizáció révén a Kubernetes biztosítja a Spark alkalmazások izolációját és reprodukálhatóságát.

- Spark Standalone Mode: A Spark saját, egyszerű cluster managere. Könnyen beállítható és használható, ideális fejlesztési és tesztelési célokra, vagy kisebb, dedikált Spark fürtök esetén. A standalone mód nem rendelkezik a YARN, Mesos vagy Kubernetes által kínált fejlett erőforrás-kezelési képességekkel.

A megfelelő cluster manager kiválasztása a környezet követelményeitől és a rendelkezésre álló infrastruktúrától függ. Ha már rendelkezünk Hadoop fürtrel, a YARN lehet a legjobb választás. A Kubernetes ideális konténerizált környezetekhez. A standalone mód egyszerűsége miatt a fejlesztés során lehet hasznos.

A cluster manager választása jelentősen befolyásolja a Spark alkalmazások teljesítményét, skálázhatóságát és erőforrás-kihasználtságát.

A YARN és a Mesos nagyobb fokú erőforrás-megosztást tesz lehetővé a Spark és más alkalmazások között, ami javíthatja a fürt általános kihasználtságát. A Kubernetes automatizálási képességei leegyszerűsíthetik a Spark alkalmazások telepítését és kezelését. A Spark standalone módja pedig egyszerűséget kínál, de korlátozottabb erőforrás-kezelési képességekkel rendelkezik.

A fentiekből látható, hogy a cluster manager kritikus fontosságú a Spark hatékony működéséhez.

A Spark telepítése és konfigurálása

A Spark telepítése és konfigurálása több lépésből áll, melyek kulcsfontosságúak a rendszer megfelelő működéséhez. Először is, gondoskodni kell a Java Development Kit (JDK) meglétéről, mivel a Spark Java virtuális gépen fut.

A telepítéshez le kell tölteni a legfrissebb Spark binárist a hivatalos Apache Spark weboldalról. A letöltött fájlt ki kell csomagolni egy választott könyvtárba. Ezt követően be kell állítani a SPARK_HOME környezeti változót, ami a Spark telepítési könyvtárára mutat.

A Spark konfigurációja az conf könyvtárban található fájlok szerkesztésével történik. A legfontosabb fájlok a következők:

spark-env.sh: Itt állíthatjuk be a Spark futtatásához szükséges környezeti változókat, például a Java elérési útját (JAVA_HOME), a memória beállításokat (SPARK_DRIVER_MEMORY,SPARK_EXECUTOR_MEMORY) és egyéb fontos paramétereket.log4j.properties: A Spark naplózásának konfigurálására szolgál.

A spark-env.sh fájlban beállított memóriaértékek kritikusak a Spark teljesítménye szempontjából. A túl kevés memória „Out of Memory” hibákhoz vezethet, míg a túl sok memória pazarló lehet.

A Spark telepítése után lehetőség van a lokális módban történő futtatásra, ami ideális a fejlesztéshez és teszteléshez. Azonban éles környezetben a Sparkot egy klaszteren kell telepíteni és konfigurálni, például YARN vagy Mesos segítségével. A klaszter konfigurációja bonyolultabb, és magában foglalja a master és worker node-ok beállítását, a hálózati konfigurációt, és a biztonsági beállításokat.

A Spark telepítése és konfigurálása során figyelni kell a verziókompatibilitásra is. Győződjünk meg arról, hogy a Spark verzió kompatibilis a használt Hadoop verzióval (ha használunk Hadoopot), valamint a Java verzióval. A nem megfelelő verziók használata problémákhoz vezethet a futtatás során.

Spark optimalizálási technikák: Adatok particionálása, szerializáció, és memóriakezelés

Az Apache Spark teljesítményének optimalizálása kritikus fontosságú a nagyméretű adathalmazok hatékony feldolgozásához. Ennek érdekében számos technikát alkalmazhatunk, amelyek közül kiemelkedik az adatok particionálása, a szerializáció optimalizálása és a memóriakezelés finomhangolása.

Az adatok particionálása azt jelenti, hogy az adathalmazt kisebb, logikailag elkülönülő részekre osztjuk, amelyeket a Spark fürt különböző csomópontjain párhuzamosan dolgozhatunk fel. A megfelelő particionálási stratégia kiválasztása kulcsfontosságú. Például, ha egy adathalmaz azonosító alapján van rendezve, érdemes lehet tartomány-alapú particionálást alkalmazni. Ha az adatok eloszlása nem egyenletes, a hasító függvények használata hatékonyabb lehet a terheléselosztás szempontjából. A repartition() és coalesce() függvények segítségével dinamikusan módosíthatjuk a partíciók számát, figyelembe véve a feldolgozási igényeket.

A szerializáció az objektumok byte-folyammá alakításának folyamata, amely lehetővé teszi az adatok hálózaton keresztüli továbbítását és a lemezre történő mentését. A Spark alapértelmezésben a Java szerializációt használja, de ez lassú és erőforrás-igényes lehet. A Kryo szerializáció egy sokkal gyorsabb és hatékonyabb alternatíva, amely jelentős teljesítménynövekedést eredményezhet, különösen akkor, ha komplex objektumokat használunk. A Kryo használatához regisztrálnunk kell a szerializálandó osztályokat a Spark konfigurációjában.

A megfelelő szerializációs módszer kiválasztása jelentősen befolyásolja a Spark alkalmazás teljesítményét és erőforrás-felhasználását.

A memóriakezelés a Spark teljesítményének egy másik kritikus területe. A Spark az adatokat a memóriában tárolja, hogy gyors hozzáférést biztosítson. Azonban a memória véges erőforrás, ezért hatékonyan kell gazdálkodnunk vele. A Spark memóriakezelési modellje lehetővé teszi, hogy finomhangoljuk a végrehajtó memória beállításait, beleértve a cache és a storage memory arányát. A spark.memory.fraction és spark.memory.storageFraction konfigurációs paraméterekkel szabályozhatjuk, hogy mennyi memóriát használhat a Spark a cache-eléshez és a storage-hez. Az RDD perzisztencia használatával explicit módon cache-elhetjük az adatokat a memóriában, elkerülve a redundáns számításokat.

A Spark alkalmazások optimalizálásakor fontos figyelembe venni az adatméretet, a számítási igényeket és a rendelkezésre álló erőforrásokat. A megfelelő particionálási stratégia, a hatékony szerializációs módszer és a finomhangolt memóriakezelés kombinációjával jelentősen javíthatjuk a Spark alkalmazások teljesítményét.

- Adatok particionálása: A párhuzamos feldolgozás alapja.

- Szerializáció optimalizálása: A Kryo használata a Java szerializáció helyett.

- Memóriakezelés finomhangolása: A cache és storage memory arányának beállítása.

Spark security: Biztonsági szempontok és konfigurációk

A Spark biztonsága kritikus fontosságú a nagy adatmennyiségek feldolgozásakor. A biztonsági konfigurációk hiánya komoly kockázatot jelenthet az adatokra és a rendszerre nézve.

A Spark biztonsági modellje több területre összpontosít:

- Hitelesítés: A felhasználók és alkalmazások azonosításának folyamata. A Spark támogatja a Kerberost és az egyszerű jelszavas hitelesítést is.

- Engedélyezés: Meghatározza, hogy egy hitelesített felhasználó vagy alkalmazás milyen erőforrásokhoz férhet hozzá. Az ACL-ek (Access Control Lists) használata elengedhetetlen.

- Adattitkosítás: Az adatok védelme nyugalmi állapotban (at rest) és mozgásban (in transit). Használható TLS/SSL a kommunikációhoz és adattitkosítás a tároláshoz.

- Auditing: A biztonsági események naplózása, ami segít a problémák felderítésében és a megfelelőség biztosításában.

A Spark konfigurációs fájljaiban (pl. spark-defaults.conf) állíthatók be a biztonsági paraméterek. Például a Kerberos bekapcsolásához szükséges a spark.authenticate tulajdonság true értékre állítása és a megfelelő Kerberos beállítások megadása.

A nem megfelelően konfigurált Spark klaszter potenciális támadási felületet jelenthet.

A Spark UI (felhasználói felület) szintén biztonsági kockázatot jelenthet, ha nem megfelelően van védve. Javasolt a Spark UI elérésének korlátozása és a hitelesítés bekapcsolása.

További biztonsági intézkedések közé tartozik a hálózati tűzfalak használata, a rendszeres biztonsági frissítések telepítése és a biztonsági rések rendszeres felmérése.

Spark használati esetei: Adattudomány, Big Data analitika, és valós idejű alkalmazások

Az Apache Spark egy gyors és általános célú elosztott számítási keretrendszer, amelyet a nagyméretű adathalmazok feldolgozására terveztek. Sokoldalúsága miatt számos területen alkalmazható, leggyakrabban az adattudományban, a Big Data analitikában és a valós idejű alkalmazásokban találkozhatunk vele.

Az adattudomány területén a Spark lehetővé teszi a nagyméretű adathalmazok hatékony elemzését és modellezését. A gépi tanulási algoritmusok párhuzamosítása révén a Spark MLlib könyvtára gyorsabbá teszi a modellek betanítását és a predikciók generálását, mint a hagyományos módszerek. Gyakran használják ajánlórendszerek, csalásfelderítés és képfelismerő rendszerek fejlesztéséhez.

A Big Data analitika során a Spark segítségével hatalmas mennyiségű adatot lehet interaktívan lekérdezni és elemezni. A Spark SQL modul lehetővé teszi a SQL-szerű lekérdezések futtatását strukturált adatokon, míg a Spark Streaming a valós idejű adatfolyamok feldolgozására alkalmas. A Spark használatával a vállalatok értékes információkat nyerhetnek ki a nagy adathalmazokból, amelyek segítenek a döntéshozatalban és az üzleti folyamatok optimalizálásában.

A Spark egyik legnagyobb előnye a sebessége, amelyet a memóriában történő adatkezelésnek és a párhuzamos feldolgozásnak köszönhet.

A valós idejű alkalmazások területén a Spark Streaming lehetővé teszi a folyamatosan érkező adatok azonnali feldolgozását. Ez különösen fontos olyan területeken, mint a pénzügyi tranzakciók monitorozása, az IoT eszközök adatainak elemzése és a közösségi média trendjeinek követése. A Spark segítségével a vállalatok azonnal reagálhatnak a változásokra és optimalizálhatják a működésüket.

Például, egy e-kereskedelmi vállalat a Spark Streaming segítségével valós időben elemezheti a felhasználók viselkedését a weboldalon, és személyre szabott ajánlatokat jeleníthet meg a látogatóknak. Egy másik példa lehet a közlekedési adatok valós idejű elemzése, amely lehetővé teszi a forgalmi dugók előrejelzését és a forgalomirányítás optimalizálását.

A Spark architektúrája lehetővé teszi a hibatűrő és skálázható alkalmazások fejlesztését. A Spark automatikusan kezeli az adatelosztást és a feladatütemezést, így a fejlesztők a üzleti logikára koncentrálhatnak anélkül, hogy a technikai részletekkel kellene foglalkozniuk.

A Spark jövője: Fejlesztési irányok és a legújabb funkciók

A Spark jövője izgalmas fejlesztési irányokat vetít előre, melyek célja a keretrendszer teljesítményének, skálázhatóságának és használhatóságának további növelése. Az egyik kulcsfontosságú terület a GPU-gyorsítás integrációjának elmélyítése. Ez lehetővé teszi a Spark számára, hogy a grafikus processzorok számítási erejét kihasználva jelentősen felgyorsítsa a gépi tanulási és adatelemzési feladatokat.

Egy másik fontos fejlesztési irány a valós idejű adatfeldolgozás képességeinek bővítése. A Spark Streaming és a Structured Streaming folyamatosan fejlődnek, hogy még hatékonyabban kezeljék a nagy sebességű adatfolyamokat, és alacsonyabb késleltetéssel biztosítsák az eredményeket.

A SQL optimalizálás továbbra is kiemelt figyelmet kap. A Spark SQL motorja folyamatosan finomodik, új optimalizációs technikákat vezetnek be, hogy még gyorsabb és hatékonyabb lekérdezéseket tegyenek lehetővé. Ez különösen fontos a big data környezetekben, ahol a hatalmas adatmennyiségek elemzése kritikus fontosságú.

A Spark fejlesztései a felhasználói élmény javítására is fókuszálnak, például a könnyebben használható API-k és a jobb hibakezelés révén.

A legújabb funkciók közé tartozik a Delta Lake integrációjának elmélyítése. A Delta Lake egy nyílt forráskódú tárolási réteg, amely megbízhatóságot és tranzakciós támogatást biztosít a Spark számára a data lake-ekben. Ez lehetővé teszi a felhasználók számára, hogy robusztusabb és megbízhatóbb adatfolyamokat építsenek ki.

Emellett a Kubernetes támogatás is egyre fontosabbá válik. A Spark natív Kubernetes integrációja lehetővé teszi a felhasználók számára, hogy a Spark feladatokat könnyebben és hatékonyabban telepítsék és kezeljék a konténerizált környezetekben.