A valós idejű adatfeldolgozás napjainkban kulcsfontosságúvá vált a vállalatok számára. Az azonnali reakcióképesség, az adatok gyors elemzése és az ebből származó döntések meghozatala versenyelőnyt jelent. Az Apache Kafka egy elosztott, nagy teljesítményű üzenetküldő rendszer, melyet kifejezetten erre a célra terveztek.

A Kafka alapvetően egy publish-subscribe rendszer, melyben az adatok „témákba” (topics) rendezve jelennek meg. Az adatok termelői (producers) üzeneteket küldenek ezekbe a témákba, míg a fogyasztók (consumers) feliratkoznak a témákra, hogy fogadják és feldolgozzák az üzeneteket. Ez a modell lehetővé teszi a független komponensek közötti laza kapcsolatot, ami növeli a rendszer rugalmasságát és skálázhatóságát.

A Kafka fő célja a nagy mennyiségű adat valós időben történő feldolgozása. Képes kezelni a folyamatosan beérkező adatfolyamokat, például weboldal-látogatásokat, szenzoradatokat, pénzügyi tranzakciókat vagy log fájlokat. Az adatok nem vesznek el, a rendszer biztosítja a tartós tárolást és a hibatűrő működést.

A Kafka nem csupán egy üzenetközvetítő, hanem egy komplett adatfolyam-platform, mely lehetővé teszi az adatok tárolását, feldolgozását és integrálását különböző rendszerekkel.

A Kafka architektúrájának köszönhetően horizontálisan skálázható, ami azt jelenti, hogy a rendszer teljesítménye növelhető további szerverek hozzáadásával. Ez különösen fontos a nagyvállalatok számára, ahol a feldolgozandó adatok mennyisége folyamatosan növekszik. A robosztus felépítés és a hibatűrő mechanizmusok garantálják a rendszer megbízható működését még kritikus helyzetekben is.

A Kafka alkalmazási területei rendkívül sokrétűek. Használják valós idejű analitikához, adatintegrációhoz, eseményvezérelt architektúrákhoz, és log aggregációhoz. Például, egy webáruház használhatja a Kafkát a vásárlói viselkedés valós idejű elemzésére, hogy személyre szabott ajánlatokat kínáljon.

Az Apache Kafka alapkoncepciói: Üzenetküldés és stream feldolgozás

Az Apache Kafka egy elosztott stream feldolgozó platform, mely lehetővé teszi valós idejű adatfeldolgozást és üzenetküldést. Lényege, hogy nagymennyiségű adatot képes megbízhatóan és skálázhatóan kezelni, így ideális megoldás olyan alkalmazások számára, ahol az adatok áramlása folyamatos és gyors.

A Kafka alapkoncepciója az üzenetküldés, mely során az adatok „üzenetek” formájában kerülnek továbbításra. Ezek az üzenetek „topic”-okba vannak szervezve, melyek logikai csoportosításokat képviselnek. Például, egy „rendelések” topic tartalmazhatja az összes beérkezett rendelés adatait.

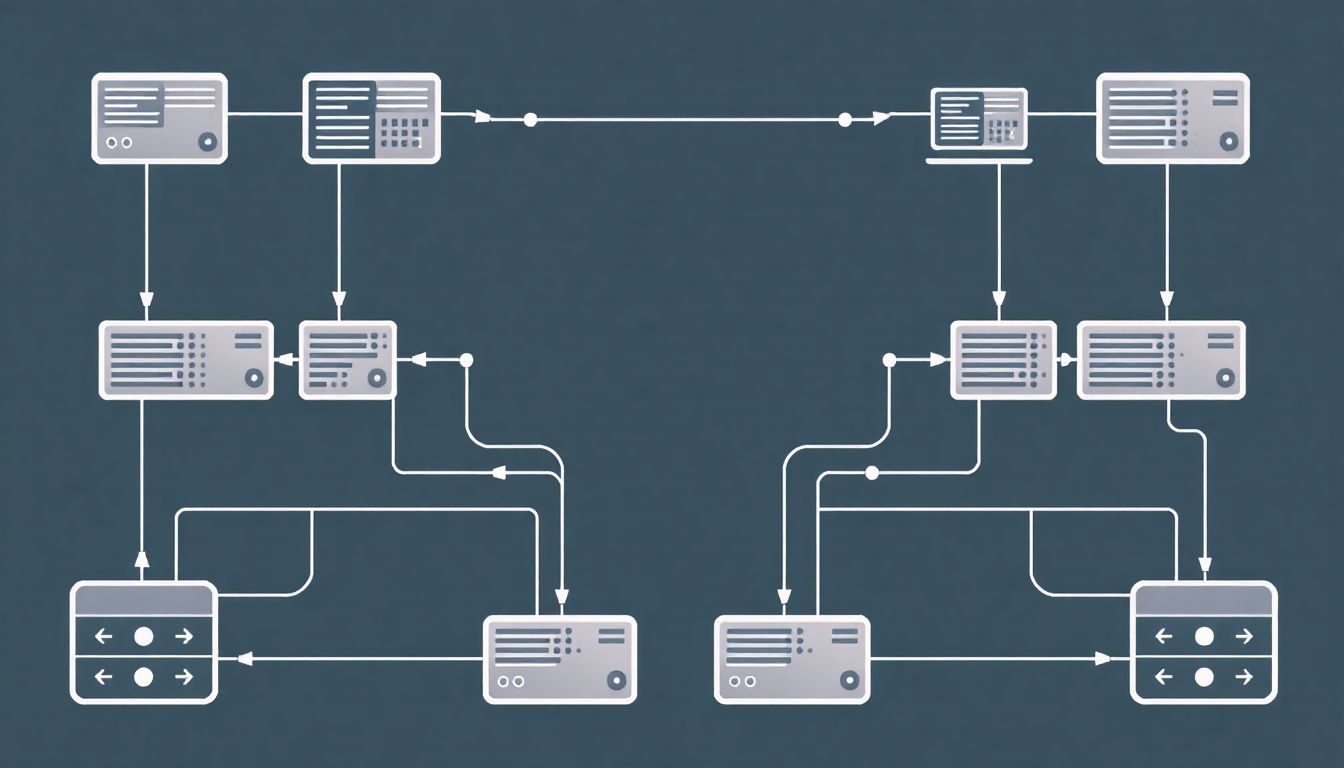

A Kafka architektúrájában két fő szereplő van: a producer és a consumer. A producer felelős az üzenetek topic-okba való küldéséért, míg a consumer feladata az üzenetek topic-okból való fogadása és feldolgozása. Egy topic-ra több producer és consumer is kapcsolódhat, ezzel párhuzamos feldolgozást biztosítva.

A Kafka lényege az adatok központi helyen történő gyűjtése és elosztása, lehetővé téve a különböző alkalmazások számára, hogy valós időben hozzáférjenek és feldolgozzák azokat.

A stream feldolgozás azt jelenti, hogy az adatok folyamatosan, valós időben kerülnek feldolgozásra, ahelyett, hogy először tárolnánk őket, majd később batch-ekben dolgoznánk fel. Ez kritikus fontosságú olyan alkalmazásoknál, mint például a pénzügyi tranzakciók monitorozása, ahol a gyors reagálás elengedhetetlen.

A Kafka particionált topic-okat használ, ami azt jelenti, hogy egy topic több partícióra van osztva. Ez lehetővé teszi a párhuzamos feldolgozást, mivel a különböző partíciók különböző szervereken tárolhatók és feldolgozhatók. A partíciók emellett biztosítják az adatok sorrendjének megőrzését a topic-on belül.

A megbízhatóság érdekében a Kafka replikálja az adatokat. Ez azt jelenti, hogy minden partícióról több másolat készül, melyek különböző szervereken tárolódnak. Ha egy szerver meghibásodik, a rendszer automatikusan átvált egy másik replikára, biztosítva ezzel az adatok folytonosságát.

A Kafka használata számos előnnyel jár:

- Skálázhatóság: Könnyen bővíthető, hogy megbirkózzon a növekvő adatmennyiséggel.

- Megbízhatóság: Az adatok replikálása garantálja az adatok folytonosságát.

- Valós idejű feldolgozás: Lehetővé teszi az adatok azonnali feldolgozását.

- Hibatűrés: A rendszer képes kezelni a szerverek meghibásodását.

A Kafka egyik legfontosabb felhasználási területe a mikroszolgáltatások közötti kommunikáció. Ahelyett, hogy a mikroszolgáltatások közvetlenül kommunikálnának egymással, a Kafka-n keresztül küldenek és fogadnak üzeneteket, ezzel lazítva a függőségeket és növelve a rendszer rugalmasságát.

Kafka architektúra: Brokerek, Zookeeper és a topicok

Az Apache Kafka egy elosztott, nagy áteresztőképességű üzenetközvetítő rendszer, amelyet valós idejű adatfolyamok kezelésére terveztek. Architektúrájának központi elemei a brokerek, a Zookeeper és a topicok. Ezek az elemek együttesen biztosítják a Kafka megbízhatóságát, skálázhatóságát és hibatűrő képességét.

A Kafka broker a rendszer alapvető építőköve. Egy broker lényegében egy szerver, amely tárolja az adatokat. Egy Kafka cluster több brokerből áll, amelyek együttesen alkotják a teljes tárolókapacitást és feldolgozási erőt. A brokerek felelősek az adatok fogadásáért a producerektől (az adatok forrásától) és az adatok elküldéséért a consumereknek (az adatok fogyasztóinak). A brokerek emellett biztosítják az adatok replikációját, ami kulcsfontosságú a hibatűrés szempontjából. Ha egy broker meghibásodik, a replikált adatok lehetővé teszik a rendszer zavartalan működését.

A Kafka cluster egy koordinált rendszer, ahol a Zookeeper kulcsszerepet játszik a brokerek és a topicok konfigurációjának kezelésében.

A Zookeeper egy elosztott koordinációs szolgáltatás, amely a Kafka cluster központi idegrendszereként funkcionál. Fő feladata a broker menedzsment, a konfiguráció kezelése és a cluster állapotának nyomon követése. A Zookeeper tárolja a topicok metaadatait, beleértve a partíciók eloszlását a brokerek között. Továbbá, a Zookeeper értesíti a brokereket a cluster változásairól, például egy új broker csatlakozásáról vagy egy meglévő broker kieséséről. A Zookeeper használata lehetővé teszi a Kafka számára, hogy dinamikusan alkalmazkodjon a változó körülményekhez, és biztosítsa a cluster stabilitását.

A topicok az adatok logikai csoportosításának egységei. Egy topic lényegében egy névvel ellátott adatfolyam. A producerek adatokat írnak a topicokba, a consumerek pedig adatokat olvasnak a topicokból. A topicok partíciókra vannak osztva, amelyek párhuzamosan kezelhetők, növelve ezzel a rendszer áteresztőképességét. Minden partíció egy rendezett, nem módosítható sorrendben tartalmazza az üzeneteket. A partíciók eloszlása a brokerek között biztosítja a terheléselosztást és a hibatűrést. A consumerek egy adott topic egy vagy több partícióját iratkozhatják fel, lehetővé téve a párhuzamos adatfeldolgozást.

A Kafka hatékony működésének záloga a brokerek, a Zookeeper és a topicok közötti szoros együttműködésben rejlik. A Zookeeper biztosítja a cluster stabilitását és koordinációját, a brokerek tárolják és kezelik az adatokat, a topicok pedig logikailag strukturálják az adatfolyamokat. Ez az architektúra lehetővé teszi a Kafka számára, hogy megbízhatóan és hatékonyan kezelje a nagyméretű, valós idejű adatfolyamokat.

Topicok és partíciók: Párhuzamos feldolgozás és skálázhatóság

Az Apache Kafka hatékonyságának és skálázhatóságának kulcsa a topicok és partíciók koncepciójában rejlik. A topic lényegében egy kategória vagy név, amelyhez az üzenetek tartoznak. Gondoljunk rá úgy, mint egy logikai csatornára, ahová a producerek üzeneteket küldenek, és a fogyasztók innen olvassák azokat.

A partíciók a topicokon belüli párhuzamosítási egységek. Egy topic egy vagy több partícióra osztható. Minden partíció egy rendezett, megváltoztathatatlan sorozat az üzenetekből. Az üzenetek sorszámmal vannak ellátva, amit offsetnek nevezünk.

Egy adott üzenet csak egy partícióban található meg, és a partíciók függetlenül működnek egymástól.

A partíciók lehetővé teszik a párhuzamos feldolgozást. Több fogyasztó is párhuzamosan olvashatja a topic különböző partícióit. Ez jelentősen növeli a rendszer átviteli sebességét (throughput). Ha például egy topicnak három partíciója van, akkor három fogyasztó párhuzamosan dolgozhatja fel az üzeneteket. A fogyasztói csoportok (consumer groups) biztosítják, hogy egy partíciót csak egy fogyasztó olvasson egy adott időpillanatban.

A Kafka horizontálisan skálázható. Ez azt jelenti, hogy a teljesítmény növelése érdekében egyszerűen hozzáadhatunk több brokert a clusterhez. A partíciók eloszthatók a különböző brokerek között, így a terhelés is eloszlik. Ha egy topicnak több partíciója van, akkor a brokerek közötti eloszlás lehetővé teszi a nagyobb átviteli sebességet és a jobb rendelkezésre állást.

A partíciók rendezett sorrendben tárolják az üzeneteket, de csak egy partíción belül. Ez azt jelenti, hogy a producer által egy partícióba küldött üzenetek a küldés sorrendjében lesznek elérhetők a fogyasztók számára. Azonban, ha egy topicnak több partíciója van, akkor az üzenetek a topic egészére nézve nem garantáltan rendezettek. Ha a rendezettség kritikus fontosságú, akkor gondoskodni kell arról, hogy az adott üzenetek mindig ugyanabba a partícióba kerüljenek, például egy kulcs (key) alapján történő partícionálással.

A topicok és partíciók konfigurálása során figyelembe kell venni a teljesítmény és a rendezettség közötti kompromisszumot. Több partíció növeli a párhuzamosságot és a skálázhatóságot, de csökkentheti a rendezettséget. A megfelelő partíciószám meghatározása a konkrét alkalmazás követelményeitől függ.

Producerek: Adatok küldése a Kafka rendszerbe

A producerek felelősek az adatok Kafka rendszerbe történő küldéséért. Ezek az alkalmazások vagy rendszerek állítják elő az adatokat, amelyeket aztán a Kafka közvetítők (broker) tárolnak. A producerek nem közvetlenül a közvetítőkkel kommunikálnak, hanem a Kafka topic-okba küldik az üzeneteket.

A topic egy logikai kategória, amelybe az azonos típusú vagy témájú adatok kerülnek. A producer kiválasztja, hogy melyik topic-ba szeretné elküldeni az üzenetet, és a Kafka rendszer gondoskodik arról, hogy az üzenet a megfelelő partíciókba kerüljön. A partíciók a topic-ok felosztásai, amelyek lehetővé teszik a párhuzamos adatfeldolgozást és a nagyobb áteresztőképességet.

A producerek konfigurálhatóak különböző beállításokkal, amelyek befolyásolják az üzenetek küldésének módját. Például beállítható, hogy a producer milyen gyakran küldje az üzeneteket (batching), vagy hogy milyen válaszokat várjon a közvetítőktől (acknowledgement). A megfelelő konfiguráció kiválasztása kritikus fontosságú a Kafka rendszer teljesítményének optimalizálásához.

Az üzenetek a Kafka rendszerbe kulcs-érték párok formájában kerülnek elküldésre, ahol a kulcs opcionális, de használata lehetővé teszi az üzenetek partíciókba rendezését a kulcs alapján.

A producereknek kezelniük kell a lehetséges hibákat is, például a hálózati problémákat vagy a közvetítők elérhetetlenségét. A Kafka API különböző mechanizmusokat kínál a hibák kezelésére, például az újraküldést (retries) és a hibatűrő konfigurációkat. Fontos, hogy a producer megfelelően kezelje ezeket a hibákat, hogy biztosítsa az adatok megbízható továbbítását.

A Kafka producer API különböző programozási nyelveken elérhető, például Java, Python, C++ és Go. Ez lehetővé teszi a fejlesztők számára, hogy könnyen integrálják a Kafka rendszert a meglévő alkalmazásaikba.

Konszumerek: Adatok fogadása és feldolgozása Kafka-ból

A Kafka rendszerben a konszumerek (fogyasztók) a kulcsszereplők, akik felelősek az adatok fogadásáért és feldolgozásáért a Kafka brokerektől. Lényegében ők azok, akik „feliratkoznak” a meghatározott topicokra, és fogadják az ott közzétett üzeneteket.

Működésük alapvetően egy pull-modell szerint történik. Ez azt jelenti, hogy a konszumerek maguk kérik le az adatokat a brokerektől, ahelyett, hogy a brokerek „tolnák” az adatokat a konszumereknek. Ez a modell rendkívül hatékony és skálázható, mivel a konszumerek saját tempójukban dolgozhatják fel az adatokat, és nem kell attól tartaniuk, hogy a broker túlterheli őket.

A konszumerek csoportokba szerveződhetnek, ezeket konszumer csoportoknak nevezzük. A Kafka biztosítja, hogy egy topic partíciójából egy időben csak egy konszumer kapjon adatot egy adott konszumer csoporton belül. Ez lehetővé teszi a párhuzamos feldolgozást, és a terhelés elosztását a konszumerek között. Ha egy csoportban több konszumer van, mint partíció, akkor néhány konszumer tétlen marad.

A Kafka a konszumer csoportok segítségével biztosítja, hogy minden üzenet pontosan egyszer kerüljön feldolgozásra (exactly-once semantics) egy adott konszumer csoporton belül.

A konszumerek offszeteket használnak az adatok követésére. Az offszet egy egyedi azonosító, amely az adott topic egy adott partíciójában lévő üzenet helyét jelzi. A konszumer rögzíti a legutóbb feldolgozott üzenet offszetjét, így ha a konszumer újraindul, onnan tudja folytatni az adatfeldolgozást, ahol abbahagyta.

A konszumer API lehetővé teszi a különböző feldolgozási logikák implementálását. A konszumer az adatokat fogadja, majd elvégzi a szükséges transzformációkat, szűréseket, vagy aggregációkat. Az eredményeket ezután elmentheti egy adatbázisba, továbbíthatja egy másik rendszernek, vagy használhatja valós idejű analitikákhoz.

Példák a konszumerek felhasználási területeire:

- Adatbázisok feltöltése: A Kafka-ból származó adatokkal feltölthetők adatbázisok, adattavak.

- Valós idejű analitika: Az adatok valós időben feldolgozhatók és vizualizálhatók.

- Eseményvezérelt architektúrák: A Kafka által közvetített eseményekre reagálhatnak a különböző szolgáltatások.

A konszumerek konfigurálásakor figyelembe kell venni a batch méretet (egy lekérdezésben hány üzenetet kér le a konszumer), a polling intervallumot (milyen gyakran kérdezze le a konszumer a brokertől az adatokat), és a commit stratégiát (milyen gyakran rögzítse a konszumer az offszeteket).

Konszumer csoportok: Terheléselosztás és hibatűrés

A Kafka konszumer csoportok kulcsfontosságú szerepet játszanak a terheléselosztásban és a hibatűrés biztosításában. Egy konszumer csoport egy vagy több konszumerből áll, amelyek közösen dolgozzák fel egy adott Kafka topic üzeneteit.

A terheléselosztás úgy valósul meg, hogy a Kafka automatikusan elosztja a topic partícióit a konszumer csoport tagjai között. Minden partícióhoz egyszerre csak egy konszumer tartozik, így biztosítva, hogy az üzenetek sorrendben kerüljenek feldolgozásra.

Ha egy konszumer kiesik a csoportból, a Kafka automatikusan újraosztja a partíciókat a megmaradt konszumerek között. Ez a mechanizmus biztosítja a hibatűrést, mivel a feldolgozás nem áll le egyetlen konszumer meghibásodása miatt.

Tegyük fel, hogy van egy topic, ami 4 partícióra van osztva, és egy konszumer csoport, ami 2 konszumerből áll. Ebben az esetben minden konszumer 2 partíció üzeneteit fogja feldolgozni. Ha az egyik konszumer leáll, a másik konszumer automatikusan átveszi a kiesett konszumer partícióit, így biztosítva a folyamatos adatfeldolgozást.

A konszumer csoportok használata lehetővé teszi a horizontális skálázhatóságot is. Ha a feldolgozási terhelés megnő, egyszerűen hozzáadhatunk új konszumereket a csoporthoz. A Kafka automatikusan elosztja a partíciókat az új konszumerek között, így növelve a feldolgozási kapacitást.

Azonban fontos megjegyezni, hogy a konszumer csoportokban lévő konszumerek számának nem szabad meghaladnia a topic partícióinak számát. Ha több konszumer van, mint partíció, akkor néhány konszumer tétlen marad, mivel nincs partíció, amit feldolgozhatnának. Ez erőforrás-pazarláshoz vezethet.

Kafka Connect: Adatok importálása és exportálása más rendszerekből

A Kafka Connect egy ingyenesen használható keretrendszer, melynek célja az adatok egyszerű és megbízható importálása és exportálása a Kafka klaszter és más rendszerek között. Lehetővé teszi, hogy külső adatbázisokból, fájlrendszerekből, kulcs-érték tárolókból és egyéb adatforrásokból adatokat olvassunk be a Kafka témákba, illetve a Kafka témákban lévő adatokat más rendszerekbe írjuk ki.

A Connect két fő típusa a forrás (source) és a fogadó (sink) csatlakozók. A forrás csatlakozók adatokat importálnak Kafka-ba, míg a fogadó csatlakozók adatokat exportálnak Kafka-ból.

A Kafka Connect kulcsfontosságú szerepet játszik a különböző rendszerek közötti adatfolyamatok automatizálásában, jelentősen csökkentve a kézi adatmozgatással járó terheket.

A Connect plug-in alapú architektúrát használ, ami azt jelenti, hogy a különböző adatforrásokhoz és célrendszerekhez speciális csatlakozókat (connectors) kell telepíteni. Ezek a csatlakozók definiálják, hogyan kell az adatokat beolvasni vagy kiírni. Számos előre elkészített csatlakozó elérhető a leggyakoribb adatbázisokhoz és rendszerekhez, de lehetőség van egyedi csatlakozók fejlesztésére is.

A Kafka Connect előnyei közé tartozik:

- Skálázhatóság: A Connect feladatok eloszthatók több worker node között, így nagy mennyiségű adatot képes kezelni.

- Megbízhatóság: A Connect beépített hibatűréssel rendelkezik, és automatikusan újraindítja a feladatokat hiba esetén.

- Egyszerű használat: A Connect konfigurálása egyszerű, és a csatlakozók telepítése és kezelése automatizált.

- Rugalmasság: A Connect támogatja a különböző adatformátumokat és transzformációkat.

A Kafka Connect REST API-n keresztül vezérelhető, ami lehetővé teszi a csatlakozók programozott konfigurálását és menedzselését. Ez különösen hasznos automatizált adatfolyamatok kialakításakor.

Kafka Streams: Valós idejű adatfeldolgozó alkalmazások építése

A Kafka Streams egy hatékony, könnyen használható könyvtár, amely lehetővé teszi valós idejű adatfeldolgozó alkalmazások építését közvetlenül a Kafka platformon. Nem igényel különálló feldolgozó klasztert, mivel az alkalmazás magában az alkalmazásban fut. Ez a megközelítés jelentősen leegyszerűsíti az architektúrát és a deployment folyamatot.

A Kafka Streams a Kafka kliens oldali könyvtára, ami azt jelenti, hogy a feldolgozás a kliens alkalmazásban történik. Ez lehetővé teszi, hogy a fejlesztők a már meglévő Kafka infrastruktúrájukat használják az adatok feldolgozásához, anélkül, hogy új rendszereket kellene bevezetniük. Az alkalmazások skálázhatósága a Kafka particionálási modelljén alapul, ami azt jelenti, hogy az adatok automatikusan elosztásra kerülnek a különböző alkalmazáspéldányok között.

A Kafka Streams egyszerű programozási modellt kínál, amely a stream-ek és táblák fogalmán alapul. A stream egy végtelen sorozat adatrekord, míg a tábla egy aktuális állapot, amely a stream-ből származik. A fejlesztők a stream-eken és táblákon végezhetnek különböző transzformációkat, például szűrést, aggregációt, csatlakozást és ablakozást.

Néhány gyakori felhasználási eset a Kafka Streams-nek:

- Valós idejű metrikák és monitoring: Adatok aggregálása és elemzése valós időben a rendszer teljesítményének nyomon követésére.

- Csalásfelderítés: Rendellenes tranzakciók azonosítása valós időben.

- Ajánlórendszerek: Felhasználói viselkedés elemzése és személyre szabott ajánlások generálása.

- IoT adatfeldolgozás: Szenzoradatok feldolgozása és elemzése valós időben.

A Kafka Streams legfontosabb előnyei közé tartozik:

- Egyszerűség: Könnyen használható API és egyszerű architektúra.

- Skálázhatóság: A Kafka particionálási modelljére épül.

- Hibatűrés: A Kafka által biztosított hibatűrési mechanizmusokat használja.

- Integráció: Szorosan integrálódik a Kafka ökoszisztémájába.

A Kafka Streams egy hatékony eszköz a valós idejű adatfeldolgozó alkalmazások építéséhez, amely lehetővé teszi a fejlesztők számára, hogy kihasználják a Kafka platform teljes potenciálját.

A Kafka Streams lehetővé teszi állapotmentes és állapotos műveletek végrehajtását is. Az állapotmentes műveletek nem igényelnek állapotot a feldolgozáshoz (pl. szűrés), míg az állapotos műveletek állapotot tárolnak (pl. aggregációk, ablakozás). Az állapotos műveletekhez a Kafka Streams egy beágyazott lokális állapot tárolót használ, amely a Kafka témákban tárolja az állapotot, biztosítva a hibatűrést.

A stream feldolgozás során gyakran szükség van időkezelésre. A Kafka Streams támogatja az esemény idő (event-time) alapú feldolgozást, ami azt jelenti, hogy az adatok feldolgozása az esemény bekövetkezésének ideje alapján történik, nem pedig a feldolgozás ideje alapján. Ez különösen fontos a valós idejű adatfeldolgozás során, mivel az adatok késhetnek vagy sorrendben érkezhetnek.

A Topology API segítségével definiálhatjuk az adatfeldolgozási folyamatot egy irányított gráfként (DAG), ahol a csomópontok a feldolgozási lépéseket (pl. szűrés, transzformáció), az élek pedig az adatáramlást jelölik. Ez a megközelítés lehetővé teszi a komplex adatfeldolgozási folyamatok egyszerű és átlátható módon történő leírását.

Kafka SQL: SQL-alapú lekérdezések a Kafka stream-ek felett

A Kafka SQL (vagy Stream SQL) lehetővé teszi, hogy SQL-szerű lekérdezéseket futtassunk a Kafka témákban tárolt valós idejű adatfolyamok felett. Ez rendkívül hasznos, ha a Kafka-ba érkező adatokon azonnal elemzéseket, aggregációkat vagy transzformációkat szeretnénk végezni anélkül, hogy az adatokat először egy adatbázisba kellene betölteni.

Számos eszköz és keretrendszer kínál Kafka SQL támogatást, beleértve a KSQLdb-t (a Confluent által fejlesztett stream feldolgozó motort), az Apache Flink-et és az Apache Spark Streaming-et. Ezek az eszközök különböző szintű SQL kompatibilitást és funkciókat kínálnak.

A Kafka SQL segítségével valós idejű döntéseket hozhatunk az adatok alapján, anélkül, hogy komplex programozási nyelveket kellene használnunk.

A Kafka SQL használatának előnyei:

- Gyorsabb elemzések: Az adatok azonnali lekérdezése lehetővé teszi a gyorsabb elemzéseket és a valós idejű problémák azonosítását.

- Egyszerűbb fejlesztés: Az SQL nyelv ismerete sok fejlesztő számára elérhető, így könnyebb a komplex adatfeldolgozó folyamatok létrehozása.

- Költséghatékonyság: Nincs szükség külön adatbázisra az adatok tárolásához és elemzéséhez, így csökkenthető a költség.

Példa egy egyszerű KSQLdb lekérdezésre, amely megszámolja a felhasználói aktivitásokat:

SELECT user_id, COUNT(*) FROM user_activity GROUP BY user_id;

Ez a lekérdezés a user_activity nevű Kafka témából olvassa az adatokat és a user_id alapján csoportosítva számolja meg az eseményeket. Az eredmények azonnal elérhetőek egy másik Kafka témában, vagy megjeleníthetők egy dashboard-on.

A Kafka SQL használata során figyelembe kell venni a stream feldolgozás sajátosságait, mint például az időablakok (windowing), a state management és a fault tolerance. Ezek a tényezők befolyásolják a lekérdezések pontosságát és teljesítményét.

Kafka biztonság: Hitelesítés, jogosultságkezelés és titkosítás

A Kafka biztonságának biztosítása kritikus fontosságú a valós idejű adatfeldolgozó rendszerek integritásának és bizalmasságának megőrzéséhez. Ez három fő területre összpontosít: hitelesítésre, jogosultságkezelésre és titkosításra.

A hitelesítés azonosítja, hogy ki vagy mi próbál hozzáférni a Kafka klaszterhez. Több mechanizmus áll rendelkezésre, beleértve a SASL (Simple Authentication and Security Layer) protokollokat, mint például a Kerberos, a PLAIN és a SCRAM. A Kerberos erős hitelesítést biztosít egy központi kulcsszerveren keresztül, míg a PLAIN egyszerű felhasználónév/jelszó alapú hitelesítést kínál (bár kevésbé biztonságos). A SCRAM egy modernebb, jelszó alapú hitelesítési mechanizmus, amely robusztusabb védelmet nyújt.

A hitelesítés után a jogosultságkezelés szabályozza, hogy a hitelesített felhasználók vagy alkalmazások mit tehetnek a Kafka klaszterben. Az ACL-ek (Access Control Lists) határozzák meg, hogy mely felhasználók vagy csoportok rendelkeznek engedéllyel témákhoz, csoportokhoz vagy más Kafka erőforrásokhoz való hozzáféréshez. A jogosultságok közé tartozik az olvasás (consume), az írás (produce), a létrehozás és a törlés.

Megfelelő jogosultságkezelés nélkül a nem kívánt felhasználók hozzáférhetnek érzékeny adatokhoz, vagy akár megzavarhatják a Kafka klaszter működését.

A titkosítás védi az adatokat nyugalmi állapotban (at rest) és mozgásban (in transit). Az adatok nyugalmi állapotban történő titkosítása a lemezen tárolt adatok védelmét jelenti, míg a mozgásban lévő adatok titkosítása a Kafka kliensek és a brokerek közötti kommunikáció védelmét jelenti. A TLS (Transport Layer Security) a leggyakrabban használt protokoll a mozgásban lévő adatok titkosítására. A TLS biztosítja, hogy az adatok titkosított csatornán keresztül kerüljenek továbbításra, megakadályozva a lehallgatást és a manipulációt.

A titkosítás mellett a Kafka támogatja a Producer és Consumer oldalán történő titkosítást is, ami lehetővé teszi az alkalmazások számára, hogy maguk titkosítsák az adatokat, mielőtt a Kafka klaszterbe küldenék, illetve a Kafka klaszterből való olvasás után dekódolják azokat. Ez a végpontok közötti titkosítás extra védelmi réteget biztosít.

Kafka monitorozás és menedzsment: Teljesítménykövetés és hibaelhárítás

A Kafka hatékony működésének kulcsa a folyamatos monitorozás és a proaktív menedzsment. A teljesítménykövetés lehetővé teszi, hogy időben észleljük a problémákat, mielőtt azok kritikus szintet érnének el. Ilyen problémák lehetnek például a lassú üzenetfeldolgozás, a nagy késleltetés, vagy a broker túlterheltsége.

A monitorozás során kiemelten fontos metrikák a következők:

- Üzenetátviteli sebesség (throughput): Az elküldött és fogadott üzenetek száma időegység alatt.

- Késleltetés (latency): Az az idő, amíg egy üzenet eléri a célját.

- CPU és memória használat: A Kafka brokerek erőforrás-igénye.

- Lemez I/O: A lemezműveletek sebessége, ami befolyásolja az üzenetek tárolásának és lekérésének hatékonyságát.

- Fogyasztói késés (consumer lag): A különbség a legutolsó elküldött üzenet és a fogyasztó által legutóbb feldolgozott üzenet között.

Ezeket a metrikákat különböző eszközökkel és módszerekkel követhetjük nyomon, beleértve a Kafka-hoz natívan elérhető JMX-et, valamint a külső monitorozó rendszereket, mint például a Prometheus, Grafana, vagy a Datadog. A valós idejű adatok elemzésével gyorsan reagálhatunk a felmerülő problémákra.

A hibaelhárítás során elengedhetetlen a naplófájlok elemzése. A Kafka részletes naplókat vezet, amelyek információkat tartalmaznak a brokerek működéséről, a felmerülő hibákról és a figyelmeztetésekről. A naplófájlok segítségével azonosíthatjuk a probléma okát, és megtehetjük a szükséges intézkedéseket.

A Kafka menedzsment magában foglalja a brokerek konfigurálását, a topicok létrehozását és kezelését, valamint a hozzáférési jogosultságok beállítását. A megfelelő konfiguráció biztosítja a Kafka optimális működését és a rendszer biztonságát.

A hatékony monitorozás és menedzsment elengedhetetlen a Kafka-alapú rendszerek megbízhatóságának és teljesítményének biztosításához.

A hibaelhárítás során gyakran szükség van a broker újraindítására, a topicok particionálásának módosítására, vagy a fogyasztói csoportok áthelyezésére. Fontos, hogy ezeket a beavatkozásokat körültekintően végezzük el, hogy elkerüljük az adatvesztést és a rendszer leállását.

A Kafka menedzsment eszközei, mint például a Kafka Manager vagy a Burrow, segítenek a rendszer állapotának áttekintésében, a konfigurációs beállítások kezelésében és a hibaelhárítási folyamatok egyszerűsítésében.