A modern üzleti környezetben az adatok jelentik az új olajat – vagy inkább az új energiát, amely hajtja a döntéshozatalt, az innovációt és a versenyképességet. Azonban az adatok puszta létezése önmagában még nem elegendő. Ahhoz, hogy valódi értéket képviseljenek, azokat gyűjteni, feldolgozni, tisztítani, rendszerezni és megfelelő formában eljuttatni kell a felhasználókhoz és az elemző rendszerekhez. Ez a komplex feladatkör adja az adatvezénylés (data orchestration) lényegét, amely mára az üzleti intelligencia (BI) és a modern adatarchitektúrák egyik pillérévé vált.

Az adatvezénylés nem csupán egy technológiai folyamat, hanem egy átfogó stratégia, amely lehetővé teszi a vállalatok számára, hogy a szétszórt, heterogén adatforrásokból származó információkat egységes, megbízható és azonnal felhasználható adatkészletekké alakítsák. Ez a cikk részletesen bemutatja az adatvezénylés definícióját, alapvető működését, az üzleti intelligenciában betöltött kritikus szerepét, valamint a kapcsolódó kihívásokat és jövőbeli trendeket.

Az adatvezénylés definíciója és alapvető működése

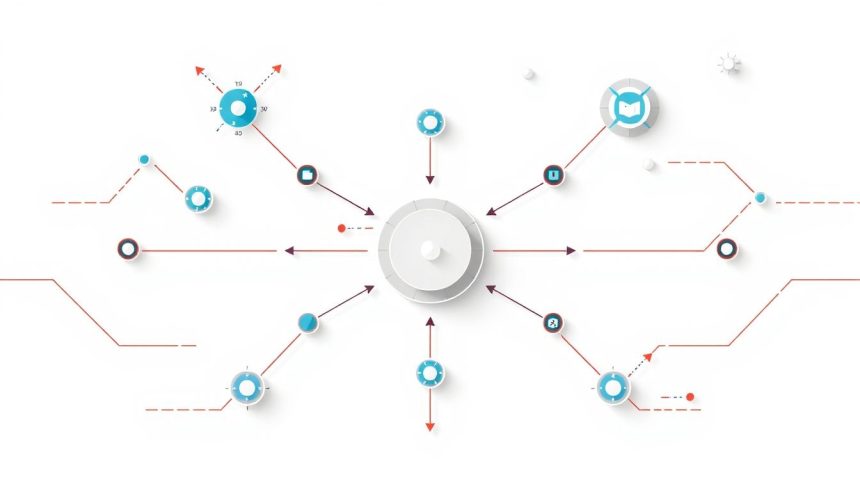

Az adatvezénylés lényegében az adatáramlások automatizált kezelésére, koordinálására és irányítására vonatkozó folyamatok és technológiák összessége, amelyek a különböző rendszerek, alkalmazások és adatforrások között mozognak. Célja, hogy az adatok a megfelelő időben, a megfelelő formában és a megfelelő helyre kerüljenek, biztosítva azok konzisztenciáját, minőségét és felhasználhatóságát a downstream rendszerek, mint például az üzleti intelligencia platformok vagy a gépi tanulási modellek számára.

Képzeljünk el egy nagyzenekart: minden hangszernek (adatforrásnak) megvan a saját dallama, ritmusa és hangszíne. Azonban ahhoz, hogy egy harmonikus szimfónia (üzleti intelligencia) szólaljon meg, szükség van egy karmesterre. Ez a karmester az adatvezénylési rendszer, amely összehangolja az egyes részeket, biztosítja a precíz időzítést és a zökkenőmentes átmeneteket. Az adatok esetében ez azt jelenti, hogy az adatvezénylés kezeli az adatok betöltését, átalakítását, tisztítását, validálását és továbbítását, gyakran különböző adatáruházakba, adattavakra vagy adatpiacokra.

Az adatvezénylés messze túlmutat az egyszerű adatáthelyezésen vagy az ETL (Extract, Transform, Load) folyamatokon. Míg az ETL egy specifikus feladatcsoportot lát el – adatok kinyerése, átalakítása és betöltése –, az adatvezénylés egy magasabb szintű absztrakciót és irányítást biztosít. Az adatvezénylés képes kezelni a komplex függőségeket, a feltételes logikákat, a hibakezelést és az erőforrás-allokációt is, gyakran több ETL folyamatot vagy más adatkezelési feladatot is összefogva egy nagyobb munkafolyamat keretében.

A modern adatvezénylési megoldások rugalmasságot kínálnak a változó adatigényekhez és rendszerekhez való alkalmazkodásban. Képesek valós idejű és kötegelt (batch) adatáramlásokat egyaránt kezelni, valamint felhőalapú és helyszíni (on-premise) környezetekben is működni. Ez a sokoldalúság teszi őket nélkülözhetetlenné a mai hibrid és multi-felhő architektúrákban.

Az adatvezénylés kulcsfontosságú szerepe az üzleti intelligenciában

Az üzleti intelligencia (BI) célja, hogy az adatokból értelmes, cselekvésre ösztönző betekintéseket nyerjen ki, amelyek támogatják a stratégiai és operatív döntéshozatalt. Azonban a BI rendszerek csak annyira jók, amennyire az általuk felhasznált adatok minősége és relevanciája. Itt lép be az adatvezénylés, mint a BI motorja, amely biztosítja az alapvető feltételeket a sikeres adatelemzéshez.

Az adatvezénylés nélkül az üzleti intelligencia olyan lenne, mint egy autó motorolaj nélkül: működésképtelen, még ha a legmodernebb technológiával is van felszerelve.

Az egyik legfontosabb szempont a megbízható és konzisztens adatok biztosítása. Különböző forrásokból származó adatok gyakran eltérő formátumúak, definíciójúak vagy akár ellentmondásosak lehetnek. Az adatvezénylés harmonizálja ezeket az adatokat, egységesíti a sémákat, tisztítja a hibákat és kitölti a hiányosságokat, így a BI jelentések és dashboardok valós, pontos képet mutatnak a vállalat működéséről.

A valós idejű vagy közel valós idejű adatokhoz való hozzáférés egyre inkább elengedhetetlenné válik. A hagyományos, kötegelt feldolgozási módszerek gyakran napokat vagy heteket vesznek igénybe, ami elavulttá teheti az információkat a gyorsan változó piaci környezetben. Az adatvezénylés lehetővé teszi az adatáramlások optimalizálását, felgyorsítását, így a BI rendszerek képesek a legfrissebb adatokkal dolgozni, támogatva az agilis döntéshozatalt és a proaktív üzleti stratégiákat.

Az adatminőség közvetlenül befolyásolja az üzleti döntések minőségét. Ha az alapul szolgáló adatok hibásak, hiányosak vagy inkonzisztensek, az elemzések és az ebből fakadó következtetések is tévesek lehetnek. Az adatvezénylési folyamatok beépített minőségellenőrzési lépéseket tartalmazhatnak, amelyek azonosítják és korrigálják az adathibákat már azelőtt, hogy azok eljutnának a BI rendszerekbe. Ez minimalizálja a „szemét be, szemét ki” (garbage in, garbage out) problémát, növelve az elemzésekbe vetett bizalmat.

Ezen túlmenően, az adatvezénylés támogatja a skálázhatóságot és rugalmasságot. Ahogy egy vállalat növekszik, úgy nő az adatmennyiség, az adatforrások száma és az elemzési igények is. Az jól megtervezett adatvezénylési architektúra képes dinamikusan alkalmazkodni ezekhez a változásokhoz, lehetővé téve új adatforrások integrálását, új elemzési igények kielégítését anélkül, hogy az egész rendszert újra kellene építeni. Ez biztosítja, hogy a BI infrastruktúra hosszú távon is fenntartható és hatékony maradjon.

Az adatvezénylési folyamat mélyreható elemzése

Az adatvezénylés nem egyetlen lépésből álló művelet, hanem egy komplex, többlépcsős folyamat, amely magában foglalja az adatok teljes életciklusának kezelését az adatforrástól a fogyasztásig. Nézzük meg részletesebben ezeket a lépéseket:

Adatforrások azonosítása és integrálása

Az első és alapvető lépés az adatforrások azonosítása. Egy modern vállalat adatai számtalan helyről származhatnak: tranzakciós adatbázisok (CRM, ERP), webanalitikai rendszerek, IoT eszközök, közösségi média platformok, külső adatszolgáltatók és még sok más. Az adatvezénylési stratégia első lépése az összes releváns adatforrás feltérképezése és azok jellemzőinek (formátum, frissítési gyakoriság, adatmennyiség) megértése.

Az integráció jelenti a következő kihívást. A különböző rendszerek eltérő API-kat, adatmodelleket és protokollokat használnak. Az adatvezénylési eszközöknek és folyamatoknak képesnek kell lenniük ezekhez a forrásokhoz csatlakozni, az adatokat kinyerni és egy egységes platformra továbbítani. Ez gyakran magában foglalja az adatok előzetes normalizálását vagy strukturálását, hogy a későbbi feldolgozás hatékonyabb legyen.

Adatátalakítás és tisztítás

Az adatátalakítás (data transformation) az a fázis, ahol a nyers adatok felhasználható formátumra válnak. Ez magában foglalhatja az adatok aggregálását, denormalizálását, összekapcsolását különböző táblákból, új mezők számítását vagy az adatok átkódolását. Például, ha egy CRM rendszerben a vevők nevei eltérő módon vannak rögzítve (pl. „Kiss János” és „kiss jános”), az átalakítás során ezeket egységesíteni kell.

Az adattisztítás (data cleansing) kritikus fontosságú a megbízható BI elemzésekhez. Ez a lépés azonosítja és javítja az adathibákat, hiányosságokat és inkonzisztenciákat. Tipikus feladatok közé tartozik a duplikátumok eltávolítása, az érvénytelen értékek javítása vagy törlése, a hiányzó adatok pótlása (ha lehetséges) és a formátumhibák korrigálása. Például, egy telefonszám mezőben lévő betűk kiszűrése vagy egy dátummező egységes dátumformátumra alakítása.

Adatáramlások tervezése és automatizálása

Az adatáramlások tervezése (workflow design) magában foglalja az összes előző lépés logikai sorrendjének és függőségeinek meghatározását. Melyik adatforrást kell először feldolgozni? Melyik átalakítás függ egy másik befejezésétől? Mikor kell futtatni az egyes feladatokat (pl. naponta egyszer, óránként, valós időben)? Az adatvezénylési eszközök vizuális felületeket vagy kódban definiált munkafolyamatokat (DAGs – Directed Acyclic Graphs) kínálnak ezen logikák felépítéséhez.

Az automatizálás az adatvezénylés egyik fő ereje. Miután a munkafolyamatokat megtervezték, az adatvezénylési platformok automatikusan futtatják azokat a meghatározott ütemezés szerint vagy eseményekre reagálva. Ez csökkenti a manuális beavatkozás szükségességét, minimalizálja az emberi hibákat és felszabadítja az IT erőforrásokat más feladatokra. Az automatizálás biztosítja a konzisztenciát és a skálázhatóságot is, mivel a komplex munkafolyamatok is megbízhatóan ismételhetők.

Monitoring és hibakezelés

A monitoring létfontosságú az adatvezénylési folyamatok egészségének fenntartásához. A rendszerek folyamatosan figyelik a futó feladatokat, az adatáramlások állapotát, a feldolgozási időket és az erőforrás-felhasználást. Ez lehetővé teszi a problémák korai felismerését, mielőtt azok komolyabb fennakadásokat okoznának.

A hatékony hibakezelés biztosítja, hogy az adatvezénylési rendszer ellenálló legyen a váratlan eseményekkel szemben. Ez magában foglalhatja az automatikus újrapróbálkozásokat sikertelen feladatok esetén, riasztások küldését az operátoroknak kritikus hibák esetén, vagy az adatok visszagörgetését egy korábbi, stabil állapotba. A részletes naplózás és hibanapló elemzés elengedhetetlen a gyökérokok azonosításához és a jövőbeli problémák megelőzéséhez.

Biztonság és megfelelőség

Az adatok kezelése során a biztonság és a megfelelőség kiemelt fontosságú. Az adatvezénylési rendszereknek biztosítaniuk kell az adatok titkosítását mind nyugalmi (at rest), mind mozgásban lévő (in transit) állapotban. Hozzáférés-vezérlési mechanizmusokat kell alkalmazni, hogy csak az arra jogosult felhasználók és rendszerek férhessenek hozzá az érzékeny adatokhoz.

Emellett a szabályozási megfelelőség (például GDPR, HIPAA, CCPA) is alapvető. Az adatvezénylésnek támogatnia kell az adatmaszkírozást, anonimizálást, az adattörlési kérelmek kezelését és az adatok származásának (data lineage) nyomon követését, hogy a vállalat bizonyítani tudja az adatkezelési gyakorlatainak jogszerűségét.

Technológiai alapok és eszközök az adatvezényléshez

Az adatvezénylés megvalósításához számos technológia és eszköz áll rendelkezésre, amelyek a vállalatok méretétől, komplexitásától és költségvetésétől függően eltérő megoldásokat kínálnak.

Felhőalapú platformok és szolgáltatások

A felhőalapú szolgáltatók (AWS, Microsoft Azure, Google Cloud Platform) integrált és skálázható megoldásokat kínálnak az adatvezénylésre. Ezek a platformok számos előnnyel járnak, mint például a rugalmas erőforrás-allokáció, a menedzselt szolgáltatások, amelyek csökkentik az üzemeltetési terheket, és a könnyű integráció más felhőalapú adatszolgáltatásokkal.

- AWS Step Functions: Lehetővé teszi komplex, elosztott alkalmazások és munkafolyamatok koordinálását vizuálisan. Ideális az ETL folyamatok, mikroszolgáltatások és gépi tanulási munkafolyamatok vezénylésére.

- Azure Data Factory: Egy felhőalapú ETL és adatintegrációs szolgáltatás, amely lehetővé teszi adatáramlások létrehozását, ütemezését és kezelését különböző adatforrások között. Különösen jól integrálódik az Azure ökoszisztémájával.

- Google Cloud Composer (Apache Airflow alapú): Menedzselt Apache Airflow szolgáltatás, amely lehetővé teszi a munkafolyamatok kód alapú definiálását és ütemezését Pythonban. Nagy rugalmasságot és testreszabhatóságot kínál.

Nyílt forráskódú megoldások

A nyílt forráskódú eszközök népszerűek a rugalmasságuk, a közösségi támogatás és a költséghatékonyság miatt, különösen azoknak a vállalatoknak, amelyek nagyobb kontrollt szeretnének az infrastruktúrájuk felett.

- Apache Airflow: Az egyik legnépszerűbb nyílt forráskódú adatvezénylési platform. Lehetővé teszi a munkafolyamatok (DAGs – Directed Acyclic Graphs) programozott definiálását Pythonban. Skálázható, rugalmas és széles körű integrációs lehetőségeket kínál.

- Prefect: Egy modern munkafolyamat-kezelő rendszer, amelyet a Python adatudományi ökoszisztémájára optimalizáltak. Célja, hogy megbízhatóbb és robusztusabb adatáramlásokat hozzon létre, különös hangsúlyt fektetve a hibakezelésre és a dinamikus munkafolyamatokra.

- Dagster: Egy másik Python-alapú adatvezénylési keretrendszer, amely az adatok tesztelhetőségére, megfigyelhetőségére és karbantarthatóságára fókuszál. Kifejezetten az adatudományi és gépi tanulási munkafolyamatokra tervezték.

Integrált adatplatformok

Vannak olyan integrált platformok is, amelyek az adatvezénylés mellett más adatkezelési funkciókat (pl. adattárolás, elemzés, gépi tanulás) is magukban foglalnak. Ilyenek például a Databricks, Snowflake, vagy az adatvezénylésre specializált, de széles körű integrációval rendelkező DataOps platformok.

Az API-k (Application Programming Interfaces) és mikroszolgáltatások szintén kulcsszerepet játszanak az adatvezénylésben. Az API-k lehetővé teszik a különböző rendszerek közötti programozott kommunikációt, míg a mikroszolgáltatások architektúrája elősegíti a moduláris, függetlenül fejleszthető és telepíthető adatfeldolgozási egységek kialakítását, amelyek könnyen vezényelhetők.

Az adatvezénylés előnyei és kihívásai

Az adatvezénylés jelentős előnyöket kínál a vállalatoknak, de bevezetése és fenntartása bizonyos kihívásokat is tartogat.

Előnyök

Az adatvezénylés számos kézzelfogható előnnyel jár, amelyek közvetlenül hozzájárulnak az üzleti teljesítmény javulásához:

- Fokozott hatékonyság és automatizálás: A manuális adatkezelési feladatok minimalizálásával az IT és adatszakértők ideje felszabadul stratégiai feladatokra. Az automatizált munkafolyamatok gyorsabbá és megbízhatóbbá teszik az adatfeldolgozást.

- Jobb adatminőség és megbízhatóság: Az adatok tisztítása, validálása és egységesítése révén a BI rendszerekbe pontosabb és konzisztensebb adatok kerülnek, ami megbízhatóbb elemzéseket és döntéseket eredményez.

- Gyorsabb betekintések és döntéshozatal: A valós idejű vagy közel valós idejű adatokhoz való hozzáférés lehetővé teszi a vállalatok számára, hogy gyorsabban reagáljanak a piaci változásokra és opportunitásokra.

- Skálázhatóság és rugalmasság: Az adatvezénylési rendszerek könnyen alkalmazkodnak a növekvő adatmennyiséghez és az új adatforrásokhoz, biztosítva az adatarchitektúra jövőállóságát.

- Csökkentett működési költségek: A manuális munka csökkentése, a hibák minimalizálása és az erőforrások hatékonyabb felhasználása hosszú távon költségmegtakarítást eredményezhet.

- Fokozott megfelelőség és biztonság: Az adatok származásának nyomon követése, a hozzáférés-vezérlés és a titkosítás támogatása segít a szabályozási követelmények teljesítésében és az adatbiztonság növelésében.

Kihívások

Az előnyök mellett az adatvezénylés bevezetése és menedzselése bizonyos nehézségeket is felvet:

- Komplexitás: Különösen nagy és heterogén adatforrásokkal rendelkező vállalatoknál az adatvezénylési munkafolyamatok rendkívül komplexek lehetnek, ami a tervezést és a karbantartást is megnehezíti.

- Költségek: A robusztus adatvezénylési platformok és eszközök licencdíjai, valamint a felhőalapú erőforrások költségei jelentősek lehetnek. Emellett a szakértelem hiánya is növelheti a költségeket.

- Szakértelem hiánya: Az adatvezénylési rendszerek tervezéséhez, fejlesztéséhez és üzemeltetéséhez speciális készségekre van szükség adatmérnöki, DevOps és felhőtechnológiai területeken, ami hiánycikk lehet a munkaerőpiacon.

- Meglévő rendszerek integrációja: A régi, örökölt (legacy) rendszerek integrálása az új adatvezénylési platformokba gyakran nehézkes és időigényes lehet, kompatibilitási problémák miatt.

- Adatminőség fenntartása: Bár az adatvezénylés célja az adatminőség javítása, a minőségi szabályok folyamatos frissítése és betartatása nagy kihívást jelenthet a változó adatforrások és üzleti igények mellett.

- Biztonsági aggályok: Az adatok több rendszeren keresztüli áramoltatása növeli a potenciális biztonsági kockázatokat. Megfelelő titkosítási, hozzáférés-vezérlési és monitorozási mechanizmusok nélkül az érzékeny adatok veszélybe kerülhetnek.

Az adatvezénylés kapcsolata más adatkezelési paradigmákkal

Az adatvezénylés nem egy elszigetelt koncepció, hanem szorosan összefügg számos más adatkezelési paradigmával és technológiával. A megfelelő megértésükhöz fontos tisztázni a különbségeket és az átfedéseket.

Adatcsatornák (data pipelines) és adatvezénylés

Az adatcsatorna egy sorozatnyi lépés, amely az adatokat egy forrásból egy célba mozgatja, miközben feldolgozza és átalakítja azokat. Egy adatcsatorna lehet egyszerű (pl. egy CSV fájl betöltése egy adatbázisba) vagy komplex (több forrásból származó adatok egyesítése, tisztítása, aggregálása és gépi tanulási modellek betanítása). Az adatcsatornák az adatvezénylés építőkövei.

Az adatvezénylés ezzel szemben a nagyobb kép. Az adatvezénylés kezeli és koordinálja az adatcsatornák közötti függőségeket, ütemezi a futásukat, kezeli a hibákat, figyeli a teljesítményt és biztosítja, hogy az adatok a megfelelő sorrendben és időben áramoljanak a különböző csatornákon keresztül. Egy adatvezénylési rendszer sok adatcsatornát vezényelhet egyszerre, vagy egy komplex adatcsatornán belül is vezényelhet részfolyamatokat.

Adatirányítás (data governance) és adatvezénylés

Az adatirányítás az adatok kezelésére vonatkozó szabályok, folyamatok és felelősségi körök rendszere, amely biztosítja az adatok minőségét, biztonságát, megfelelőségét és hozzáférhetőségét. Az adatirányítás a „mit” és a „miért” kérdésekre ad választ, meghatározza az adatpolitikákat.

Az adatvezénylés a „hogyan” kérdésre fókuszál. Az adatvezénylés biztosítja, hogy az adatirányítási politikák és szabályok technikailag is megvalósuljanak az adatáramlásokon keresztül. Például, ha az adatirányítás előírja az érzékeny adatok maszkírozását, az adatvezénylési folyamat tartalmazza azt a lépést, amely elvégzi ezt a maszkírozást. Az adatvezénylés tehát az adatirányítási stratégia technikai végrehajtója.

Adatminőség (data quality) és adatvezénylés

Az adatminőség az adatok pontosságára, teljességére, konzisztenciájára, időszerűségére és relevanciájára vonatkozó mérőszám. A rossz adatminőség hibás elemzésekhez és rossz üzleti döntésekhez vezet.

Az adatvezénylés alapvető fontosságú az adatminőség biztosításában és fenntartásában. Az adatvezénylési munkafolyamatokba beépített tisztítási, validálási és ellenőrzési lépések proaktívan javítják az adatok minőségét, még mielőtt azok eljutnának a fogyasztó rendszerekhez. Az adatvezénylés lehetővé teszi az adatminőségi szabályok automatizált alkalmazását és a minőségi problémák gyors azonosítását.

Adatháló (data mesh) és adatvezénylés

Az adatháló (data mesh) egy decentralizált adatarchitektúra, amely az adatokat termékként kezeli, és domain-specifikus csapatoknak adja át az adatok tulajdonjogát és felelősségét. Célja, hogy skálázhatóbbá és agilisabbá tegye az adatkezelést nagyvállalatoknál.

Az adatháló kontextusában az adatvezénylés szerepe átalakul. Ahelyett, hogy egy központi csapat vezényelné az összes adatáramlást, minden domain csapat felelős a saját adattermékeihez tartozó adatvezénylésért. Azonban még ebben a decentralizált modellben is szükség van egyfajta „meta-vezénylésre” vagy „federált vezénylésre”, amely biztosítja az interoperabilitást és az egységes szabványok betartását a domainek között.

Adatszövet (data fabric) és adatvezénylés

Az adatszövet (data fabric) egy integrált adatkezelési platform, amely egységes, valós idejű és intelligens hozzáférést biztosít a heterogén adatforrásokhoz. Célja az adatsilók lebontása és az adatokhoz való hozzáférés egyszerűsítése az egész vállalatban, gyakran mesterséges intelligencia és gépi tanulás segítségével.

Az adatszövet architektúrában az adatvezénylés az egyik alapvető komponens. Az adatszövet automatikusan felfedezi, rendszerezi és vezényli az adatáramlásokat a különböző források között, gyakran intelligens módon, a metaadatok és a gépi tanulási algoritmusok alapján. Itt az adatvezénylés nemcsak a „hogyan” kérdésre ad választ, hanem a „mikor” és a „hol” kérdésekre is, optimalizálva az adatáramlásokat a legjobb teljesítmény és hatékonyság érdekében.

Gyakorlati alkalmazási területek és esettanulmányok

Az adatvezénylés számos iparágban és üzleti funkcióban nélkülözhetetlen, ahol az adatokból származó betekintések kulcsfontosságúak a versenyelőny fenntartásához.

Pénzügyi szektor

A pénzügyi intézmények hatalmas mennyiségű tranzakciós adatot, ügyféladatot és piaci adatot generálnak. Az adatvezénylés kritikus szerepet játszik a kockázatkezelésben, a csalásfelderítésben és a szabályozási megfelelőségben. Például, valós idejű adatvezényléssel lehet monitorozni a tranzakciókat gyanús mintázatok után kutatva, vagy konszolidálni a különböző rendszerekből származó adatokat a Basel III vagy GDPR jelentésekhez.

Egy vezető bank az adatvezénylés bevezetésével 30%-kal csökkentette a havi jelentések elkészítési idejét, miközben 15%-kal növelte az adatok pontosságát a különböző részlegek között.

Kiskereskedelem

A kiskereskedelemben az adatvezénylés segíti az ügyfélélmény személyre szabását, a készletoptimalizálást és az értékesítési előrejelzéseket. Az online és offline vásárlási adatok, a marketingkampányok adatai és a beszállítói lánc adatai integrálhatók és vezényelhetők, hogy egységes képet kapjunk az ügyfélről és a termékek mozgásáról. Ez lehetővé teszi célzott ajánlatok küldését, a raktárkészletek hatékonyabb kezelését és az értékesítési trendek pontosabb előrejelzését.

Egészségügy

Az egészségügyi szektorban az adatvezénylés kulcsfontosságú a betegellátás javításában, a kutatás támogatásában és a működési hatékonyság növelésében. Elektronikus egészségügyi nyilvántartások (EHR), orvosi képalkotó rendszerek, viselhető eszközök és laboratóriumi adatok integrálásával az orvosok teljesebb képet kaphatnak a páciensek állapotáról, míg a kutatók gyorsabban férhetnek hozzá a nagy adatkészletekhez az új terápiák fejlesztéséhez.

Gyártás

A gyártásban az IoT (Internet of Things) eszközökből származó adatok vezénylése alapvető a prediktív karbantartáshoz, a minőségellenőrzéshez és az ellátási lánc optimalizálásához. Az érzékelőkből származó valós idejű adatok feldolgozásával előre jelezhető a gépek meghibásodása, optimalizálható a gyártási folyamat és javítható a termékminőség.

Marketing és értékesítés

Marketing és értékesítés területén az adatvezénylés lehetővé teszi a perszonalizált marketingkampányokat, az ügyfélút elemzését és az értékesítési teljesítmény nyomon követését. A CRM, marketing automatizálási platformok, webanalitikai eszközök és közösségi média adatok integrálásával a vállalatok pontosabb ügyfélprofilokat hozhatnak létre, optimalizálhatják a kampányokat és javíthatják a konverziós arányokat.

Jövőbeli trendek és az adatvezénylés evolúciója

Az adatvezénylés területe folyamatosan fejlődik, ahogy az adatmennyiség, az adatforrások és az elemzési igények is növekednek. Néhány kulcsfontosságú trend rajzolódik ki a jövőre nézve.

Mesterséges intelligencia és gépi tanulás szerepe

A mesterséges intelligencia (MI) és a gépi tanulás (ML) egyre nagyobb szerepet kap az adatvezénylésben. Az MI-alapú algoritmusok képesek automatizálni az adatok felfedezését, a sémák illesztését, az adatminőségi problémák azonosítását és akár a munkafolyamatok optimalizálását is. Például, az ML modellek előre jelezhetik, hogy mely adatforrásokat kell előnyben részesíteni, vagy milyen átalakításokra van szükség a legjobb eredmény eléréséhez. Ez a „smart orchestration” csökkenti a manuális beavatkozást és növeli a hatékonyságot.

Valós idejű adatvezénylés

A jövő az azonnali, valós idejű adatoké. Ahogy a streaming adatok mennyisége nő (IoT, clickstream, pénzügyi tranzakciók), úgy válik egyre kritikusabbá a valós idejű adatvezénylés. Ez lehetővé teszi az azonnali reagálást az eseményekre, például fraud detektálást, személyre szabott ajánlatok azonnali megjelenítését vagy a gyártósorok valós idejű optimalizálását. Ehhez olyan technológiákra van szükség, mint az Apache Kafka, Flink vagy Spark Streaming, amelyek integrálódnak az adatvezénylési platformokkal.

Demokratizált adatvezénylés (no-code/low-code)

A „no-code/low-code” megközelítések megjelenése az adatvezénylésben azt jelenti, hogy az üzleti felhasználók is képesek lesznek egyszerűbb adatáramlásokat létrehozni és kezelni programozási ismeretek nélkül. Ez a demokratizált adatvezénylés felgyorsítja az innovációt, csökkenti az IT-re nehezedő terheket és lehetővé teszi, hogy az adatokkal dolgozók gyorsabban jussanak hozzá a szükséges információkhoz anélkül, hogy adatmérnöki csapatokra kellene várniuk.

Adatbiztonság és adatvédelem (GDPR, CCPA)

Az adatbiztonság és adatvédelem továbbra is kiemelt fontosságú marad, sőt, a szabályozások szigorodásával (pl. GDPR, CCPA) még inkább előtérbe kerül. Az adatvezénylési rendszereknek natívan kell támogatniuk a személyes adatok anonimizálását, maszkírozását és törlését, valamint az adatok származásának (data lineage) részletes nyomon követését. A beépített biztonsági funkciók és a szabályozási megfelelőségi auditálási képességek alapvetőek lesznek.

Hibrid és multi-felhő környezetek vezénylése

Egyre több vállalat működik hibrid (helyszíni és felhőalapú) vagy multi-felhő (több felhőszolgáltatót használó) környezetben. Az adatvezénylési platformoknak képesnek kell lenniük az adatáramlások zökkenőmentes kezelésére ezekben a komplex, elosztott architektúrákban, biztosítva az adatok konzisztenciáját és biztonságát a különböző környezetek között.

Az adatvezénylés tehát nem egy statikus technológia, hanem egy dinamikusan fejlődő terület, amely folyamatosan alkalmazkodik az üzleti igényekhez és a technológiai innovációkhoz. Ahogy a vállalatok egyre inkább adatvezérelté válnak, az adatvezénylés szerepe csak növekedni fog, mint az üzleti intelligencia és az adatalapú döntéshozatal alapvető mozgatórugója.