A multimodális MI (Multimodal Artificial Intelligence) egy olyan terület a mesterséges intelligencián belül, amely arra törekszik, hogy a gépek az emberekhez hasonlóan, egyszerre több különböző típusú adatot (modalitást) képesek legyenek feldolgozni és értelmezni. Ezek a modalitások lehetnek például szöveg, kép, hang, videó, vagy szenzoradatok. A hagyományos MI rendszerek gyakran csak egyetlen modalitásra összpontosítanak, ami korlátozza a valós világ összetett helyzeteinek megértését.

A multimodális MI lényege, hogy a különböző modalitásokból származó információkat integrálja és korrelálja. Ezáltal a rendszer képes mélyebb, árnyaltabb következtetéseket levonni, és olyan feladatokat megoldani, amelyek egyetlen modalitás alapján nem lennének lehetségesek. Például, egy videó elemzésekor a rendszer egyszerre figyelembe veheti a képi tartalmat, a hangot (beszéd, zene, zajok) és a feliratokat, hogy megértse a videó kontextusát és tartalmát.

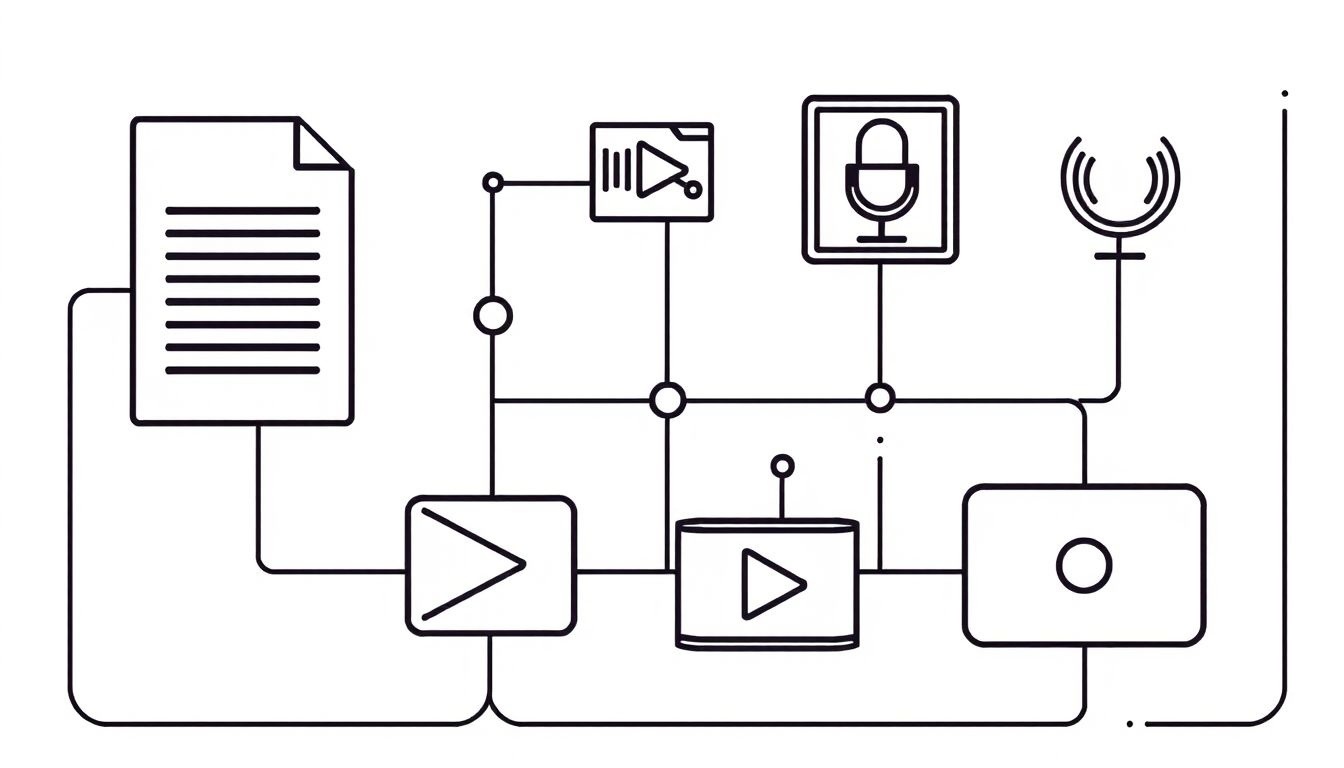

A multimodális MI működése több lépésből áll. Először is, a rendszer feldolgozza az egyes modalitásokat külön-külön, jellemzőket von ki belőlük, és valamilyen formában reprezentálja őket. Ezt követően, a rendszer összehangolja a különböző reprezentációkat, és megpróbálja megtalálni a kapcsolatokat és korrelációkat közöttük. Ez a folyamat történhet például mélytanulási modellek segítségével, amelyek képesek automatikusan megtanulni a modalitások közötti összefüggéseket.

A multimodális MI célja, hogy a gépek képesek legyenek a valós világ komplexitásának megértésére, az emberekhez hasonlóan, a különböző érzékszervi információk egyidejű feldolgozásával.

A multimodális MI számos területen kínál potenciális előnyöket. A beszédértés területén például lehetővé teszi, hogy a rendszer ne csak a kimondott szavakat, hanem a beszélő arckifejezését és hangszínét is figyelembe vegye, ami javítja a beszédértés pontosságát. A képi tartalom elemzése során a rendszer a képen látható objektumok mellett a hozzájuk tartozó szöveges leírásokat is felhasználhatja, ami segít a képek pontosabb azonosításában és kategorizálásában. Az önvezető autók esetében a multimodális MI lehetővé teszi, hogy az autó ne csak a kamerák képéből, hanem a radar- és lidar-adatokból is információt gyűjtsön, ami növeli a biztonságot és a megbízhatóságot.

A multimodális MI egy gyorsan fejlődő terület, amely jelentős potenciált rejt magában a jövő technológiáinak fejlesztésében. A különböző modalitások integrálásával a gépek képesek lesznek komplexebb problémákat megoldani, és az emberekhez hasonlóan, a valós világ összetettségét megérteni.

A multimodalitás alapelvei és a humán érzékelés kapcsolata

A multimodális MI többféle érzékelési módból származó adatokat képes feldolgozni és értelmezni. Hasonlóan ahhoz, ahogy mi, emberek a világot érzékeljük: nem csak látunk, hanem hallunk, tapintunk, szagolunk és ízlelünk is. Ezek az érzékelések együttesen adnak egy teljesebb képet a valóságról.

A humán érzékeléshez hasonlóan, a multimodális MI is arra törekszik, hogy különböző adatforrásokat, például képeket, szöveget, hangot és videót integráljon. Ez az integráció lehetővé teszi a rendszer számára, hogy a puszta adatokon túlmenően mélyebb összefüggéseket fedezzen fel.

A multimodalitás lényege, hogy az egyes modalitások információi kiegészítik egymást, ezáltal a rendszer pontosabb és robusztusabb következtetéseket vonhat le.

Például, egy képről önmagában nehéz lehet megállapítani, hogy mi történik rajta pontosan. Ha azonban a képhez tartozik egy leíró szöveg, vagy egy hangfelvétel, amely a kép készítésekor készült, akkor a rendszer sokkal jobban megértheti a jelenetet.

A multimodális MI alkalmazásai rendkívül sokrétűek:

- Képfelismerés: A képhez tartozó szöveges leírás segíthet a tárgyak pontosabb azonosításában.

- Beszédértés: A beszédhang mellett a nonverbális jelek (arc mimika, gesztusok) figyelembe vétele javíthatja a beszédértés pontosságát.

- Robotika: A robotok a különböző érzékelőik (kamerák, mikrofonok, tapintásérzékelők) segítségével egy komplex képet alkothatnak a környezetükről, és ennek megfelelően cselekedhetnek.

Az adatok összehangolása és értelmezése kulcsfontosságú a multimodális rendszerek működésében. Ehhez gyakran mélytanulási módszereket használnak, amelyek képesek a különböző modalitások közötti komplex kapcsolatok feltárására.

A multimodális MI architektúrák típusai: Korai, késői és köztes fúzió

A multimodális MI rendszerek lényege, hogy több különböző modalitásból származó adatokat képesek integrálni és értelmezni. Ezek a modalitások lehetnek például szöveg, kép, hang, videó, vagy akár szenzoradatok. A különböző modalitások kombinálásának módja nagyban befolyásolja a rendszer teljesítményét és képességeit. Az architektúrák alapvetően három fő típusba sorolhatók: korai fúzió, késői fúzió és köztes fúzió.

Korai fúzió esetén a különböző modalitásokból származó adatok a lehető legkorábbi szakaszban, jellemzően a feldolgozó hálózat bemeneténél kerülnek egyesítésre. Ez azt jelenti, hogy a nyers adatok, vagy azok kezdeti reprezentációi kerülnek összefűzésre. Előnye, hogy a rendszer képes a modalitások közötti korrelációkat már a kezdetektől figyelembe venni. Például, egy kép és a hozzá tartozó leírás korai fúziója lehetővé teheti, hogy a rendszer a kép vizuális elemeit a szöveges kontextus alapján értelmezze. Hátránya viszont, hogy a modalitások eltérő jellege és formátuma nehézségeket okozhat az egyesítési folyamatban. Emellett a rendszer érzékenyebb lehet az egyes modalitások hiányára vagy zajára.

A késői fúzió ezzel szemben a modalitásokat külön-külön dolgozza fel, és csak a végső döntési szakaszban egyesíti az eredményeket. Minden modalitás egy külön „szakértőként” működik, és a rendszer a szakértők véleményét kombinálja. Előnye, hogy a modalitások sajátosságaihoz igazodó, specializált modellek használhatók, és a rendszer robusztusabb az egyes modalitások hiányával szemben. Például, ha egy képről nem áll rendelkezésre leírás, a rendszer továbbra is képes lehet a kép alapján döntést hozni. Hátránya, hogy a modalitások közötti korrelációk kevésbé kerülnek kihasználásra, és a rendszer kevésbé képes a modalitások közötti finom interakciókat megragadni.

A korai fúzió a modalitások közötti korrelációk kihasználására törekszik, míg a késői fúzió a robusztusságra és a specializált modellek használatára fókuszál.

A köztes fúzió egy kompromisszumot jelent a korai és késői fúzió között. Ebben az esetben a modalitásokból származó adatok a feldolgozó hálózat köztes rétegeiben kerülnek egyesítésre. Ez lehetővé teszi, hogy a rendszer bizonyos szinten figyelembe vegye a modalitások közötti korrelációkat, ugyanakkor megőrzi a modalitások sajátosságaihoz igazodó feldolgozás lehetőségét. A köztes fúzió rugalmasabb architektúrát tesz lehetővé, amely jobban alkalmazkodik a különböző feladatokhoz és adathalmazokhoz. Például, a rendszer egyes modalitásokat korán egyesíthet, míg másokat csak később, a feladat jellegétől függően.

A fúziós stratégia megválasztása nagyban függ a feladat jellegétől, az elérhető adatok mennyiségétől és minőségétől, valamint a rendszerrel szemben támasztott követelményektől. Nincs egyetlen „helyes” megoldás, a legmegfelelőbb architektúra kiválasztása kísérletezést és a probléma alapos megértését igényli.

A leggyakoribb modalitások a multimodális MI-ben: Szöveg, kép, hang, videó, szenzor adatok

A multimodális MI lényege, hogy egyszerre több különböző típusú adatot, úgynevezett modalitást használ fel a következtetések levonásához és a feladatok megoldásához. A leggyakoribb modalitások közé tartozik a szöveg, a kép, a hang, a videó és a szenzor adatok. Mindegyik modalitás más-más típusú információt hordoz, és a kombinációjukkal a MI rendszerek sokkal komplexebb és pontosabb képet kaphatnak a világról.

A szöveg az egyik legelterjedtebb modalitás. Lehetővé teszi a MI számára, hogy természetes nyelven kommunikáljon, információkat gyűjtsön dokumentumokból, weboldalakról vagy akár közösségi média bejegyzésekből. A szöveges adatok elemzése során a MI rendszerek képesek megérteni a szavak jelentését, a mondatok szerkezetét és a szöveg kontextusát.

A képek és videók vizuális információkat hordoznak. A képek elemzése lehetővé teszi a tárgyak felismerését, az arcok azonosítását és a jelenetek értelmezését. A videók továbbá időbeli információkat is tartalmaznak, ami lehetővé teszi a mozgás, a viselkedés és az események elemzését. A multimodális MI rendszerek a szöveges leírásokkal kombinálva a képeket és videókat, sokkal pontosabb és részletesebb képet kaphatnak a világról.

A hang modalitás a beszédfelismerésen túl sok más információt is hordozhat. A hangszín, a hangerő és a beszéd sebessége mind-mind árulkodó jelek lehetnek az ember érzelmi állapotáról, szándékairól és személyiségéről. A zene elemzése lehetővé teszi a hangulat és a stílus azonosítását. A multimodális MI rendszerek a hangot a szöveggel és a vizuális információkkal kombinálva, sokkal árnyaltabb képet kaphatnak az emberi kommunikációról.

A szenzor adatok, mint például a hőmérséklet, a nyomás, a gyorsulás és a GPS koordináták, a fizikai világról szolgáltatnak információt.

A szenzor adatok a fizikai világról szolgáltatnak információt. Például, egy okos otthon rendszer a hőmérséklet, a páratartalom és a fényerő szenzorok adatait felhasználva képes optimalizálni a fűtést, a szellőzést és a világítást. Az önvezető autók a lidar, a radar és a kamera szenzorok adatait felhasználva képesek érzékelni a környezetüket és biztonságosan navigálni.

A multimodális MI kihasználja, hogy a különböző modalitások kiegészítik egymást. Például, egy képfelismerő rendszer, amely szöveges leírást is kap a képről, sokkal pontosabban tudja azonosítani a képen szereplő tárgyakat. Egy beszédfelismerő rendszer, amely látja az arc mimikáját, sokkal jobban megérti a beszédet, különösen zajos környezetben.

A modalitások kombinálásának számos módja létezik. Néhány módszer a korai fúzióra épül, ahol a különböző modalitásokból származó adatokat a feldolgozás elején kombinálják. Más módszerek a késői fúziót alkalmazzák, ahol a különböző modalitásokból származó eredményeket a feldolgozás végén kombinálják. Az egyes módszerek előnyei és hátrányai a konkrét alkalmazástól függnek.

Adatfúziós technikák: Konkatenáció, súlyozott átlagolás, figyelem mechanizmusok

A multimodális MI rendszerek ereje abban rejlik, hogy képesek különböző típusú adatok (móduszok) együttes feldolgozására. Ilyen móduszok lehetnek például a szöveg, kép, hang és videó. Az adatok integrálása, más néven adatfúzió kulcsfontosságú lépés a multimodális rendszerekben. Többféle technika létezik az adatok egyesítésére, melyek közül a leggyakoribbak a konkatenáció, a súlyozott átlagolás és a figyelem mechanizmusok.

A konkatenáció egy egyszerű, mégis hatékony módszer az adatok összevonására. Lényege, hogy a különböző móduszokból származó reprezentációkat (pl. vektorokat) egyszerűen egymás mellé fűzzük. Például, ha egy képből és egy szövegből származó vektoraink vannak, ezeket egymás mellé illesztve egy hosszabb vektort kapunk, ami mindkét módusz információit tartalmazza. Ez a hosszú vektor aztán betáplálható egy neurális hálózatba további feldolgozásra. A konkatenáció előnye, hogy könnyen implementálható és gyorsan elvégezhető. Hátránya viszont, hogy nem veszi figyelembe a különböző móduszok közötti kapcsolatokat, és a keletkező vektor dimenziószáma jelentősen megnőhet.

A súlyozott átlagolás egy kifinomultabb megközelítés, amely lehetővé teszi, hogy a különböző móduszok fontosságát figyelembe vegyük. Ebben az esetben minden móduszhoz egy súlyt rendelünk, amely azt jelzi, hogy az adott módusz mennyire releváns a feladat szempontjából. A végső reprezentációt a móduszok súlyozott átlagaként számítjuk ki. A súlyok lehetnek rögzítettek, vagy tanulhatók a tréning során. Például, egy képfelismerési feladatnál a kép módusz kaphat nagyobb súlyt, mint a szöveg. A súlyozott átlagolás előnye, hogy rugalmasabban kezeli a különböző móduszok fontosságát, és csökkentheti a zajos vagy irreleváns adatok hatását. A megfelelő súlyok megtalálása azonban kihívást jelenthet.

A figyelem mechanizmusok (attention mechanisms) a legfejlettebb adatfúziós technikák közé tartoznak. Ezek a mechanizmusok lehetővé teszik, hogy a rendszer dinamikusan meghatározza, hogy az egyes móduszok mely részei a legfontosabbak a feladat szempontjából. A figyelem mechanizmusok jellemzően egy figyelmi súlyt generálnak minden módusz minden elemére (pl. egy szöveg minden szavára, vagy egy kép minden régiójára). Ezek a súlyok azt jelzik, hogy az adott elem mennyire fontos a feladat szempontjából. A figyelemmel súlyozott reprezentációkat aztán összevonják, hogy a végső reprezentációt megkapják. Például, egy képaláírás generálási feladatnál a figyelem mechanizmus segíthet a rendszernek abban, hogy a kép mely részeire kell a leginkább koncentrálnia az aláírás generálásakor.

A figyelem mechanizmusok különösen hatékonyak a multimodális adatok közötti komplex kapcsolatok feltárásában.

Számos különböző architektúra létezik a figyelem mechanizmusok implementálására, de a leggyakoribbak a transzformátor alapú modellek. Ezek a modellek párhuzamosan tudják feldolgozni a különböző móduszokat, és hatékonyan tudják megragadni a hosszú távú függőségeket. A figyelem mechanizmusok előnye, hogy nagyon rugalmasak és hatékonyak, de a tréningjük komplex és erőforrásigényes lehet.

Az alábbiakban egy példa látható a figyelem mechanizmus működésére egy videó és szöveg alapú kérdés-válasz rendszerben:

- A videót képkockák sorozatára bontják, és minden képkockából kinyernek vizuális jellemzőket.

- A kérdést beágyazzák egy vektor reprezentációba.

- A figyelem mechanizmus a kérdés vektor és a videó képkockák vizuális jellemzői alapján kiszámítja a figyelmi súlyokat minden képkockára.

- A képkockákat a figyelmi súlyokkal súlyozzák, és összevonják a végső videó reprezentáció megkapásához.

- A videó és kérdés reprezentációkat egyesítik, és betáplálják egy válasz generáló modellbe.

A megfelelő adatfúziós technika kiválasztása a konkrét feladattól és a rendelkezésre álló adatoktól függ. A konkatenáció egyszerűsége miatt jó kiindulópont lehet, míg a súlyozott átlagolás és a figyelem mechanizmusok komplexebb feladatokhoz alkalmasabbak.

A multimodális MI alkalmazási területei: Képfelismerés szöveges leírással, hangulatfelismerés videóból

A multimodális MI (vagyis a különböző típusú adatokkal dolgozó mesterséges intelligencia) ígéretes alkalmazási területeket nyit meg, melyek közül kettő kiemelkedő: a képfelismerés szöveges leírással és a hangulatfelismerés videóból. Ezek a területek a gépi tanulás különböző modalitásait – képet, szöveget és hangot – integrálják, hogy komplexebb és árnyaltabb elemzéseket végezzenek.

A képfelismerés szöveges leírással lehetővé teszi, hogy a rendszer ne csak felismerje, mi van egy képen, hanem azt is, hogy elmondja, mit lát. Ez túlmutat a hagyományos képfelismerési feladatokon, ahol a rendszer egyszerűen címkézi a képet (pl. „kutya”, „macska”, „autó”). Ehelyett a multimodális megközelítés képes részletes leírásokat generálni, például: „Egy barna labrador ül a zöld fűben, a háttérben egy kék autó látható”. Ez a képesség különösen hasznos lehet olyan alkalmazásokban, mint a látássérültek segítése, ahol a rendszer felolvassa a környezetük leírását, vagy a képek automatikus indexelése és keresése a képtárakban.

A multimodális MI lehetővé teszi, hogy a gépek a világot az emberekhez hasonlóan, különböző érzékszervekből származó információk alapján értelmezzék.

A működés alapja általában az, hogy a képet egy konvolúciós neurális hálózat (CNN) dolgozza fel, ami képi jellemzőket von ki. Ezzel párhuzamosan egy szöveges modell (például egy rekurrens neurális hálózat, RNN, vagy egy transzformer alapú modell) van betanítva arra, hogy ezekből a képi jellemzőkből szöveget generáljon. A két modell közötti kapcsolatot egy attribúció mechanizmus teremti meg, ami lehetővé teszi, hogy a rendszer figyelmet fordítson a kép azon részeire, amelyek a generált szöveg szempontjából a legfontosabbak.

A hangulatfelismerés videóból egy másik izgalmas alkalmazási terület. Ebben az esetben a rendszer nem csak a videó képanyagát, hanem a hangját és a hozzá tartozó szöveget (ha van) is elemzi, hogy következtetéseket vonjon le a szereplők érzelmi állapotáról. Például, egy videókonferencián a rendszer képes lehet felismerni, ha valaki stresszes vagy ideges, és figyelmeztetni a moderátort, hogy avatkozzon be.

A hangulatfelismerés videóból számos kihívást rejt magában. A nonverbális jelek (például a testbeszéd és az arckifejezések) értelmezése összetett feladat, és az érzelmek kifejezése kultúránként eltérő lehet. Ezenkívül a hangszín és a beszéd sebessége is fontos információt hordozhat az érzelmi állapotról. A szöveg (például a szubtitrált párbeszéd) elemzése pedig segíthet a kontextus megértésében és az érzelmek pontosabb azonosításában. A multimodális megközelítés előnye, hogy a rendszer képes kompenzálni az egyes modalitások hiányosságait. Például, ha a képanyag rossz minőségű, a rendszer a hangból és a szövegből nyert információkra támaszkodhat.

Ezek az alkalmazások rávilágítanak arra, hogy a multimodális MI hogyan képes új lehetőségeket nyitni a gépi tanulás területén. A különböző modalitások integrálásával a rendszerek képesek komplexebb és árnyaltabb feladatokat elvégezni, ami közelebb visz bennünket ahhoz, hogy a gépek valóban megértsék a világot körülöttünk.

A multimodális MI alkalmazási területei: Robotika, önvezető autók, orvosi diagnosztika

A multimodális MI, vagyis a több érzékelési módot kombináló mesterséges intelligencia, forradalmasítja számos területet, különösen a robotikát, az önvezető autókat és az orvosi diagnosztikát. Lényege, hogy nem csupán egyetlen típusú bemeneti adatot (pl. képet vagy szöveget) használ, hanem egyszerre több forrásból származó információt dolgoz fel, így sokkal átfogóbb és pontosabb képet kap a valóságról.

A robotikában a multimodális MI lehetővé teszi, hogy a robotok sokkal komplexebb feladatokat hajtsanak végre. Egy robot, amely egyszerre lát (kamerák), hall (mikrofonok) és tapint (nyomásérzékelők), képes például egy zsúfolt raktárban biztonságosan navigálni, tárgyakat felismerni és azokat a megfelelő helyre tenni. A vizuális információk mellett a hang alapján azonosíthatja a közeledő embereket vagy gépeket, a tapintással pedig megállapíthatja a tárgyak súlyát és textúráját.

Az önvezető autók működése elképzelhetetlen a multimodális MI nélkül. A járművek szenzorok sokaságát használják – kamerák, lidar, radar, ultrahang – hogy a környezetükről információkat gyűjtsenek. A multimodális MI ezeket az adatokat fuzionálja, ami lehetővé teszi az autó számára, hogy a sávokat tartsa, felismerje a közlekedési táblákat, elkerülje az akadályokat és reagáljon a váratlan helyzetekre. Például, ha egy kamera nem látja tisztán az útburkolati jeleket eső miatt, a radar adatai segíthetnek a sávtartásban.

Az orvosi diagnosztika területén a multimodális MI a különböző képalkotó eljárások (röntgen, MRI, CT) és a beteg egyéb adatai (kórtörténet, laboreredmények) együttes elemzésével segíti az orvosokat a pontosabb diagnózis felállításában. Egy multimodális MI rendszer képes észlelni a daganatokat a röntgenfelvételeken, figyelembe véve a beteg kórtörténetét és a laboreredményeit, ezáltal csökkentve a téves diagnózisok számát és javítva a kezelés hatékonyságát. A rendszer képes a rejtett összefüggések feltárására is, ami az emberi szem számára nem feltétlenül nyilvánvaló.

A multimodális MI alkalmazása lehetővé teszi a rendszerek számára, hogy a valós világot sokkal pontosabban és átfogóbban érzékeljék, ami elengedhetetlen a komplex feladatok automatizálásához és a hatékony döntéshozatalhoz.

Ezeken a területeken kívül a multimodális MI számos más területen is alkalmazható, mint például a személyre szabott oktatás, a vásárlói élmény javítása és a biztonsági rendszerek fejlesztése. A technológia fejlődésével a multimodális MI egyre nagyobb szerepet fog játszani a jövőben.

A multimodális MI kihívásai: Adatok szinkronizálása, zajos adatok kezelése, eltérő adatformátumok

A multimodális MI (Multimodális Mesterséges Intelligencia) ígéretes terület, de számos kihívással néz szembe, amelyek gátolják a széles körű alkalmazását. Ezek a kihívások elsősorban az adatok természetéből és az integrációjuk komplexitásából erednek.

Az egyik legjelentősebb akadály az adatok szinkronizálása. A különböző modalitásokból (pl. kép, szöveg, hang) származó adatok gyakran eltérő időskálán érkeznek. Például egy videóban a képkockák másodpercenként többször változnak, míg a hozzá tartozó hanganyag vagy szöveges leírás lényegesen lassabban. A multimodális rendszernek képesnek kell lennie ezeket az eltérő időbeli információkat összehangolni, hogy a megfelelő összefüggéseket tudja feltárni.

Egy másik komoly probléma a zajos adatok kezelése. Valós környezetben a modalitásokból származó adatok szinte mindig tartalmaznak zajt. A képek lehetnek homályosak vagy rosszul megvilágítottak, a hanganyag tartalmazhat háttérzajt, a szövegek pedig elírásokat vagy nyelvtani hibákat. A zajos adatok jelentősen rontják a multimodális rendszer teljesítményét, ezért robusztus módszereket kell alkalmazni a zaj csökkentésére vagy a zajra való érzékenység minimalizálására.

A zajos adatok kezelése kritikus fontosságú a multimodális MI megbízhatóságának és pontosságának szempontjából.

Végül, az eltérő adatformátumok is jelentős kihívást jelentenek. A különböző modalitásokból származó adatok különböző formátumokban érkeznek (pl. képek pixelmátrixként, szövegek karakterláncként, hanganyag hanghullámként). Ahhoz, hogy a multimodális rendszer képes legyen feldolgozni ezeket az adatokat, először át kell alakítani őket egy közös reprezentációba. Ez az átalakítás bonyolult lehet, és információvesztéssel járhat, ha nem megfelelően végzik.

A megoldások keresése során a kutatók és mérnökök számos megközelítést alkalmaznak, beleértve a mélytanulási módszereket, amelyek képesek automatikusan tanulni a különböző modalitások közötti kapcsolatokat, valamint a statisztikai modelleket, amelyek a zajos adatok hatásának csökkentésére szolgálnak. A multimodális MI fejlődése szorosan összefügg ezen kihívások sikeres leküzdésével.

Tanulási módszerek multimodális MI-hez: Mélytanulás, erősítéses tanulás, transzfer tanulás

A multimodális MI rendszerek különféle tanulási módszereket alkalmaznak a különböző modalitásokból származó adatok hatékony feldolgozására és integrálására. Ezek közül a mélytanulás, az erősítéses tanulás és a transzfer tanulás kiemelkedő szerepet játszanak.

A mélytanulás, különösen a neurális hálózatok, kiválóan alkalmasak arra, hogy automatikusan tanuljanak komplex reprezentációkat nagy mennyiségű, strukturálatlan adatból, mint például képekből, szövegekből és hanganyagokból. A konvolúciós neurális hálózatok (CNN-ek) képek feldolgozására, a rekurrens neurális hálózatok (RNN-ek) pedig szekvenciális adatok, mint például szövegek vagy idősorok elemzésére használhatók. A mélytanulás lehetővé teszi a modalitások közötti korrelációk feltárását és a magas szintű, absztrakt jellemzők kinyerését.

A mélytanulás alapú modellek képesek a különböző modalitásokból származó információkat egy közös reprezentációs térbe leképezni, ami elősegíti a modalitások közötti interakciók megértését és a pontosabb előrejelzéseket.

Az erősítéses tanulás (Reinforcement Learning – RL) egy másik fontos megközelítés, amely lehetővé teszi az MI-ügynökök számára, hogy interakcióba lépjenek egy környezettel, és megtanulják, hogyan maximalizálják a jutalmakat. Multimodális környezetben ez azt jelentheti, hogy az ügynök különböző szenzorokból származó információkat (pl. látás, hallás, tapintás) használ fel a döntések meghozatalához. Az RL különösen hasznos lehet olyan feladatoknál, ahol a cél a cselekvések sorozatának optimalizálása, például robotikában vagy autonóm járművek vezérlésében.

A transzfer tanulás pedig lehetővé teszi, hogy egy feladaton vagy modalitáson szerzett tudást átvigyük egy másik, kapcsolódó feladatra vagy modalitásra. Ez különösen értékes, ha kevés adat áll rendelkezésre egy adott modalitás számára. Például, egy képek osztályozására betanított modellt finomhangolhatunk egy új, kapcsolódó feladatra, mint például objektumok detektálására, vagy akár szöveges adatok elemzésére, ha a reprezentációk megfelelően illeszkednek.

A multimodális MI etikai kérdései: Torzítások, adatvédelem, felelősség

A multimodális MI, amely különböző adattípusokat (szöveg, kép, hang, videó) képes értelmezni és integrálni, komoly etikai kérdéseket vet fel. Az egyik legégetőbb probléma a torzítások jelenléte a betanító adatokban. Ha például egy képfelismerő rendszer, amely nagyrészt fehér bőrű emberekről készült képeken tanult, kevésbé pontosan azonosítja a más etnikumú arcokat, az diszkriminációhoz vezethet.

Az adatvédelem szintén kritikus szempont. A multimodális rendszerek gyakran személyes és érzékeny adatokat dolgoznak fel, ami növeli a visszaélés kockázatát. Különösen aggályos, ha a rendszereket arcfelismerésre, hangazonosításra vagy egyéb biometrikus adatok elemzésére használják anélkül, hogy a felhasználók egyértelműen hozzájárulnának.

A multimodális MI rendszerek által hozott döntések felelősségének kérdése nehezen megválaszolható. Ki a felelős, ha egy önvezető autó, amely a vizuális és szenzoros adatok alapján hoz döntéseket, balesetet okoz? A fejlesztő, a gyártó vagy a felhasználó?

A multimodális MI átláthatósága is problémás lehet. Sok ilyen rendszer „fekete dobozként” működik, azaz nem lehet megérteni, hogy pontosan milyen alapon hozták meg a döntéseiket. Ez megnehezíti a hibák feltárását és a méltányosság biztosítását.

A fenti problémák kezelése érdekében elengedhetetlen a tudatos fejlesztés, a szigorú tesztelés és az átlátható algoritmusok alkalmazása. Emellett fontos a megfelelő jogi szabályozás kialakítása is, amely védi a felhasználók jogait és biztosítja a felelősségre vonhatóságot.

A multimodális MI jövőbeli irányai: Magyarázható MI (XAI), élethosszig tartó tanulás, új modalitások integrálása

A multimodális MI jövője izgalmas irányokat tartogat, melyek közül kiemelkedik a magyarázható MI (XAI). A jelenlegi modellek gyakran „fekete dobozként” működnek, nehezen érthető, miért hoznak egy adott döntést. Az XAI célja, hogy ezeket a döntéseket átláthatóvá tegye, különösen fontos a multimodális rendszereknél, ahol a különböző bemeneti adatok (pl. kép, szöveg, hang) komplex kölcsönhatásban állnak.

Egy másik kulcsfontosságú terület az élethosszig tartó tanulás (Lifelong Learning). Ahelyett, hogy minden új feladathoz a modellt a nulláról kellene betanítani, az élethosszig tartó tanulás lehetővé teszi, hogy a modell folyamatosan, inkrementálisan tanuljon új információkat anélkül, hogy elfelejtené a korábbi tudását. Ez különösen előnyös a multimodális MI számára, mivel a világ folyamatosan változik, és a modelleknek alkalmazkodniuk kell az új adatokhoz és modalitásokhoz.

A jövőben a multimodális MI képes lesz új modalitásokat integrálni, mint például a szag, íz vagy akár a felhasználó agyhullámai, ezzel is bővítve az érzékelési tartományt és a lehetséges alkalmazásokat.

A új modalitások integrálása egy folyamatosan fejlődő terület. Bár a kép, szöveg és hang adatok széles körben elterjedtek, más érzékelési módok is értékes információkat hordozhatnak. Például a szagok elemzése segíthet a betegségek diagnosztizálásában, az ízek elemzése az élelmiszeriparban, az agyhullámok elemzése pedig a felhasználói élmény javításában.

Ezen irányok mindegyike hozzájárul ahhoz, hogy a multimodális MI rendszerek intelligensebbek, megbízhatóbbak és hasznosabbak legyenek a mindennapi életben. A magyarázhatóság növeli a felhasználók bizalmát, az élethosszig tartó tanulás biztosítja a folyamatos fejlődést, az új modalitások integrálása pedig új lehetőségeket nyit meg.

Példák sikeres multimodális MI projektekre és kutatásokra

A multimodális MI területe rohamosan fejlődik, számos sikeres projekt és kutatás bizonyítja a technológia potenciálját. Ezek a projektek gyakran kombinálják a képeket, szövegeket, hangokat és egyéb adatokat, hogy komplexebb és pontosabb eredményeket érjenek el.

Egyik kiemelkedő példa az automatikus képaláírás generálás. A modellek képesek elemezni a képeket és releváns, természetes nyelvi leírásokat generálni hozzájuk. Ez különösen hasznos lehet a látássérültek számára, vagy a nagy mennyiségű képanyag automatikus kategorizálásához.

A beszédértés és -generálás területén is jelentős előrelépések történtek. A multimodális modellek nem csak a szöveget, hanem a beszélő hangszínét, arckifejezését és testbeszédét is figyelembe veszik, így pontosabban értelmezik a mondanivalót. Ez javítja a virtuális asszisztensek és chatbotok teljesítményét, lehetővé téve a természetesebb interakciót.

A multimodális MI a jövőben kulcsszerepet játszik majd az ember-gép interakcióban, az orvosi diagnosztikában és a robotikában.

Az orvosi képalkotás egy másik terület, ahol a multimodális MI hatalmas potenciált rejt. A különböző képalkotó eljárások (röntgen, MRI, CT) eredményeinek kombinálásával a modellek képesek pontosabb diagnózist felállítani, és korábban észrevenni a betegségeket. Például, egy modell, amely a mammogramot és a beteg anamnézisét egyaránt figyelembe veszi, pontosabban képes megjósolni a mellrák kockázatát.

A robotikában a multimodális MI lehetővé teszi, hogy a robotok jobban megértsék a környezetüket és hatékonyabban végezzenek feladatokat. Egy robot, amely a kamerakép, a lidar adatok és a tapintási információk alapján tájékozódik, könnyebben navigál komplex környezetekben és képes tárgyakat manipulálni.

A YouTube videóinak elemzése is egy érdekes alkalmazási terület. A Google kutatói olyan modelleket fejlesztettek, amelyek a videó képi és hanganyagát egyaránt elemzik, hogy megértsék a videó tartalmát és kontextusát. Ez lehetővé teszi a videók automatikus címkézését és ajánlását, ami javítja a felhasználói élményt.

Néhány további példa:

- Érzelmek felismerése: Arckifejezés, hangszín és szöveges tartalom alapján azonosítani az érzelmi állapotot.

- Autonóm vezetés: Kamerák, radarok, lidarok és GPS adatok kombinálásával biztonságosabbá tenni a vezetést.

- Kreatív tartalmak generálása: Szöveges leírás alapján képeket vagy zenét generálni.

Ezek a sikeres projektek és kutatások bizonyítják, hogy a multimodális MI képes leküzdeni az egyetlen adatforrásra támaszkodó modellek korlátait, és új lehetőségeket nyit a mesterséges intelligencia alkalmazására.