A felügyelt tanulás a gépi tanulás egyik alapvető ága, ahol a cél egy olyan modell létrehozása, ami képes előrejelezni a kimenetet a bemeneti adatok alapján. A felügyelet itt abban rejlik, hogy a modell címkézett adatokkal van betanítva, vagyis minden bemeneti adat mellé a helyes kimenet is meg van adva. Ez lehetővé teszi a modell számára, hogy megtanulja a kapcsolatot a bemenet és a kimenet között.

A felügyelt tanulás két fő típusa a klasszifikáció és a regresszió. A klasszifikációs problémákban a cél, hogy a bemeneti adatot egy adott kategóriába soroljuk be. Például, egy e-mail lehet spam vagy nem spam. Ezzel szemben a regressziós problémákban a cél egy folytonos érték előrejelzése, mint például egy ház ára a mérete és elhelyezkedése alapján.

A felügyelt tanulás működése a következőképpen foglalható össze:

- Adatgyűjtés: Címkézett adatok gyűjtése, ahol minden bemeneti adat mellé a kívánt kimenet is rendelkezésre áll.

- Modellválasztás: A feladathoz megfelelő modell kiválasztása. Ez lehet egy egyszerű lineáris regresszió, vagy egy komplexebb neurális hálózat.

- Modell betanítása: A modell paramétereinek beállítása a betanító adatok alapján. A cél, hogy a modell minél pontosabban tudja előrejelezni a kimeneteket.

- Modell validálása: A betanított modell teljesítményének értékelése egy külön validációs adathalmazon. Ez segít elkerülni a túltanulást, amikor a modell csak a betanító adatokra „emlékszik”, és nem tud jól teljesíteni új adatokon.

- Modell tesztelése: A végleges modell teljesítményének értékelése egy teszt adathalmazon. Ez a lépés ad egy reális képet a modell általánosítási képességéről.

A felügyelt tanulás széles körben alkalmazható a gyakorlatban. Például használják orvosi diagnosztikában (betegségek felismerése röntgenfelvételeken), pénzügyi elemzésben (részvényárfolyamok előrejelzése), és a természetes nyelvi feldolgozásban (szövegek osztályozása).

A felügyelt tanulás lényege, hogy a modell a helyes válaszokat látva tanul, és így képes új, korábban nem látott adatokra is helyes előrejelzést adni.

A sikeres felügyelt tanulási modell létrehozásához elengedhetetlen a megfelelő adatok minősége és mennyisége. A zajos vagy hiányos adatok rontják a modell teljesítményét. A jellemzőmérnökség, vagyis a releváns jellemzők kiválasztása és átalakítása is kulcsfontosságú a jó eredmények eléréséhez.

A felügyelt tanulás definíciója és alapelvei

A felügyelt tanulás a gépi tanulás egyik alapvető ága, ahol a modell címkézett adatok alapján tanul. Ez azt jelenti, hogy minden bemeneti adatponthoz tartozik egy ismert kimeneti érték vagy címke. A cél az, hogy a modell megtanulja a bemenetek és kimenetek közötti kapcsolatot, és képes legyen új, nem látott bemenetekhez helyes kimeneteket jósolni.

A felügyelt tanulás során használt algoritmusok két fő típusra oszthatók:

- Regresszió: Amikor a cél egy folytonos érték előrejelzése (pl. egy ház ára, egy hőmérséklet).

- Osztályozás: Amikor a cél a bemeneti adatpontok besorolása különböző kategóriákba (pl. spamek szűrése, képek osztályozása).

A felügyelt tanulás lényege, hogy a modell a hibáiból tanul, és fokozatosan finomítja a belső paramétereit, hogy a jövőbeli jóslatai minél pontosabbak legyenek.

A felügyelt tanulás folyamata általában a következő lépésekből áll:

- Adatgyűjtés: Címkézett adatok összegyűjtése. Minél több és jobb minőségű adat áll rendelkezésre, annál jobb lesz a modell teljesítménye.

- Adat előfeldolgozás: Az adatok tisztítása, átalakítása és formázása a modell számára megfelelő formátumba.

- Modell választás: A feladathoz leginkább illő modell kiválasztása (pl. lineáris regresszió, döntési fa, neurális hálózat).

- Modell betanítás: A modell betanítása a címkézett adatokon. Ez a lépés magában foglalja a modell paramétereinek optimalizálását a hiba minimalizálása érdekében.

- Modell validálás: A betanított modell teljesítményének értékelése egy külön validációs adathalmazon. Ez segít elkerülni a túltanulást, amikor a modell túl jól illeszkedik a betanító adatokhoz, de rosszul teljesít az új adatokon.

- Modell tesztelés: A végleges modell teljesítményének értékelése egy harmadik, teszt adathalmazon.

A felügyelt tanulás széles körben alkalmazható a valós életben, például a pénzügyi előrejelzésekben, az orvosi diagnosztikában és a marketing automatizálásban.

A felügyelt tanulás működése: az adatok szerepe, a tanítási folyamat és az algoritmusok

A felügyelt tanulás lényege, hogy a gép címkézett adatokból tanul. Ez azt jelenti, hogy minden egyes bemeneti adatponthoz tartozik egy helyes kimeneti érték, amit a gépnek meg kell tanulnia előrejelezni. Az adatok szerepe kulcsfontosságú: minél több és minél jobb minőségű adat áll rendelkezésre, annál pontosabb lesz a modell.

A tanítási folyamat során az algoritmus iteratívan próbálja megjósolni a kimeneti értékeket a bemeneti adatok alapján. Minden egyes próbálkozás után összehasonlítja a saját előrejelzését a helyes kimenettel, és korrigálja a modell paramétereit, hogy a jövőben pontosabb előrejelzéseket tudjon adni.

A felügyelt tanulás sikeressége nagymértékben függ a felhasznált adatok minőségétől és mennyiségétől, valamint a választott algoritmus megfelelőségétől az adott problémára.

Számos különböző algoritmus létezik a felügyelt tanulásra, melyek közül a legnépszerűbbek:

- Lineáris regresszió: Folyamatos értékek előrejelzésére alkalmas, például lakásárak becslésére.

- Logisztikus regresszió: Két vagy több osztályba sorolásra használható, például spam szűrésre.

- Döntési fák: Egyszerűen értelmezhető szabályrendszereket hoznak létre, amelyek segítségével döntéseket lehet hozni.

- Véletlen erdők: Több döntési fa kombinálásával pontosabb előrejelzéseket adnak.

- Támogatásvektor gépek (SVM): Hatékonyen képesek komplex adathalmazokat osztályozni.

- Neurális hálózatok: Rendkívül komplex problémák megoldására alkalmasak, például kép- és hangfelismerésre.

Az algoritmus kiválasztása a probléma jellegétől, az adatok méretétől és a kívánt pontosságtól függ. Fontos, hogy a modell teljesítményét validációs adatokon is ellenőrizzük, hogy elkerüljük a túltanulást (overfitting) – amikor a modell túl jól illeszkedik a tanító adatokhoz, de rosszul teljesít az új, ismeretlen adatokon.

A felügyelt tanulás széles körben alkalmazható a gyakorlatban, beleértve a kockázatbecslést, a vásárlói viselkedés elemzését, a diagnosztikát és a személyre szabott ajánlások kidolgozását.

A felügyelt tanulás tipikus alkalmazási területei: osztályozás és regresszió

A felügyelt tanulás két leggyakoribb alkalmazási területe az osztályozás és a regresszió. Mindkettőben a cél az, hogy egy modell a tanító adatok alapján predikciókat tegyen új, ismeretlen adatokra.

Az osztályozás során a modell célja, hogy az adatokat különböző kategóriákba sorolja be. Például, egy e-mail spam szűrő a beérkező leveleket két kategóriába sorolja: „spam” vagy „nem spam”. Hasonlóképpen, egy orvosi diagnosztikai rendszer a betegeket különböző betegségcsoportokba sorolhatja a tüneteik alapján. A tanító adatok ebben az esetben a már címkézett adatok, azaz minden adathoz tartozik egy kategória-címke. A modell a tanítás során megtanulja, hogy mely jellemzők alapján lehet az adatokat a megfelelő kategóriába sorolni.

Az osztályozás végeredménye egy diszkrét érték, a kategória, amibe az adott adat tartozik.

A regresszió ezzel szemben folytonos értékek előrejelzésére szolgál. Például, egy ingatlanár-becslő rendszer a házak jellemzői (méret, elhelyezkedés, stb.) alapján próbálja megbecsülni az eladási árat. Egy másik példa lehet a tőzsdei árfolyamok előrejelzése a múltbeli adatok alapján. A tanító adatok itt is címkézettek, de a címkék folytonos értékek, nem kategóriák.

A regressziós modellek célja, hogy megtalálják azt a matematikai függvényt, amely a legjobban leírja az összefüggést a bemeneti adatok és a kimeneti értékek között. A modell a tanítás során minimalizálja a különbséget a modell által jósolt értékek és a valós értékek között.

Mind az osztályozás, mind a regresszió fontos eszközök a gépi tanulásban, és számos valós problémára kínálnak megoldást. A megfelelő módszer kiválasztása a megoldandó probléma jellegétől függ.

Osztályozási algoritmusok a felügyelt tanulásban: logisztikus regresszió, support vector machines (SVM), döntési fák és random erdők

A felügyelt tanulás keretében az osztályozási algoritmusok kulcsszerepet játszanak abban, hogy a gép megtanuljon különböző kategóriákba sorolni adatokat. Négy elterjedt és hatékony algoritmus a logisztikus regresszió, a support vector machines (SVM), a döntési fák és a random erdők.

A logisztikus regresszió egy statisztikai modell, amelyet bináris (két kategória) osztályozási problémák megoldására használnak. Bár a neve regressziót sugall, valójában egy osztályozási algoritmus. A logisztikus regresszió egy logisztikus függvény segítségével becsüli meg a valószínűségét annak, hogy egy adott adatpont egy adott kategóriába tartozik. Az algoritmus a tanító adatok alapján megtanulja, hogy mely jellemzők a legfontosabbak az osztályozás szempontjából, és ezeket súlyozza. Az eredmény egy valószínűségi érték, amelyet egy küszöbértékkel összehasonlítva dönthetünk el, hogy az adatpont melyik kategóriába tartozik. A logisztikus regresszió könnyen értelmezhető és viszonylag gyors, de kevésbé hatékony komplex, nemlineáris adathalmazok esetén.

A Support Vector Machines (SVM) egy hatékony algoritmus mind lineáris, mind nemlineáris osztályozási problémákra. Az SVM célja, hogy megtalálja a legjobb elválasztó hipersíkot (vagyis egy vonalat 2D-ben, egy síkot 3D-ben stb.) az adatok között. A „legjobb” azt jelenti, hogy a hipersík maximalizálja a margót, azaz a távolságot a hipersík és a legközelebbi adatpontok között (ezeket hívják support vector-oknak). Az SVM képes nemlineáris adatokat is kezelni a kernel trükk segítségével, amely az adatokat egy magasabb dimenziós térbe transzformálja, ahol könnyebben elválaszthatók. Az SVM jól teljesít magas dimenziós adatokon és hatékony komplex problémák esetén, de a tanítási idő hosszabb lehet, és a paraméterek (pl. a kernel típusa és paraméterei) megfelelő beállítása kulcsfontosságú.

A döntési fák egy fa struktúrát használnak az adatok osztályozására. Minden belső csomópont egy jellemzőt képvisel, minden ág egy döntést (a jellemző értékétől függően), és minden levél csomópont egy osztályt. Az algoritmus a tanító adatok alapján rekurzív módon építi fel a fát, kiválasztva a legjobb jellemzőt minden csomópontban az adatok szétválasztására. A „legjobb” jellemző kiválasztásához különböző metrikákat használnak, mint például az entrópia vagy a Gini index. A döntési fák könnyen értelmezhetők és vizualizálhatók, és nem igényelnek sok adat előfeldolgozást. Azonban hajlamosak a túltanulásra, azaz a tanító adatokra való túlzott specializálódásra, ami rosszabb teljesítményt eredményezhet új adatokon.

A random erdők egy ensemble módszer, amely több döntési fát kombinál az osztályozás pontosságának javítása érdekében. Az algoritmus több döntési fát hoz létre a tanító adatok véletlenszerű részhalmazain (bagging) és a jellemzők véletlenszerű részhalmazain (feature randomness). Az osztályozás során minden fa leadja a saját szavazatát, és a végső osztályt a legtöbb szavazatot kapott osztály határozza meg. A random erdők csökkentik a túltanulás kockázatát és jobb általánosító képességet biztosítanak, mint az egyetlen döntési fa. Emellett robusztusak a zajos adatokkal szemben és jól kezelik a hiányzó értékeket. A random erdők azonban kevésbé értelmezhetők, mint az egyetlen döntési fa.

Az osztályozási algoritmusok kiválasztása a felügyelt tanulásban nagyban függ az adathalmaz jellemzőitől, a probléma komplexitásától és a kívánt pontosság és értelmezhetőség közötti kompromisszumtól.

Az egyes algoritmusok erősségeinek és gyengeségeinek ismerete elengedhetetlen a megfelelő modell kiválasztásához és a felügyelt tanulási feladat sikeres megoldásához.

Regressziós algoritmusok a felügyelt tanulásban: lineáris regresszió, polinomiális regresszió, support vector regression (SVR)

A felügyelt tanulásban a regressziós algoritmusok célja, hogy egy vagy több bemeneti változó alapján folytonos értékeket jósoljanak meg. Nézzük meg a legnépszerűbbeket:

Lineáris Regresszió

A lineáris regresszió a legegyszerűbb regressziós módszer. Feltételezi, hogy a bemeneti változók és a célváltozó között lineáris kapcsolat van. Az algoritmus célja egy egyenes vonal (vagy magasabb dimenziókban hipersík) illesztése az adatokhoz, ami minimalizálja a predikciók és a valós értékek közötti különbséget. Ezt a különbséget általában a legkisebb négyzetek módszerével számolják.

A lineáris regresszió képlete:

y = mx + b

ahol:

- y a predikált érték

- x a bemeneti változó

- m a vonal meredeksége

- b a tengelymetszet

Polinomiális Regresszió

Ha a bemeneti és célváltozó közötti kapcsolat nem lineáris, akkor a polinomiális regresszió lehet a megoldás. Ebben az esetben a lineáris egyenlet helyett egy polinomot illesztünk az adatokra. Például egy másodfokú polinom (parabola) használata a következőképpen néz ki:

y = ax2 + bx + c

A polinomiális regresszió rugalmasabb, mint a lineáris, mivel képes komplexebb kapcsolatokat is modellezni. Fontos azonban a polinom fokszámának helyes megválasztása, mert a túl magas fokszám túlfeszüléshez (overfitting) vezethet, ami azt jelenti, hogy a modell jól teljesít a tanító adatokon, de rosszul az új, ismeretlen adatokon.

Support Vector Regression (SVR)

A Support Vector Regression (SVR) a Support Vector Machine (SVM) algoritmus regressziós változata. Az SVR célja nem az, hogy a lehető legpontosabban jósoljon meg minden egyes értéket, hanem hogy a predikciók egy bizonyos hibahatáron belül maradjanak. Ezt a hibahatárt az epsilon paraméter határozza meg.

Az SVR a kernel trükköt használja, ami lehetővé teszi, hogy nemlineáris kapcsolatokat is modellezzen anélkül, hogy explicit módon transzformálná az adatokat. Néhány gyakori kernel típus:

- Lineáris

- Polinomiális

- Radiális bázisfüggvény (RBF)

Az SVR különösen hatékony nagy dimenziós adatok esetén, és kevésbé érzékeny a kiugró értékekre, mint a hagyományos regressziós módszerek.

Az SVR működését a következők befolyásolják:

- C paraméter: szabályozza a modell komplexitását. Nagyobb C érték kisebb hibát enged meg a tanító adatokon, ami túlfeszüléshez vezethet.

- Epsilon (ε): meghatározza a hibazónát szélességét. Az adatok azon része, amely a zónán belül esik, nem járul hozzá a költségfüggvényhez.

- Kernel típusa és paraméterei: a kernel típusa és paraméterei (pl. a RBF kernel gamma paramétere) jelentősen befolyásolják a modell teljesítményét.

Mindhárom regressziós módszer a felügyelt tanulás elvén alapul, ahol a modell a tanító adatokból tanulva próbálja meg minél jobban megjósolni a célváltozó értékét új, ismeretlen adatok esetén.

A felügyelt tanulás adathalmazának előkészítése: adatgyűjtés, adattisztítás, jellemzők kiválasztása és mérnöki munka

A felügyelt tanulásban a megfelelő adathalmaz előkészítése kritikus lépés a sikeres modell létrehozásához. Ez a folyamat négy fő fázisra osztható: adatgyűjtés, adattisztítás, jellemzők kiválasztása és jellemzők mérnöki munkája.

Adatgyűjtés: Az első lépés a releváns adatok összegyűjtése. Ez jelentheti meglévő adatbázisok használatát, webes adatgyűjtést (web scraping), érzékelők adatait, vagy akár manuális adatbevitelt. A lényeg, hogy az adatok reprezentálják azt a problémát, amit a modellnek meg kell oldania. Minél több és változatosabb az adat, annál jobb esély van egy robusztus modell létrehozására. A felügyelt tanulás során az adatoknak címkézetteknek kell lenniük, azaz minden adathoz tartoznia kell egy helyes kimenetnek (a címkének).

Adattisztítás: A valóságban az összegyűjtött adatok ritkán tökéletesek. Gyakran tartalmaznak hiányzó értékeket, zajt (hibás adatokat) és inkonzisztenciákat. Az adattisztítás célja ezeknek a problémáknak a kezelése. A hiányzó értékeket például helyettesíthetjük átlagértékekkel, mediánokkal, vagy akár egy különleges „hiányzó” értékkel. A zajt kiszűrhetjük statisztikai módszerekkel vagy vizuális elemzéssel. Az inkonzisztenciákat pedig javíthatjuk, például egységes formátumra hozva az adatokat.

A tiszta adat elengedhetetlen a pontos és megbízható modell létrehozásához.

Jellemzők kiválasztása: Nem minden adat ugyanolyan fontos a modell számára. A jellemzők kiválasztása során azokat a változókat választjuk ki, amelyek a legnagyobb hatással vannak a célváltozóra (a címkére). Ezt megtehetjük kézzel, a probléma ismeretében, vagy automatikusan, különböző statisztikai módszerekkel és gépi tanulási algoritmusokkal. A lényeg, hogy csökkentsük a modell komplexitását és javítsuk a teljesítményét azáltal, hogy eltávolítjuk a redundáns vagy irreleváns jellemzőket.

Jellemzők mérnöki munkája: Ez a legkreatívabb fázis, ahol új jellemzőket hozunk létre a meglévőkből. Például, ha van egy dátumunk, abból kinyerhetjük a napot, a hónapot, az évet, vagy akár a hét napját. Vagy ha van két különböző adatunk, akkor létrehozhatjuk a kettő hányadosát, szorzatát, stb. A cél az, hogy olyan új információkat nyerjünk ki az adatokból, amelyek segítenek a modellnek jobban megérteni a problémát. A jól megtervezett jellemzők jelentősen javíthatják a modell pontosságát.

Ezek a lépések iteratívak, ami azt jelenti, hogy gyakran vissza kell térnünk egy korábbi fázishoz, ha valami nem működik megfelelően. A jó adathalmaz előkészítése időigényes, de elengedhetetlen a sikeres felügyelt tanulási modell létrehozásához.

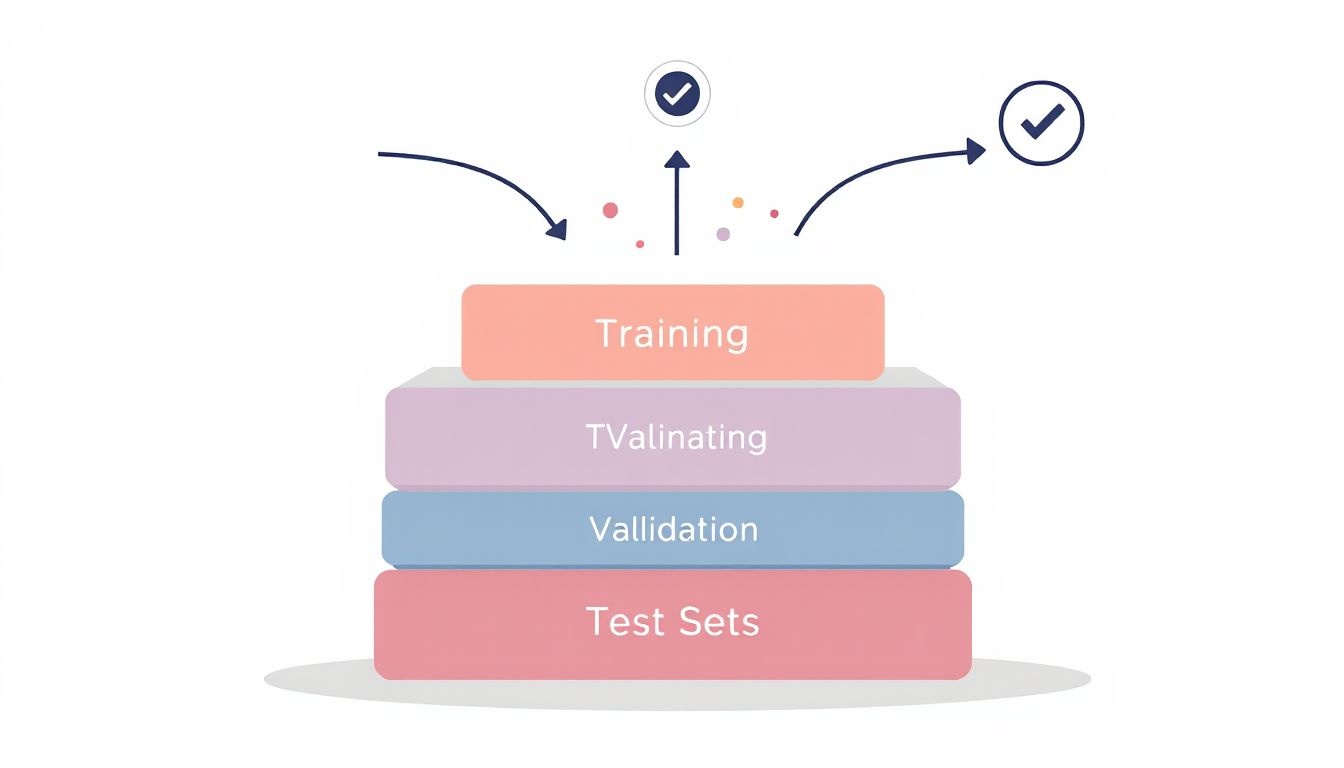

A tanítási, validációs és teszt adathalmazok szerepe a felügyelt tanulásban

A felügyelt tanulás során a modell betanításához, finomhangolásához és teljesítményének értékeléséhez különböző adathalmazokat használunk. Ezek a tanítási, validációs és teszt adathalmazok. Mindegyiknek különleges szerepe van a modell fejlesztési folyamatában.

A tanítási adathalmaz a legnagyobb, és ez az, amellyel a modellt ténylegesen *betanítjuk*. A modell ezen az adathalmazon keresztül tanulja meg a bemeneti adatok és a hozzájuk tartozó kimenetek közötti kapcsolatot. Célunk, hogy a modell minél jobban illeszkedjen ehhez az adathalmazhoz, azaz minél pontosabban tudja előrejelezni a kimeneteket a bemenetek alapján.

A validációs adathalmaz a betanítás során használt adatoktól elkülönített adathalmaz. Célja a modell finomhangolása és a *túlilleszkedés* elkerülése. A túlilleszkedés azt jelenti, hogy a modell túlságosan jól megtanulta a tanítási adathalmazt, és nem képes jól teljesíteni új, ismeretlen adatokon. A validációs adathalmaz segítségével ellenőrizzük, hogy a modell mennyire képes *általánosítani* az új adatokra. A modell paramétereit (pl. a tanulási ráta, a rétegek száma) a validációs adathalmazon elért teljesítmény alapján állítjuk be.

A validációs adathalmaz kulcsfontosságú a modell általánosítási képességének megítélésében és a hiperparaméterek optimalizálásában.

A teszt adathalmaz egy teljesen elkülönített adathalmaz, amelyet a modell betanítása és finomhangolása után használunk a modell végső teljesítményének felmérésére. Ez az adathalmaz reprezentálja azokat az adatokat, amelyekkel a modell a valós világban találkozni fog. A teszt adathalmazon elért eredmények alapján tudjuk megítélni, hogy a modell mennyire használható a gyakorlatban.

A helyes eljárás az, hogy a teszt adathalmazt csak egyszer használjuk, a modell fejlesztésének legvégén. Ha a teszt adathalmazon elért eredmények nem kielégítőek, az nem jelenthet alapot a modell további módosítására, mert ez a tesztadat szivárgásához vezethet, ami torz képet ad a modell valós teljesítményéről.

A modell teljesítményének értékelése a felügyelt tanulásban: metrikák osztályozáshoz (pontosság, precizitás, visszahívás, F1-érték, AUC)

A felügyelt tanulás során a modell teljesítményének értékelése kulcsfontosságú annak megállapításához, hogy mennyire jól képes általánosítani az új, nem látott adatokra. Osztályozási problémák esetén, ahol a cél a bemeneti adatok kategorizálása, számos metrika áll rendelkezésünkre a modell hatékonyságának mérésére.

A leggyakrabban használt metrikák közé tartozik a pontosság (accuracy), a precizitás (precision), a visszahívás (recall), az F1-érték (F1-score) és az AUC (Area Under the Curve).

- Pontosság: A helyesen osztályozott példányok aránya az összes példányhoz képest. Egyszerűen fogalmazva, megmutatja, hogy a modellünk az esetek hány százalékában ad helyes választ.

- Precizitás: A pozitívként jósolt példányok közül hány volt valóban pozitív. A precizitás azt méri, hogy a modellünk mennyire pontos, amikor azt állítja, hogy valami pozitív.

- Visszahívás: A ténylegesen pozitív példányok közül hányat sikerült a modellnek pozitívként azonosítania. A visszahívás azt méri, hogy a modellünk mennyire teljes, amikor a pozitív eseteket keresi.

- F1-érték: A precizitás és a visszahívás harmonikus közepe. Egyetlen számban foglalja össze a modell teljesítményét, figyelembe véve mind a pontosságot, mind a teljességet.

Az F1-érték különösen hasznos, ha az osztályok nem egyensúlyban vannak, azaz az egyik osztályból sokkal több példány van, mint a másikból.

Az AUC a Receiver Operating Characteristic (ROC) görbe alatti területet jelenti. A ROC görbe a modell által adott különböző küszöbértékekhez tartozó igaz pozitív arány (true positive rate) és hamis pozitív arány (false positive rate) közötti kapcsolatot ábrázolja. Az AUC érték 0 és 1 között mozog, ahol az 1 a tökéletes osztályozót jelenti. Minél nagyobb az AUC érték, annál jobb a modell teljesítménye.

Ezek a metrikák különböző szempontokból közelítik meg a modell teljesítményét. A pontosság egyszerűen értelmezhető, de félrevezető lehet kiegyensúlyozatlan adathalmazok esetén. A precizitás és a visszahívás a pozitív osztályra fókuszálnak, míg az F1-érték egyensúlyt teremt közöttük. Az AUC pedig a modell osztályozási képességét méri különböző küszöbértékek mellett.

A megfelelő metrika kiválasztása a probléma jellegétől és a céloktól függ. Például, ha a cél a hamis pozitívok minimalizálása (pl. spamszűrés), akkor a precizitás fontosabb lehet. Ha a cél a pozitív esetek azonosítása (pl. betegségdiagnosztika), akkor a visszahívás lehet a kulcsfontosságú metrika.

A modell teljesítményének értékelése a felügyelt tanulásban: metrikák regresszióhoz (MSE, RMSE, MAE, R-négyzet)

A felügyelt tanulás regressziós feladatai során a modell teljesítményének értékelése kulcsfontosságú. Számos metrika áll rendelkezésünkre annak megítélésére, mennyire jól képes a modellünk a valós értékeket előrejelezni. Nézzünk meg néhány gyakran használt metrikát:

- MSE (Mean Squared Error) – Átlagos Négyzetes Hiba: Ez a metrika az előrejelzett és a tényleges értékek közötti különbségek négyzeteinek átlagát számolja. Minél kisebb az MSE, annál jobb a modell. A négyzetre emelés miatt az MSE érzékeny a kiugró értékekre.

- RMSE (Root Mean Squared Error) – Gyök Átlagos Négyzetes Hiba: Az RMSE az MSE négyzetgyöke. Az RMSE előnye, hogy ugyanabban a mértékegységben van kifejezve, mint a célváltozó, így könnyebb értelmezni.

- MAE (Mean Absolute Error) – Átlagos Abszolút Hiba: A MAE az előrejelzett és a tényleges értékek közötti különbségek abszolút értékének átlagát számolja. Kevésbé érzékeny a kiugró értékekre, mint az MSE vagy az RMSE.

- R-négyzet (R2) – Determinációs Együttható: Az R-négyzet azt mutatja meg, hogy a modell mennyire jól magyarázza meg a célváltozó varianciáját. Értéke 0 és 1 között van. Minél közelebb van az 1-hez, annál jobban illeszkedik a modell az adatokra. Egy negatív R-négyzet érték azt jelzi, hogy a modell rosszabbul teljesít, mint egy egyszerű átlag.

Ezek a metrikák különböző szempontok alapján értékelik a modell teljesítményét. Az MSE és RMSE a hibák nagyságát büntetik, a MAE kevésbé érzékeny a kiugró értékekre, míg az R-négyzet a modell magyarázó erejét méri.

A megfelelő metrika kiválasztása a feladat jellegétől és a célkitűzésektől függ.

Például, ha a kiugró értékek nagy hatással vannak a döntéseinkre, akkor érdemes az RMSE-t használni. Ha viszont a kiugró értékek nem relevánsak, akkor a MAE lehet a jobb választás. Az R-négyzet hasznos lehet a különböző modellek összehasonlítására, de önmagában nem ad teljes képet a modell pontosságáról.

Fontos, hogy ne csak egyetlen metrikára hagyatkozzunk a modell értékelésekor. Érdemes több metrikát is figyelembe venni, és az eredményeket a feladat kontextusában értelmezni.

A túltanulás (overfitting) és alultanulás (underfitting) problémái a felügyelt tanulásban és a megoldási módszerek (regularizáció, keresztvalidáció)

A felügyelt tanulás során a modellek célja, hogy egy adott bemenethez a helyes kimenetet társítsák, tanulva a rendelkezésre álló címkézett adatokból. Azonban ez a folyamat nem mentes a kihívásoktól. Két gyakori probléma merül fel: a túltanulás (overfitting) és az alultanulás (underfitting).

A túltanulás akkor következik be, amikor a modell túlságosan „megtanulja” a tréning adatok zaját és sajátosságait ahelyett, hogy a mögöttes mintázatot azonosítaná. Ennek eredményeként a modell kiválóan teljesít a tréning adatokon, de gyengén a teszt adatokon, mivel nem képes generalizálni az új, ismeretlen adatokra. Olyan, mintha a modell „bemagolta” volna a tréning példákat, ahelyett, hogy a lényeget ragadta volna meg.

Ezzel szemben az alultanulás azt jelenti, hogy a modell nem elég komplex ahhoz, hogy megragadja a tréning adatokban rejlő alapvető összefüggéseket. Ebben az esetben a modell gyengén teljesít mind a tréning, mind a teszt adatokon. Az alultanulás gyakran egyszerű modellek használatából ered, vagy abból, hogy nem áll rendelkezésre elegendő információ.

A túltanulás és alultanulás közötti egyensúly megtalálása kulcsfontosságú a sikeres felügyelt tanulási modellek létrehozásához. Szerencsére léteznek technikák, amelyek segítenek ezeket a problémákat kezelni.

Az egyik legelterjedtebb módszer a regularizáció. A regularizáció célja, hogy büntesse a túl komplex modelleket, ezzel megakadályozva a túltanulást. Két gyakori regularizációs technika az L1 és L2 regularizáció. Az L1 regularizáció a modell súlyainak abszolút értékét bünteti, míg az L2 regularizáció a súlyok négyzetét. Mindkét módszer arra ösztönzi a modellt, hogy egyszerűbb, generalizálhatóbb megoldásokat találjon.

A regularizáció egy finomhangolási folyamat, melynek során a modell komplexitását optimalizáljuk a jobb általánosítás érdekében.

Egy másik fontos technika a keresztvalidáció. A keresztvalidáció során az adatokat több részre osztjuk: tréning adatokra és validációs adatokra. A modellt a tréning adatokon képezzük, majd a validációs adatokon értékeljük a teljesítményét. Ezt a folyamatot többször megismételjük, különböző adatrészeket használva validációra. A keresztvalidáció segít megbecsülni, hogy a modell mennyire jól fog teljesíteni új, ismeretlen adatokon, és segít elkerülni a túltanulást, mivel a modell teljesítményét nem csak a tréning adatokon, hanem egy független adathalmazon is ellenőrizzük.

A modellek komplexitásának szabályozása is egy fontos tényező. Például, a döntési fáknál a fa mélységének korlátozása, vagy a neurális hálózatoknál a rétegek és neuronok számának csökkentése segíthet megelőzni a túltanulást. Az adatgyűjtés is kulcsfontosságú. Minél több és változatosabb adat áll rendelkezésre, annál jobban képes a modell a valódi mintázatokat megtanulni és generalizálni.

A felügyelt tanulás kihívásai: hiányzó adatok, zajos adatok, kiegyensúlyozatlan adathalmazok

A felügyelt tanulás során a modell tanítása címkézett adatokkal történik, melyek tartalmazzák a bemeneti jellemzőket és a hozzájuk tartozó helyes kimeneteket. Azonban a valós adathalmazok ritkán tökéletesek, és számos kihívást tartogatnak a modell számára. Ezek a kihívások jelentősen befolyásolhatják a modell teljesítményét és általánosíthatóságát.

Az egyik leggyakoribb probléma a hiányzó adatok jelensége. Ez azt jelenti, hogy bizonyos bemeneti jellemzők értékei nem állnak rendelkezésre az összes adatpont esetén. A hiányzó adatok kezelésére több módszer létezik, például a hiányzó értékek átlaggal vagy mediánnal való pótlása, vagy a hiányzó adatokat tartalmazó sorok eltávolítása. A megfelelő módszer kiválasztása az adathalmaz jellegétől és a hiányzó adatok mennyiségétől függ.

Egy másik jelentős kihívást a zajos adatok jelentenek. A zajos adatok hibás vagy pontatlan értékeket tartalmaznak, melyek származhatnak mérési hibákból, adatbeviteli hibákból vagy egyszerűen a valós folyamatok természetes változékonyságából. A zajos adatok torzíthatják a modell tanulását, ezért fontos a zajszűrés alkalmazása. Erre a célra különböző statisztikai módszerek és adatelőkészítési technikák állnak rendelkezésre.

A kiegyensúlyozatlan adathalmazok komoly problémát jelenthetnek a felügyelt tanulás során, különösen a klasszifikációs feladatoknál.

Kiegyensúlyozatlan adathalmazról akkor beszélünk, ha az egyes osztályokba tartozó adatpontok száma jelentősen eltér egymástól. Például, egy orvosi diagnosztikai alkalmazásban a beteg emberek száma valószínűleg sokkal kisebb lesz, mint az egészségeseké. Ebben az esetben a modell hajlamos lehet a többségi osztályt (az egészségeseket) előnyben részesíteni, és a kisebbségi osztályt (a betegeket) rosszul felismerni. A kiegyensúlyozatlan adathalmazok kezelésére különböző technikák léteznek, például a mintavételezés (oversampling vagy undersampling) és a költségérzékeny tanulás.

A felügyelt tanulás során tehát elengedhetetlen a hiányzó, zajos és kiegyensúlyozatlan adatok megfelelő kezelése ahhoz, hogy a modell pontos és megbízható előrejelzéseket tudjon adni.

A felügyelt tanulás etikai vonatkozásai: elfogultság, diszkrimináció és a felelős AI

A felügyelt tanulás során használt adatok minősége kritikus fontosságú. Ha a betanító adatok elfogultak, akkor a modell is elfogult döntéseket fog hozni. Ez különösen problémás lehet olyan területeken, mint a hitelkérelmek elbírálása, a bűnüldözés, vagy a munkaerő-felvétel, ahol a diszkriminatív döntések súlyos következményekkel járhatnak.

Az elfogultság a betanító adatokban többféle forrásból eredhet. Például, ha egy arcfelismerő rendszert túlnyomórészt fehér bőrű emberek képeivel tanítanak be, akkor kevésbé lesz pontos a sötétebb bőrű emberek arcának felismerésében. Hasonlóképpen, ha egy hitelkérelmeket elbíráló modell olyan adatokkal van betanítva, amelyekben bizonyos etnikai csoportok alulreprezentáltak, akkor a modell diszkriminatív döntéseket hozhat ezen csoportok tagjai ellen.

A felelős AI elengedhetetlen a felügyelt tanulási modellek etikus alkalmazásához. Ez magában foglalja az adatok gondos elemzését az elfogultságok feltárása és kiküszöbölése érdekében, valamint a modellek folyamatos monitorozását a diszkriminatív döntések elkerülése érdekében.

A diszkrimináció elkerülése érdekében fontos, hogy a modellek tervezésekor és betanításakor figyelembe vegyük az etikai szempontokat. Ez magában foglalhatja a szenzitív attribútumok (pl. nem, etnikum) eltávolítását a betanító adatokból, vagy a modellek olyan módon történő betanítását, hogy azok kevésbé legyenek érzékenyek ezekre az attribútumokra. Ezenkívül fontos, hogy a modellek működését átláthatóvá tegyük, hogy az emberek megérthessék, miért hozott egy adott döntést a modell.

Az átláthatóság és az elmagyarázhatóság kulcsfontosságú a bizalom kiépítéséhez a felügyelt tanulási modellek iránt. Ha az emberek megértik, hogyan működik egy modell, és miért hoz egy adott döntést, akkor nagyobb valószínűséggel fogadják el a modell által hozott döntéseket.

A felügyelt tanulás jövőbeli trendjei és a legújabb kutatási irányok

A felügyelt tanulás jövője izgalmas területeket ölel fel. Egyik ilyen a few-shot learning, ahol a modellek kevés példa alapján képesek tanulni. Ez különösen hasznos lehet olyan esetekben, ahol a címkézett adatok gyűjtése költséges vagy időigényes. A kutatók azon dolgoznak, hogy a modellek jobban tudjanak általánosítani kis mennyiségű adatból, ezzel csökkentve a nagy adathalmazok szükségességét.

Egy másik fontos irány a magyarázható mesterséges intelligencia (XAI). A felügyelt tanulási modellek, különösen a mélytanulási modellek, gyakran fekete dobozként működnek. Az XAI célja, hogy feltárja, miért hoz egy modell egy adott döntést, ezáltal növelve a bizalmat a modellek iránt, és segítve a hibák feltárását. Ez elengedhetetlen a kritikus alkalmazásokban, mint például az egészségügyben és a pénzügyekben.

A transzfer tanulás is egyre nagyobb hangsúlyt kap, ahol egy feladatra betanított modellt egy másik, kapcsolódó feladatra használják fel. Ez lehetővé teszi a gyorsabb és hatékonyabb tanulást, különösen akkor, ha a célfeladathoz kevés adat áll rendelkezésre. A transzfer tanulás sikeresen alkalmazható például a képfelismerés, a természetes nyelvfeldolgozás és a beszédértés területein.

A szemantikus szegmentáció fejlesztése, különösen a 3D-s környezetekben, szintén kulcsfontosságú. Ez lehetővé teszi a gépek számára, hogy részletesen megértsék a környezetüket, ami elengedhetetlen az autonóm járművek, a robotika és a kiterjesztett valóság alkalmazások szempontjából.

Végül, a generatív modellek, mint például a generatív ellentétes hálózatok (GAN-ok), egyre fontosabb szerepet játszanak a felügyelt tanulásban. Ezek a modellek képesek új, valósághű adatokat generálni, amelyek felhasználhatók a meglévő modellek betanítására, ezáltal javítva azok teljesítményét és robusztusságát.