A dimenziócsökkentés egy elengedhetetlen technika a modern adatelemzésben, különösen a nagyméretű adathalmazok korában. Alapvetően arról van szó, hogy az adatokban szereplő változók (vagyis dimenziók) számát csökkentjük anélkül, hogy jelentős mennyiségű információt veszítenénk. Ez a folyamat számos előnnyel jár, amelyek kulcsfontosságúak lehetnek a sikeres adatelemzéshez.

Az egyik legfontosabb cél a számítási igény csökkentése. Minél több dimenzióval dolgozunk, annál több számításra van szükség az adatok feldolgozásához, modellek létrehozásához és elemzések futtatásához. A dimenziócsökkentés lehetővé teszi, hogy gyorsabban és hatékonyabban dolgozzunk fel nagy adathalmazokat, ami különösen fontos a valós idejű elemzések és alkalmazások esetében.

Egy másik lényeges cél a túlillesztés elkerülése. A túlillesztés akkor fordul elő, amikor egy modell túlságosan jól illeszkedik a betanító adatokhoz, és ezáltal rosszul teljesít az új, ismeretlen adatokon. A dimenziócsökkentés segíthet a zaj és a redundáns információ kiszűrésében, ezáltal javítva a modell általánosíthatóságát.

A dimenziócsökkentés emellett segít az adatok vizualizálásában. Nehéz elképzelni és ábrázolni az adatokat több mint három dimenzióban. A dimenziócsökkentés lehetővé teszi, hogy az adatokat alacsonyabb dimenziókba vetítsük, például két vagy három dimenzióba, ami megkönnyíti a mintázatok és a kapcsolatok azonosítását vizuális eszközökkel.

A dimenziócsökkentés lényege, hogy az adatban rejlő lényegi információt megtartva egyszerűsítsük az adathalmazt, ezzel elősegítve a hatékonyabb és értelmezhetőbb elemzést.

Nem utolsósorban, a dimenziócsökkentés javíthatja a modell értelmezhetőségét. Kevesebb változóval könnyebb megérteni, hogy mely tényezők befolyásolják a legjobban az eredményeket, és hogyan függenek össze egymással a különböző változók.

Vannak különböző módszerek a dimenziócsökkentésre, beleértve a főkomponens-elemzést (PCA), a lineáris diszkrimináns analízist (LDA) és a nemlineáris módszereket. A megfelelő módszer kiválasztása az adatok jellegétől és az elemzés céljától függ.

A dimenzió átka: Miért jelent problémát a magas dimenziószám?

A dimenzió átka egy olyan jelenség az adatelemzésben, ami jelentős problémákat okoz, amikor nagy dimenziószámú adathalmazokkal dolgozunk. Magas dimenzió alatt azt értjük, hogy az adathalmazunkban rengeteg attribútum (oszlop, változó) található.

Az egyik fő probléma, hogy ahogy a dimenziók száma nő, az adatok térfogata exponenciálisan növekszik. Emiatt az adatok egyre „ritkábbá” válnak a térben. Képzeljük el, hogy egy 2D-s térben elhelyezünk 10 pontot. Könnyen találunk olyan pontokat, amik közel vannak egymáshoz. Most képzeljük el ugyanezt egy 1000 dimenziós térben. Ugyanaz a 10 pont valószínűleg nagyon messze lesz egymástól, mert a tér nagysága sokkal nagyobb.

Ez a ritkaság számos problémát okoz:

- Túlillesztés: A modellek könnyebben „megtanulják” a zajt az adatokban, ami gyenge általánosításhoz vezet új adatokon.

- Számítási komplexitás: Az algoritmusok futási ideje és memóriahasználata exponenciálisan nőhet a dimenziók számával.

- Távolságfüggő algoritmusok gyengülése: A távolság fogalma elveszíti a jelentőségét, mivel szinte minden pont egyformán távol van a többitől. Ez rontja a klaszterező és a szomszédság alapú algoritmusok teljesítményét.

A dimenzió átka azt jelenti, hogy több adatra van szükségünk a megbízható modellekhez. Ahogy a dimenziók száma növekszik, a szükséges adatmennyiség is exponenciálisan nő. Ez gyakran nem megvalósítható a gyakorlatban, mert korlátozott mennyiségű adat áll rendelkezésünkre.

A magas dimenziószámú adathalmazok elemzése során a zaj, a redundancia és a irreleváns információk felerősödnek, ami megnehezíti a valódi mintázatok és összefüggések feltárását.

Röviden, a dimenzió átka lelassítja az algoritmusokat, rontja a pontosságot és növeli az erőforrásigényt. Ezért van szükség dimenziócsökkentési technikákra, amik segítenek kezelni ezt a problémát.

A dimenziócsökkentés alapelvei és módszertanai

A dimenziócsökkentés egy olyan technika az adatelemzésben, amelynek célja a változók számának csökkentése egy adathalmazban. Ez különösen hasznos, amikor nagyméretű, komplex adathalmazokkal dolgozunk, ahol a túl sok változó (dimenzió) megnehezítheti a mintázatok felismerését és a modellek hatékony felépítését.

A dimenziócsökkentés lényege, hogy az eredeti adathalmazban található információ jelentős részét megőrizve, kevesebb változóval reprezentáljuk az adatokat. Ezáltal csökken a számítási igény, javul a modellek teljesítménye, és könnyebben értelmezhetővé válnak az eredmények.

A dimenziócsökkentés egyik legfontosabb célja, hogy az adatokban rejlő lényegi információt megőrizze, miközben a zajt és a redundanciát eltávolítja.

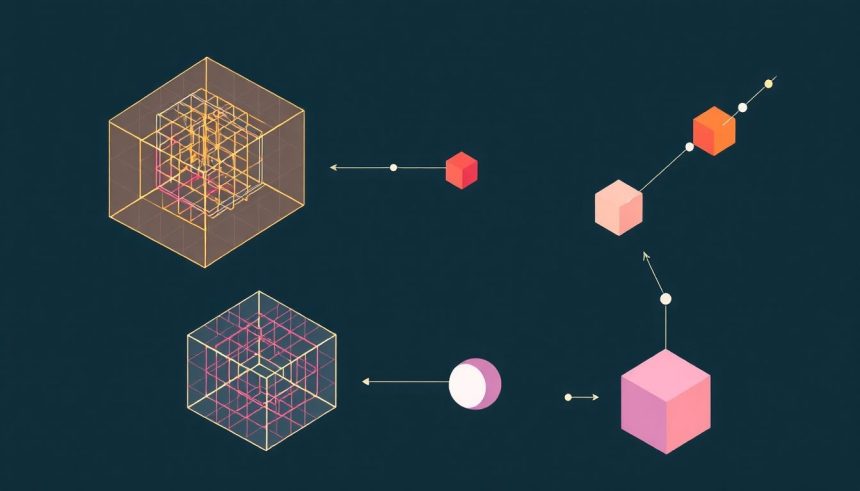

Két fő típusa létezik: a feature selection (változó kiválasztás) és a feature extraction (változó kinyerés). A feature selection során a legrelevánsabb változókat választjuk ki az eredeti adathalmazból, míg a feature extraction során új, kevesebb változót hozunk létre az eredeti változók kombinálásával.

Néhány népszerű módszer a dimenziócsökkentésre:

- PCA (Principal Component Analysis): Főkomponens elemzés, amely lineáris transzformációval keresi az adatokban a legnagyobb varianciát leíró komponenseket.

- LDA (Linear Discriminant Analysis): Lineáris diszkriminancia analízis, amely a különböző osztályok közötti szeparálhatóságot maximalizálja.

- T-SNE (t-distributed Stochastic Neighbor Embedding): Nem-lineáris módszer, amely a magas dimenziós adatok pontjainak közti távolságokat igyekszik megőrizni alacsony dimenziós térben.

A dimenziócsökkentés alkalmazása során figyelembe kell venni az adatok jellegét és a célkitűzéseket. A megfelelő módszer kiválasztása kulcsfontosságú a sikeres adatelemzéshez.

Lineáris dimenziócsökkentési technikák: PCA (Principal Component Analysis) részletesen

A Főkomponens-elemzés (Principal Component Analysis, PCA) egy széles körben alkalmazott lineáris dimenziócsökkentési technika, melynek célja, hogy nagy dimenziójú adathalmazokat kisebb dimenziójú reprezentációvá alakítson át, miközben a lehető legnagyobb mértékben megőrzi az adatok varianciáját. A PCA alapvetően az adatpontok közötti kapcsolatokat vizsgálja, és olyan új, ortogonális tengelyeket (főkomponenseket) talál, amelyek mentén az adatok varianciája maximalizálódik.

A PCA működésének alapelve a következő:

- Adatok standardizálása: Az első lépés az adatok standardizálása, azaz minden változót úgy transzformálunk, hogy az átlaga 0, a szórása pedig 1 legyen. Ez azért fontos, mert a PCA érzékeny a változók skálájára. Ha például az egyik változó mértékegysége méter, a másiké pedig centiméter, a PCA eredményét jelentősen befolyásolhatja a skála különbsége.

- Kovarianciamátrix vagy korrelációs mátrix számítása: A standardizált adatokból kiszámítjuk a kovarianciamátrixot vagy a korrelációs mátrixot. A kovarianciamátrix az egyes változók közötti kapcsolatok erősségét és irányát mutatja meg. A korrelációs mátrix a kovarianciamátrix egy standardizált változata, amely a változók közötti lineáris kapcsolatok erősségét mutatja -1 és 1 közötti értékekkel.

- Sajátértékek és sajátvektorok számítása: A kovarianciamátrixból vagy a korrelációs mátrixból kiszámítjuk a sajátértékeket és a sajátvektorokat. A sajátvektorok a főkomponensek irányát mutatják, a sajátértékek pedig azt, hogy az adott főkomponens mentén mekkora a variancia. Minél nagyobb egy sajátérték, annál fontosabb a hozzá tartozó főkomponens.

- Főkomponensek kiválasztása: A sajátértékek alapján sorba rendezzük a főkomponenseket, és kiválasztjuk az első néhányat, amelyek a legtöbb varianciát megmagyarázzák. A kiválasztott főkomponensek száma határozza meg a dimenziócsökkentett adathalmaz dimenzióját. Például, ha egy 10 dimenziós adathalmazból 2 főkomponenst választunk ki, akkor a dimenziócsökkentett adathalmaz 2 dimenziós lesz.

- Adatok transzformálása: Az eredeti adatokat a kiválasztott főkomponensek mentén transzformáljuk. Ez azt jelenti, hogy minden adatpontot levetítünk a kiválasztott főkomponensekre. A transzformált adatok a dimenziócsökkentett adathalmazt alkotják.

A PCA számos előnnyel rendelkezik:

- Dimenziócsökkentés: Csökkenti az adathalmaz dimenzióját, ami egyszerűsíti az adatfeldolgozást és csökkenti a számítási igényt.

- Adatvizualizáció: A dimenziócsökkentett adatok könnyebben vizualizálhatók, ami segíthet az adatokban rejlő mintázatok felfedezésében.

- Zajszűrés: A PCA segíthet a zaj kiszűrésében, mivel a zaj általában a kevésbé fontos főkomponensekben koncentrálódik.

- Feature extraction: A PCA új, értelmes jellemzőket generálhat az eredeti adatokból.

Azonban a PCA-nak vannak korlátai is:

- Lineáris módszer: A PCA csak lineáris kapcsolatokat tud megragadni az adatokban. Ha az adatok között nemlineáris kapcsolatok vannak, a PCA nem lesz hatékony.

- Érzékenység a kiugró értékekre: A PCA érzékeny a kiugró értékekre, mivel ezek jelentősen befolyásolhatják a kovarianciamátrixot vagy a korrelációs mátrixot.

- Nehéz interpretáció: A főkomponensek interpretálása néha nehéz lehet, különösen, ha az eredeti változók nem egyértelműen értelmezhetők.

A PCA-t széles körben alkalmazzák különböző területeken, például:

- Képfeldolgozás: Képek tömörítésére és zajszűrésére.

- Genomika: Génexpressziós adatok elemzésére.

- Pénzügy: Portfólió optimalizálására és kockázatkezelésre.

- Marketing: Ügyfélszegmentálásra és termékajánlásra.

A PCA egy hatékony eszköz a dimenziócsökkentésre és az adatfeltárásra, de fontos tisztában lenni a korlátaival és megfelelően alkalmazni a konkrét problémához.

A megfelelő számú főkomponens kiválasztása kritikus lépés. Több módszer is létezik ennek meghatározására. Az egyik legelterjedtebb a szórásmagyarázat (explained variance) vizsgálata. Ez azt mutatja meg, hogy az egyes főkomponensek a teljes varianciának mekkora hányadát magyarázzák. Általában addig tartjuk meg a főkomponenseket, amíg a szórásmagyarázat el nem éri egy bizonyos küszöbértéket (pl. 90%).

Egy másik módszer a scree plot használata. Ez a sajátértékeket ábrázolja a főkomponensek sorszáma függvényében. A görbe általában egy meredek eséssel kezdődik, majd egy laposabb szakasz következik. A „könyök” pontja, ahol a görbe hirtelen ellaposodik, jelzi a megtartandó főkomponensek számát.

A PCA célja nem az adatok teljes eltávolítása, hanem a lényeges információk megőrzése egy tömörebb formában.

A PCA implementálása különböző szoftvercsomagokban és programozási nyelveken elérhető, mint például a Python (scikit-learn), R, MATLAB. Ezek a csomagok egyszerűvé teszik a PCA alkalmazását és a kapott eredmények elemzését.

Lineáris dimenziócsökkentési technikák: LDA (Linear Discriminant Analysis) részletesen

A Lineáris Diszkriminancia Analízis (LDA) egy felügyelt dimenziócsökkentési technika, ami azt jelenti, hogy a modell a bemeneti adatok mellett a célváltozó (osztálycímkék) információit is felhasználja a dimenziók csökkentésére. Ezzel szemben a felügyelet nélküli módszerek, mint például a PCA (Principal Component Analysis), csak a bemeneti adatok varianciájára támaszkodnak.

Az LDA elsődleges célja, hogy olyan lineáris kombinációkat találjon a bemeneti változókból (jellemzőkből), amelyek maximalizálják az osztályok közötti szóródást (between-class scatter) és minimalizálják az osztályokon belüli szóródást (within-class scatter). Más szóval, az LDA arra törekszik, hogy az adatpontokat úgy vetítse le egy alacsonyabb dimenziós térbe, hogy az azonos osztályba tartozó pontok minél közelebb legyenek egymáshoz, míg a különböző osztályokba tartozó pontok minél távolabb legyenek egymástól. Ezáltal az osztályozás sokkal egyszerűbbé és hatékonyabbá válik.

Az LDA működése a következő lépésekre bontható:

- Osztályok közötti szóródási mátrix (Between-class scatter matrix) számítása (SB): Ez a mátrix az egyes osztályok átlagpontjainak szóródását méri a teljes adathalmaz átlagpontjához viszonyítva. Minél nagyobb ez a szóródás, annál jobban elkülönülnek az osztályok egymástól.

- Osztályokon belüli szóródási mátrix (Within-class scatter matrix) számítása (SW): Ez a mátrix az egyes osztályokon belüli szóródást méri. Minél kisebb ez a szóródás, annál kompaktabbak az osztályok.

- SW-1SB sajátértékeinek és sajátvektorainak számítása: Az LDA célja, hogy megtalálja azokat a sajátvektorokat, amelyek maximalizálják az SB/SW arányt. Ezek a sajátvektorok reprezentálják azokat az irányokat, amelyek mentén az osztályok a legjobban elkülönülnek.

- A sajátvektorok kiválasztása: A sajátértékek nagysága mutatja, hogy az adott sajátvektor mennyire fontos az osztályok elkülönítésében. Általában a legnagyobb sajátértékekhez tartozó sajátvektorokat választjuk ki, és ezeket használjuk a dimenziócsökkentéshez.

- Az adatok vetítése az új dimenziókba: Az eredeti adatpontokat megszorozzuk a kiválasztott sajátvektorokkal, így kapjuk meg az új, alacsonyabb dimenziós reprezentációt.

Az LDA különösen hatékony olyan esetekben, amikor az osztályok jól elkülönülnek egymástól, és a jellemzők Gauss-eloszlásúak.

Az LDA előnyei közé tartozik:

- Egyszerűség és gyorsaság: Az LDA egy viszonylag egyszerű algoritmus, ami gyorsan végrehajtható.

- Hatékony dimenziócsökkentés: Az LDA képes hatékonyan csökkenteni a dimenziók számát, miközben megőrzi az osztályok közötti fontos információkat.

- Jól alkalmazható osztályozási problémákra: Az LDA kifejezetten osztályozási feladatokra lett kifejlesztve, és gyakran jobb eredményeket ér el, mint a felügyelet nélküli dimenziócsökkentési módszerek.

Az LDA hátrányai közé tartozik:

- Feltételezések: Az LDA feltételezi, hogy a jellemzők Gauss-eloszlásúak, és az osztályok azonos kovariancia mátrixszal rendelkeznek. Ha ezek a feltételezések nem teljesülnek, az LDA teljesítménye romolhat.

- Szingularitás: Ha az osztályokon belüli szóródási mátrix (SW) szinguláris (nem invertálható), az LDA nem alkalmazható közvetlenül. Ebben az esetben regularizációs technikákat kell alkalmazni.

- Nem lineáris adatok: Az LDA egy lineáris módszer, ezért nem hatékony nem lineáris adatok esetén. Ilyenkor más, nem lineáris dimenziócsökkentési módszereket kell alkalmazni.

Az LDA-t széles körben alkalmazzák különböző területeken, például:

- Arcfelismerés: Az LDA-t használják arcok azonosítására és osztályozására.

- Orvosi diagnosztika: Az LDA-t használják betegségek diagnosztizálására orvosi adatok alapján.

- Szövegbányászat: Az LDA-t használják dokumentumok osztályozására és témák azonosítására.

- Marketing: Az LDA-t használják ügyfelek szegmentálására és a marketingkampányok hatékonyságának növelésére.

Az LDA tehát egy értékes eszköz az adatelemzők számára, különösen akkor, ha felügyelt dimenziócsökkentésre van szükség osztályozási feladatokhoz. A módszer egyszerűsége és hatékonysága miatt gyakran az első választás a dimenziócsökkentési technikák között.

Nemlineáris dimenziócsökkentési technikák: t-SNE (t-distributed Stochastic Neighbor Embedding) részletesen

A t-SNE (t-distributed Stochastic Neighbor Embedding) egy nemlineáris dimenziócsökkentő technika, amelyet elsősorban nagydimenziós adatok vizualizációjára használnak. A célja, hogy a magas dimenziós adatokban lévő pontok közötti hasonlóságokat megőrizze egy alacsonyabb dimenziós térben, tipikusan 2D-ben vagy 3D-ben, lehetővé téve az adatok vizuális feltárását és a klaszterek azonosítását.

A t-SNE alapelve a valószínűségi modellezésen alapul. Először a magas dimenziós térben minden pontpárra kiszámolja a hasonlóságot. Ezt úgy teszi, hogy minden pontot egy Gauss-eloszlás középpontjának tekint, és a többi pont valószínűségét a Gauss-eloszlás alatt számolja ki. Az a pont, amely közelebb van a középponthoz, nagyobb valószínűséggel lesz „szomszéd”. A valószínűségeket úgy normalizálják, hogy minden pontra a valószínűségek összege 1 legyen.

Ezután a t-SNE az alacsony dimenziós térben is létrehoz egy hasonló valószínűségi eloszlást, de itt a t-eloszlást használja a Gauss-eloszlás helyett. A t-eloszlás „nehezebb farkokkal” rendelkezik, ami azt jelenti, hogy jobban tolerálja a pontok közötti nagyobb távolságokat az alacsony dimenziós térben. Ez segít elkerülni a „zsúfoltsági problémát”, ahol a pontok túl közel kerülnek egymáshoz az alacsony dimenziós térben, ami torzíthatja a struktúrát.

A t-SNE célja, hogy a magas és alacsony dimenziós térben lévő valószínűségi eloszlások közötti különbséget minimalizálja. Ezt egy gradiens ereszkedési algoritmussal éri el, amely iteratívan módosítja a pontok pozícióját az alacsony dimenziós térben, amíg a különbség (általában Kullback-Leibler divergencia) minimális nem lesz.

A t-SNE működésének kulcselemei:

- Példányonkénti variancia: A Gauss-eloszlások szórását (varianciáját) pontonként állítja be. Ez lehetővé teszi, hogy a t-SNE jobban alkalmazkodjon a különböző sűrűségű területekhez az adatokban.

- T-eloszlás: A t-eloszlás használata az alacsony dimenziós térben segít a zsúfoltsági probléma leküzdésében, és lehetővé teszi, hogy a távoli pontok is jól reprezentálva legyenek.

- Optimalizálás: A gradiens ereszkedési algoritmus iteratívan finomítja a pontok pozícióját, amíg a valószínűségi eloszlások közötti különbség minimális nem lesz.

A t-SNE különösen hatékony a helyi struktúra megőrzésében, ami azt jelenti, hogy a magas dimenziós térben közel lévő pontok az alacsony dimenziós térben is közel maradnak egymáshoz.

A t-SNE használatakor figyelembe kell venni néhány dolgot:

- Perplexitás: A perplexitás egy paraméter, amely befolyásolja a szomszédság definícióját. Általában 5 és 50 közötti értéket szoktak használni. A túl alacsony érték zajos eredményeket, míg a túl magas érték elmosódott eredményeket eredményezhet.

- Inicializálás: A t-SNE eredményei függhetnek az inicializálástól. Többször érdemes futtatni különböző inicializálásokkal, hogy megbizonyosodjunk arról, hogy az eredmények stabilak.

- Globális struktúra: A t-SNE elsősorban a helyi struktúrát őrzi meg, a globális struktúra kevésbé megbízható. A távoli klaszterek közötti távolságok nem feltétlenül tükrözik a valós távolságokat a magas dimenziós térben.

- Számítási igény: A t-SNE számításigényes algoritmus, különösen nagy adathalmazok esetén.

Összességében a t-SNE egy hatékony eszköz az adatok vizualizációjához és feltárásához, különösen akkor, ha a cél a klaszterek azonosítása és a helyi struktúra megértése. Azonban fontos tisztában lenni a korlátaival és a paraméterek hatásával, hogy megbízható és értelmezhető eredményeket kapjunk.

Nemlineáris dimenziócsökkentési technikák: UMAP (Uniform Manifold Approximation and Projection) részletesen

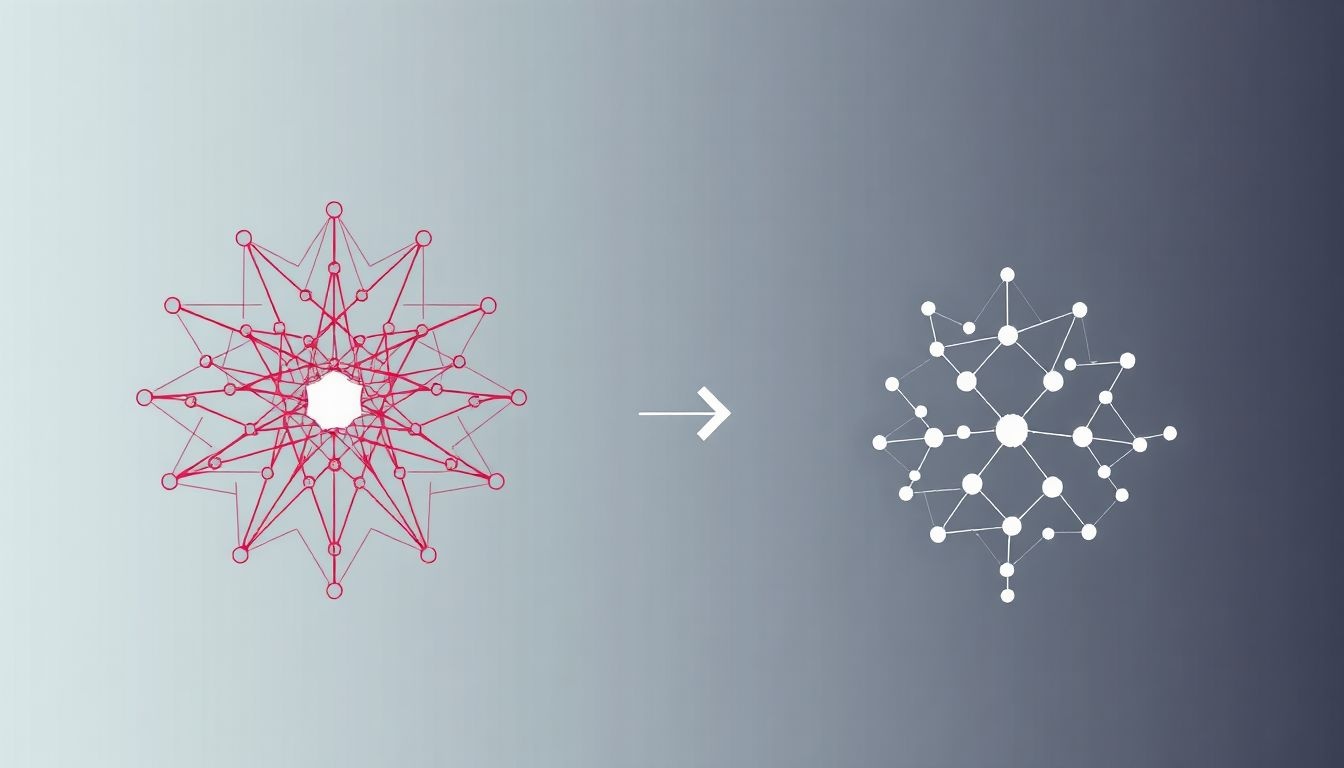

Az UMAP (Uniform Manifold Approximation and Projection) egy nemlineáris dimenziócsökkentési technika, melynek célja a magas dimenziójú adatok alacsonyabb dimenzióba történő leképezése úgy, hogy közben a globális struktúrát is megőrizze. Ez különbözteti meg a lokális struktúrára fókuszáló módszerektől, mint például a t-SNE.

Az UMAP két fő lépésből áll:

- Gráfépítés: Az első lépésben az UMAP létrehoz egy gráfot, melyben az adatok pontjai a csomópontok, és az élek súlyozása az adatok közötti hasonlóságot tükrözi. A hasonlóságot a k-legközelebbi szomszédok alapján számítják ki, figyelembe véve egy felhasználó által definiált

n_neighborsparamétert. Minél nagyobb ez az érték, annál globálisabb lesz a nézet. - Alacsony dimenziós beágyazás optimalizálása: A második lépésben az UMAP megpróbálja az eredeti gráfot egy alacsony dimenziós térbe leképezni, minimalizálva a két gráf közötti különbséget. Ehhez egy speciális költségfüggvényt használ, mely bünteti a közeli pontok eltávolodását és a távoli pontok közeledését is.

Az UMAP egyik kulcsfontosságú jellemzője, hogy a topológiai adatanalízis (TDA) elveit használja. A TDA célja az adatok alakjának és struktúrájának feltárása topológiai módszerekkel. Az UMAP a TDA-ból kölcsönözött eszközökkel próbálja megragadni az adatok mögötti sokaságot (manifold) és annak topológiai tulajdonságait.

Az UMAP célja, hogy olyan alacsony dimenziós reprezentációt hozzon létre, amely a lehető legjobban tükrözi az eredeti adatok globális és lokális struktúráját, miközben minimalizálja a torzítást.

Az UMAP paraméterezése lehetővé teszi a felhasználó számára, hogy befolyásolja a végső eredményt. A min_dist paraméter például azt szabályozza, hogy mennyire közel kerülhetnek egymáshoz a pontok az alacsony dimenziós térben. Nagyobb min_dist értékek tömörebb klasztereket eredményezhetnek.

Az UMAP előnyei közé tartozik a gyors számítási sebesség (különösen a t-SNE-hez képest) és a jó skálázhatóság nagy adathalmazok esetén. Emellett az UMAP képes a globális struktúra megőrzésére, ami lehetővé teszi a klaszterek és azok egymáshoz való viszonyának pontosabb feltárását.

Az UMAP alkalmazási területei rendkívül széleskörűek, beleértve a genomikát, a képfeldolgozást, a természetes nyelvi feldolgozást és a pénzügyi elemzést. Mindenhol használható, ahol nagy dimenziójú adatok elemzésére és vizualizációjára van szükség.

Egy fontos szempont az UMAP használatakor, hogy az eredmények nem mindig egyértelműek és interpretálhatók. Az alacsony dimenziós térben megjelenő minták nem feltétlenül tükrözik pontosan az eredeti adatokban rejlő kapcsolatokat. Ezért az UMAP eredményeit mindig óvatosan kell értelmezni, és más elemzési módszerekkel együtt kell használni.

Az UMAP egy hatékony eszköz a nemlineáris dimenziócsökkentésre, amely lehetővé teszi a nagy dimenziójú adatok feltárását és vizualizációját. Azonban fontos megérteni a technika működését és korlátait ahhoz, hogy a lehető legjobb eredményeket érjük el.

Autoencoderek a dimenziócsökkentésben: Mélytanulási megközelítés

Az autoencoderek a mélytanulás egyik izgalmas alkalmazása a dimenziócsökkentés területén. Eltérően a klasszikus módszerektől, mint a PCA (Principal Component Analysis), az autoencoderek nem lineáris transzformációkat is képesek megtanulni, így komplexebb adatok esetén is hatékonyak lehetnek. Az autoencoder egy neurális hálózat, amelynek célja, hogy megtanulja azonos módon rekonstruálni a bemenetét a kimenetén. Ez elsőre feleslegesnek tűnhet, de a trükk abban rejlik, hogy a hálózat közepén egy szűk keresztmetszetet (bottleneck) hozunk létre.

Ez a szűk keresztmetszet kényszeríti a hálózatot, hogy a bemeneti adatok legfontosabb jellemzőit egy alacsonyabb dimenziós térben reprezentálja. Az autoencoder két fő részből áll: az encoder-ből és a decoder-ből. Az encoder feladata a bemeneti adatok tömörítése a szűk keresztmetszetbe, míg a decoder feladata a tömörített reprezentációból az eredeti adatok rekonstruálása. A hálózat tanítása során a cél a rekonstrukciós hiba minimalizálása, ami arra ösztönzi a hálózatot, hogy a bemeneti adatok legfontosabb jellemzőit tartsa meg a tömörített formában.

Az autoencoderek lényege, hogy az adatok tömörített reprezentációját tanulják meg oly módon, hogy képesek legyenek az eredeti adatok rekonstruálására.

Számos variációja létezik az autoencodereknek, amelyek különböző célokra optimalizáltak. Néhány példa:

- Undercomplete autoencoderek: Ezeknél a szűk keresztmetszet dimenziója kisebb, mint a bemeneti adatok dimenziója. Ez kényszeríti a hálózatot, hogy a legrelevánsabb jellemzőket tartsa meg.

- Sparse autoencoderek: Ezek a hálózatok a rejtett rétegekben lévő neuronok aktivitását szabályozzák, hogy csak néhány neuron legyen aktív egyszerre. Ez segít a hálózatnak, hogy robusztusabb reprezentációkat tanuljon.

- Denoising autoencoderek: Ezek a hálózatok zajos bemeneti adatokkal vannak betanítva, és a céljuk a zaj eltávolítása és az eredeti adatok rekonstruálása. Ez segít a hálózatnak, hogy robusztusabbá váljon a zajjal szemben.

- Variational autoencoderek (VAE): A VAE-k valószínűségi megközelítést alkalmaznak, és a tömörített reprezentációt egy valószínűségi eloszlásként írják le. Ez lehetővé teszi új adatok generálását a tanult eloszlásból.

Az autoencoderek széles körben alkalmazhatók a dimenziócsökkentés mellett. Például használhatók képfeldolgozásban képek zajszűrésére, anomália detektálására, vagy akár új képek generálására. Az autoencoderek a természetes nyelvi feldolgozásban is hasznosak lehetnek, például szövegek tömörítésére, vagy mondatok generálására. Az autoencoderek nem lineáris jellege különösen előnyös lehet olyan adatok esetén, ahol a lineáris módszerek, mint a PCA, nem képesek hatékonyan csökkenteni a dimenziót.

Azonban az autoencoderek használata kihívásokat is rejt. A hálózat architektúrájának és a hiperparamétereknek a megfelelő megválasztása kulcsfontosságú a jó eredmények eléréséhez. A túl komplex hálózatok túltanulhatják a tréning adatokat, míg a túl egyszerű hálózatok nem képesek hatékonyan tömöríteni az adatokat. Ezenkívül a hálózat tanítása időigényes lehet, különösen nagy adathalmazok esetén. Az autoencoderek, mint a mélytanulás eszközei, a dimenziócsökkentés hatékony és rugalmas megközelítését kínálják, de a sikeres alkalmazásuk gondos tervezést és kísérletezést igényel.

Feature selection vs. Feature extraction: A két megközelítés összehasonlítása

A dimenziócsökkentés két fő megközelítése a feature selection (jellemzők kiválasztása) és a feature extraction (jellemzők kinyerése). Mindkettő célja az adathalmazban szereplő változók számának csökkentése, de eltérő módon valósítják ezt meg.

A feature selection során a meglévő jellemzők közül választjuk ki azokat, amelyek a legrelevánsabbak a modell szempontjából. Ez azt jelenti, hogy a eredeti jellemzők egy részét megtartjuk, a többit pedig elhagyjuk. Például, ha egy szöveges adathalmazban a leggyakoribb szavak nem hordoznak lényeges információt, ezeket eltávolíthatjuk. A feature selection előnye, hogy értelmezhető marad az adathalmaz, hiszen a kiválasztott jellemzők eredeti jelentésüket megőrzik.

Ezzel szemben a feature extraction új, mesterséges jellemzőket hoz létre az eredeti jellemzők kombinációjával. Ezek az új jellemzők az eredeti információ egy tömörített, átalakított formáját reprezentálják. Például a főkomponens-elemzés (PCA) egy feature extraction technika, amely lineáris kombinációkat hoz létre az eredeti jellemzőkből, hogy megtalálja a variancia legnagyobb részét leíró főkomponenseket. A feature extraction során az eredeti jellemzők elveszítik egyedi jelentésüket, mivel az újonnan létrehozott jellemzők az eredeti jellemzők valamilyen kombinációi.

A feature selection a jellemzők egy részének megtartásával, a feature extraction pedig a jellemzők kombinálásával csökkenti a dimenziót.

A választás a két megközelítés között az adatok jellegétől és a probléma céljától függ. Ha fontos, hogy az adatok értelmezhetőek maradjanak, a feature selection a jobb választás. Ha a cél a modell teljesítményének maximalizálása, és az értelmezhetőség kevésbé fontos, a feature extraction lehet a megfelelő.

A dimenziócsökkentés alkalmazási területei: Képfeldolgozás

A dimenziócsökkentés a képfeldolgozásban kritikus szerepet játszik, különösen a nagy felbontású képek és videók kezelésekor. Egy kép minden egyes pixelét egy jellemzőnek tekinthetjük, így egy 1000×1000 pixeles kép 1 millió dimenziós adathalmazt jelent. Ez a hatalmas dimenziószám jelentős számítási igényt és tárolási kapacitást eredményezhet.

A dimenziócsökkentési technikák segítségével csökkenthető a kép reprezentációjához szükséges adatok mennyisége anélkül, hogy jelentősen rontana a kép minőségén vagy a belőle kinyerhető információkon. Ez különösen fontos a gépi tanulási algoritmusok hatékony betanítása szempontjából, mivel a kevesebb dimenzióval rendelkező adatokkal gyorsabban és hatékonyabban lehet dolgozni.

Egyik gyakori módszer a főkomponens-elemzés (PCA), amely az adatban található variancia nagy részét megtartó alacsonyabb dimenziós reprezentációt keres. A PCA megtalálja azokat a „főkomponenseket”, amelyek a leginkább meghatározóak a kép szóródásában, és a többi komponenst elhagyja. Ezáltal a kép lényegesen kevesebb adattal leírható.

A dimenziócsökkentés alkalmazása a képfeldolgozásban nem csupán a tárolási és számítási igények csökkentését szolgálja, hanem a zajszűrést és a jellemzők kiválasztását is elősegítheti.

Egy másik népszerű technika az autoenkóderek használata. Az autoenkóderek olyan neurális hálók, amelyek célja, hogy a bemeneti adatot alacsonyabb dimenziós kódolásra képezzék le, majd ezt a kódolást visszaalakítsák az eredeti bemenethez minél hasonlóbb formába. Az alacsonyabb dimenziós kódolás a kép tömörített reprezentációját adja, amely a képfeldolgozási feladatokhoz használható.

A dimenziócsökkentés alkalmazása különösen előnyös lehet a következő területeken:

- Arcfelismerés: Az arcok képeinek dimenziócsökkentése lehetővé teszi a gyorsabb és hatékonyabb azonosítást.

- Képkeresés: A képek tömörített reprezentációi alapján gyorsabban lehet hasonló képeket keresni nagy adatbázisokban.

- Orvosi képalkotás: A CT és MRI felvételek elemzése során a dimenziócsökkentés segíthet a releváns információk kiemelésében és a diagnózis felállításában.

A dimenziócsökkentés alkalmazási területei: Természetes nyelvi feldolgozás (NLP)

A dimenziócsökkentés a természetes nyelvi feldolgozásban (NLP) kulcsfontosságú szerepet játszik a nagyméretű szöveges adathalmazok kezelésében. Az NLP feladatok, mint például a szöveg kategorizálás, a témamodellezés vagy a gépi fordítás, gyakran hatalmas, sokdimenziós adatokkal dolgoznak. Ezek az adatok származhatnak például a szavak gyakoriságának méréséből egy dokumentumban (bag-of-words modell), vagy a szavak beágyazásából (word embeddings).

A probléma az, hogy a magas dimenziószám növelheti a számítási igényt és a tárhely szükségletet, valamint ronthatja a modellek teljesítményét a „dimenziók átka” miatt. Ez a jelenség azt jelenti, hogy ahogy a dimenziók száma nő, az adatok egyre ritkábbá válnak a térben, ami megnehezíti a modellek számára a minták megtanulását és az általánosítást új adatokra.

A dimenziócsökkentés célja az NLP-ben, hogy csökkentse az adatok dimenziószámát úgy, hogy a lényeges információt megőrizze. Ez lehetővé teszi hatékonyabb modellek építését és gyorsabb feldolgozást.

A dimenziócsökkentés nem csak a számítási hatékonyságot javítja, hanem a modellek értelmezhetőségét is növelheti.

Számos technika létezik a dimenziócsökkentésre az NLP-ben. Néhány példa:

- Főkomponens-elemzés (PCA): Egy lineáris módszer, amely az adatok varianciájának maximalizálására törekszik azáltal, hogy új, ortogonális komponenseket hoz létre.

- Szinguálisérték-felbontás (SVD): Egy mátrixfaktorizációs technika, amelyet gyakran használnak a szövegek szemantikai elemzésére és a témák feltárására.

- Lineáris diszkrimináns analízis (LDA): Egy felügyelt tanulási módszer, amely a különböző osztályok közötti szeparálhatóság maximalizálására törekszik.

- Nemnegatív mátrixfaktorizáció (NMF): Egy olyan technika, amely nemnegatív mátrixok szorzatára bontja az adatokat, ami különösen hasznos lehet a témamodellezésben.

- Autoencoderek: Neurális hálózati architektúrák, amelyek célja az adatok tömörített reprezentációjának megtanulása.

Például, a word embeddings, mint a Word2Vec vagy a GloVe, eleve egyfajta dimenziócsökkentési eljárásnak tekinthetők, mivel a szavakat egy alacsonyabb dimenziós térbe képezik le, ahol a szemantikailag hasonló szavak közel helyezkednek el egymáshoz. Ezek a beágyazások aztán felhasználhatók különféle NLP feladatokban.

A megfelelő dimenziócsökkentési technika kiválasztása az adott feladattól és az adatok jellegétől függ. A teljesítmény értékelése elengedhetetlen annak biztosításához, hogy a dimenziócsökkentés ne rontsa a modell pontosságát.

A dimenziócsökkentés alkalmazási területei: Genomikai adatok elemzése

A genomikai adatok elemzése kiemelkedő terület a dimenziócsökkentési technikák alkalmazásában. A genomikai adatok, mint például a génexpressziós adatok vagy a SNP (Single Nucleotide Polymorphism) adatok, gyakran rendkívül magas dimenziójúak. Ez azt jelenti, hogy nagyszámú változót (gént, SNP-t) mérnek egy viszonylag kis számú mintán (pl. beteg, kontroll). A magas dimenzió komoly kihívásokat jelent az adatok elemzése során, növeli a számítási igényt, rontja a modellek általánosíthatóságát, és megnehezíti az értelmezést.

A dimenziócsökkentés célja a genomikai adatokban rejlő lényeges információk megőrzése mellett a dimenziók számának csökkentése. Ez lehetővé teszi a biomarkerek azonosítását, amelyek segíthetnek a betegségek diagnosztizálásában, prognosztizálásában vagy a kezelések hatékonyságának előrejelzésében.

A dimenziócsökkentés a genomikai kutatásban kulcsszerepet játszik a komplex adathalmazok egyszerűsítésében és az értelmezhető mintázatok feltárásában.

Számos módszer létezik a genomikai adatok dimenziócsökkentésére, beleértve a főkomponens-elemzést (PCA), a nem-negatív mátrixfaktorizációt (NMF) és a t-eloszlású sztochasztikus szomszédbedési (t-SNE) módszert. A PCA például lineáris transzformációval keresi meg az adatokban a legnagyobb varianciát mutató irányokat (főkomponenseket), míg a t-SNE a magas dimenziós adatokat alacsony dimenziós térbe képezi le, megőrizve a pontok közötti távolságokat.

Ezek a technikák segítenek a kutatóknak abban, hogy vizualizálják a komplex genomikai adatokat, csoportosítsák a hasonló génexpressziós profilú mintákat, és azonosítsák a betegségekkel összefüggő géneket vagy genetikai variációkat. A dimenziócsökkentés tehát elengedhetetlen eszköz a modern genomikai kutatásban, lehetővé téve a nagy adathalmazokból származó értékes információk kinyerését.

A dimenziócsökkentés alkalmazásának kihívásai és korlátai

Bár a dimenziócsökkentés számos előnnyel jár, alkalmazása nem mindig egyszerű és problémamentes. Komoly kihívást jelenthet a megfelelő módszer kiválasztása, hiszen a különböző algoritmusok más és más adatokra optimalizáltak. A sikeres dimenziócsökkentés kulcsa az adatok alapos megismerése és a módszer céljának pontos meghatározása.

Egyik fő korlátja, hogy az információvesztés elkerülhetetlen. Bár a cél a lényeges információk megtartása, a dimenziók csökkentésével bizonyos részletek elveszhetnek, ami befolyásolhatja a későbbi elemzések pontosságát.

A dimenziócsökkentés alkalmazásakor figyelembe kell venni az interpretálhatóság kérdését. A transzformált adatok gyakran nehezen értelmezhetők az eredeti változókhoz képest, ami megnehezíti az eredmények gyakorlati alkalmazását.

A túl sok dimenzió csökkentése jelentős információmegőrzési problémákhoz vezethet, míg a túl kevés csökkentés hatástalan lehet.

További kihívást jelent a számítási komplexitás. Egyes dimenziócsökkentő algoritmusok, különösen a nagyméretű adathalmazok esetén, számításigényesek lehetnek, ami korlátozhatja a felhasználhatóságukat. Ezen kívül a dimenziócsökkentés eredményei függhetnek a paraméterek helyes beállításától. A paraméterek optimalizálása időigényes és szakértelmet igényel.

Végül, a dimenziócsökkentés nem mindig javítja az algoritmusok teljesítményét. Bizonyos esetekben a dimenziócsökkentés növelheti a zajszintet, vagy torzíthatja az adatokat, ami rontja a modellek pontosságát.

Dimenziócsökkentés a gyakorlatban: Python könyvtárak és eszközök (pl. scikit-learn)

A dimenziócsökkentés a gyakorlatban a Python programozási nyelv eszköztárával válik igazán hatékonnyá. A scikit-learn könyvtár kiemelkedő szerepet játszik ebben, számos algoritmust kínálva a különféle dimenziócsökkentési feladatokhoz.

Néhány népszerű technika a scikit-learn-ben:

- PCA (Principal Component Analysis): A leggyakrabban használt módszer, mely ortogonális transzformációval az adatokat új, lineárisan független változókra képezi le. Ezek a főkomponensek, melyek az eredeti adatok varianciájának legnagyobb részét tartalmazzák.

- LDA (Linear Discriminant Analysis): Felügyelt tanulási módszer, mely a különböző osztályok közötti szeparálhatóságot maximalizálja. Különösen hasznos osztályozási problémák esetén.

- t-SNE (t-distributed Stochastic Neighbor Embedding): Nemlineáris dimenziócsökkentő technika, mely a magas dimenziós adatok pontjainak közötti távolságokat igyekszik megőrizni alacsonyabb dimenzióban. Kiválóan alkalmas adatok vizualizációjára.

- UMAP (Uniform Manifold Approximation and Projection): Egy másik nemlineáris módszer, amely a globális adatstruktúrát is igyekszik megőrizni a dimenziócsökkentés során. Gyorsabb és gyakran pontosabb eredményeket ad, mint a t-SNE.

A scikit-learn használata egyszerű és intuitív. Az algoritmusok implementációja egységes, így könnyen kipróbálhatunk többféle módszert is. Például a PCA alkalmazása néhány sor kóddal megvalósítható:

from sklearn.decomposition import PCA

pca = PCA(n_components=2) # 2 dimenzióra csökkentjük

pca.fit(X) # X az eredeti adatmátrix

X_reduced = pca.transform(X) # Csökkentett dimenziójú adatok

A dimenziócsökkentés nem csak az adatok méretének csökkentéséről szól, hanem a zajszűrésről és a lényeges információk kiemeléséről is.

Fontos, hogy a paraméterek helyes beállítása kulcsfontosságú a jó eredmény eléréséhez. Például a PCA esetén a megfelelő számú főkomponens kiválasztása, vagy a t-SNE esetén a perplexitás beállítása befolyásolja a végső eredményt.

Más Python könyvtárak, mint például a TensorFlow és a PyTorch is kínálnak eszközöket a dimenziócsökkentéshez, különösen autoencoderek formájában, melyek neurális hálózatok segítségével tanulják meg az adatok tömörített reprezentációját.