A gépi tanulás területén számos algoritmus létezik, amelyek a legkülönfélébb problémák megoldására kínálnak hatékony eszközöket. Ezek közül az egyik legrobosztusabb és leggyakrabban alkalmazott módszer a Support Vector Machine (SVM), azaz a Támogató Vektor Gép. Az SVM algoritmus nem csupán egy egyszerű osztályozó, hanem egy komplex matematikai keretrendszer, amely képes lineárisan és nemlineárisan szétválasztható adatokkal egyaránt dolgozni, kiemelkedő teljesítményt nyújtva a prediktív modellezésben.

Az SVM-et eredetileg Vapnik és Chervonenkis fejlesztette ki az 1960-as években, de igazi áttörést csak az 1990-es években ért el, amikor a kernel trükk bevezetésével képessé vált bonyolult, nemlineáris kapcsolatok kezelésére is. A módszer alapvető célja, hogy megtalálja azt az optimális hiperplánt, amely a lehető legnagyobb „margint” (határteret) biztosítja a különböző osztályokba tartozó adatpontok között. Ez a megközelítés teszi az SVM-et különösen ellenállóvá az új, ismeretlen adatokkal szemben, és minimalizálja a túlillesztés (overfitting) kockázatát.

A Support Vector Machine nem csupán osztályozási feladatokra alkalmas; létezik egy regressziós változata is, a Support Vector Regression (SVR), amely folyamatos értékek előrejelzésére használható. Ez a sokoldalúság, valamint a mögötte álló szilárd matematikai elmélet tette az SVM-et a mesterséges intelligencia és az adatbányászat egyik sarokkövévé. A következőkben részletesen bemutatjuk az SVM működését, a lineárisan szeparálható esettől a kernel trükkön át a gyakorlati alkalmazásokig, rávilágítva az algoritmus erősségeire és kihívásaira.

Az SVM alapjai: a lineárisan szeparálható eset

Képzeljünk el egy egyszerű osztályozási problémát, ahol két különböző osztályba tartozó adatpontokat szeretnénk elkülöníteni. Ha ezek az adatpontok egy síkon helyezkednek el (két dimenzióban), és egy egyenes vonallal elválaszthatók egymástól, akkor lineárisan szeparálható adatokról beszélünk. Az SVM alapvető célja ebben az esetben az, hogy megtalálja azt az egyenest (vagy magasabb dimenzióban hiperplánt), amely a lehető legjobban szétválasztja a két osztályt.

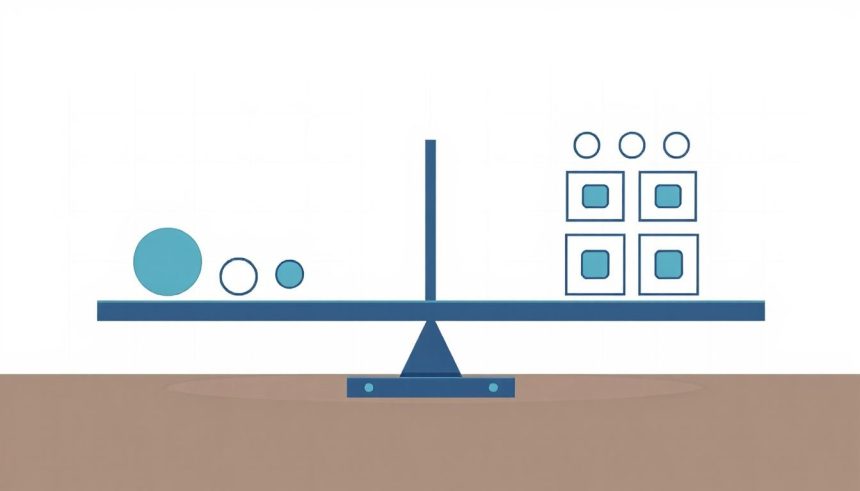

A „legjobban” ebben a kontextusban azt jelenti, hogy az elválasztó hiperplán a lehető legtávolabb legyen mindkét osztály legközelebbi adatpontjától. Ezt a távolságot nevezzük marginnak. Az SVM algoritmus tehát azt a hiperplánt keresi, amely maximalizálja ezt a margint. Miért fontos ez? Egy nagyobb margin azt jelenti, hogy a modell robusztusabb, és jobban képes általánosítani az új, nem látott adatokra, minimalizálva a téves besorolás kockázatát a határterületeken.

Azokat az adatpontokat, amelyek a legközelebb esnek az optimális hiperplánhoz, és így meghatározzák a margin szélességét, támogató vektoroknak (support vectors) nevezzük. Ezek az adatok kulcsfontosságúak, mivel kizárólag ők befolyásolják az elválasztó hiperplán helyzetét és orientációját. Az összes többi adatpont, amely távolabb esik a margintól, irreleváns az algoritmus szempontjából, ami az SVM egyik jelentős előnye: kevésbé érzékeny a zajos adatokra, feltéve, hogy a zajos pontok nem válnak támogató vektorokká.

A Support Vector Machine lényege, hogy megtalálja azt az optimális hiperplánt, amely maximalizálja a margin szélességét a különböző osztályok között.

Matematikailag egy hiperplán egy lineáris egyenlettel írható le: $w \cdot x – b = 0$, ahol $w$ a normálvektor (merőleges a hiperplánra), $x$ egy adatpont, és $b$ egy skalár érték, amely a hiperplán eltolását adja meg az origótól. Az SVM célja, hogy megtalálja az optimális $w$ és $b$ értékeket, amelyek maximalizálják a margint, miközben biztosítják, hogy minden adatpont a megfelelő oldalra essen a hiperplánhoz képest.

A margin maximalizálása egy kvadratikus optimalizálási probléma formájában fogalmazható meg, amelyre hatékony algoritmusok léteznek. A lineárisan szeparálható esetben az SVM garantáltan megtalálja a globális optimumot, ami rendkívül vonzó tulajdonság a gépi tanulásban, ahol sok algoritmus csak lokális optimumokat képes találni.

Ez a tiszta és elegáns matematikai keretrendszer adja az SVM erejét a kezdeti, lineárisan szeparálható esetekben. Azonban a valós adatok ritkán viselkednek ilyen ideálisan. Gyakran előfordul, hogy az osztályok átfedésben vannak, vagy nem választhatók el egy egyszerű egyenes vagy sík segítségével. Ezen kihívások kezelésére fejlesztették ki a „soft margin” SVM-et és a forradalmi kernel trükköt.

A lineárisan nem szeparálható eset: a soft margin SVM

A valós világban az adatok ritkán olyan rendezettek, hogy egy egyszerű egyenes vagy sík tökéletesen elválaszthatná a különböző osztályokat. Gyakran előfordul, hogy az adatpontok átfedésben vannak, vagy néhány „zajos” pont a „rossz” oldalon helyezkedik el a marginon belül. Ilyen esetekben a merev, „hard margin” SVM, amely tökéletes szeparálhatóságot feltételez, nem működne, vagy túlillesztést eredményezne.

Ennek a problémának a megoldására fejlesztették ki a soft margin SVM-et. A soft margin megközelítés megengedi, hogy néhány adatpont a marginon belülre essen, vagy akár a rossz oldalra kerüljön az elválasztó hiperplánhoz képest. Cserébe az algoritmus továbbra is igyekszik maximalizálni a margint, de egyúttal minimalizálja a hibás besorolások számát és az áthágások mértékét.

A soft margin SVM bevezeti a slack változókat (ξ – ejtsd: kszi). Ezek a változók mérik az adatpontok „áthágásának” mértékét:

- Ha egy pont a marginon kívül van és a helyes oldalon, akkor ξ = 0.

- Ha egy pont a marginon belül van, de még a helyes oldalon, akkor 0 < ξ < 1.

- Ha egy pont a rossz oldalon van (hibásan besorolva), akkor ξ ≥ 1.

Az SVM célja ebben az esetben az, hogy megtalálja azt a hiperplánt, amely minimalizálja az összes slack változó összegét, miközben továbbra is maximalizálja a margin szélességét.

Ezt a kompromisszumot egy C paraméter vezérli, amely az algoritmus egyik legfontosabb hiperparamétere.

- A kis C érték azt jelenti, hogy az algoritmus nagy toleranciával viseltetik a hibákkal szemben. Ebben az esetben a margin szélesebb lesz, de több hibás besorolás is megengedett. Ez a modell hajlamosabb az alulillesztésre (underfitting), de robusztusabb a zajjal szemben.

- A nagy C érték arra ösztönzi az algoritmust, hogy minimalizálja a hibákat. A margin szűkebb lesz, és az algoritmus szigorúbban bünteti az áthágásokat. Ez a modell jobban illeszkedik a tanító adatokhoz, de hajlamosabb a túlillesztésre, és érzékenyebb lehet a zajos pontokra.

A C paraméter optimális értékének megtalálása kulcsfontosságú a modell jó teljesítményéhez, és általában keresztezett validációval történik.

A soft margin SVM tehát rugalmasabb megközelítést kínál a valós világ adatainak kezelésére, lehetővé téve az osztályok közötti átfedéseket és a zajos pontok kezelését. Ez a rugalmasság teszi lehetővé az algoritmus széles körű alkalmazását olyan területeken, ahol a tökéletes lineáris szeparálhatóság ritkán fordul elő. Azonban még a soft margin SVM sem képes minden nemlineáris problémát megoldani, ami elvezet minket az SVM igazi erejét adó innovációhoz: a kernel trükkhöz.

A kernel trükk: nemlineáris szeparálhatóság

Mi történik, ha az adataink egyáltalán nem választhatók el egy egyenes vonallal vagy síkkal, még akkor sem, ha megengedünk néhány hibát? Gondoljunk például egy olyan adathalmazra, ahol az egyik osztály pontjai a középpontban helyezkednek el, a másik osztály pontjai pedig egy gyűrű formájában veszik körül őket. Ezt a konfigurációt semmilyen lineáris hiperplán nem tudja hatékonyan szétválasztani.

Ilyen esetekben lép színre az SVM egyik legzseniálisabb és leginnovatívabb aspektusa: a kernel trükk. A kernel trükk alapgondolata az, hogy az eredeti, alacsony dimenziójú bemeneti teret (ahol az adatok nemlineárisan szeparálhatók) leképezzük egy magasabb dimenziójú jellemzőtérbe (feature space), ahol az adatok már lineárisan szeparálhatóvá válnak. Ezt követően a már ismert lineáris SVM algoritmust alkalmazzuk ebben az új, magasabb dimenziójú térben.

A kernel trükk lehetővé teszi, hogy az SVM nemlineáris elválasztó felületeket hozzon létre az eredeti adatterületen anélkül, hogy valaha is explicit módon leképeznénk az adatokat egy magasabb dimenziós térbe.

A „trükk” abban rejlik, hogy nem kell explicit módon végrehajtani ezt a gyakran rendkívül magas (akár végtelen) dimenziójú leképezést. Ehelyett egy kernel függvényt használunk, amely közvetlenül kiszámítja a pontok közötti skaláris szorzatot a magasabb dimenziójú térben, anélkül, hogy valaha is ténylegesen létrehoznánk ezt a teret. Ezáltal elkerüljük a dimenzionalitás átka (curse of dimensionality) néven ismert problémát, amely hatalmas számítási költségeket és memóriaszükségletet jelentene.

Népszerű kernel típusok

Számos kernel függvény létezik, amelyek különböző típusú nemlineáris elválasztó felületeket tesznek lehetővé. A leggyakrabban használtak a következők:

- Lineáris kernel: $K(x_i, x_j) = x_i \cdot x_j$

Ez lényegében a standard lineáris SVM. Akkor használjuk, ha feltételezzük, hogy az adatok lineárisan szeparálhatók, vagy ha a magas dimenziós jellemzőtérbe való leképezés nem szükséges. Gyors és egyszerű, de nem képes nemlineáris problémákat kezelni.

- Polinomiális kernel: $K(x_i, x_j) = (\gamma x_i \cdot x_j + r)^d$

Ez a kernel polinomális elválasztó felületeket hoz létre. A $d$ paraméter a polinom fokát jelöli, míg a $\gamma$ és $r$ paraméterek további finomhangolást tesznek lehetővé. Alkalmas, ha az adatok közötti kapcsolatok polinomiális jellegűek.

- Radiális Bázisfüggvény (RBF) kernel / Gauss-kernel: $K(x_i, x_j) = \exp(-\gamma ||x_i – x_j||^2)$

Az RBF kernel az egyik legnépszerűbb és leggyakrabban használt kernel. Képes komplex, nemlineáris elválasztó felületeket létrehozni, és lényegében egy végtelen dimenziójú térbe képezi le az adatokat. A $\gamma$ paraméter szabályozza a kernel „hatókörét”:

- Kis $\gamma$ érték széles „hatókör” – a modell simább elválasztó felületet hoz létre, és hajlamosabb az alulillesztésre.

- Nagy $\gamma$ érték szűk „hatókör” – a modell bonyolultabb elválasztó felületet hoz létre, és hajlamosabb a túlillesztésre.

- Szigma (Sigmoid) kernel: $K(x_i, x_j) = \tanh(\gamma x_i \cdot x_j + r)$

Ez a kernel a neurális hálózatok sigmoid aktivációs függvényéhez hasonlít. Bár elméletileg képes nemlineáris elválasztó felületeket létrehozni, a gyakorlatban gyakran az RBF kernel jobban teljesít.

A megfelelő kernel függvény kiválasztása és a hozzá tartozó paraméterek (pl. $\gamma$, $d$) finomhangolása kulcsfontosságú az SVM modell teljesítményéhez. Ez a folyamat általában keresztezett validációval történik, ahol különböző kernel típusokat és paraméterkombinációkat próbálunk ki, hogy megtaláljuk a legjobban teljesítő modellt.

A kernel trükk forradalmasította az SVM-et, lehetővé téve számára, hogy rendkívül bonyolult, nemlineáris osztályozási problémákat oldjon meg, miközben megőrzi a lineáris SVM robusztusságát és a globális optimum megtalálásának képességét. Ez a flexibilitás tette az SVM-et az egyik legértékesebb eszközzé a gépi tanulás arzenáljában.

SVM regresszió (SVR): folyamatos értékek előrejelzése

Az SVM algoritmus nem csupán osztályozási feladatokra korlátozódik, ahol diszkrét kategóriákba soroljuk az adatokat. Létezik egy hatékony változata, a Support Vector Regression (SVR), amely folyamatos értékek előrejelzésére szolgál, hasonlóan a hagyományos regressziós modellekhez, mint például a lineáris regresszió.

Míg az SVM osztályozás célja egy hiperplán megtalálása, amely maximalizálja a margint a két osztály között, addig az SVR célja egy olyan hiperplán megtalálása, amely a lehető legjobban illeszkedik az adatpontokhoz, miközben minimalizálja a hibát, de egy bizonyos toleranciasávon belül. Ezt a toleranciasávot az ε (epsilon) paraméter határozza meg, és gyakran nevezik ε-inszenzitív tubusnak vagy csőnek.

Az SVR modell nem a margin maximalizálására törekszik, hanem arra, hogy a lehető legtöbb adatpontot helyezze el ezen az ε-tubuson belül. Azok az adatpontok, amelyek a tubuson kívül esnek, hibaként büntetésre kerülnek. A tubuson belül eső pontok esetében azonban a modell nem számol hibát, ami az SVR egyik megkülönböztető jellemzője. Ez a megközelítés robusztusabbá teszi az SVR-t a kiugró értékekkel (outliers) szemben, mivel a kis hibákat figyelmen kívül hagyja.

Az SVR működési elve

Az SVR célfüggvénye is egy optimalizálási probléma, amely a következőket igyekszik minimalizálni:

- A modell komplexitása (a $w$ normálvektor normája), hogy elkerülje a túlillesztést.

- Az ε-tubuson kívül eső pontok okozta hiba.

Hasonlóan a soft margin SVM-hez, az SVR is bevezeti a slack változókat (ξ és ξ*). Ezek a változók azt mérik, hogy az adatpontok mennyire esnek az ε-tubuson kívülre, mind a felső, mind az alsó határon. A modell célja, hogy minimalizálja ezeknek a slack változóknak az összegét.

A C paraméter itt is megjelenik, és a hibákra adott büntetés súlyát szabályozza.

- Nagy C érték: A modell kevésbé toleráns a hibákkal szemben, szigorúbban bünteti a tubuson kívül eső pontokat. Ez egy komplexebb modellt eredményezhet, amely hajlamosabb a túlillesztésre.

- Kis C érték: A modell toleránsabb a hibákkal szemben, és egy simább, általánosabb regressziós görbét eredményezhet, amely robusztusabb a zajjal szemben.

Az ε paraméter pedig a hibatűrés mértékét határozza meg. Minél nagyobb az ε, annál szélesebb a tubus, és annál több pont eshet bele anélkül, hogy hibaként büntetésre kerülne. Egy jól megválasztott ε érték segíthet elkerülni a túlillesztést és a zajra való érzékenységet.

Kernel trükk az SVR-ben

Ahogy az osztályozási SVM esetében, az SVR is képes kihasználni a kernel trükk erejét. Ezáltal az SVR nem csupán lineáris regressziós feladatokat képes megoldani, hanem bonyolult, nemlineáris kapcsolatokat is modellezhet az adatok között. A Radiális Bázisfüggvény (RBF) kernel itt is az egyik leggyakrabban használt választás, de alkalmazható a polinomiális vagy szigma kernel is.

Az RBF kernel használata esetén a $\gamma$ paraméter is kulcsszerepet játszik, hasonlóan az SVM osztályozáshoz. A $\gamma$ szabályozza a modell rugalmasságát és azt, hogy mennyire képes követni az adatpontok ingadozásait.

- Kis $\gamma$ érték: A modell simább regressziós felületet hoz létre, és kevésbé érzékeny az egyes adatpontokra.

- Nagy $\gamma$ érték: A modell komplexebb regressziós felületet hoz létre, és jobban illeszkedik az egyes adatpontokhoz, ami növelheti a túlillesztés kockázatát.

Az SVR paramétereinek (C, ε, kernel paraméterek mint $\gamma$) optimális beállítása elengedhetetlen a pontos és általánosítható modell eléréséhez, amit általában keresztezett validációs technikákkal végeznek.

Az SVR rendkívül hasznos olyan területeken, mint a pénzügyi előrejelzés, a tőzsdei árfolyamok becslése, az energiafogyasztás modellezése vagy bármilyen más feladat, ahol folyamatos numerikus kimenetet kell előre jelezni. Robusztussága a kiugró értékekkel szemben és a nemlineáris kapcsolatok kezelésének képessége miatt az SVR egy erős alternatívát jelent a hagyományos regressziós módszerekkel szemben.

Paraméterhangolás és modellválasztás

Az SVM algoritmus ereje és rugalmassága nagymértékben függ attól, hogy mennyire jól hangoljuk be a hiperparamétereit. A modell teljesítménye drámaian változhat a különböző paraméterkombinációk hatására. A paraméterhangolás célja, hogy megtaláljuk azt a paraméterkészletet, amely a legjobban általánosít az új, ismeretlen adatokra, elkerülve mind az alulillesztést, mind a túlillesztést.

Az SVM és SVR legfontosabb hiperparaméterei a következők:

| Paraméter | Leírás | Hatás alacsony érték esetén | Hatás magas érték esetén |

|---|---|---|---|

| C (Büntető paraméter) | Szabályozza a hibák büntetését. Kompromisszum a margin maximalizálása és a hibák minimalizálása között. | Szélesebb margin, több megengedett hiba (alulillesztés veszélye, robusztusabb). | Szűkebb margin, kevesebb megengedett hiba (túlillesztés veszélye, pontosabb a tanító halmazon). |

| Kernel típusa | Meghatározza a leképezést a magasabb dimenziós jellemzőtérbe (pl. lineáris, polinomiális, RBF, sigmoid). | Lineáris szeparátor, ha lineáris kernelt választunk. | Nemlineáris szeparátor, ha nemlineáris kernelt választunk (pl. RBF). |

| $\gamma$ (Gamma paraméter) | Csak nemlineáris kernelek (pl. RBF) esetén. Szabályozza, hogy egyetlen edzésminta mekkora „hatókörrel” rendelkezik. | Nagy hatókör, simább elválasztó felület (alulillesztés veszélye). | Kis hatókör, komplexebb elválasztó felület (túlillesztés veszélye). |

| $d$ (Polinom foka) | Csak polinomiális kernel esetén. A polinom rendjét határozza meg. | Egyszerűbb, simább elválasztó felület. | Bonyolultabb, rugalmasabb elválasztó felület. |

| $\epsilon$ (Epsilon, SVR esetén) | Az SVR-nél a hibatűrés mértéke, az ε-inszenzitív tubus szélessége. | Szűkebb tubus, érzékenyebb a hibákra (pontosabb, de zajérzékenyebb). | Szélesebb tubus, toleránsabb a hibákkal szemben (robusztusabb, de kevésbé pontos). |

A paraméterhangolás módszerei

A hiperparaméterek optimális kombinációjának megtalálása iteratív folyamat, amely gyakran a következő technikákat foglalja magában:

- Keresztezett validáció (Cross-Validation):

Ez a leggyakoribb és legmegbízhatóbb módszer a modell általánosítási képességének felmérésére. Az adathalmazt több részre (foldra) osztják. A modell minden egyes foldon tanítva van, és a fennmaradó foldokon tesztelik. A leggyakoribb a k-fold keresztvalidáció, ahol az adathalmazt $k$ egyenlő részre osztják, és $k$ alkalommal futtatják a modell tanítását és tesztelését, minden alkalommal más-más foldot használva tesztelési halmazként. Az eredmények átlagolása adja a modell valós teljesítménybecslését, és segít minimalizálni az adatok felosztásából adódó véletlenszerű torzítást.

- Rácskeresés (Grid Search):

Ez egy kimerítő keresési módszer, amely a hiperparaméterek előre definiált tartományában minden lehetséges kombinációt kipróbál. Például, ha a C paramétert [0.1, 1, 10, 100] és a $\gamma$ paramétert [0.001, 0.01, 0.1, 1] értékekkel akarjuk tesztelni, a rácskeresés minden 4×4=16 kombinációt kipróbálna. Minden kombinációt keresztvalidációval értékelnek, és a legjobb teljesítményt nyújtó paraméterkészletet választják ki. Bár alapos, számításigényes lehet, különösen sok paraméter és nagy tartományok esetén.

- Véletlenszerű keresés (Random Search):

A rácskeresés alternatívája, amely véletlenszerűen választ paraméterkombinációkat az előre definiált tartományokból egy adott számú iterációra. Tanulmányok kimutatták, hogy a véletlenszerű keresés gyakran hatékonyabb, mint a rácskeresés, különösen nagy dimenziós paramétertér esetén, mivel jobban képes felfedezni az optimális régiókat.

- Bayesian optimalizáció:

Ez egy fejlettebb módszer, amely egy valószínűségi modellt épít fel a hiperparaméter-készlet és a modell teljesítménye közötti kapcsolatról. Ezt a modellt használja arra, hogy intelligensen válassza ki a következő kipróbálandó paraméterkombinációt, minimalizálva az iterációk számát és maximalizálva az esélyt a globális optimum megtalálására.

A modellválasztás nem csupán a hiperparaméterekről szól, hanem a megfelelő kernel kiválasztásáról is. Nincs „egy méret mindenkire” megoldás; a legjobb kernel és paraméterkészlet az adathalmaz tulajdonságaitól és a megoldandó problémától függ. Gyakran az RBF kernel a jó kiindulópont, mivel rugalmas és sokféle adatszerkezethez képes illeszkedni. Azonban más kernelek is jobban teljesíthetnek bizonyos specifikus esetekben.

A gondos paraméterhangolás és modellválasztás elengedhetetlen ahhoz, hogy az SVM modelljeink ne csak a tanító adatokon, hanem az új, valós adatokon is kiemelkedő teljesítményt nyújtsanak. Ez a folyamat időigényes lehet, de a befektetett munka megtérül a robusztusabb és pontosabb prediktív modellek formájában.

Az SVM előnyei és hátrányai

A Support Vector Machine egy rendkívül erőteljes és sokoldalú algoritmus, de mint minden gépi tanulási módszernek, megvannak a maga előnyei és hátrányai. Fontos tisztában lenni ezekkel, amikor mérlegeljük, hogy az SVM-et válasszuk-e egy adott feladathoz.

Előnyök

- Hatékony magas dimenziós terekben:

Az SVM különösen jól teljesít, ha az adatok sok jellemzővel rendelkeznek (magas dimenziósak). A kernel trükk lehetővé teszi, hogy hatékonyan dolgozzon olyan terekben, ahol a jellemzők száma meghaladja az adatpontok számát, anélkül, hogy explicit módon kezelné ezeket a magas dimenziókat.

- Robusztus a túlillesztéssel szemben (jó általánosítási képesség):

Az SVM a margin maximalizálására törekszik, nem pedig a tanító adatok hibátlan illesztésére. Ez a megközelítés természetesen vezet a jobb általánosítási képességhez, és csökkenti a túlillesztés kockázatát, különösen a „soft margin” implementációkban.

- Jól definiált matematikai alapok:

Az SVM mögött szilárd matematikai elmélet áll, ami garantálja a globális optimum megtalálását a kvadratikus optimalizálási probléma megoldása során (ellentétben sok más algoritmussal, amelyek lokális optimumokba ragadhatnak).

- Rugalmasság a kernel trükk révén:

A kernel trükk képessé teszi az SVM-et a lineárisan nem szeparálható adatok kezelésére, lehetővé téve rendkívül komplex, nemlineáris elválasztó felületek létrehozását anélkül, hogy a számítási költségek exponenciálisan növekednének.

- Kevés támogató vektor:

A modell csak a támogató vektorokra támaszkodik a döntési határ meghatározásához. Ez azt jelenti, hogy a legtöbb adatpont elhagyható a modell betanítása után anélkül, hogy befolyásolná a predikciókat, ami memóriahatékonyabbá teszi a modellt.

- Robusztus a kiugró értékekkel szemben (SVR):

Az SVR az ε-inszenzitív tubusnak köszönhetően kevésbé érzékeny a kiugró értékekre, mivel a tubuson belüli hibákat figyelmen kívül hagyja, ami stabilabb regressziós modelleket eredményezhet.

Hátrányok

- Lassú nagy adathalmazokon:

Az SVM betanítási ideje a tanító adatok számának négyzetével vagy köbével arányos lehet ($O(n^2)$ vagy $O(n^3)$), ami nagyon lassúvá teheti a nagy adathalmazok (több százezer vagy millió adatpont) feldolgozását. Bár léteznek optimalizált implementációk, ez továbbra is korlátozó tényező lehet.

- Érzékeny a paraméterhangolásra:

Az SVM teljesítménye rendkívül érzékeny a C, $\gamma$ és más kernel paraméterek megfelelő beállítására. Az optimális paraméterek megtalálása időigényes és számításigényes folyamat lehet, amelyhez gyakran keresztezett validációra és rácskeresésre vagy véletlenszerű keresésre van szükség.

- Kernel kiválasztása:

Nincs univerzális szabály arra, hogy melyik kernel a legjobb egy adott problémára. A megfelelő kernel kiválasztása tapasztalatot és kísérletezést igényel, és nagymértékben befolyásolja a modell teljesítményét.

- Interpretálhatóság hiánya:

Az SVM, különösen a nemlineáris kernelekkel, egy „fekete doboz” modellnek tekinthető. Nehéz közvetlenül értelmezni, hogy mely jellemzők járulnak hozzá leginkább a döntéshez, vagy hogy miért hozott a modell egy adott predikciót. Ez problémás lehet olyan alkalmazásokban, ahol az átláthatóság kulcsfontosságú (pl. orvosi diagnosztika, pénzügyi szabályozás).

- Bináris osztályozásra tervezve:

Az SVM eredetileg bináris osztályozási problémákra lett kifejlesztve (két osztály). Többosztályos osztályozás esetén általában „egy az egy ellen” (one-vs-one) vagy „egy a többi ellen” (one-vs-rest) stratégiákat alkalmaznak, amelyek több SVM modell betanítását igénylik, ami növelheti a komplexitást és a számítási időt.

- Zajos adatokra való érzékenység (hard margin):

Bár a „soft margin” SVM robusztusabb, a „hard margin” változat rendkívül érzékeny a zajos adatokra és a kiugró értékekre, mivel megpróbálja tökéletesen elválasztani az osztályokat, ami túlillesztéshez vezethet.

Összességében az SVM továbbra is egy kiemelkedő algoritmus, különösen a közepes méretű, magas dimenziós adathalmazokon, ahol a robusztusság és a jó általánosítási képesség a legfontosabb. Azonban a nagy adathalmazok és az interpretálhatóság iránti igények esetén más algoritmusok, mint például a neurális hálózatok vagy a döntési fák, jobb választásnak bizonyulhatnak.

Gyakori felhasználási területek

Az Support Vector Machine (SVM) sokoldalúságának és robusztusságának köszönhetően számos iparágban és alkalmazási területen bizonyította hatékonyságát. Képes kezelni mind az osztályozási, mind a regressziós feladatokat, és különösen jól teljesít magas dimenziós adatokon és bonyolult, nemlineáris kapcsolatok esetén.

1. Szövegbesorolás és spam szűrés

Az SVM az egyik leggyakrabban használt algoritmus a természetes nyelvi feldolgozás (NLP) területén, különösen a szövegbesorolásra.

- Spam szűrés: E-mailek osztályozása spam vagy nem-spam kategóriába. Az SVM képes az e-mail tartalmából és metaadataiból kinyert jellemzők alapján hatékonyan azonosítani a kéretlen üzeneteket.

- Hangulatelemzés: Szövegek hangulatának (pozitív, negatív, semleges) meghatározása, például vásárlói vélemények, közösségi média posztok elemzésére.

- Témabesorolás: Dokumentumok, cikkek, weboldalak automatikus besorolása előre definiált témakörökbe (pl. sport, politika, technológia).

Az SVM jól kezeli a szöveges adatok magas dimenzióját (ahol minden szó vagy szógyök egy jellemző lehet), és a kevésbé sűrű (sparse) adatokon is hatékonyan működik.

2. Képfelismerés és objektumdetektálás

A képfeldolgozás és a számítógépes látás területén az SVM széles körben alkalmazott algoritmus volt, mielőtt a mélytanulás forradalmasította volna a területet.

- Arcfelismerés: Arcok azonosítása képeken, gyakran más algoritmusokkal (pl. PCA) kombinálva a jellemzők kinyerésére.

- Objektumdetektálás: Bizonyos objektumok (pl. autók, gyalogosok) azonosítása képeken vagy videófolyamokban.

- Kézírás-felismerés: Karakterek vagy számok felismerése kézzel írt szövegekből.

- Orvosi képalkotás: Daganatok, betegségek azonosítása orvosi képeken (pl. MRI, CT felvételek).

Az SVM képes a képekből kinyert jellemzők (pl. HOG – Histogram of Oriented Gradients) alapján hatékonyan osztályozni a képrészleteket.

3. Biomedicinális és genetikai adatok elemzése

Az SVM robusztussága és képessége a magas dimenziós, komplex adatok kezelésére ideálissá teszi a biológiai és orvosi alkalmazásokhoz.

- Betegségdiagnózis: Betegségek diagnosztizálása orvosi adatok (pl. laboreredmények, genetikai markerek) alapján.

- Fehérjeosztályozás: Fehérjék funkcionális osztályba sorolása aminosav-szekvenciák vagy szerkezeti adatok alapján.

- Genexpressziós adatok elemzése: Gépek vagy géncsoportok azonosítása, amelyek egy adott betegséggel vagy biológiai folyamattal kapcsolatosak.

A precíziós orvoslásban az SVM segíthet a személyre szabott kezelések kidolgozásában a beteg egyedi genetikai profilja alapján.

4. Pénzügyi előrejelzések és kockázatelemzés

A pénzügyi szektorban az SVR (Support Vector Regression) különösen hasznos a folyamatos értékek előrejelzésére és az SVM az osztályozásra.

- Tőzsdei árfolyamok előrejelzése: Részvényárfolyamok, devizaárfolyamok vagy árupiaci árak alakulásának becslése.

- Hitelkockázat-értékelés: Ügyfelek besorolása hitelképességi kategóriákba, a hitel visszafizetésének valószínűsége alapján.

- Csalásfelderítés: Tranzakciók vagy hitelkártya-használatok elemzése a csalárd tevékenységek azonosítása érdekében.

Az SVM képes kezelni a pénzügyi adatokban gyakran előforduló zajt és nemlineáris kapcsolatokat.

5. Bioinformatika és gyógyszerkutatás

A nagy adathalmazok és a komplex mintázatok miatt az SVM értékes eszköz a bioinformatikában.

- Gyógyszertervezés: Molekulák szűrése a potenciális gyógyszerjelöltek azonosítására.

- Szekvenciaanalízis: DNS vagy RNS szekvenciák osztályozása funkcionális régiókba.

- Klinikai vizsgálatok: Betegek csoportosítása a kezelésre adott válasz alapján.

Az SVM segíthet felgyorsítani a kutatási és fejlesztési folyamatokat a gyógyszeriparban.

Ezek csupán néhány példa az SVM széles körű alkalmazhatóságára. Az algoritmus továbbra is népszerű választás a kutatók és az ipari szakemberek körében, különösen akkor, ha a robusztusság, a jó általánosítási képesség és a komplex, nemlineáris kapcsolatok kezelésének képessége a legfontosabb szempontok.

Összehasonlítás más gépi tanulási algoritmusokkal

Az SVM egy rendkívül hatékony algoritmus, de a gépi tanulás eszköztára tele van más, hasonlóan erőteljes módszerekkel. Fontos megérteni, hogy mikor érdemes az SVM-et választani, és mikor lehetnek más algoritmusok előnyösebbek.

1. Logisztikus regresszió

A logisztikus regresszió egy egyszerűbb lineáris modell, amelyet bináris osztályozásra használnak.

- Hasonlóságok: Mindkettő lineáris elválasztó felületet használhat.

- Különbségek:

- SVM: A margin maximalizálására fókuszál, csak a támogató vektorok fontosak. Kevésbé érzékeny a kiugró értékekre a soft margin miatt. A kernel trükkkel nemlineáris problémákat is kezel.

- Logisztikus regresszió: Valószínűségi kimenetet ad (0 és 1 közötti értéket), ami jobban interpretálható. Az összes adatpont befolyásolja a modellt. Nincs beépített kernel trükk, így alapvetően lineáris osztályozó.

- Mikor válasszuk?

- SVM: Ha az adatok lineárisan vagy nemlineárisan szeparálhatók, és a robusztusság, valamint a jó általánosítás a cél.

- Logisztikus regresszió: Ha valószínűségi előrejelzésekre van szükség, és az adatok lineárisan szeparálhatók, vagy a modell interpretálhatósága fontosabb.

2. Döntési fák és Random Forest

A döntési fák és az Random Forest (véletlen erdő) ensemble módszerek, amelyek hierarchikus döntési szabályokat használnak.

- Hasonlóságok: Mindkettő képes nemlineáris kapcsolatokat modellezni.

- Különbségek:

- SVM: Globális optimumot keres, nemlineáris kernelekkel flexibilis. Nehezen interpretálható.

- Döntési fák/Random Forest: Könnyen interpretálhatóak (különösen a döntési fák). Jól kezelik a kategorikus jellemzőket. A Random Forest robusztus a túlillesztéssel szemben, és általában jól teljesít.

- Mikor válasszuk?

- SVM: Ha az adatok magas dimenziósak, és a pontosság a fő szempont.

- Döntési fák/Random Forest: Ha az interpretálhatóság fontos, vagy ha sok kategorikus jellemző van. A Random Forest gyakran jó kiindulópont, mivel általában megbízhatóan teljesít kevés paraméterhangolással is.

3. Neurális hálózatok (Mélytanulás)

A neurális hálózatok, különösen a mélytanulási modellek, rendkívül komplex nemlineáris kapcsolatokat képesek megtanulni.

- Hasonlóságok: Mindkettő képes bonyolult nemlineáris elválasztó felületeket létrehozni.

- Különbségek:

- SVM: Kisebb adathalmazokon gyakran jobban teljesít, és kevesebb paraméterhangolást igényel, mint a mélytanulás. Nem igényel GPU-t a betanításhoz (általában).

- Neurális hálózatok: Kiemelkedően teljesítenek hatalmas adathalmazokon (képek, videók, hangok), ahol az SVM számításilag korlátokba ütközik. Sok paramétert igényelnek, és sok adatot a betanításhoz. Gyakran GPU-ra van szükség.

- Mikor válasszuk?

- SVM: Közepes méretű strukturált adathalmazokon (táblázatos adatok), ahol a robusztusság és a jól megalapozott elmélet fontos.

- Neurális hálózatok: Nagy, nem strukturált adathalmazokon (képek, hang, szöveg), ahol a mélytanulás képes automatikusan megtanulni a releváns jellemzőket.

Mikor válasszunk SVM-et?

Az SVM különösen jó választás lehet a következő esetekben:

- Közepes méretű adathalmazok: Nem túl kicsi, de nem is hatalmas adathalmazokon (néhány ezer-százezer adatpont) az SVM kiváló teljesítményt nyújthat.

- Magas dimenziós adatok: Ha sok jellemző van, különösen akkor, ha a jellemzők száma meghaladja az adatpontok számát, az SVM a kernel trükknek köszönhetően hatékonyan működik.

- Tiszta elválasztási margin: Ha az osztályok jól elválaszthatók, akár lineárisan, akár nemlineárisan, az SVM képes megtalálni az optimális döntési határt.

- Robusztusság és általánosítás: Ha a cél egy olyan modell létrehozása, amely jól általánosít új adatokra, és ellenálló a zajjal vagy a kiugró értékekkel szemben.

- Memóriahatékonyság (predikció): Miután a modellt betanították, csak a támogató vektorokat kell tárolni a predikciókhoz, ami memóriahatékonyabbá teszi, mint például a k-NN.

Az optimális algoritmus kiválasztása mindig a konkrét probléma, az adatok jellege és a rendelkezésre álló erőforrások függvénye. Gyakran érdemes több algoritmust is kipróbálni, és keresztezett validációval összehasonlítani a teljesítményüket, hogy megtaláljuk a legjobb megoldást.

Gyakorlati megvalósítás Pythonban (Scikit-learn)

A Support Vector Machine algoritmusok implementálása a gyakorlatban, különösen Pythonban, rendkívül egyszerű a népszerű Scikit-learn könyvtárnak köszönhetően. A Scikit-learn egy gazdag funkcionalitású és könnyen használható eszköz a gépi tanulási feladatokhoz, beleértve az SVM osztályozást (SVC) és a SVM regressziót (SVR) is.

A Scikit-learn `svm` modulja tartalmazza a legfontosabb osztályokat az SVM modellek létrehozásához:

- `sklearn.svm.SVC`: Osztályozási feladatokra (Support Vector Classification).

- `sklearn.svm.SVR`: Regressziós feladatokra (Support Vector Regression).

- `sklearn.svm.NuSVC` és `sklearn.svm.NuSVR`: Alternatív implementációk, ahol a C paraméter helyett a $\nu$ (nu) paramétert használjuk a hibák szabályozására.

Példa SVC (osztályozás) használatára

Képzeljünk el egy egyszerű bináris osztályozási feladatot, ahol két osztályt szeretnénk elkülöníteni. Az alábbiakban bemutatjuk, hogyan lehetne egy SVC modellt betanítani és használni. A kódblokkban a koncepciót szemléltetjük, nem futtatható kódot adunk:

# Szükséges könyvtárak importálása

from sklearn import svm

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

import numpy as np

# Adatok generálása (példa)

# X: jellemzők (features), y: célváltozó (target)

X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1], [-1, 1], [1, -1]])

y = np.array([0, 0, 1, 1, 0, 1]) # Két osztály: 0 és 1

# Adatok felosztása tanító és teszt halmazra

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# SVM osztályozó létrehozása és paraméterezése

# Itt egy RBF kernelt használunk, C=10 és gamma=0.1 paraméterekkel

model = svm.SVC(kernel='rbf', C=10, gamma=0.1)

# Modell betanítása (illesztése) a tanító adatokra

model.fit(X_train, y_train)

# Predikciók készítése a teszt adatokon

y_pred = model.predict(X_test)

# A modell teljesítményének kiértékelése (pontosság)

accuracy = accuracy_score(y_test, y_pred)

print(f"A modell pontossága: {accuracy:.2f}")

# Támogató vektorok lekérdezése

# print(model.support_vectors_)

Ebben a példában a `svm.SVC` osztályt használtuk. A `kernel` paraméterrel választhatjuk ki a kernel típusát (`’linear’`, `’poly’`, `’rbf’`, `’sigmoid’`, `’precomputed’`). A `C` és `gamma` (RBF kernel esetén) paraméterek finomhangolása kulcsfontosságú. A `fit()` metódus tanítja be a modellt, a `predict()` metódus pedig előrejelzéseket készít.

Példa SVR (regresszió) használatára

Hasonlóan egyszerű az SVR használata is, ha folyamatos értékeket szeretnénk előre jelezni:

# Szükséges könyvtárak importálása

from sklearn import svm

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

import numpy as np

# Adatok generálása (példa)

# X: jellemzők, y: célváltozó (folyamatos érték)

X = np.sort(5 * np.random.rand(40, 1), axis=0)

y = np.sin(X).ravel()

y[::5] += 3 * (0.5 - np.random.rand(8)) # Zaj hozzáadása

# Adatok felosztása tanító és teszt halmazra

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# SVM regresszor létrehozása és paraméterezése

# Itt egy RBF kernelt használunk, C=100, epsilon=0.1 és gamma=0.1 paraméterekkel

model_svr = svm.SVR(kernel='rbf', C=100, epsilon=0.1, gamma=0.1)

# Modell betanítása (illesztése) a tanító adatokra

model_svr.fit(X_train, y_train)

# Predikciók készítése a teszt adatokon

y_pred_svr = model_svr.predict(X_test)

# A modell teljesítményének kiértékelése (középnégyzetes hiba)

mse = mean_squared_error(y_test, y_pred_svr)

print(f"A modell középnégyzetes hibája: {mse:.2f}")

Az SVR esetében a `svm.SVR` osztályt használjuk, ahol a `C`, `epsilon` (ε) és `gamma` (RBF kernel esetén) paraméterek meghatározóak. A `mean_squared_error` (középnégyzetes hiba) egy gyakori metrika a regressziós modellek értékelésére.

Paraméterhangolás Scikit-learnnel

A paraméterhangolás, mint a rácskeresés (GridSearchCV) vagy a véletlenszerű keresés (RandomizedSearchCV), szintén könnyen megvalósítható a Scikit-learn segítségével. Ezek az eszközök automatizálják a keresztvalidációt és a paraméterkombinációk kipróbálását, megtalálva a legjobb teljesítményt nyújtó modellt.

from sklearn.model_selection import GridSearchCV

# Paraméterek szótára, amit tesztelni szeretnénk

param_grid = {

'C': [0.1, 1, 10, 100],

'gamma': [1, 0.1, 0.01, 0.001],

'kernel': ['rbf']

}

# GridSearchCV létrehozása

# Az SVC modellt használjuk, 5-ös keresztvalidációval (cv=5)

grid_search = GridSearchCV(svm.SVC(), param_grid, refit=True, verbose=2, cv=5)

# A rácskeresés futtatása a tanító adatokon

grid_search.fit(X_train, y_train)

# A legjobb paraméterek és a legjobb modell lekérdezése

print(f"Legjobb paraméterek: {grid_search.best_params_}")

print(f"Legjobb pontosság a keresztvalidáció során: {grid_search.best_score_:.2f}")

best_model = grid_search.best_estimator_

# A legjobb modellel történő predikciók és kiértékelés

# y_pred_best = best_model.predict(X_test)

# accuracy_best = accuracy_score(y_test, y_pred_best)

# print(f"A legjobb modell pontossága a teszt halmazon: {accuracy_best:.2f}")

A Scikit-learn egyszerűsíti az SVM és SVR modellek létrehozását, betanítását és finomhangolását, lehetővé téve a fejlesztők és adatelemzők számára, hogy hatékonyan alkalmazzák ezeket az erős algoritmusokat a legkülönfélébb gépi tanulási problémák megoldására.

Jövőbeli irányok és fejlesztések

A Support Vector Machine (SVM) algoritmusok, bár már évtizedek óta léteznek, továbbra is aktív kutatási területet jelentenek, és folyamatosan fejlődnek. A gépi tanulás és a mesterséges intelligencia robbanásszerű fejlődése új kihívásokat és lehetőségeket teremt az SVM számára, különösen a nagy adathalmazok kezelése és a más technológiákkal való integráció terén.

1. Nagy adathalmazok kezelése

Az SVM egyik legnagyobb hátránya a számítási idő, amely nagy adathalmazok esetén jelentősen megnő. A jövőbeli fejlesztések egyik fő iránya az, hogy az SVM-et skálázhatóbbá tegyék a „big data” környezetben.

- Párhuzamos és elosztott számítás: Olyan implementációk fejlesztése, amelyek képesek kihasználni a többmagos processzorokat vagy a számítási klasztereket az SVM betanítási idejének csökkentésére.

- Inkremetális és online SVM: Algoritmusok, amelyek képesek folyamatosan tanulni az új adatokból anélkül, hogy az egész modellt újra kellene tanítani.

- Strukturált jellemzők és adatok: Az SVM kiterjesztése strukturált adatok (pl. gráfok, szekvenciák) kezelésére, amelyekben a hagyományos jellemzők kinyerése bonyolult lehet.

Ezek a fejlesztések segítenek abban, hogy az SVM versenyképes maradjon a mélytanulási modellekkel szemben a nagy adathalmazokon.

2. Quantum SVM

A kvantum számítástechnika megjelenése új távlatokat nyit a gépi tanulásban. A Quantum SVM egy ígéretes kutatási terület, amely a kvantummechanika elveit használja fel a klasszikus SVM algoritmusok felgyorsítására vagy új képességekkel való felruházására.

- Kvantum kernel trükk: A kvantum számítógépek képesek lehetnek olyan komplex, magas dimenziójú jellemzőtérbe leképezni az adatokat, amelyet a klasszikus számítógépek nem tudnak hatékonyan szimulálni, ezáltal még erősebb nemlineáris elválasztó felületeket hozva létre.

- Gyorsabb optimalizálás: A kvantum algoritmusok potenciálisan felgyorsíthatják az SVM mögött meghúzódó kvadratikus optimalizálási probléma megoldását.

Bár még gyerekcipőben jár, a Quantum SVM hosszú távon jelentős áttörést hozhat a gépi tanulásban.

3. Ensemble módszerek és hibrid modellek

Az SVM ereje gyakran fokozható más algoritmusokkal vagy ensemble módszerekkel kombinálva.

- SVM + Mélytanulás: Az SVM használható a mélytanulási modell utolsó rétegeként osztályozási feladatokhoz, kihasználva a mélytanulás jellemzőkivonási képességét és az SVM robusztusságát.

- Ensemble SVM: Több SVM modell kombinálása (pl. bagging, boosting) a prediktív teljesítmény javítása és a modell stabilitásának növelése érdekében.

- Hibrid modellek: Az SVM integrálása más gépi tanulási módszerekkel, mint például a döntési fák vagy a neurális hálózatok, hogy kihasználják az egyes algoritmusok erősségeit.

Ezek a megközelítések lehetővé teszik az SVM számára, hogy még összetettebb problémákat oldjon meg, és jobban alkalmazkodjon a különböző adatszerkezetekhez.

4. Magyarázható SVM (Explainable SVM)

Az SVM, különösen a nemlineáris kernelekkel, egy „fekete doboz” modell. Az magyarázható mesterséges intelligencia (XAI) területének fejlődésével egyre nagyobb igény mutatkozik olyan SVM modellekre, amelyek döntései jobban értelmezhetők.

- Jellemző fontosság: Módszerek fejlesztése annak megállapítására, hogy mely jellemzők a legfontosabbak az SVM döntésében.

- Vizualizációs technikák: A döntési határok és a támogató vektorok vizualizálása magas dimenziós terekben, hogy intuitívabbá tegyék a modell működését.

- Magyarázó modellek: Egyszerűbb, értelmezhetőbb modellek létrehozása, amelyek magyarázzák a komplex SVM modell döntéseit.

Ez a terület kritikus fontosságú az SVM elfogadásának növeléséhez olyan iparágakban, ahol az átláthatóság és az elszámoltathatóság kulcsfontosságú.

Az SVM továbbra is egy alapvető és releváns algoritmus a gépi tanulásban. Bár a mélytanulás számos területen dominál, az SVM továbbra is kiváló teljesítményt nyújt specifikus problémákon és adathalmazokon. A folyamatos kutatás és fejlesztés biztosítja, hogy az SVM továbbra is az egyik legértékesebb eszköz maradjon a mesterséges intelligencia eszköztárában.