A modern számítástechnika alapköve a gyors és hatékony adatkezelés, amelynek középpontjában a memória áll. Amikor a rendszermemóriáról (RAM – Random Access Memory) beszélünk, gyakran a modulok, a kapacitás és a sebesség jut eszünkbe, azonban a mögöttes architektúra, különösen a memóriabankok fogalma, kulcsfontosságú a RAM működésének és teljesítményének megértéséhez. Ez a hardverelem nem csupán egy technikai részlet; valójában ez teszi lehetővé a párhuzamos adatfeldolgozást és a modern rendszerek elképesztő sebességét.

A memóriabankok alapvetően a RAM fizikai és logikai szervezésének egy módját jelentik. Képzeljük el úgy, mint a memória chipen belüli különálló, de koordináltan működő tárolóegységeket. Ezek a bankok teszik lehetővé, hogy a memóriavezérlő egyszerre több műveletet is elindítson, ezzel jelentősen növelve az adatátviteli sebességet és csökkentve a késleltetést. A bankok közötti intelligens váltás, az úgynevezett bank interleaving, optimalizálja a hozzáférési időt, hiszen amíg az egyik bank egy adatkérést dolgoz fel, addig a másik már felkészülhet a következőre.

Ez a cikk mélyrehatóan tárgyalja a memóriabankok definícióját, szerepét, felépítését és működését a RAM kontextusában. Megvizsgáljuk, hogyan fejlődött ez a koncepció az évek során a különböző DRAM generációkban, milyen hatással van a rendszer teljesítményére, és milyen fejlettebb technológiák épülnek rájuk. Célunk, hogy ne csak egy definíciót adjunk, hanem teljes képet kapjunk arról, miért elengedhetetlen a memóriabank a mai nagy teljesítményű számítógépek működéséhez.

A memóriabank alapjai: Mi is az valójában?

A memóriabank a dinamikus véletlen hozzáférésű memória (DRAM) modulok alapvető szervezeti egysége. A legegyszerűbb megfogalmazásban egy bank egy önállóan címezhető memóriaterületet jelent egy DRAM chipen belül. Ezek a bankok nem csupán logikai felosztások; fizikai struktúrák, amelyek önállóan, de a memóriavezérlő irányítása alatt működnek.

A bankok létezésének elsődleges oka a párhuzamosság növelése. Egyetlen memóriachipen belül több bank lehetővé teszi, hogy a vezérlő egyszerre több adatkérést kezeljen, vagy legalábbis gyorsan váltson közöttük anélkül, hogy megvárná az egyes műveletek teljes befejezését. Ez a képesség drámaian javítja a memória sávszélességét és csökkenti a látszólagos késleltetést.

A bankok nélkül minden memóriahozzáférés egymás után, szekvenciálisan történne, ami rendkívül lassúvá tenné a mai rendszereket. Gondoljunk csak bele: egyetlen memóriacella aktiválása és adatainak kiolvasása időbe telik. Ha minden egyes adatkéréshez meg kellene várni az előző teljes lezárását, mielőtt a következő megkezdődhetne, a processzor sokkal többet várakozna adatokra.

A memória hierarchia szempontjából a memóriabank a RAM szintjén helyezkedik el. A CPU közvetlenül nem a bankokkal kommunikál, hanem a memóriavezérlőn keresztül, amely a CPU-ba van integrálva. A vezérlő felelős a bankok közötti koordinációért, a címfordításért, az adatok kiolvasásáért és beírásáért, valamint a DRAM frissítéséért.

Minden DRAM cella egy kondenzátorból és egy tranzisztorból áll. A kondenzátor tárolja az adatot (töltött állapot = 1, töltetlen állapot = 0), a tranzisztor pedig kapcsolóként funkcionál, lehetővé téve a kondenzátor töltésének vagy kiolvasásának vezérlését. A probléma az, hogy a kondenzátorok idővel elveszítik töltésüket, ezért rendszeres frissítésre van szükségük. Ezt a frissítési ciklust is a memóriabankok szervezik, biztosítva, hogy az adatok integritása megmaradjon.

A memóriabankok létezése alapvetően változtatta meg a RAM működését, lehetővé téve a modern számítástechnika számára elengedhetetlen párhuzamosságot és sebességet.

A memóriabankok felépítése és szervezése

A memóriabankok szervezése összetett, de logikus felépítést követ. Egy tipikus DRAM chip több bankot tartalmaz, amelyek mindegyike egy mátrixszerű elrendezésben tárolja az adatokat. Ez a mátrix sorokból és oszlopokból áll, ahol minden metszéspontban egy memóriacella található. Amikor a memóriavezérlő adatot kér, először a bankot, majd azon belül a megfelelő sort és oszlopot azonosítja.

A fizikai szervezés a chipen belüli elrendezésre utal. Egy DRAM chip általában több, elkülönített bankból áll, amelyek mindegyike saját sor- és oszlopdekóderekkel, valamint erősítőkkel rendelkezik. Ez az önállóság teszi lehetővé, hogy a bankok egymástól függetlenül, de koordináltan működjenek. A logikai szervezés pedig azt mutatja, hogyan címezhetők és kezelhetők ezek a bankok a memóriavezérlő szempontjából.

A címzés folyamata kulcsfontosságú. A memóriavezérlő egyetlen fizikai címet kap a CPU-tól, amelyet aztán feloszt különböző részekre: bankcímre, sorcímre és oszlopcímre. Először kiválasztja a megfelelő bankot, majd azon belül aktiválja a megadott sort (ezt hívják soraktiválásnak vagy „row activation”-nek). Ezt követően az oszlopcímet használva kiválasztja a kívánt adatot a sorból. Az adatok ezután az I/O pufferekbe kerülnek, majd eljutnak a memóriavezérlőhöz.

Az adatátvitel nem egyetlen bitenként történik, hanem nagyobb egységekben, úgynevezett burst-ökben. Amikor egy sort aktiválnak, annak teljes tartalma beolvasódik egy sorpufferbe. Ebből a pufferből aztán gyorsan kiolvashatók az egymást követő adatok az oszlopcímek változtatásával. Ez a mechanizmus jelentősen gyorsítja a szekvenciális adathozzáférést, mivel a teljes sor aktiválása a legidőigényesebb lépés.

A memóriavezérlő felelős az összes fent említett művelet koordinálásáért. Ez a chip vagy a CPU-ba integrált egység küldi ki a megfelelő parancsokat (RAS – Row Address Strobe, CAS – Column Address Strobe, WE – Write Enable, CS – Chip Select) a DRAM chipeknek. A vezérlő dönti el, melyik bankot mikor kell aktiválni, melyik sort kell megnyitni, és mikor kell adatot olvasni vagy írni. A modern vezérlők rendkívül kifinomult algoritmusokat használnak a bankok és csatornák optimalizálására a maximális teljesítmény érdekében.

DRAM és memóriabankok: A dinamikus memória világa

A DRAM (Dynamic Random Access Memory) a legelterjedtebb memóriatípus a rendszermemóriában, főként költséghatékonysága és nagy kapacitása miatt. A „dinamikus” jelző arra utal, hogy a tárolt adatokat rendszeresen frissíteni kell a töltésvesztés elkerülése érdekében. A memóriabankok koncepciója már a korai DRAM-oknál is jelen volt, de a szinkron DRAM (SDRAM) megjelenésével vált igazán fontossá.

Az SDRAM (Synchronous DRAM) forradalmasította a memóriatechnológiát azáltal, hogy szinkronizálta a memória működését a rendszer órajelével. Ez lehetővé tette a pontosabb időzítést és a hatékonyabb adatátvitelt. Az SDRAM-ban a memóriabankok még szorosabban integrálódtak az órajel-vezérelt működésbe, lehetővé téve a parancsok előzetes kiadását és a pipeline-ozott végrehajtást.

A DDR generációk (Double Data Rate) továbbfejlesztették az SDRAM alapjait, lehetővé téve az adatátvitelt az órajel fel- és lefutó élén is, ezzel megduplázva az effektív sebességet. Minden új DDR generáció (DDR1, DDR2, DDR3, DDR4, DDR5) jelentős fejlesztéseket hozott a memóriabankok szervezésében és kezelésében:

- DDR1: Általában 2 vagy 4 bankot használt egy chipen belül, és 2 bites pre-fetch architektúrát alkalmazott. Ez azt jelentette, hogy egyetlen órajelciklus alatt két adatcsomagot tudott előre betölteni.

- DDR2: Növelte a bankok számát (gyakran 4 vagy 8 bank) és 4 bites pre-fetch architektúrára váltott. Ez kétszer annyi adat előtöltését tette lehetővé, mint a DDR1, tovább növelve a sávszélességet.

- DDR3: Általában 8 bankot tartalmazott, és 8 bites pre-fetch architektúrát vezetett be. Ez a jelentős ugrás tette lehetővé a mai modern rendszerek elképesztő sebességét, hiszen egyetlen adatkérésre akár 8 adatcsomagot is tudott előre betölteni.

- DDR4: Tovább optimalizálta a bankok kezelését, bevezetve a bankcsoportok (bank groups) koncepcióját. Ez azt jelenti, hogy a bankokat csoportokba rendezték, és a memóriavezérlő egyszerre több bankcsoporttal tudott párhuzamosan dolgozni. Ez a hierarchikus bankstruktúra tovább növelte a hatékonyságot és a sávszélességet. A DDR4 jellemzően 4 bankcsoportot (összesen 16 bankot) használ.

- DDR5: A legújabb generáció még tovább finomítja a bankstruktúrát, még több bankcsoportot (8 bankcsoport, azaz 32 bank) és egyidejűleg két független 32 bites alcsatornát (sub-channels) vezet be modulonként. Ez a hatalmas növekedés a párhuzamosságban és a bankok számában a DDR5 egyik fő előnye, ami rendkívül nagy sávszélességet biztosít.

A pre-fetch architektúra és a bankok szoros összefüggésben állnak. A pre-fetch mechanizmus lényege, hogy a memóriavezérlő nem csak a pontosan kért adatot olvassa ki, hanem az azt követő adatokat is, előre feltételezve, hogy azokra is szükség lesz. Minél nagyobb a pre-fetch mélysége, annál több adatot lehet egyszerre kinyerni egyetlen soraktiválásból, feltéve, hogy a bankok elegendő párhuzamosságot biztosítanak ehhez. A bankok száma és szervezése tehát közvetlenül befolyásolja, hogy mennyire hatékonyan tudja a pre-fetch mechanizmus kihasználni a memória sávszélességét.

A memóriabankok működése a gyakorlatban: Címzés és hozzáférés

A memóriabankok működésének megértéséhez elengedhetetlen a címzés és a hozzáférés pontos folyamatának ismerete. Amikor a CPU adatot kér, a memóriavezérlő egy összetett folyamatot indít el, amely több lépésből áll, és a memóriabankok intelligens kihasználására épül.

A folyamat azzal kezdődik, hogy a memóriavezérlő megkapja a logikai címet, amelyet aztán fizikai címmé alakít. Ez a fizikai cím tartalmazza a bankcím, a sorcím (Row Address) és az oszlopcím (Column Address) információkat. A vezérlő először kiválasztja azt a DRAM chipet és azon belül azt a bankot, amely a kért adatot tartalmazza.

Ezt követően a vezérlő kiadja a sorcím kiválasztó (RAS – Row Address Strobe) parancsot, és elküldi a sorcímet a kiválasztott banknak. Ez a lépés aktiválja a bankon belüli adott sort. Amikor egy sor aktiválódik, annak összes memóriacellájának töltését beolvassák egy ideiglenes tárolóba, az úgynevezett sorpufferbe. Ez a folyamat időbe telik, és a memória egyik legnagyobb késleltetési tényezője (tRCD – Row to Column Delay).

Amint a sor aktiválódott és a sorpuffer feltöltődött, a memóriavezérlő kiadja az oszlopcím kiválasztó (CAS – Column Address Strobe) parancsot, és elküldi az oszlopcímet. Ez az oszlopcím határozza meg, hogy a sorpufferből pontosan melyik adatot kell kiolvasni. Az adatok ezután az I/O pufferekbe kerülnek, és elindulnak a memóriavezérlő felé.

A modern DRAM-ok, különösen a DDR generációk, a burst mód-ot (sorozat) használják az adatátvitel felgyorsítására. Miután egy sort aktiváltak és az oszlopcímet megadták, nem csak egyetlen adatcsomagot olvasnak ki, hanem egy előre meghatározott számú (pl. 8) adatcsomagot, egymás után, rendkívül gyorsan. Ez a burst hossza (BL – Burst Length) határozza meg, hogy hány adatcsomagot olvas ki a memória egyetlen CAS parancsra. Ez a mechanizmus nagymértékben csökkenti az effektív hozzáférési időt, mivel a soraktiválás időigényes lépését csak egyszer kell végrehajtani a burst elején.

A frissítés (refresh) folyamata is szorosan kapcsolódik a memóriabankokhoz. Mivel a DRAM cellák kondenzátorai elveszítik töltésüket, rendszeres frissítésre van szükség. A memóriavezérlő periodikusan kiadja a frissítési parancsokat. Ezt a frissítést általában bankonként vagy soronként végzik, minimalizálva az adatátviteli műveletekkel való ütközést. A modern DRAM-ok képesek automatikus önfrissítésre (self-refresh), ami különösen hasznos alacsony fogyasztású üzemmódokban.

A memóriabankok intelligens címzése és a burst mód kombinációja teszi lehetővé, hogy a RAM hatalmas mennyiségű adatot tudjon gyorsan és hatékonyan kezelni.

Több memóriabank és a párhuzamosság: Interleaving és channel architektúra

A memóriabankok valódi ereje a párhuzamosságban rejlik. Annak érdekében, hogy a memóriarendszer a lehető leggyorsabban tudja kiszolgálni a CPU adatkéréseit, számos technológiát fejlesztettek ki, amelyek kihasználják a több bank adta lehetőségeket. Ezek közül a legfontosabbak a bank interleaving és a memóriacsatorna architektúra.

A bank interleaving (bankok közötti váltás) egy olyan technika, amely a memóriavezérlő számára lehetővé teszi, hogy felváltva hozzáférjen a különböző bankokhoz. Ahelyett, hogy egy bankban befejezne egy teljes műveletet (soraktiválás, adatok kiolvasása, sor bezárása), majd áttérne egy másik bankra, a vezérlő képes elindítani egy műveletet az egyik bankban, majd amíg az feldolgozódik, elindítani egy másikat egy másik bankban. Például, amíg az egyik bankban a sor aktiválódik (ami időigényes), addig a vezérlő kiadhatja az oszlopcímet egy másik bankban, amelynek sora már aktív. Ez a „fedés” jelentősen csökkenti az effektív késleltetést és növeli a sávszélességet, mivel a memória kevesebb ideig áll tétlenül.

A bank interleaving tipikusan a címbitek felosztásával valósul meg. A memóriavezérlő a cím egy részét a bank kiválasztására használja. Ha a cím alsó bitjei (legkevésbé jelentős bitek) határozzák meg a bankot, akkor az egymást követő memóriacímek automatikusan különböző bankokba kerülnek, maximalizálva az interleaving hatékonyságát. Ez különösen hasznos a szekvenciális adathozzáféréseknél, amelyek gyakoriak a programok és adatok betöltésekor.

A memóriacsatornák (memory channels) egy még magasabb szintű párhuzamosságot biztosítanak. A modern CPU-k beépített memóriavezérlői több független memóriacsatornát támogatnak (pl. single-channel, dual-channel, quad-channel, hexa-channel, octa-channel). Minden csatorna egy önálló adatútvonalat jelent a CPU és a memóriamodulok között, saját cím- és adatbuszokkal. Ez azt jelenti, hogy a CPU egyszerre több memóriamodullal is képes kommunikálni, mintha azok teljesen különálló memóriarendszerek lennének.

A memóriacsatornák és a memóriabankok kapcsolata szimbiotikus. Egy dual-channel rendszerben például a memóriavezérlő felváltva fér hozzá a két csatornán lévő memóriamodulokhoz. Míg az egyik csatorna egy bankjából olvas adatot, addig a másik csatorna egy bankjában már elindíthatja a következő műveletet. Ez a kétszintű párhuzamosság (bank interleaving a chipeken belül, channel interleaving a modulok között) drámaian növeli a teljes rendszer sávszélességét.

A ranks (rangok) és modulok (modules) fogalma is ide tartozik. Egy memóriamodul (DIMM vagy SO-DIMM) több DRAM chipet tartalmaz. Ezek a chipek együttesen alkotják a modul kapacitását és sávszélességét. Egy rank egy 64 bites (vagy 72 bites ECC esetén) adatszélességű logikai egység, amelyet egy vagy több chip biztosít. Egy memóriamodul tartalmazhat egy (single-rank) vagy több (dual-rank, quad-rank) ranket. A több rank lehetővé teszi a memóriavezérlő számára, hogy a rankok között is interleavinget alkalmazzon, tovább növelve a párhuzamosságot.

Például, egy dual-channel rendszerben, ahol minden csatornán egy dual-rank modul található, a memóriavezérlő akár négy különböző rankhez is hozzáférhet párhuzamosan. Ezen rankek mindegyike pedig több bankot tartalmaz, így a lehetséges párhuzamos műveletek száma rendkívül magas. Ez a komplex architektúra biztosítja a mai nagy teljesítményű rendszerek számára szükséges adatáteresztő képességet.

A memóriabankok hatása a rendszer teljesítményére

A memóriabankok szervezése és kezelése közvetlen és jelentős hatással van a számítógépes rendszer általános teljesítményére. A sávszélesség és a késleltetés két kulcsfontosságú mutató, amelyet a memóriabankok működése alapvetően befolyásol.

A sávszélesség azt méri, hogy mennyi adatot képes a memória egy adott időegység alatt átvinni (pl. GB/s). A memóriabankok, különösen a bank interleaving és a több memóriacsatorna révén, drámaian növelik a rendszer sávszélességét. Ha a memóriavezérlő egyszerre több bankból tud adatot kiolvasni vagy írni, vagy felváltva tudja kezelni a különböző bankokat, akkor az adatátviteli sebesség többszörösére nőhet. Ez különösen kritikus az olyan alkalmazásoknál, amelyek nagy adatmennyiséggel dolgoznak, mint például a videószerkesztés, a 3D renderelés, a tudományos szimulációk vagy a nagy adatbázisok.

A késleltetés (latency) az az idő, ami eltelik egy adatkérés kiadása és az adat rendelkezésre állása között. Bár a bankok közötti váltás nem csökkenti az egyetlen memóriacella aktiválásához szükséges időt, de jelentősen csökkenti a látszólagos vagy effektív késleltetést. Az interleaving révén a memóriavezérlő „elrejtheti” a késleltetés egy részét azáltal, hogy amíg az egyik bank egy műveletet végez, addig egy másik bankban már elindítja a következőt. Ezáltal a CPU kevesebbet várakozik adatokra, ami általánosságban gyorsabb rendszerműködést eredményez.

A memóriavezérlő és a bankok közötti interakció rendkívül komplex. A vezérlőnek folyamatosan optimalizálnia kell a parancsok sorrendjét, figyelembe véve a bankok aktuális állapotát (nyitott sor, zárt sor, frissítés alatt álló bank). A modern memóriavezérlők fejlett ütemező algoritmusokat használnak, amelyek előre látják a CPU adatkéréseit és ennek megfelelően priorizálják a bankok közötti műveleteket. Például, ha egy bankban már nyitva van a sor, és a CPU egy másik adatot kér ugyanabból a sorból, akkor a vezérlő azonnal kiadhatja a CAS parancsot, elkerülve a sor újraaktiválásának késleltetését.

A teljesítményoptimalizálás szempontjából a memóriabankok megfelelő kihasználása elengedhetetlen. Ez nem csak a hardveres kialakításon múlik, hanem a szoftveres optimalizáción is. Az operációs rendszerek és a programok igyekeznek úgy szervezni az adathozzáféréseket, hogy azok minél jobban kihasználják a bank interleaving és a burst mód előnyeit. Például, ha egy program egymást követő memóriacímeken tárolja a szükséges adatokat, akkor a memóriavezérlő egyetlen soraktiválással és egy hosszú burst-tel tudja azokat beolvasni, maximalizálva a hatékonyságot.

A nem megfelelő memória-konfiguráció, például ha csak egy memóriamodul van egy dual-channel alaplapon, jelentősen korlátozhatja a bankok és csatornák kihasználtságát, ami alacsonyabb sávszélességet és lassabb rendszert eredményezhet. Ezért fontos, hogy a rendszerépítés során figyelembe vegyék a memóriabankok és csatornák optimalizálásának szempontjait.

A memóriabankok intelligens kezelése és a párhuzamos hozzáférés biztosítása alapvető a modern számítógépek sávszélességének maximalizálásához és a késleltetés minimalizálásához.

Fejlettebb memóriatechnológiák és a memóriabankok evolúciója

A memóriatechnológia folyamatosan fejlődik, és ezzel együtt a memóriabankok koncepciója is adaptálódik és új formákat ölt. A hagyományos DDR DRAM mellett számos speciális memóriatípus is létezik, amelyek eltérő módon használják ki vagy építenek a bankok alapelvére.

A HBM (High Bandwidth Memory) egy forradalmi technológia, amelyet elsősorban grafikus kártyákban és nagy teljesítményű számítástechnikai (HPC) rendszerekben alkalmaznak. A HBM lényege a vertikális stackelés: több DRAM chipet egymásra helyeznek, és egy közös interposer-en keresztül kommunikálnak a GPU-val vagy CPU-val. Ebben az architektúrában a memóriabankok továbbra is alapvető építőkövek, de a szervezésük vertikális dimenziót kap. A HBM több független pseudo-csatornát (pseudo-channels) használ, amelyek mindegyike több bankot tartalmaz. Ez a kialakítás rendkívül széles adatbuszt és hatalmas sávszélességet biztosít, miközben csökkenti az energiafogyasztást és a fizikai méretet.

A GDDR (Graphics Double Data Rate) memória, amelyet szintén a grafikus kártyák használnak, a DDR RAM-hoz hasonlóan fejlődött (GDDR5, GDDR6, GDDR6X). A GDDR memóriák a DDR-től eltérően optimalizáltak a grafikus feladatok specifikus igényeire: rendkívül nagy sávszélességet biztosítanak, gyakran szélesebb adatbuszon keresztül (pl. 384 bit vagy 512 bit). Bár a GDDR is memóriabankokat használ, a hangsúly itt a maximális adatátviteli sebességen van, gyakran magasabb késleltetés árán, mint a rendszermemóriánál. A GDDR-ban is több bankcsoport és bank található a párhuzamosság növelése érdekében, de a vezérlési logika a grafikus adatáramlásra van optimalizálva.

Az LPDDR (Low Power Double Data Rate) memóriát elsősorban mobil eszközökben, laptopokban és beágyazott rendszerekben alkalmazzák, ahol az energiafogyasztás kritikus tényező. Az LPDDR generációk (LPDDR4, LPDDR5) is memóriabankokra épülnek, de számos energiatakarékos funkcióval rendelkeznek, mint például az alacsonyabb feszültség, az agresszívebb önfrissítési módok és az alacsony fogyasztású állapotok. Az LPDDR5 például két független 16 bites csatornát (összesen 32 bit) és 16 bankot tartalmaz modulonként, ami a teljesítmény és az energiahatékonyság optimalizált egyensúlyát biztosítja.

A Non-Volatile RAM (NVRAM), mint például az Intel Optane Persistent Memory (amely 3D XPoint technológián alapul), egy hibrid megoldás, amely a RAM sebességét a háttértár adatmegőrző képességével ötvözi. Bár az NVRAM nem DRAM alapú, és nem igényel folyamatos frissítést, a belső szervezése során hasonló, bank-szerű struktúrákat alkalmaz az adathozzáférés párhuzamosítására és a teljesítmény optimalizálására. A bankok fogalma itt is a fizikai tárolóegységek logikai felosztására utal, amelyek önállóan címezhetők és kezelhetők a vezérlő által.

Ezek a technológiák mind azt mutatják, hogy a memóriabankok alapkoncepciója – a memória felosztása kisebb, önállóan címezhető egységekre a párhuzamosság és a hatékonyság növelése érdekében – rendkívül rugalmas és alkalmazkodóképes. Bár a fizikai megvalósítás és a vezérlési logika eltérhet, az alapelv változatlan marad: a bankok kulcsfontosságúak a memória teljesítményének maximalizálásában, legyen szó akár asztali számítógépekről, grafikus munkaállomásokról, mobil eszközökről vagy szerverekről.

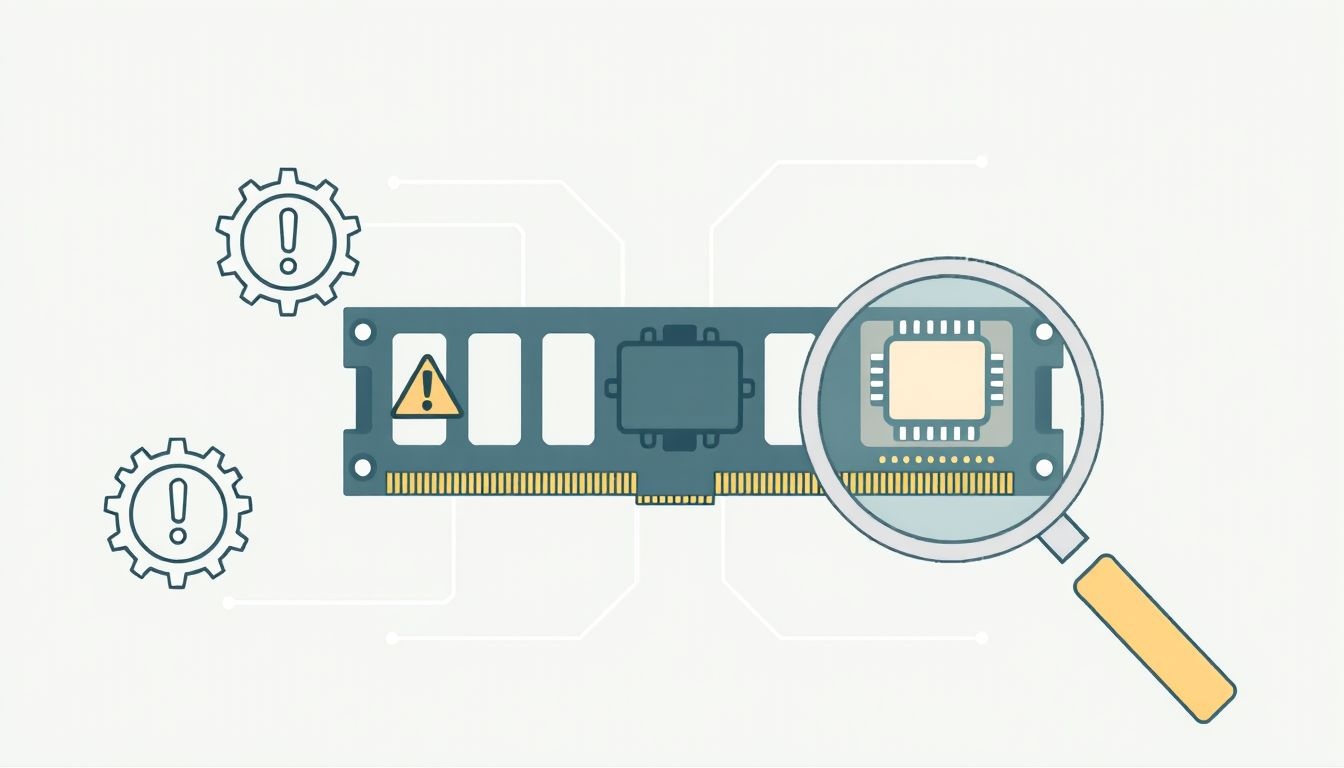

Gyakori problémák és hibaelhárítás a memóriabankokkal kapcsolatban

A memóriabankok, bár a modern RAM működésének alapkövei, időnként problémák forrásai is lehetnek. Ezek a problémák gyakran a rendszer instabilitásához, összeomlásokhoz vagy teljesítménycsökkenéshez vezethetnek. A hibaelhárítás során érdemes figyelembe venni a memóriabankok működésével kapcsolatos aspektusokat.

A memóriahibák a leggyakoribb problémák közé tartoznak. Ezek jelentkezhetnek „kék halál” (BSOD) formájában, alkalmazások összeomlásaként, adatkorrupcióként vagy véletlenszerű újraindulásként. A memóriahibák okai sokrétűek lehetnek:

- Fizikai sérülés: A RAM modulon lévő chipek vagy a nyomtatott áramkör (PCB) sérülése.

- Gyártási hibák: Hibás memóriacellák vagy hibás bankvezérlő logika a chipen belül.

- Túlfeszültség vagy alulfeszültség: Nem megfelelő tápellátás, ami instabil működéshez vezethet.

- Túlmelegedés: A DRAM chipek túlmelegedése, ami adathibákat okozhat.

- Időzítési problémák: A memória időzítési paramétereinek (CAS Latency, tRCD, tRP stb.) helytelen beállítása, különösen overclocking esetén.

- Kondenzátor töltésvesztés: Bár a frissítés ezt hivatott kiküszöbölni, extrém körülmények között vagy hibás működés esetén mégis előfordulhat.

A kompatibilitási kérdések szintén gyakoriak. Nem minden memóriamodul működik tökéletesen minden alaplappal és CPU-val, még akkor sem, ha az alapvető specifikációk megegyeznek. A memóriavezérlők és a DRAM chipek közötti finomhangolás rendkívül összetett, és a különböző gyártók eltérő bankstruktúrákat, chip-elrendezéseket és időzítéseket alkalmazhatnak. Ezért fontos, hogy az alaplap gyártója által javasolt memória listáját (QVL – Qualified Vendor List) ellenőrizzük, különösen több memóriamodul telepítésekor, vagy dual/quad-channel konfigurációk építésekor.

Az overclocking (túlhajtás) során a memória órajelét és/vagy időzítését a gyári specifikációk fölé emelik a nagyobb teljesítmény érdekében. Ez azonban jelentősen megnövelheti a memóriabankok terhelését és a hibák kockázatát. A túlzott órajel vagy túl agresszív időzítések instabilitáshoz, adathibákhoz és akár a modulok károsodásához is vezethetnek. Az overclocking során a memóriavezérlőnek nehezebb fenntartania a bankok közötti koordinációt és a megfelelő frissítési ciklusokat.

A hibaelhárítás során az alábbi lépések javasoltak:

- Memóriadiagnosztika futtatása: Az operációs rendszerek beépített memóriadiagnosztikai eszközökkel rendelkeznek (pl. Windows Memory Diagnostic), de léteznek külső, hatékonyabb programok is, mint például a MemTest86. Ezek képesek azonosítani a hibás memóriacellákat vagy bankokat.

- Modulok cseréje/átrakása: Ha több memóriamodul van a rendszerben, próbáljuk meg egyesével tesztelni őket, vagy cseréljük meg a slotjaikat. Néha egy hibás slot vagy egy rosszul behelyezett modul okozza a problémát.

- BIOS/UEFI beállítások ellenőrzése: Győződjünk meg róla, hogy a memória időzítések és feszültségek helyesen vannak beállítva. A gyári XMP (Extreme Memory Profile) profilok általában biztonságosak, de néha manuális beállításra van szükség.

- Hőmérséklet ellenőrzése: Győződjünk meg róla, hogy a memória modulok megfelelő hűtéssel rendelkeznek, különösen zárt házban vagy overclocking esetén.

- Tisztítás: A por vagy szennyeződés a RAM slotokban is okozhat kontakt hibákat.

A memóriabankok ismerete segíthet megérteni, hogy miért fontos a memória megfelelő konfigurálása és miért lehetnek problémák, ha a rendszer nem tudja hatékonyan kihasználni a bankok adta párhuzamosságot.

A memóriabankok jövője: Új technológiák és kihívások

A memóriabankok koncepciója, bár alapvető, folyamatosan fejlődik, hogy megfeleljen a modern számítástechnika egyre növekvő igényeinek. Az új technológiák és architektúrák célja a sávszélesség további növelése, a késleltetés csökkentése, az energiahatékonyság javítása, valamint a memória és a processzor közötti kommunikáció optimalizálása. A memóriabankok jövője szorosan összefügg az olyan innovációkkal, mint a CXL és a Persistent Memory.

A CXL (Compute Express Link) egy nyílt iparági szabvány, amely egy nagy sávszélességű, alacsony késleltetésű összeköttetést biztosít a CPU és a perifériák (beleértve a memóriát is) között. A CXL egyik legizgalmasabb alkalmazása a memória poolok (memory pooling) létrehozása. Ez azt jelenti, hogy a szerverekben lévő memória nem egy adott CPU-hoz van kötve, hanem egy közös erőforrásként, egy „memóriapool”-ként működik, amelyet több CPU is megoszthat. Ebben a felállásban a memóriabankok továbbra is a fizikai tárolás alapvető egységei maradnak, de a logikai kezelés és a hozzárendelés dinamikusabbá válik. A CXL lehetővé teszi, hogy a rendszerek igény szerint skálázzák a memóriát, és hatékonyabban használják ki a rendelkezésre álló erőforrásokat, minimalizálva a kihasználatlan memóriát.

A Persistent Memory (PMem), mint például az Intel Optane DC Persistent Memory, egy másik kulcsfontosságú fejlesztés. Ez a technológia egyesíti a DRAM sebességét a háttértár adatmegőrző képességével (non-volatility). A PMem modulok memóriabankokhoz hasonló belső struktúrákat használnak az adathozzáférés optimalizálására, de a hagyományos DRAM-tól eltérően képesek megőrizni az adatokat áramkimaradás esetén is. A PMem-et két módban lehet használni: „Memory Mode”-ban, ahol RAM-ként működik, vagy „App Direct Mode”-ban, ahol a programok közvetlenül címezhetik, mint egy rendkívül gyors háttértárat. A bankok itt is a párhuzamos hozzáférés és a nagy áteresztőképesség alapját képezik.

A mesterséges intelligencia (AI) és a Big Data rohamos fejlődése hatalmas kihívásokat támaszt a memóriarendszerekkel szemben. Az AI modellek képzése és futtatása, valamint a hatalmas adathalmazok elemzése rendkívül nagy sávszélességet és alacsony késleltetést igényel. Ezen igények kielégítésére a memóriabankok száma, mérete és szervezése tovább fog fejlődni. A HBM technológia, a DDR5 és a jövőbeli DDR generációk, valamint az olyan fejlesztések, mint a CXL, mind a memóriarendszerek optimalizálását célozzák, hogy hatékonyabban tudják kiszolgálni ezeket az erőforrásigényes feladatokat.

A jövőbeni memóriák valószínűleg még nagyobb integrációt mutatnak majd a processzorokkal, és még kifinomultabb bankkezelési mechanizmusokat alkalmaznak. Elképzelhető, hogy a memóriabankok dinamikusabban konfigurálhatók lesznek, vagy akár intelligens vezérlőlogikát is tartalmaznak majd a chipen belül, hogy még jobban optimalizálják az adathozzáférést. A cél továbbra is az, hogy a CPU-t a lehető leggyorsabban és leghatékonyabban lássák el adatokkal, minimalizálva a várakozási időt és maximalizálva a számítási teljesítményt. A memóriabankok tehát a számítástechnika fejlődésének továbbra is alapvető és kulcsfontosságú elemei maradnak.