A digitális korszakban a vállalkozások soha nem látott mennyiségű adatot generálnak és halmoznak fel. Ez a big data jelenség hatalmas lehetőségeket rejt, de egyúttal komoly kihívásokat is támaszt az adatok tárolása, feldolgozása és elemzése terén. Hagyományosan az Apache Hadoop ökoszisztéma jelentette az egyik legrobosztusabb megoldást ezen kihívások kezelésére, lehetővé téve a petabájtos nagyságrendű adatok elosztott feldolgozását. Azonban a helyben telepített (on-premise) Hadoop klaszterek üzemeltetése jelentős beruházást, szakértelmet és folyamatos karbantartást igényel. Itt lép színre a Hadoop mint szolgáltatás (HaaS), amely a felhő erejét kihasználva demokratizálja a big data analitikát, elérhetővé téve azt a kisebb és közepes vállalkozások számára is, miközben a nagyvállalatok számára is optimalizált, rugalmas megoldást kínál.

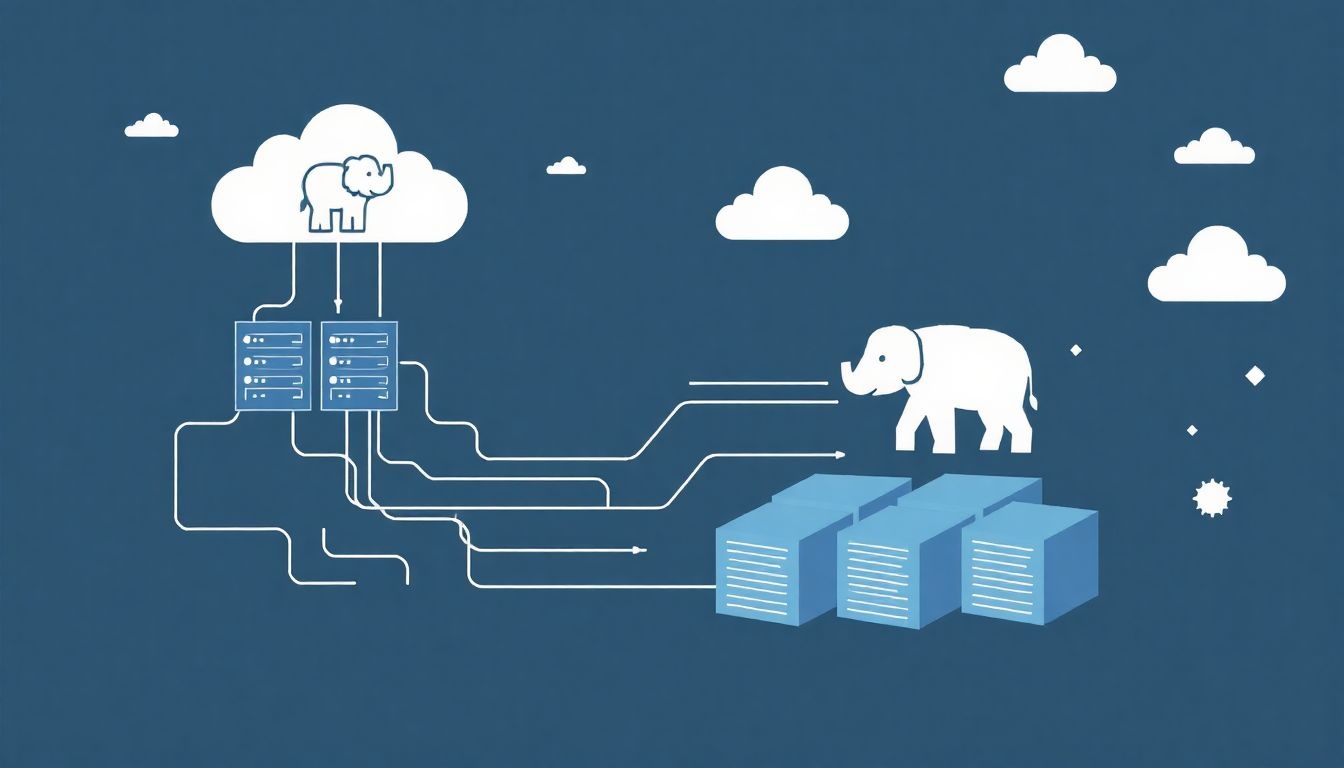

A HaaS alapvetően azt jelenti, hogy a Hadoop ökoszisztéma komponensei – mint például a HDFS (Hadoop Distributed File System), YARN (Yet Another Resource Negotiator), MapReduce, Hive, Pig, Spark, HBase és sok más – felhőalapú szolgáltatásként érhetők el. A felhasználóknak nem kell aggódniuk a hardver beszerzése, a szoftverek telepítése, konfigurálása vagy a klaszterek skálázása miatt. Ezeket a feladatokat a felhőszolgáltató végzi, lehetővé téve a vállalkozások számára, hogy teljes mértékben az adatelemzésre és az üzleti érték kinyerésére koncentráljanak. Ez a modell jelentősen csökkenti a belépési küszöböt, felgyorsítja a projektek indítását és optimalizálja az üzemeltetési költségeket.

A Hadoop ökoszisztéma alapjai és evolúciója

Mielőtt mélyebben belemerülnénk a HaaS előnyeibe és működésébe, elengedhetetlen megérteni az alapját képező Hadoop ökoszisztémát. A Hadoop egy nyílt forráskódú keretrendszer, amelyet nagyméretű adathalmazok elosztott tárolására és feldolgozására terveztek, számítógépfürtökön keresztül. A kezdetekben két fő komponensre épült: a HDFS-re a tárolásra és a MapReduce-ra a feldolgozásra. A HDFS biztosítja az adatok megbízható és elosztott tárolását, replikációval a hibatűrés érdekében, míg a MapReduce egy programozási modell a párhuzamos feldolgozásra.

Az évek során a Hadoop ökoszisztéma jelentősen bővült, számos kiegészítő eszközzel és technológiával. A YARN (Yet Another Resource Negotiator) bevezetése forradalmasította a Hadoop erőforrás-kezelését, lehetővé téve különböző alkalmazások, például a Spark, a Hive vagy az Impala futtatását ugyanazon a klaszteren, dinamikus erőforrás-allokációval. Ez a flexibilitás tette lehetővé, hogy a Hadoop ne csak a kötegelt (batch) feldolgozás, hanem más big data feladatok, például interaktív lekérdezések, valós idejű analitika és gépi tanulás alapjává is váljon.

A kulcsfontosságú kiegészítők közé tartozik az Apache Spark, amely sok esetben felváltotta vagy kiegészítette a MapReduce-t a gyorsabb adatfeldolgozás érdekében, különösen az in-memory számítások terén. Az Apache Hive lehetővé teszi a strukturált adatok lekérdezését SQL-szerű nyelven (HiveQL) a HDFS-en tárolt adatok felett. Az Apache HBase egy elosztott, nem relációs (NoSQL) adatbázis, amely valós idejű olvasási és írási műveleteket tesz lehetővé nagy adathalmazokon. Az Apache Kafka egy elosztott streaming platform valós idejű adatfolyamok kezelésére, míg az Apache Zookeeper elosztott koordinációs szolgáltatásokat nyújt a klaszterek számára. Ezek a komponensek együttesen alkotják azt a sokoldalú eszköztárat, amelyet a HaaS szolgáltatók kínálnak a felhasználóknak.

A Hadoop ökoszisztéma folyamatos fejlődése és az új komponensek integrációja biztosítja, hogy a HaaS ne csak egy egyszerű „lift-and-shift” megoldás legyen, hanem egy modern, adaptív platform a legkomplexebb adatigények kielégítésére is.

Miért éppen HaaS? A felhő alapú big data analitika előnyei

A Hadoop mint szolgáltatás modell számos meggyőző érvvel szolgál a hagyományos, helyben telepített rendszerekkel szemben. Ezek az előnyök nem csupán költségmegtakarításban nyilvánulnak meg, hanem a működési hatékonyság, a rugalmasság és az innováció terén is jelentős javulást hoznak.

Skálázhatóság és rugalmasság

A skálázhatóság az egyik legnagyobb vonzereje a HaaS-nak. A felhőinfrastruktúra alapvetően rugalmas, ami azt jelenti, hogy a felhasználók pillanatok alatt hozzáadhatnak vagy eltávolíthatnak számítási és tárolási erőforrásokat. Egy on-premise klaszter esetében az erőforrások bővítése hosszú beszerzési, telepítési és konfigurációs folyamatot igényel. Ezzel szemben a HaaS-ban az erőforrásokat igény szerint lehet méretezni, legyen szó hirtelen megnövekedett adatmennyiségről vagy egy rövid távú, intenzív analitikai feladatról. Ez a rugalmas skálázódás lehetővé teszi a költségek optimalizálását is, mivel csak a ténylegesen felhasznált erőforrásokért kell fizetni.

Költséghatékonyság

A HaaS modell jelentős költségmegtakarítást eredményezhet. Először is, nincs szükség kezdeti tőkebefektetésre (CAPEX) hardverek, szoftverlicencek és adatközponti infrastruktúra megvásárlására. Ehelyett a modell az operatív költségekre (OPEX) helyezi a hangsúlyt, ahol a felhasználók csak a tényleges használatért fizetnek (pay-as-you-go). Másodszor, a karbantartás, frissítések és hibaelhárítás terhe a szolgáltatóra hárul, ami csökkenti a belső IT-csapatra nehezedő terhet és a kapcsolódó munkaerő költségeit. Harmadszor, a dinamikus skálázhatóság révén elkerülhető a túlzott erőforrás-allokáció, ami szintén pénzügyi előnyökkel jár.

Gyorsabb bevezetés és egyszerűbb üzemeltetés

Egy on-premise Hadoop klaszter telepítése és konfigurálása heteket vagy akár hónapokat is igénybe vehet, szakértelmet és gondos tervezést igényelve. A HaaS esetében a klaszterek percek alatt üzembe helyezhetők, mivel a szolgáltató előre konfigurált, optimalizált környezeteket kínál. Ez a gyorsabb bevezetés felgyorsítja az adatelemzési projektek indítását és a piaci reakcióképességet. Az egyszerűbb üzemeltetés azt jelenti, hogy a felhasználóknak nem kell aggódniuk a klaszterek felügyelete, a szoftveres patch-ek telepítése, a biztonsági frissítések vagy a hardverhibák miatt. A szolgáltató gondoskodik a teljes infrastruktúráról, lehetővé téve a felhasználók számára, hogy kizárólag az adatokra és az üzleti logikára koncentráljanak.

Fókusz az üzleti értékre

A HaaS felszabadítja a szervezeteket a big data infrastruktúra menedzselésének terhe alól. Ezáltal az adatszakértők, adatmérnökök és üzleti elemzők sokkal több időt fordíthatnak az adatok elemzésére, új modellek fejlesztésére, és az üzleti érték kinyerésére. Ahelyett, hogy rendszergazdai feladatokkal foglalkoznának, mélyebb betekintést nyerhetnek az adatokból, ami innovatív termékekhez, szolgáltatásokhoz és hatékonyabb döntéshozatalhoz vezethet.

Beépített biztonság és megbízhatóság

A vezető felhőszolgáltatók hatalmas erőforrásokat fektetnek a biztonságba és a megbízhatóságba. A HaaS platformok általában beépített biztonsági funkciókat kínálnak, mint például az adatok titkosítása nyugalmi és mozgás közben, szigorú hozzáférés-szabályozás, hálózati elkülönítés és folyamatos biztonsági auditok. A magas rendelkezésre állás (HA) és a hibatűrés szintén alapvető jellemzők, gyakran több rendelkezésre állási zónán keresztül biztosítva az üzletmenet folytonosságát még regionális katasztrófák esetén is.

A HaaS működése: Technológiai mélységek

A HaaS a felhőalapú infrastruktúrára épül, kihasználva a virtualizációt, a konténerizációt és az automatizálást. Bár a felhasználó számára ez egy egyszerűen kezelhető szolgáltatásnak tűnik, a háttérben komplex technológiai rétegek dolgoznak a klaszterek hatékony működéséért.

Az infrastruktúra réteg

A HaaS alapját a felhőszolgáltató globális infrastruktúrája képezi, amely szerverparkokból, hálózati eszközökből és tárolórendszerekből áll. Ezek az erőforrások virtualizált formában állnak rendelkezésre, lehetővé téve a klaszterek dinamikus létrehozását és skálázását. A legtöbb HaaS megoldás virtuális gépeken futtatja a Hadoop komponenseket, de egyre inkább teret nyer a konténerizáció (pl. Docker, Kubernetes) is, ami még nagyobb rugalmasságot és erőforrás-kihasználtságot biztosít.

A Hadoop komponensek menedzselése

A HaaS lényege a menedzselt szolgáltatás. Ez azt jelenti, hogy a szolgáltató felelős a Hadoop ökoszisztéma összes komponensének telepítéséért, konfigurálásáért, felügyeletéért és karbantartásáért. Ide tartozik a szoftverek frissítése, a biztonsági javítások telepítése, a klaszterek állapotának monitorozása, a hibaelhárítás és a teljesítményoptimalizálás. A felhasználók általában egy webes konzolon vagy API-n keresztül kezelhetik a klasztereiket, elindíthatnak és leállíthatnak feladatokat, módosíthatják az erőforrás-allokációt, de a mélyebb technikai menedzsment a szolgáltató feladata.

Adatkezelés és integráció

Az adatok kezelése kulcsfontosságú a HaaS-ban. A legtöbb szolgáltató integrálja a Hadoop klasztereket a felhő saját tárolási szolgáltatásaival, mint például az Amazon S3, az Azure Data Lake Storage vagy a Google Cloud Storage. Ez lehetővé teszi az adatok tárolását a Hadoop klaszteren kívül, ami növeli a rugalmasságot, csökkenti a tárolási költségeket és lehetővé teszi a számítási és tárolási erőforrások független skálázását. Az adatok betöltésére és kinyerésére szolgáló eszközök (pl. Apache Sqoop, Apache Flume) is rendelkezésre állnak, valamint integrációk más felhőalapú adatbázisokkal és analitikai eszközökkel.

Felhasználói interfészek és API-k

A HaaS platformok általában gazdag felhasználói felületet (UI) és robusztus API-kat (Application Programming Interface) kínálnak. A webes UI lehetővé teszi a klaszterek vizuális menedzselését, a feladatok indítását és monitorozását, valamint a metrikák megtekintését. Az API-k révén a felhasználók programozottan is interakcióba léphetnek a szolgáltatással, ami lehetővé teszi a folyamatok automatizálását, az adatintegrációt és a CI/CD (Continuous Integration/Continuous Deployment) pipeline-okba való beépítést.

Főbb HaaS szolgáltatók és ajánlataik

A big data és a felhő térnyerésével számos nagy felhőszolgáltató kínál HaaS megoldásokat. A három legnagyobb szereplő az Amazon Web Services (AWS), a Microsoft Azure és a Google Cloud Platform (GCP).

Amazon Web Services (AWS) EMR

Az AWS EMR (Elastic MapReduce) az egyik legkorábbi és legátfogóbb HaaS szolgáltatás. Lehetővé teszi a felhasználók számára, hogy könnyedén indítsanak és skálázzanak Hadoop, Spark, Hive, Presto és egyéb big data keretrendszereket futtató klasztereket. Az EMR szorosan integrálódik az AWS ökoszisztémával, különösen az Amazon S3-mal az adatok tárolására, az AWS Glue-val az ETL (Extract, Transform, Load) feladatokhoz, és az Amazon Redshift-tel az adattárház (data warehouse) megoldásokhoz. Az EMR rugalmasságot kínál a klaszterek típusának és méretének kiválasztásában, valamint a spot instance-ok használatával költségoptimalizálási lehetőségeket is biztosít.

Microsoft Azure HDInsight

A Microsoft Azure HDInsight egy másik vezető HaaS szolgáltatás, amely Apache Hadoop, Spark, Hive, LLAP, Kafka, Storm és R Server klasztereket kínál a felhőben. A HDInsight mélyen integrálódik az Azure szolgáltatásokkal, mint például az Azure Data Lake Storage (ADLS) az adatok tárolására, az Azure Synapse Analytics az adattárház és analitikai feladatokhoz, valamint az Azure Data Factory az adatmozgatáshoz és transzformációhoz. A HDInsight különösen vonzó lehet azoknak a vállalkozásoknak, amelyek már Microsoft technológiákat használnak, mivel zökkenőmentes integrációt biztosít az Azure Active Directoryval és más Microsoft termékekkel.

Google Cloud Dataproc

A Google Cloud Dataproc a Google Cloud Platform HaaS ajánlata. Gyors, költséghatékony és könnyen kezelhető módot biztosít Apache Spark, Hadoop, Flink, Presto és más big data eszközök futtatására. A Dataproc kiemelkedik a gyors klaszterindítási idejével (gyakran 90 másodperc alatt), és a szoros integrációval a Google Cloud Storage (GCS)-szel, ami lehetővé teszi a számítási és tárolási erőforrások teljes szétválasztását és független skálázását. Emellett integrálódik a BigQuery-vel (Google szerver nélküli adattárháza) és a Cloud Dataflow-val (streaming és batch feldolgozás). A Google erős AI/ML képességei is előnyt jelentenek a Dataproc felhasználók számára.

Minden szolgáltató sajátos előnyökkel és funkciókkal rendelkezik, így a választás gyakran függ a meglévő infrastruktúrától, a költségvetéstől, a szükséges integrációktól és a specifikus teljesítményigényektől.

Gyakori felhasználási esetek a HaaS-ban

A HaaS széles körben alkalmazható különböző iparágakban és feladatkörökben, ahol nagy mennyiségű adat feldolgozása és elemzése szükséges. Néhány kiemelt felhasználási eset:

Log analitika és monitorozás

A webes alkalmazások, szerverek és hálózati eszközök hatalmas mennyiségű log adatot generálnak. A HaaS klaszterek ideálisak ezen logok gyűjtésére, tárolására és elemzésére. A MapReduce vagy Spark segítségével a vállalatok valós időben vagy közel valós időben dolgozhatják fel a logokat, azonosíthatnak anomáliákat, biztonsági fenyegetéseket, teljesítményproblémákat és felhasználói viselkedési mintázatokat. Ez elengedhetetlen a rendszer stabilitásának fenntartásához és a proaktív hibaelhárításhoz.

Adattárház és adat tó (Data Lake)

A HaaS platformok tökéletes alapot biztosítanak egy modern adat tó (data lake) építéséhez, ahol strukturált, félig strukturált és strukturálatlan adatok tárolhatók nyers formában. A Hadoop és Spark komponensekkel ezek az adatok feldolgozhatók, tisztíthatók és transformálhatók, majd betölthetők egy adattárházba (pl. felhőalapú adattárház szolgáltatásokba, mint a Redshift, Synapse vagy BigQuery) további elemzés céljából. Ez a megközelítés lehetővé teszi a vállalatok számára, hogy a hagyományos adattárházakon túlmutató, mélyebb betekintést nyerjenek az adataikból.

Gépi tanulás és mesterséges intelligencia (AI/ML)

A big data és a gépi tanulás kéz a kézben jár. A gépi tanulási modellek betanításához és futtatásához hatalmas mennyiségű adatra van szükség, amit a HaaS klaszterek hatékonyan tudnak kezelni. A Spark MLLib (Machine Learning Library) és a Python alapú gépi tanulási keretrendszerek (pl. TensorFlow, PyTorch) integrációja lehetővé teszi a prediktív analitika, a klaszterezés, a klasszifikáció és más fejlett gépi tanulási feladatok végrehajtását. Például, egy HaaS klaszterrel lehet fejleszteni ajánlórendszereket, csalásdetektáló algoritmusokat vagy ügyfél szegmentációs modelleket.

Valós idejű analitika és adatfolyam-feldolgozás

Bár a Hadoop hagyományosan kötegelt feldolgozásra készült, a Spark Streaming és az Apache Kafka bevezetése lehetővé tette a valós idejű analitikát és az adatfolyam-feldolgozást. A HaaS platformok képesek kezelni a folyamatosan érkező adatfolyamokat (pl. IoT eszközökről, kattintási adatokból, közösségi média feedekből), és azonnali betekintést nyújtani. Ez kritikus fontosságú olyan alkalmazásokban, mint a csalásfelismerés, a személyre szabott marketing, a hálózati forgalom monitorozása vagy az ipari szenzoradatok elemzése.

Kockázatkezelés és csalásfelismerés

A pénzügyi szektorban a HaaS segíthet a nagy adathalmazok elemzésében a kockázatok felméréséhez és a csalárd tevékenységek azonosításához. A tranzakciós adatok, ügyféladatok és külső forrásokból származó információk kombinálásával a HaaS klaszterek képesek komplex mintázatokat felismerni, amelyek csalásra utalhatnak, vagy segíthetnek a hitelképesség pontosabb felmérésében.

Kihívások és megfontolások a HaaS bevezetésénél

Bár a HaaS számos előnnyel jár, fontos tudatában lenni a lehetséges kihívásoknak és megfontolásoknak, mielőtt egy szervezet elkötelezi magát e modell mellett.

Adatbiztonság és megfelelőség

Az adatok felhőbe való áthelyezése mindig felvet adatbiztonsági és megfelelőségi (compliance) aggályokat. Bár a felhőszolgáltatók rendkívül magas szintű biztonsági intézkedéseket alkalmaznak, a felelősség megosztott modellje (Shared Responsibility Model) értelmében a felhasználó is felelős az adatok biztonságáért a saját szintjén (pl. hozzáférés-szabályozás, titkosítási kulcsok kezelése). Különös figyelmet kell fordítani a jogszabályi megfelelőségre (pl. GDPR, HIPAA), és gondosan meg kell vizsgálni a szolgáltató által nyújtott tanúsítványokat és audit jelentéseket.

Adatátviteli költségek (Data Egress Costs)

A felhőben az adatok befelé irányuló áramlása (ingress) általában ingyenes, de az adatok kifelé irányuló áramlása (egress) a felhőből jelentős költségekkel járhat. Ha egy szervezetnek gyakran kell nagy mennyiségű adatot kihoznia a HaaS klaszterből más rendszerekbe vagy on-premise környezetbe, ezek az adatátviteli költségek gyorsan összeadódhatnak. Fontos a költségek előzetes felmérése és az adatmozgatási stratégiák optimalizálása.

Vendor Lock-in

Bár a Hadoop nyílt forráskódú, egy adott HaaS szolgáltatóhoz való kötődés (vendor lock-in) kockázata fennáll. Az egyes szolgáltatók egyedi integrációkat, menedzsment eszközöket és optimalizációkat kínálnak, amelyek megnehezíthetik a későbbi migrációt egy másik felhőszolgáltatóhoz vagy egy on-premise környezetbe. Ezért fontos a hosszú távú stratégia mérlegelése és a hordozható architektúrák tervezése, amennyire lehetséges.

Teljesítményoptimalizálás és tuning

Bár a HaaS leegyszerűsíti az üzemeltetést, a teljesítményoptimalizálás továbbra is kihívás lehet. A Hadoop és Spark feladatok megfelelő konfigurálása, az erőforrás-allokáció finomhangolása és az adatok elrendezésének optimalizálása továbbra is szakértelmet igényelhet a legjobb teljesítmény eléréséhez és a költségek kordában tartásához. A szolgáltatók általában kínálnak monitorozó és tuning eszközöket, de a felhasználónak értenie kell az alapul szolgáló technológiák működését a hatékony kihasználáshoz.

Integráció a meglévő rendszerekkel

Egy szervezetnek gyakran már meglévő adatbázisai, alkalmazásai és üzleti folyamatai vannak. A HaaS klaszterek integrációja ezekkel a rendszerekkel komplex feladat lehet, különösen, ha hibrid felhő környezetről van szó. Megfelelő adatcsatlakozókra, ETL folyamatokra és API integrációkra van szükség a zökkenőmentes adatmozgatás és együttműködés biztosításához.

Költségmenedzsment és optimalizálás HaaS környezetben

A HaaS modell egyik fő vonzereje a költséghatékonyság, de ennek eléréséhez aktív költségmenedzsmentre van szükség. A „pay-as-you-go” modell lehetőséget ad a spórolásra, de gondatlan használat esetén a kiadások gyorsan elszállhatnak.

Megfelelő erőforrás-méretezés

A felhő rugalmassága lehetővé teszi a klaszterek dinamikus méretezését. Használja ki ezt a lehetőséget! Ne futtasson feleslegesen nagy klasztereket, ha éppen nincsenek nagy terhelésű feladatok. Alkalmazza a skálázódási stratégiákat: indítson kisebb klasztereket a napi feladatokhoz, és skálázza fel őket csak a csúcsterhelés idejére. Sok HaaS szolgáltató kínál automatikus skálázási funkciókat, amelyek automatikusan hozzáadnak vagy eltávolítanak node-okat a terhelés függvényében. Ez jelentősen optimalizálja a költségeket.

Klaszterek leállítása, ha nincsenek használatban

A felhőben a számítási erőforrásokért akkor is fizetni kell, ha tétlenül állnak. Ha egy klaszterre nincs szükség folyamatosan (pl. csak napi vagy heti kötegelt feladatokat futtat), állítsa le, amikor nem használja. Sok szolgáltató kínál lehetőséget a klaszterek automatikus leállítására egy bizonyos inaktivitási idő után. Ez az egyik leggyorsabb módja a költségmegtakarításnak.

Spot instance-ok és foglalások

Az AWS EMR és más szolgáltatók kínálnak spot instance-okat, amelyek jelentősen olcsóbbak a normál igény szerinti instance-oknál, cserébe azért, hogy a felhőszolgáltató bármikor visszaveheti őket, ha más ügyfélnek van rá szüksége. Jól alkalmazhatók hibatűrő, megszakítható feladatokhoz. Hosszú távú, stabil terhelés esetén érdemes megfontolni a foglalásokat (reserved instances), amelyek kedvezményes áron biztosítanak erőforrásokat egy előre meghatározott időszakra (pl. 1 vagy 3 évre).

Adattárolási költségek optimalizálása

Bár a tárolás általában olcsóbb, mint a számítás, nagy adatmennyiségek esetén jelentős tételt jelenthet. Használja ki a felhőalapú tárolási szolgáltatások különböző osztályait (pl. standard, infrequent access, archiválás) az adatok hozzáférési mintázatai alapján. A ritkán hozzáférhető adatok áthelyezése olcsóbb tárolási osztályokba jelentős megtakarítást eredményezhet. Fontos az adatok életciklus-kezelésének beállítása is.

Monitorozás és költségriportok

Rendszeresen ellenőrizze a felhőszolgáltató által biztosított költségriportokat és monitorozó eszközöket. Ezek a riportok részletes betekintést nyújtanak abba, hogy melyik szolgáltatás mennyibe kerül, és segítenek azonosítani a túlköltekezés területeit. Állítson be költségriportokat és riasztásokat, hogy azonnal értesüljön, ha a kiadások túllépnek egy bizonyos küszöböt.

A HaaS és a DataOps: Gyorsabb adatinnováció

A DataOps egy módszertan, amely az agilis fejlesztési elveket, a DevOps gyakorlatokat és a statisztikai folyamatszabályozást ötvözi az adatelemzési folyamatok felgyorsítása és minőségének javítása érdekében. A HaaS platformok kiválóan támogatják a DataOps bevezetését egy szervezetben.

A HaaS által nyújtott gyors klaszterindítás és dinamikus skálázhatóság tökéletesen illeszkedik a DataOps azon elvéhez, hogy gyorsan lehessen kísérletezni és iterálni az adatokkal. Az adatszakértők pillanatok alatt indíthatnak egy klasztert egy új modell teszteléséhez, majd leállíthatják, ha végeztek. Ez minimalizálja a várakozási időt és ösztönzi az innovációt.

A HaaS platformok API-jai és az automatizálási lehetőségek lehetővé teszik a CI/CD pipeline-ok kiépítését az adatelemzési és gépi tanulási munkafolyamatokhoz. Az adatintegráció, adattranszformáció, modellbetanítás és -telepítés automatizálható, csökkentve az emberi hibákat és felgyorsítva a termékre jutás idejét (time-to-market). A verziókövetés és a kollaboráció is könnyebbé válik a megosztott, felhőalapú környezetben.

A beépített monitorozási és logolási képességek, valamint a felhőszolgáltatók által biztosított analitikai eszközök támogatják a DataOps egyik kulcsfontosságú elemét: a folyamatos megfigyelést és visszacsatolást. Az adatelemzők és adatmérnökök valós időben láthatják a klaszterek teljesítményét, az adatfolyamok állapotát és a modellek pontosságát, lehetővé téve a gyors beavatkozást és a folyamatos optimalizálást.

Összességében a HaaS nem csupán egy technológiai megoldás, hanem egy olyan paradigma shift, amely alapjaiban változtatja meg a vállalatok big data-hoz való hozzáállását. Lehetővé teszi a fókusz áthelyezését az infrastruktúra menedzsmentjéről az adatokból származó üzleti érték kinyerésére, felgyorsítva az adatinnovációt és növelve a versenyképességet.

A HaaS jövője: Trendek és kilátások

A HaaS és a felhőalapú big data analitika folyamatosan fejlődik, és számos izgalmas trend körvonalazódik a jövőre nézve.

Szerver nélküli (Serverless) big data

Az egyik legjelentősebb trend a szerver nélküli big data. Bár a HaaS már most is absztrakciót biztosít a mögöttes infrastruktúráról, a szerver nélküli modellek még tovább viszik ezt. A felhasználóknak egyáltalán nem kell a szerverekről, klaszterekről vagy erőforrás-allokációról gondolkodniuk. Egyszerűen feltöltik az adataikat és elindítják a lekérdezéseket vagy a feldolgozási feladatokat, és a felhőszolgáltató automatikusan skálázza és menedzseli az összes mögöttes erőforrást. Példák erre a Google BigQuery, az AWS Athena vagy az Azure Synapse Analytics Spark pooljai. Ez még nagyobb egyszerűséget és költséghatékonyságot ígér, különösen az időszakos vagy változó terhelésű feladatoknál.

Adat tóház (Data Lakehouse) architektúra

A data lakehouse egy új architektúra, amely egyesíti az adat tavak (rugalmasság, nyers adatok tárolása) és az adattárházak (strukturált adatok, teljesítmény, ACID tranzakciók) legjobb tulajdonságait. A HaaS platformok egyre inkább támogatni fogják ezt a hibrid megközelítést, lehetővé téve a felhasználók számára, hogy mind a strukturált, mind a strukturálatlan adatok felett komplex analitikát végezzenek egyetlen, egységes platformon. Az olyan technológiák, mint a Delta Lake, a Apache Iceberg és a Apache Hudi kulcsszerepet játszanak ebben a fejlődésben.

Mesterséges intelligencia és gépi tanulás mélyebb integrációja

A jövőben a HaaS platformok még szorosabban integrálják a mesterséges intelligencia és gépi tanulás képességeit. Ez nem csak a gépi tanulási keretrendszerek (pl. TensorFlow, PyTorch) támogatását jelenti, hanem beépített AutoML (Automated Machine Learning) funkciókat, előre betanított modelleket és egyszerűsített ML MLOps munkafolyamatokat is. Az adatszakértők kevesebb időt fognak tölteni az infrastruktúra beállításával és többet a modellek fejlesztésével és finomhangolásával.

Fokozott biztonság és adatirányítás (Data Governance)

Ahogy egyre több kritikus adat kerül a felhőbe, az adatbiztonság és az adatirányítás (data governance) még fontosabbá válik. A HaaS szolgáltatók folyamatosan fejleszteni fogják a titkosítási, hozzáférés-szabályozási és auditálási képességeiket. Emellett az adatirányítási eszközök, mint az adat katalogizálás, adatminőség-ellenőrzés és adatvonal (data lineage) nyomon követése, is beépülnek a platformokba, segítve a szervezeteket a megfelelőség és az adatok megbízhatóságának biztosításában.

Hibrid és multi-cloud stratégiák

Sok nagyvállalat alkalmaz hibrid felhő (on-premise és felhő kombinációja) vagy multi-cloud (több felhőszolgáltató használata) stratégiát. A HaaS szolgáltatók egyre inkább támogatni fogják ezeket a komplex környezeteket, egységes menedzsment eszközöket és adatátviteli megoldásokat kínálva a különböző platformok között. Ez növeli a rugalmasságot és csökkenti a vendor lock-in kockázatát.

A Hadoop mint szolgáltatás nem csupán egy technológiai trend, hanem egy alapvető paradigmaváltás a big data analitika területén. Lehetővé teszi a szervezetek számára, hogy a hatalmas adatmennyiségekből kinyerjék a szükséges betekintéseket anélkül, hogy az infrastruktúra komplexitásával kellene küzdeniük. Ahogy a felhőtechnológiák és a big data eszközök tovább fejlődnek, a HaaS még inkább a modern adatközpontú stratégia sarokkövévé válik, felgyorsítva az innovációt és segítve a vállalatokat abban, hogy a digitális gazdaságban versenyképesek maradjanak.