Az ETL (Extract, Transform, Load) egy kulcsfontosságú folyamat a modern adatkezelésben, melynek célja az adatok különböző forrásokból történő kinyerése, átalakítása és betöltése egy céladatbázisba vagy adattárházba. Ez a folyamat lehetővé teszi, hogy a szervezetek hatékonyabban használják fel adataikat üzleti intelligencia (BI), elemzések és jelentéskészítés céljaira.

A kinyerés (Extract) fázisban az adatok különböző forrásokból kerülnek összegyűjtésre. Ezek a források lehetnek relációs adatbázisok, fájlok (CSV, XML, JSON), felhőalapú rendszerek vagy akár külső API-k. A kinyerés során az adatok validálása is megtörténhet, hogy a további lépésekhez csak a releváns és helyes adatok kerüljenek.

Az átalakítás (Transform) fázisban az adatok megtisztítása, formázása és integrálása történik. Ez magában foglalhatja az adatok szűrését, egyesítését, aggregálását, számítását, valamint a hiányzó értékek kezelését. Az átalakítás célja, hogy az adatok a céladatbázis formátumának megfelelőek legyenek, és konzisztensek, megbízhatóak legyenek a további felhasználás szempontjából.

A betöltés (Load) fázisban az átalakított adatok bekerülnek a céladatbázisba vagy adattárházba. Ez lehet egy teljes adatbetöltés (full load), amikor az összes adat bekerül, vagy egy inkrementális betöltés (incremental load), amikor csak a változások kerülnek rögzítésre. A betöltés során az adatok integritásának megőrzése érdekében tranzakciókezelést alkalmaznak.

Az ETL folyamat jelentősége abban rejlik, hogy lehetővé teszi a szervezetek számára, hogy különböző forrásokból származó adatokat egyetlen, egységes nézetbe rendezzenek, ami elengedhetetlen a pontos és megalapozott döntéshozatalhoz.

Gyakran egyetlen programozási eszköz használatával valósítják meg az ETL folyamatot, ami leegyszerűsíti a fejlesztést és a karbantartást. Ezek az eszközök grafikus felületet biztosítanak az adatáramlások tervezéséhez és kezeléséhez, valamint beépített funkciókat kínálnak az adatok kinyeréséhez, átalakításához és betöltéséhez. Az ETL eszközök rugalmasságot és skálázhatóságot biztosítanak, lehetővé téve a szervezetek számára, hogy gyorsan reagáljanak a változó üzleti igényekre.

Az ETL folyamatok automatizálása kulcsfontosságú a hatékonyság növelése és a hibák minimalizálása szempontjából. Az ütemezett ETL feladatok biztosítják, hogy az adatok naprakészek legyenek, és az üzleti felhasználók mindig a legfrissebb információkhoz jussanak.

Az ETL folyamat definíciója és alapelvei

Az ETL (Extract, Transform, Load) egy adatintegrációs folyamat, amelynek célja az adatok kinyerése különböző forrásokból, azok átalakítása a célrendszer igényeinek megfelelően, majd betöltése a céladatbázisba vagy adattárházba.

A folyamat három fő lépésből áll:

- Kinyerés (Extract): Az adatok összegyűjtése különböző forrásokból. Ezek a források lehetnek adatbázisok, fájlok (CSV, XML, JSON), alkalmazások API-jai, vagy akár régebbi rendszerek is. A kinyerés során fontos az adatok integritásának megőrzése és a releváns adatok kiválasztása.

- Átalakítás (Transform): Ebben a fázisban az adatok megtisztítása, szűrése, validálása, formázása és összevonása történik. Az átalakítási lépések célja, hogy az adatok alkalmasak legyenek a célrendszerben való tárolásra és elemzésre. Például, az adatok normalizálása, duplikációk eltávolítása, számítások elvégzése, vagy különböző adatformátumok közötti konvertálás.

- Betöltés (Load): Az átalakított adatok betöltése a céladatbázisba vagy adattárházba. A betöltés lehet teljes (full load), amikor az összes adat betöltésre kerül, vagy inkrementális (incremental load), amikor csak a változott adatok kerülnek betöltésre. A betöltés során figyelembe kell venni a célrendszer teljesítményét és a párhuzamosságot a hatékony adatbetöltés érdekében.

Az ETL folyamatokat gyakran használják adattárházak építéséhez, üzleti intelligencia (BI) megoldásokhoz, és adatelemzési projektekhez. Lehetővé teszi a különböző forrásokból származó adatok egységes formában történő tárolását és elemzését.

Az ETL folyamat célja, hogy a különböző forrásokból származó adatokból értékes információkat nyerjünk ki, amelyek üzleti döntések támogatására használhatók fel.

Az ETL folyamatok implementálása során különböző eszközök és technológiák állnak rendelkezésre. Használhatók dedikált ETL eszközök, amelyek grafikus felületen teszik lehetővé a folyamatok tervezését és menedzselését. Emellett programozási nyelvek (pl. Python, Java) és adatbázis-specifikus eszközök is alkalmazhatók az ETL folyamatok megvalósításához. A következőkben egy példa látható egy egyszerű átalakításra:

Példa egy átalakításra:

- Eredeti adat: „John Doe, 30, New York”

- Átalakítási lépések:

- Szétválasztás vessző mentén: [„John Doe”, ” 30″, ” New York”]

- Vezeték- és keresztnévre bontás: [„John”, „Doe”, „30”, „New York”]

- Szám konvertálása egész számmá: [„John”, „Doe”, 30, „New York”]

- Szóközök eltávolítása: [„John”, „Doe”, 30, „NewYork”]

- Végeredmény: Egy adatszerkezet, amely tartalmazza a nevet, életkort és várost külön mezőkben.

Az ETL folyamatok tervezése és implementálása komplex feladat lehet, amely alapos tervezést és a forrás- és célrendszerek alapos ismeretét igényli. A sikeres ETL folyamatok kulcsa a megfelelő eszközök és technológiák kiválasztása, a részletes adatmodellezés és a folyamatos monitorozás és karbantartás.

Az Extract (Kinyerés) fázis részletes elemzése

Az ETL folyamat első és kritikus lépése az Extract (Kinyerés) fázis. Ebben a szakaszban az adatok kinyerése történik meg a különböző forrásokból. Ezek a források rendkívül változatosak lehetnek, beleértve a relációs adatbázisokat, fájlokat (CSV, TXT, JSON, XML), felhő alapú szolgáltatásokat, API-kat, sőt, akár régi, örökölt rendszereket is.

A kinyerési folyamat során az a cél, hogy minél kevesebb beavatkozással, lehetőleg az eredeti formátumban szerezzük meg az adatokat. Ez azért fontos, mert a transzformációs fázisban lesz lehetőségünk az adatok tisztítására, átalakítására és egységesítésére. Ha már a kinyerés során módosítjuk az adatokat, az növelheti a hibalehetőséget és megnehezítheti a későbbi hibakeresést.

A kinyerés során figyelembe kell venni a különböző adatforrások sajátosságait. Például, egy relációs adatbázisból SQL lekérdezésekkel nyerjük ki az adatokat, míg egy CSV fájlból soronként olvassuk be az adatokat. API-k esetében pedig REST vagy SOAP hívásokat kell indítanunk.

A kinyerési folyamat során a teljességre kell törekedni. Minden releváns adatot ki kell nyernünk a forrásokból. Ugyanakkor, figyelembe kell vennünk a teljesítményt is. A nagy mennyiségű adat kinyerése időigényes lehet, ezért optimalizálnunk kell a kinyerési folyamatot.

A kinyerés során a biztonság is kiemelt szempont. Az érzékeny adatokat titkosítva kell tárolnunk és továbbítanunk. A hozzáférési jogosultságokat is megfelelően kell kezelnünk.

A kinyerés célja, hogy az adatokat a forrásrendszerekből a célrendszerbe juttassuk anélkül, hogy az eredeti adatokat megváltoztatnánk.

A kinyerési stratégia megválasztásakor több tényezőt is figyelembe kell vennünk:

- Az adatforrások típusa: Relációs adatbázisok, fájlok, API-k stb.

- Az adatok mennyisége: Kis, közepes vagy nagy mennyiségű adat.

- Az adatok frissítési gyakorisága: Naponta, hetente, havonta stb.

- A célrendszer követelményei: Milyen formátumban és struktúrában kell az adatokat betölteni.

A kinyerési módszerek lehetnek:

- Teljes kinyerés: Minden adatot kinyerünk a forrásból. Ez a legegyszerűbb módszer, de nagy mennyiségű adat esetén időigényes lehet.

- Inkrementális kinyerés: Csak a legutóbbi frissítések óta megváltozott adatokat nyerjük ki. Ehhez szükség van valamilyen változáskövetési mechanizmusra a forrásrendszerben.

A kinyert adatokat általában egy staging területen tároljuk. Ez egy ideiglenes tároló, ahol az adatok a transzformációs fázisra várnak. A staging terület lehet egy fájlrendszer, egy adatbázis vagy egy felhő alapú tároló.

A kinyerési folyamat során naplózást is kell végeznünk. Rögzítenünk kell, hogy mely adatokat, mikor és honnan nyertük ki. Ez segít a hibakeresésben és az adatok nyomon követésében.

A hatékony és megbízható kinyerési folyamat elengedhetetlen az ETL folyamat sikeréhez. A gondos tervezés és a megfelelő eszközök kiválasztása biztosítja, hogy az adatok időben és pontosan kerüljenek a célrendszerbe.

Az Transform (Átalakítás) fázis részletes elemzése

A Transform (Átalakítás) fázis az ETL folyamat kritikus eleme, amely a kinyert (Extract) adatokat a célrendszer számára megfelelő formátumba hozza. Ez a fázis biztosítja, hogy az adatok tiszták, konzisztensek és használhatók legyenek a céladatbázisban vagy adattárházban. Az átalakítások célja, hogy az adatok megfeleljenek a célrendszer követelményeinek, és hogy az adatokból a lehető legtöbb információ kinyerhető legyen.

Az átalakítási folyamat során számos feladatot végezhetünk el, amelyek mindegyike az adatok minőségének javítását és a használhatóságának növelését szolgálja. Ezek a feladatok magukban foglalhatják:

- Tisztítás: Az adatok tisztítása során a hibás, hiányos vagy irreleváns adatokat javítjuk vagy távolítjuk el. Ez magában foglalhatja a helyesírási hibák javítását, a hiányzó értékek pótlását (pl. átlaggal, mediánnal vagy egy alapértelmezett értékkel), és a duplikátumok eltávolítását.

- Standardizálás: Az adatok standardizálása során az adatokat egységes formátumba hozzuk. Ez magában foglalhatja a dátumformátumok, mértékegységek és pénznemek egységesítését. Például, ha az adatok különböző forrásokból származnak, amelyek különböző dátumformátumokat használnak (pl. ÉÉÉÉ-HH-NN és HH/NN/ÉÉÉÉ), akkor ezeket egyetlen, egységes formátumba kell konvertálni.

- Dúsítás: Az adatok dúsítása során további információkat adunk az adatokhoz, amelyek növelik az adatok értékét. Ez magában foglalhatja a külső forrásokból származó adatok hozzáadását, például demográfiai adatokat, földrajzi adatokat vagy piaci adatokat.

- Aggregáció: Az adatok aggregációja során az adatokat összesítjük, hogy magasabb szintű információkat nyerjünk. Ez magában foglalhatja az adatok csoportosítását és összesítését, például az értékesítési adatok összesítését termékkategóriánként vagy régiók szerint.

- Szűrés: Az adatok szűrése során eltávolítjuk azokat az adatokat, amelyek nem relevánsak a célrendszer számára. Ez magában foglalhatja az érvénytelen vagy irreleváns adatokat, valamint azokat az adatokat, amelyek nem felelnek meg bizonyos kritériumoknak.

- Konverzió: Az adatok konverziója során az adatokat egyik formátumból a másikba alakítjuk át. Ez magában foglalhatja az adattípusok konvertálását (pl. szövegből számmá), a karakterkódolás konvertálását és az adatok kódolását vagy dekódolását.

Az átalakítási fázis kulcsfontosságú a sikeres ETL folyamathoz, mivel biztosítja, hogy az adatok a célrendszer számára megfelelőek és használhatók legyenek.

Az átalakítási fázis során használt konkrét technikák és eszközök az adatok jellegétől, a célrendszer követelményeitől és a rendelkezésre álló erőforrásoktól függenek. Gyakran használt eszközök közé tartoznak az SQL szkriptek, az ETL eszközök (pl. Apache NiFi, Informatica PowerCenter, Talend), és a programozási nyelvek (pl. Python, Java).

A Transform fázis során figyelembe kell venni a teljesítményt is. Az átalakítási folyamatok jelentős erőforrásokat igényelhetnek, különösen nagy adathalmazok esetén. Ezért fontos, hogy az átalakítási folyamatokat optimalizáljuk a teljesítmény javítása érdekében. Ez magában foglalhatja az indexek használatát, az adatbázis-optimalizálást és a párhuzamos feldolgozást.

A validálás elengedhetetlen része az átalakítási fázisnak. A validálás során ellenőrizzük, hogy az átalakított adatok megfelelnek-e a célrendszer követelményeinek, és hogy nincsenek-e hibák vagy inkonzisztenciák. A validálás magában foglalhatja az adatprofilozást, az adatminőség-ellenőrzést és a tesztelést.

Például, ha egy webshopból gyűjtünk adatokat és egy adattárházba szeretnénk azokat betölteni, akkor az átalakítási fázisban el kell végeznünk a következőket:

- A termékneveket és leírásokat tisztítjuk, eltávolítva a HTML tageket és a speciális karaktereket.

- A dátumokat standardizáljuk, hogy egységes formátumban legyenek tárolva.

- Az árakat pénznem szerint konvertáljuk, ha a webshop több pénznemet is használ.

- A vásárlási adatokat aggregáljuk, hogy megkapjuk a legnépszerűbb termékeket és a leggyakoribb vásárlási időpontokat.

A sikeres Transform fázis elengedhetetlen a megbízható és pontos adatok biztosításához a célrendszerben, ami lehetővé teszi a megalapozott üzleti döntések meghozatalát.

Az Load (Betöltés) fázis részletes elemzése

A Load (Betöltés) fázis az ETL (Extract, Transform, Load) folyamat utolsó, de nem kevésbé kritikus eleme. Ebben a szakaszban a kivont, megtisztított és átalakított adatok a cél adatbázisba vagy adattárházba kerülnek. A betöltés hatékonysága és pontossága közvetlenül befolyásolja a teljes ETL folyamat sikerét és az adatok felhasználhatóságát az üzleti döntésekhez.

A betöltés során számos szempontot figyelembe kell venni, többek között a célrendszer típusát, a rendelkezésre álló erőforrásokat és a betöltendő adatok mennyiségét. A célrendszer lehet egy relációs adatbázis (pl. MySQL, PostgreSQL, Oracle), egy NoSQL adatbázis (pl. MongoDB, Cassandra) vagy egy adattárház (pl. Snowflake, Amazon Redshift). Mindegyik rendszer más-más betöltési módszert és optimalizálási technikát igényel.

A betöltési módszerek alapvetően két fő csoportra oszthatók: teljes betöltés (full load) és inkrementális betöltés (incremental load). A teljes betöltés során a teljes adathalmaz minden alkalommal betöltésre kerül, ami egyszerű, de időigényes lehet nagy adathalmazok esetén. Az inkrementális betöltés ezzel szemben csak a változásokat (új, módosított vagy törölt rekordokat) tölti be, ami jelentősen csökkentheti a betöltési időt és a rendszer terhelését.

Az inkrementális betöltés megvalósításához különböző technikák állnak rendelkezésre, például:

- Időbélyeg alapú megközelítés: Az adatokban tárolt időbélyeg segítségével azonosítjuk a legutóbbi betöltés óta történt változásokat.

- Verziószám alapú megközelítés: Minden rekordhoz egy verziószámot rendelünk, és csak a magasabb verziószámú rekordokat töltjük be.

- Változásnapló (change data capture – CDC): Az adatbázis tranzakciós naplóit használjuk a változások azonosítására.

A betöltés során felmerülő egyik legfontosabb kihívás a teljesítmény optimalizálása. A nagy adathalmazok betöltése jelentős erőforrásokat igényelhet, ezért fontos a megfelelő indexek létrehozása a cél adatbázisban, a párhuzamos betöltés alkalmazása és a batch méretének optimalizálása. A batch méret azt jelenti, hogy egyszerre hány rekordot töltünk be a cél adatbázisba. A túl kicsi batch méret lassú betöltést eredményezhet, míg a túl nagy batch méret a rendszer túlterheléséhez vezethet.

A betöltés során a hibakezelés is kiemelt fontosságú. Előfordulhatnak adatminőségi problémák, hálózati hibák vagy egyéb váratlan események, amelyek megszakíthatják a betöltési folyamatot. Fontos, hogy a betöltő alkalmazás képes legyen észlelni és kezelni ezeket a hibákat, naplózni a hibaüzeneteket és lehetőség szerint automatikusan újrapróbálni a sikertelen betöltéseket.

A betöltés sikerességének ellenőrzésére adatvalidációs teszteket kell futtatni a betöltés után. Ezek a tesztek ellenőrzik, hogy az adatok helyesen kerültek-e betöltésre, nincsenek-e hiányzó vagy sérült adatok, és megfelelnek-e a meghatározott üzleti szabályoknak.

Az ETL folyamat hatékonyságának és megbízhatóságának biztosítása érdekében a betöltési fázis során a következő legjobb gyakorlatokat érdemes követni:

- Tervezzük meg alaposan a betöltési stratégiát: Döntsük el, hogy teljes vagy inkrementális betöltést alkalmazunk, és válasszuk ki a legmegfelelőbb betöltési módszert a célrendszer és az adatok jellemzői alapján.

- Optimalizáljuk a teljesítményt: Használjunk indexeket, párhuzamos betöltést és optimalizált batch méretet a betöltési idő csökkentése érdekében.

- Implementáljunk robusztus hibakezelést: Kezeljük a váratlan hibákat, naplózzuk a hibaüzeneteket és próbáljuk újra a sikertelen betöltéseket.

- Végezzünk adatvalidációs teszteket: Ellenőrizzük a betöltött adatok helyességét és integritását.

- Monitorozzuk a betöltési folyamatot: Kövessük nyomon a betöltési időt, a hibákat és az erőforrás-felhasználást.

A Load (Betöltés) fázis nem csupán az adatok fizikai áthelyezése a célrendszerbe, hanem egy komplex folyamat, amely magában foglalja a teljesítmény optimalizálását, a hibakezelést és az adatvalidációt is.

A modern ETL eszközök számos funkciót kínálnak a betöltési folyamat automatizálására és egyszerűsítésére. Ezek az eszközök lehetővé teszik a különböző adatforrásokhoz való csatlakozást, az adatok átalakítását és a cél adatbázisba vagy adattárházba való betöltését egyetlen, integrált platformon belül. Emellett olyan funkciókat is kínálnak, mint a munkafolyamat-kezelés, a hibakezelés és a monitorozás, amelyek segítenek a betöltési folyamat hatékonyabbá tételében.

Az ETL architektúrák típusai és jellemzőik

Az ETL (Extract, Transform, Load) architektúrák különböző megvalósítási módokat kínálnak az adatok céladatbázisba történő betöltésére. Ezek az architektúrák eltérő erőforrásigényűek, skálázhatóságúak és komplexitásúak lehetnek, attól függően, hogy hol történik az adatok transzformálása.

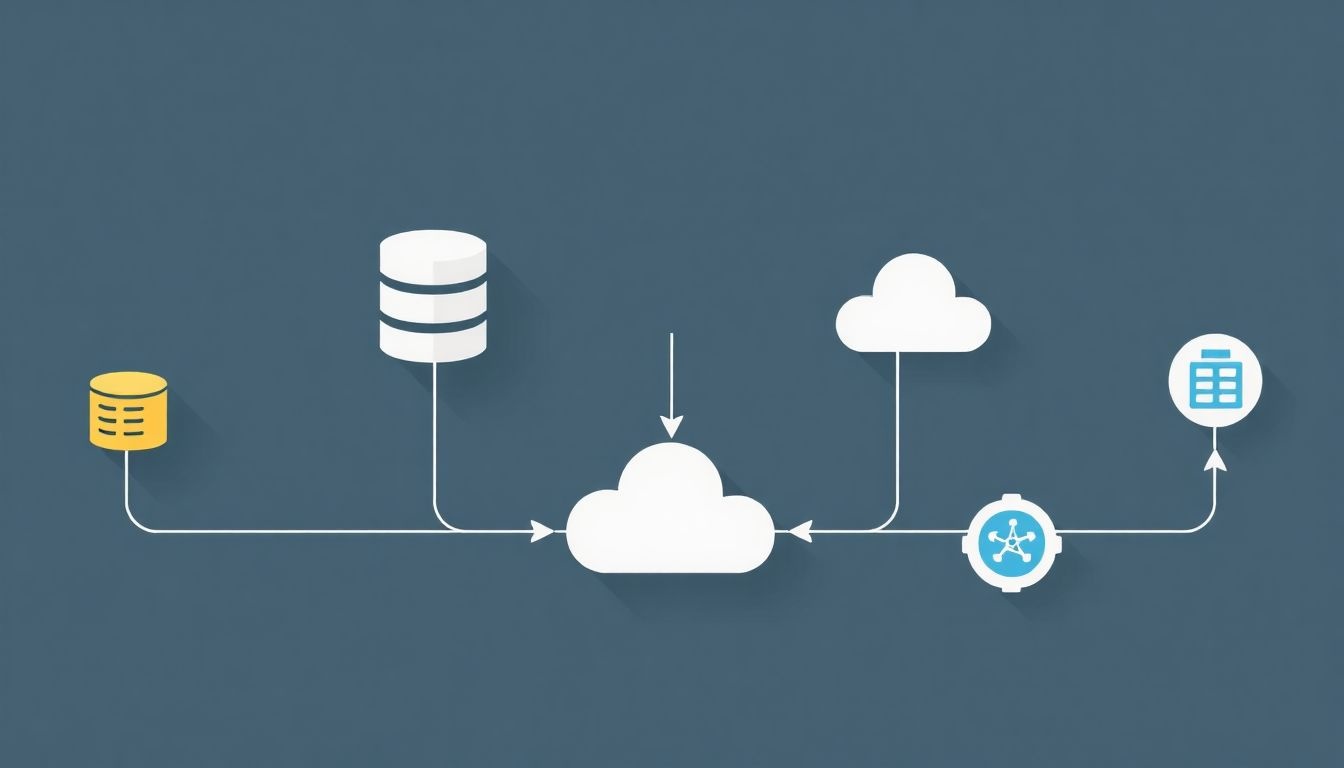

Az egyik alapvető típus a klasszikus ETL architektúra, ahol az adatok kinyerése (Extract), a transzformáció (Transform) és a betöltés (Load) egy dedikált ETL szerveren történik. Ez a szerver általában egy központi helyen található, és felelős az adatok forrásrendszerekből történő kinyeréséért, a szükséges tisztításokért, átalakításokért és validálásokért, majd a céladatbázisba történő betöltésért. Ez az architektúra jól bevált, de a transzformációk központosítása miatt szűk keresztmetszetet jelenthet nagy adatmennyiségek esetén.

Egy másik megközelítés az ELT (Extract, Load, Transform) architektúra, amely a felhő alapú adattárházak elterjedésével vált népszerűvé. Ebben az esetben az adatok először nyers formában betöltődnek a céladatbázisba (Load), majd a transzformáció (Transform) a céladatbázis számítási erőforrásait használva történik. Ez lehetővé teszi a transzformációk skálázását a céladatbázis kapacitásának megfelelően, és kihasználja a felhő alapú adattárházak párhuzamos feldolgozási képességeit. Az ELT különösen előnyös, ha a céladatbázis nagy teljesítményű és képes a komplex transzformációk hatékony elvégzésére.

Az ELT architektúra a felhő alapú adattárházak elterjedésével vált népszerűvé, kihasználva azok párhuzamos feldolgozási képességeit.

Léteznek valós idejű ETL architektúrák is, amelyek lehetővé teszik az adatok azonnali betöltését és transzformálását a beérkezés pillanatában. Ezek az architektúrák gyakran használnak stream feldolgozási technológiákat, mint például az Apache Kafka vagy az Apache Flink, hogy az adatokat folyamatosan dolgozzák fel és frissítsék a céladatbázist. A valós idejű ETL kritikus fontosságú olyan alkalmazásokban, ahol az adatok frissessége elengedhetetlen, például a pénzügyi tranzakciók elemzésében vagy a IoT adatok feldolgozásában.

Ezen kívül megemlíthetőek a hibrid ETL architektúrák, amelyek a klasszikus ETL és az ELT előnyeit ötvözik. Ezek az architektúrák lehetővé teszik, hogy bizonyos transzformációk a forrásoldalon vagy egy dedikált ETL szerveren történjenek, míg más transzformációk a céladatbázisban. Ez a megközelítés rugalmasságot biztosít az adatok feldolgozásában, és lehetővé teszi a különböző transzformációk optimalizálását a rendelkezésre álló erőforrások és a teljesítménykövetelmények alapján.

A megfelelő ETL architektúra kiválasztása számos tényezőtől függ, beleértve az adatok mennyiségét és sebességét, a transzformációk komplexitását, a rendelkezésre álló erőforrásokat és a céladatbázis képességeit. A gondos tervezés és a megfelelő eszközök kiválasztása elengedhetetlen a sikeres ETL implementációhoz.

Az ETL folyamatok előnyei és hátrányai

Az ETL (Extract, Transform, Load) folyamatok számos előnnyel járnak az adatok betöltése során, de nem mentesek a hátrányoktól sem.

Előnyök:

- Adatok minőségének javítása: Az ETL folyamat lehetővé teszi az adatok tisztítását, szűrését és átalakítását, így a céladatbázisba csak a releváns és pontos adatok kerülnek.

- Integráció: Különböző forrásokból származó adatokat egyesít egyetlen, egységes formátumba.

- Rugalmasság: Az ETL folyamatok testreszabhatók az egyedi üzleti igényeknek megfelelően.

- Időmegtakarítás: Automatizált adatáramlás, ami csökkenti a manuális beavatkozást és a hibák lehetőségét.

Az ETL folyamatok kulcsfontosságúak az adatok megbízható és hatékony betöltéséhez, lehetővé téve a vállalatok számára, hogy megalapozott döntéseket hozzanak az adatok alapján.

Hátrányok:

- Komplexitás: Az ETL folyamatok tervezése és implementálása komplex feladat lehet, különösen, ha sok különböző adatforrást kell integrálni.

- Költség: Az ETL eszközök és a hozzájuk kapcsolódó szakértelem költséges lehet.

- Időigény: A folyamat fejlesztése és tesztelése időigényes lehet, főleg bonyolultabb rendszerek esetén.

- Teljesítmény: Nagy adatmennyiségek esetén az ETL folyamatok teljesítménye problémát okozhat, ami optimalizálást igényel.

Az ETL folyamatok hatékonysága nagyban függ a tervezés minőségétől és a felhasznált eszközöktől. A megfelelő eszközök kiválasztása és a jól megtervezett folyamat minimalizálhatja a hátrányokat és maximalizálhatja az előnyöket.

Egyetlen programozási eszköz szerepe az ETL folyamatban

Az ETL (Extract, Transform, Load) folyamat során az adatok kinyerése, átalakítása és betöltése történik egy céladatbázisba. A hatékonyság és egyszerűség érdekében gyakran törekszünk arra, hogy ezt a teljes folyamatot egyetlen programozási eszközzel valósítsuk meg.

Ennek számos előnye van. Először is, a fejlesztési idő jelentősen csökken, mivel nem kell különböző eszközök között váltogatni és integrációs problémákkal foglalkozni. A kód egységes lesz, ami megkönnyíti a karbantartást és a hibakeresést. Emellett a tanulási görbe is rövidebb, hiszen a fejlesztőknek csak egyetlen eszközt kell elsajátítaniuk.

Azonban fontos megjegyezni, hogy egyetlen eszköz használata nem mindig a legjobb megoldás. Bizonyos esetekben, amikor komplex adattranszformációkra van szükség, vagy a forrásadatok nagyon eltérő formátumúak, a specializált ETL eszközök hatékonyabbak lehetnek.

Egyetlen programozási eszköz használatával az ETL folyamatban a fejlesztés gyorsabbá és egyszerűbbé válik, csökkentve a komplexitást és a karbantartási költségeket.

Például, egy Python szkript a Pandas könyvtárral könnyen kezelheti a különböző forrásokból származó adatokat, elvégezheti a szükséges átalakításokat, és betöltheti azokat egy relációs adatbázisba. Másik lehetőség, hogy egy SQL alapú megoldást használunk, amelyben a kinyerés, átalakítás és betöltés mind SQL lekérdezésekkel és tárolt eljárásokkal történik. A választás a konkrét igényektől és a rendelkezésre álló erőforrásoktól függ.

A megfelelő eszköz kiválasztása kulcsfontosságú. Figyelembe kell venni a forrásadatok típusát, a szükséges transzformációk komplexitását, a céladatbázis típusát, a teljesítményigényeket és a fejlesztői csapat szakértelmét.

Népszerű programozási nyelvek és eszközök ETL feladatokhoz

Az ETL (Extract, Transform, Load) folyamatok során az adatok kinyerése, átalakítása és betöltése történik egy céladatbázisba. Számos programozási nyelv és eszköz áll rendelkezésre ezen feladatok elvégzésére, attól függően, hogy milyen komplexitású és mennyiségű adatról van szó, illetve milyen infrastruktúrával rendelkezünk.

A Python az egyik legnépszerűbb választás ETL feladatokhoz. Számos könyvtár áll rendelkezésre, amelyek megkönnyítik az adatok kinyerését különböző forrásokból (pl. CSV, JSON, adatbázisok), átalakítását (pl. pandas) és betöltését a céladatbázisba. A pandas különösen hasznos az adatok tisztítására, szűrésére és aggregálására. A SQLAlchemy pedig egy hatékony eszköz az adatbázisokkal való interakcióhoz.

A Java egy másik elterjedt nyelv, különösen vállalati környezetben, ahol a stabilitás és a skálázhatóság kulcsfontosságú. Számos keretrendszer és könyvtár támogatja az ETL folyamatokat, például az Apache Camel és a Spring Batch. Ezek az eszközök lehetővé teszik komplex adatfolyamatok definiálását és kezelését.

A SQL önmagában is használható egyszerűbb ETL feladatokra, különösen ha az adatok már egy adatbázisban vannak tárolva. Az SQL lekérdezésekkel az adatok kinyerhetők, átalakíthatók és betölthetők a céladatbázisba. Az adatbázis-specifikus funkciók, mint például a stored procedure-ök, tovább bővíthetik az SQL lehetőségeit.

A megfelelő eszköz kiválasztása az ETL feladathoz nagymértékben függ az adatforrásoktól, a céladatbázistól, az adatok komplexitásától és a rendelkezésre álló erőforrásoktól.

A Spark egy elosztott számítási keretrendszer, amely különösen alkalmas nagyméretű adathalmazok feldolgozására. A Spark SQL lehetővé teszi az adatok lekérdezését és átalakítását SQL-szerű nyelven. A Spark emellett támogatja a különböző adatforrásokat és céladatbázisokat, így egy sokoldalú eszköz az ETL folyamatokhoz.

Vannak dedikált ETL eszközök is, mint például az Apache NiFi vagy a Talend. Ezek grafikus felületet biztosítanak az adatfolyamatok definiálásához és kezeléséhez, ami megkönnyíti a fejlesztést és a karbantartást. Ezen eszközök általában támogatják a különböző adatforrásokat és céladatbázisokat, valamint számos beépített transzformációs funkciót kínálnak.

A PowerShell használható Windows környezetben az ETL feladatok automatizálására. Bár nem olyan elterjedt, mint a Python vagy a Java, a PowerShell alkalmas lehet kisebb, egyszerűbb ETL folyamatokhoz, különösen ha a forrás- és céladatbázisok Microsoft technológiákon alapulnak.

Az adatminőség biztosítása az ETL folyamat során

Az adatminőség az ETL folyamat során kritikus fontosságú. A hibás vagy hiányos adatok a céladatbázisban helytelen elemzésekhez és rossz üzleti döntésekhez vezethetnek. Ezért a minőségbiztosítási lépések beépítése elengedhetetlen a teljes ETL folyamatba.

Az adatminőség biztosításának egyik legfontosabb eleme az adatprofilozás. Ez a folyamat során az adatok szerkezetének, tartalmának és minőségének elemzését jelenti. Az adatprofilozás segít azonosítani a potenciális problémákat, mint például a hiányzó értékeket, az érvénytelen formátumokat vagy az inkonzisztens adatokat.

A transzformációs fázis kulcsfontosságú a minőség javításában. Ebben a szakaszban az adatokat tisztíthatjuk, normalizálhatjuk és standardizálhatjuk. Például, a hiányzó értékeket pótolhatjuk, a helytelen formátumokat javíthatjuk, és az inkonzisztens adatokat egységesíthetjük.

A validációs szabályok alkalmazása szintén elengedhetetlen. Ezek a szabályok meghatározzák, hogy mely adatok fogadhatók el a céladatbázisban. Például, egy szabály előírhatja, hogy egy adott mezőben csak pozitív számok szerepelhetnek. Ha egy adat nem felel meg a validációs szabályoknak, akkor azt elutasíthatjuk, vagy külön kezelhetjük.

Az adatminőség nem egy egyszeri feladat, hanem egy folyamatos törekvés.

A monitorozás és a jelentéskészítés segítségével nyomon követhetjük az adatminőséget az ETL folyamat során. A monitorozás során ellenőrizhetjük, hogy az adatok megfelelnek-e a validációs szabályoknak, és időben észlelhetjük a problémákat. A jelentéskészítés segítségével tájékoztathatjuk az érintett feleket az adatminőségről, és javaslatokat tehetünk a javításra.

Az adatminőség javítása az ETL folyamat során összetett feladat, de a befektetés megtérül a megbízhatóbb elemzések és a jobb üzleti döntések révén.

A következőkben felsorolunk néhány gyakori technikát az adatminőség javítására:

- Hiányzó értékek pótlása (pl. átlaggal, mediánnal, vagy egy előre definiált értékkel)

- Érvénytelen adatok javítása (pl. elgépelések korrigálása, formátumok egységesítése)

- Duplikált adatok eltávolítása

- Inkonzisztens adatok egységesítése (pl. különböző mértékegységek átváltása)

- Adatok validálása (pl. adattípusok, tartományok ellenőrzése)

A tesztelés kulcsszerepet játszik az ETL folyamat megbízhatóságának biztosításában. A tesztelés során ellenőrizzük, hogy az adatok helyesen kerülnek-e kinyerésre, transzformálásra és betöltésre. A tesztelés magában foglalhatja az adatok érvényességének, teljességének és pontosságának ellenőrzését.

Az ETL folyamatok monitorozása és hibaelhárítása

Az ETL folyamatok monitorozása és hibaelhárítása kritikus fontosságú a megbízható adatvezérelt döntéshozatalhoz. Mivel az ETL folyamatok az adatok kinyeréséért, átalakításáért és betöltéséért felelősek, a hibák komoly következményekkel járhatnak.

A monitorozás célja az ETL folyamatok folyamatos felügyelete, hogy azonosítsuk a lehetséges problémákat még azok bekövetkezése előtt. Ez magában foglalhatja az alábbiakat:

- Teljesítménymutatók (KPI-k) figyelése: Például a futási idő, a feldolgozott rekordok száma, a sikeres és sikertelen betöltések aránya.

- Rendszererőforrások monitorozása: A CPU használat, a memória használat és a lemezterület figyelése a szervereken, ahol az ETL folyamatok futnak.

- Naplófájlok elemzése: A naplófájlok tartalmazhatnak hasznos információkat a hibákról, a figyelmeztetésekről és a teljesítményproblémákról.

- Értesítések beállítása: Automatikus értesítések beállítása kritikus hibák vagy teljesítményproblémák esetén.

A hibaelhárítás magában foglalja a problémák azonosítását és megoldását, amikor azok bekövetkeznek. A hibaelhárítás során fontos:

- A hiba okának azonosítása: Ez magában foglalhatja a naplófájlok elemzését, a kód hibakeresését és az adatforrások ellenőrzését.

- A hiba kijavítása: Ez magában foglalhatja a kód javítását, az adatforrások javítását vagy a konfigurációs beállítások módosítását.

- A javítás tesztelése: A javítás tesztelése annak biztosítása érdekében, hogy a probléma megoldódott, és hogy nem okoz új problémákat.

- A dokumentáció frissítése: A dokumentáció frissítése a hiba okának és a javítás módjának rögzítéséhez.

A hatékony monitorozás és hibaelhárítás elengedhetetlen az ETL folyamatok megbízhatóságának és teljesítményének biztosításához.

A különböző ETL eszközök és platformok különböző monitorozási és hibaelhárítási funkciókat kínálnak. Fontos, hogy olyan eszközöket és technikákat válasszunk, amelyek megfelelnek az adott igényeknek és követelményeknek.

Például, ha az adatminőségi problémák gyakoriak, érdemes lehet adatprofilozó eszközöket használni az adatok minőségének proaktív monitorozására. Ha a teljesítményproblémák gyakoriak, érdemes lehet teljesítmény-optimalizálási technikákat alkalmazni, például az adatok particionálását vagy a párhuzamos feldolgozást.

A proaktív megközelítés kulcsfontosságú a sikeres ETL monitorozáshoz és hibaelhárításhoz. Ez azt jelenti, hogy nem csak a problémákra reagálunk, amikor azok bekövetkeznek, hanem megelőző intézkedéseket is teszünk a problémák elkerülése érdekében.

ETL és az adat raktározás kapcsolata

Az ETL (Extract, Transform, Load) folyamat kulcsfontosságú szerepet játszik az adat raktározásban. Gyakorlatilag ez a folyamat teszi lehetővé, hogy különböző forrásokból származó, heterogén adatokat integráljunk egy központi adattárba, azaz az adat raktárba.

Az Extract fázis során az adatok kinyerése történik a különböző forrásokból, mint például adatbázisokból, fájlokból, vagy akár webes API-kból. Ezek az adatok gyakran eltérő formátumban és struktúrában vannak.

A Transform fázis az adatok megtisztítását, átalakítását és egységesítését foglalja magában. Itt történik például az adatok szűrése, aggregálása, konvertálása, és a hiányzó adatok kezelése. Ez a lépés kritikus ahhoz, hogy az adatok a céladatbázisban használhatók legyenek.

A Load fázisban az átalakított adatok betöltésre kerülnek a cél adatbázisba, azaz az adat raktárba. Ez az adat raktár általában egy relációs adatbázis, de lehet egy NoSQL adatbázis vagy egy adat tó is.

Az ETL folyamat nélkül az adat raktárak nem lennének képesek a különböző forrásokból származó adatok integrálására és elemzésre alkalmassá tételére.

Az ETL folyamat lehetővé teszi, hogy a vállalatok összefüggéseket fedezzenek fel az adataikban, és megalapozott döntéseket hozzanak. Az adat raktárban lévő adatok alapján készíthetők jelentések, dashboardok, és végezhetők komplex elemzések.

Egyetlen programozási eszköz használata az ETL folyamathoz számos előnnyel járhat, mint például a könnyebb karbantarthatóság és a csökkentett komplexitás. Az ETL eszközök általában grafikus felületet biztosítanak az adatok átalakításához, így nem szükséges bonyolult programkódot írni.

ETL a felhőben: lehetőségek és kihívások

Az ETL (Extract, Transform, Load) folyamatok a felhőbe költözése jelentős előnyökkel jár, de kihívásokkal is szembesülünk. Az egyik legnagyobb előny a skálázhatóság. A felhő alapú ETL eszközök képesek automatikusan alkalmazkodni a változó adatmennyiséghez, így elkerülhető a hardver korlátai miatti szűk keresztmetszet. Ez különösen fontos a big data projektek esetében.

A felhőben az ETL folyamatok költséghatékonyabbak is lehetnek. A fizetős modellek lehetővé teszik, hogy csak a ténylegesen felhasznált erőforrásokért fizessünk, elkerülve a drága, előre megvásárolt infrastruktúrát. Emellett a felhő szolgáltatók gyakran kínálnak előre elkészített ETL sablonokat és szolgáltatásokat, amelyek jelentősen lerövidíthetik a fejlesztési időt.

Azonban a felhő alapú ETL nem mentes a kihívásoktól. A biztonság kiemelt fontosságú, hiszen az adatok a felhőben tárolódnak és mozognak. Gondoskodni kell az adatok titkosításáról, a hozzáférési jogosultságok megfelelő beállításáról és a megfelelőségi követelmények betartásáról.

További kihívást jelenthet a komplexitás. A felhő alapú ETL eszközök sokszor bonyolultabbak lehetnek a helyi megoldásoknál, és speciális szakértelmet igényelhetnek a beállításhoz és a karbantartáshoz. Végül, a latency, vagyis a késleltetés is problémát okozhat, különösen akkor, ha az adatok különböző földrajzi helyeken találhatók.

ETL és a Big Data

Az ETL (Extract, Transform, Load) folyamatok kulcsfontosságúak a Big Data környezetben. A nagyméretű adathalmazok integrálása, tisztítása és betöltése a céladatbázisba komoly kihívásokat jelent. A hagyományos ETL eszközök gyakran nem képesek megbirkózni a Big Data által támasztott követelményekkel, mint a nagy sebességű adatfolyamok és a változatos adatforrások.

A Big Data ETL folyamatok során elengedhetetlen a skálázhatóság és a párhuzamosítás. Az adatok kinyerése különböző forrásokból, mint például szenzorok, közösségi média platformok vagy webes naplók, jelentős erőforrásokat igényel. Az adatok átalakítása, beleértve a tisztítást, a formázást és az aggregációt, szintén kritikus lépés.

A Big Data ETL folyamatok lényege, hogy az adatokat hatékonyan és megbízhatóan juttassuk el a céladatbázisba, ahol azok elemzésre és üzleti döntések támogatására használhatók fel.

A modern ETL eszközök, mint például az Apache Spark, a Hadoop vagy a Cloud-alapú ETL szolgáltatások, lehetővé teszik a nagyméretű adathalmazok párhuzamos feldolgozását és a különböző adatforrások integrálását. Ezek az eszközök gyakran támogatják a valós idejű adatfeldolgozást is, ami lehetővé teszi az azonnali reakciót az üzleti változásokra.

Példák ETL használatára különböző iparágakban

Az ETL folyamatok elterjedtek a különböző iparágakban, mivel lehetővé teszik az adatok hatékony és egységesített kezelését. Nézzünk néhány példát:

- Pénzügyi szektor: A bankok és biztosítótársaságok ETL-t használnak az ügyféladatok, tranzakciók és kockázatkezelési adatok integrálására. Ez lehetővé teszi a pontosabb jelentéseket, a csalások felderítését és a személyre szabott szolgáltatások nyújtását.

- Kiskereskedelem: Az ETL segít a vásárlási szokások elemzésében, a készletgazdálkodás optimalizálásában és a marketingkampányok hatékonyságának növelésében. Az adatok különböző forrásokból – például online áruházakból, fizikai boltokból és hűségprogramokból – származnak.

- Egészségügy: Az ETL kulcsfontosságú a betegadatok kezelésében, a klinikai kutatások támogatásában és a közegészségügyi statisztikák készítésében. A különböző rendszerekből származó adatok – például elektronikus egészségügyi nyilvántartásokból (EHR) és laboratóriumi rendszerekből – integrálása javítja a betegellátást és a döntéshozatalt.

- Gyártás: Az ETL segítségével a gyártó cégek nyomon követhetik a termelési folyamatokat, optimalizálhatják a ellátási láncot és javíthatják a minőségellenőrzést. Az adatok a gépekből, szenzorokból és egyéb rendszerekből származnak, amelyek valós idejű betekintést nyújtanak a gyártási folyamatokba.

Az ETL folyamatok lehetővé teszik a szervezetek számára, hogy értékes betekintést nyerjenek adataikból, javítsák a döntéshozatalt és növeljék a versenyképességet.

Az adatok minősége kritikus fontosságú. Az ETL folyamatok során a tisztítás, átalakítás és validálás elengedhetetlen a megbízható eredményekhez.

Például egy telekommunikációs cég használhatja az ETL-t a hívásadatok, az előfizetői információk és a hálózati teljesítményadatok integrálására. Ez lehetővé teszi számukra a hálózat optimalizálását, a szolgáltatások javítását és az ügyfélelégedettség növelését.

Az ETL folyamat jövője és a legújabb trendek

Az ETL folyamatok jövője szorosan összefonódik a felhőalapú technológiák elterjedésével. A korábban helyben futó, komplex ETL megoldások helyét egyre inkább a felhőben skálázható, költséghatékony szolgáltatások veszik át.

Egyre nagyobb hangsúlyt kap az ELT (Extract, Load, Transform) megközelítés, ahol az adatok először a célrendszerbe kerülnek betöltésre, és csak ezt követően történik meg a transzformáció. Ez különösen a big data környezetben előnyös, ahol a hatalmas adatmennyiségek mozgatása és transzformálása a forrás oldalon erőforrásigényes lehet.

Az ETL folyamatok automatizálása és az AI/ML integráció kulcsfontosságú a hatékonyság növelésében és az adatok minőségének javításában.

A data lakehouse architektúrák térnyerése is hatással van az ETL-re. Ezek az architektúrák egyesítik a data lake és a data warehouse előnyeit, lehetővé téve a strukturált és strukturálatlan adatok együttes kezelését és elemzését. Az ETL folyamatoknak ebben az esetben is kulcsszerepük van az adatok előkészítésében és a megfelelő formátumba alakításában.

A no-code/low-code ETL eszközök megjelenése demokratizálja az adatintegrációt, lehetővé téve a nem-programozó felhasználók számára is, hogy ETL folyamatokat hozzanak létre és kezeljenek. Ez a trend tovább erősödik, ahogy a vállalatok igyekeznek csökkenteni a fejlesztési időt és költségeket.