A High-Bandwidth Memory (HBM) egy nagy teljesítményű számítógépes memória technológia, mely a hagyományos DDR (Double Data Rate) memóriák alternatívája. Kifejlesztésének célja, hogy a modern processzorok és grafikus processzorok (GPU-k) növekvő sávszélesség igényeit kielégítse. A HBM alapvetően egy 3D stackelt memória megoldás, ami azt jelenti, hogy több memórialapkát helyeznek egymásra, és ezeket függőleges összeköttetésekkel, úgynevezett Through-Silicon Vias (TSV) technológiával kötik össze.

Ez a 3D architektúra lehetővé teszi, hogy a memórialapkák párhuzamosan működjenek, drasztikusan növelve a sávszélességet. A TSV-k biztosítják a gyors adatátvitelt a lapkák között, minimalizálva a késleltetést. A HBM nemcsak a sávszélességet növeli, hanem a teljesítményfelvételt is csökkenti a hagyományos memóriákhoz képest, ami különösen fontos a nagy teljesítményű számítástechnikai rendszerekben.

A HBM széles körben alkalmazzák a grafikus kártyákban, a mesterséges intelligencia (MI) gyorsítókban és a szuperszámítógépekben, ahol a nagyméretű adathalmazok gyors feldolgozása elengedhetetlen. A technológia fejlődésével a HBM egyre nagyobb szerepet játszik a modern számítástechnikai rendszerek teljesítményének maximalizálásában.

A HBM jelentősége abban rejlik, hogy képes áthidalni a szakadékot a processzorok számítási teljesítménye és a memória sávszélessége között, lehetővé téve a komplex számítások gyorsabb és hatékonyabb végrehajtását.

A HBM különböző generációi (HBM2, HBM2E, HBM3) folyamatosan fejlődnek, egyre nagyobb sávszélességet és kapacitást kínálva. Ez a folyamatos fejlesztés biztosítja, hogy a HBM továbbra is releváns maradjon a jövő számítástechnikai kihívásainak kezelésében.

A memória architektúrák fejlődése: A DRAM korlátok és az új igények

A nagy sávszélességű memória (HBM) egy viszonylag új memóriatechnológia, amely a DRAM korlátait hivatott feloldani. A hagyományos DRAM modulok (pl. DDR4, DDR5) egyre nehezebben tudnak lépést tartani a modern processzorok és grafikus kártyák memóriaigényével. A problémát a sávszélesség szűk keresztmetszete és a növekvő energiafogyasztás jelenti.

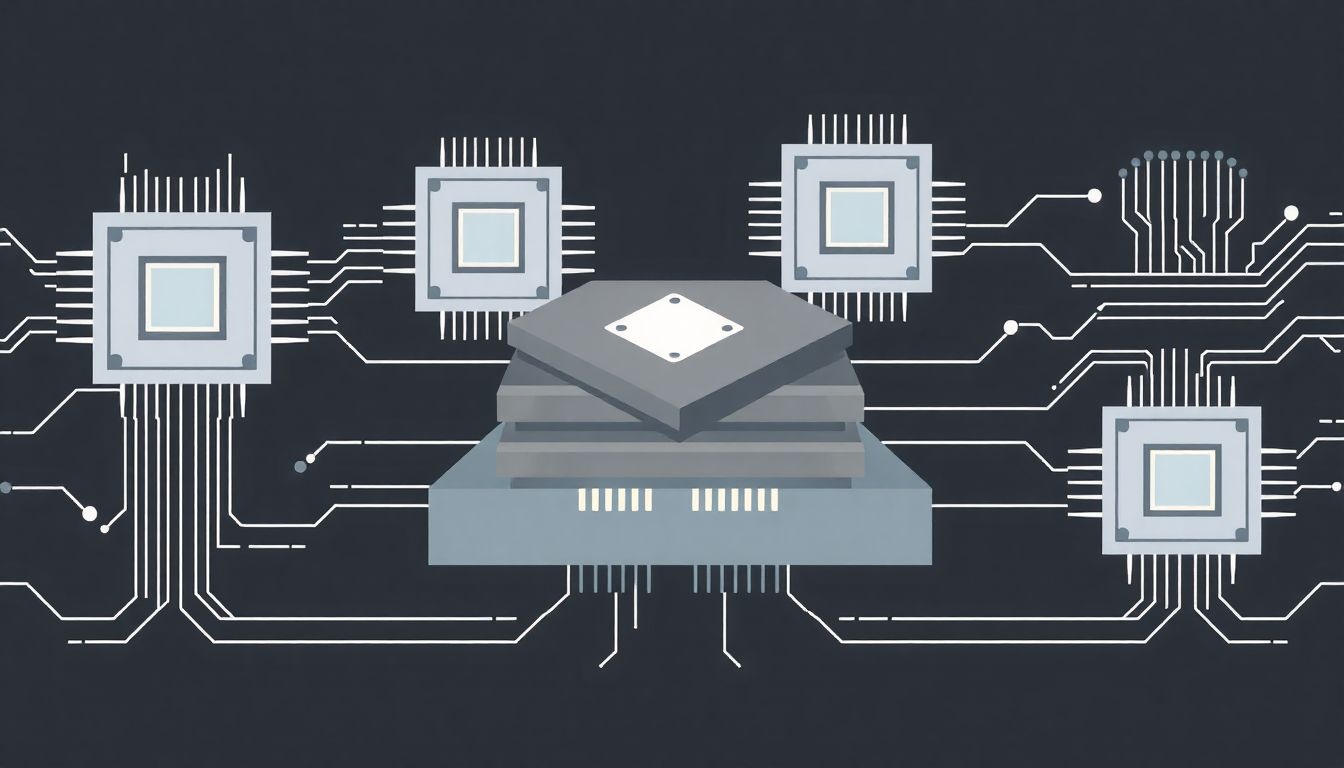

A HBM lényege, hogy több DRAM chipet egymásra helyeznek (3D stacking), és egy szilícium interposer segítségével kötik össze a processzorral vagy a grafikus processzorral. Ez a megoldás drasztikusan megnöveli a sávszélességet és csökkenti a késleltetést, mivel a memóriachipek sokkal közelebb helyezkednek el a feldolgozó egységhez.

A HBM technológia lehetővé teszi a párhuzamos adatátvitelt sokkal több csatornán keresztül, mint a hagyományos DRAM, így jelentősen javítja a teljesítményt.

A 3D stacking miatt a HBM modulok fizikai mérete is kisebb lehet, ami előnyös a helytakarékosság szempontjából. A HBM energiahatékonyabb is, mivel a rövidebb távolságok miatt kevesebb energia szükséges az adatok mozgatásához.

A HBM-et elsősorban nagy teljesítményű alkalmazásokban használják, mint például a grafikus kártyák, a nagy teljesítményű számítógépek (HPC), és a mesterséges intelligencia (AI) gyorsítók. A technológia folyamatosan fejlődik, és újabb, még nagyobb sávszélességű HBM generációk jelennek meg.

Mi az a HBM? A technológia definíciója és alapelvei

A Nagy Sávszélességű Memória (High-Bandwidth Memory – HBM) egy nagy teljesítményű számítógépes memória technológia, amelyet elsősorban a grafikus kártyákban és a nagy teljesítményű számításokban használnak. A hagyományos memóriatípusokhoz (pl. DDR) képest a HBM jelentősen nagyobb sávszélességet és alacsonyabb energiafogyasztást kínál.

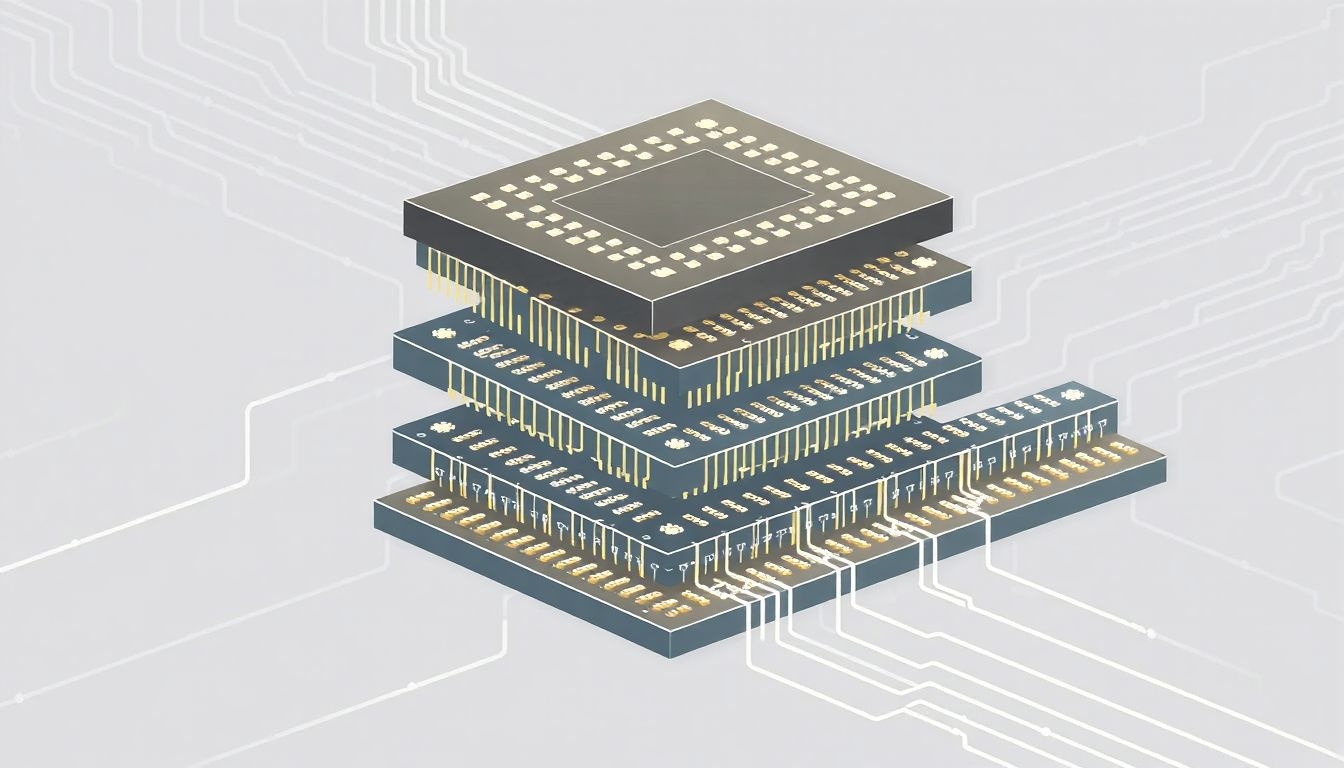

A HBM működésének kulcsa a 3D-s stacked (egymásra épített) architektúrában rejlik. Több memóriachipet helyeznek egymásra, amelyeket TSV-k (Through-Silicon Vias), azaz szilíciumon átmenő összeköttetések kötnek össze. Ezek a TSV-k vertikális csatornákat képeznek, amelyek lehetővé teszik a memóriachipek közötti gyors adatátvitelt. A hagyományos memóriákhoz képest ez a vertikális összeköttetés jelentősen csökkenti az adatátviteli távolságot és növeli a sávszélességet.

A HBM architektúra egyik legfontosabb eleme a memory controller (memória vezérlő), amely a CPU vagy GPU és a HBM memória között kommunikál. A memória vezérlő felelős az adatok írásáért és olvasásáért, valamint a memória címzéséért és a frissítési ciklusok kezeléséért.

A HBM technológia a sávszélesség növelését úgy éri el, hogy több memóriachipet helyez egymásra és azokat nagy sebességű vertikális összeköttetésekkel köti össze.

A HBM előnyei a következők:

- Nagyobb sávszélesség: Gyorsabb adatátvitelt tesz lehetővé, ami javítja a teljesítményt a grafikai alkalmazásokban és a nagy adatmennyiséget kezelő feladatokban.

- Alacsonyabb energiafogyasztás: A rövidebb adatátviteli utak miatt kevesebb energiát fogyaszt, ami fontos a mobil eszközök és a nagy teljesítményű rendszerek számára.

- Kisebb helyigény: A 3D-s architektúra miatt a HBM kevesebb helyet foglal el a nyomtatott áramköri lapon, mint a hagyományos memóriák.

A HBM technológia fejlődése során több generáció jelent meg, mint például a HBM2 és a HBM3, amelyek tovább növelték a sávszélességet és csökkentették az energiafogyasztást. A jövőben várhatóan még tovább fog fejlődni, és egyre szélesebb körben fogják alkalmazni a különböző területeken.

A HBM architektúra: 3D stacking és TSV technológia

A High-Bandwidth Memory (HBM) egy nagyteljesítményű memória interfész, amelyet elsősorban grafikus kártyákban, nagy teljesítményű számítógépekben és hálózati eszközökben használnak. A hagyományos memóriákhoz képest a HBM drámai módon növeli a sávszélességet és csökkenti az energiafogyasztást. Mindez a 3D stacking technológiának és a TSV (Through-Silicon Via) kapcsolatoknak köszönhető.

A 3D stacking azt jelenti, hogy a memória chipeket egymásra helyezik, így egyetlen, magasabb memóriamodult alkotnak. Ez a vertikális elrendezés lehetővé teszi, hogy sokkal több memória kerüljön közelebb a processzorhoz, ami jelentősen csökkenti a késleltetést és növeli a sávszélességet.

A TSV-k vertikális összeköttetések a szilícium chipeken keresztül. Ezek a mikro-méretű csatornák elektromos kapcsolatot biztosítanak a egymásra helyezett chipek között. A TSV-k segítségével a memória chipek sokkal gyorsabban és hatékonyabban tudnak kommunikálni egymással, mint a hagyományos vezetékezéssel.

A TSV technológia kulcsfontosságú a HBM magas sávszélességének elérésében, mivel minimalizálja a jelveszteséget és a késleltetést, lehetővé téve a párhuzamos adatátvitelt a chipek között.

A HBM architektúra több memóriamodult (stack) tartalmaz, amelyek egy interposer-en keresztül kapcsolódnak a processzorhoz vagy a GPU-hoz. Az interposer egy passzív szilíciumlapka, amely a chipek közötti kapcsolatot biztosítja. Ez a megoldás lehetővé teszi, hogy a processzor egyszerre több memóriamodullal kommunikáljon, tovább növelve a sávszélességet.

A HBM előnyei:

- Magas sávszélesség: Többszöröse a hagyományos memóriákénak.

- Alacsonyabb energiafogyasztás: A rövidebb távolságok miatt kevesebb energiát igényel.

- Kisebb helyigény: A 3D stacking miatt kisebb területen több memória fér el.

A HBM technológia folyamatosan fejlődik, és újabb verziók (HBM2, HBM2E, HBM3) jelennek meg, amelyek még nagyobb sávszélességet és alacsonyabb energiafogyasztást kínálnak. Ezek a fejlesztések elengedhetetlenek a nagy teljesítményű számítástechnikai alkalmazások, mint például a gépi tanulás, a mesterséges intelligencia és a tudományos szimulációk számára.

HBM generációk: HBM, HBM2, HBM2E, HBM3 – Összehasonlítás és fejlődés

A High-Bandwidth Memory (HBM) egy nagyteljesítményű DRAM technológia, amelyet a grafikus processzorok (GPU-k), a nagy teljesítményű számítástechnikai rendszerek és a hálózati eszközök memóriaigényeinek kielégítésére fejlesztettek ki. Az HBM lényege a 3D-s stacking, vagyis a memóriachipek egymásra helyezése és a Wide I/O interfész, ami szélesebb adatbuszt eredményez, ezáltal jelentősen megnövelve a sávszélességet és csökkentve az energiafogyasztást a hagyományos memóriákhoz képest.

Az első generációs HBM 2013-ban jelent meg, és a 2.5D szilícium interposeren alapult, amely összeköti a memóriachipeket a GPU-val vagy más processzorral. A HBM egyetlen stackje akár 128 GB/s sávszélességet is képes volt biztosítani. Bár forradalmi volt, korlátai is voltak, például a relatíve magas költségek és a gyártási nehézségek.

A HBM2 a második generációs HBM, amely jelentős fejlesztéseket hozott a sávszélesség és a kapacitás terén. A HBM2 stackek akár 256 GB/s sávszélességet kínáltak, és nagyobb kapacitású chipeket is támogattak. Ez lehetővé tette a GPU-k számára, hogy nagyobb mennyiségű adatot kezeljenek egyszerre, ami különösen fontos a gépi tanulás és a nagy felbontású játékok esetében. A HBM2 javított az energiahatékonyságon is.

A HBM2E a HBM2 továbbfejlesztett változata, amely még nagyobb sávszélességet és kapacitást kínál. A HBM2E stackek akár 460 GB/s sávszélességet is elérhetnek, és 16 GB kapacitású stackek is elérhetővé váltak. Ez a generáció különösen népszerűvé vált a csúcskategóriás GPU-kban és az adatközpontokban.

A HBM technológia fejlődése a sávszélesség folyamatos növekedését és az energiafogyasztás csökkentését célozza meg.

A legújabb generáció a HBM3, amely még nagyobb sávszélességet és kapacitást ígér. A HBM3 célja, hogy akár 800 GB/s sávszélességet is elérjen stackenként, jelentősen növelve a teljes rendszer teljesítményét. A HBM3 továbbfejlesztett architektúrával rendelkezik, amely lehetővé teszi a nagyobb denzitású memóriachipek használatát, és javítja az energiahatékonyságot. A HBM3 kulcsfontosságú lesz a következő generációs GPU-k, AI gyorsítók és nagy teljesítményű számítástechnikai rendszerek számára.

A generációk közti különbségek leginkább a következő paraméterekben mutatkoznak meg:

- Sávszélesség: A HBM generációk sávszélessége jelentősen nőtt az idő múlásával.

- Kapacitás: A stackenkénti kapacitás is növekedett, lehetővé téve nagyobb adatmennyiségek tárolását.

- Energiahatékonyság: Az újabb generációk hatékonyabban használják fel az energiát, csökkentve a rendszer teljes energiafogyasztását.

- Költség: Bár a HBM kezdetben drága volt, a gyártási folyamatok fejlődésével a költségek csökkentek.

A HBM technológia fejlődése elengedhetetlen a nagy teljesítményű számítástechnikai rendszerek és a grafikus processzorok számára, mivel lehetővé teszi a nagyobb adatmennyiségek gyorsabb és hatékonyabb kezelését.

A HBM működési elve: A memória cellák szervezése és az adatátviteli sebesség

A High-Bandwidth Memory (HBM) egy nagy teljesítményű memória technológia, melyet a magas sávszélességű adatátvitelre terveztek. A hagyományos memóriákkal szemben, a HBM 3D-s vertikális elrendezést alkalmaz, ami azt jelenti, hogy a memória cellák egymásra vannak építve, és TSV (Through-Silicon Via) technológiával vannak összekötve.

Ez a vertikális elrendezés jelentősen csökkenti az adatátviteli távolságot, ami lehetővé teszi a sokkal nagyobb sávszélességet és alacsonyabb energiafogyasztást. A TSV-k apró, a szilícium lapkán átmenő függőleges csatornák, melyek lehetővé teszik a rétegek közötti kommunikációt.

A HBM általában memória „stack”-ekből áll, ahol minden stack több memória lapkát tartalmaz. Ezek a stack-ek aztán egy memóriavezérlővel vannak összekötve, ami kezeli az adatok olvasását és írását.

A HBM egyik legfontosabb előnye a párhuzamos adatátvitel lehetősége. Mivel több memória lapka van egymásra építve, egyszerre több csatornán keresztül is lehet adatot mozgatni, ami drasztikusan növeli a sávszélességet.

A HBM széles interfészt használ a memóriavezérlővel való kommunikációhoz. Ez a széles interfész lehetővé teszi, hogy egyszerre sok bitet küldjön és fogadjon, ami szintén hozzájárul a magas sávszélességhez. Például, egy HBM2 stack akár 1024 bit széles interfészt is használhat.

A HBM technológia fejlődésével egyre nagyobb sávszélesség érhető el, ami elengedhetetlen a modern GPU-k, CPU-k és egyéb nagy teljesítményű alkalmazások számára. Az energiahatékonysága is kiemelkedő, hiszen a rövidebb adatátviteli távolságok miatt kevesebb energia szükséges az adatok mozgatásához.

A HBM előnyei a hagyományos memóriákkal szemben: Sávszélesség, energiahatékonyság, méret

A HBM (High-Bandwidth Memory) a hagyományos memóriákhoz képest számos előnnyel rendelkezik, melyek leginkább a sávszélességben, energiahatékonyságban és méretben mutatkoznak meg. Ezek a tulajdonságok teszik a HBM-et ideális választássá nagy teljesítményű alkalmazásokhoz, mint például a grafikus kártyák, a mesterséges intelligencia gyorsítók és a nagy teljesítményű számítástechnikai rendszerek.

A sávszélesség a HBM legkiemelkedőbb előnye. A hagyományos memóriák, mint a DDR5, egyetlen csatornán keresztül kommunikálnak a processzorral vagy GPU-val. Ezzel szemben a HBM több, egymásra helyezett memóriamodulból áll, melyek egy szilícium interposerrel kapcsolódnak a processzorhoz. Ez lehetővé teszi számos, párhuzamos adatcsatorna létrehozását, ami nagyságrendekkel nagyobb sávszélességet eredményez. A nagyobb sávszélesség azt jelenti, hogy több adatot lehet egyszerre mozgatni a memória és a processzor között, ami jelentősen felgyorsítja a számítási feladatokat.

Az energiahatékonyság egy másik kulcsfontosságú előny. A HBM a rövidebb adatutaknak és az alacsonyabb feszültségszintnek köszönhetően kevesebb energiát fogyaszt, mint a hagyományos memóriák. Mivel az adatokat rövidebb távolságra kell mozgatni, kevesebb energia vész el a folyamat során. Ez különösen fontos a hordozható eszközökben és a nagy teljesítményű rendszerekben, ahol a hőtermelés és az energiafogyasztás korlátozó tényező lehet.

A HBM energiahatékonysága lehetővé teszi a nagyobb teljesítményű rendszerek építését anélkül, hogy a hőkezelés jelentős problémát okozna.

A méret is a HBM mellett szól. A memóriamodulok egymásra helyezése lehetővé teszi, hogy a HBM kisebb helyen nagyobb memóriakapacitást kínáljon. Ez különösen előnyös a mobil eszközökben és a kis helyigényű rendszerekben, ahol a hely szűkös erőforrás.

Összefoglalva, a HBM a nagyobb sávszélesség, az alacsonyabb energiafogyasztás és a kisebb méret kombinációjával jelentős előnyöket kínál a hagyományos memóriákkal szemben. Ezek az előnyök teszik a HBM-et a jövő memóriatechnológiájává a nagy teljesítményt igénylő alkalmazások számára.

A HBM hátrányai: Költség, komplexitás, hűtés

Bár a HBM technológia jelentős előnyöket kínál a sávszélesség terén, számos hátránnyal is számolni kell, amelyek korlátozhatják az alkalmazását.

Az egyik legjelentősebb hátrány a magas költség. A HBM chipek gyártása sokkal bonyolultabb, mint a hagyományos memóriáké, ami drágább gyártási folyamatokat és alacsonyabb hozamot eredményez. Ezáltal a HBM-mel felszerelt termékek, mint például a csúcskategóriás grafikus kártyák és a nagy teljesítményű számítógépek, jelentősen drágábbak.

A komplexitás egy másik kulcsfontosságú tényező. A HBM integrálása a rendszerbe bonyolultabb áramköröket és tervezési megoldásokat igényel. A chipek egymásra rétegzése és a TSV-k (Through-Silicon Vias) használata speciális tervezési és gyártási szakértelmet követel meg. Ez növeli a fejlesztési időt és a költségeket, valamint a potenciális hibalehetőségeket.

A HBM komplexitása nem csak a gyártásban jelentkezik, hanem a memóriavezérlő tervezésében és a szoftveres támogatásban is.

Végül, a hűtés is kritikus szempont. A HBM chipek nagy teljesítményűek, ami azt jelenti, hogy jelentős mennyiségű hőt termelnek. A szorosan egymásra helyezett memóriamodulok nehezítik a hő elvezetését, ezért hatékonyabb és gyakran drágább hűtési megoldásokra van szükség. Ez a megnövekedett hőtermelés befolyásolhatja a rendszer stabilitását és élettartamát, ha nem kezelik megfelelően.

Összességében a HBM előnyei ellenére a magas költség, a komplexitás és a hűtési kihívások jelentős akadályt jelenthetnek a szélesebb körű elterjedésében. A gyártók folyamatosan dolgoznak ezen problémák leküzdésén, hogy a HBM előnyeit minél több alkalmazásban lehessen kihasználni.

A HBM alkalmazási területei: GPU-k, HPC, AI, FPGA-k

A nagy sávszélességű memória (HBM) technológia forradalmasította a memória architektúrát, különösen azokban az alkalmazásokban, ahol rendkívüli adatátviteli sebességre van szükség. Nézzük meg, hol kamatoztatják a HBM előnyeit:

GPU-k (Grafikus feldolgozó egységek): A játékok, a professzionális grafikai tervezés és a gépi tanulás terén a GPU-k hatalmas mennyiségű adatot dolgoznak fel párhuzamosan. A HBM lehetővé teszi a GPU számára, hogy sokkal gyorsabban férjen hozzá az adatokhoz, mint a hagyományos GDDR memória. Ez kritikus a magas felbontású textúrák betöltéséhez, a komplex árnyékolók futtatásához és a valós idejű ray tracinghez. A nagy sávszélességű memória nélkül a GPU teljesítménye jelentősen korlátozott lenne, különösen a legújabb generációs játékokban és alkalmazásokban.

HPC (Nagy teljesítményű számítástechnika): A tudományos szimulációk, a meteorológiai előrejelzések és a pénzügyi modellezés terén a HPC rendszerek hatalmas adathalmazokat elemeznek. A HBM lehetővé teszi a processzorok és gyorsítók számára, hogy gyorsabban végezzenek számításokat, ami lerövidíti a szimulációk futási idejét és javítja a modellek pontosságát. A HBM nélkül a HPC rendszerek teljesítménye jelentősen csökkenne, ami befolyásolná a tudományos felfedezések ütemét és a kritikus problémák megoldását.

AI (Mesterséges intelligencia): A gépi tanulási modellek betanítása és futtatása hatalmas mennyiségű adatot igényel. A HBM lehetővé teszi az AI gyorsítók számára, hogy gyorsabban férjenek hozzá a képzési adatokhoz és a modellparaméterekhez, ami felgyorsítja a betanítási folyamatot és javítja a modellek pontosságát. A HBM nélkül az AI modellek betanítása sokkal tovább tartana, és a valós idejű következtetés kevésbé lenne hatékony.

A HBM kulcsfontosságú az AI alkalmazások fejlődéséhez, lehetővé téve a komplex neurális hálózatok hatékony betanítását és futtatását.

FPGA-k (Programozható logikai áramkörök): Az FPGA-k rugalmas platformot kínálnak a különböző alkalmazásokhoz, beleértve a hálózati eszközöket, a beágyazott rendszereket és a gyorsítókártyákat. A HBM lehetővé teszi az FPGA-k számára, hogy nagy sávszélességű memóriát használjanak, ami javítja a teljesítményt és csökkenti a késleltetést. Ez különösen fontos azokban az alkalmazásokban, ahol valós idejű adatfeldolgozásra van szükség, például a hálózati forgalom elemzésében és a képfeldolgozásban.

A HBM technológia tehát egyre fontosabbá válik a modern számítástechnikai rendszerekben, és elengedhetetlen a nagy teljesítményű alkalmazásokhoz.

HBM a GPU-kban: A grafikus kártyák teljesítményének növelése

A High-Bandwidth Memory (HBM) egy nagy teljesítményű memóriatechnológia, melyet kifejezetten a grafikus kártyák (GPU-k) teljesítményének növelésére fejlesztettek ki. A hagyományos GDDR memóriákkal szemben a HBM a nagyobb sávszélességre és az alacsonyabb energiafogyasztásra fókuszál.

A HBM működésének alapja a 3D-s elrendezés. Több memórialapkát (DRAM) egymásra helyeznek, és egy silicon via (TSV) technológiával függőlegesen összekapcsolják őket. Ez a megoldás lehetővé teszi, hogy a memórialapkák párhuzamosan működjenek, ami drasztikusan megnöveli a sávszélességet.

A HBM a GPU számára sokkal gyorsabban és hatékonyabban képes adatokat biztosítani, mint a hagyományos memóriák, ami jelentősen javítja a grafikai renderelési teljesítményt.

A szélesebb adatbusz (az adatok párhuzamos átvitelére szolgáló vezetékek száma) szintén kulcsfontosságú tényező. A HBM sokkal szélesebb adatbusszal rendelkezik, mint a GDDR memóriák, ami még tovább növeli a sávszélességet. Például, míg a GDDR6 jellemzően 32-bites adatbuszt használ, a HBM2 akár 1024-bites adatbusszal is rendelkezhet.

A HBM használata a GPU-kban számos előnnyel jár:

- Magasabb sávszélesség: Gyorsabb adatátvitel a GPU és a memória között.

- Alacsonyabb energiafogyasztás: Hatékonyabb energiafelhasználás a 3D-s elrendezésnek köszönhetően.

- Kisebb helyigény: Kompaktabb kialakítás a memórialapkák függőleges elrendezése miatt.

Bár a HBM drágább, mint a GDDR, a magasabb teljesítménye és hatékonysága miatt a csúcskategóriás grafikus kártyákban és a professzionális alkalmazásokban egyre elterjedtebbé válik. A jövőben várhatóan még tovább fejlődik, és még nagyobb teljesítményt fog biztosítani a GPU-k számára.

HBM a HPC-ben: A szuperszámítógépek memóriaigényeinek kielégítése

A nagy sávszélességű memória (HBM) egy nagy teljesítményű RAM technológia, amelyet kifejezetten a szuperszámítógépek, grafikus processzorok (GPU-k) és más, nagy számítási teljesítményt igénylő alkalmazások számára fejlesztettek ki. A HPC (High-Performance Computing) területén a HBM elengedhetetlen a növekvő memóriaigények kielégítéséhez.

A HBM a hagyományos memóriákhoz képest jelentősen nagyobb sávszélességet kínál. Ezt a 3D-s architektúrának köszönheti, ahol a memóriachipek egymásra vannak rétegezve, és egy úgynevezett interposer köti össze őket a processzorral. Az interposer egy szilícium alapú híd, amely rendkívül rövid és széles adatutakat biztosít, minimalizálva az adatátviteli késleltetést.

A HBM lehetővé teszi, hogy a processzor sokkal gyorsabban férjen hozzá a memóriában tárolt adatokhoz, ami kulcsfontosságú a komplex számítások és szimulációk futtatásához.

A HBM előnyei a HPC-ben:

- Nagyobb sávszélesség: Gyorsabb adatátvitel a processzor és a memória között.

- Kisebb energiafogyasztás: A rövidebb adatutak miatt kevesebb energiát igényel az adatmozgatás.

- Kisebb helyigény: A 3D-s architektúra lehetővé teszi a nagyobb memóriakapacitást kisebb fizikai területen.

A szuperszámítógépekben a HBM-et gyakran használják a nagyméretű adathalmazok feldolgozására, például időjárás-előrejelzésekhez, klímamodellezéshez, tudományos szimulációkhoz és mesterséges intelligencia alkalmazásokhoz. A technológia folyamatosan fejlődik, a HBM2, HBM2E és a jövőbeli HBM3 verziók még nagyobb sávszélességet és kapacitást ígérnek.

HBM az AI-ban: A mesterséges intelligencia alkalmazások támogatása

A Nagy Sávszélességű Memória (HBM) kulcsfontosságú technológia a mesterséges intelligencia (AI) területén, különösen a nagyméretű adathalmazokkal dolgozó, számításigényes alkalmazásokban. A HBM lehetővé teszi az AI modellek számára, hogy gyorsabban és hatékonyabban férjenek hozzá az adatokhoz, ezáltal jelentősen felgyorsítva a betanítási és következtetési folyamatokat.

Az AI alkalmazások, mint például a mélytanulás, hatalmas mennyiségű adaton alapulnak. A hagyományos memóriatípusok, mint a DDR SDRAM, gyakran szűk keresztmetszetet jelentenek, mivel nem képesek elég gyorsan adatot szolgáltatni a processzoroknak. A HBM ezt a problémát oldja meg azzal, hogy több memóriachipet egymásra helyez, és egy szélesebb adatbusszal köti össze őket a processzorral.

Ez a vertikális elrendezés és a szélesebb adatbusz drasztikusan megnöveli a memória sávszélességét, ami azt jelenti, hogy a processzor sokkal több adatot tud olvasni és írni egy adott idő alatt.

Például, a HBM jelentősen javítja a grafikus processzorok (GPU-k) teljesítményét, amelyek központi szerepet játszanak a mélytanulási modellek betanításában. A nagyobb sávszélesség lehetővé teszi a GPU-k számára, hogy gyorsabban végezzék el a mátrixműveleteket, amelyek a mélytanulási algoritmusok alapját képezik.

Ezen túlmenően, a HBM energiahatékonyabb is lehet a hagyományos memóriatípusokhoz képest, különösen nagy terhelés alatt. Ez azért van, mert az adatok rövidebb távolságon belül mozognak a memóriachipek és a processzor között, ami csökkenti az energiafogyasztást. A HBM használata az AI-ban tehát nem csak a teljesítményt növeli, hanem a fenntarthatóbb számításhoz is hozzájárul.

A jövőben a HBM várhatóan még fontosabb szerepet fog játszani az AI területén, ahogy a modellek egyre nagyobbak és komplexebbek lesznek. A folyamatos fejlesztések a HBM technológiában tovább fogják növelni a sávszélességet és az energiahatékonyságot, lehetővé téve az AI alkalmazások számára, hogy még komplexebb problémákat oldjanak meg.

HBM az FPGA-kban: A programozható logikai eszközök memóriabővítése

A High-Bandwidth Memory (HBM) egy nagy teljesítményű, 3D-s memória technológia, amely jelentős előrelépést jelent az FPGA-k memóriakezelésében. Az FPGA-k, a programozható logikai eszközök, gyakran szembesülnek a memória sávszélességének korlátaival, ami gátat szabhat a nagy teljesítményt igénylő alkalmazások, például a valós idejű képfeldolgozás vagy a nagysebességű hálózati adatfeldolgozás számára.

Az HBM integrálása az FPGA-kba lehetővé teszi, hogy ezek az eszközök jelentősen megnöveljék a memóriához való hozzáférés sebességét és a sávszélességet. A hagyományos memóriákkal szemben, amelyek a processzorral párhuzamosan helyezkednek el, az HBM több memóriachipet egymásra helyezve, függőlegesen épül fel, és egy széles interfészen keresztül kapcsolódik a processzorhoz. Ez a 3D-s felépítés lehetővé teszi a rövidebb összeköttetéseket és a nagyobb adatátviteli sebességet.

Az HBM integrációja az FPGA-kba áttörést jelent a nagy teljesítményű alkalmazások számára, mivel lehetővé teszi a memória sávszélességének jelentős növelését.

Az FPGA-k esetében ez azt jelenti, hogy komplex algoritmusok futtathatók gyorsabban és hatékonyabban. Például, egy képfeldolgozó alkalmazás, amely nagy felbontású képeket dolgoz fel valós időben, jelentősen profitálhat az HBM által biztosított nagy sávszélességből, mivel az adatok gyorsabban tölthetők be és tárolhatók a memóriában.

Az HBM ezenkívül csökkenti az energiafogyasztást is a hagyományos memóriamegoldásokhoz képest, mivel a rövidebb összeköttetések kevesebb energiát igényelnek az adatátvitelhez. Ez különösen fontos a mobil eszközökben és az olyan alkalmazásokban, ahol az energiahatékonyság kritikus tényező.

A HBM alternatívái: HMC (Hybrid Memory Cube) és egyéb technológiák

A HBM (High-Bandwidth Memory) egyike azon megoldásoknak, amelyek a memória sávszélességének növelésére törekszenek. Azonban léteznek alternatív technológiák is, amelyek hasonló célokat szolgálnak, de más megközelítést alkalmaznak.

Az egyik ilyen alternatíva a HMC (Hybrid Memory Cube), amely szintén 3D-s architektúrát használ, de a memóriachipek és a logikai processzor közötti összeköttetést másképp valósítja meg. A HMC „through-silicon vias” (TSV) technológiát alkalmaz, de a memóriachipek egy „cube” formában vannak elrendezve, és a logikai processzor alul helyezkedik el. Ez a megoldás elméletileg magasabb sávszélességet és alacsonyabb energiafogyasztást ígér, de a HBM-hez képest kevésbé terjedt el.

A HMC és a HBM közötti legfontosabb különbség a fizikai megvalósításban és a piaci elfogadottságban rejlik.

Emellett léteznek egyéb technológiák is, mint például a Wide I/O, amely szintén a memória sávszélességének növelésére fókuszál, de kevésbé agresszív 3D-s megoldást alkalmaz. A Wide I/O a memóriachipek szélesebb interfészén keresztül kommunikál a processzorral, ami nagyobb sávszélességet eredményez.

Bár a HBM jelenleg domináns a nagy sávszélességű memória piacán, a HMC és a Wide I/O továbbra is potenciális alternatívák, amelyek a jövőben szerepet játszhatnak a memóriaarchitektúrák fejlődésében.

A HBM jövője: Fejlesztési irányok és a technológia potenciálja

A HBM jövője izgalmas fejlesztési irányokat ígér. A hangsúly a nagyobb sávszélesség, a kisebb energiafogyasztás és a nagyobb kapacitás elérésén van. A gyártók folyamatosan dolgoznak az architektúra finomításán és az új anyagok bevezetésén.

Az egyik legfontosabb fejlesztési irány a HBM generációk közötti ugrás. A HBM3 és a jövőbeli HBM4 célja a sávszélesség jelentős növelése a korábbi generációkhoz képest. Ez elengedhetetlen a gépi tanulás, a nagy teljesítményű számítástechnika (HPC) és a grafikus kártyák igényeinek kielégítéséhez.

A 3D stacking technológia továbbfejlesztése is kulcsfontosságú. A chipek függőleges egymásra helyezése lehetővé teszi a memória sűrűségének növelését anélkül, hogy a fizikai méret jelentősen nőne. Ez a nagyobb kapacitás mellett a rövidebb jelutak révén a teljesítmény javulását is eredményezi.

A HBM technológia potenciálja óriási. Nemcsak a teljesítmény növelésében játszik kulcsszerepet, hanem az energiahatékonyság javításában is, ami egyre fontosabb a fenntartható számítástechnika szempontjából.

A HBM technológia alkalmazási területei folyamatosan bővülnek. A jövőben várhatóan egyre több területen találkozunk vele, a mobil eszközöktől kezdve a szerverparkokig. A virtuális valóság (VR) és a kiterjesztett valóság (AR) is profitálhat a HBM által nyújtott nagy sávszélességből.

A legfontosabb HBM gyártók: Samsung, SK Hynix, Micron

A High-Bandwidth Memory (HBM) piacát jelenleg három nagy gyártó uralja: a Samsung, az SK Hynix és a Micron. Ezek a vállalatok élen járnak a HBM technológia fejlesztésében és gyártásában, ami elengedhetetlen a modern, nagy teljesítményű számítástechnikai rendszerek számára.

A Samsung jelentős szereplőként kínál HBM memóriákat grafikus kártyákhoz és adatközpontokhoz. Innovatív megoldásaikkal folyamatosan növelik a sávszélességet és a kapacitást.

Az SK Hynix szintén kulcsszerepet játszik a HBM piacon. Termékeiket széles körben alkalmazzák a mesterséges intelligencia és a nagy teljesítményű számítás (HPC) területein. Az SK Hynix folyamatosan fejleszti a HBM technológiát, hogy megfeleljen a növekvő igényeknek.

A Micron, bár később csatlakozott a HBM gyártók táborához, gyorsan felzárkózott. A vállalat HBM memóriái a megbízhatóságukról és a teljesítményükről ismertek, és egyre nagyobb teret hódítanak a piacon.

Mindhárom gyártó – Samsung, SK Hynix és Micron – komoly versenyben van egymással, ami a HBM technológia folyamatos fejlődését eredményezi.

A verseny ösztönzi a gyártókat, hogy új generációs HBM memóriákat fejlesszenek ki, melyek nagyobb sávszélességet, alacsonyabb energiafogyasztást és nagyobb kapacitást kínálnak. Ez kritikus fontosságú a következő generációs grafikus kártyák, AI gyorsítók és egyéb nagy teljesítményű alkalmazások számára.

HBM és a memória interfészek: A fizikai kapcsolat a processzorral

A High-Bandwidth Memory (HBM) egy nagy teljesítményű memória interfész, amely a hagyományos memóriákhoz képest jelentősen nagyobb sávszélességet kínál. Ennek elérésében kulcsfontosságú a fizikai kapcsolat a processzorral vagy a grafikus processzorral (GPU).

Az HBM nem hagyományos DIMM modulokon keresztül csatlakozik. Ehelyett a processzor közvetlen közelében helyezkedik el, gyakran ugyanazon a lapkán (vagy egy közeli lapkán, interposer segítségével). Ez a közelség drasztikusan csökkenti a jelutakat, ami alacsonyabb késleltetést és nagyobb sávszélességet eredményez.

A kapcsolatot gyakran egy szilícium interposer biztosítja. Ez egy passzív szilícium lapka, ami áthidalja a processzor és az HBM memóriamodulok közötti fizikai távolságot, és lehetővé teszi a nagy sűrűségű, rövid összeköttetéseket. Az interposeren keresztül ezer számú kapcsolat létesül, ami elengedhetetlen a hatalmas adatátviteli sebességhez.

Az HBM memória interfész lényege, hogy a memóriamodulokat a processzorhoz a lehető legközelebb helyezi, minimalizálva a jelutakat és maximalizálva a sávszélességet.

A TSV (Through-Silicon Via) technológia is kritikus szerepet játszik. Ez a technológia lehetővé teszi, hogy a memórialapkákat függőlegesen egymásra helyezzék (stacking), és függőlegesen átfúrják őket, hogy elektromos kapcsolatot teremtsenek a különböző rétegek között. Ez tovább növeli a memória sűrűségét és csökkenti az energiafogyasztást.

A HBM energiafogyasztásának optimalizálása: Technikák és módszerek

A HBM energiafogyasztásának csökkentése kritikus fontosságú a modern, nagy teljesítményű számítástechnikai rendszerekben. Több technika is alkalmazható a hatékonyság növelésére. Az egyik ilyen módszer a dinamikus feszültség- és frekvencia skálázás (DVFS), amely lehetővé teszi a HBM működési paramétereinek az aktuális terheléshez igazítását. Alacsonyabb terhelés esetén a feszültség és a frekvencia csökkenthető, ezáltal energiát takarítva meg.

Egy másik fontos szempont a memóriabankok szelektív aktiválása. Ahelyett, hogy az összes bank egyszerre működne, csak a szükséges bankok aktiválódnak, minimalizálva ezzel az energiafogyasztást.

A hatékony memóriakezelés, például a adatok tömörítése és a felesleges adatmásolások elkerülése, szintén jelentős energiamegtakarítást eredményezhet.

Emellett a 3D-s integráció is hozzájárul az energiahatékonysághoz. A HBM lapkák egymásra helyezése csökkenti az adatátviteli távolságot, ami alacsonyabb energiafogyasztást eredményez. A jövőbeli fejlesztések a hűtési technológiák továbbfejlesztésére is összpontosítanak, lehetővé téve a HBM nagyobb teljesítményen történő működtetését a túlzott energiafogyasztás nélkül.

A HBM hibakezelése és megbízhatósága

A HBM memóriák hibakezelése és megbízhatósága kulcsfontosságú szempont a széleskörű elterjedés szempontjából. A 3D architektúra, ahol több memórialap van egymásra építve, eleve nagyobb kockázatot jelent a hibákra.

A HBM memóriák különböző hibakezelési technikákat alkalmaznak, többek között:

- ECC (Error Correcting Code): Ez a legelterjedtebb módszer, mely lehetővé teszi az adatok tárolása során keletkező hibák észlelését és javítását.

- Redundáns memóriacellák: Hibás cellák esetén ezek a tartalék cellák lépnek a helyükre, így biztosítva a folyamatos működést.

- Hibás címtartományok letiltása: Ha egy nagyobb memóriaterület hibásnak bizonyul, a rendszer letilthatja azt a területet, elkerülve a további problémákat.

A HBM memóriák megbízhatóságát növeli a gyártás során alkalmazott szigorú minőségellenőrzés és tesztelés.

Mindezek ellenére a HBM memóriák sem hibátlanok. A hibák előfordulásának esélye függ a gyártási technológiától, a működési körülményektől (hőmérséklet, feszültség) és a használati időtől. A fejlett hibakezelési mechanizmusoknak köszönhetően azonban a legtöbb hiba automatikusan javításra kerül, minimalizálva a rendszer működésére gyakorolt hatást. A jövőben a hibakezelési technikák további fejlesztése várható, hogy a HBM memóriák még megbízhatóbbak legyenek.

HBM és a chipek integrációja: A SoC (System-on-Chip) tervezés kihívásai

A nagy sávszélességű memória (HBM) integrációja a SoC (System-on-Chip) tervezésbe jelentős kihívásokat vet fel. A HBM egy 3D-s memóriatechnológia, amely a memória chipeket egymásra helyezi, és egy széles, párhuzamos interfésszel kapcsolódik a processzorhoz. Ez jelentősen megnöveli a sávszélességet és csökkenti az energiafogyasztást a hagyományos memóriamegoldásokhoz képest.

A HBM integrálása azonban komoly tervezési komplexitást okoz, különösen a chip fizikai elrendezése és a hőkezelés tekintetében.

Az egyik fő kihívás a HBM és a processzor közötti rövid és nagy sebességű kapcsolat biztosítása. Ez speciális interposereket igényel, amelyek a memória és a processzor közötti jelátvitelt optimalizálják. A hőkezelés is kritikus szempont, mivel a HBM chipek sűrű elhelyezkedése jelentős hőtermeléssel jár, ami befolyásolhatja a rendszer stabilitását és élettartamát. A SoC tervezőknek hatékony hűtési megoldásokat kell alkalmazniuk, például folyadékhűtést vagy fejlett hővezető anyagokat.

További kihívást jelent a tesztelés és hibakeresés. A HBM chipek komplexitása miatt a hibák felderítése és javítása nehézkes lehet. A SoC tervezőknek speciális tesztelési módszereket és eszközöket kell alkalmazniuk a HBM megbízhatóságának biztosítására.